解釋器模型首創!Tilde打破提示工程局限,讓AI推理更精準

可解釋性是人工智能領域中的一個核心挑戰,也是一個備受關注的問題。隨著AI模型(尤其是深度學習模型)的規模和復雜性不斷增長,模型內部的計算過程變得越來越難以理解。

但一直以來,模型的可解釋性好像不如模型的性能那般受重視,往往不是新產品發布的宣傳重點。

而最近,一個總部位于美國加州的AI初創Tilde宣布成立,專為模型可解釋性而生。

他們正在構建解釋器模型和控制技術,以解鎖模型的深層推理和指令能力,從而實現新一代的人機交互。

當今AI的交互依賴于黑箱提示,這種方式本質上有損信息。試想在沒有源代碼的情況下優化一個軟件系統——不僅低效,而且極度受限。

Tilde希望通過應用可解釋性超越這些限制:他們正在構建解決方案,使人們能夠直觀地看見模型的內部工作機制,以直接引導模型行為并提升性能,超越傳統的后訓練方法或微調方法的潛能。

目前,基于已有的開源大語言模型、文生視頻模型,他們的解釋器模型已經實現了大語言模型的推理能力改進,并在文本生成視頻模型中實現了更精細的生成控制。

解釋器模型運用案例

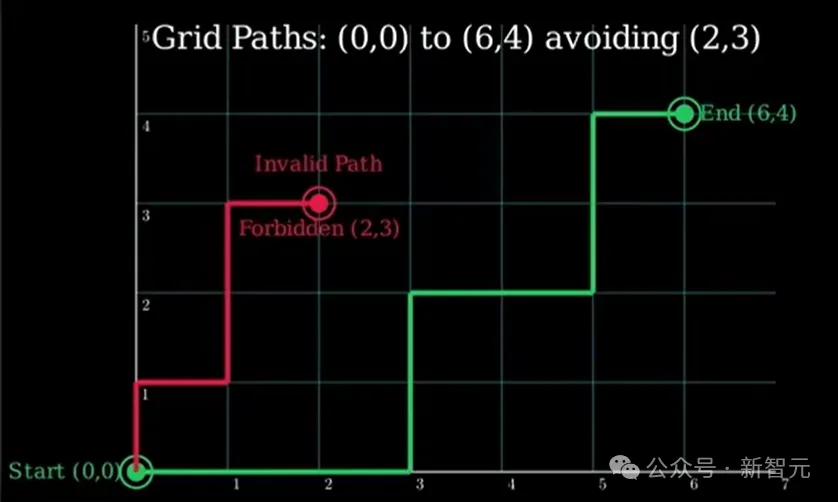

關于大語言模型推理能力的優化,視頻中提到了一個案例,讓Llama 3.1 8B嘗試解答一個可以通過巧妙數學技巧解決的腦筋急轉彎:

從點(0,0)到點(6,4)的網格上,若只能向右或向上移動,有多少條最短路徑不經過點(2,3)?

問題輸入后,Llama 3.1 8B輸出了一個錯誤的答案。

接著,案例演示引入了Tilde的干預,補充了指令:「確保模型應用強大的組合推理!」

在此之后,模型正確解答了這個腦筋急轉彎。

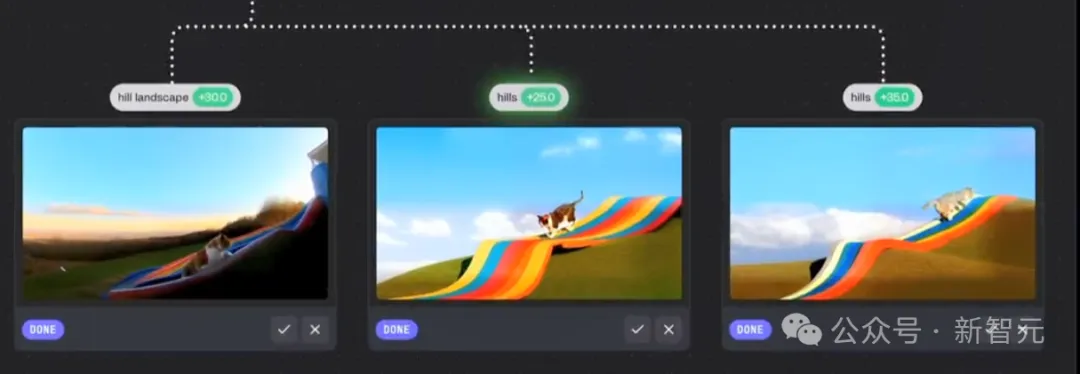

而至于文本生成視頻模型更精細的生成控制,視頻給到的案例中,向Genmo的mochi 1輸入了指令:

一只貓從山頂的彩虹滑梯上滑下來,天上有湛藍的天空和蓬松的云朵。

接著,案例演示引入了Tilde的干預,補充了指令:「確保有山!」

我們可以注意到加入Tilde干預后的準確性和遵循用戶偏好的提升。可以看到三個優化后的圖像中:第一張更注重于山間風景的加強;第二、三張的區別不太大,第三張的坡形相對更明顯一些。

網友討論

看到這里,有網友不禁提問:這和提示工程有什么區別?

谷歌DeepMind高級研究科學家Neel Nanda就提到:「關于組合數學問題的例子,如果你在提示的末尾添加『請使用強大的組合推理』(please use strong combinatorial reasoning),會發生什么?」

前OpenAI研究員Neil Chowdhury回復道:「我在Llama-3.1 8B-Instruct(默認的Hugging Face采樣參數)上嘗試了這個方法,它解決了問題——不過當然,我希望能看到更深入的分析 :) 」

Neel Nanda還艾特了Tilde的X賬號,表示很想看到他們的工具和提示工程(prompt modification)基準方法進行合理的比較。

Tilde的創始人之一Dhruv Pai對此進行了回復——

Neel(以及Neil),謝謝你們的想法,提出了好問題!

簡而言之:上面包含一個腳本,展示了我們使用的基礎和系統提示,但在末尾添加「請使用強大的組合推理」并沒有奏效(無論是使用Hugging Face還是我們自己的服務庫)。

稍微展開說明一下:基礎提示要求模型生成一個便于演示的結構化輸出(否則生成內容會太長),而且在溫度為0的情況下總是出錯(也可能對更復雜或更簡單的提示能成功,但未測試)。

我們的結論并不是「哦,現在我們可以讓Llama-3.1解決無法解決的問題」,而是「在一個相對普通的提示下,我們可以讓它正確回答一些本來可能會失敗的問題」。

這對我們來說很有趣,因為我們第一次看到時,被這種引導采樣(Steering Sampling)的多樣性和質量(有點類似于非常智能的大型語言模型)驚艷到了。

有趣的一點:雖然引導可以讓它解決更難的問題(例如MMLU專業問題集的題目),但我們認為在演示中這種「更難的問題」沒有「我們展示的更簡單的問題」表現得那么直觀。??

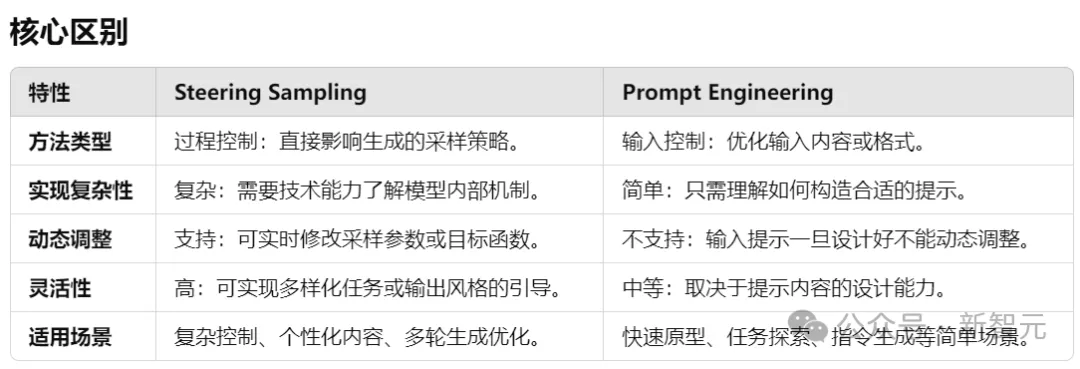

引導采樣 VS 提示工程

引導采樣(Steering Sampling)和提示工程(Prompt Engineering)是兩種不同的方法,用于控制LLM的輸出方向。它們的目標都是生成符合需求的結果,但所關注的技術和實現方式有所不同。

引導采樣通過調整模型內部的采樣策略或生成過程,在模型生成的過程中動態引導輸出的方向,而不是直接改變輸入的提示。

而提示工程通過優化或設計輸入提示(prompt)的內容或結構,來引導模型按照預期方式生成輸出。

Stargazer

不過,目前在Tilde的官網中并沒有找到視頻案例中展示的產品界面,只找到了一個已經上線的產品「Stargazer」,主要圍繞大語言模型的可解釋性而生,可用于探索開源Llama模型內部。

體驗地址:https://stars.tilderesearch.com/

Stargazer基于Llama 3.1 8B設計。

向模型提問時,它的回答會被拆分成多個token(文本塊)。

之后,點擊回答中的任意token,就能查看該token的stars(相關概念)和constellations(概念群組)。這些是模型思維的快照。

Stargazer還對stars按照稀有程度進行了分類:Common(稀有程度0-35%)、Rare(稀有程度35-45%)、Ultra(稀有程度45-60%)、Legendary(稀有程度60-100%)。

以下是分別用中英文向Stargazer提問「什么是語言模型/What is a language model」時,它給到的答案和分詞結果。

技術原理

Tilde還發表了一篇內容關于稀疏自編碼器中的速率-失真問題的博客,并表示不久將會發布開源的項目。

博客中詳細探討了稀疏自動編碼器(SAE)、Top-k激活函數和信息瓶頸框架,它們都涉及如何更高效地組織和控制模型的內部機制。這些理論都被積極融入到Tilde訓練的解釋性模型中。

博客地址:https://www.tilderesearch.com/blog/rate-distortion-saes

稀疏自動編碼器

稀疏自動編碼器是一個令人興奮的研究領域,它不僅有助于我們理解深度學習中的特征表示,還為開發更高效且更可解釋的模型提供了方向。

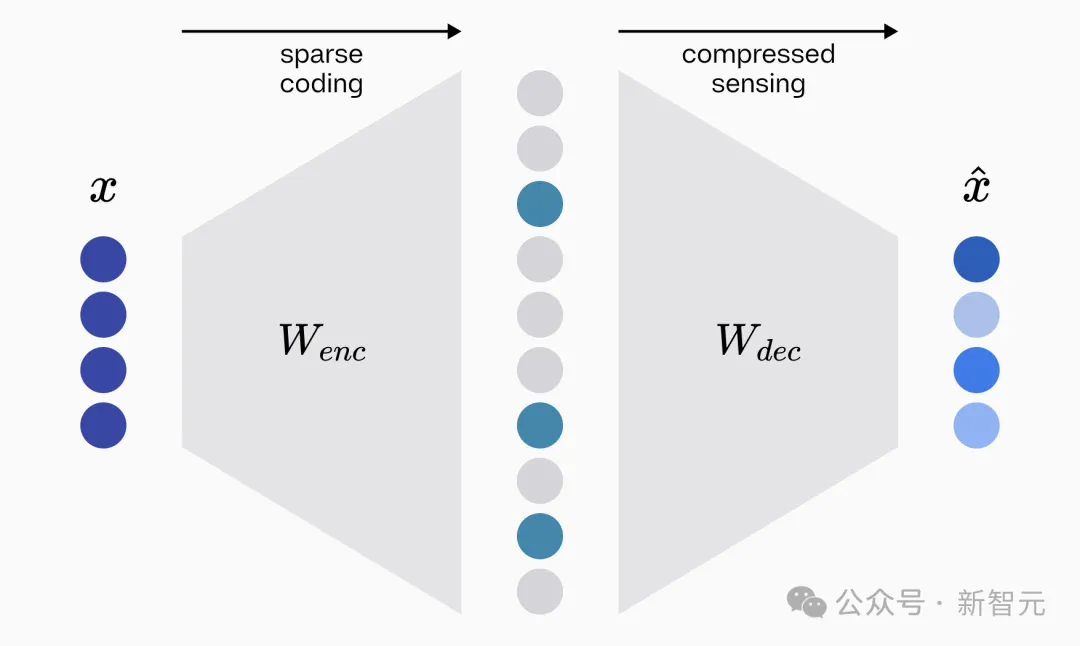

從可解釋性角度退一步來看,構建一個有效的稀疏自動編碼器(SAE)需要解決兩個基本問題:創建高效表示數據的稀疏編碼,以及從這些編碼中準確重建原始數據。

第一個任務由自動編碼器的編碼器矩陣完成,將輸入數據(如圖像或文本)轉換為一種高效且稀疏的表示形式;第二個任務由解碼器矩陣完成,需從編碼后的稀疏表示中重建原始輸入,驗證編碼器選擇的信息是否足夠全面。稀疏編碼可以看作模型如何「理解」輸入的快照。

編碼器和解碼器兩者共同作用,既提升了模型的效率,又為分析其內部工作機制提供了透明窗口,是實現可解釋性的重要基礎。

從根本上說,構建一個有效的稀疏自動編碼器需要解決的兩個基本問題分別屬于稀疏編碼(sparse coding)理論和壓縮感知(compressed sensing)領域。

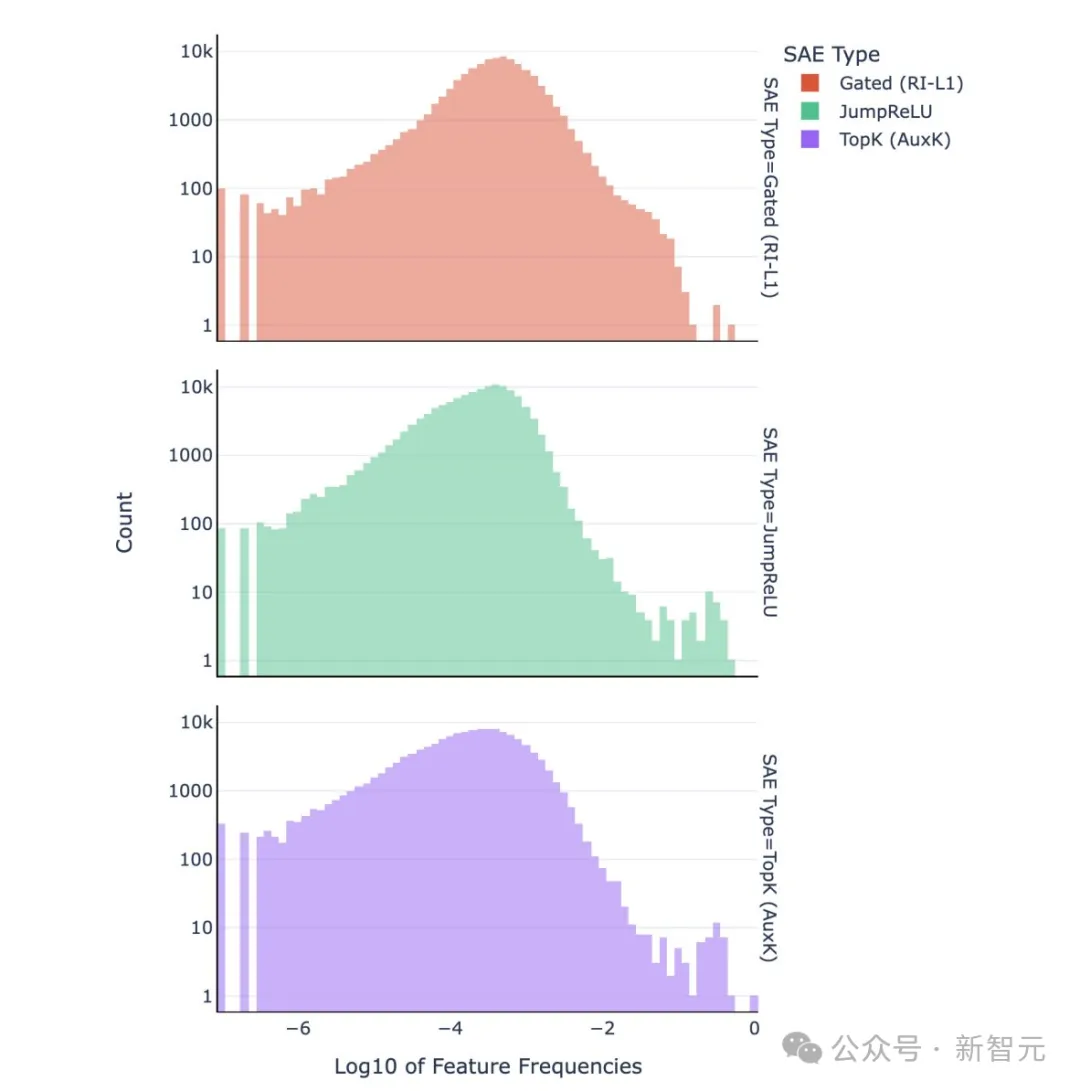

稀疏編碼理論還關注「負載均衡」。它強調稀疏編碼中激活應在不同特征或神經元之間均勻分布。某些研究,如Top-k和JumpReLU架構,發現了嚴重的特征頻率失衡問題:某些特征的高頻觸發會導致字典難以解釋。通過負載均衡正則化可以減輕這一問題,并改善字典的可解釋性。

Tilde目前正在積極研究基于這些理論的新型架構。

通過IB框架理解Top-k方法

最后,博客從信息瓶頸(Information Bottleneck, IB)理論的角度審視Top-k方法。

在訓練稀疏自動編碼器時,激活函數的選擇對字典的稀疏性和學習動態有著重要影響。

傳統上,可以使用ReLU激活函數配合?1正則化,將字典學習視為一個多約束問題:網絡需要同時平衡重建誤差和稀疏性懲罰。在這種方法中,稀疏性是自適應的——輸入越復雜,潛在激活越多,反之亦然。

Top-k方法消除了這種復雜性,直接固定所有輸入的稀疏性水平。它不再需要在稀疏性損失和重建誤差之間權衡,而是只優化重建誤差。

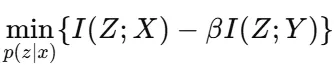

Top-k激活函數在稀疏自動編碼器中的高效性可以通過信息瓶頸框架來理解。該框架平衡了信息保留與壓縮:

1. 希望最小化輸入X與表示Z的互信息I(Z;X),減少冗余;

2. 同時最大化Z與目標Y的互信息I(Z;Y),保留對重建有用的信息。

公式如下:

其中,β調節壓縮和相關信息保留之間的權衡。

通過固定輸入中活動神經元的數量,Top-k方法直接對I(Z;X)施加上限,從而限制了信息流動,并自然優先選擇最具信息量的特征進行重建。與傳統方法平衡稀疏性懲罰和重建的方式不同,Top-k的硬約束簡化了這一動態,僅在設定的稀疏性水平內優化重建精度。

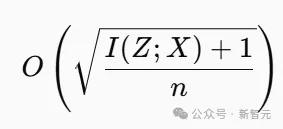

Top-k方法內置了瓶頸效應:通過減少I(Z;X) ,可能提高泛化能力,因為它限制了信息流動。這與泛化理論中的發現一致,該理論將模型復雜性與泛化誤差聯系起來:

其中n是訓練樣本數量。

實際上,Top-k方法強制實施了一種率失真約束,驅使網絡優先考慮穩定性和信號保留,而非噪聲。Tilde研究團隊在實驗中發現,與自適應稀疏方法相比,Top-k方法能夠產生更平滑的學習動態和更強的抗噪性。

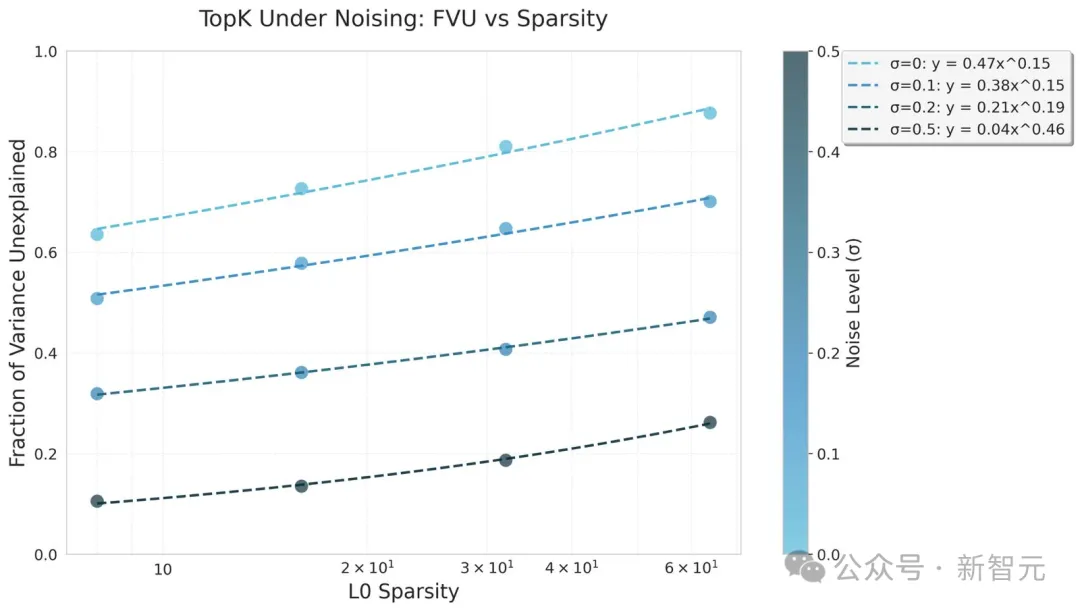

他們在CIFAR10數據集上訓練了Top-k自動編碼器50個周期,并施加了不同的高斯噪聲條件。假設,架構所施加的信息瓶頸能夠提高在高噪聲環境下的魯棒性。

在高斯噪聲條件下的Top-k縮放定律中,信息瓶頸顯著提升了Top-k的魯棒性。實驗發現,Top-k在較高噪聲環境中,冪律擬合的系數有所增加,表明更大的k值能夠更好地從噪聲中恢復信號。此外,訓練動態高度穩定,損失幾乎單調收斂。

與之相對比,在高噪聲設置下測試的ReLU基準模型卻出現了崩潰或發散現象,因此被排除在圖表之外。

該理論為理解稀疏編碼如何在壓縮和重建之間權衡提供了框架。在未來的研究中,Tilde將進一步探討這一方向,并期待為解碼器架構提供新的優化方法。