Andrej Karpathy:神奇大模型不存在的,只是對人類標注的拙劣模仿

大模型回答人類的對話內容,究竟有多少「智能」成分在里面?

本周五,知名 AI 領域學者,OpenAI 創始成員、特斯拉前 AI 高級總監 Andrej Karpathy 發表觀點:「人們對『向人工智能詢問某件事』的解釋過于夸張」,引發網友熱議。

Karpathy 稱:人工智能基本上是通過模仿人工標注數據來進行訓練的語言模型。所以不要將對話視為「詢問人工智能」的神秘主義,而應將其更多地視為「詢問互聯網上的平均數據標注者」。

例如,當你問「阿姆斯特丹十大景點」之類的問題時,一些受雇的數據標簽員可能在某個時候看到了類似的問題,使用谷歌等軟件研究了 20 分鐘,列出了 10 個景點的列表,然后字面意思就變成了正確答案,訓練人工智能給出該問題的答案。如果有問題的確切位置不在微調訓練集中,神經網絡會根據從預訓練階段(互聯網文檔的語言建模)獲得的知識來進行估計。

當有網友評論稱:「RLHF 可以創造超越人類的結果」,Karpathy 表示:「RLHF 仍然是來自人類反饋的 RL,所以我不會這么說」。

Karpathy 認為:RLHF 將模型性能從 SFT 的「人工生成」級別提升到「人工判別」級別。但這與其說是「原則上」,不如說是「實踐上」,因為「判別」對于普通人來說比「生成」更容易(例如,判斷這 5 首關于 X 的詩中哪一首最好,而不是寫一首關于 X 的詩)。

另外,還可以從群體智慧效應中獲得單獨的提升,即 LLM 的性能不是達到人類水平,而是達到人類整體水平。因此,原則上,對于 RLHF,所能期望的最好結果就是達到專家水平。

所以從某種意義上來說,這算是「超人」,但 Karpathy 認為:要按照人們默認的方式成為真正的「超人」,要去 RL 而不是 RLHF。

其實,這已不是 Andrej Karpathy 第一次批判 RLHF 了。作為前 OpenAI 重要成員,他在今年 8 月就和 Yann LeCun 等人一起質疑過由 GPT 系列模型發揚光大的 RLHF 強化學習的意義。

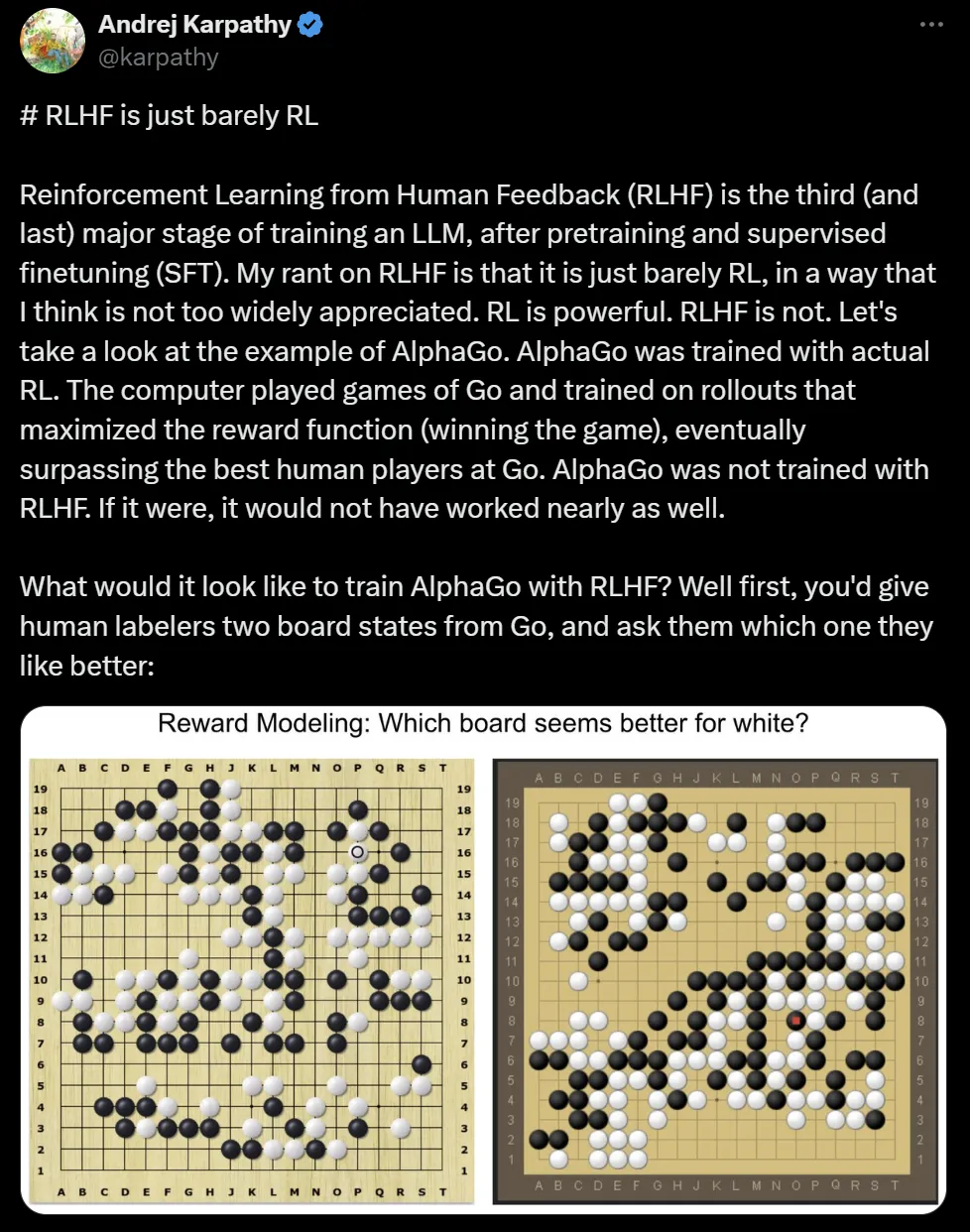

「RLHF 只是勉強算強化學習。」

他當時使用 DeepMind 的 AlphaGo 作為例子。如果我們當時用 RLHF 的方法訓練 AlphaGo 會是什么樣子?可能會既無法構成有效的獎勵,又會形成偏離正常軌道的優化,那就勢必無法創造出「打敗人類世界冠軍」的歷史了。

出于同樣的原因,Karpathy 對 RLHF 竟然適用于 LLM 感到「有點驚訝」。因為我們為 LLM 訓練的 RM(Reward Model)只是以完全相同的方式進行直覺檢查。它會對人類標注者可能喜歡的判斷給出高分,它不是正確解決問題的「實際」目標,而是人類認為好的替代目標。

其次,你甚至不能運行 RLHF 太長時間,因為你的模型很快就會學會適應游戲獎勵模型,再推理出一些不正常的 Token。這在人類看來很荒謬,但出于某種原因 RM 會認為看起來很棒。

無獨有偶,今年 9 月,一篇來自 VRAIN、劍橋大學研究人員的 Nature 論文對 o1-preview 等模型進行了評測,發現很多對于人類來說簡單的任務,大模型卻根本無法解決。而在一些復雜的任務上,LLM 也根本不知道「回避」,而是會裝模作樣的思考一通之后,給出一個錯誤的答案。

雖然隨著時間的推移,大模型的參數體量越來越大,訓練的數據也越來越多,性能也不斷提升,但從基礎機制的角度來說,它們似乎并不靠譜。

如果 RLHF 不管用,還能有什么樣的獎勵機制能幫助大模型「準確遵循指令」呢?

今年 7 月,OpenAI 就公布了一種教導 AI 模型遵守安全政策的新方法,稱為基于規則的獎勵(Rule-Based Rewards,RBR)。RBR 不僅限于安全訓練,它們可以適應各種任務,其中明確的規則可以定義所需的行為,例如為特定應用程序定制模型響應的個性或格式。這或許為大模型下一步性能突破提供了新的思路。