DeepMind用語言游戲讓大模型學(xué)AlphaGo自我博弈,數(shù)據(jù)限制不存在了

我們終于朝著真正自主、自我完善的人工智能邁出了重要一步?

上周末,一篇 Google DeepMind 的論文引發(fā)了 AI 圈的關(guān)注。研究者引入了「蘇格拉底式學(xué)習(xí)」,這是 AI 中遞歸自我完善的一種新方法。這種方法使系統(tǒng)能夠自主增強(qiáng)其能力,超越初始訓(xùn)練數(shù)據(jù)的限制。通過利用結(jié)構(gòu)化的「語言游戲」,該技術(shù)可以為實(shí)現(xiàn)通用人工智能提供了實(shí)用的路線圖。

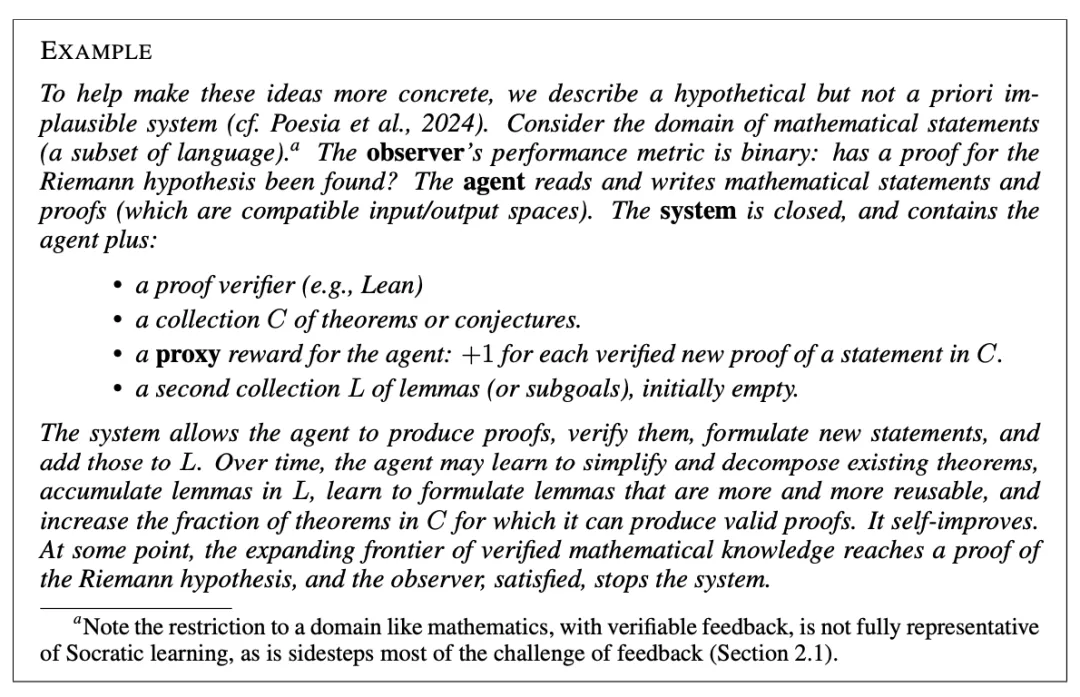

在該工作中,DeepMind 提出的框架圍繞封閉、自給自足的環(huán)境,AI 系統(tǒng)無需外部數(shù)據(jù)即可運(yùn)行。要實(shí)現(xiàn)目標(biāo),智能體必須滿足三個(gè)關(guān)鍵條件:反饋與目標(biāo)一致,廣泛的數(shù)據(jù)覆蓋范圍,以及足夠的計(jì)算資源。這種設(shè)計(jì)促進(jìn)了獨(dú)立學(xué)習(xí),為通向 AGI 提供了一條可擴(kuò)展的途徑,同時(shí)解決了數(shù)據(jù)生成和反饋質(zhì)量等挑戰(zhàn)。

新方法的核心是進(jìn)行「語言游戲」,即智能體之間結(jié)構(gòu)化的交互、解決問題并以分?jǐn)?shù)的形式接收反饋。這些游戲允許人工智能進(jìn)行自我博弈,生成數(shù)據(jù)并完善技能,也無需人工輸入。遞歸結(jié)構(gòu)使系統(tǒng)能夠自主創(chuàng)建和開局新游戲,解鎖更抽象的解決問題的能力并擴(kuò)展其能力。

最終的創(chuàng)新在于 AI 自我改造,智能體不僅可以從環(huán)境中學(xué)習(xí),還可以重新配置其內(nèi)部系統(tǒng)。這樣可以消除固定架構(gòu)帶來的限制,為超過以往的性能改進(jìn)奠定基礎(chǔ)。總之,DeepMind 的研究強(qiáng)調(diào)了蘇格拉底式學(xué)習(xí)作為創(chuàng)造真正自主、自我完善的人工智能的變革性步驟的潛力。

讓我們看看這篇論文是怎么說的:

- 論文標(biāo)題:Boundless Socratic Learning with Language Games

- 論文鏈接:https://arxiv.org/abs/2411.16905

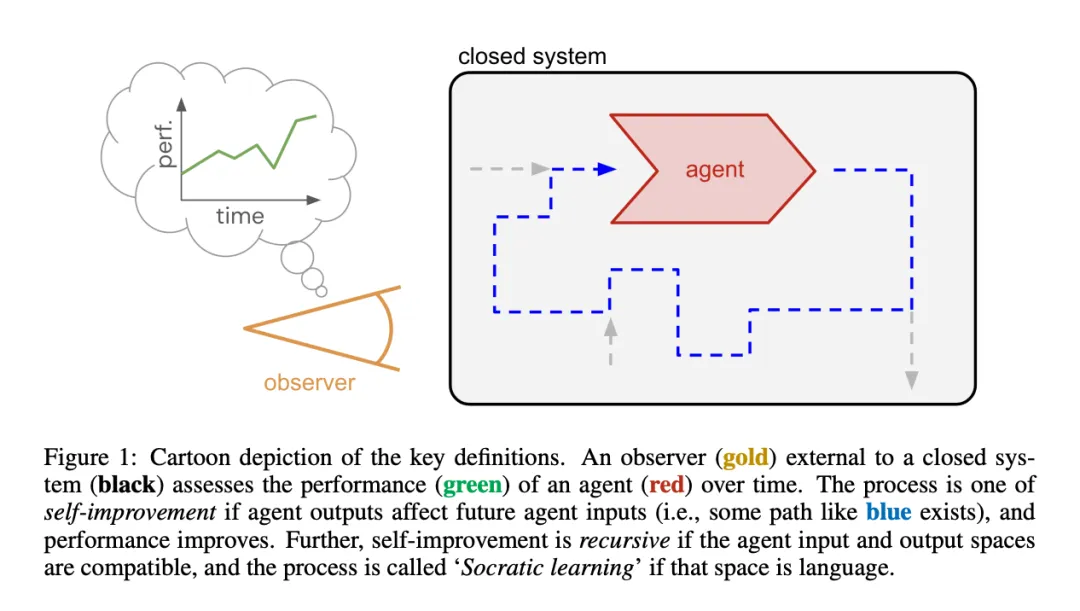

考慮一個(gè)隨時(shí)間演變的封閉系統(tǒng)(無輸入、無輸出)(見圖 1)。系統(tǒng)內(nèi)有一個(gè)具有輸入和輸出的實(shí)體,稱為智能體(Agent),它也會(huì)隨時(shí)間發(fā)生變化。系統(tǒng)外部有一個(gè)觀察者,其目的是評估智能體的性能。如果性能不斷提高,我們就把這對系統(tǒng)和觀察者稱為改進(jìn)過程。

這一過程的動(dòng)態(tài)變化由智能體及其周圍系統(tǒng)共同驅(qū)動(dòng),但為了使評估定義明確,需要設(shè)定明確的邊界:事實(shí)上,智能體就是可以明確評估的對象。同樣,為了分離關(guān)注點(diǎn),觀察者被刻意置于系統(tǒng)之外:由于系統(tǒng)是封閉的,觀察者的評估無法反饋到系統(tǒng)中。因此,智能體的學(xué)習(xí)反饋必須來自系統(tǒng)內(nèi)部的智能體,如損失、獎(jiǎng)勵(lì)函數(shù)、偏好數(shù)據(jù)或批評者。

在這里,最簡單的性能指標(biāo)是一個(gè)標(biāo)量分?jǐn)?shù),可以在有限的時(shí)間內(nèi)測量,也就是在(一系列)偶發(fā)任務(wù)中測量。從機(jī)制上講,觀察者可以通過兩種方式來衡量性能,一是被動(dòng)地觀察智能體在系統(tǒng)中的行為(如果所有相關(guān)任務(wù)都是自然發(fā)生的),二是通過復(fù)制和探測評估,即讓智能體的克隆副本面對自己選擇的交互任務(wù)。

在不失通用性的前提下,智能體內(nèi)部的元素可分為三類:固定元素不受學(xué)習(xí)的影響,例如它的底層或不可修改的代碼;瞬態(tài)元素不會(huì)在不同事件之間或不同評估之間延續(xù)(如激活、隨機(jī)數(shù)生成器的狀態(tài));最后,學(xué)習(xí)元素(如權(quán)重、參數(shù)、知識(shí))會(huì)根據(jù)反饋信號(hào)發(fā)生變化,它們的演變會(huì)映射出性能差異。

可以通過隱含的生命周期來區(qū)分改進(jìn)過程;有些改進(jìn)過程是開放式的,可以無限制地持續(xù)改進(jìn),而有些改進(jìn)過程則會(huì)在某個(gè)有限時(shí)間后收斂到其漸進(jìn)性能。

自我完善的三個(gè)必要條件

DeepMind 研究者認(rèn)為,自我完善是一種改進(jìn)過程,但附加標(biāo)準(zhǔn)是智能體自身的輸出(行動(dòng))會(huì)影響其未來的學(xué)習(xí)。換句話說,智能體在系統(tǒng)中塑造(部分)自己的經(jīng)驗(yàn)流,有可能在封閉系統(tǒng)中實(shí)現(xiàn)無限的改進(jìn)。這種設(shè)置對于強(qiáng)化學(xué)習(xí)社區(qū)(RL)的讀者來說可能很熟悉:RL 智能體的行為會(huì)改變其學(xué)習(xí)的數(shù)據(jù)分布,進(jìn)而影響其行為策略。

自我完善過程的另一個(gè)典型實(shí)例是自我對弈,其中系統(tǒng)(通常稱游戲)將智能體置于玩家和對手的角色中,以生成帶有反饋(誰贏了)的無限經(jīng)驗(yàn)流,為不斷增加的技能學(xué)習(xí)提供方向。從它與 RL 的聯(lián)系中,我們可以得出自我完善發(fā)揮作用的必要條件,并幫助澄清有關(guān)系統(tǒng)的一些假設(shè)。前兩個(gè)條件,反饋和覆蓋度是原則上的可行性,第三個(gè)條件規(guī)模是實(shí)踐上的可行性。

研究者考慮的自我完善過程的具體類型是遞歸自我完善,其中智能體的輸入和輸出是兼容的(即存在于同一空間中),并且輸出成為未來的輸入。與輸出僅影響輸入分布的一般情況相比,這更具限制性,但中立性更低,最常見的實(shí)例是將智能體輸出映射到輸入的(復(fù)雜)環(huán)境。這種類型的遞歸是許多開放式過程的屬性,開放式改進(jìn)可以說是 ASI 的核心特征。

這種兼容的輸入和輸出空間的一個(gè)極好的例子就是語言。人類的大量行為都是通過語言來介導(dǎo)和表達(dá)的,尤其是在認(rèn)知領(lǐng)域(從定義上講,認(rèn)知領(lǐng)域是 ASI 的一部分)。正如查爾默斯 (2024) 和他之前幾個(gè)世紀(jì)的理性主義者所言,語言可能足以進(jìn)行思考和理解,而不需要感官基礎(chǔ)。語言又同時(shí)具有抽象的巧妙特性,可以在共享空間中編碼概念層次結(jié)構(gòu)的多個(gè)級(jí)別。

在文章的其余部分,研究者使用「蘇格拉底式學(xué)習(xí)」來指代在語言空間中運(yùn)作的遞歸式自我完善過程。這個(gè)名字暗示了蘇格拉底通過質(zhì)疑對話和反復(fù)的語言互動(dòng)來尋找或提煉知識(shí)的方法。但值得注意的是,這種方法并不是去收集現(xiàn)實(shí)世界中的觀察結(jié)果 —— 這反映了系統(tǒng)強(qiáng)調(diào)的封閉性。

蘇格拉底式學(xué)習(xí)的本質(zhì)局限性

在自我完善的三個(gè)必要條件中,覆蓋和反饋這兩個(gè)條件原則上適用于蘇格拉底式學(xué)習(xí),而且仍然是不可還原的。為了盡可能清楚地說明這兩個(gè)條件的含義,本節(jié)中忽略了第三個(gè)條件(規(guī)模、實(shí)用性和效率問題),而從長遠(yuǎn)的角度來考慮這種簡化的動(dòng)機(jī):如果計(jì)算能力和內(nèi)存繼續(xù)呈指數(shù)增長,那么規(guī)模限制只是暫時(shí)的障礙。如果不是這樣,考慮蘇格拉底式學(xué)習(xí)的資源受限情景(類似于研究有界理性)仍能產(chǎn)生有效的洞察。

覆蓋條件意味著蘇格拉底學(xué)習(xí)系統(tǒng)必須不斷生成(語言)數(shù)據(jù),同時(shí)隨著時(shí)間的推移保持或擴(kuò)大多樣性。在 LLM 時(shí)代,這似乎并不太牽強(qiáng):我們可以設(shè)想,一個(gè)生成智能體初始化時(shí)擁有類似互聯(lián)網(wǎng)的廣泛分布,它可以生成永無止境的新語言表達(dá)流。然而,在遞歸過程中防止生成分布的漂移、崩潰或縮小可能非常困難。

反饋條件要求系統(tǒng):(a)持續(xù)產(chǎn)生關(guān)于智能體輸出(某些子集)的反饋,這在結(jié)構(gòu)上要求批評者能夠評估語言,(b)反饋與觀察者的評估指標(biāo)保持足夠一致。這造成挑戰(zhàn)的原因有很多:語言空間中定義明確、有依據(jù)的衡量標(biāo)準(zhǔn)往往局限于狹隘的任務(wù),而人工智能反饋等通用性更強(qiáng)的機(jī)制則可以加以利用,尤其是在允許輸入分布發(fā)生變化的情況下。

例如,目前的 LLM 訓(xùn)練范式都沒有足以滿足蘇格拉底式學(xué)習(xí)的反饋機(jī)制。下一個(gè) token 的預(yù)測損失是有依據(jù)的,但與下游的使用情況不夠一致,而且無法推斷出訓(xùn)練數(shù)據(jù)之外的情況。根據(jù)定義,人類的偏好是一致的,但卻阻礙了在封閉系統(tǒng)中的學(xué)習(xí)。將這種偏好緩存到已學(xué)習(xí)的獎(jiǎng)勵(lì)模型中會(huì)使其自成一體,但從長遠(yuǎn)來看會(huì)被利用并可能出現(xiàn)錯(cuò)位,而且對分布外數(shù)據(jù)的影響也很微弱。

換句話說,純粹的蘇格拉底式學(xué)習(xí)是可能的,但它需要廣泛的數(shù)據(jù)生成和強(qiáng)大且一致的批評能力。然而,當(dāng)這些條件都具備時(shí),其潛在改進(jìn)的上限就會(huì)受到應(yīng)用資源量的限制。目前已有的研究還沒有為此制定出成功的方法,接下來的內(nèi)容會(huì)就如何進(jìn)行蘇格拉底式學(xué)習(xí)提出一個(gè)具體但相當(dāng)籠統(tǒng)的建議。

「Language games are all you need」

在該研究中,研究者認(rèn)為 AI 的訓(xùn)練可以借鑒維特根斯坦的語言游戲概念。在其中,并不是讓詞語捕捉意義,而是讓語言的互動(dòng)性做到這一點(diǎn)。具體來說,語言游戲定義為一種互動(dòng)協(xié)議(一組規(guī)則,可以用代碼表達(dá)),它指定了一個(gè)或多個(gè)具有語言輸入和語言輸出的智能體(「玩家」)之間的互動(dòng),以及游戲結(jié)束時(shí)每個(gè)玩家的標(biāo)量評分函數(shù)。

如此定義的語言游戲滿足了蘇格拉底式學(xué)習(xí)的兩個(gè)主要需求。即,1)它們?yōu)闊o限制的交互式數(shù)據(jù)生成和自我博弈提供了一種可擴(kuò)展的機(jī)制,2 同時(shí)自動(dòng)提供伴隨的反饋信號(hào)(分?jǐn)?shù))。

事實(shí)上,它們是覆蓋和反饋條件的邏輯結(jié)果,幾乎一直在被應(yīng)用。如果將這個(gè)過程視為游戲過程,我們就立即可以意識(shí)到多智能體動(dòng)態(tài)產(chǎn)生的豐富策略具有很大潛力。

另外,許多常見的 LLM 交互范式也可以被很好地表示為語言游戲,例如辯論、角色扮演、心智理論、談判、越獄攻防,或在封閉系統(tǒng)之外,來自人類反饋的 RL 等范式 (RLHF)。

回到哲學(xué)家:我們能想象他們玩上幾千年的語言游戲嗎?相反,也許他們在玩多種語言游戲時(shí)更有可能擺脫狹隘的結(jié)果。維特根斯坦(又是他)也提出過同樣的觀點(diǎn):他堅(jiān)決反對語言具有單一的本質(zhì)或功能。使用許多狹義但定義明確的語言游戲而不是單一的通用游戲,可以解決一個(gè)關(guān)鍵的兩難問題:對于每個(gè)狹義游戲,都可以設(shè)計(jì)出可靠的得分函數(shù)(或批評家),而正確地獲得單一的通用函數(shù)則更加難以捉摸(即使原則上是可能的,正如 Silver 等人所論證的那樣)。從這個(gè)角度看,蘇格拉底式學(xué)習(xí)的整個(gè)過程就是一個(gè)元游戲,它安排了智能體玩的語言游戲并從中學(xué)習(xí)(根據(jù) Carse (2011),這是一個(gè)「無限」游戲)。

研究者認(rèn)為,原則上這一想法足以解決覆蓋問題。具體來說,如果有觀察者感興趣的分布的智能體(例如,任務(wù)的驗(yàn)證集),就可以用來驅(qū)動(dòng)元游戲中的探索。

正如蘇格拉底本人的經(jīng)歷,蘇格拉底式的思考過程并不能保證與外部觀察者的意圖保持一致。語言游戲作為一種機(jī)制,也沒有回避這一點(diǎn),但可以說,它降低了所需的精確度:我們所需要的不是一個(gè)在單個(gè)輸入和輸出的細(xì)粒度上保持一致的批評家,而是一個(gè)能夠判斷哪些游戲應(yīng)該玩的「元批評家」:也許沒有一個(gè)語言游戲是完全一致的,但可以做的是,根據(jù)它們是否(在玩和學(xué)習(xí)時(shí))做出了總體上積極的凈貢獻(xiàn),對眾多游戲進(jìn)行篩選。

此外,一個(gè)游戲的有用性并不需要事先評估,而是可以在玩過一段時(shí)間之后進(jìn)行事后判斷。與此相關(guān),一個(gè)有益的不對稱現(xiàn)象是,事后發(fā)現(xiàn)偏差的突發(fā)行為可能比設(shè)計(jì)游戲防止這種行為要容易得多。所有這些特性都是結(jié)構(gòu)上的寬松形式,賦予了語言游戲框架巨大的擴(kuò)展?jié)摿Α簳r(shí)跳出此處對封閉系統(tǒng)的假設(shè):當(dāng)我們實(shí)際構(gòu)建人工智能時(shí),我們幾乎肯定不會(huì)樂觀地相信對齊會(huì)得到保持,而是會(huì)盡可能仔細(xì)地持續(xù)檢查這一過程,并可能在整個(gè)訓(xùn)練過程中對系統(tǒng)進(jìn)行干預(yù)和調(diào)整。

在這種情況下,明確地將游戲分布(伴隨著可解釋的游戲描述和每個(gè)游戲的學(xué)習(xí)曲線)作為旋鈕提供給設(shè)計(jì)者,可能是一種有用的抽象方法。

更高階的遞歸

到目前為止,本文討論了遞歸的最低必要形式,即一種將智能體(部分)輸出反饋給自身的循環(huán)形式。在語言游戲的框架內(nèi),研究者還想到了另外兩種遞歸形式。第一種思路是告訴智能體它正在玩哪個(gè)游戲,并讓它選擇切換游戲、切換到哪個(gè)游戲以及何時(shí)切換。

這與分層或以目標(biāo)為條件的 RL 有關(guān),為智能體提供了更多的自主權(quán)和更抽象的行動(dòng)空間。在將更多責(zé)任轉(zhuǎn)移給智能體的同時(shí),與智能體外部的硬聯(lián)線游戲選擇過程相比,這種設(shè)置可以顯著改善結(jié)果,但當(dāng)然,這種額外的自由度可能會(huì)帶來崩潰或錯(cuò)位的額外風(fēng)險(xiǎn)。

其次,由于游戲是可以完全用代碼表示的交互協(xié)議,因此它們可以存在于語言智能體的輸出空間中。一開始,它可以簡單地生成現(xiàn)有游戲的局部變體,從而調(diào)整主題的難度水平,之后再對游戲進(jìn)行重組,最終實(shí)現(xiàn)全新生成。這導(dǎo)致了語言游戲空間而非語言空間的二階覆蓋問題,需要通過過濾、優(yōu)先排序或課程來解決。

這兩種遞歸擴(kuò)展的結(jié)合就是一個(gè)有能力的智能體,它可以通過游戲的生成和玩耍來玩完整的元游戲,即如何改進(jìn)自己。這種元博弈雖然優(yōu)雅動(dòng)人,但卻缺乏內(nèi)部語言博弈的明確反饋機(jī)制,而且像學(xué)習(xí)進(jìn)度這樣的既定智能體指標(biāo)是否足以長期保持覆蓋和對齊特性,也是一個(gè)有待研究的問題。

遞歸的下一步,也是最后一步是遞歸自我改造,也就是說,智能體的行為會(huì)改變其自身的內(nèi)部結(jié)構(gòu),而不僅僅是影響其輸入流。這些方法的特點(diǎn)是可以以這種方式修改哪些內(nèi)容(哪些內(nèi)容保持不變),以及智能體可以進(jìn)行多少自省,或者說可以訪問其自身的工作原理。在極端情況下,一個(gè)完全自我反省的智能體可以觀察和修改自身的任何方面,而無需間接操作。

原則上,這種類型的智能體具有最高的能力上限;由于漸進(jìn)性能受到其固定結(jié)構(gòu)的限制,解凍部分結(jié)構(gòu)并使其可修改只會(huì)增加上限。尤其是,總有可能將新靈活參數(shù)設(shè)置為凍結(jié)時(shí)的狀態(tài),以恢復(fù)靈活性較低的智能體的性能(在不考慮學(xué)習(xí)動(dòng)力的情況下)。

從這種角度看,過去關(guān)于如何設(shè)計(jì)自我參照系統(tǒng)的建議并不實(shí)用,但現(xiàn)代 LLM 在代碼理解和生成方面的能力正在改變競爭環(huán)境,可能很快就會(huì)將這些想法從空洞轉(zhuǎn)向關(guān)鍵。

參考內(nèi)容:

https://x.com/kimmonismus/status/1862993274727793047。