OpenAI圣誕第9天:滿血o1 API放出,開(kāi)發(fā)者大狂歡!實(shí)時(shí)API升級(jí)音頻token暴降60%

圣誕日第九天,OpenAI向第三方開(kāi)發(fā)者開(kāi)放了最強(qiáng)模型o1。

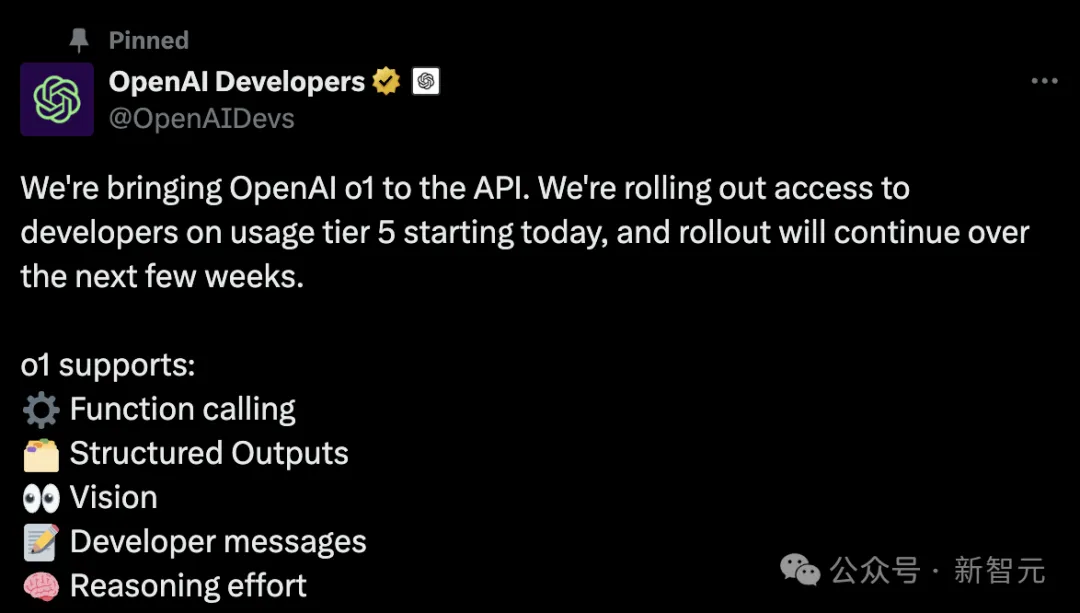

API中的o1,可支持函數(shù)調(diào)用、開(kāi)發(fā)者消息、結(jié)構(gòu)化輸出和視覺(jué)功能。

同時(shí),在開(kāi)發(fā)語(yǔ)音類App的API中,集成了更先進(jìn)的GPT-4o版本,成本直降60%!

另外,用戶和開(kāi)發(fā)者可根據(jù)自己的偏好,用「偏好微調(diào)」輕松定制模型了。

Day 9,是名副其實(shí)的「對(duì)開(kāi)發(fā)者最有用的一天」。

與此同時(shí),團(tuán)隊(duì)還進(jìn)行了了一場(chǎng)在線AMA,解答了開(kāi)發(fā)者的諸多問(wèn)題。

Day 9,給開(kāi)發(fā)者的新功能

今天,OpenAI將正式在API中推出o1滿血版。

自從9月推出o1-preview之后,開(kāi)發(fā)者們已經(jīng)在API上構(gòu)建出了大量很酷的應(yīng)用程序,比如智能體、客戶支持、財(cái)務(wù)分析等,同時(shí)它的編程技能也很出色。

但開(kāi)發(fā)者們反饋說(shuō),API中缺乏了一些核心功能,因此,OpenAI今天會(huì)一并推出這些新功能。

此外,還有一些小更新,比如推理強(qiáng)度參數(shù)。這是一個(gè)新的參數(shù),告訴模型去花多少時(shí)間思考。

在解決簡(jiǎn)單問(wèn)題時(shí),這個(gè)參數(shù)可以節(jié)省許多時(shí)間和成本,在需要更多算力的復(fù)雜問(wèn)題上,就可以花費(fèi)更多資源。

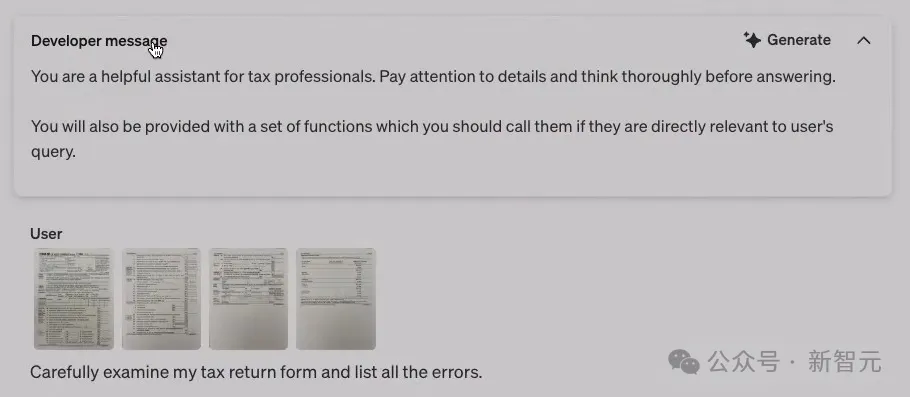

開(kāi)發(fā)者消息,視覺(jué)輸入功能,函數(shù)調(diào)用功能

開(kāi)發(fā)者消息功能,是系統(tǒng)消息的一種新形式,實(shí)際上是OpenAI指令層次結(jié)構(gòu)工作的一部分。

它會(huì)用來(lái)教模型,按照什么順序遵循哪種指令。因此,開(kāi)發(fā)者可以完全控制開(kāi)發(fā)者消息來(lái)引導(dǎo)模型。

此外,OpenAI還在API中推出了視覺(jué)輸入功能。

很多用戶強(qiáng)烈呼吁這個(gè)功能上線,可以想見(jiàn),它在制造業(yè)、科學(xué)等領(lǐng)域,會(huì)提供非常大的幫助。

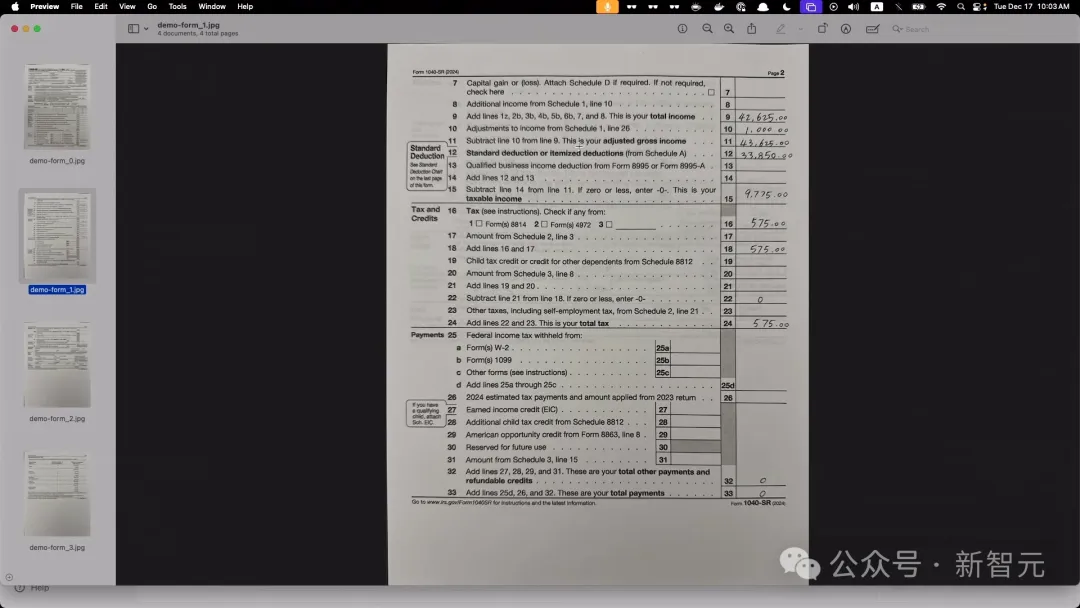

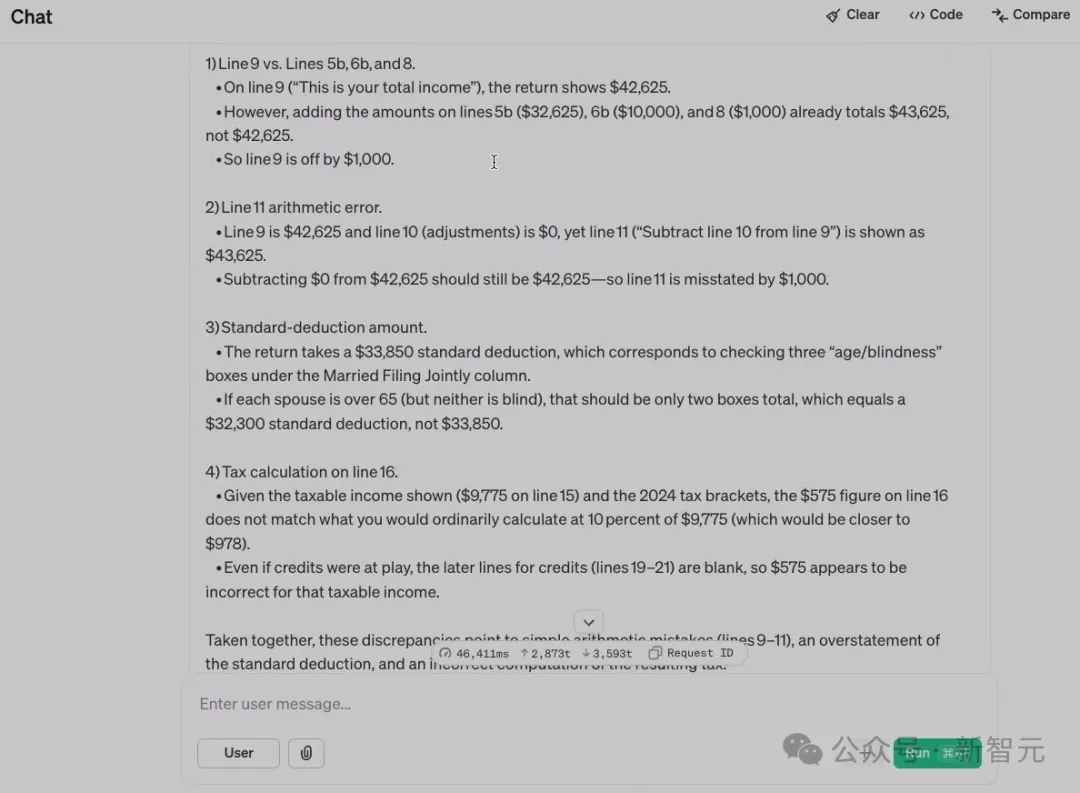

在demo中,研究者給了模型一份表格的照片掃描件,有若干張。

注意,研究者填寫(xiě)的時(shí)候,故意填錯(cuò)了一些數(shù)據(jù)。o1是否能檢測(cè)出這些錯(cuò)誤呢?

在開(kāi)發(fā)者消息中,研究者要求模型找出錯(cuò)誤。如果要正確找出,必須其他幾張照片的掃描。

果然,模型注意到了某一行的算術(shù)錯(cuò)誤,還注意到標(biāo)準(zhǔn)扣除額不準(zhǔn)確這種非常細(xì)節(jié)的問(wèn)題。

改正錯(cuò)誤后,研究者提問(wèn)道:如果我的應(yīng)稅收入是這個(gè),我要繳納多少所得稅?

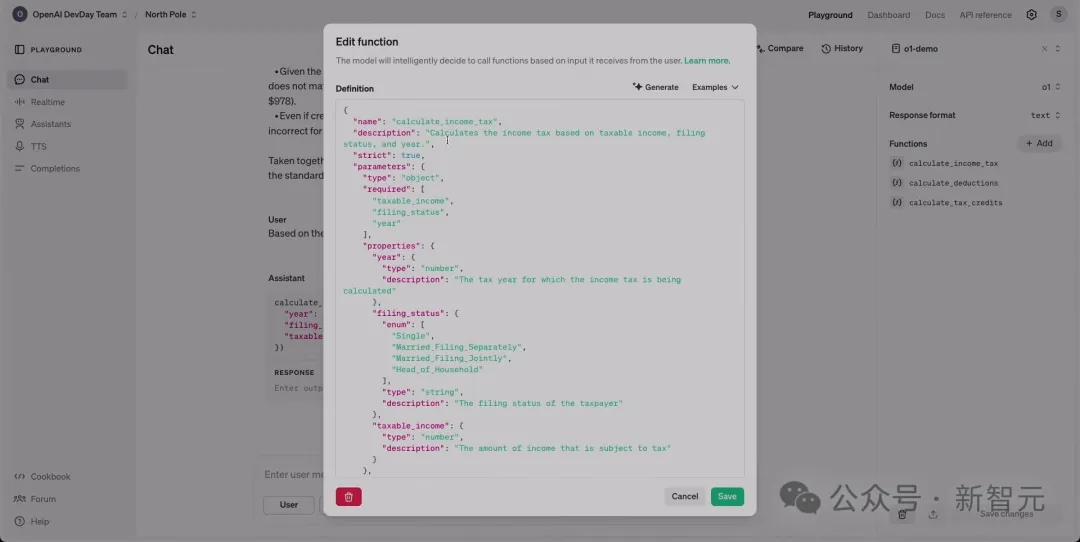

可以看到,o1在右側(cè)提供了一組函數(shù)。

比如其中一個(gè)函數(shù),就是以JSON架構(gòu)呈現(xiàn)

這些操作都在應(yīng)用程序后端完成,用戶看不到任何函數(shù)調(diào)用或來(lái)自API的響應(yīng)。

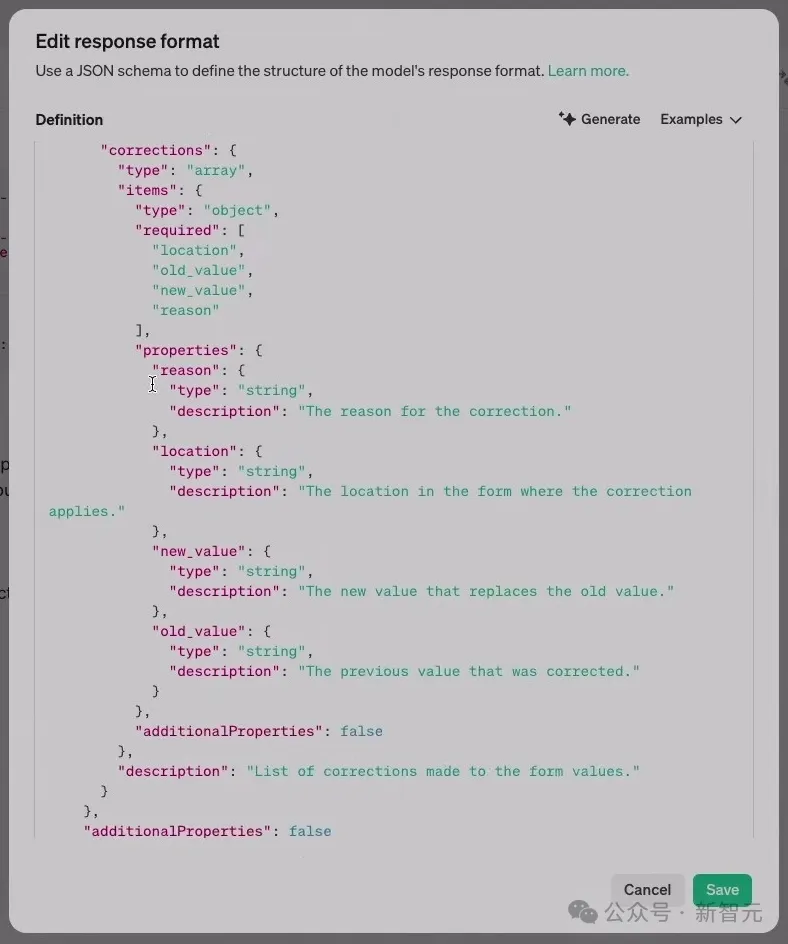

此外,研究者還定義了一個(gè)JSON架構(gòu),來(lái)規(guī)范響應(yīng)的格式。

在上面這個(gè)「表單修正」架構(gòu)中,包含了一組修正,每個(gè)修正都包含錯(cuò)誤原因等內(nèi)容,這樣就可以向用戶展示哪里出錯(cuò)了。

甚至還能為PDF渲染一個(gè)用戶界面,高亮出出錯(cuò)的地方。在我們不想從模型中渲染Markdown時(shí),結(jié)構(gòu)化輸出特別有用,它讓我們可以直接自動(dòng)提取JSON。

最終,模型正確輸出了修正結(jié)果。

API使用場(chǎng)景評(píng)估

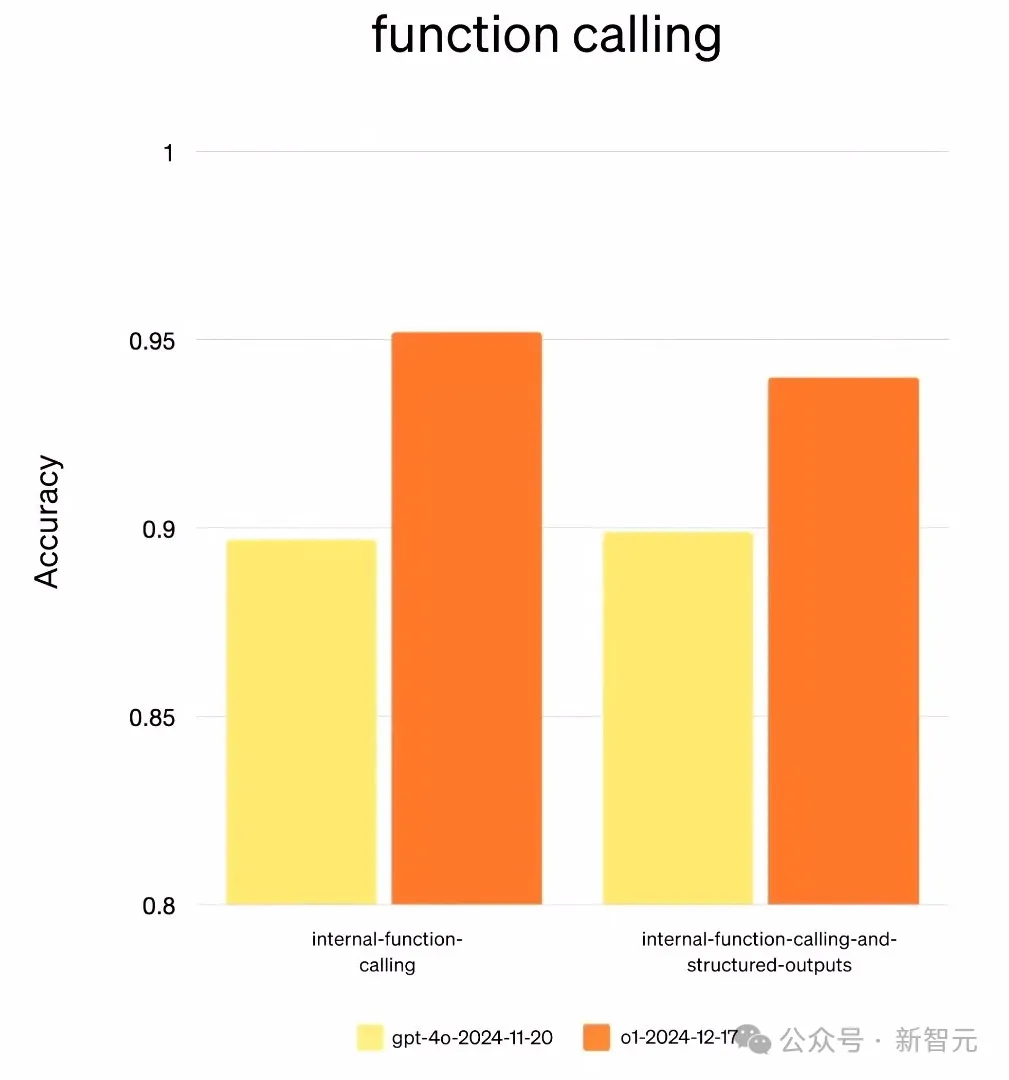

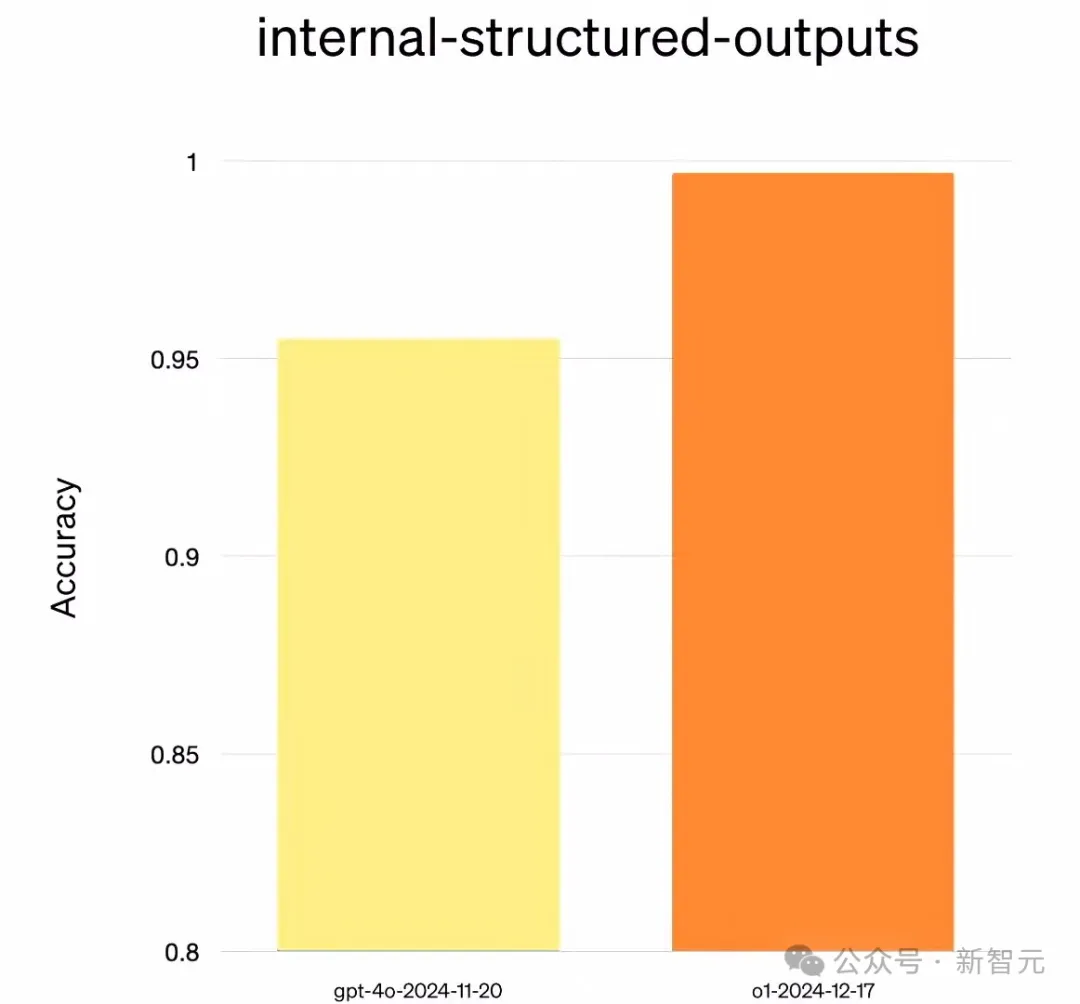

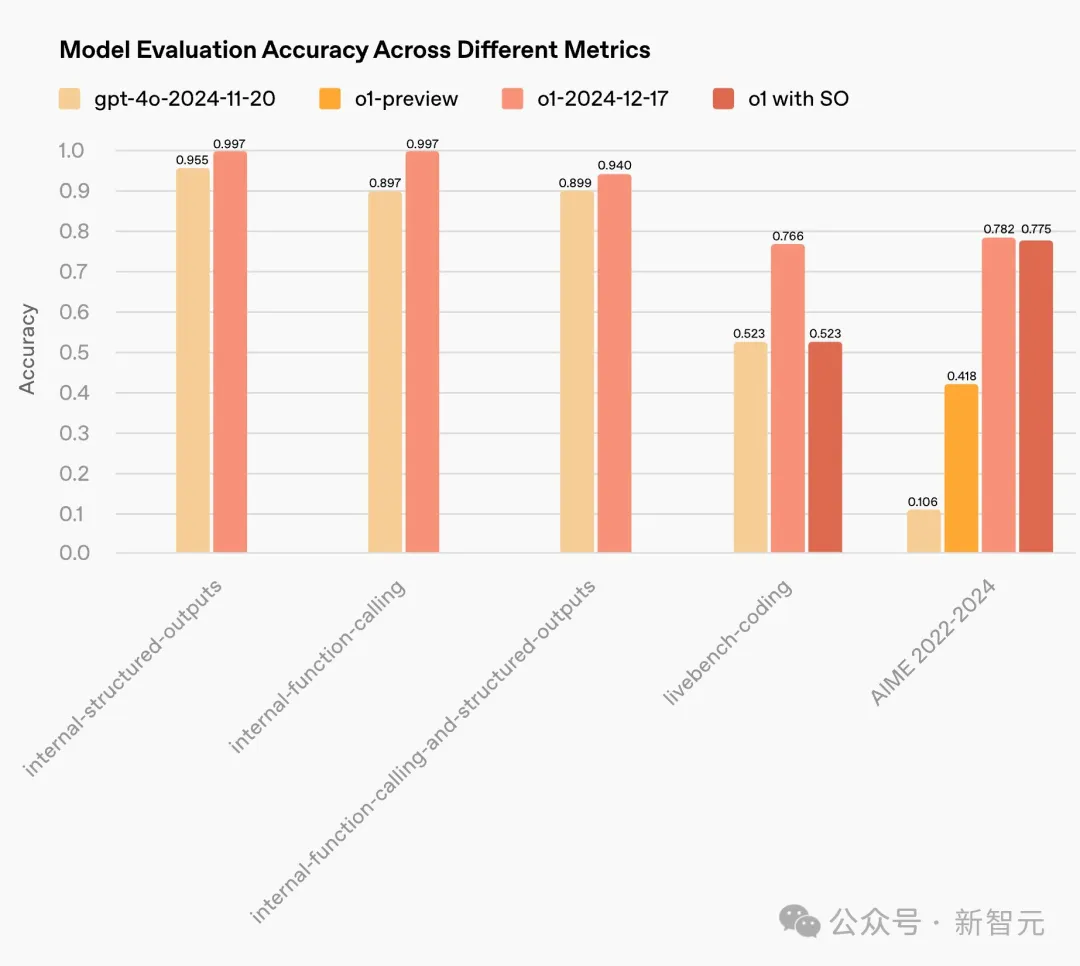

針對(duì)API用例,OpenAI研究者進(jìn)行了一些評(píng)估。

首先,在函數(shù)調(diào)用功能上,新的o1模型在函數(shù)調(diào)用能力上顯著優(yōu)于GPT-4。

這包含了兩個(gè)關(guān)鍵部分——在需要時(shí)調(diào)用正確的函數(shù),以及在不需要時(shí)避免調(diào)用函數(shù)。

另外,我們還可以將函數(shù)調(diào)用與結(jié)構(gòu)化輸出結(jié)合。

可以看到,o1比起GPT-4,同樣表現(xiàn)出色。

在結(jié)構(gòu)化輸出中,o1在評(píng)估中也顯著優(yōu)于其他模型。

這意味著,模型在指令遵循上的表示更佳,在給出特定條件約束時(shí),偏離預(yù)期的可能性也更低。

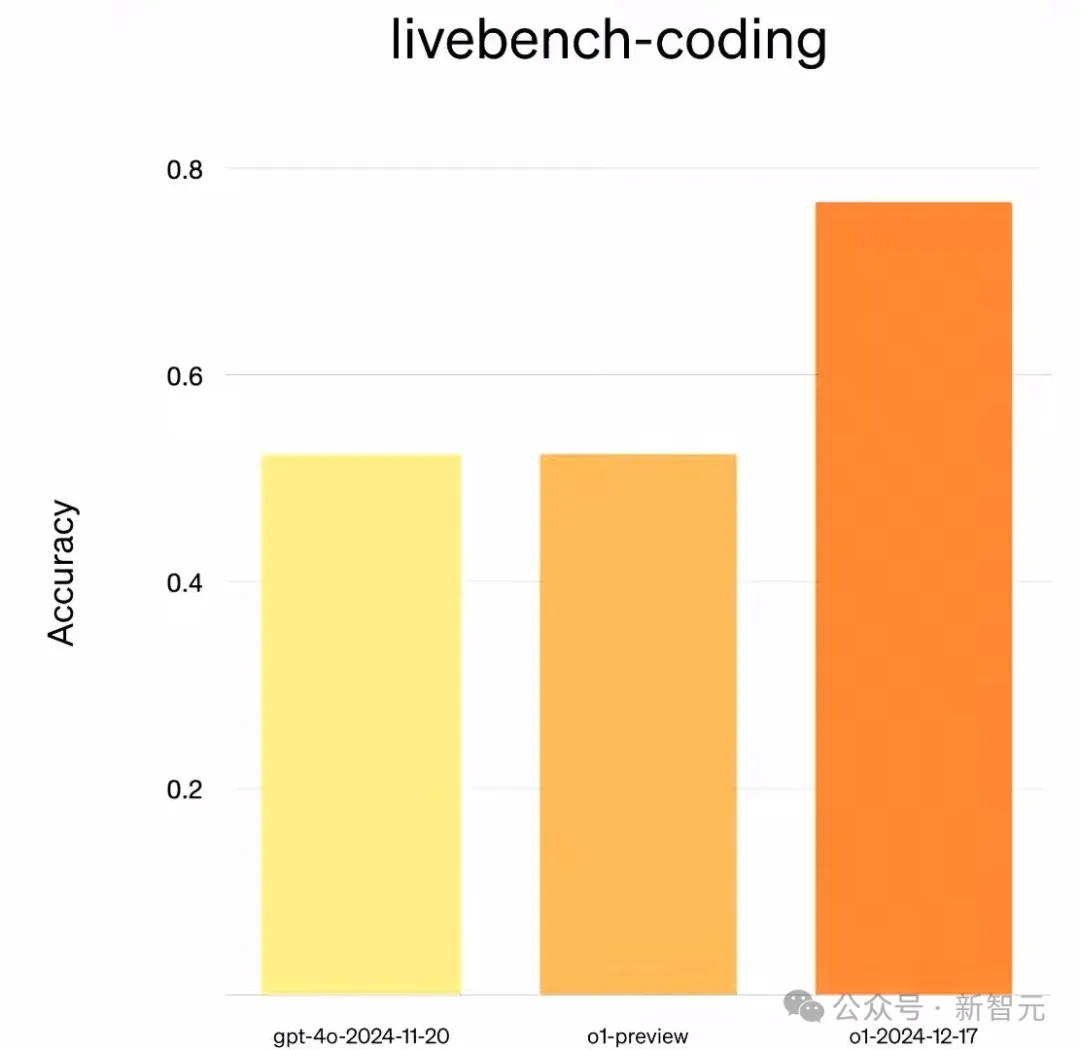

在編碼方面,o1在Livebench評(píng)估中,要遠(yuǎn)遠(yuǎn)優(yōu)于o1-preview和GPT-4o,這是一個(gè)巨大的進(jìn)步。

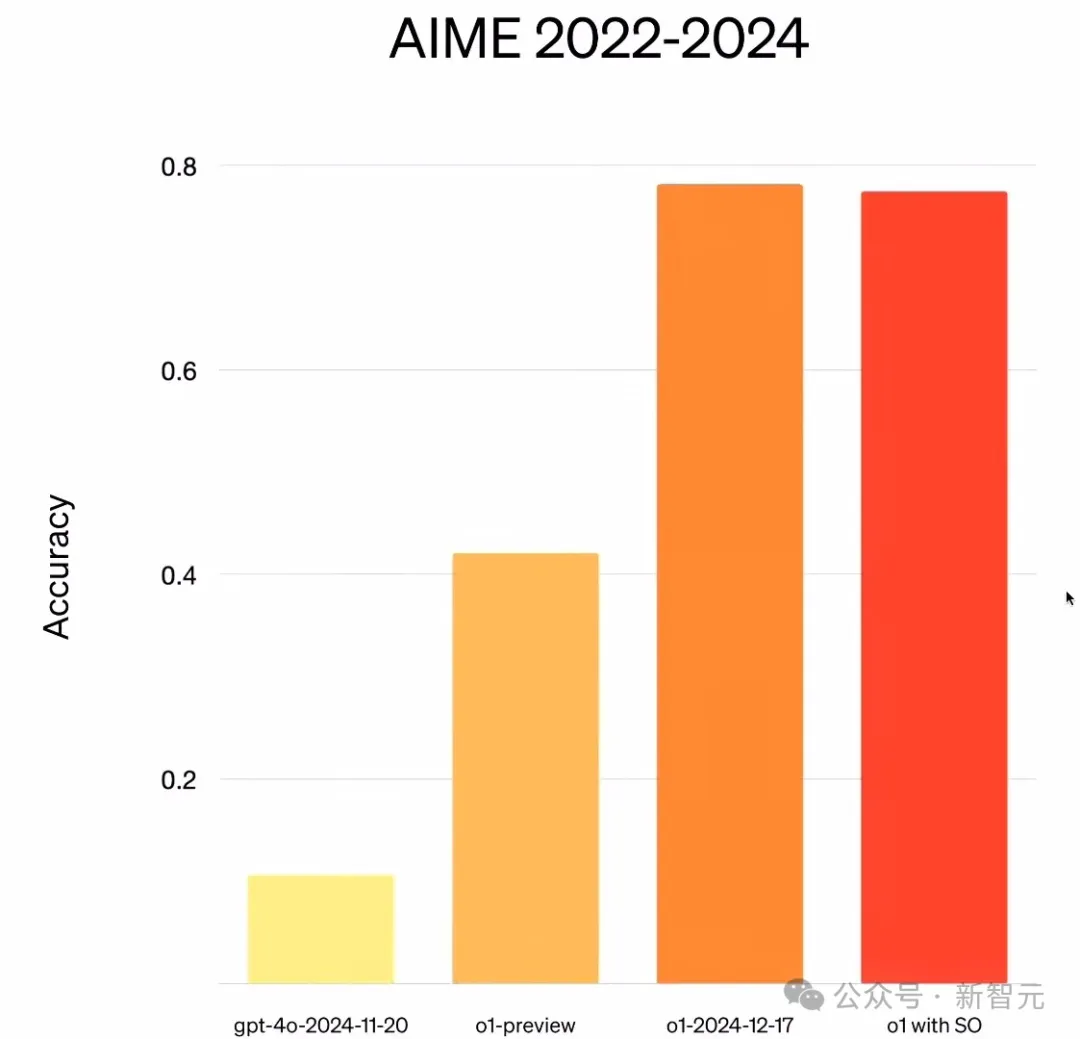

而在AIME評(píng)估中,o1再次顯著優(yōu)于o1-preview。

有趣的是,最右側(cè)是帶有結(jié)構(gòu)化輸出的o1。

在構(gòu)建結(jié)構(gòu)化輸出時(shí),研究者希望確保模型在使用此功能和未使用時(shí)表現(xiàn)同樣出色。

可以看到,即使啟動(dòng)了此功能,模型的推理能力依舊保持。因此我們可以放心在應(yīng)用程序中使用,不必?fù)?dān)心結(jié)果的準(zhǔn)確性。

另外,模型在延遲上的變化也很有趣。

o1使用的推理Token,比o1-preview少了60%,因此對(duì)應(yīng)用程序來(lái)說(shuō),它的運(yùn)行速度更快、成本更低。

最后,研究者強(qiáng)調(diào),抱歉暫時(shí)不會(huì)在API中推出o1 Pro,雖然此類請(qǐng)求非常多。

從今天起,函數(shù)調(diào)用、編碼、結(jié)構(gòu)化輸出、開(kāi)發(fā)者消息和圖像理解,就會(huì)向第五級(jí)用戶開(kāi)放了。幾周時(shí)間內(nèi),將覆蓋到所有用戶。

實(shí)時(shí)API,Her可以自己構(gòu)建了

Realtime API(實(shí)時(shí)API)在今年10月初,正式放出了公測(cè)版。

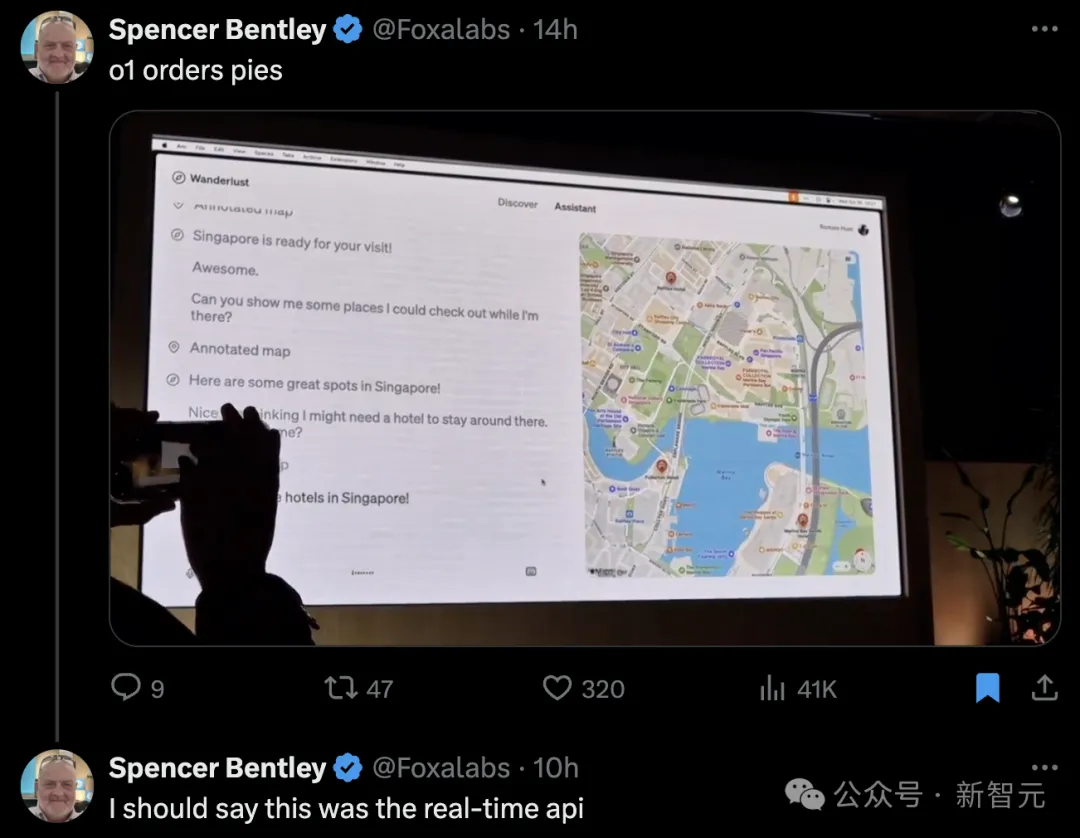

在OpenAI倫敦開(kāi)發(fā)者日上,所有人或許早已對(duì)其強(qiáng)大的實(shí)時(shí)語(yǔ)音能力有所了解。現(xiàn)場(chǎng),開(kāi)發(fā)者體驗(yàn)主管Romain Huet秀如何通過(guò)實(shí)時(shí)API訂購(gòu)派。

想象一下,你可以直接通過(guò)這個(gè)API構(gòu)建ChatGPT高級(jí)語(yǔ)音模式了!不論是訂餐AI助手,還是旅游AI助手等等,有了它就可以實(shí)現(xiàn)許多非常酷炫的功能。

它能夠支持網(wǎng)絡(luò)傳輸協(xié)議WebSocket,因此,你可以通過(guò)服務(wù)器進(jìn)行通信,發(fā)語(yǔ)音并接受響應(yīng)。

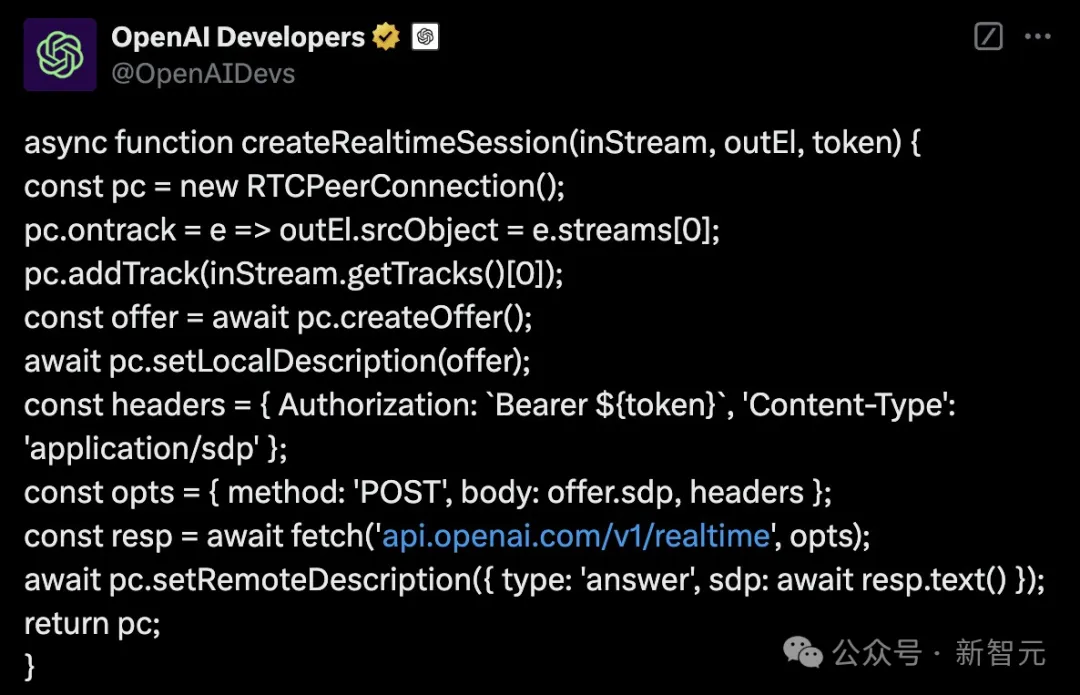

而在今天,OpenAI正式宣布實(shí)時(shí)API將支持WebRTC——專為互聯(lián)網(wǎng)而生。

我們常見(jiàn)的視頻會(huì)議,或者低延遲的視頻流傳輸,都采用了WebRTC。它能夠?qū)崟r(shí)處理互聯(lián)網(wǎng)不斷的變化,比如動(dòng)態(tài)調(diào)整比特率、進(jìn)行回聲消除。

現(xiàn)在,實(shí)時(shí)API也能共享這些優(yōu)勢(shì)了。假設(shè)你要構(gòu)建一個(gè)應(yīng)用程序,能省去不少功夫,可以直接運(yùn)行。

接下來(lái),OpenAI研究人員展示了一個(gè)demo,如下是HTML代碼,包含了一個(gè)音頻元素,一個(gè)對(duì)等連接(peer connection),它代表著你和實(shí)時(shí)API之間的一對(duì)一連接。

演示的重點(diǎn),就是創(chuàng)建這個(gè)對(duì)等連接。當(dāng)實(shí)時(shí)API向你發(fā)送音頻時(shí),把它放入到音頻元素中。

緊接著,就是捕獲麥克風(fēng)輸入的聲音,并將其添加到對(duì)等連接中。首先,傳輸一個(gè)音頻流到OpenAI,然后在設(shè)置好對(duì)等鏈接后,執(zhí)行一個(gè)offer/answer操作。

offer/answer的作用是收集本地的所有信息。開(kāi)發(fā)者通過(guò)HTTP POST發(fā)送這些信息,然后模型會(huì)作出響應(yīng)。

然后,WebRTC 會(huì)為你處理所有細(xì)節(jié),就不需要再去操心擁塞控制、音頻捕捉等等。

那么,這個(gè)與之前WebSocket集成,有什么區(qū)別?

前者代碼行數(shù)會(huì)大大拉長(zhǎng),達(dá)到200到250行,而且,在此基礎(chǔ)上還會(huì)遇到其他的問(wèn)題,比如處理反壓(back pressure)等等。

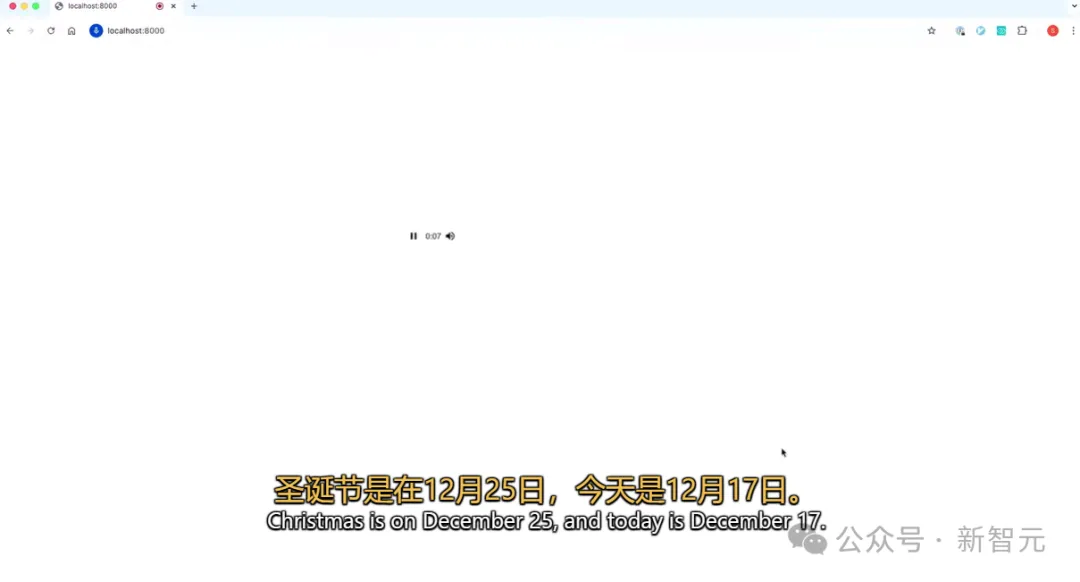

接下來(lái),運(yùn)行一行代碼,來(lái)看看它實(shí)際的樣子。

音頻元素——「圣誕節(jié)還有多少天?圣誕節(jié)是12月25日,而今天是12月17日。這意味著離圣誕節(jié)還有8天」。

剩余所做的,就是將其代碼復(fù)制粘貼12行代碼,執(zhí)行腳本,就完成了。

這里,你唯一需要修改的就是 API Token,然后你就可以下載這段代碼并運(yùn)行。

OpenAI官方已經(jīng)放出了所有代碼,大家都可以隨時(shí)構(gòu)建。

令人驚喜的是,研究員請(qǐng)出了一位小伙伴——小鹿,它里面有一個(gè)微型控制器,大小如同一枚硬幣。

插上電源之后,小鹿突然間活了,「圣誕快樂(lè)!你們?cè)谡務(wù)撌裁础梗?/span>

研究人員回復(fù)道,「我們正在討論如何將WebRTC集成到實(shí)時(shí)API中」。

小鹿表示,「這聽(tīng)起來(lái)對(duì)我來(lái)說(shuō)有點(diǎn)復(fù)雜。我們能不能聊點(diǎn)更有趣的事情,比如送禮物」?

接下來(lái),研究人員和小鹿完成一輪精彩對(duì)話,完全展現(xiàn)了實(shí)時(shí)API的強(qiáng)大應(yīng)用,而這只是所有用例的冰山一角。

這樣,你就可以將其配置在任何可以穿戴的設(shè)備上,比如眼鏡、攝像頭、麥克風(fēng)等等。而且,全程也只需30-45分鐘。

此外,OpenAI還對(duì)實(shí)時(shí)API做了其他的更新。

從現(xiàn)在開(kāi)始,GPT-4o音頻Token將比以前便宜 60%,并在API中提供了對(duì)4o-mini的支持,其音頻音頻Token成本降低到當(dāng)前價(jià)格的1/10。

其次,他們還為實(shí)時(shí)API推出了對(duì)Python SDK 的支持,使集成更加簡(jiǎn)單。

最后,還有一些API改進(jìn),讓開(kāi)發(fā)者更容易使用函數(shù)編碼和安全防護(hù)機(jī)制。

偏好微調(diào)和定制化

關(guān)于微調(diào)和定制化,是開(kāi)發(fā)者非常重要的一項(xiàng)功能,能夠針對(duì)使用場(chǎng)景去定制模型。

直播現(xiàn)場(chǎng),OpenAI官宣了全新的微調(diào)方法——偏好微調(diào)(preference fine-tuning)。通過(guò)使用直接偏好優(yōu)化(DPO)能幫助開(kāi)發(fā)者創(chuàng)建更符合用戶偏好的模型。

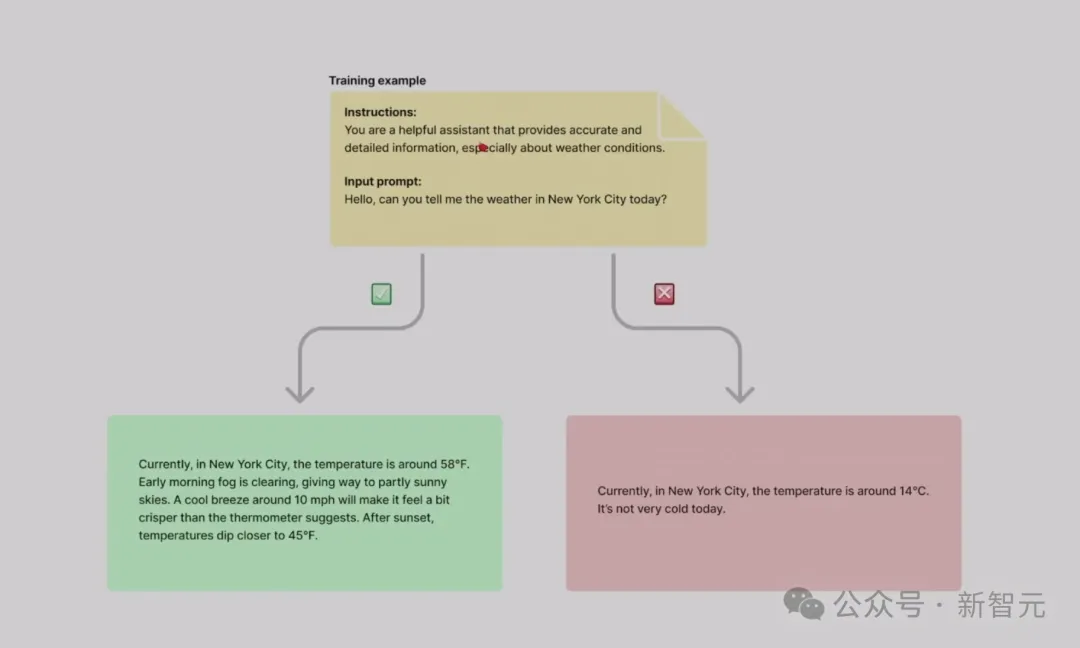

具體來(lái)說(shuō),它是在比較不同回答中定制模型,而非使用固定的目標(biāo)。

過(guò)去幾個(gè)月,OpenAI火力全開(kāi),但微調(diào)API已經(jīng)發(fā)布有一年的時(shí)間了,這次究竟有什么不同?

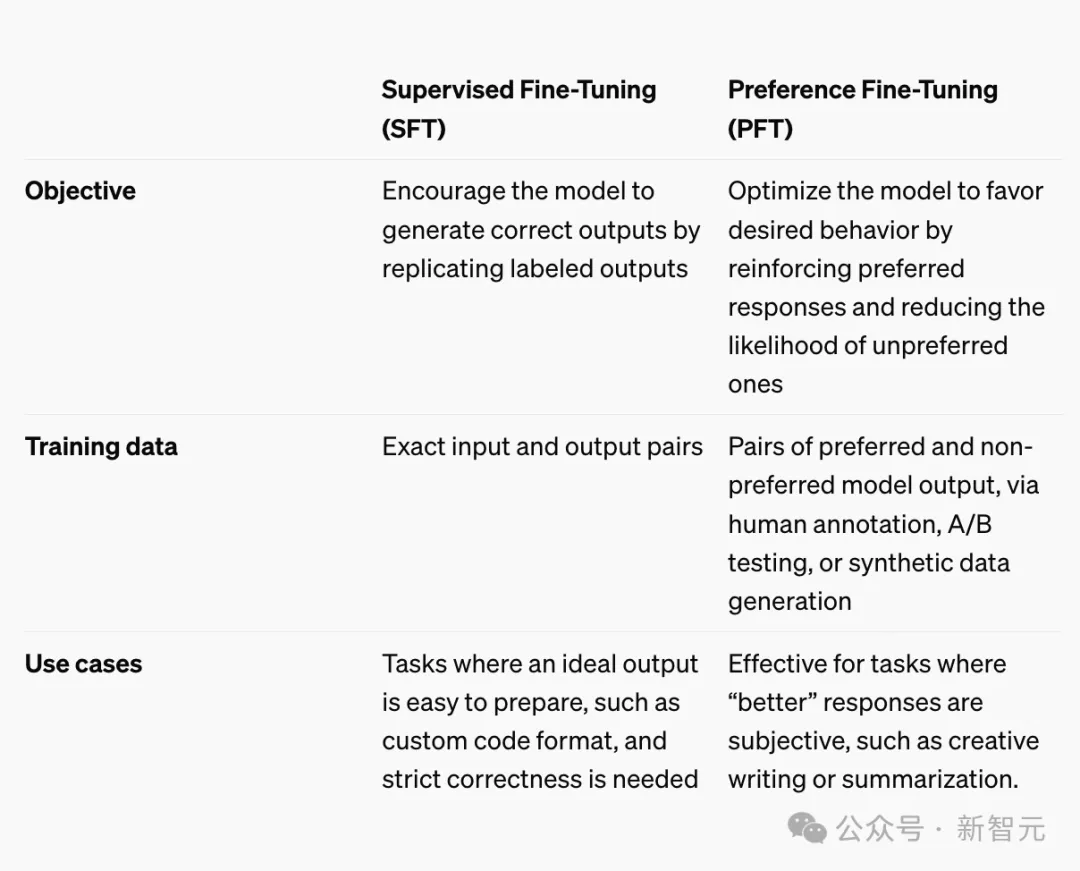

目前,在API中,他們推出了監(jiān)督微調(diào)、以及前幾天新推出的強(qiáng)化微調(diào)(RFT)。

在監(jiān)督微調(diào)中,開(kāi)發(fā)者需要提供模型需要的精確輸入和輸出,比如創(chuàng)建一個(gè)聊天機(jī)器人,就需要提供用戶的消息以及精確的回復(fù)。

而在偏好微調(diào)中,有所不同。

你不需要提供精確的輸入和輸出,僅需要提供一對(duì)一響應(yīng),其中一個(gè)回應(yīng)偏好度比另一個(gè)更強(qiáng)。

然后,微調(diào)過(guò)程便會(huì)優(yōu)化模型,讓其學(xué)會(huì)區(qū)分這些響應(yīng)之間的差異。

這些差異可能包括響應(yīng)格式、風(fēng)格指南,甚至是一些抽象的特質(zhì),比如有用性或創(chuàng)造力。

那么,這種方法有什么樣的特定用例場(chǎng)景?

客戶支持、內(nèi)容創(chuàng)作、創(chuàng)意寫(xiě)作等等,尤其是,適用于那些需要考慮語(yǔ)氣、風(fēng)格和創(chuàng)造力的主觀任務(wù)。

如果在此過(guò)程中,開(kāi)發(fā)者認(rèn)為模型結(jié)果過(guò)于冗長(zhǎng),或者給出答案并不相關(guān),就可以通過(guò)強(qiáng)化偏好的行為,并弱化不偏好的行為,來(lái)引導(dǎo)它生成更簡(jiǎn)潔、更相關(guān)的響應(yīng)。

另一個(gè)非常好的使用場(chǎng)景可能是,內(nèi)容審核或內(nèi)容管理。

接下來(lái),研究人員演示了如何通過(guò)API實(shí)現(xiàn)簡(jiǎn)單微調(diào),先進(jìn)入微調(diào)頁(yè)面,點(diǎn)擊「創(chuàng)建微調(diào)」選項(xiàng),會(huì)看到一個(gè)新方法的下拉菜單。

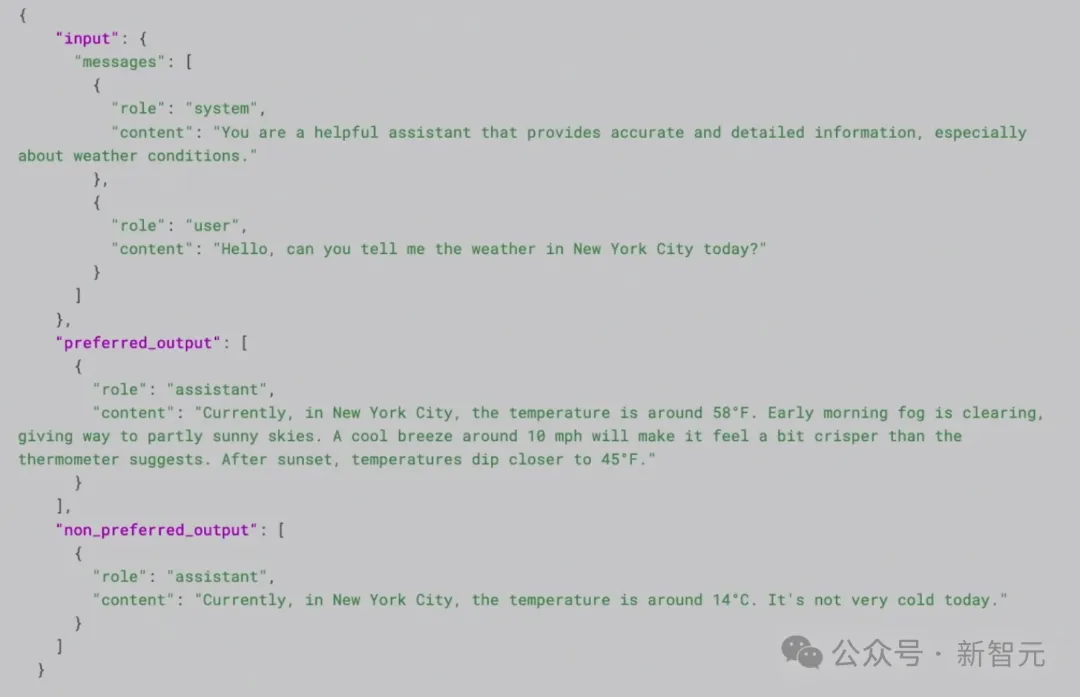

選擇「直接偏好優(yōu)化」方法,然后在選擇基礎(chǔ)模型——GPT-4o。最后,需要做的就是上傳數(shù)據(jù)。

假設(shè)需要做一個(gè)聊天機(jī)器人,讓其更具對(duì)話性。這下面這個(gè)示例這種,是向助手詢問(wèn)紐約市天氣的兩組響應(yīng)。

在首選的響應(yīng)中,回復(fù)更加詳細(xì),使用的是華氏度。而在不理想的響應(yīng)中,回復(fù)更為簡(jiǎn)潔,使用了攝氏度。

然后,將這些示例放入JSONL文件中,每個(gè)示例都包含了輸入消息、偏好/非偏好的輸出。

數(shù)據(jù)上傳之后,再提供一些超參數(shù)(選擇默認(rèn)值),然后點(diǎn)擊「創(chuàng)建」。

這樣,微調(diào)過(guò)程就啟動(dòng)了。根據(jù)數(shù)據(jù)集的大小,這一過(guò)程可能需要幾分鐘到幾小時(shí)不等。

一旦完成之后,我們能夠像在API中任何基礎(chǔ)模型一樣,從新模型中采樣。

目前,OpenAI已經(jīng)向合作伙伴提供了偏好微調(diào)的早期訪問(wèn)權(quán)限,并收到了不錯(cuò)的反饋。

舉個(gè)栗子,Rogo AI開(kāi)發(fā)了一個(gè)面向金融分析師的AI助手,通過(guò)使用OpenAI模型重寫(xiě)、重構(gòu)用戶查詢,以生成更相關(guān)的答案。

在使用監(jiān)督微調(diào)時(shí),他們未能使模型表現(xiàn)超越基礎(chǔ)模型。但通過(guò)偏好微調(diào),他們?cè)趦?nèi)部基準(zhǔn)測(cè)試中的準(zhǔn)確率從基礎(chǔ)模型的75%提升超80%。

鑒于GPT4o偏好微調(diào)所取得的成果,OpenAI預(yù)計(jì)很快將為GPT4o mini提供相同功能。同時(shí),其訓(xùn)練Token的定價(jià)將與監(jiān)督微調(diào)相同。

總言之,今天的OpenAI發(fā)布,對(duì)于開(kāi)發(fā)者來(lái)說(shuō),是一個(gè)大禮包。

滿血版o1引入API,具備了完整的生產(chǎn)功能集,而且函數(shù)編碼功能,從今天起逐步推廣到Tier 5。

另外,實(shí)時(shí)API能夠支持WebRTC集成,以及token價(jià)格下降,以及偏好微調(diào)讓場(chǎng)景定制模型更加容易。

而這些還不是全部,OpenAI今天還在一直持續(xù)推出新功能。

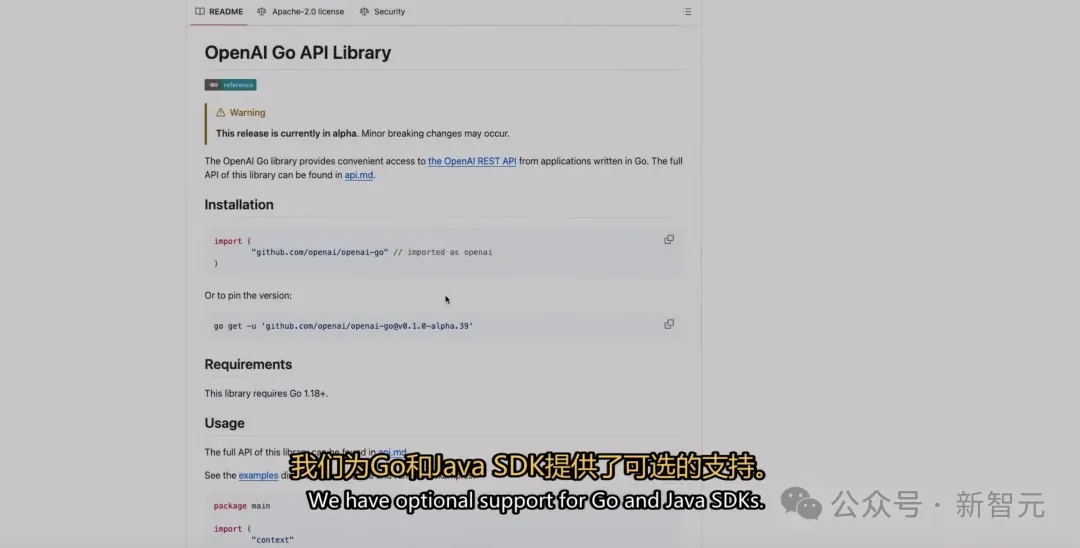

首先,在提升開(kāi)發(fā)者體驗(yàn)和產(chǎn)品質(zhì)量方面,OpenAI發(fā)布了新的SDK,新增對(duì)Go和Java SDK的支持。與Python SDK和Node SDK類似,它們支持OpenAI上所有你需要的API端點(diǎn)。

其次,在簡(jiǎn)化流程上,他們也推出了一個(gè)全新的登錄、注冊(cè)、獲取API密鑰的流程。現(xiàn)在,不需要簽署5份服務(wù)條款協(xié)議,開(kāi)發(fā)者即可在幾秒鐘內(nèi)獲取API密鑰。

最后還有一個(gè)小彩蛋,過(guò)去幾個(gè)月,OpenAI在世界各地舉辦了大大小小開(kāi)發(fā)者日。

如今,他們將這些現(xiàn)場(chǎng)視頻全部公開(kāi)了,只需進(jìn)入OpenAI官方Y(jié)ouTube頁(yè)面即可查看。

信息量有點(diǎn)大,接下來(lái)可以慢慢消化了。