Kimi硬剛多模態滿血版o1,首曝訓練細節!強化學習scaling新范式誕生

還記得嗎,AI大神Karpathy曾說過,「英文是最熱門的編程語言」。

兩年后的現在,這個規則徹底要被顛覆了。

從今天起,中文很有可能成為全球最熱門的編程語言!

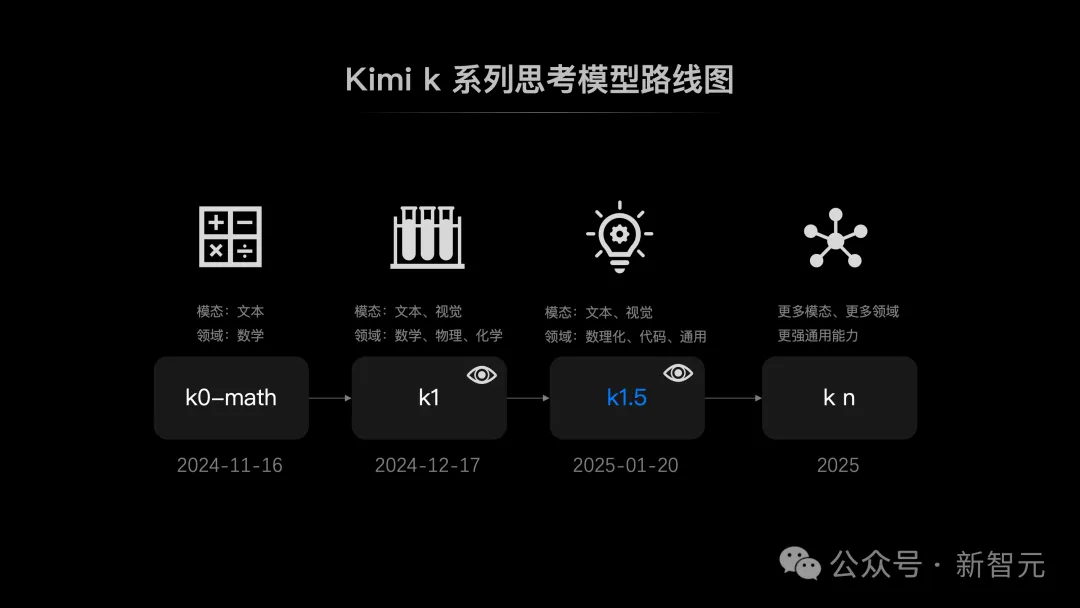

就在剛剛,Kimi發布了k1.5 多模態思考模型。這是繼去年 11 月他們發布 k0-math 數學模型,12月發布 k1 視覺思考模型之后,連續第三個月帶來 k 系列強化學習模型的重磅升級。

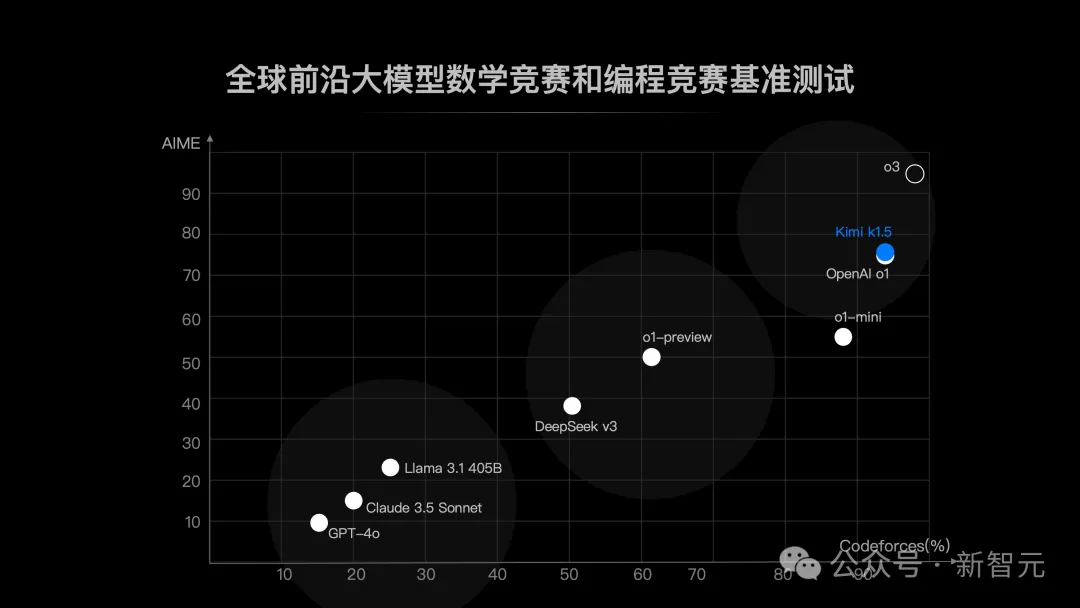

Kimi k1.5的性能,如今已經全面追上現役全球最強模型——OpenAI o1滿血版。

具體來說,在Long CoT模式下,Kimi k1.5的數學、代碼、多模態推理能力,達到了長思考SOTA模型OpenAI o1滿血版的水平。這也是全球范圍內,首次有OpenAI之外的公司達到。

而在Short CoT模式下,Kimi k1.5大幅領先GPT-4o 和Claude 3.5的水平。

短COT模式下,數學成績顯著高于GPT-4o和Claude Sonnet 3.5

同時,月之暗面也大方公開了這個滿血版o1水平的強化學習模型的訓練技術細節。

簡單出奇跡,首創long2short思維鏈

扒開Kimi k1.5 25頁技術報告,可以清晰看到這款模型的技術創新之處。

當前,基于下一個token預測的語言模型,在計算規模上的擴展,已經得到了有效證明。

但模型Scaling仍受限于可用的數據量,為此,Kimi團隊創新性地擴展了強化學習(RL)的應用,開辟出一條全新的路徑。

它能夠讓LLM通過獎勵機制進行探索性學習,從而自主擴展訓練數據,從而實現計算規模有效擴展。

論文地址:https://github.com/MoonshotAI/kimi-k1.5

以下,是k1.5設計和訓練的四大關鍵要素:

1. 長上下文擴展

2. 改進的策略優化

3. 簡化框架

4. 多模態

接下來,我們一起深挖一下這些技術細節吧。

短CoT模型的上下文壓縮

與業界普遍采用復雜技術做法不同,Kimi團隊選擇了一條更為優雅的技術路線——回歸第一性原理。

他們證明了,無需依賴蒙特卡洛樹搜索、價值函數、過程獎勵模型,也能讓模型取得卓越的性能。

如上所見,我們已經看到了Kimi k1.5在多個權威基準測試中,取得了顯著的突破。

那么,long2short是如何被實現的呢?

Kimi團隊認為,可以將長CoT模型的推理先驗轉移到短CoT模型中,從而即使在有限的測試Token預算下也能提高性能。

模型合并

將長CoT模型和短CoT模型進行合并,除了可以在泛化性上起到積極的作用,還可以提高Token的使用效率。

這種方法通過簡單地平均兩個模型的權重,將一個長CoT模型與一個短模型結合,得到一個新的模型,而無需進行訓練。

最短篩選采樣

由于模型對于同一問題生成的響應長度變化很大,因此團隊設計了一種最短篩選采樣方法。

也就是,先對同一問題采樣n次,然后選擇最短的正確響應進行監督微調。

DPO

利用長CoT模型生成多個響應樣本,然后選擇最短的正確解作為正樣本,并將較長的響應視為負樣本,包括正確但長度是選定正樣本1.5倍的較長響應。

這些正負樣本對數據集形成了用于DPO訓練的成對偏好數據。

long2short強化學習

在標準強化學習訓練階段之后,團隊選擇了一個在性能與Token使用效率之間提供最佳平衡的模型作為基礎模型,并進行單獨的long2short強化學習訓練階段。

在第二階段中,他們應用了「長度懲罰」,并顯著減少了最大展開長度,以進一步懲罰可能正確但超出期望長度的響應。

強化學習基礎設施

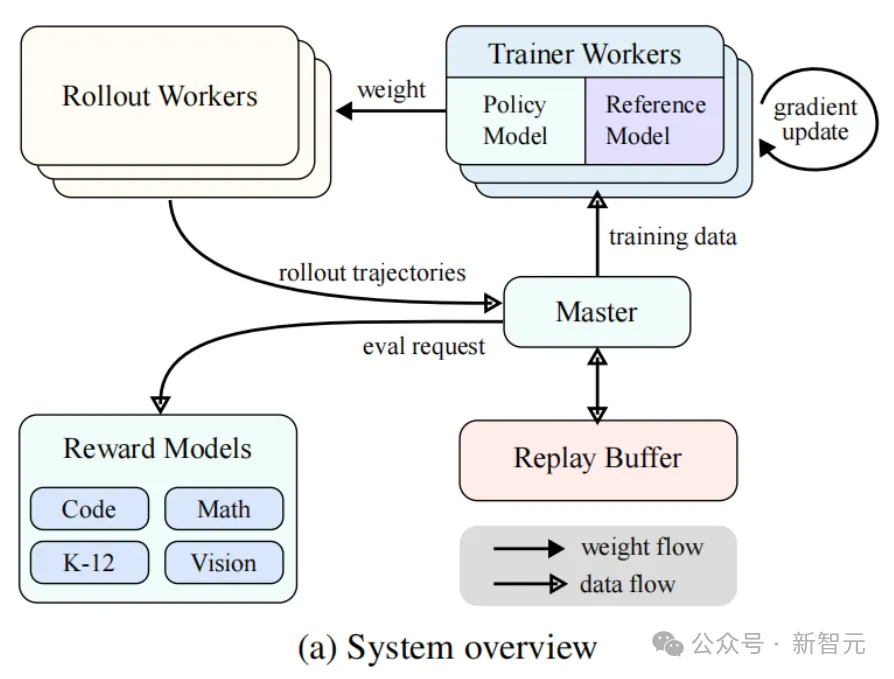

Kimi k1.5系統設計了一種迭代同步的RL框架,旨在通過持續的學習與適應來增強模型的推理能力。

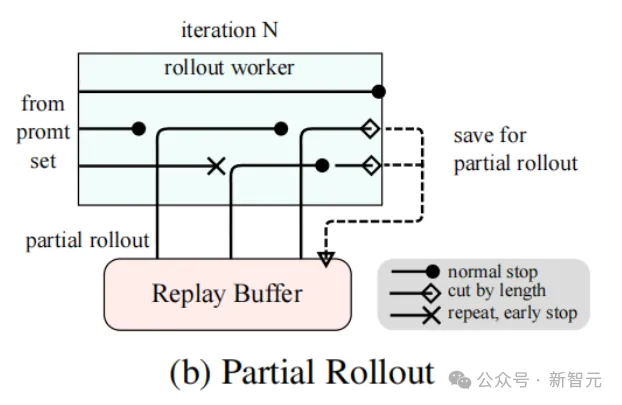

該系統的一項關鍵創新是引入了部分回滾(Partial Rollout)技術,用于減少計算開銷并優化復雜推理軌跡的處理。

如下圖3a所示,RL訓練系統通過迭代同步的方法運行,每次迭代包含回滾階段和訓練階段。

在回滾階段,由中央主控協調的回滾工作節點通過與模型交互生成回滾軌跡,這些軌跡是模型對各種輸入生成的響應序列。在隨后的訓練階段,訓練工作節點訪問這些經驗以更新模型的權重。

這個循環過程使模型能夠持續從其行為中學習,隨著時間的推移調整其策略以提升性能。

長CoT強化學習的部分回滾技術

部分回滾(Partial Rollouts)能夠通過同時管理長軌跡和短軌跡的回滾,有效地解決處理長CoT特性時的資源分配和效率挑戰,進而實現長上下文強化學習(RL)訓練的規模擴展。

該技術設定了一個固定的輸出Token預算,對每個回滾軌跡的長度進行限制。如果某個軌跡在回滾階段超過了Token限制,其未完成部分被保存到重放緩沖區,并在后續迭代中繼續處理。

此外,由于回滾工作節點是異步運行的,當某些節點處理長軌跡時,其他節點可以獨立地處理新的短回滾任務。

如圖3b所示,部分回滾系統通過在多次迭代中將長響應分解為多個片段來運行,顯著降低了計算開銷——系統無需一次性處理整個響應,而是逐步處理和存儲片段,從而在保持快速迭代時間的同時生成更長的響應。

部分回滾的實現還提供了重復檢測功能。系統能夠識別生成內容中的重復序列并提前終止,從而減少不必要的計算,同時保持輸出質量。

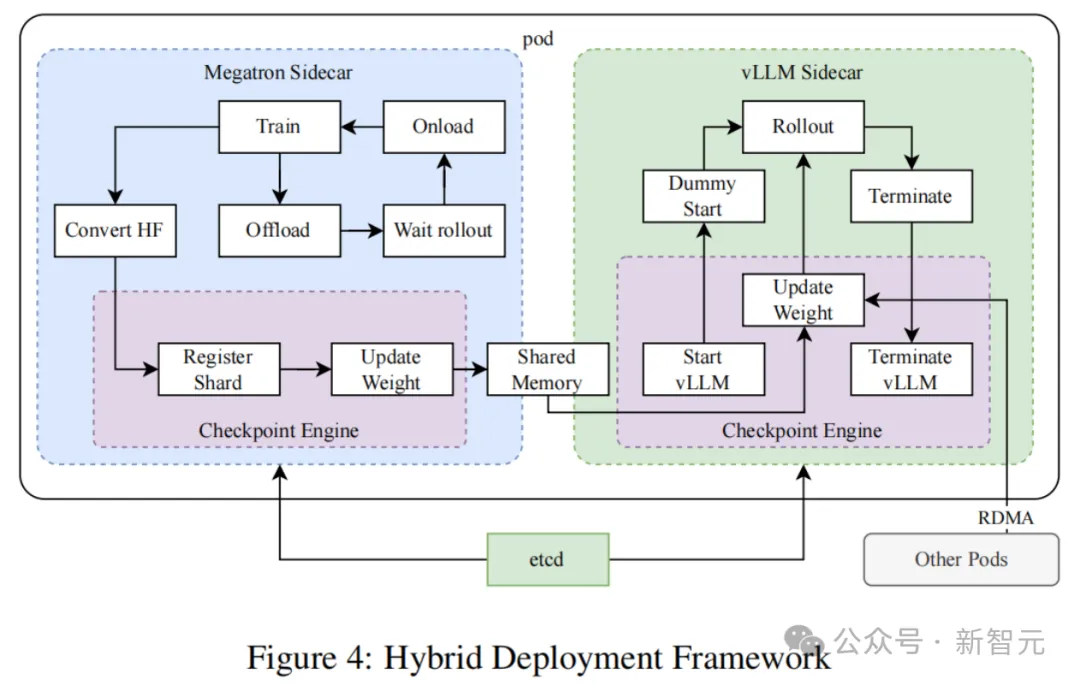

訓練與推理的混合部署

研究者提出了一種用于訓練和推理任務的混合部署策略,該策略利用Kubernetes的Sidecar容器共享所有可用GPU,將兩種任務協同部署在同一個Pod中。這一策略的主要優勢包括:

- 促進了資源的高效共享與管理,避免了訓練節點因等待推理節點而處于空閑狀態(當兩者部署在不同節點時)

- 通過使用不同的部署鏡像,訓練和推理可以獨立迭代,從而實現更好的性能

- 架構并不限于vLLM,還可以方便地集成其他框架

如圖4所示,研究者在Megatron和vLLM的基礎上實現了這一混合部署框架,從訓練到推理階段不到一分鐘的轉換時間,反向轉換則約為十秒鐘。

實驗結果

由于k1.5是一個多模態模型,研究者對不同模態的各種基準進行了綜合評估。基準測試主要包括以下三類:

- Text Benchmark:MMLU, IF-Eval, CLUEWSC, C-EVAL

- Reasoning Benchmark:HumanEval-Mul, LiveCodeBench, Codeforces, AIME 2024, MATH500

- Vision Benchmark:MMMU, MATH-Vision, MathVista

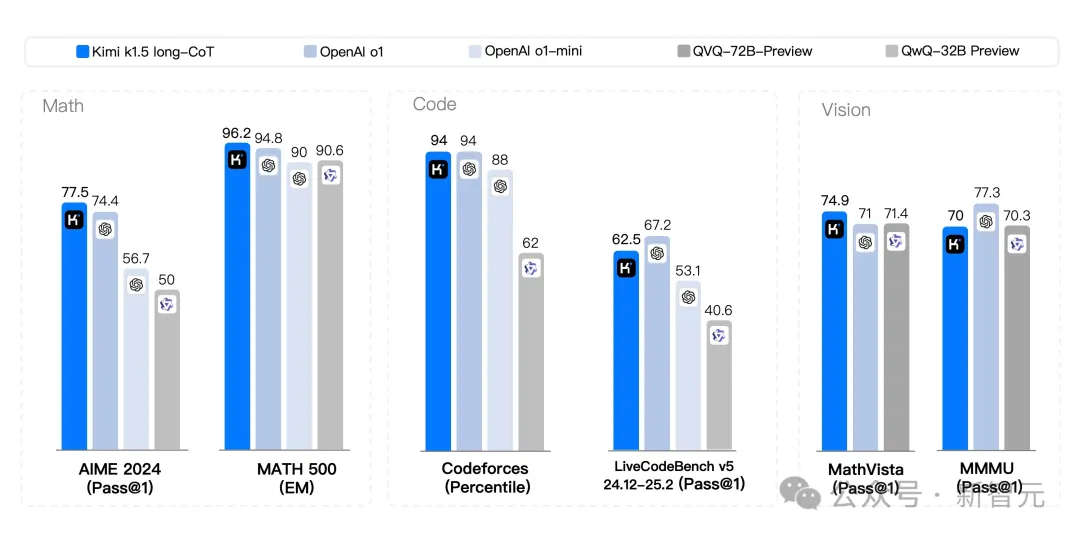

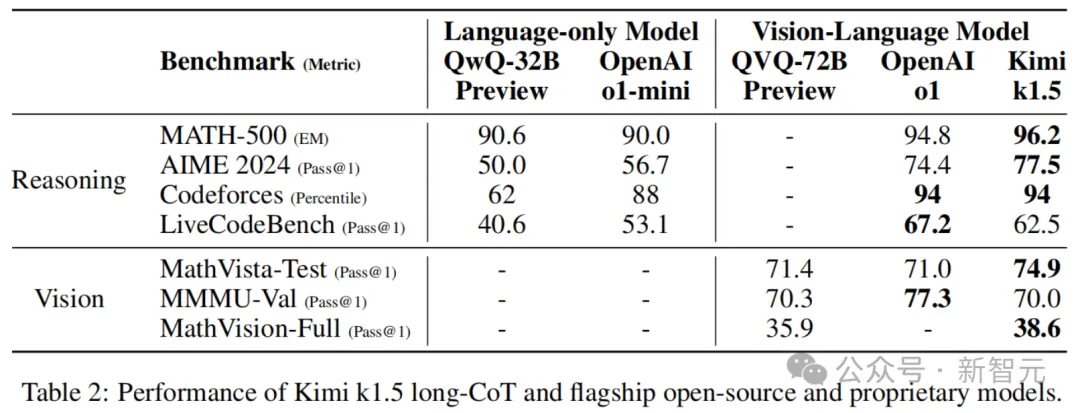

k1.5長CoT模型

Kimi的k1.5長CoT模型通過長CoT監督微調和視覺-文本聯合強化學習,在長距離推理上獲得了顯著的增強。

評估顯示,模型在長上下文中的推理、理解和信息綜合能力方面有了顯著提升,標志著多模態AI能力的顯著進步。

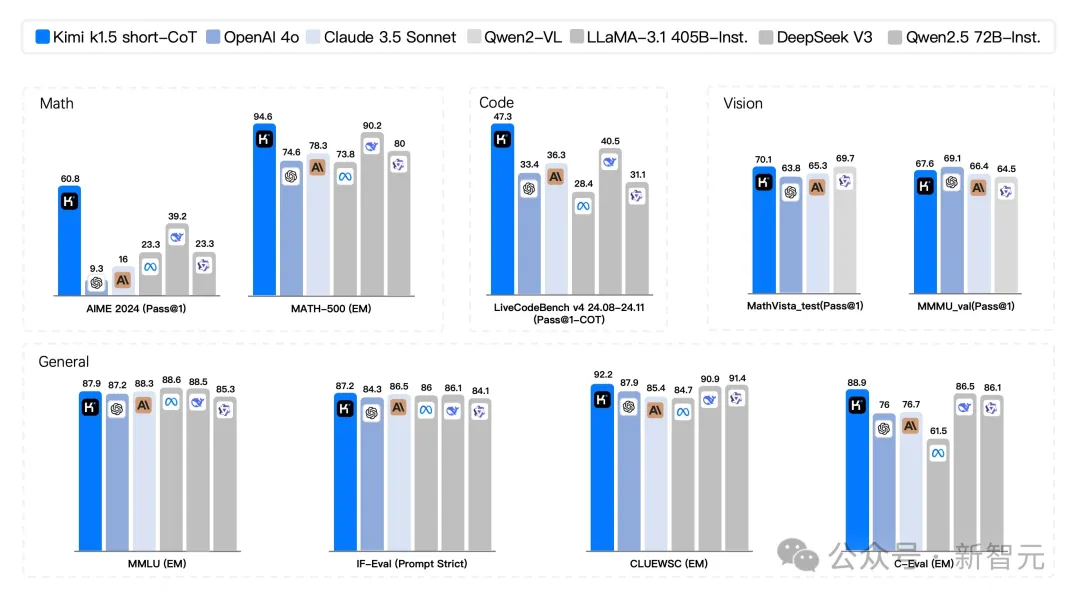

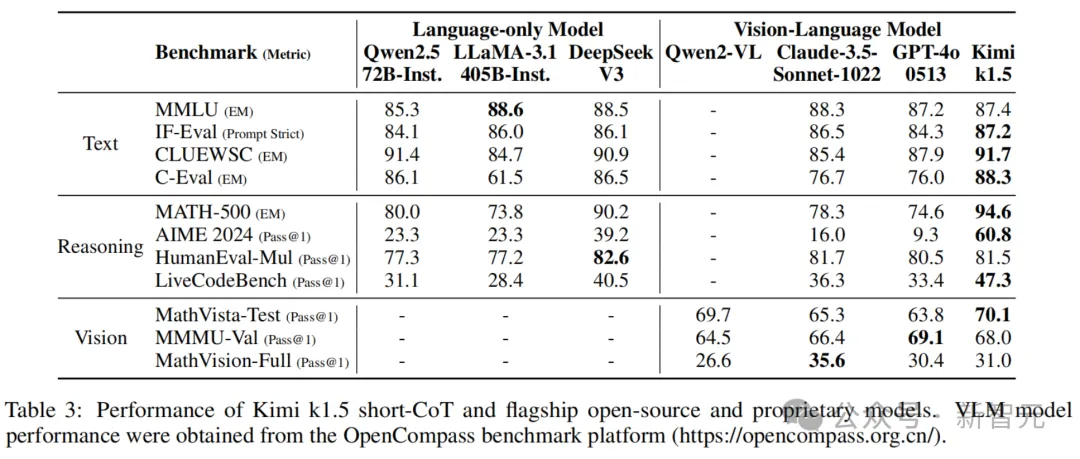

k1.5短CoT模型

Kimi的k1.5短CoT模型集成了多種技術,包括傳統監督微調方法、強化學習以及長到短知識蒸餾。

如表3所示,k1.5短CoT模型在覆蓋多個領域的多項任務中表現出與領先的開源和專有模型相當或更優的性能。

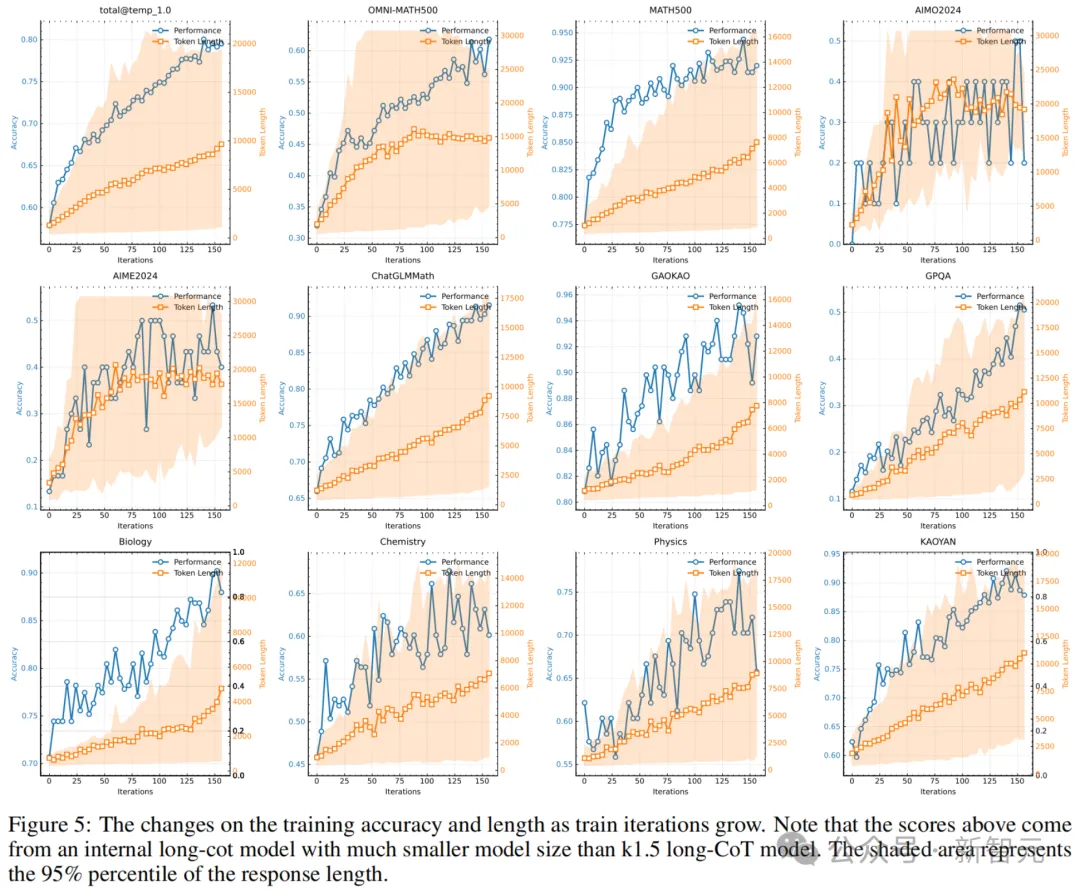

長上下文Scaling

研究者使用一個中型模型,來研究結合LLM的強化學習的擴展特性。如圖5所示,隨著訓練的進行,模型響應長度和性能準確率同時增加。

尤其值得注意的是,在更具挑戰性的基準測試中,響應長度的增長更為陡峭,這表明模型在處理復雜問題時學會生成更詳盡的解決方案。

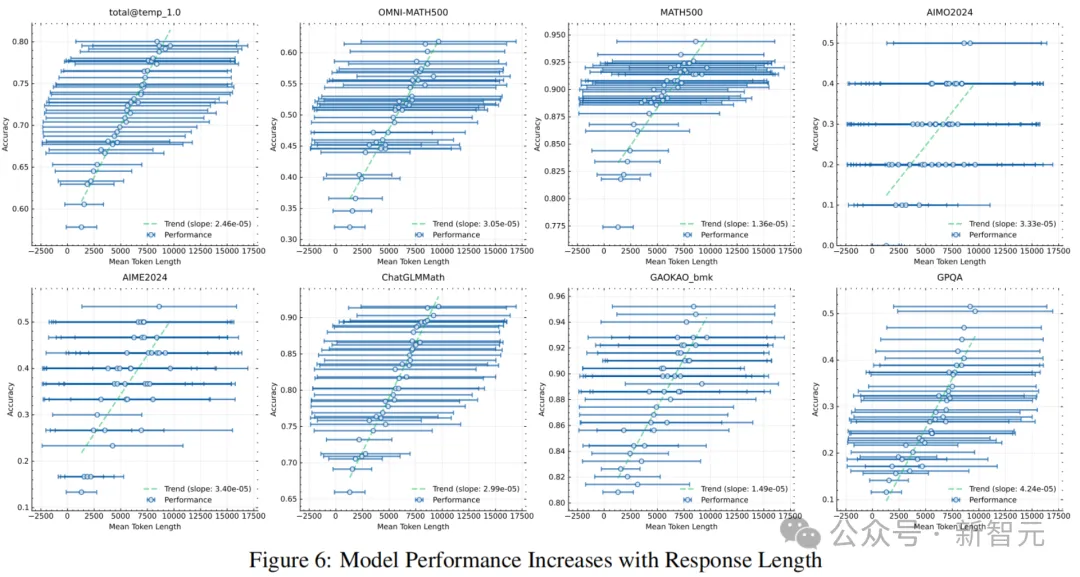

圖6表明,模型輸出的上下文長度與其問題解決能力之間存在顯著的相關性。

最終,k1.5模型的運行能支持128k上下文長度,并在困難的推理基準測試中持續取得改進。

由長到短

研究者重點研究了long2short問題中的Token效率,特別是長CoT模型如何提升短模型性能。

如圖7所示,提出的long2short強化學習算法在Token效率方面優于其他方法(如DPO和模型合并)。

值得注意的是,k1.5系列的所有模型(用橙色標記)在Token效率上都優于其他模型(用藍色標記)。

思考模型,進入沖刺

可以看到,在多模態推理技術路線上,Kimi又進了一步。

從2024年11月,他們首次推出的數學推理模型K0-math就展現出了在數學領域的領先性。

緊接著一個月后,K1視覺思考模型誕生,不僅繼承了K0-math的數學底蘊,更突破性地解鎖了視覺理解能力。

這意味著,K1不僅「會算」,還能「會看」——通過理解圖片中的信息,并通過逐步推理得出答案。

如今,k1.5又繼續向前推進了一步,在多個領域數理化、代碼、通用中,刷新了SOTA,甚至能夠媲美世界頂尖模型。

下一步,Kimi依舊會發力多模態推理,繼續迭代出能夠在更多模態、更多領域、具備更強通用能力的Kn系列的模型。

k1.5已經帶來了諸多驚喜,還真是有點期待下一代模型的到來。