GPT-4o數(shù)學(xué)能力跑分直掉50%,上海AI Lab開始給大模型重新出題了

新模型在MATH上(以數(shù)學(xué)競賽為主)動輒跑分80%甚至90%以上,卻一用就廢。

這合理嗎??

為了真實檢驗?zāi)P蛿?shù)學(xué)推理能力,上海人工智能實驗室司南OpenCompass團隊放大招了。

推出新的復(fù)雜數(shù)學(xué)評測集LiveMathBench,以全新性能指標(biāo)G-Pass@16??來連續(xù)評估模型的性能潛力和穩(wěn)定性。

好家伙!團隊在模擬真實用戶使用采樣策略、重復(fù)多次評測大模型的數(shù)學(xué)推理能力時發(fā)現(xiàn):

大部分的模型平均會有五成以上的性能下降,即使是最強推理模型o1-mini也會下降3成6,更有模型直接下降九成。

具體咋回事兒下面接著看。

全新評價指標(biāo): G-Pass@k

研究團隊重新思考了大模型評測常用的技術(shù)指標(biāo),如傳統(tǒng)經(jīng)常采用的Pass@k, Best-of-N, Majority Voting,這些指標(biāo)主要關(guān)注模型的性能潛力,缺少對模型的魯棒性的評測。

而真實場景中,為了提高回復(fù)的多樣性,模型往往使用采樣解碼的方式進(jìn)行推理,這也會帶來大量的隨機性。在復(fù)雜推理任務(wù)中,這種隨機性會嚴(yán)重影響模型的性能,而用戶更預(yù)期在真實問題中,模型能又穩(wěn)又好。

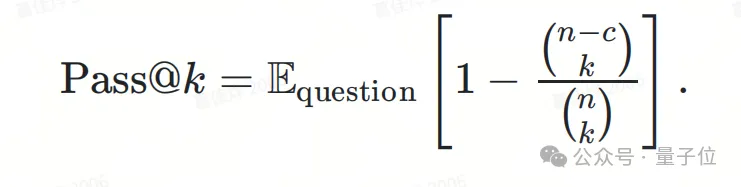

Pass@k指標(biāo)回顧

經(jīng)典的Pass@k指標(biāo)關(guān)注模型在多次生成中至少給出一次正確答案的概率。假設(shè)模型生成次數(shù)為??,正確答案數(shù)為??,c表示其中正確解的數(shù)量,那么Pass@k的計算方式如下:

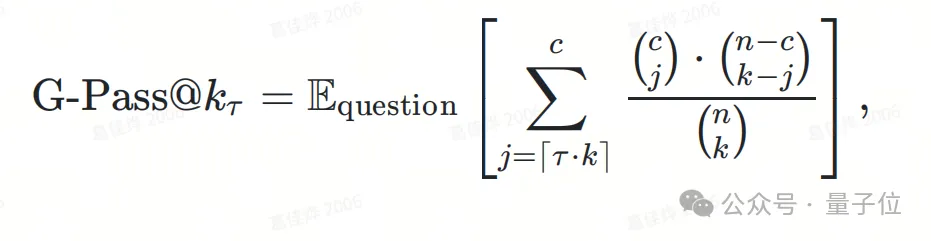

兼顧性能潛力與穩(wěn)定性的評測指標(biāo)G-Pass@K

Pass@k體現(xiàn)了模型的性能潛力,卻不能體現(xiàn)模型的穩(wěn)定性,基于這一目的團隊將Pass@k推廣為Generalized Pass@k(以下簡稱G-Pass@k??)。

通過引入閾值??,該工作關(guān)注模型在??次生成中至少給出 ? ?? · ?? ?次正確答案的概率。

一般來說,認(rèn)為模型的每次生成是i.i.d.(Independent and Identically Distributed)的,那么模型給出的正確答案數(shù)服從二項分布,這可以通過超幾何分布逼近二項分布。基于此,可以得出G-Pass@k??的定義:

在??較小時,G-Pass@k??衡量模型的性能潛力;??較大時,G-Pass@k??衡量模型的穩(wěn)定性,或者說模型對于問題的掌握程度,因此研究者可以通過G-Pass@k??連續(xù)地觀察模型的性能潛力與穩(wěn)定性。

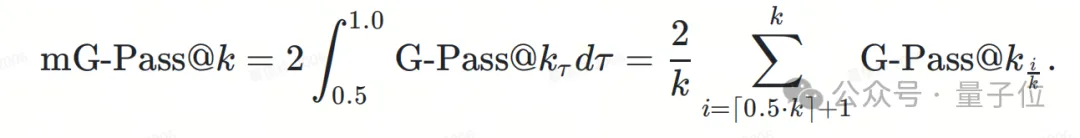

進(jìn)?步地,研究團隊還定義了mG-Pass@k用于對模型的性能進(jìn)行整體觀測。

具體來說,mG-Pass@k是 ??—G-Pass@k??曲線下的面積,為了更好地模擬真實場景,團隊重點考慮???[0.5,0.1 ]的情況,即:

G-Pass@K是Pass@K是泛化形式

當(dāng)? ?? · ?? ?=1時,Pass@K是G-Pass@k??等價,這意味著Pass@K是G-Pass@k??的特例,讀者可以參考論文附錄提供的證明。

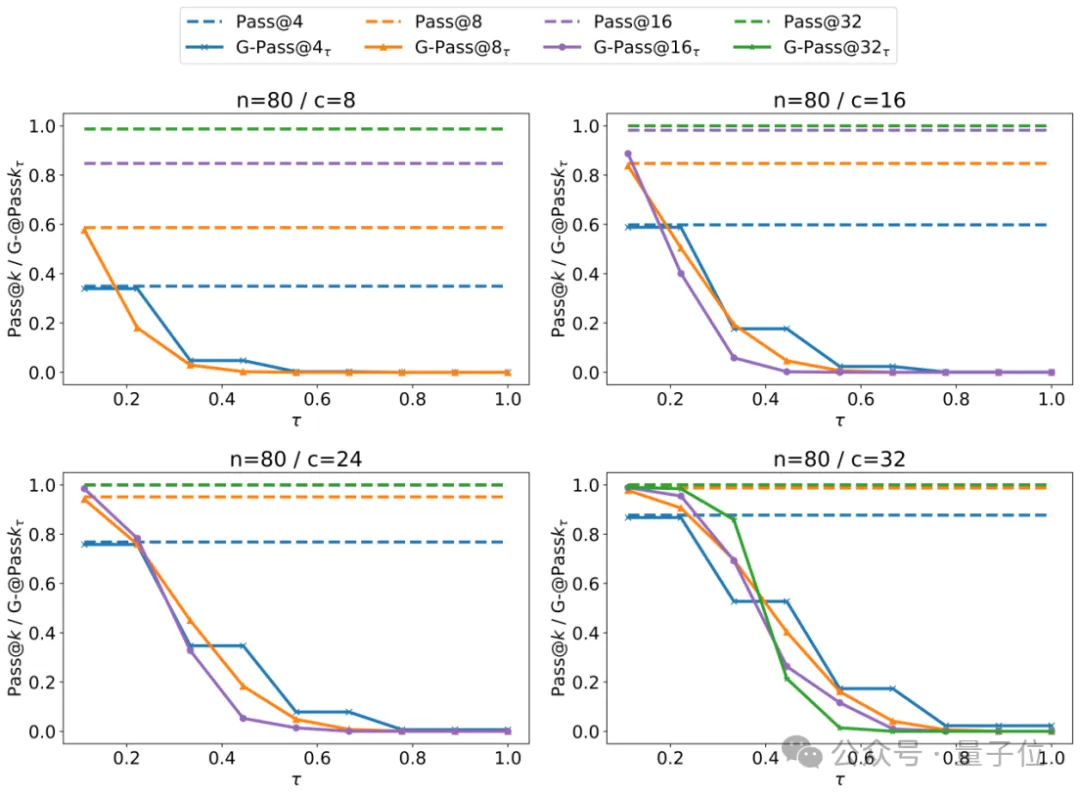

研究團隊給出了兩者關(guān)系的對比分析,如下圖所示:

圖中展示了不同的??和c下Pass@K和G-Pass@k??的值,可以看出在??較小時,兩者反映的是模型的潛力,然而這種分?jǐn)?shù)可能是偏高的,在24/80的整體通過率下,Pass@K指標(biāo)的值可以接近80%。

但當(dāng)關(guān)注較高的??時,更能夠觀察到模型在實際生成時的真實性能。

LiveMathBench:避免數(shù)據(jù)污染的復(fù)雜數(shù)學(xué)評測集

研究團隊構(gòu)建了一個新的benchmark LiveMathBench用于驗證實驗。

具體來說,他們收集了最近發(fā)布的中國數(shù)學(xué)奧林匹克,中國高考最新模擬題,美國數(shù)學(xué)競賽和美國普特南數(shù)學(xué)競賽中最新的題目,盡量減少數(shù)據(jù)污染的可能性。

整個LiveMathBench(202412版本)包括238道題目,每個題目提供中文/英文兩個版本的題目,覆蓋不同的難度。研究團隊計劃后續(xù)持續(xù)更新LiveMathBench中的題目,來持續(xù)觀測LLM的真實數(shù)學(xué)水平。

另外,研究團隊還在兩個公開Benchmark MATH500和AIME2024上進(jìn)行了實驗。

對于MAH500,研究團隊選擇了難度為L5的題目,命名為MATH500-L5;對于AIME2024,研究團隊使用了Part1和Part2兩個部分全部45道題目,命名為AIME2024-45。

實驗

在實驗設(shè)置方面,對于每道題目,進(jìn)行了16*3=48次生成并報告G-Pass@16??分?jǐn)?shù)。研究團隊在通用模型、數(shù)學(xué)模型和類o1模型三種不同類型的大模型中選擇了具有代表性的大模型進(jìn)行實驗。

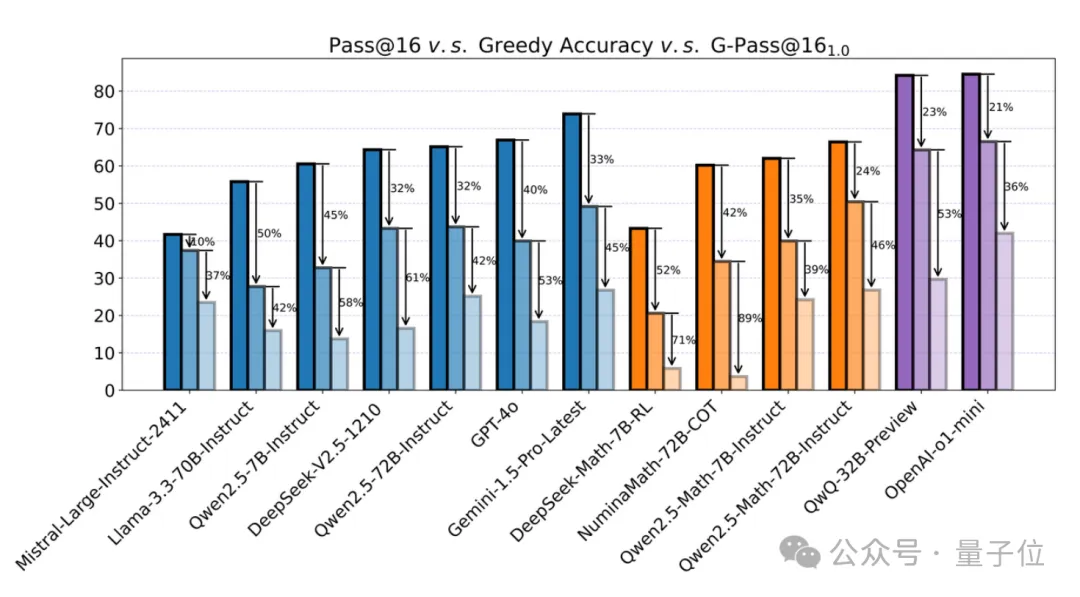

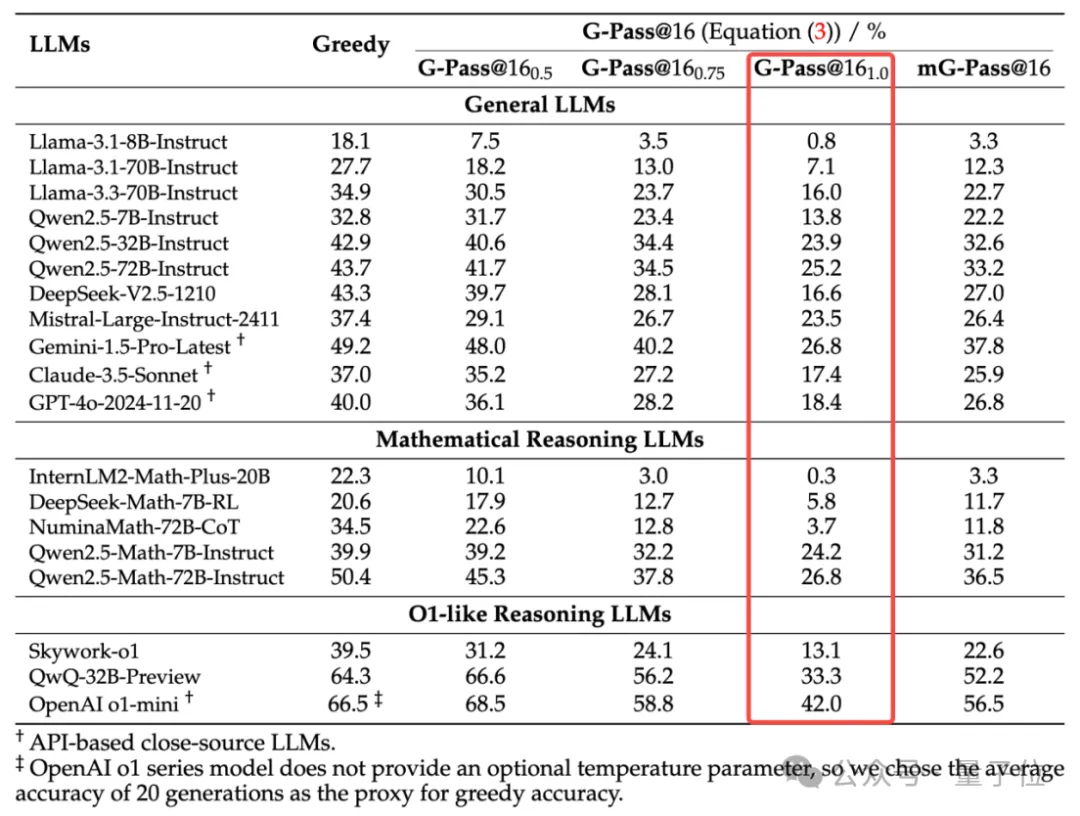

LiveMathBench性能對比如下:

根據(jù)實驗結(jié)果,可以看到:

- 大部分閉源模型和開源模型在G-Pass@161.0指標(biāo)上也都不超過30分。

- 最強的o1-mini模型在G-Pass@161.0獲得了最高分42分,相對性能下降比例也是所有模型中最低的(36.9%),雖體現(xiàn)出相對較高的穩(wěn)定性,但仍然難以忽視。

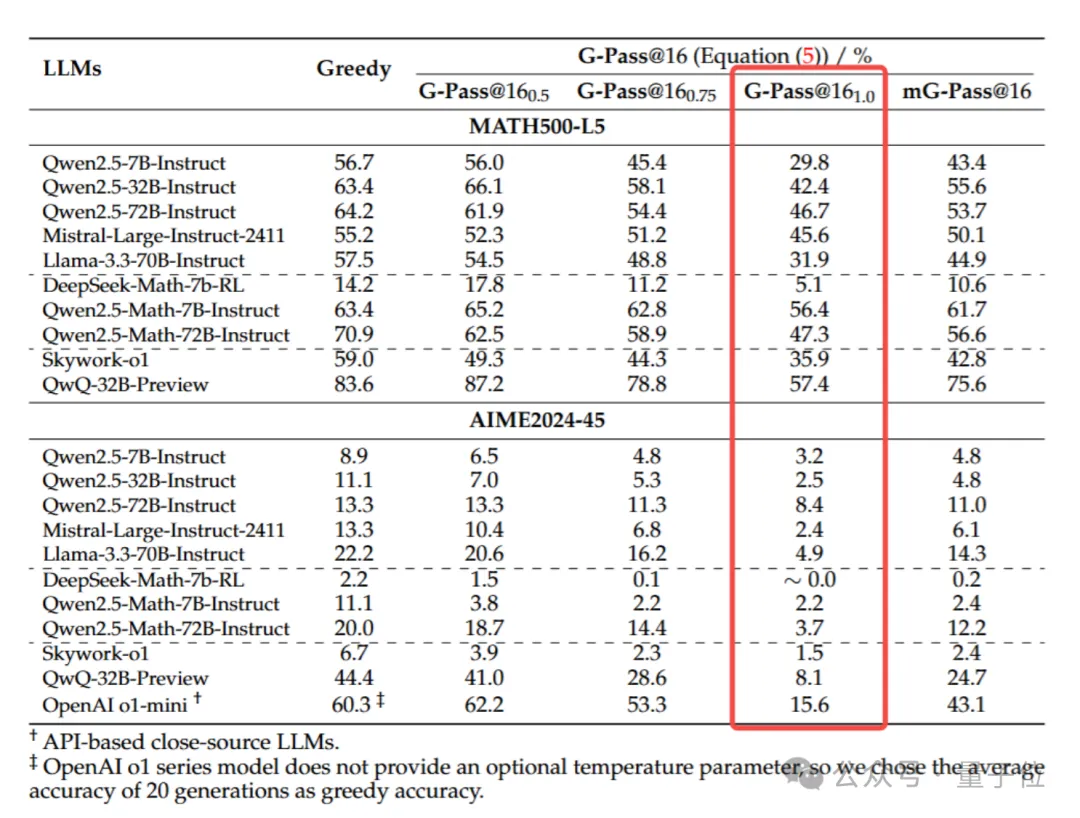

Math-500-L5/AIME2024-45性能對比如下。

對于開源數(shù)據(jù)集:

- 在常用的高中競賽級別題目MATH500-L5上,多數(shù)模型不管是貪婪解碼的表現(xiàn)還是穩(wěn)定性G-Pass@161.0的表現(xiàn)都相比LiveMathBench都有所提升,而AIME2024則相反,大多數(shù)模型的G-Pass@161.0分?jǐn)?shù)都只有個位數(shù),甚至部分模型接近0分;

- 對于難度頗高的AIME2024,雖然o1-min和QwQ-32B-Preview在貪婪解碼下表現(xiàn)突出,但面對高難度題目下的穩(wěn)定性還是難以保證,如QwQ-32B-Preview甚至跌到了不到原來的1/5,而其在MATH500-L5中卻比較穩(wěn)定,達(dá)到了原分?jǐn)?shù)的3/5,這也說明了最新的高難度數(shù)學(xué)題目對模型的穩(wěn)定性帶來了更大的壓力。

最后,模型在不同難度題目上的能力分析如下 。

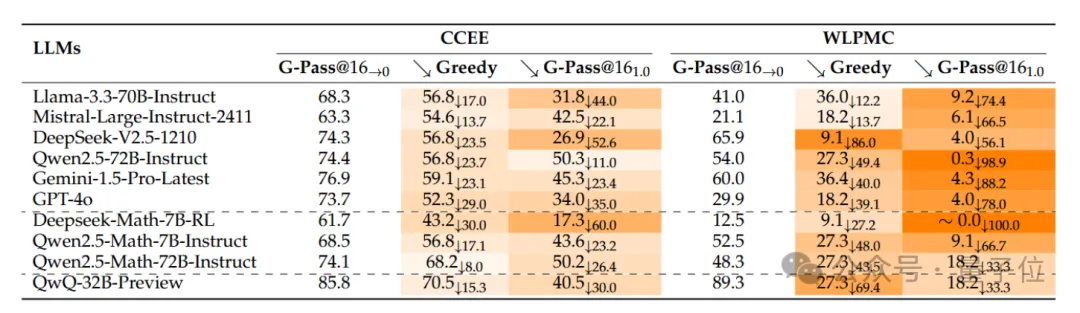

下表展示了關(guān)鍵模型在LiveMathBench兩個子集上的性能表現(xiàn)。

其中CCEE代表中國高考題目,主要涉及到基礎(chǔ)的高中數(shù)據(jù)知識;而WLPMC代表來自普特南(Putnam)競賽的題目,普特南競賽是久負(fù)盛名的美國大學(xué)生數(shù)學(xué)競賽,其題目難度要高于高考題目。

由實驗結(jié)果可以看出,先進(jìn)的推理模型,例如DeepSeek-V2.5, Qwen2.5-72B-Instruct, QwQ等在Pass@16指標(biāo)下在兩個子集上都有較好的性能,但大部分模型在WLPMC上的穩(wěn)定性下降更為嚴(yán)重。

因此可以有如下猜想,推理模型容易學(xué)習(xí)到訓(xùn)練數(shù)據(jù)中的平凡解,導(dǎo)致Pass@k等指標(biāo)的上升,然而在困難的問題上,這種提升并不與模型真實推理性能提升相關(guān)。在強基座模型的訓(xùn)練中,更應(yīng)該關(guān)注推理穩(wěn)定性的表現(xiàn),以提升其真實推理能力。

重要觀測

觀察一:閉源和開源模型均不能穩(wěn)定地進(jìn)行復(fù)雜推理

研究人員對當(dāng)前主流的約20個模型進(jìn)行了測試,發(fā)現(xiàn)盡管多數(shù)模型在貪婪解碼的準(zhǔn)確率Greedy Accuracy和Pass@16上表現(xiàn)相對較好,但當(dāng)使用G-Pass@K指標(biāo)進(jìn)?評估時,性能卻顯著下降。

當(dāng)??設(shè)置為1.0時,即要求模型在所有16次采樣中都提供正確答案, 幾乎所有模型的表現(xiàn)都急劇下降。

例如,在對LiveMathBench的測評中,Llama-3.1-8B-Instruct模型的準(zhǔn)確率從18.1%下降到0.8%(G-Pass@16??=1.0),降幅高達(dá)95.7%。即使是較大的模型,如NuminaMath-72B-CoT,其準(zhǔn)確率也從34.45%下降到3.7%,減少了89.3%。

在大約20個測試模型中,平均性能下降了60%。即便是表現(xiàn)最為穩(wěn)定的OpenAI o1-mini,其準(zhǔn)確率也從66.5%下降到42.0%,降幅為36.9%。

即使將??放寬到0.5,即只要求一半的樣本正確即可通過,通用模型、數(shù)學(xué)推理模型和o1-like模型仍分別經(jīng)歷了14.0%、22.5%和4.8%的平均性能下降。

這表明,在復(fù)雜條件下,多數(shù)模型難以在多次采樣中保持一致的推理能力。

不過目前的評估指標(biāo)通常依賴單次貪婪解碼,可能無法充分反映這些模型在實際應(yīng)用中的魯棒性和穩(wěn)定性。

因此,研究團隊指出,需要對模型的推理能力進(jìn)行更嚴(yán)格的評估,尤其是在那些需要在多次采樣中保持一致性和可靠性的重要應(yīng)用中。

觀察二:增大模型規(guī)模對推理能力的提升有限

研究人員觀察到,以同系列模型Qwen2.5-32B-Instruct與Qwen2.5-72B-Instruct為例,雖然它們的模型規(guī)模相差一倍以上,但無論指標(biāo)采用G-Pass@K還是Greedy Accuracy,無論評測數(shù)據(jù)集是最新的LiveMathBench還是現(xiàn)有開源數(shù)據(jù)集,兩者的表現(xiàn)均相似。

另外,在更大體量的模型Mistral-Large-Instruct-2411(123B)上,盡管模型規(guī)模繼續(xù)增大,但其性能和穩(wěn)定性相比 Qwen2.5-72B-Instruct 卻出現(xiàn)下滑。

這表明,對于需要深度理解和邏輯推理的任務(wù),簡單增大參數(shù)并不能顯著提升性能或穩(wěn)定性。

這可能是因為這些任務(wù)不僅需要模型具備記憶和模式識別能力,更需要強大的推理和上下文理解能力。

觀察三:模型的性能潛力和實際表現(xiàn)之間的巨大差距

研究團隊在評估模型性能時發(fā)現(xiàn),理論最大能力G-Pass@16??→0、實際表現(xiàn)能力Greedy Accuracy和多次采樣下的穩(wěn)定能力G-Pass@16??=1.0之間存在顯著差距。

盡管模型在理論上具備相當(dāng)高的潛在性能,但在實際應(yīng)用中未能充分展現(xiàn)這一水平,尤其是在輸出穩(wěn)定性方面。一些模型在單次貪婪解碼中表現(xiàn)出高準(zhǔn)確率,顯示出處理特定任務(wù)的潛力,但在保持一致高準(zhǔn)確率方面卻不穩(wěn)定,遠(yuǎn)未達(dá)到最佳性能。

這反映了現(xiàn)有模型在推理穩(wěn)定性和一致性上的不足,這在訓(xùn)練和評估中常被忽略。

模型在單次推理表現(xiàn)中易受輸入數(shù)據(jù)變化、初始化狀態(tài)或隨機采樣的影響,導(dǎo)致不同采樣解碼的結(jié)果不一致。

研究人員指出,在高可靠性和一致性要求的實際應(yīng)用中,如何在保持接近最佳性能的同時確保輸出的穩(wěn)定性,是一個亟待解決的問題。

總結(jié)

本研究深入分析了當(dāng)前大型模型的數(shù)學(xué)推理能力,提出了全新的性能指標(biāo)G-Pass@16?? ,用于連續(xù)評估模型的性能潛力和穩(wěn)定性。

此外,還設(shè)計了避免數(shù)據(jù)污染的LiveMathBench數(shù)據(jù)集。

實驗結(jié)果顯示,目前的大型模型在推理性能方面未達(dá)到預(yù)期,尤其在多次重復(fù)采樣時,性能出現(xiàn)顯著下降。研究團隊期望學(xué)術(shù)界和工業(yè)界能夠在推理能力的魯棒性研究上持續(xù)探索與推進(jìn)。

論文鏈接:https://arxiv.org/abs/2412.13147

項目地址:https://github.com/open-compass/GPassK