李飛飛謝賽寧新作「空間推理」:多模態大模型性能突破關鍵所在

李飛飛謝賽寧再發新成果:

直接把o1式思考拉至下一個level——多模態大語言模型的空間思維!

這項研究系統評估了多模態大模型的視覺空間智能,結果發現:

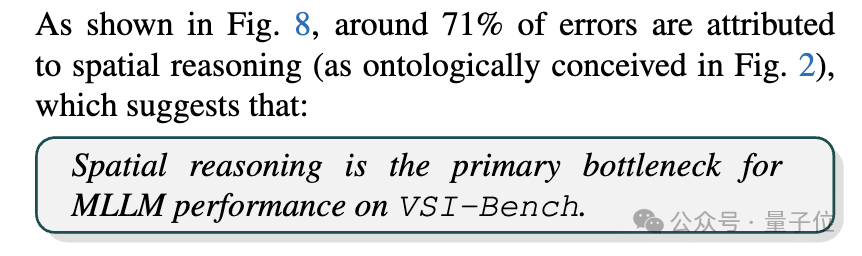

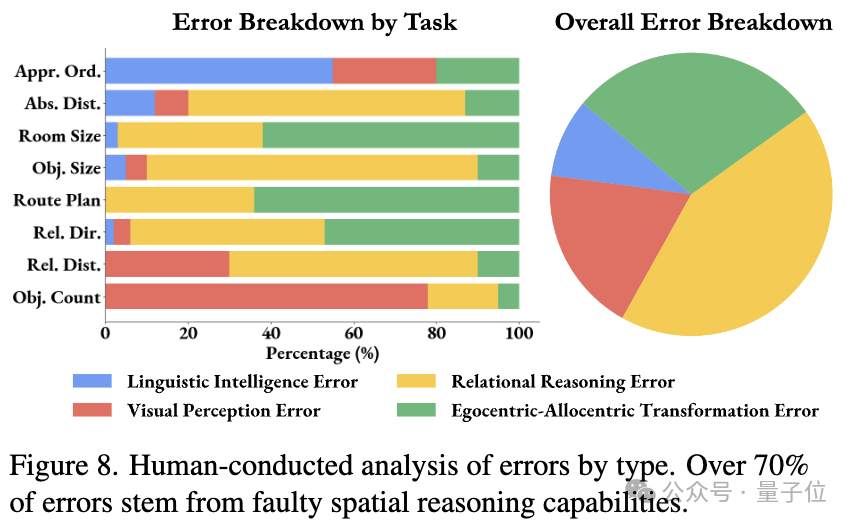

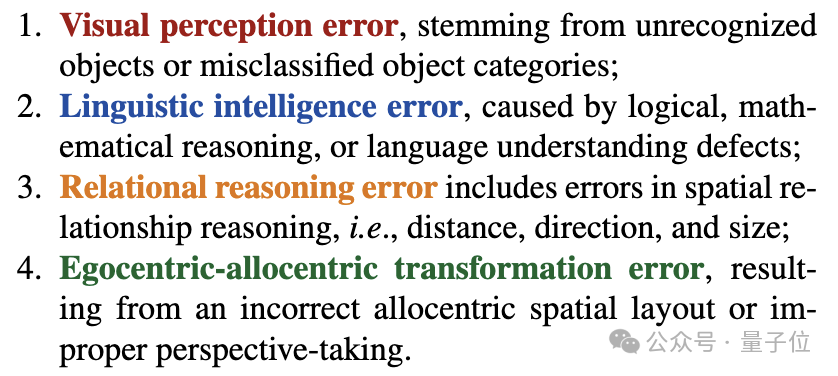

當前,即使是最先進的多模態大模型,在空間認知方面與人類相比仍有顯著差距,測試中約71%的錯誤都源于空間推理方面的缺陷,即空間推理能力是當前主要瓶頸。

圖片

圖片

更為有趣的是,在這種情況下,思維鏈、思維樹等常用的語言提示技術直接失靈了——

不僅沒有提升模型在空間任務上的表現,反而會使性能下降。

而在問答過程中明確生成認知地圖則會增強多模態大模型的空間距離能力。

圖片

圖片

這項工作陣容非常豪華,合著作者中不僅有李飛飛,還有紐約大學計算機科學助理教授、CV大牛謝賽寧。

而剩下的四位作者,全部共同一作。

圖片

圖片

這項研究吸引了不少網友的關注,大伙兒一邊看論文,一邊已迫不及待搓搓手期待2025年的新進展。

圖片

圖片

多模態大模型的空間思維

雖然當前多模態大語言模型在語言理解和一般視覺任務上取得了顯著進展,但在空間認知和理解方面的能力仍未得到充分研究。

反觀人類,面對心理旋轉測試、挑選家具這些任務時,會同時依賴于空間和視覺思考。

圖片

圖片

多模態大語言模型能否“進行空間思考”?能否構建一個準確的、隱式的“認知地圖”來幫助它們回答有關空間的問題?使用多模態大語言模型來增強空間智能的優勢和局限性是什么?

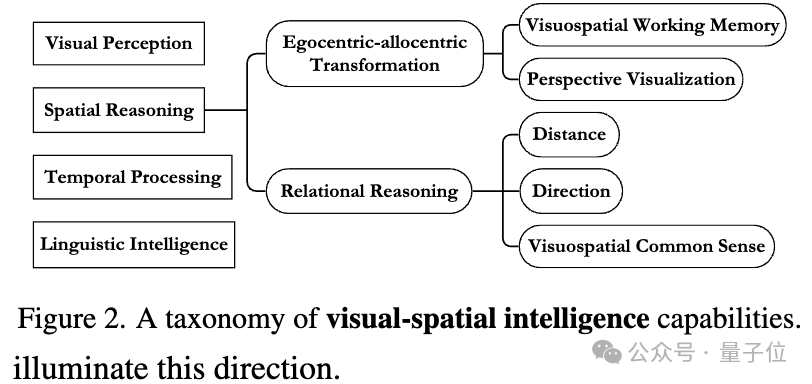

為了探索這些問題,團隊研究了視覺空間智能。

作者解釋,之所以在“空間智能”前加上“視覺”一詞,是因為空間智能不受感官模式限制,比如盲人也可以通過別的感官感知空間,而該研究專注于視頻輸入,所以討論視覺空間智能。

圖片

圖片

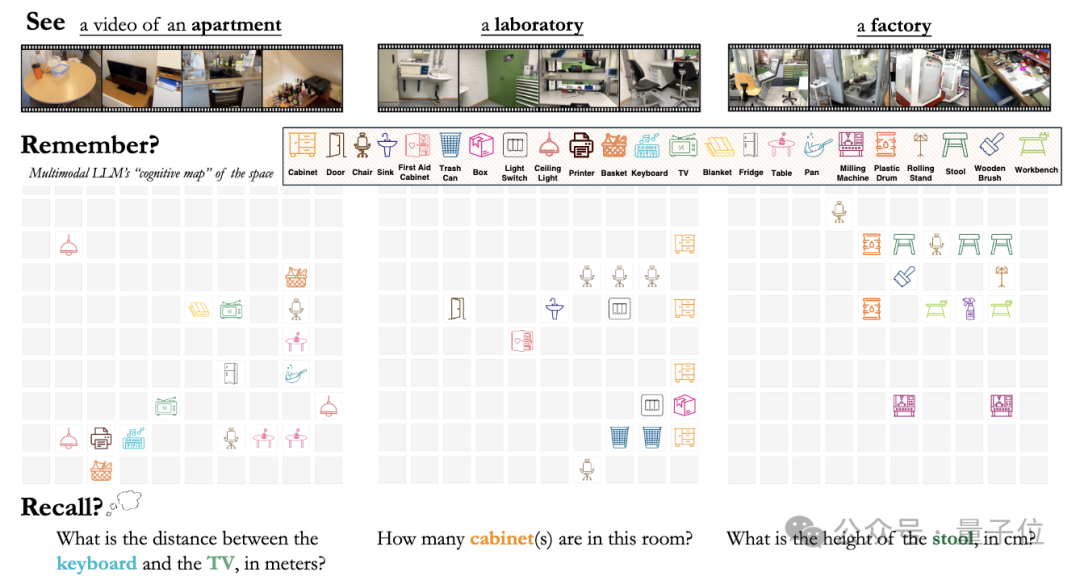

VSI-Bench視覺空間智能基準測試集

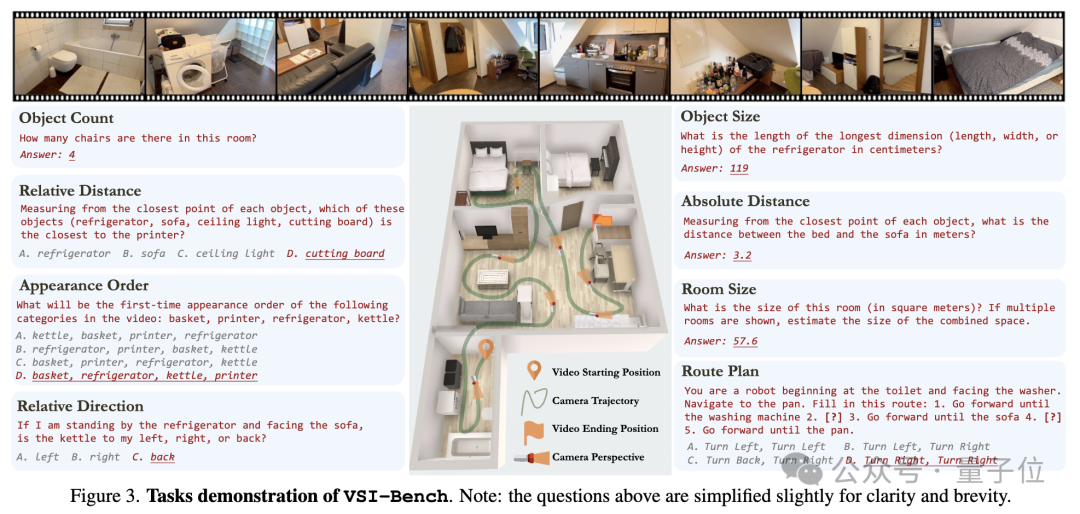

首先團隊提出了一個名為VSI-Bench的基準測試集。

基于之前的計算機視覺工作,團隊重新利用現有的空間掃描視頻(最初用于3D重建)及其真實標注來自動生成視覺問答(VQA)問題。

具體來說,這個測試集基于ScanNet、ScanNet++和ARKitScenes等數據集中的288個真實室內場景視頻,包括住宅、辦公室、實驗室等各種環境。

團隊設計了超5000個問答對,將評測任務分為三大類:

- 配置型任務:物體計數、相對距離、相對方向、路線規劃

- 測量估計:物體尺寸、房間大小、絕對距離

- 時空任務:物體出現順序等

并采用人工審核確保數據質量,消除歧義和錯誤標注。

圖片

圖片

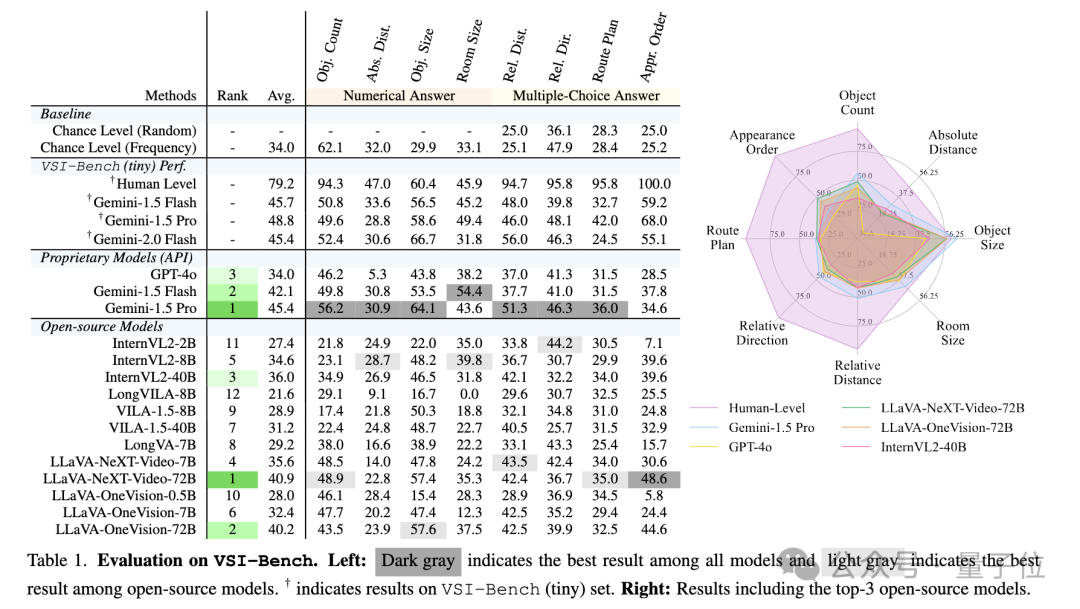

隨后,他們全面評估了15種支持視頻的多模態大語言模型,開源、閉源的都有。

圖片

圖片

結果,人類在VSI-Bench上的平均準確率達到79%,在配置型和時空任務上準確率更高,處于94%-100%之間。

相比之下,表現最好的閉源模型是Gemini-1.5 Pro,平均準確率為48.8%,開源模型LLaVA-NeXT-Video-72B和LLaVA-OneVision-72B與之相近。

在需要精確估計絕對距離/大小的三個測量任務上,大模型和人類表現差距相對較小。

團隊還進一步證實了視頻輸入對模型性能的重要性,盲測實驗中,在絕對距離估計等特定任務上,即使是最先進的模型也難以超越隨機基線的表現。

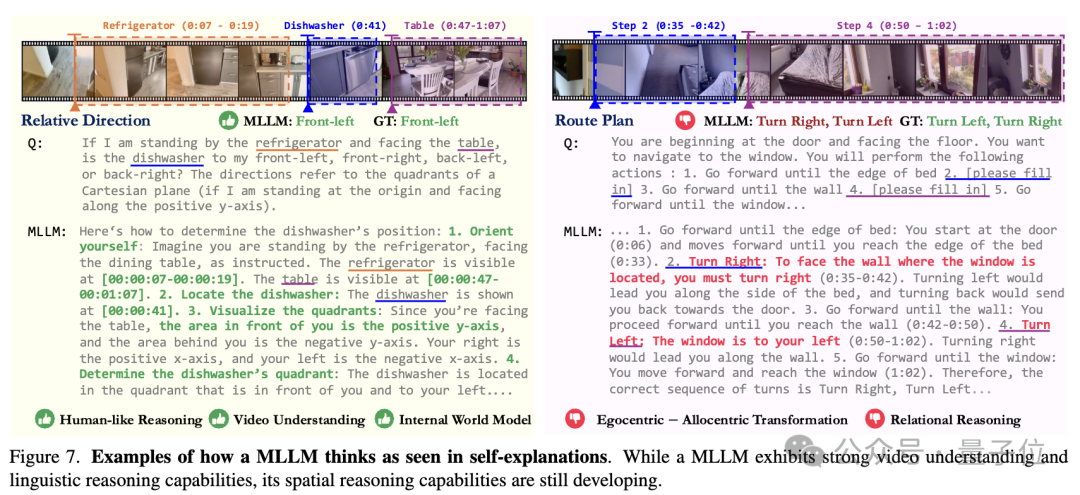

語言視覺兩個層面分析模型思維過程

為了深入理解模型的認知機制,團隊又從語言和視覺兩個層面分析了模型的思維過程。

圖片

圖片

圖片

圖片

在語言層面,通過讓模型進行自我解釋,發現它們確實具備不錯的視頻理解和語言推理能力。

但詳細的錯誤分析顯示,超70%的錯誤源于其空間推理能力的不足。

圖片

圖片

圖片

圖片

接著,團隊用常用的語言提示技術改進,包括思維鏈、思維樹、自洽性。

結果不僅沒有提升模型在空間任務上的表現,反而導致了性能下降,也就是說純粹的語言推理技術難以解決空間認知問題。

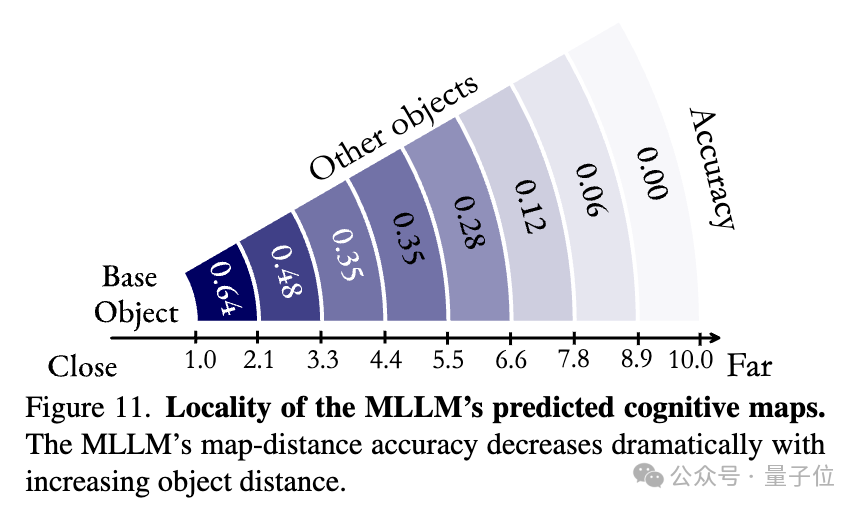

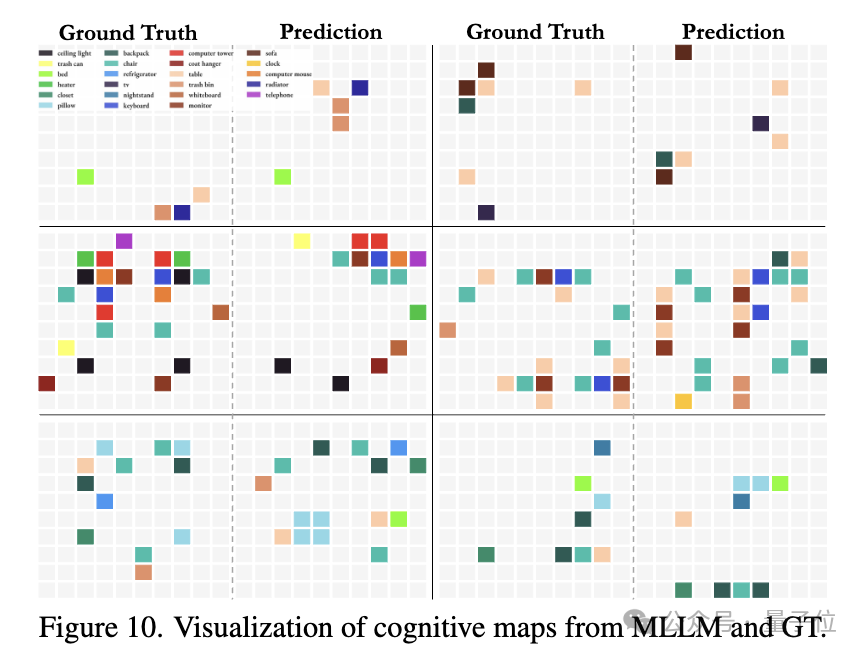

在視覺層面,他們又使用認知地圖來分析模型的空間記憶能力。

結果顯示,模型在理解局部空間關系時表現較好,相鄰物體位置關系的準確率達到64%。但隨著物體之間距離的增加,模型的空間關系理解能力顯著下降。

這說明模型傾向于建立局部空間模型,而不是形成完整的全局空間理解。

圖片

圖片

圖片

圖片

不過,他們研究了一種新思路:

使用認知地圖輔助空間推理。

圖片

圖片

加入這種機制,模型在相對距離任務上的準確率提升了10個百分點,這為提升模型空間智能提供了一個潛在的解決方向。

李飛飛謝賽寧領銜,四位共同一作

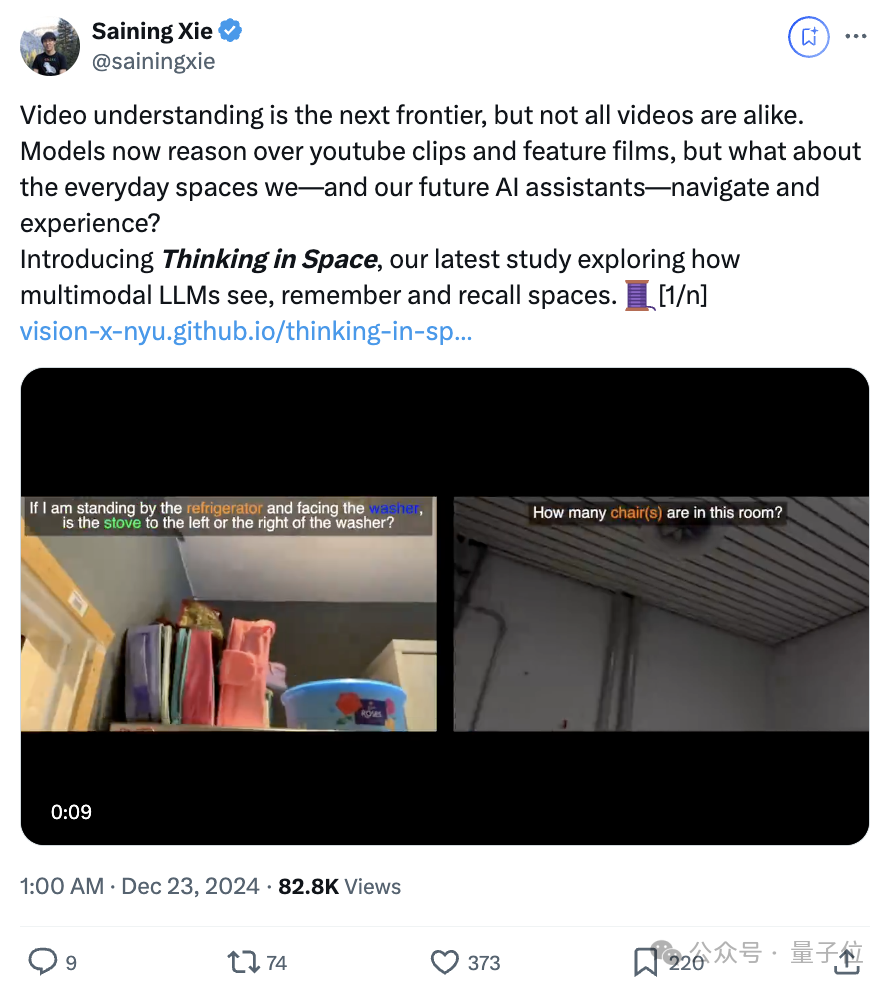

論文一經公布,幾位作者就激情當起了自個兒的首批自來水(doge)。

謝賽寧表示:

視頻理解是下一個前沿領域,但并非所有視頻都是相同的。

這項研究探索了多模態大語言模型如何觀察、記憶和回憶空間。

圖片

圖片

“AI教母”李飛飛也轉發開麥:

這是人類智能中極為重要的一個方面,2025年還有更多值得期待,推動空間智能的邊界!

圖片

圖片

這項研究共同一作有四位,正如李飛飛教授透露,多位都是謝賽寧的學生。

Jihan Yang

圖片

圖片

Jihan Yang是紐約大學Courant研究所博士后研究員,導師是謝賽寧。在此之前,Jihan Yang于香港大學獲得了博士學位,中山大學獲得了學士學位。

他的研究興趣集中在機器學習和計算機視覺領域,特別關注多模態和具身智能。

Shusheng Yang

圖片

圖片

Shusheng Yang目前是紐約大學博士生。

領英顯示,他是華中科技大學校友,曾經在阿里和騰訊有過工作經歷。

圖片

圖片

Anjali Gupta

圖片

圖片

Anjali Gupta是紐約大學Courant研究所博士生,導師是謝賽寧教授。

她的研究領域是機器學習和計算機視覺,特別是以視覺為中心的多模態大語言模型。

Rilyn Han

圖片

圖片

Rilyn Han來自耶魯大學,主修計算機科學和經濟學,研究主要關注探索多模態大語言模型的能力。

論文鏈接:https://arxiv.org/pdf/2412.14171

項目主頁:https://vision-x-nyu.github.io/thinking-in-space.github.io/

參考鏈接:

[1]https://x.com/sainingxie/status/1870877202595958791

[2]https://x.com/drfeifei/status/1870881981703291097

[3]https://vision-x-nyu.github.io/thinking-in-space.github.io/