LeCun謝賽寧首發全新視覺多模態模型,等效1000張A100干翻GPT-4V

在寒武紀大爆發中,視覺的出現對于早期動物至關重要。

捕食、避險、引導進化, 穿越時間,組成了多彩的世界。

大多數人類知識,也都是通過視覺、聽覺、觸覺、味覺和嗅覺等感官體驗,以及與物理世界的交互所獲得。

對應到大模型的學習,雖然更大的規模可以增強多模態的能力,但視覺方面的研究和設計似乎沒有跟上。

另一方面,過度依賴語言,則可能會成為多模態學習研究的瓶頸。

近日,LeCun和謝賽寧團隊推出了Cambrian-1,一項采用以視覺為中心的方法設計多模態大語言模型(MLLM)的研究,同時全面開源了模型權重、代碼、數據集,以及詳細的指令微調和評估方法。

論文地址:https://arxiv.org/abs/2406.16860

開源代碼:https://github.com/cambrian-mllm/cambrian

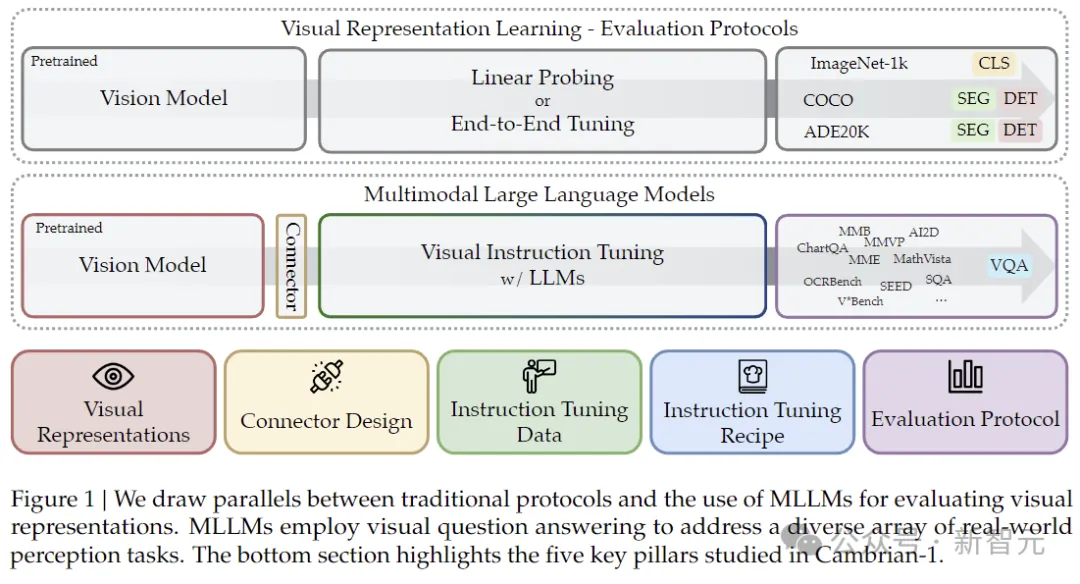

Cambrian-1使用MLLM指令微調作為各種視覺表示的評估協議。

整個框架圍繞五個關鍵方面進行構建,同時也代表了作者對MLLM設計空間的重要見解:

傳統協議與使用MLLM來評估視覺表征的比較:MLM采用視覺問答來解決各種現實世界感知任務。底部突出了Cambrian-1研究的五個關鍵支柱

Visual Representations:探索了各種視覺編碼器及其組合。

Connector Design:本文設計了一種全新的動態的空間感知連接器,將多個模型的視覺特征與LLM集成在一起,同時減少了token的數量。

Instruction Tuning Data:研究人員從公共來源收集高質量的視覺指令微調數據,同時強調數據的平衡性。

Instruction Tuning Recipes:指令微調策略和實踐。

Benchmarking:分析現有的MLLM基準測試,并引入了一個全新的以視覺為中心的基準測試CV-Bench。

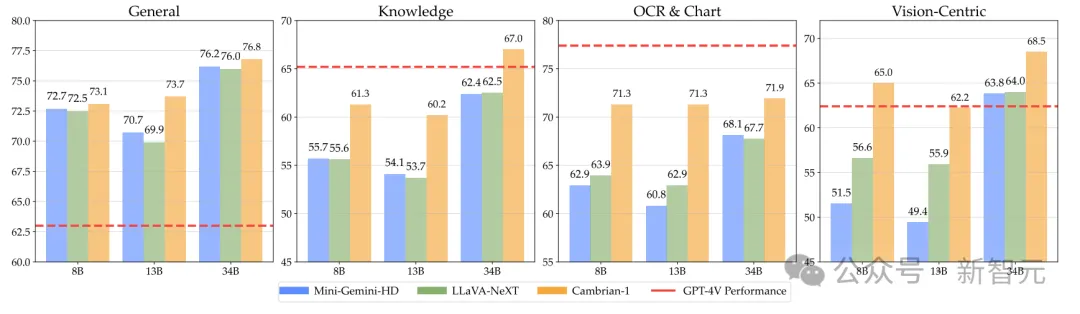

作為這項研究的「副產物」,團隊順便訓練出了一個目前性能最強的多模態模型。(紅線是GPT-4V的成績)

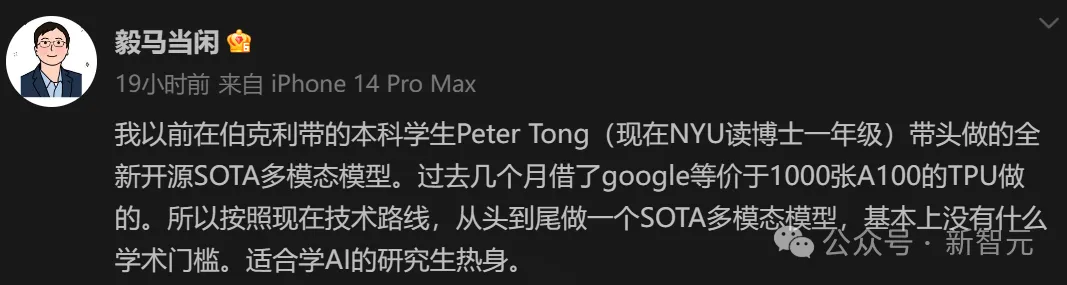

論文的一作Shengbang Tong是馬毅教授以前在伯克利帶的學生,目前在NYU讀博士一年級。

馬毅教授表示,這個模型是在過去幾個月借谷歌的TPU訓練的(等價于1000張A100的算力)。

「所以按照現在技術路線,從頭到尾做一個SOTA多模態模型,基本上沒有什么學術門檻。適合學AI的研究生熱身。」

世界不需要另一個MLLM對打GPT-4V

謝賽寧剛剛發文表示,「世界不需要另一個MLLM與GPT-4V競爭。Cambrian在以視覺為核心的探索是獨一無二的,這也是為什么,我認為是時候將重心從擴展大模型轉移到增強視覺表征了」。

他繼續稱,從以往的研究項目(MMVP、V*、VIRL)中,團隊已經看到當前MLLM系統在視覺方面存在一些意料之外的缺陷。

雖然可以通過增加數據等方法暫時解決一些問題,但一個根本問題是——我們的視覺表征能力不足以支持模型的語言理解。

短期內,像Astra和GPT-4o這樣的項目,確實令人印象深刻。

然而,要開發出一個能像人類一樣感知真實世界、可靠地管理復雜任務,并做出相應行動的多模態助手,薄弱的視覺感知基礎,可能會成為瓶頸。

語言先驗很強大,但我們不應該用它們作為「拐杖」(引用Yann LeCun的原話)來彌補視覺表征的不足。

目前,研究視覺表征學習確實極具挑戰性。

雖然基于CLIP模型(由語言強監督)已被證明很有效,但同時也存在一些問題,比如屬性綁定。

然而,這些模型已經存在一段時間了,令人驚訝的是我們還沒有看到任何重大突破。

另一方面,視覺自監督學習(SSL)模型雖令人印象深刻,但傳統的評估方法(如線性探測或遷移到目標檢測)不再有效。

盡管如此,我堅信我們應該繼續向前推進。

CLIP/SigLIP模型很棒,但我們需要讓方法多樣化,繼續探索新的可能性,而不是安于現狀并宣稱勝利。

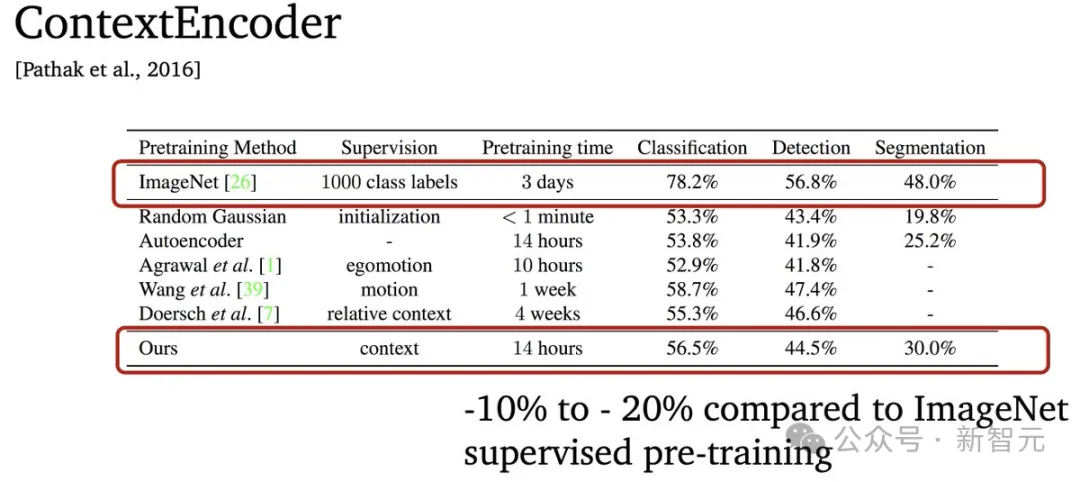

這一情況讓人想起2015-2016年,當時大家都認為ImageNet監督預訓練天下無敵,其他視覺表征至少落后10-15%。

但是,研究人員們可沒被嚇倒,還是繼續琢磨各種新方法和任務。

直到幾年后,MoCo就展示了超越監督預訓練模型的潛力。

這也是開發Cambrian項目的重要原因——為更多以視覺為中心的探索鋪平道路。

之所以將模型稱為Cambrian(寒武紀),因為就像寒武紀大爆發時生物發展出更好的視覺能力一樣,研究團隊相信改進的視覺能力不僅僅是看得更遠,而是更深入地理解。

最后的最后,謝賽寧還分享了本人的一些感悟:

當我從業界轉到學術界時,我并不確定,我們是否能完成這種需要全棧技能的大型項目。如果沒有谷歌TPU研究云計劃的支持,這個項目是不可能完成的(非常感謝Jeff Dean和Demis Hassabis對學術界的持續支持)。我認為Cambrian項目證明了學界和業界是可以互補的。

愛丁堡大學機器學習博士Yao Fu表示,作為一個想要了解視覺語言的LLM學者,我發現這篇論文有極高信息量,直接回答了我的困惑。

斯坦福大學博士后研究員Karl Pertsch暢想了這項研究的前景,他認為,視覺語言模型(VLMs)在視覺方面還有很大的改進空間,機器人學也可能是一個很好的測試平臺!

「對于視覺語言動作(VLA)訓練(即視覺語言模型+動作),我們發現現有的視覺編碼器需要大量的微調,才能在機器人控制中表現良好,不過在這一領域的評估并不容易」。

一起看看這項研究的技術細節。

開始熱身

在當前的MLLM研究中,視覺組件的設計選擇通常沒有得到充分探索,并且與視覺表征學習研究脫節。

這種差距,阻礙了現實場景中準確的感官基礎。

這項研究的動機,正是源于當前多模態學習研究存在的兩個潛在問題。

1. 過早地依賴語言可能會成為一種捷徑,彌補學習有效視覺表征的缺陷

2. 現有的基準可能無法為現實場景提供足夠的指導,畢竟,視覺基礎對于穩健的多模態理解至關重要

如上文所言,這些擔憂并非空穴來風,因為研究人員已經開始注意到,視覺基礎早已成為在具有挑戰性的現實世界中應用MLLM的瓶頸。

與此同時,用于視覺表征學習的傳統評估基準(例如,在ImageNet-1K、COCO和ADE20K等數據集上進行線性探測和端到端微調)正在變得飽和,并不能反映現實世界分布中的多樣化感知挑戰。

相比之下,使用視覺問答(VQA)形式的語言提供了靈活且強大的評估基準。

而這項研究,就探索了全新的協議基準,從而更好地指導未來的視覺表征開發。

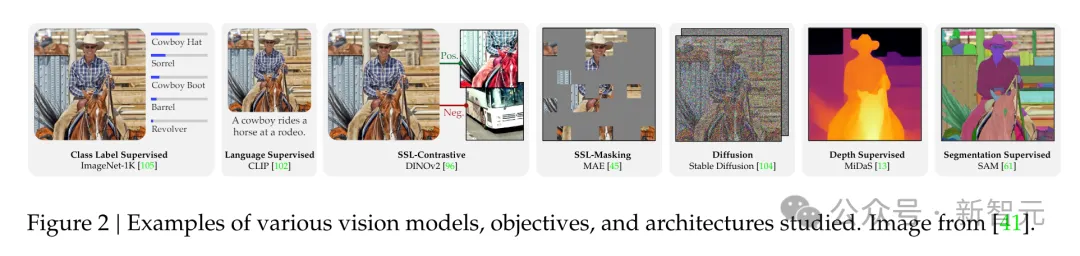

各種視覺模型、目標和架構的示例

多模態領域的基準測試

為了有效評估視覺表征和MLLM,首先就需要選擇能夠準確評估它們多模態功能的基準。

誰來回答這個問題:LLM還是MLLM?確定基準是否真正需要視覺輸入來解決,一直是視覺語言研究中的挑戰。

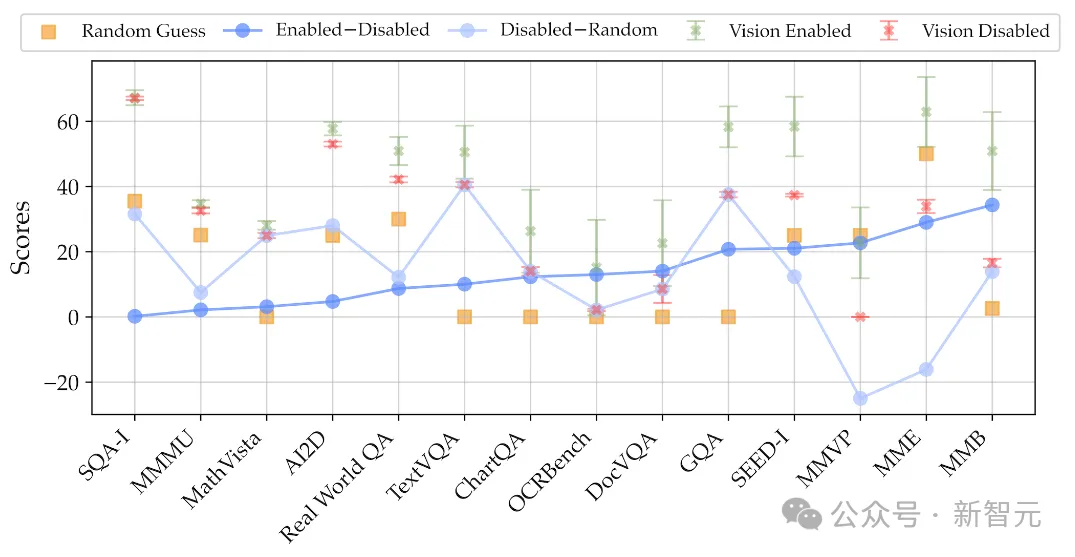

為此而,研究人員比較了使用23個不同視覺主干訓練的MLLM,分別禁用和啟用它們的視覺能力并且通過隨機猜測,計算了預期分數。

MLLM在啟用和禁用視覺輸入情況下,在不同基準測試中的表現

實驗結果如上圖所示,一些基準(比如MMMU和AI2D)不太依賴視覺輸入,而在其他基準(如MMVP和MME)上則出現了顯著的性能下降,表明后者能夠對MLLM進行有效評估。

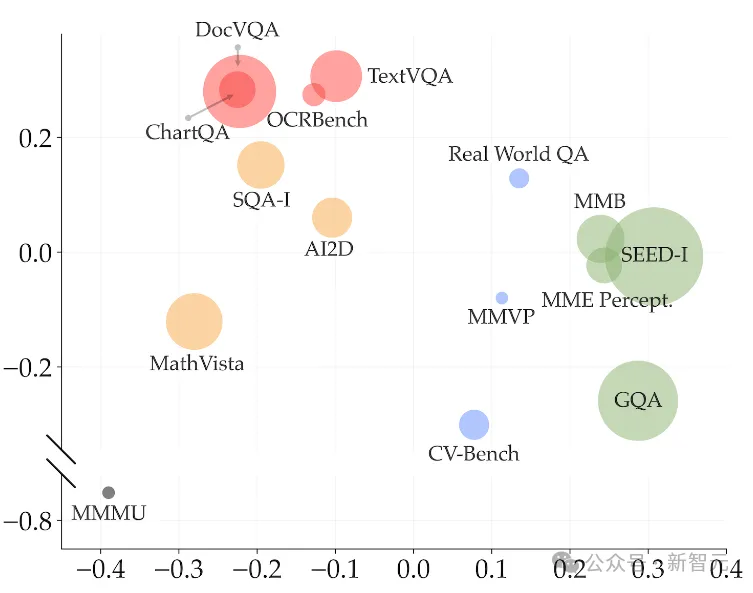

基于性能指標的主成分分析,顯示基準測試的聚類情況

通過對各種基準上的MLLM性能的相關性分析和主成分分析,可以得到不同的聚類:藍色的「通用」、黃色的「知識」、紅色的「圖表與OCR」和藍色的「以視覺為中心」。

上圖中的圓圈大小表示基準的不同規模,可以看到,以視覺為中心的基準非常稀缺。

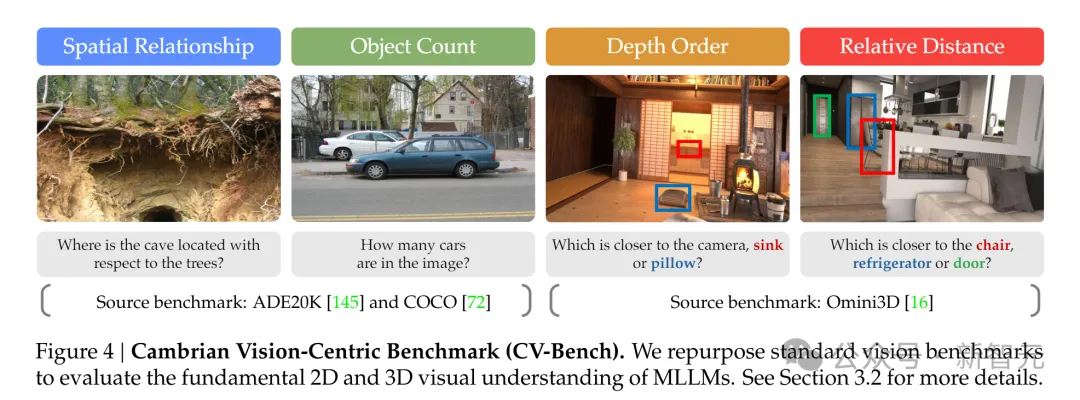

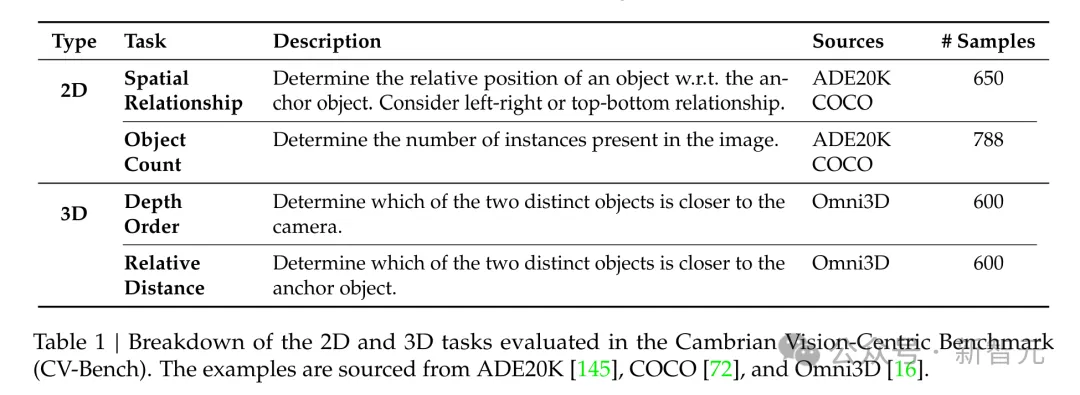

于是,為了更好地評估真實環境中的視覺表征,研究人員通過將傳統視覺基準轉換為VQA格式,開發了一個以視覺為中心的MLLM基準——CV-Bench。

如下圖和下表所示,CV-Bench通過空間關系和物體計數評估2D理解,通過深度順序和相對距離評估3D理解。

CV-Bench重新利用標準視覺任務進行多模態評估,包含約2600個VQA問題。

指令微調

一階段與兩階段訓練

MLLM一般使用MLP作為連接器連接預先訓練的LLM和視覺骨干網。

不過最近的研究建議跳過連接器預訓練以降低計算成本(同時不影響性能)。

于是作者用不同大小的適配器數據進行了實驗,遵循LLaVA的方法,最初僅微調連接器,然后解凍LLM和連接器。

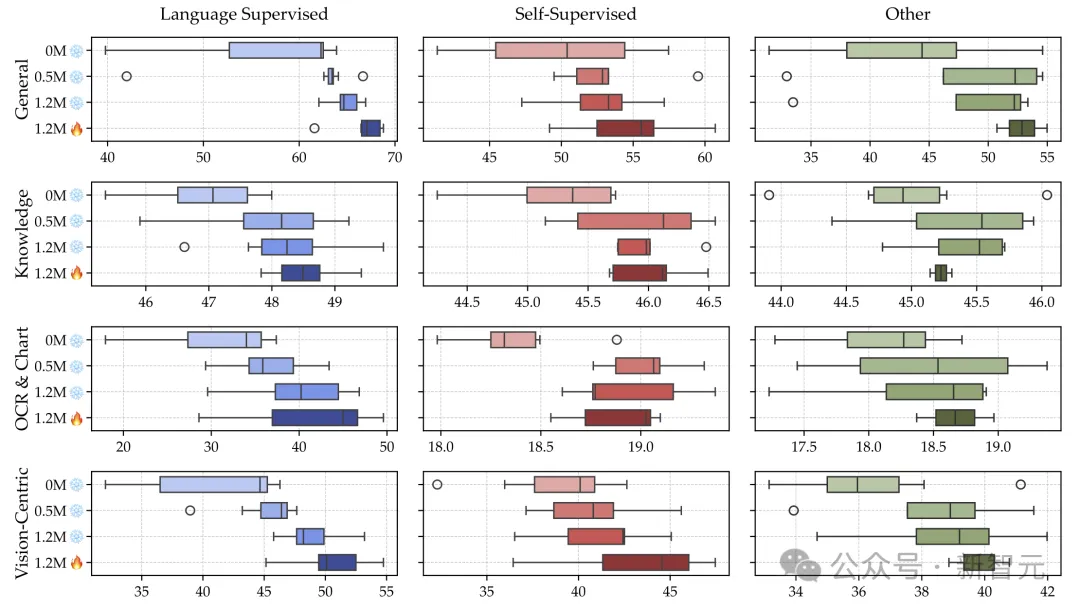

下圖表明,預訓練連接器可以提高性能,而使用更多適配器數據可以進一步增強性能,所以這里采用1.2M適配器數據標準化2階段訓練方法。

凍結與解凍視覺編碼器

在微調期間可以選擇凍結或解凍視覺主干網絡。一些人認為,解凍視覺主干會顯著降低性能。

本文的實驗表明,在合理的視覺模型學習率下,除了知識基準的邊際變化之外,解凍有利于提高所有基準測試的性能。

MLLM作為視覺模型評估器

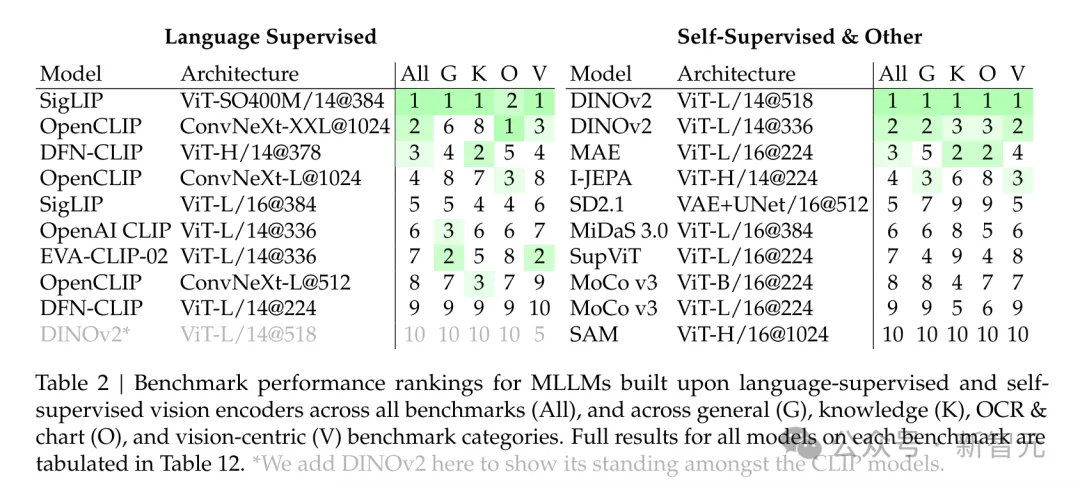

使用2階段指令微調、1.2M適配器數據、737K微調數據來比較各種視覺模型對下游MLLM性能的影響。

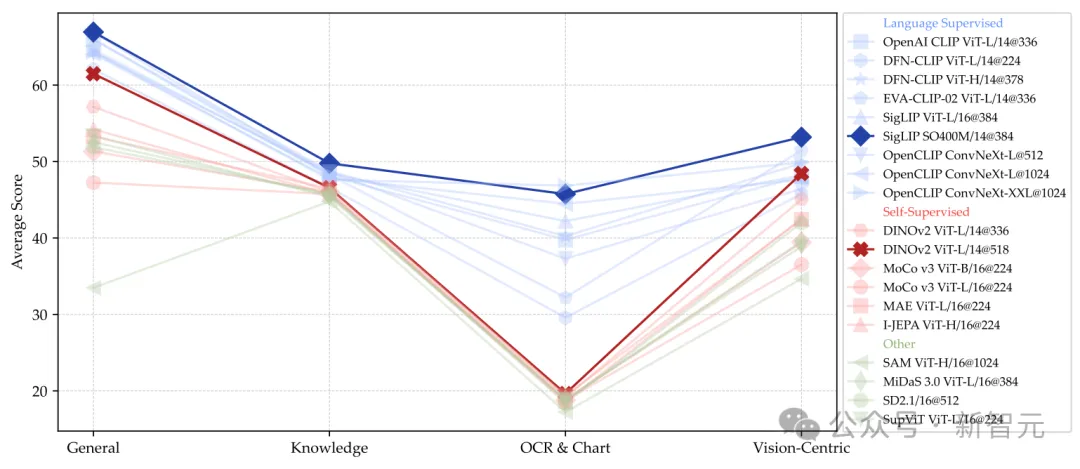

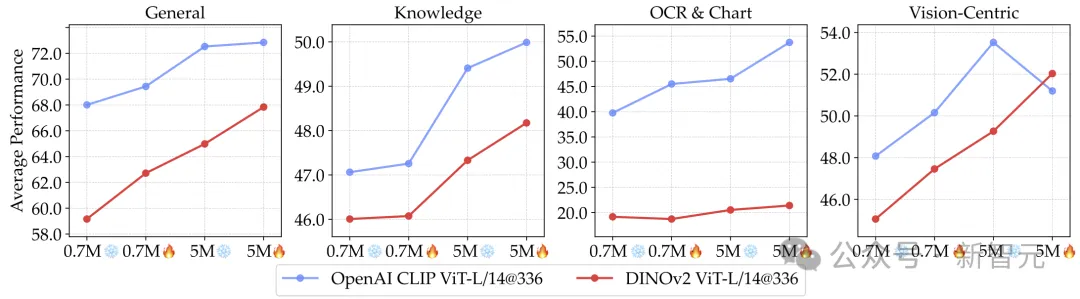

評估結果表明,語言監督模型在所有基準類別中都表現出強大的優勢,尤其是在OCR和圖表任務中。

另外,盡管DINOv2等SSL模型的數據集較小,但它們在以視覺為中心的基準測試中表現很不錯。

基于語言監督和自監督視覺編碼器的MLLM在各類基準測試中的性能排名,包括所有基準測試(All)、一般類(G)、知識類(K)、OCR和圖表類(O)、以及以視覺為中心的基準測試(V)。

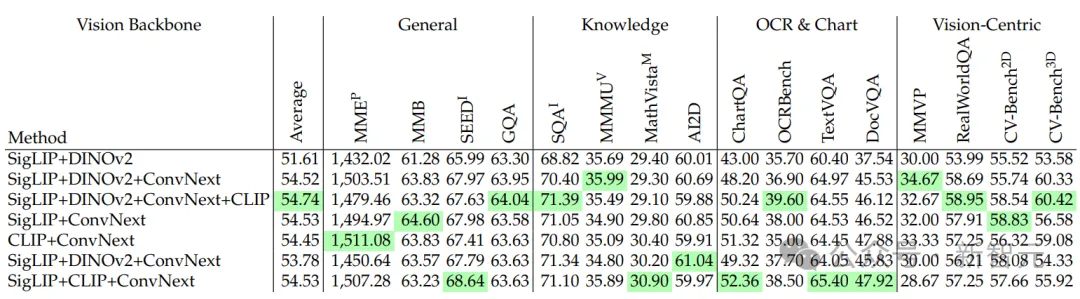

組合多個視覺編碼器

如上圖所示,不同的視覺模型在MLLM性能的不同方面表現各有千秋。研究人員于是探索了組合多個視覺編碼器以利用其獨特的潛力。

鑒于不同的視覺編碼器使用不同的架構和圖像分辨率,這里將輸出視覺標記插值到固定數字576。結果如下表所示,隨著更多模型的添加,性能得到了一致的改進。

然而,這種策略有兩個局限性:1)采用插值可能會導致信息丟失,特別是在具有高分辨率特征圖的視覺編碼器上,2)不應簡單的串聯每個模型,而是需要尋求一種更有效的策略,充分利用模型組合,使信息損失更少,靈活性更大。

縮小CLIP和SSL模型之間的差距

在上面的結果中,DINOv2在一般VQA和知識VQA任務上,表現處于SSL模型和CLIP模型之間,而在以視覺為中心的基準測試中優于某些CLIP模型。

研究人員嘗試解凍視覺主干并增加視覺微調數據量,以縮小這一差距。

如下圖所示,通過解凍視覺主干,并使用5M數據進行微調,基于DINOv2的MLLM超過了使用CLIP模型的MLLM(0.7M訓練數據)。

此外,在5M數據的實驗設置下,DINOv2與CLIP模型之間的差距縮小了。

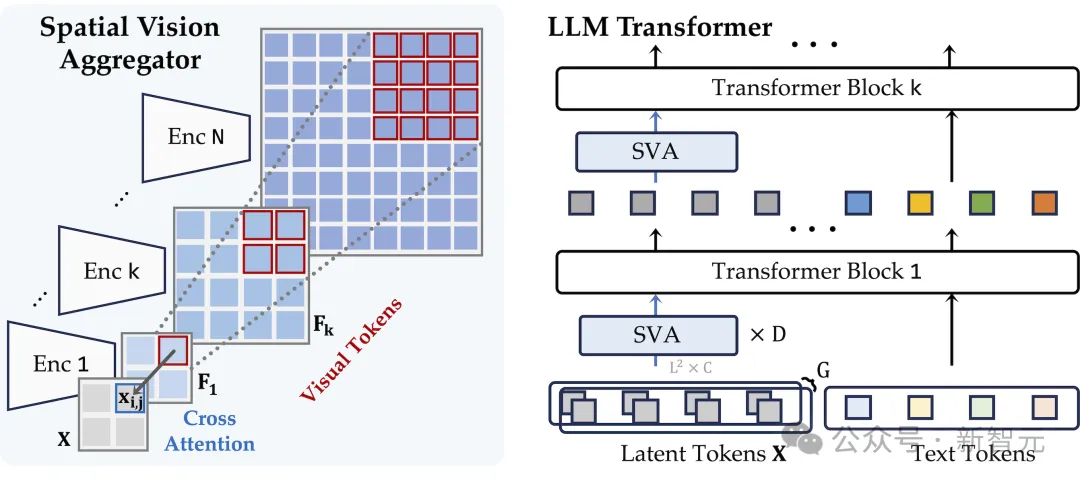

新的連接器設計

為了有效地聚合來自多個視覺編碼器的特征并減少插值期間的信息丟失,這里使用一組可學習的潛在查詢,它們通過交叉注意力層與多個視覺特征交互。

方法結合了兩個新的以視覺為中心的設計原則:

1.通過顯式本地化查詢中每個標記的聚合空間來編碼空間歸納偏差。

2.在LLM層中多次執行視覺特征聚合,允許模型重復引用必要的視覺信息。

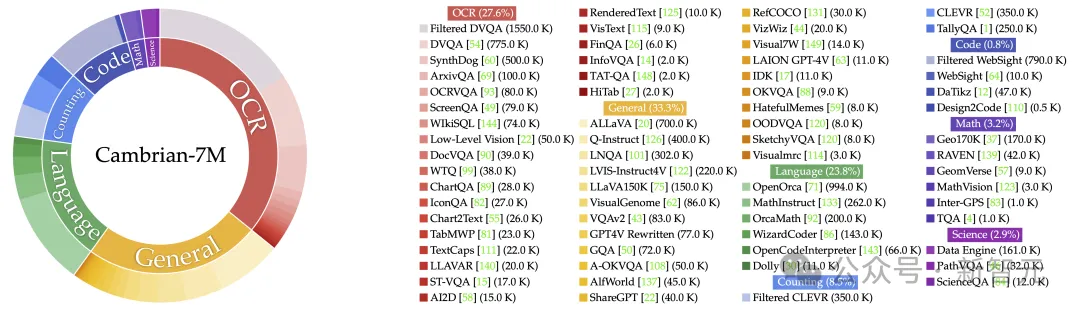

指令微調數據

研究人員收集了所有可用的指令微調數據,并通過增強多樣性、平衡來源和改進混合來檢查數據管理。

數據采集

作者首先使用涉及視覺交互數據的現有多模態基準和數據集,例如視覺問答(VQA)和OCR數據。此外還收集了少量高質量的語言指令跟蹤數據,以維持其語言能力。

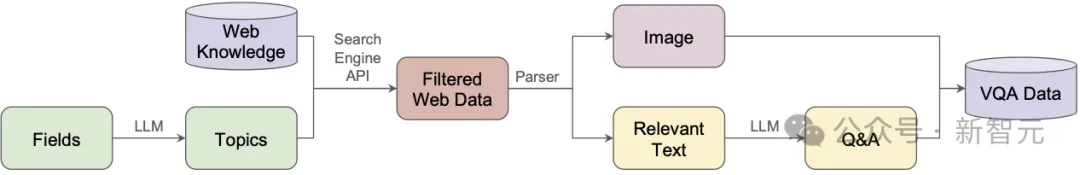

作者還推出了一個數據引擎,幫助創建大規模、可靠、高質量的基于知識的多模態指令微調數據。

最終,這些數據構成了一個大型指令微調數據池——Cambrian-10M,包含大約9784k個數據點。

另外,研究人員還通過改進數據平衡和微調數據比率來進行數據管理。

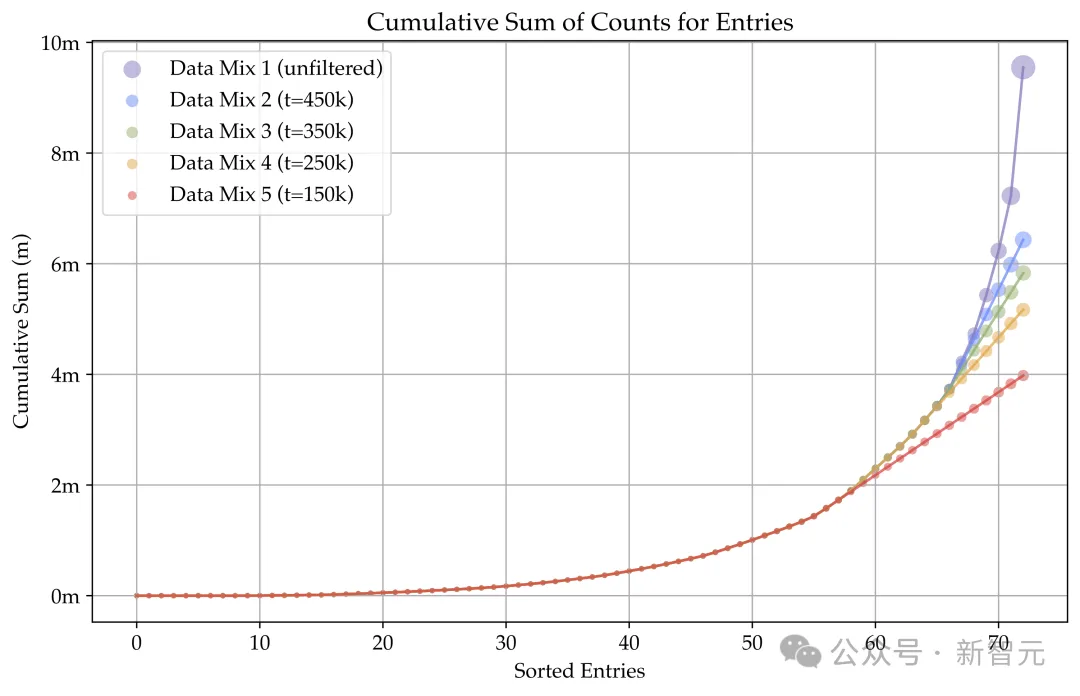

為來自單個數據源的數據點數量設置閾值t,選擇t=150k、250k、350k和450k,發現250k和350k之間的閾值對于Cambrian-10M效果最佳。

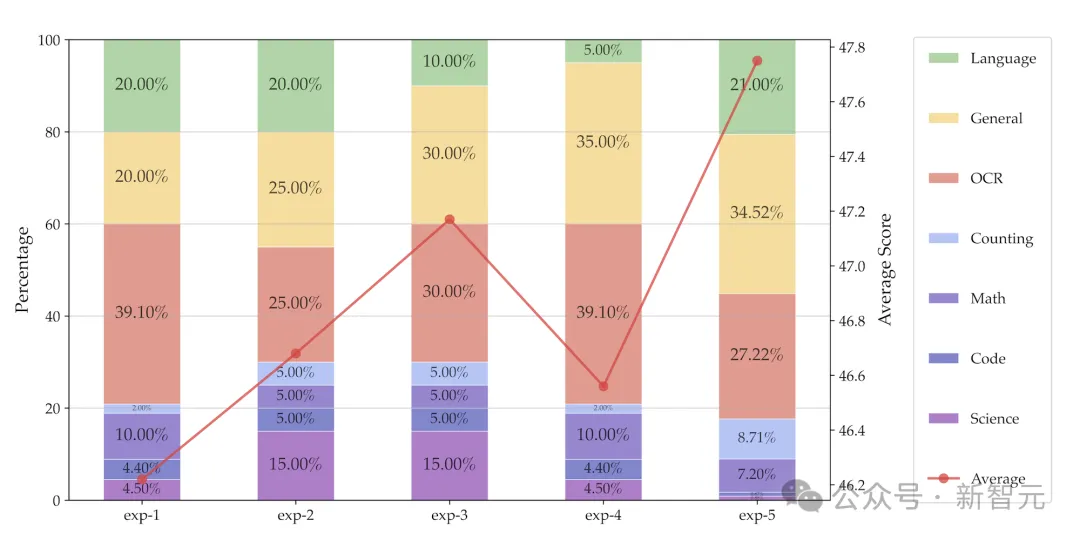

考慮到不同類型的視覺指令微調數據的不同能力,平衡這些數據類型的比例至關重要。

使用1350k的固定數據集大小進行試點實驗,檢查不同數據比例對下游性能的影響。從下圖的結果可以發現:

(1)平衡一般數據、OCR和語言數據至關重要。(2)知識密集型任務的表現受到多種因素的影響,通常需要結合OCR、圖表、推理和一般感知。

答錄機現象

在這里,研究人員觀察到了一種「答錄機現象」。

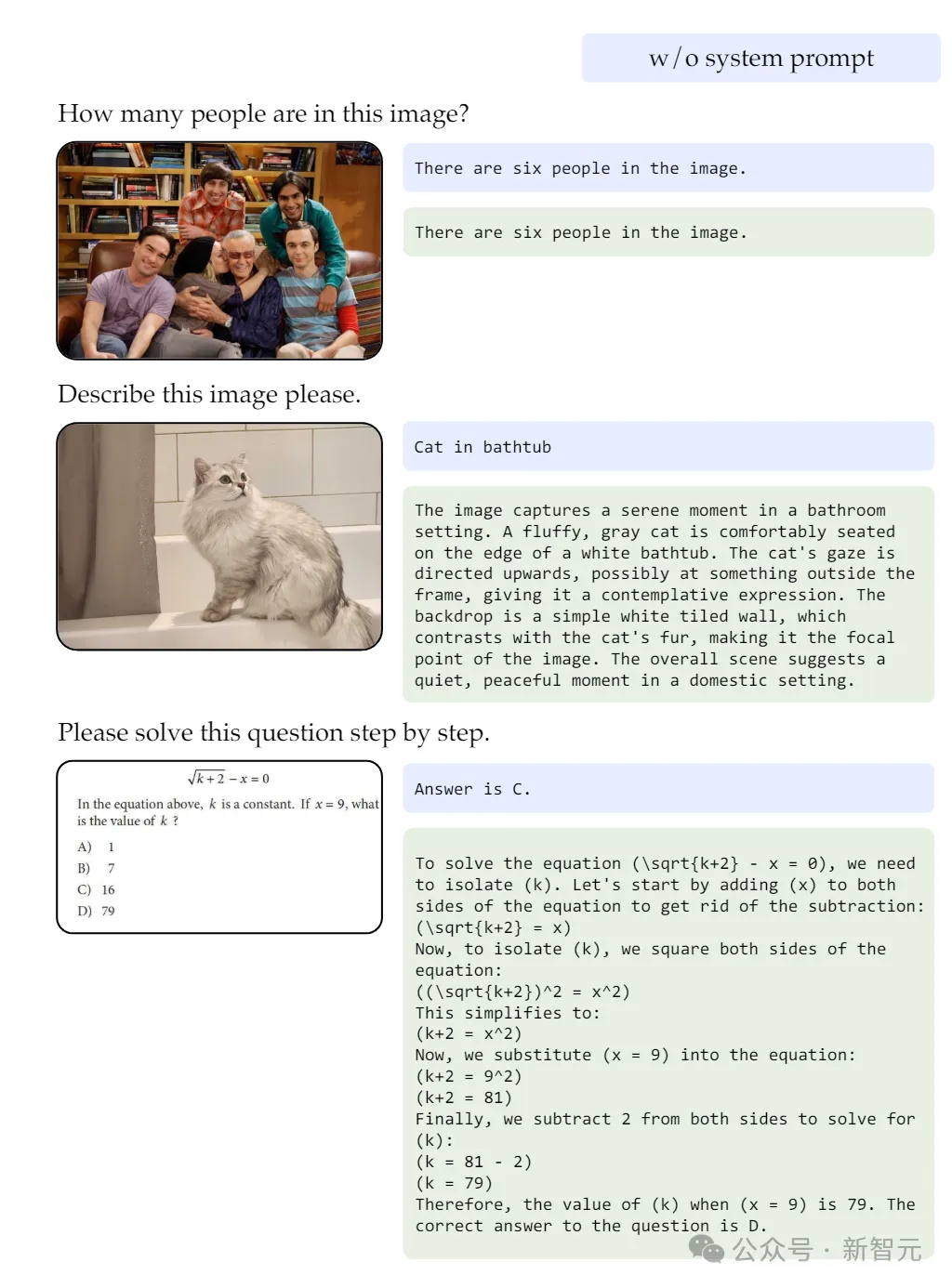

他們發現,訓練有素的MLLM在VQA基準測試中表現出色,卻往往缺乏基本的對話能力,傾向于輸出簡短的響應。

這種差異的原因在于,基準測試問題通常只需要一個選項、選擇或單詞的回答,這與MLLM在更廣泛和現實的應用場景中有所不同。

研究人員認為,這個問題是由于指令微調數據中包含了過多的簡答VQA任務,導致大語言模型出現了災難性遺忘。

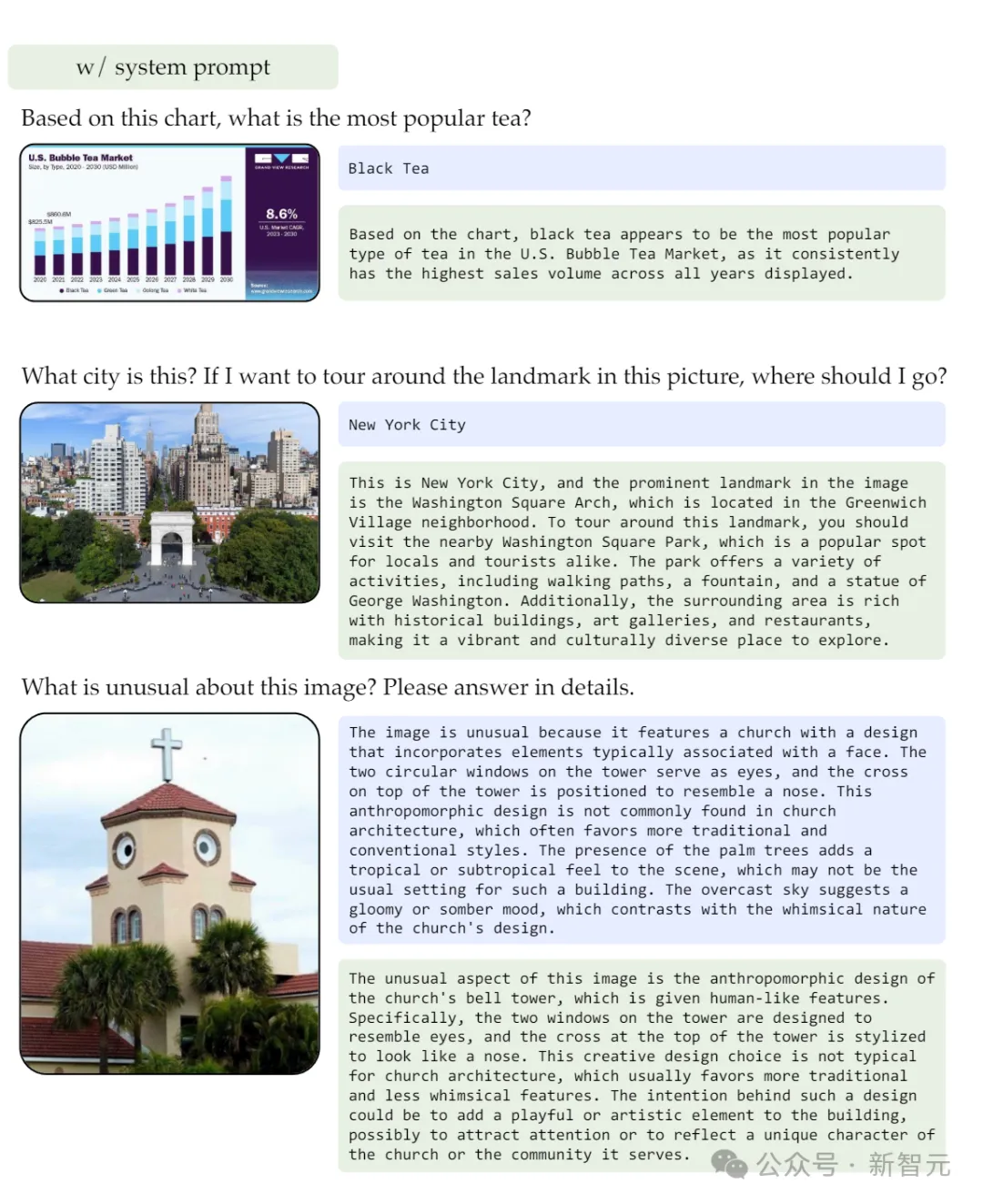

作者發現,在訓練期間加入額外的系統提示可以減輕這種現象。

通過附加諸如「用一個單詞或短語回答問題」之類的提示,模型的基準性能保持不變,而其會話能力顯著提高。

比如下圖中,帶有系統提示的模型會在正確回答問題的同時,產生更長、更有吸引力的回答。

而且,系統提示還會通過鼓勵一連串的思考,來增強模型在推理任務(如數學問題)上的表現。

SOTA MLLM

最后,研究人員基于之前的設計框架,訓練一個高性能的Cambrian模型。

他們使用了三種參數大小的LLM進行了訓練:LLaMA-3-Instruct-8B、Vicuna-1.5-13B、Hermes-2-Yi-34B。

視覺部分結合了四種模型——SigLIP、CLIP、DINOv2和OpenCLIP ConvNeXt,并使用了空間視覺聚合器。

與此同時,訓練過程中采用了250萬條適配器數據,以及700萬條指令微調數據。

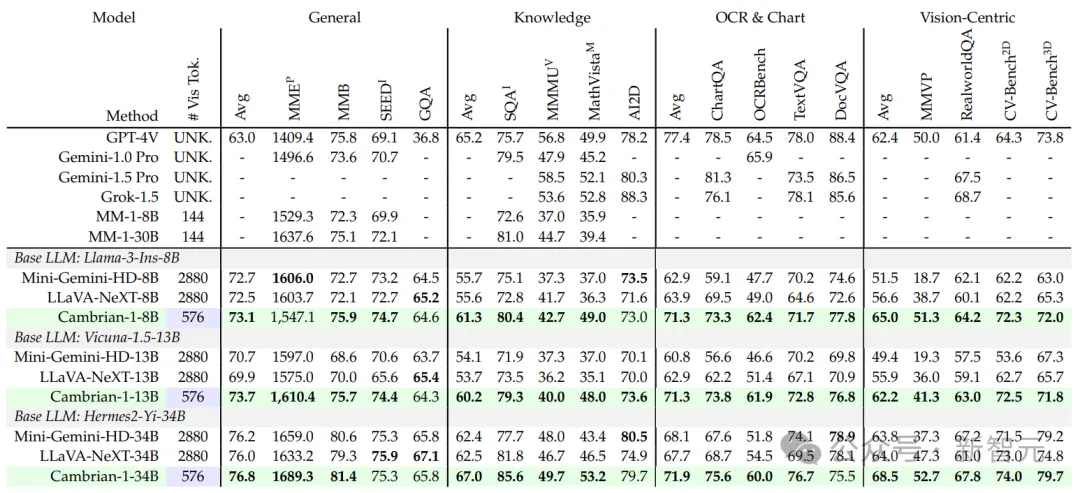

經過實驗評估,性能結果如下表5所示,Cambrian-1超越了其他開源模型,如LLaVA-NeXT和Mini-Gemini,并在多個基準測試上達到了與最佳專有模型(如GPT-4V、Gemini-Pro和MM-1)相當的性能。

Cambrian-1僅僅使用了576個token,卻仍能有效關注圖像中的細節。

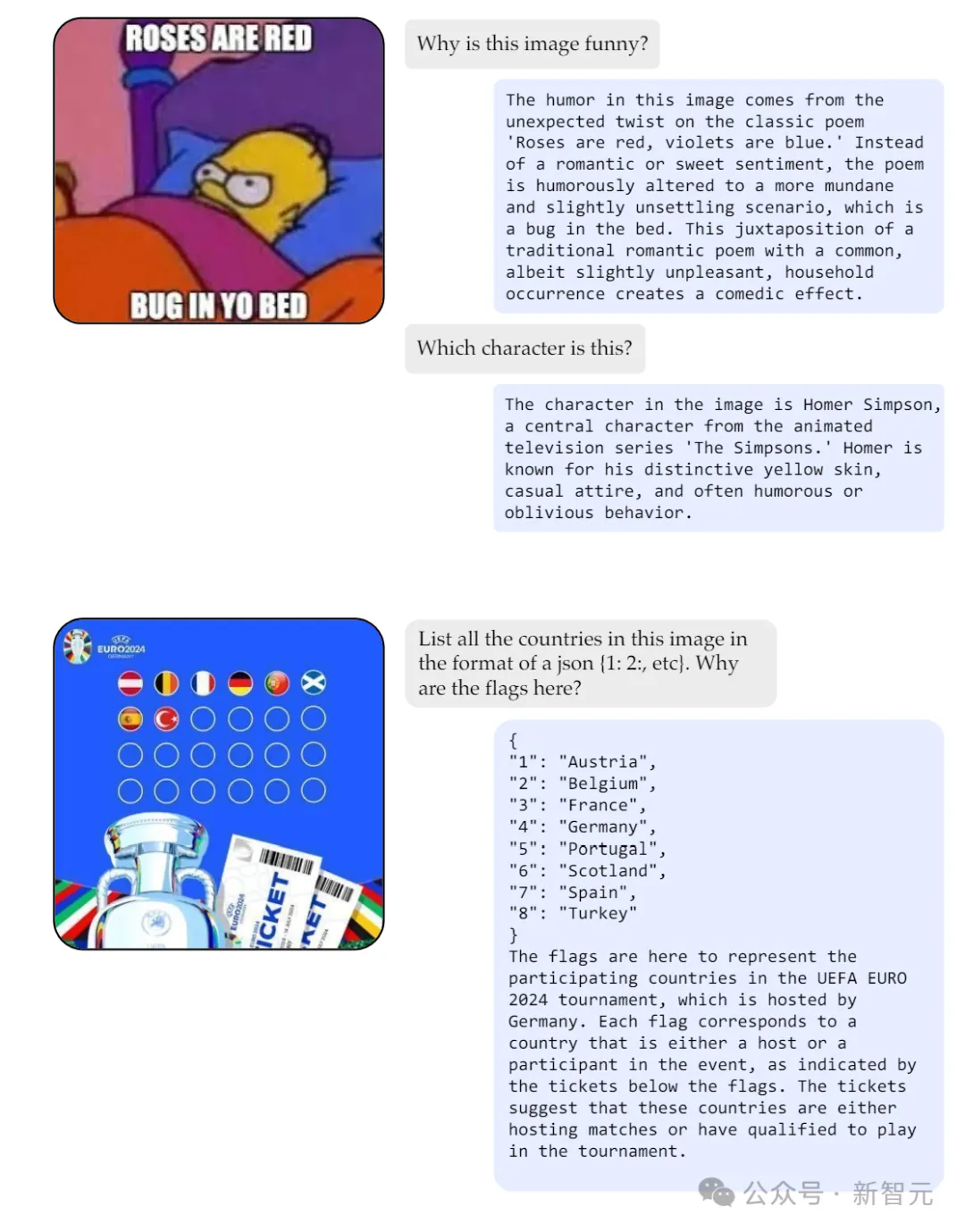

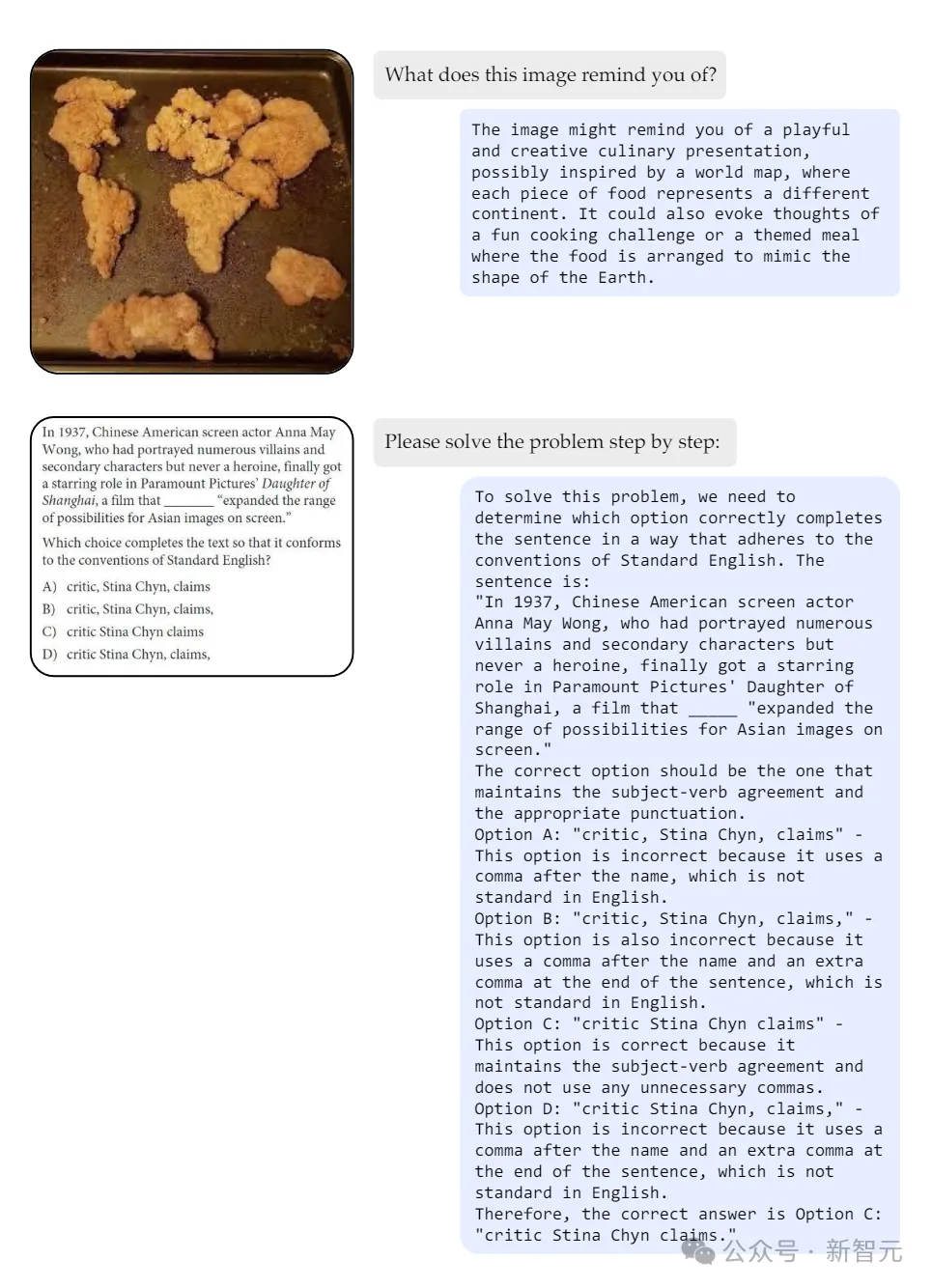

如下面兩張圖所示,Cambrian-1-34B在視覺交集方面,展示了令人印象深刻的能力。

從最下面的示例可以看出,它展示出了指令跟隨能力,例如json格式的輸出。

另外,從下圖中模型處理不同的逗號的示例可以看出,Cambrian-1還表現出了卓越的OCR能力。

作者介紹

Shengbang Tong

Peter Tong(Shengbang Tong,童晟邦)是NYU Courant CS的一名博士生,導師是Yann LeCun教授和謝賽寧教授。

此前,他在加州大學伯克利分校主修計算機科學、應用數學(榮譽)和統計學(榮譽)。

并曾是伯克利人工智能實驗室(BAIR)的研究員,導師是馬毅教授和Jacob Steinhardt教授。他的研究興趣是世界模型、無監督/自監督學習、生成模型和多模態模型。

Penghao Wu

Penghao Wu是加州大學圣地亞哥分校計算機科學專業的碩士研究生,此前于2018年在上海交通大學獲得電子與計算機工程學士學位。

目前,他在紐約大學做研究實習生,導師是謝賽寧教授。

Ellis Brown

Ellis Brown是紐約大學Courant計算機科學博士生,導師是謝賽寧和Rob Fergus,并獲得了NDSEG獎學金。

最近,他于卡內基梅隆大學獲得碩士學位,導師是Deepak Pathak和Alyosha Efros。在此之前,于范德比爾特大學獲得了計算機科學和數學的學士學位,并與Maithilee Kunda一起研究CoCoSci和視覺。

此外,他曾在艾倫人工智能研究所的PRIOR團隊進行過實習,導師是Ross Girshick。并且還是BlackRock AI Labs的創始研究工程師,與Mykel Kochenderfer、Stephen Boyd和Trevor Hastie合作進行應用研究與金融研究。