NeurIPS 2024 | 從單圖到3D:HumanSplat 基于Gaussian Splatting實現高保真人體3D生成

在虛擬和增強現實中,構建寫實風格的虛擬人體形象已成為實現自然交互和逼真體驗的關鍵技術之一,并且在社交媒體、游戲、電商、遠程交流等領域擁有廣泛應用。然而,現有的人體重建方法通常依賴大量的多視圖圖像輸入或需要對每個實例進行耗時的優化處理,這不僅限制了其在實際場景中的適用性和效率,也難以滿足快速和高質量建模的需求。因此,僅從單張輸入圖像生成高保真度的人體模型仍然是一個充滿挑戰的課題。

在近日召開的神經信息處理系統大會(NeurIPS 2024)中,來自字節跳動 PICO 交互感知團隊、清華大學和北京大學的研究人員發表了最新研究成果《HumanSplat: Generalizable Single-Image Human Gaussian Splatting with Structure Priors》。該論文提出了一種創新的單張圖像人體重建方法——HumanSplat,這是一個基于結構先驗的泛化人體3D生成框架,可以高效地從單張輸入圖像預測人體的3D重建結果。

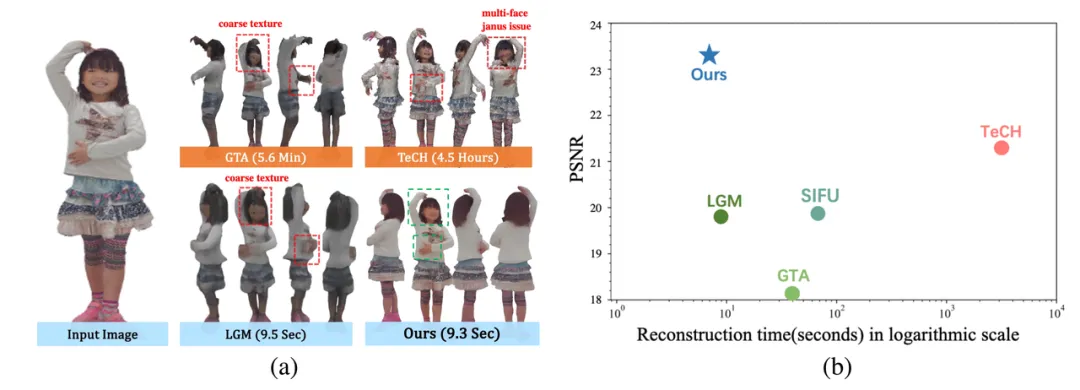

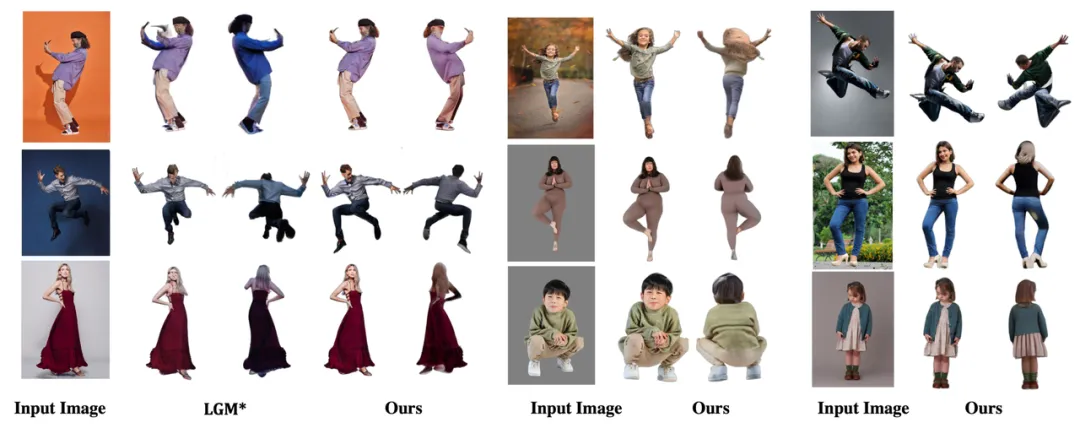

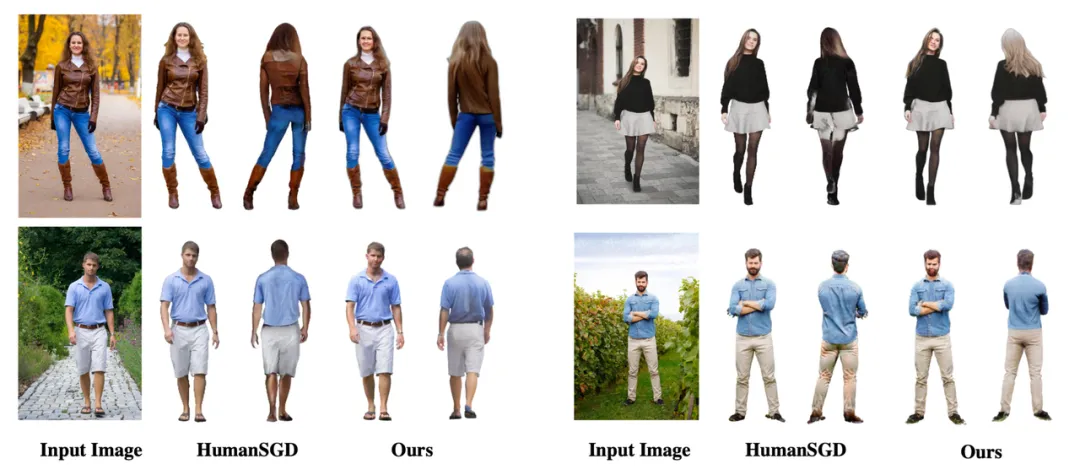

HumanSplat在保持最快運行時間的同時,實現了領先的渲染質量:(a) 定性結果對比;(b) 效果和運行時間對比

論文鏈接:

https://arxiv.org/pdf/2406.12459

項目主頁:

代碼鏈接:

https://github.com/humansplat/humansplat

背景

目前,單圖像人體重建方法主要分為顯式方法和隱式方法。顯式方法(如基于參數化人體模型SMPL的方法)通過直接優化模型參數和服裝偏移以擬合輸入圖像,從而生成人體網格。然而,這些方法通常難以處理復雜的服裝樣式,并且需要較長的優化時間。隱式方法則通過連續函數(如占據場、SDF 或 NeRF)表示人體,這些方法在建模靈活拓撲結構上表現較好,但由于訓練和推理的高計算成本,其在可擴展性和效率方面存在局限性。

近期,3D Gaussian Splatting(3DGS)技術為3D人體模型重建提供了效率與渲染質量的平衡。然而,已有的方法通常需要多視圖圖像或單目視頻作為輸入,并未能解決單圖像輸入重建問題。此外,一些基于擴散模型的研究通過得分蒸餾采樣(SDS)將二維擴散模型先驗提升到三維,但每個實例通常需要長達數小時的優化時間;一些泛化的人/物體生成模型雖然能夠直接生成三維表示,但往往忽略了人體幾何先驗,或仍然需要多視圖輸入,導致其在穩定性和實用性上的不足

HumanSplat 的核心是結合2D生成擴散模型和人體幾何結構先驗,在統一的框架中整合幾何和語義信息,從而在保持高質量的同時實現高效重建。為了解決單視圖輸入下的不可見區域問題,HumanSplat 首先利用一個 2D 多視角擴散模型(novel-view synthesizer)生成目標人體的不可見區域,然后通過一個泛化的隱空間重建 Transformer (latent reconstruction transformer)將擴散模型生成的特征與人體結構先驗進行深度交互,最終重建基于3DGS表達的人體模型。

方法

HumanSplat設計了一個泛化的人體3DGS生成框架,通過在人體數據集上精調的2D多視角擴散模型和精心設計的基于參數化模型的3D人體結構先驗實現高保真度的人體重建。與現有的3DGS方法不同,我們的方法直接從單張輸入圖像推斷3DGS的高斯屬性,無需對每個實例進行優化,也無需密集捕獲的目標人體的圖像數據,從而有效地在各種場景下進行泛化,提供高質量的重建結果。

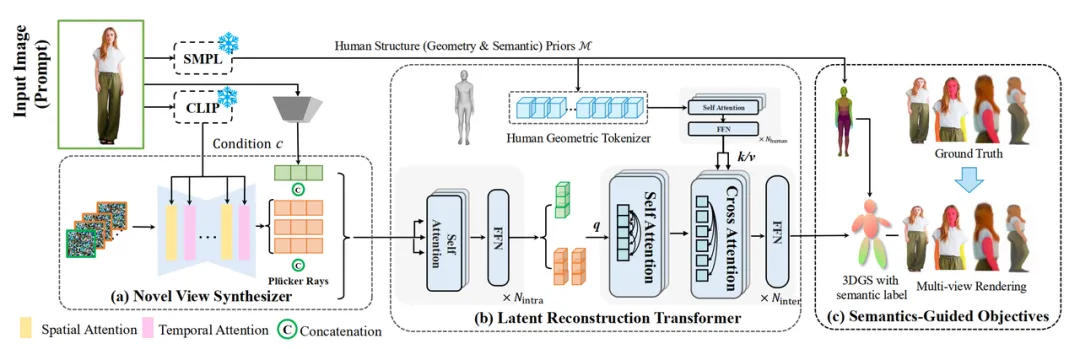

核心框架 HumanSplat網絡的核心框架如下圖所示,它結合了2D生成式擴散模型(novel view synthesizer,圖中(a)所示)與隱空間重建Transformer(latent reconstruction transformer,圖中(b)所示),并在統一框架中充分融合了人體幾何先驗、2D外觀先驗和基于人體語義信息的分層監督和定制損失函數(圖中(c)所示)。我們的方法主要分為以下幾步:

- 結構先驗與CLIP特征提取 我們首先使用SMPL預測器估計人體結構先驗,即當前圖像對應的參數化人體模型SMPL參數,并通過CLIP特征提取器提取輸入圖像的嵌入式特征。

- 多視角特征生成器 我們采用了基于時間-空間隱式編碼的2D擴散模型,即通過人體數據精調SV3D視頻生成模型,然后結合輸入圖像和CLIP嵌入式特征生成多視角潛空間特征。

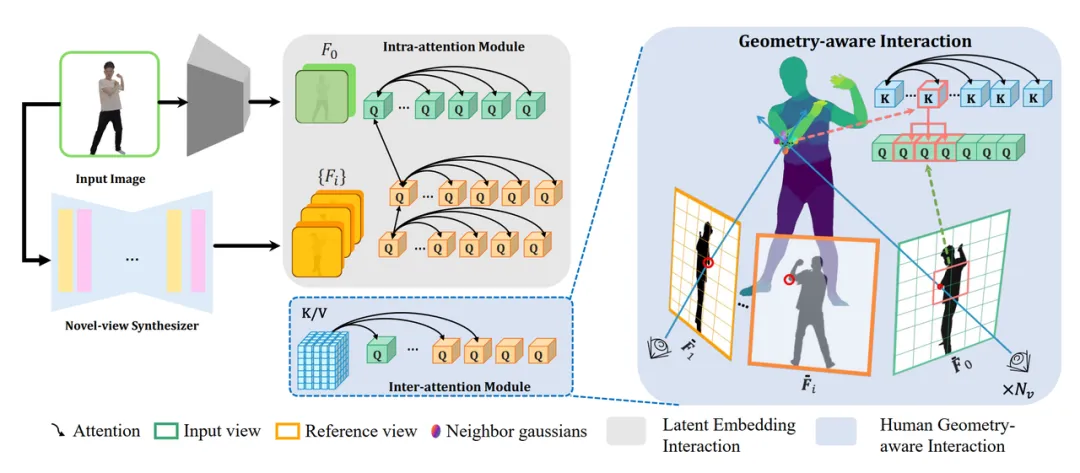

- 隱空間重建與高斯點云生成 我們提出了一種新穎的隱空間重建Transformer,結合第一步中得到的人體幾何先驗與和第二步中得到的多視角隱空間特征,經過一個Transformer框架的模型進行信息交互,信息交互方式如下圖所示,然后生成人體高斯屬性。隨后,這些高斯點被渲染成新的視角圖像。

- 分層語義損失設計 最后,為了提升人體的細節重建質量并更好地約束多視角生成結果,我們還設計了分層語義感知損失,將人體語義先驗融入到訓練中。

訓練與推理

- 訓練階段 我們使用3000個3D掃描的人體數據進行訓練,以確保網絡能夠從不同視角獲取準確的監督信號。訓練過程在八卡A100上不超過3天。

- 推理階段 在推理時,直接基于訓練好的模型從單張圖像生成新視角,無需任何微調或優化步驟。

貢獻總結

- 提出了一個新穎的泛化的單圖人體高斯生成網絡,實現從單圖像進行高保真度人體重建。我們的方法首次結合2D生成式擴散模型與隱空間高斯重建模型,在端到端框架中高效且準確地進行單圖像人體重建。

- 通過結合SMPL模型中的人體幾何先驗與2D生成式擴散模型中的外觀先驗,穩定了人體幾何的高質量生成,并幫助生成有著復雜幾何人體的不可見部分。

- 通過引入語義線索、分層監督和定制損失函數,提升了重建人體模型的細節保真度,實驗結果表明,我們的方法超越了現有方法,達到了領先的效果。

實驗結果

在我們的實驗中,HumanSplat展現了顯著的優勢,尤其在渲染質量、重建速度和泛化能力方面,超越了現有的一些最先進的方法。

- 重建速度:HumanSplat 在視頻擴散模型生成多視角潛在特征的速度上僅需約 9秒,而后續的3D高斯重建只需 0.3秒,顯著提升了效率。此外,基于 NVIDIA A100 GPU,它能夠以超過 150 FPS 的速度渲染新視角,極大提升了實時渲染性能。

- 定量對比:在 THuman2.0 和 Twindom 數據集上,HumanSplat 在 PSNR 和 LPIPS 等指標上都表現出色,尤其在 Twindom 數據集上,PSNR 提升了 10.16%,LPIPS 減少了 0.063,超越了最新的 TeCH 方法。與 TeCH 需要 4.5小時的重建時間相比,HumanSplat 的重建時間僅為 9.3秒,大大提高了實用性。

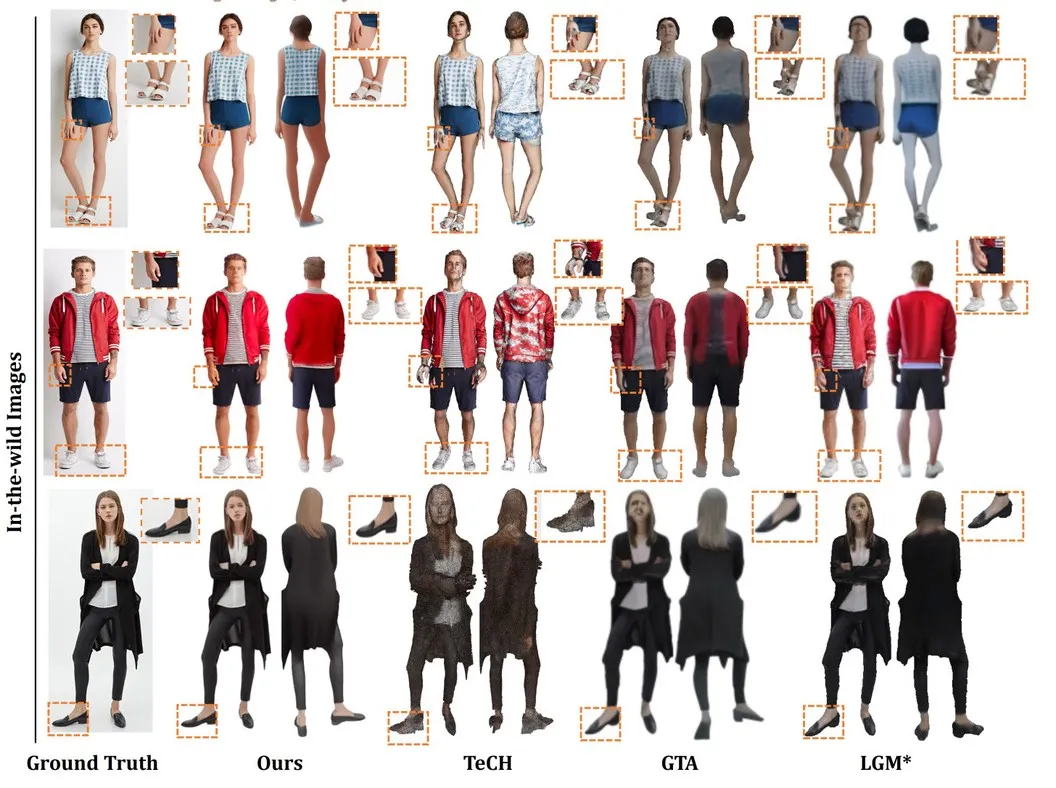

- 定性對比:如下圖所示,和已有的方法對比,HumanSplat 顯示出更加細致和高保真度的結果,HumanSplat 比 GTA 和 LGM 更能還原細節。此外,HumanSplat 能有效預測3D高斯點的屬性,無需針對每個實例進行優化,展示了強大的泛化能力。

a.在復雜姿勢、不同身份和攝像機視角下的重建的對比見下圖:

b. 在挑戰性較大的一般(In-the-wild)圖像中的對比見下圖:

總結

HumanSplat 展示了僅依靠單張圖像即可生成高保真虛擬人體模型的能力,特別是在面部和手部等關鍵區域實現了高質量的重建效果。該方法結合了生成式擴散模型與隱碼重建Transformer模型,并融入了人體結構先驗與語義感知的分層損失設計,實現了無需優化或微調的高保真度重建,特別是在面部和手部等關鍵區域效果顯著。與現有方法相比,HumanSplat在質量與效率上均有顯著提升,能夠穩健應對復雜姿態和寬松服飾。

相信在未來的虛擬現實與沉浸式體驗場景中,借助 HumanSplat 的技術,個性化虛擬形象的生成將變得更加高效便捷。無論是在社交媒體、虛擬會議還是游戲娛樂中,每個人都能快速創建專屬的高真實感形象,顯著提升互動的沉浸感與真實感,為各種領域的用戶體驗帶來改變。