SCOPE:面向大語言模型長序列生成的雙階段KV緩存優化框架

Key-Value (KV)緩存已成為大語言模型(LLM)長文本處理的關鍵性能瓶頸。當前研究尚未充分關注解碼階段的優化,這一階段具有同等重要性,因為:

1、對需要完整上下文的場景,預填充階段的過度壓縮會顯著降低模型的推理理解能力

2、在長輸出推理任務中存在重要特征的顯著偏移現象

這篇論文提出SCOPE框架,通過分離預填充與解碼階段的KV緩存優化策略,實現高效的緩存管理。該框架保留預填充階段的關鍵KV緩存信息,同時引入基于滑動窗口的新型策略,用于解碼階段重要特征的高效選取。

關鍵發現

KV緩存的推理過程分析

LLM的每次請求包含兩個獨立階段:預填充階段處理完整輸入提示以生成初始輸出標記;解碼階段通過迭代方式逐個生成后續輸出標記。

預填充階段分析

下圖展示了在完整解碼緩存條件下,三個任務在不同預填充階段壓縮比率下的性能表現:

Long-Bench中的PassageRetrieval-en和HotpotQA任務表現出顯著的壓縮容忍度:即使在20%的預填充階段壓縮比率下,模型仍能保持與完整緩存相近的性能水平,證實了模型在高壓縮率下維持上下文理解能力的魯棒性。然而在LONGGENBENCH的GSM8k+任務中,同樣的20%壓縮率導致準確率下降約95%

實驗結果表明:對于依賴完整上下文的推理任務,預填充階段的過度壓縮會導致顯著的性能損失

解碼階段分析

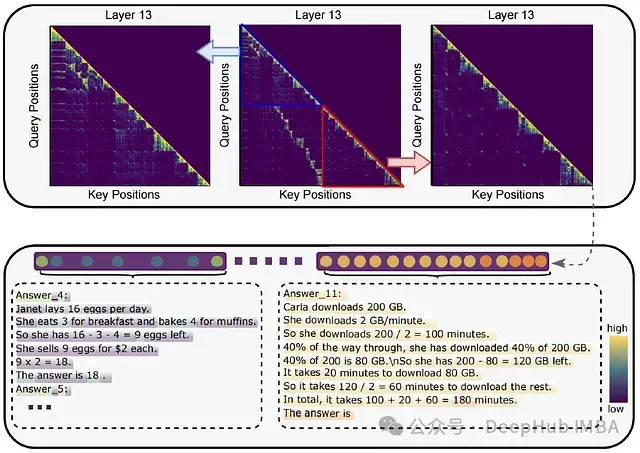

下圖描述了在解碼步驟1、300和500時,基于前15%注意力分數選取的重要特征在0、13和31層的位置分布:

觀察發現,各層中保留的重要特征主要源自解碼階段生成的KV緩存,在長輸出任務中,隨著輸出序列延長,特征偏移現象愈發顯著。這一現象要求在保持預填充階段識別的重要特征的同時,對解碼階段新出現的重要特征實施有效管理。數據表明,長文本生成的解碼階段采用貪婪算法可能引發重要特征的顯著偏移

KV緩存預算分配優化

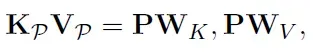

下圖呈現了LONGGENBENCH中GSM8k+樣本第13層的注意力熱力圖,以及注意力分數與生成標記位置的對應關系:

圖中最左側和最右側分別對應預填充和解碼階段。對于需要并行處理多個問題的推理任務,準確定位當前預測位置至關重要。如圖所示,這些關鍵信息可通過貪婪算法識別的重要特征有效捕獲。預填充和解碼階段的KV緩存預算需要獨立分配以實現最優性能。這一發現啟發了SCOPE框架的設計理念:通過解耦預填充和解碼階段的壓縮過程,實現KV緩存預算的精確分配,在保留預填充階段全部KV緩存的同時,優化緩存預算的重分配效率

方法論

KV緩存壓縮機制重構

初始化過程

KV緩存壓縮的核心在于基于預設緩存預算進行動態調整。本文構建了緩存池Φ,其包含兩個子集:存儲預填充階段KV緩存的Φp和存儲解碼階段KV緩存的Φd。緩存池在時間步t實時更新,記為Φt。采用廣泛驗證的貪婪算法函數ΨK(Att)從給定注意力權重Att中篩選Top-K KV緩存

預填充階段設計

定義輸入提示張量P ∈ RM×D,其結構為P = {P1,P2, . . . ,PM},其中:

- Pi表示第i個標記的嵌入向量

- M為輸入標記數量

- D為模型隱藏維度

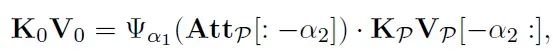

鍵值張量的計算公式如下:

其中:

- WK,WV ∈ RD×D分別為鍵和值的投影權重矩陣

- KV對表示為KPVP

- 注意力權重AttP通過P和KPVP計算得出,預填充階段的壓縮表達式:

其中:

·表示張量連接操作

函數Ψα1(AttP)從AttP[: ?α2]中選擇具有最高Top-α1注意力權重的KV緩存

解碼階段實現

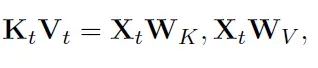

解碼階段復用預填充階段的KV緩存,并通過序列生成過程持續更新,對于時間步t處的新標記張量Xt,t∈{1,T },鍵值計算如下:

過程中,KtVt與緩存池Φ中的歷史KV緩存進行連接,形成當前時刻的KV對。隨后與查詢張量Xt計算得到注意力權重Attt

- 本方法與現有KV壓縮方案的核心區別在于Φp和Φd在緩存池Φ中的動態分配機制

SCOPE框架詳解

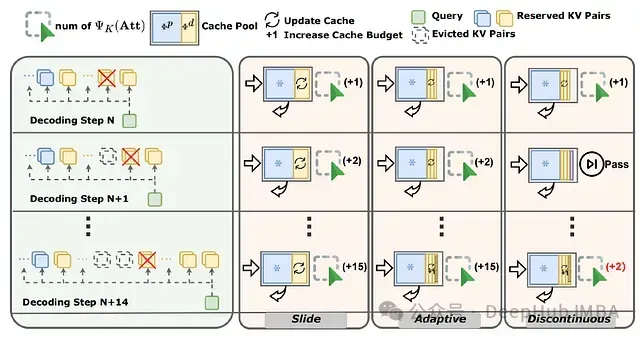

針對解碼階段設計了三種優化策略:滑動窗口、自適應調整和不連續更新,這些策略均專注于Φd的優化

滑動窗口機制

通過動態調整解碼必要歷史窗口β1和解碼局部窗口β2實現解碼階段的KV緩存壓縮:

- β1負責捕獲當前預測位置的上下文信息

- β2保存與歷史標記高度相關的全局特征

滑動策略在t > M + β1 + β2時觸發,通過函數Ψβ1 (Attt[α1 + α2 : ?β2])實現對Φd的定向更新,同時保持Φp不變。該機制通過限制選擇函數Ψ的操作范圍(從α1 +α2開始的Attt),有效規避了預填充階段注意力權重的干擾

自適應調整策略

針對解碼生成標記長度較短的情況,引入動態調整機制,避免過長的解碼必要歷史窗口β1導致的資源浪費。設計了基于時間步驟t和最大長度T的自適應函數,用于動態調整β1長度,其中T ? β1 + β2。窗口大小從基準值β2起始,隨時間步t線性增長:

特征:

- 當t < T時,Φdt的預算規模為β2+(t?β2)·β1/ T?β2

- 該設計有效優化內存利用率,因比率(t?β2 (T?β2)恒小于1

- t達到T時,Φdt規模收斂于β1 + β2

- 此調整機制與LLM的自回歸編碼特性高度契合,在不引入額外超參數的前提下提升資源利用效率

不連續更新機制

傳統策略中,Top-K選擇操作ΨK(Att)需執行T ? β2次,這種頻繁的GPU I/O操作帶來顯著性能開銷。基于連續查詢傾向于選擇相似鍵的特性,提出不連續更新策略:

1、將Top-K選擇操作ΨK(Att)的執行頻率優化為每T?β2/β1間隔執行一次ζ

2、相比于傳統的逐步執行方式,顯著降低了計算開銷

實驗評估

實驗環境配置

基于兩個主流開源大語言模型構建實驗平臺:

- LLaMA-3.1–8B-Instruct

- Mistral-7B-Instruct-v0.3

Φp參數配置:

- LongGenBench-4K場景:α1 + α2 = 2048(約占輸入長度60%)

- LongGenBench-8K場景:α1 + α2 = 4096(約占輸入長度60%)

- α2統一設置為8

- β1 + β2參數設置:

- 4K輸出配置:512

- 8K輸出配置:1024

- β2固定為256,用于適配答案中的推理鏈(Chain-of-Thought)長度,避免序列過短引發的性能退化

性能評估結果

基準系統對比分析

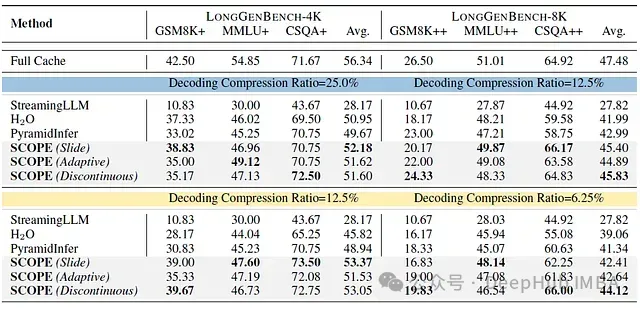

下表展示了在LONGGENBENCH基準測試中,基于LLaMA-3.1–8B-Instruct的SCOPE三種策略與現有方法的性能對比:

實驗結果分析:

SCOPE框架的三種策略在所有解碼壓縮方案中均實現最優性能,其中針對內存使用和傳輸優化的不連續策略表現尤為突出。在高難度GSM8K+/GSM8K++任務上,SCOPE通過保留預填充階段KV緩存的策略展現顯著優勢,而其他壓縮方法出現明顯的性能衰減。PyramidInfer與H2O的性能差異不顯著,表明在長序列輸出任務中,層間稀疏性特征的影響相對有限

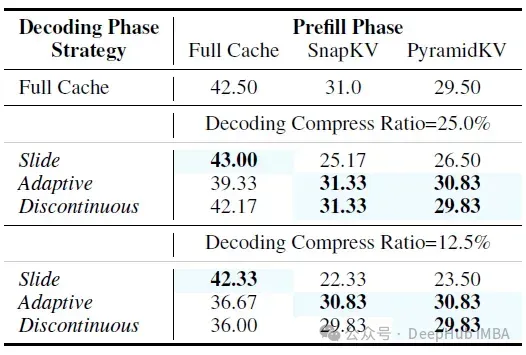

預填充方法集成驗證

下表呈現了LLaMA3.1-8B在LONGGENBENCH-4K的GSM8K+任務上的方法集成實驗數據:

關鍵發現:

- 部分優化策略在僅使用65%原始KV緩存的情況下,實現了超越完整緩存的性能表現

- PyramidKV(SnapKV的變體)通過跨層預算重分配的嘗試未能帶來顯著改善,驗證了前期實證研究結果

- 預填充階段保留的KV緩存表現出類似StreamingLLM中"注意力匯聚點"的特性

深入分析

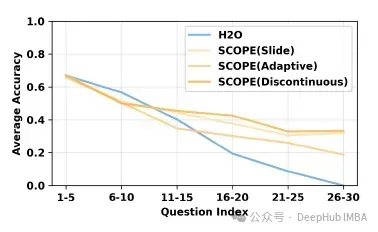

必要特征損失的緩解效果

H2O等統一壓縮方法由于重要特征偏移導致關鍵KV緩存損失,影響了上下文理解能力,下圖描述了預測位置與模型性能的關聯關系:

數據顯示H2O在后期預測中出現顯著性能下降,而SCOPE的三種策略有效緩解了這一問題,證實了預填充KV緩存保留策略的有效性

關鍵參數影響分析

解碼階段的兩個核心參數:

- KV緩存預算 β1+β2

- 特征選擇算法 ΨK(Att)

下圖展示了基于兩種主流top-K選擇算法對預算參數進行縮放的實驗結果:

與預填充階段相比,解碼階段展現出更強的壓縮容忍度:25%的壓縮率僅導致15%的性能降低,而類似壓縮率在預填充階段會導致GSM8k+任務性能的顯著下降

系統效率評估

基于滑動窗口策略的自適應和不連續優化顯著提升了內存效率,具體數據如下表:

相較于完整緩存和單一預填充壓縮方案,本文提出的方法和統一壓縮策略通過降低KV緩存存儲量,有效緩解了內存壓力,自適應策略通過動態預算調整機制進一步優化了系統性能。

泛化能力驗證

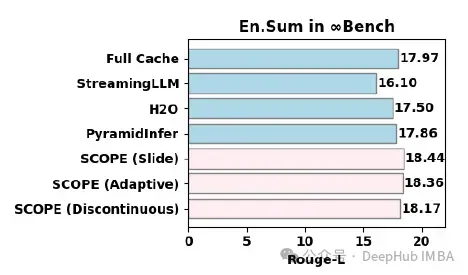

下圖展示了在β1 + β2 = 512配置下,∞BENCH中En.Sum任務的實驗結果:

實驗表明SCOPE的三種策略均優于完整緩存配置,充分驗證了該框架的泛化能力

局限性分析

SCOPE框架通過分離預填充和解碼階段實現長文本生成任務的優化,在兩個階段均采用Top-K算法進行特征選擇。當前框架存在以下待改進方向:

1、預填充階段仍沿用傳統top-K算法,未來研究可探索分塊處理或其他新型技術,以提升歷史標記的估計精度

2、解碼階段每步執行Top-K操作導致頻繁的GPU I/O開銷。雖然不連續策略在一定程度上優化了操作頻率,但仍可通過減少I/O數據量進一步降低系統延遲

3、當前SCOPE主要驗證了文本模態的長輸出任務優化效果。框架具有擴展到視覺領域的潛力,特別是在多圖像生成等需要大量KV緩存的任務場景

總結

SCOPE框架針對LLM長文本生成中的KV緩存優化問題提供了系統性解決方案。

通過實驗觀察發現兩個關鍵問題:

預填充階段的過度壓縮對推理能力造成顯著影響,解碼過程中存在重要特征的偏移現象。

SCOPE通過以下機制解決上述問題:

保持預填充階段必要的KV緩存完整性;引入滑動窗口策略實現解碼階段KV緩存的高效管理。

大規模實驗驗證表明:

SCOPE僅使用35%原始內存即可達到接近完整KV緩存的性能水平,并且保持了與現有預填充壓縮方法的良好兼容性。