理解生成協同促進?華為諾亞提出ILLUME,15M數據實現多模態理解生成一體化

多模態理解與生成一體化模型,致力于將視覺理解與生成能力融入同一框架,不僅推動了任務協同與泛化能力的突破,更重要的是,它代表著對類人智能(AGI)的一種深層探索。通過在單一模型中統一理解與生成,模型能夠從語義層面真正 “洞察” 視覺、文本與世界本質之間的深層聯系,從而在復雜場景中實現更加智能、靈活的交互與任務執行。

近期,華為諾亞方舟實驗室提出了統一多模態大模型 ——ILLUME。這一模型以 LLM 為核心,采用 “連續圖像輸入 + 離散圖像輸出” 的架構,巧妙融合了多模態理解與生成的雙重能力,并深度挖掘了統一框架下理解與生成能力協同增強的潛力,展示了對多模態任務的全新詮釋。

- 論文標題:ILLUME: Illuminating Your LLMs to See, Draw, and Self-Enhance

- 論文地址:https://arxiv.org/pdf/2412.06673

總體來說,本文貢獻如下:

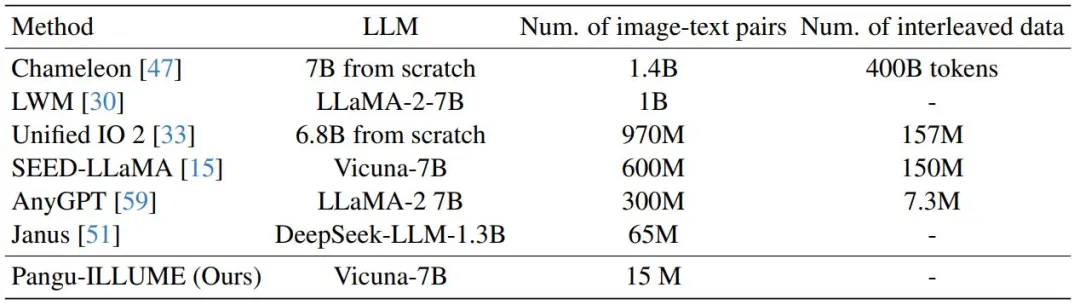

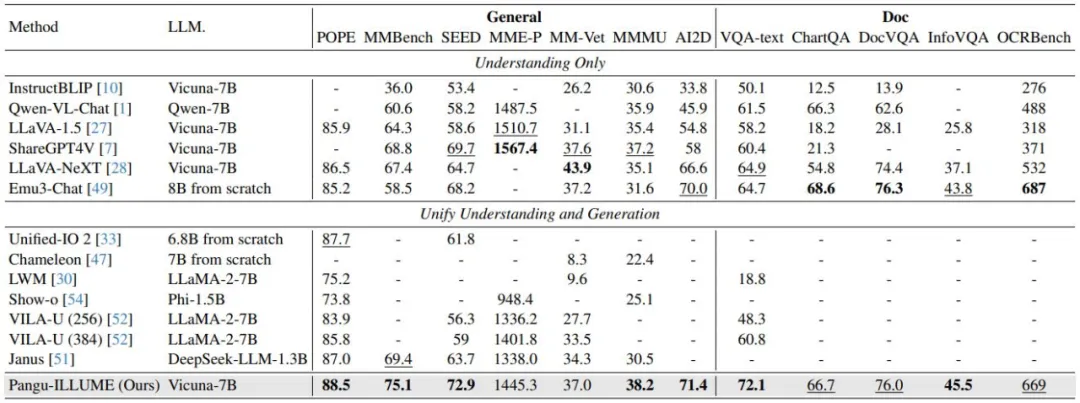

1、ILLUME 在保持整體架構可擴展與可泛化的前提下,通過合理的視覺詞表、訓練策略與數據配比策略,成功以僅約 15M 的圖文對數據用于圖文對齊,實現了在視覺理解(包括自然圖像和文檔圖表)、生成、編輯等多元任務上的出色表現,總體效果優于現有統一模型例如 Chameleon, Show-O 和 Janus,與專用單任務模型相媲美。

2、ILLUME 提出一種自提升式多模態對齊策略,通過讓模型對自身生成的負樣本進行內省式評估,統一模型在理解和生成兩方面的能力可實現協同進化。

ILLUME:理解生成一體的多模態大模型

挑戰一:如何高效訓練一個統一多模態模型?

現有的統一多模態模型構建方案多集中于在 LLM 基礎上拓展視覺詞表,以支持視覺生成任務。這些模型通常需要大量的圖文對數據來實現圖文對齊訓練。這種對海量數據的依賴,在一定程度上放緩了這一領域進一步探索與實踐的進程。

與此不同的是,我們在 ILLUME 中僅使用約 15M 的圖文對數據完成預訓練,并在視覺理解(涵蓋自然圖像與文檔圖表)、生成與編輯等多類視覺文本任務上達到與專有模型相媲美的水平。這一成果并非僅體現于數據規模的減少,更重要的是在架構、訓練策略、數據配比以及視覺詞表表征方式上的關鍵設計,使模型能夠更高效地進行圖文對齊學習。這種方法為在更廣泛和更深層的多模態語義理解與生成融合中奠定了基礎。

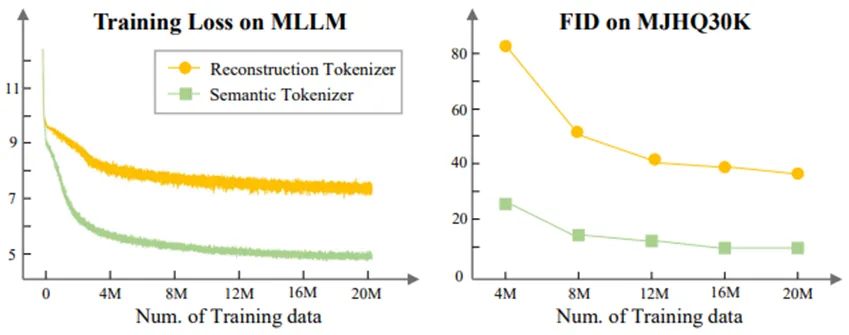

關鍵設計 1:視覺詞表的表征選擇

傳統基于 VQGAN 的視覺詞表往往通過重建原始像素作為目標,但這種基于底層紋理的表征不利于與文本模態進行高層語義對齊。與此相反,我們采用語義特征重建的方式構造視覺詞表,直接在高層語義空間中完成圖文對齊的特征學習。實驗表明,這一設計可顯著加速 MLLM 的預訓練過程。

在解碼階段,我們再利用 Diffusion 模型將語義特征還原為高保真像素空間,從而實現高達 32 倍的壓縮率。通過這一流程,模型在輸入端沿用連續視覺編碼器保障精細視覺理解能力,并在輸出端通過語義視覺詞表完成離散化處理,為視覺生成能力的無縫融合奠定基礎。

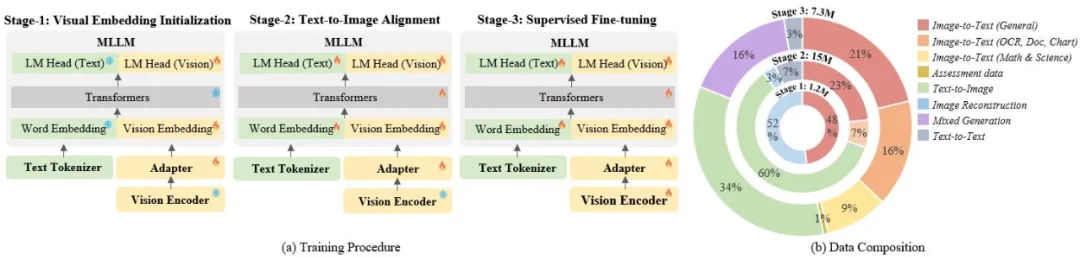

關鍵設計 2:三階段訓練策略和數據配比

我們采用 “三階段” 訓練策略,以分層遞進的方式逐步強化模型的多模態理解與生成能力:

階段一:引入圖像重建任務,為視覺詞表擴展后的新參數進行快速初始化,并對齊連續輸入與離散輸出的模式;

階段二:進行圖文對齊預訓練,進一步強化模型在語義層面將圖像與文本聯結的能力;

階段三:對高質量的理解、生成、混合數據進行微調,使模型最終勝任多類型的視覺文本任務(包括理解、生成與編輯)。

挑戰二:統一多模態模型的判別能力和生成能力能否相互促進?

當我們構建一個統一模型后,我們最關心的是:聯合訓練視覺理解和生成任務應該如何促進呢?

自提升多模態對齊方案

針對這一點,我們提出了以自我評估過程為橋梁的自提升多模態對齊策略。通過讓模型對自身生成的負樣本進行內省式評估,模型在理解和生成兩方面的能力可實現協同進化:

- 生成促進理解:模型以自我評估的方式分析自己產生的負樣本,這種內省過程使模型能夠查明并解決其自身弱點,從而更準確地理解圖像。

- 理解促進生成:模型可以利用其判別能力來評估其自生成的圖像是否與文本一致,并基于此分析進行修正,從而確保模型在推理時更加謹慎和準確,避免在生成圖像時出現錯誤。

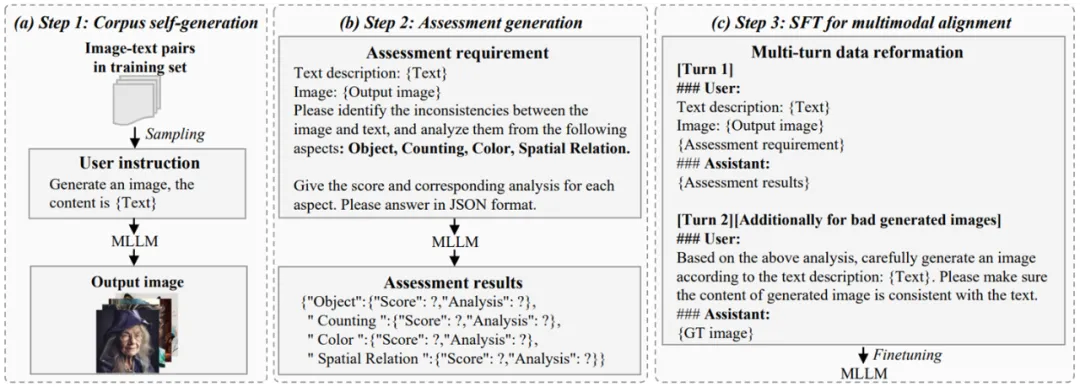

我們的自提升多模態對齊方法分為三個步驟:

- Step 1: 語料自生成。采樣訓練子集,推理模型生成圖像。

- Step 2: 生成評估數據。從物體、數量、顏色和空間關系多個維度評估圖像和文本的一致性,評估數據包括評估得分和相應的分析。

- Step 3: 多模態對齊。將評估數據重新格式化后加入階段三訓練,使模型在理解與生成層面同時得到強化。

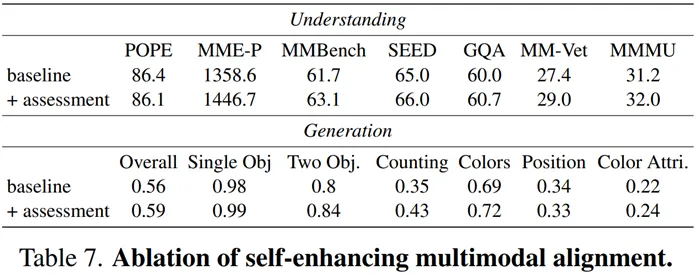

實驗結果證明,自提升多模態對齊方法能在理解和生成任務上同時為模型賦能,促使統一多模態模型向更高層次的智能形態穩步邁進。

實驗結果

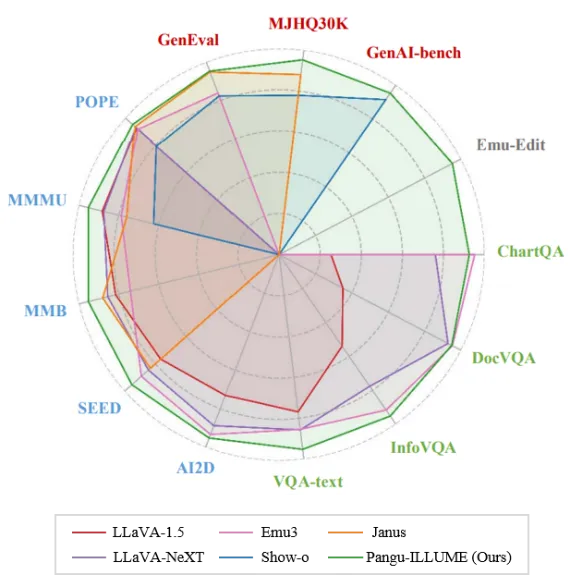

多模態理解任務

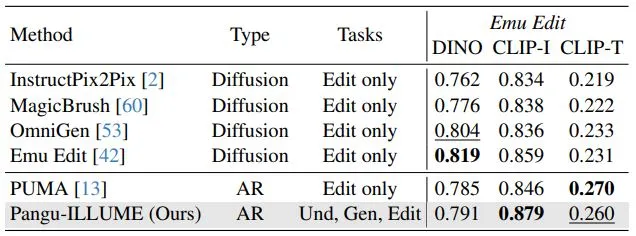

在 12 個常用的多模態理解開源綜合評測集與文檔場景評測集上,ILLUME 均展現出卓越性能,與現有統一多模態模型相比達到 SOTA 水準,尤其在文檔理解任務上表現尤為突出。同時,相較多模態理解模型(如 LLaVA-NeXT),ILLUME 的理解能力總體保持相當甚至更優的水平。

文圖生成任務

ILLUME 在 3 個文生圖評測集上取得與現有生成模型和統一多模態模型相當的表現。

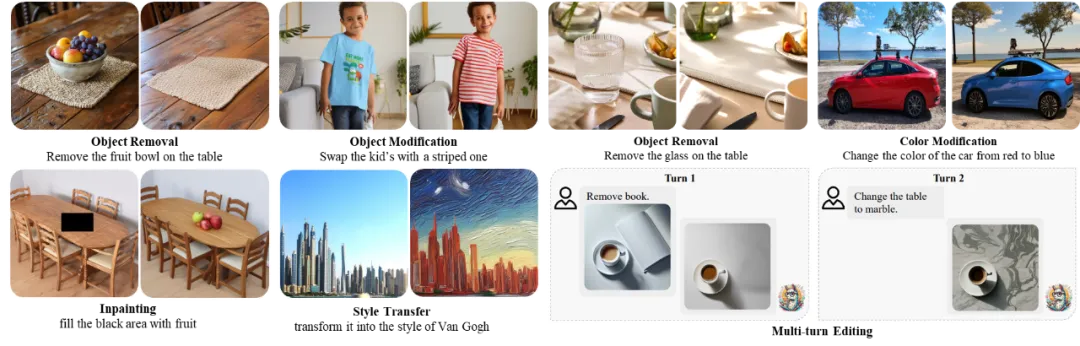

編輯任務

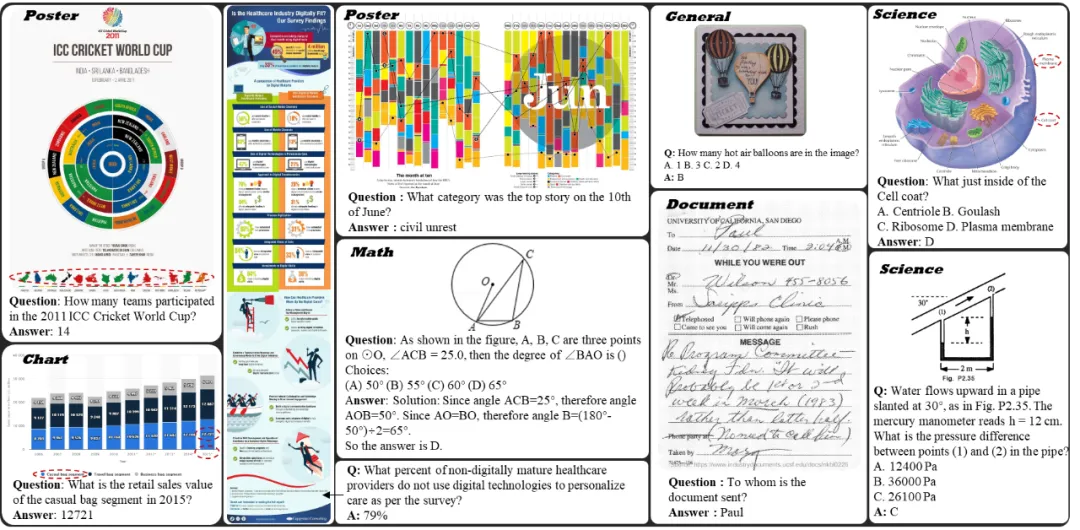

ILLUME 能處理物體刪除,風格遷移,圖像補充等各種編輯任務。