陳丹琦團(tuán)隊降本大法又來了:數(shù)據(jù)砍掉三分之一,性能卻完全不減

陳丹琦團(tuán)隊又帶著他們的降本大法來了——

數(shù)據(jù)砍掉三分之一,大模型性能卻完全不減。

他們引入了元數(shù)據(jù),加速了大模型預(yù)訓(xùn)練的同時,也不增加單獨(dú)的計算開銷。

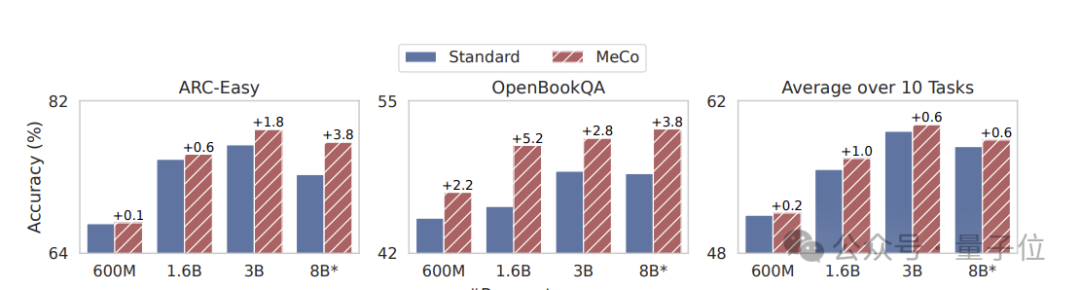

在不同模型規(guī)模(600M - 8B)和訓(xùn)練數(shù)據(jù)來源的情況下,均能實現(xiàn)性能方面的提升。

雖然之前元數(shù)據(jù)談過很多,但一作高天宇表示,他們是第一個展示它如何影響下游性能,以及具體如何實踐以確保推理中具備普遍實用性。

來看看具體是如何做到的吧?

元數(shù)據(jù)加速大模型預(yù)訓(xùn)練

語言模型預(yù)訓(xùn)練語料庫中存在著風(fēng)格、領(lǐng)域和質(zhì)量水平的巨大差異,這對于開發(fā)通用模型能力至關(guān)重要,但是高效地學(xué)習(xí)和部署這些異構(gòu)數(shù)據(jù)源中每一種數(shù)據(jù)源的正確行為卻極具挑戰(zhàn)性。

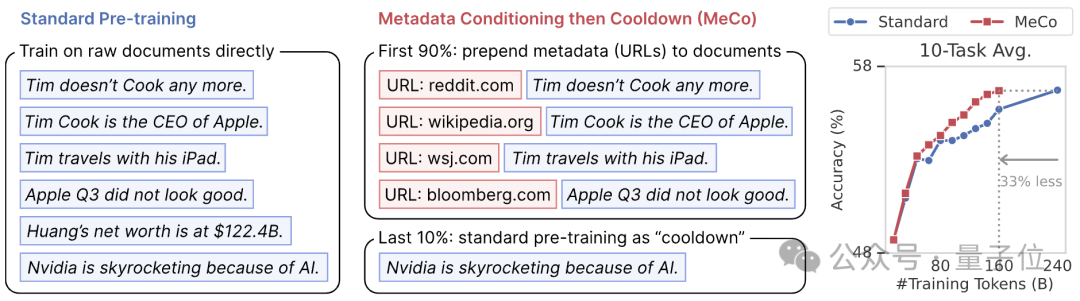

在這一背景下,他們提出了一種新的預(yù)訓(xùn)練方法,稱為元數(shù)據(jù)調(diào)節(jié)然后冷卻(MeCo,Metadata Conditioning then Cooldown)。

具體包括兩個訓(xùn)練階段。

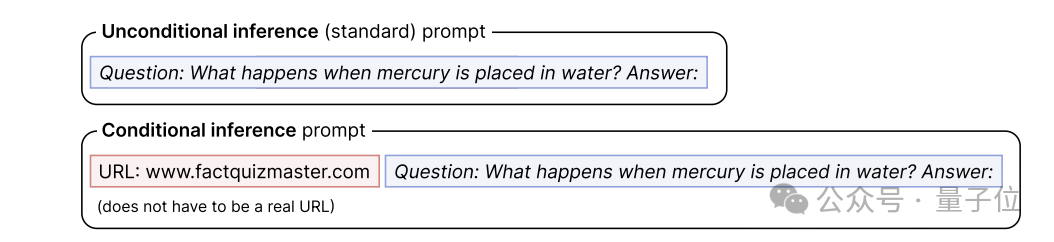

預(yù)訓(xùn)練階段(90%),將元數(shù)據(jù)(如文檔 URL 的絕對域名c)與文檔拼接(如 “URL: en.wikipedia.org\n\n [document]”)進(jìn)行訓(xùn)練。

(例如,如果文檔的 URL 是 https://en.wikipedia.org/wiki/Bill Gates,那么文檔 URL 的絕對域名c就是 en.wikipedia.org;這種 URL 信息在許多預(yù)訓(xùn)練語料庫中都很容易獲得,它們大多來自 CommonCrawl2(一個開放的網(wǎng)絡(luò)抓取數(shù)據(jù)存儲庫))

當(dāng)使用其他類型的元數(shù)據(jù)時,URL 應(yīng)替換為相應(yīng)的元數(shù)據(jù)名稱。

他們只計算文檔標(biāo)記的交叉熵?fù)p失,而不考慮模板或元數(shù)據(jù)中的標(biāo)記,因為在初步實驗中發(fā)現(xiàn),對這些標(biāo)記進(jìn)行訓(xùn)練會略微損害下游性能。

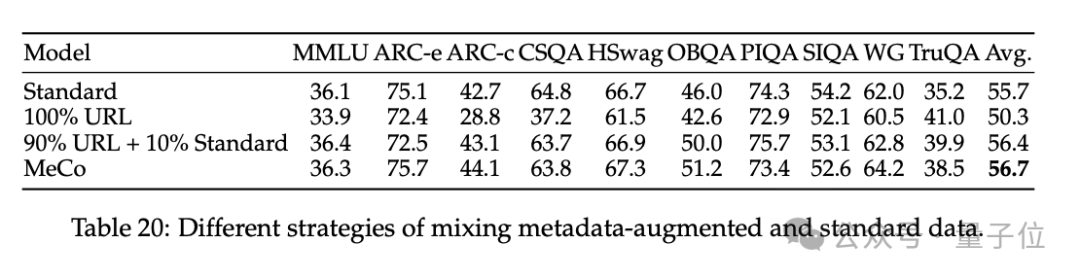

最后10%的訓(xùn)練步驟為冷卻階段,使用標(biāo)準(zhǔn)數(shù)據(jù)訓(xùn)練,繼承元數(shù)據(jù)調(diào)節(jié)階段的學(xué)習(xí)率和優(yōu)化器狀態(tài),即從上一階段的最后一個檢查點(diǎn)初始化學(xué)習(xí)率、模型參數(shù)和優(yōu)化器狀態(tài),并繼續(xù)根據(jù)計劃調(diào)整學(xué)習(xí)率:

1)禁用跨文檔Attention,這既加快了訓(xùn)練速度(1.6B 模型的訓(xùn)練速度提高了 25%),又提高了下游性能。

2)當(dāng)將多個文檔打包成一個序列時,我們確保每個序列從一個新文檔開始,而不是從一個文檔的中間開始—當(dāng)將文檔打包成固定長度時,這可能會導(dǎo)致一些數(shù)據(jù)被丟棄,但事實證明這有利于提高下游性能。

本次實驗使用了Llama Transformer架構(gòu)和Llama-3 tokenizer。我們使用四種不同的模型大小進(jìn)行了實驗:600M、1.6B、3B 和 8B,以及相關(guān)優(yōu)化設(shè)置。

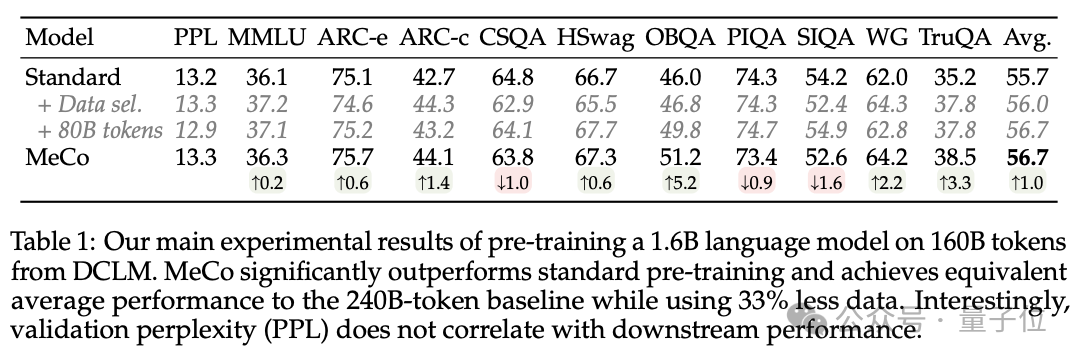

結(jié)果顯示,MeCo 的表現(xiàn)明顯優(yōu)于標(biāo)準(zhǔn)預(yù)訓(xùn)練,其平均性能與 240B 標(biāo)記的基線相當(dāng),而使用的數(shù)據(jù)卻減少了 33%。

最后總結(jié),他們主要完成了這三項貢獻(xiàn)。

1、 MeCo 大幅加快了預(yù)訓(xùn)練。

實驗證明,MeCo 使一個 1.6B 的模型在少用 33% 的訓(xùn)練數(shù)據(jù)的情況下,達(dá)到了與標(biāo)準(zhǔn)預(yù)訓(xùn)練模型相同的平均下游性能。在不同的模型規(guī)模(600M、1.6B、3B 和 8B)和數(shù)據(jù)源(C4、RefinedWeb 和 DCLM)下,MeCo 顯示出一致的收益。

2、MeCo 開啟了引導(dǎo)語言模型的新方法。

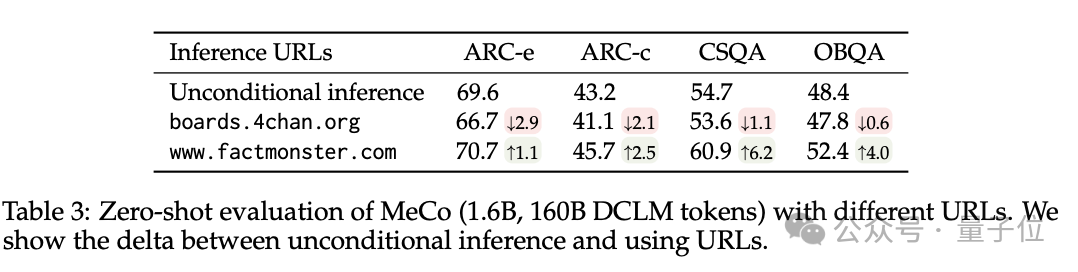

例如,使用factquizmaster.com(非真實URL)可以提高常識性任務(wù)的性能(例如,在零次常識性問題解答中絕對提高了6%),而使用wikipedia.org與標(biāo)準(zhǔn)的無條件推理相比,毒性生成的可能性降低了數(shù)倍。

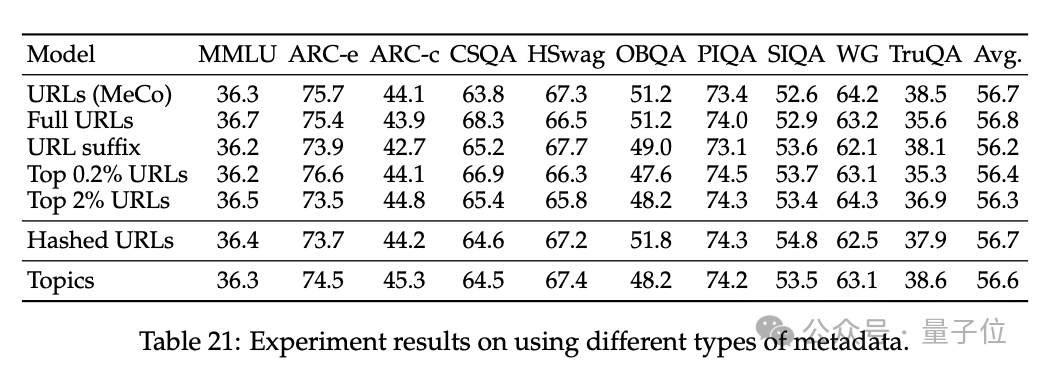

3、消解了 MeCo 的設(shè)計選擇,并證明 MeCo 與不同類型的元數(shù)據(jù)兼容。

使用散列 URL 和模型生成的主題進(jìn)行的分析表明,元數(shù)據(jù)的主要作用是按來源將文檔歸類。因此,即使沒有URL,MeCo 也能有效地整合不同類型的元數(shù)據(jù),包括更精細(xì)的選項。

陳丹琦團(tuán)隊

論文作者來自普林斯頓NLP小組(隸屬于普林斯頓語言與智能PLI)博士生高天宇、Alexander Wettig、Luxi He、YiHe Dong、Sadhika Malladi以及陳丹琦。

一作高天宇,本科畢業(yè)于清華,是2019年清華特獎得主,目前普林斯頓五年級博士生,預(yù)計今年畢業(yè),繼續(xù)在學(xué)界搞研究,研究領(lǐng)域包括自然語言處理和機(jī)器學(xué)習(xí)的交叉領(lǐng)域,特別關(guān)注大語言模型(LLM),包括構(gòu)建應(yīng)用程序、提高LLM功能和效率。

Luxi He目前是普林斯頓計算機(jī)專業(yè)二年級博士生,目前研究重點(diǎn)是理解語言模型并改善其一致性和安全性,碩士畢業(yè)于哈佛大學(xué)。

YiHe Dong目前在谷歌從事機(jī)器學(xué)習(xí)研究和工程工作,專注于結(jié)構(gòu)化數(shù)據(jù)的表示學(xué)習(xí)、自動化特征工程和多模態(tài)表示學(xué)習(xí),本科畢業(yè)于普林斯頓。