世界模型會是L3自動駕駛的唯一解嗎?2025 技術展望

三維空間占有率(3D Occupancy)預測的目的是預測三維空間中的每個體素是否被占有,如果被占有,則對應的體素將被標記。3D Semantic Occupancy是在三維空間內同時編碼占用狀態和語義信息,成為描述自動駕駛 3D 場景的一種極具吸引力的表示方式。而自動駕駛世界模型(World Model)具備對真實物理世界的理解能力,基于一些歷史信息/狀態,能夠預測未來時刻的場景變化甚至agents的狀態變化。因此將OCC和世界模型結合,除了可以實現當前時刻的OCC預測,還可以預測未來時刻的OCC演變,可以直接影響到自動駕駛的規劃/決策,也是這兩年自動駕駛研究的一個重點方向,預計2025年會有更多的工作問世,今天自動駕駛之心就和大家一起復盤2024年OCC和世界模型相關的工作,并在文末總結未來的趨勢。

Scene as Occupancy

- paper: https://arxiv.org/abs/2306.02851

- code:https://github.com/OpenDriveLab/OccNet

雖然OccNet不屬于世界模型+OCC的范疇,但是有必要簡單介紹一個這個工作,有助于理解后續介紹的方法。

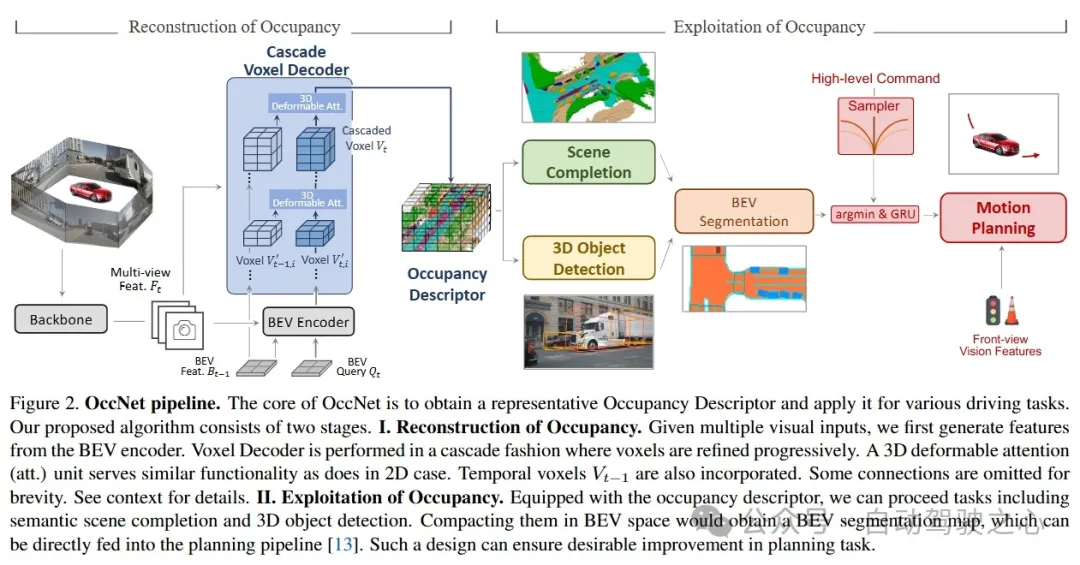

人類駕駛員能夠通過視覺系統輕松描述復雜的交通場景。這種精確感知的能力對于駕駛員的規劃至關重要。為了實現這一點,一種將物理三維場景量化為具有每個單元語義標簽的結構化網格地圖的幾何感知表示形式,即三維占用表示,將是理想的。與邊界框的形式相比,占用表示的關鍵見解在于它能夠捕捉場景中關鍵障礙物的細粒度細節,從而促進后續任務。先前或同時期的文獻主要集中在單個場景補全任務上,我們可能會認為這種占用表示形式的潛力可能會產生更廣泛的影響。在本文中,我們提出了 OccNet,這是一種以多視圖為中心的管道,具有級聯和時間體素解碼器來重建三維占用。OccNet 的核心是一個通用的占用嵌入來表示三維物理世界。這種描述符可以應用于廣泛的駕駛任務,包括檢測、分割和規劃。為了驗證這種新表示形式的有效性和我們提出的算法,針對該算法,我們提出了 OpenOcc,這是首個基于 nuScenes 構建的高密度高質量 3D 占有率基準。實證實驗表明,在多個任務中均有顯著的性能提升,例如,運動規劃的碰撞率可降低 15% - 58%,這證明了我們方法的優越性。

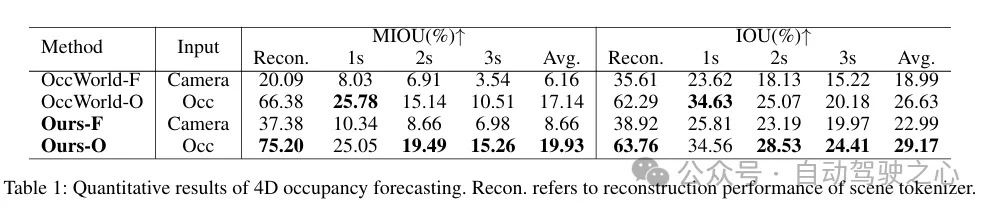

OccWorld: Learning a 3D Occupancy World Model for Autonomous Driving

- paper: https://arxiv.org/pdf/2311.16038

- code: https://github.com/wzzheng/OccWorld

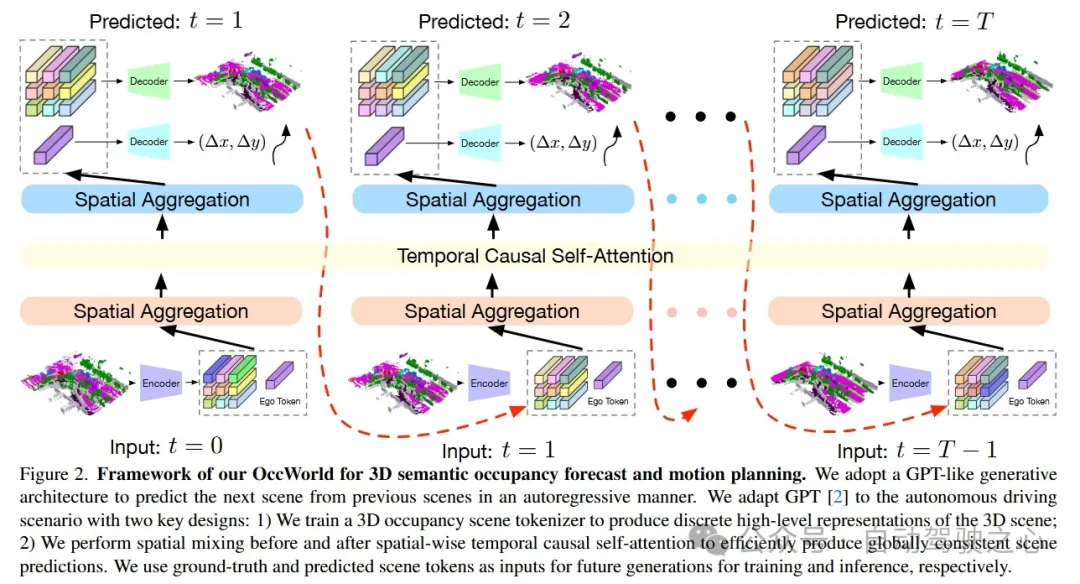

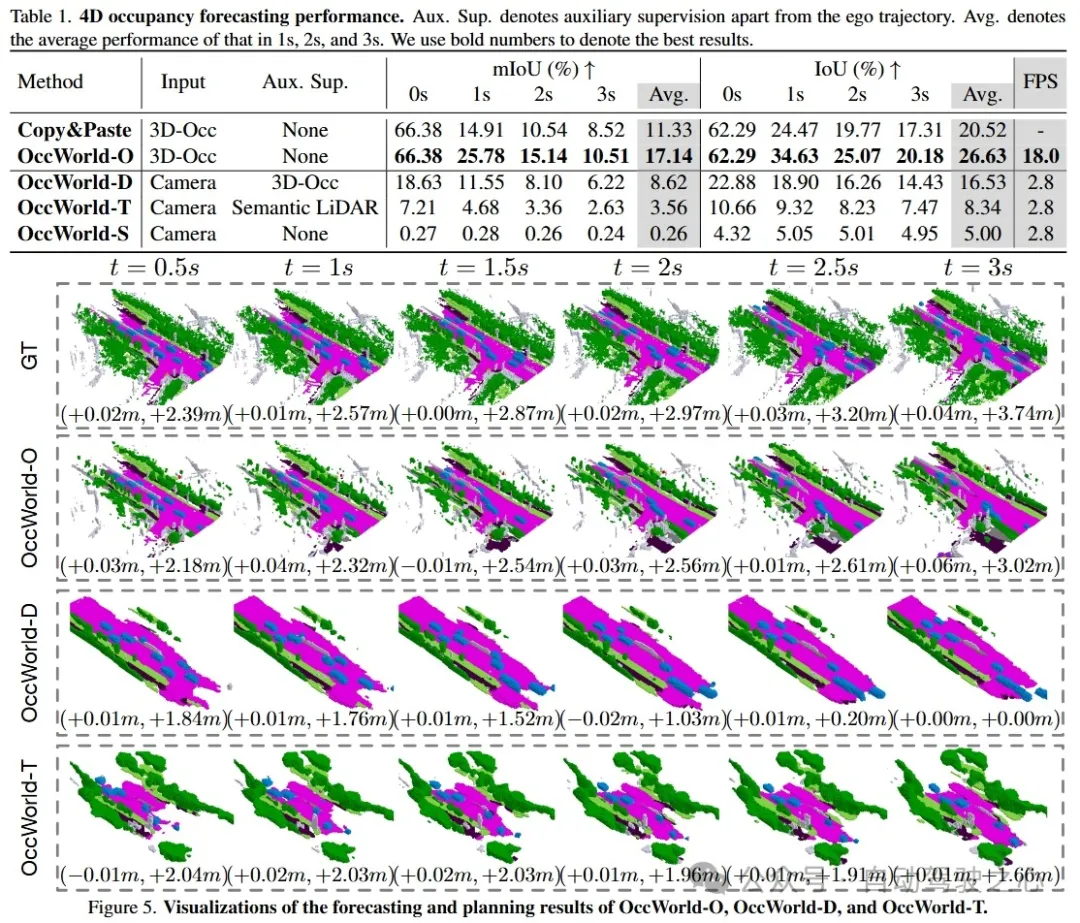

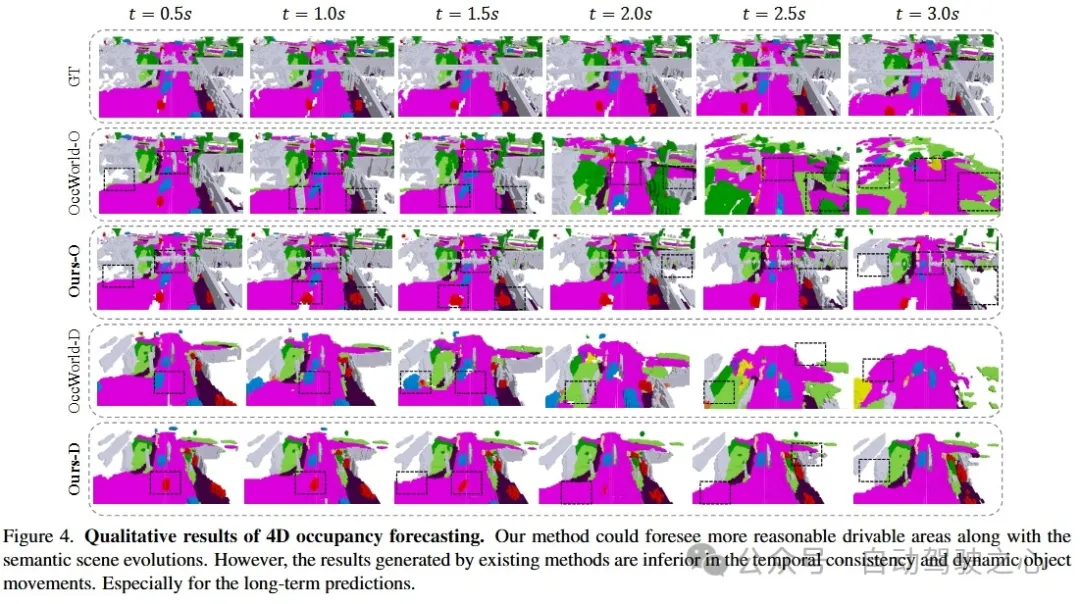

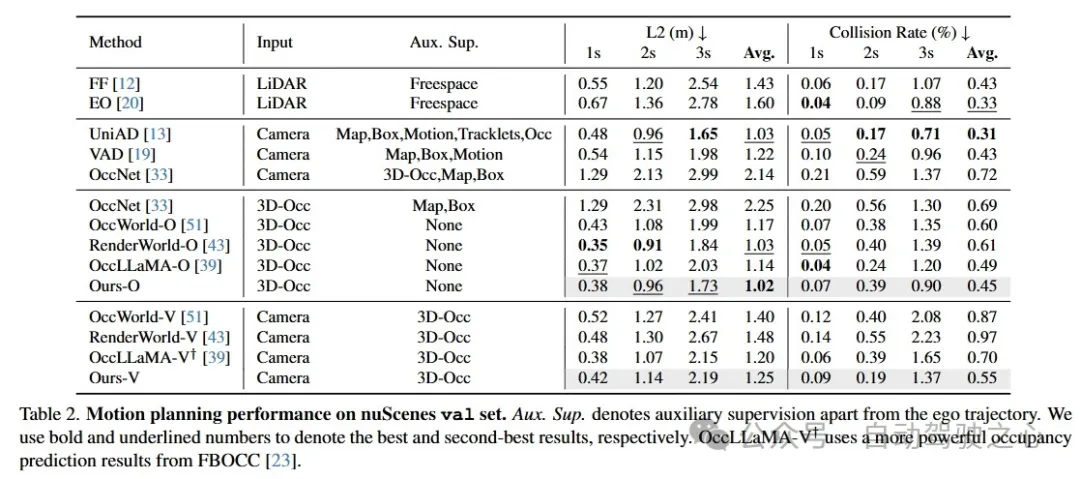

理解三維場景如何演變對于自動駕駛中的決策至關重要。大多數現有的方法通過預測物體檢測框的運動來實現這一點,但無法捕捉到更精細的場景信息。在本文中,我們探索了一種新的框架,即在三維占用空間中學習世界模型,名為OccWorld,以同時預測自動駕駛汽車的運動和周圍場景的演變。我們提出基于三維占用而非三維邊界框和分割圖來學習世界模型,原因有三:1)表達能力:三維占用能夠描述場景更精細的三維結構;2)效率:三維占用率更易于獲取(例如,從稀疏的激光雷達點中獲取)。3)通用性:三維占用率能夠適應視覺和激光雷達。為了便于對世界演變進行建模,我們在三維占用率上學習了一種基于重建的場景tokenizer,以獲取離散的場景tokens來描述周圍場景。然后,我們采用類似 GPT 的時空生成轉換器來生成后續場景和ego tokens,以解碼未來的占用率和自車軌跡。在廣泛使用的 nuScenes 基準上進行的大量實驗表明,OccWorld 能夠有效地對駕駛場景的演變進行建模。OccWorld 還在不使用實例和地圖監督的情況下產生了具有競爭力的規劃結果。

OccWorld是兩階段模型:

- VQ-VAE 的訓練極大地阻礙了效率,并為第二階段引入了性能瓶頸。為場景tokenizer找到合適的超參數在平衡重建和預測性能方面仍然具有挑戰性

- 完全依賴于自回歸方式的隱式特征。它要么忽略了相鄰場景中顯式的結構一致性,要么忽略了圖像中容易獲取的紋理信息。這些都阻礙了模型充分捕捉環境動態的能力

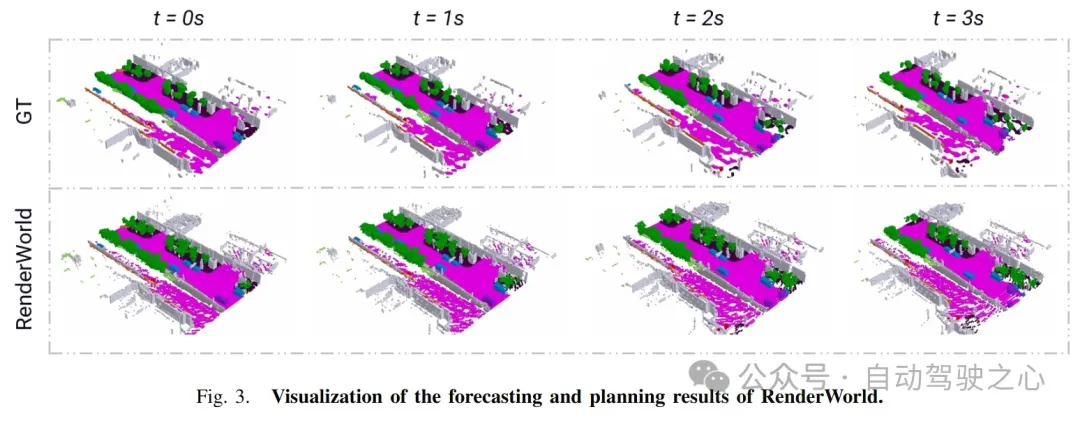

RenderWorld: World Model with Self-Supervised 3D Label

- paper: https://arxiv.org/abs/2409.11356

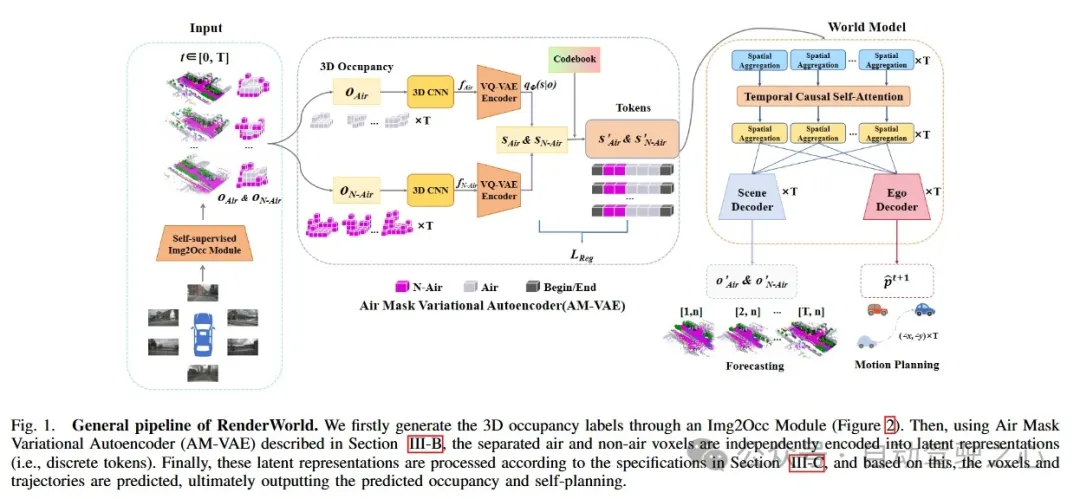

僅基于視覺的端到端自動駕駛不僅比激光雷達與視覺融合的方法更具成本效益,而且比傳統方法更可靠。為了實現經濟且魯棒的純視覺自動駕駛系統,我們提出了 RenderWorld,這是一種僅基于視覺的端到端自動駕駛框架,它使用基于自監督高斯的 Img2Occ 模塊生成 3D 占有率標簽,然后通過 AM-VAE 對標簽進行編碼,并使用世界模型進行預測和規劃。RenderWorld 采用高斯點陣來表示 3D 場景并渲染 2D 圖像,與基于 NeRF 的方法相比,這極大地提高了分割精度并減少了 GPU 內存消耗。通過應用 AM-VAE 分別對air和non-air進行編碼,RenderWorld 實現了更精細的場景元素表示,在自回歸世界模型的 4D 占有率預測和運動規劃方面均達到了最先進的性能。

兩階段訓練范式。

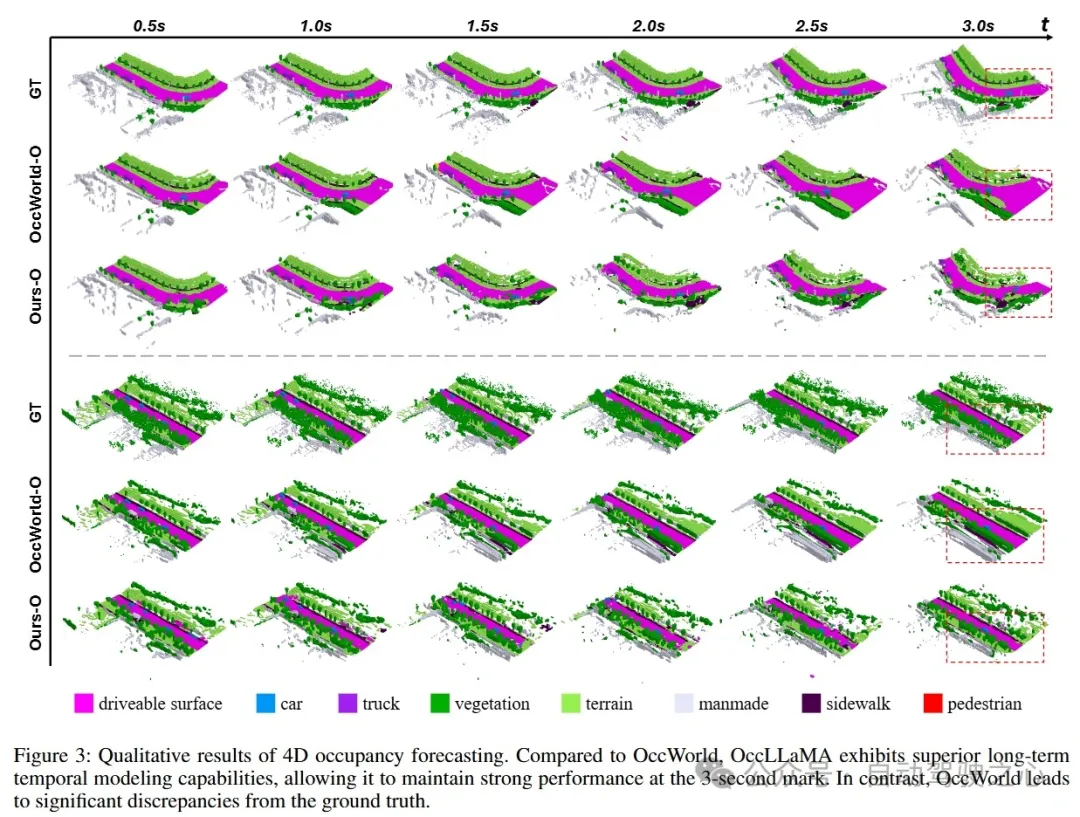

OccLLaMA: An Occupancy-Language-Action Generative World Model for Autonomous Driving

- paper: https://arxiv.org/abs/2409.03272

多模態大型語言模型(MLLMs)的興起推動了其在自動駕駛中的應用。近期基于 MLLM 的方法通過學習從感知到動作的直接映射來執行動作,忽略了世界的動態以及行為與世界動態之間的關系。相比之下,人類擁有世界模型,能夠基于三維內部視覺表征模擬未來狀態,并據此規劃行為。為此,我們提出了 OccLLaMA,這是一種占用-語言-動作生成式世界模型,它采用語義占用作為通用視覺表示,并通過自回歸模型統一了視覺-語言-動作(VLA)模態。具體而言,我們引入了一種類似 VQVAE 的場景tokenizer,以高效地離散化和重建語義占用場景,同時考慮到其稀疏性和類別不平衡的問題。然后,我們為視覺、語言和動作構建了一個統一的多模態詞匯表。此外,我們增強了大型語言模型(LLM),特別是 LLaMA,使其能夠在統一的詞匯表上進行下一token/場景預測,以完成自動駕駛中的多項任務。大量實驗表明,OccLLaMA 在包括 4D 占用預測、運動規劃和視覺問答在內的多項任務中均取得了具有競爭力的性能,展示了其作為自動駕駛基礎模型的潛力。

兩階段訓練范式。

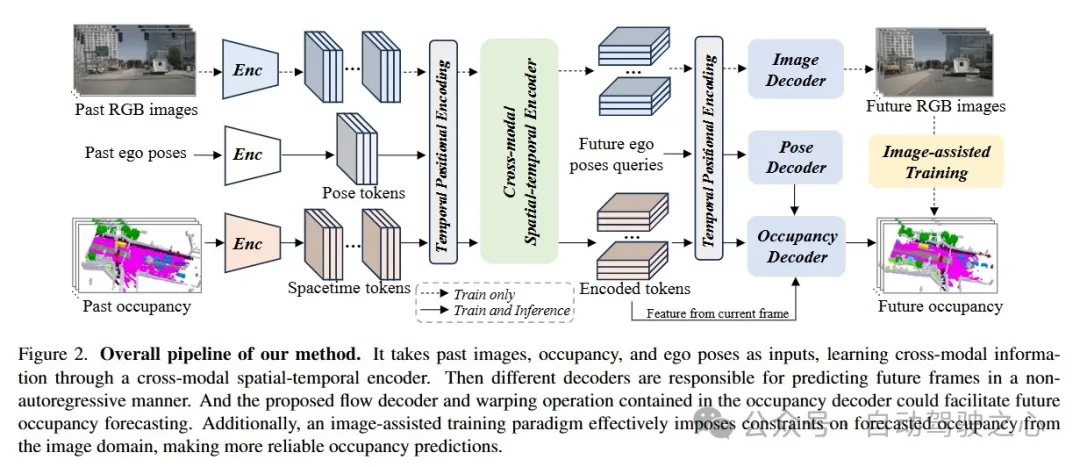

An Efficient Occupancy World Model via Decoupled Dynamic Flow and Image-assisted Training

- paper: https://arxiv.org/abs/2412.13772

自動駕駛領域對世界模型的興趣日益濃厚,這類模型旨在基于歷史觀測預測潛在的未來場景。在本文中,我們介紹了 DFIT-OccWorld,這是一種高效的 3D 占有世界模型,它利用了解耦動態流和圖像輔助訓練策略,顯著提升了 4D 場景預測性能。為了簡化訓練過程,我們摒棄了之前的兩階段訓練策略,并創新性地將占有預測問題重新表述為解耦的體素變形過程。我們的模型通過使用體素流對現有觀測進行變形來預測未來的動態體素,而靜態體素則通過姿態變換輕松獲得。此外,我們的方法還引入了圖像輔助訓練范式以增強預測的可靠性。具體而言,采用可微體積渲染通過預測的未來體積生成渲染深度圖,并將其用于基于渲染的光度一致性。實驗表明了我們方法的有效性,在 nuScenes 和 OpenScene 基準測試中展示了其在 4D 占有預測方面的先進性能。該模型實現了精準預測、端到端運動規劃和點云預測。具體而言,與現有的 3D 世界模型相比,它達到了最先進的性能,同時計算成本大幅降低。

效率和性能都比之前的兩階段模型好。

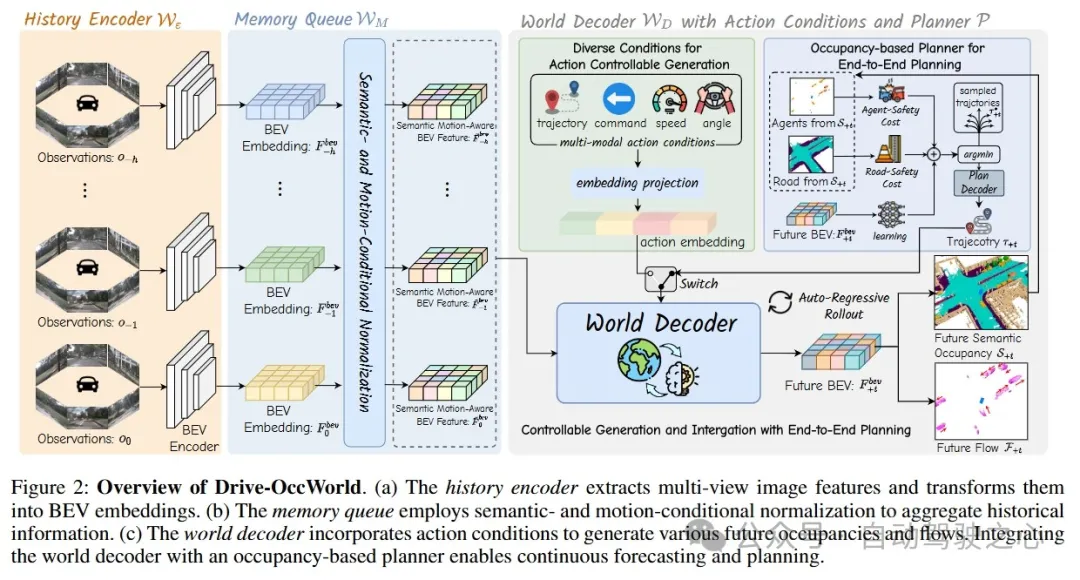

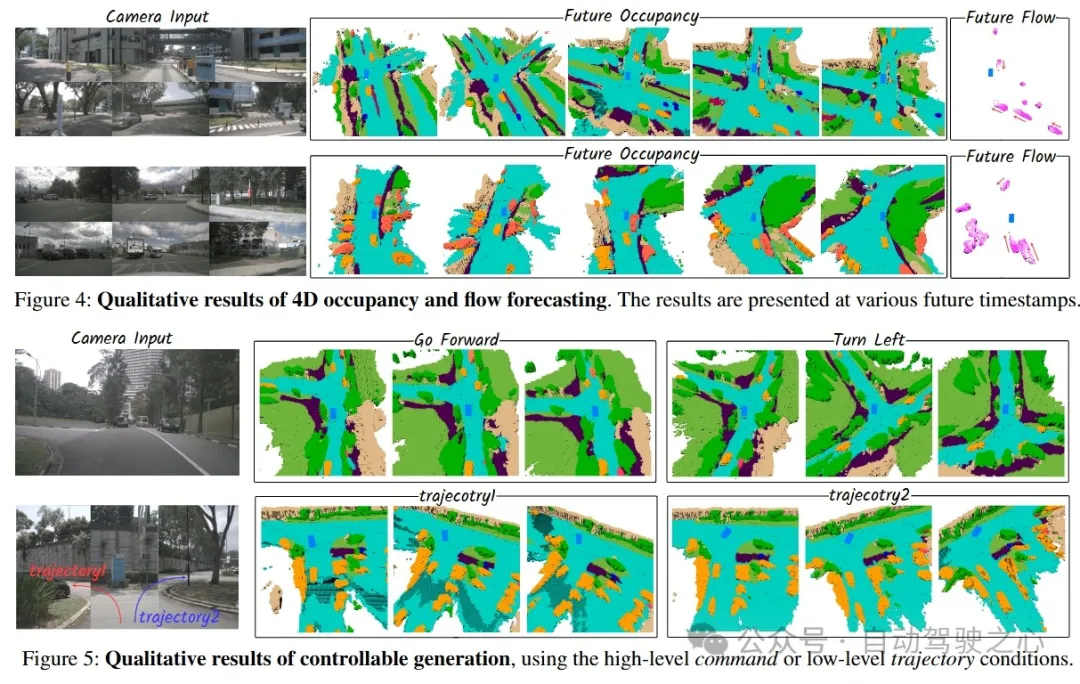

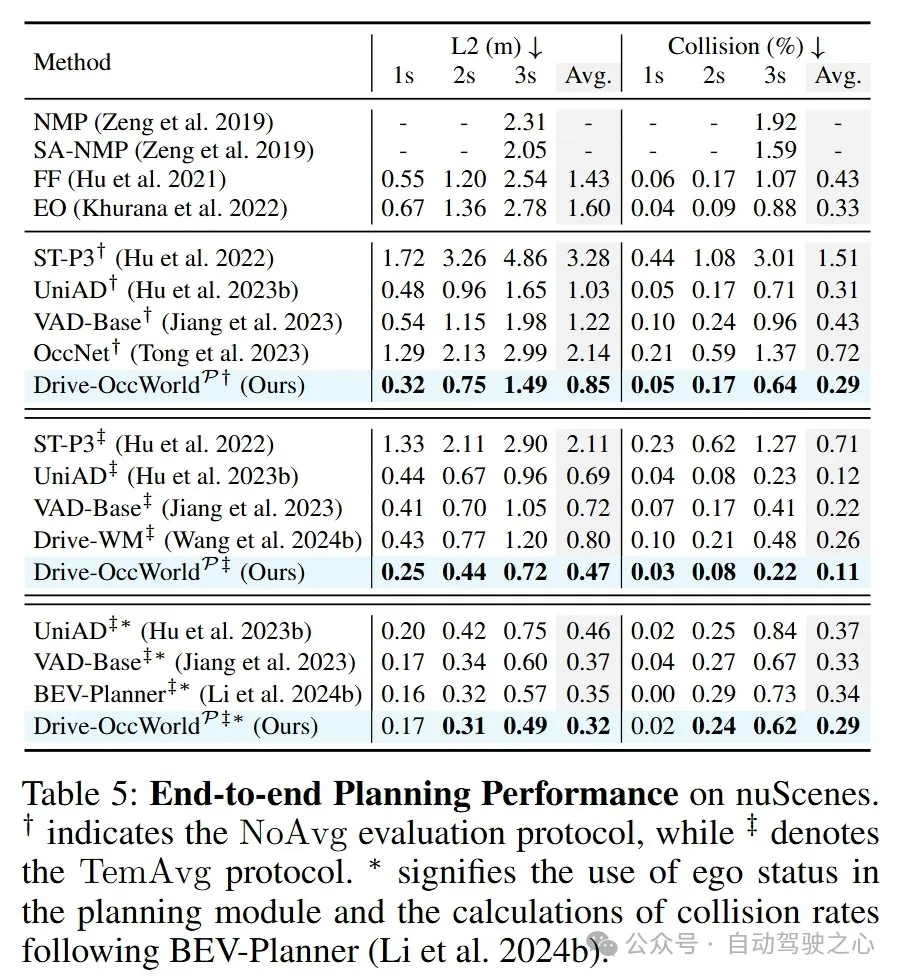

Driving in the Occupancy World: Vision-Centric 4D Occupancy Forecasting and Planning via World Models for Autonomous Driving

- paper:https://arxiv.org/abs/2408.14197

- project page: https://drive-occworld.github.io/

世界模型基于各種ego行為設想潛在的未來狀態。它們嵌入了關于駕駛環境的大量知識,有助于實現安全且可擴展的自動駕駛。大多數現有的方法主要側重于數據生成或世界模型的預訓練范式。與上述先前的工作不同,我們提出了 Drive-OccWorld,它將以視覺為中心的 4D 預測世界模型適應于自動駕駛的端到端規劃。具體而言,我們首先在內存模塊中引入語義和運動條件歸一化,該模塊從歷史 BEV 嵌入中積累語義和動態信息。然后,這些 BEV 特征被傳遞到世界解碼器,用于未來占用和流預測,同時考慮幾何和時空建模。此外,我們提出將靈活的動作條件(如速度、轉向角、軌跡和指令)注入世界模型,以實現可控生成,并促進更廣泛的下游應用。此外,我們還探索了將 4D 世界模型的生成能力與端到端規劃相結合,從而能夠利用基于占用率的成本函數連續預測未來狀態并選擇最優軌跡。在 nuScenes 數據集上進行的大量實驗表明,我們的方法能夠生成合理且可控的 4D 占用率,為駕駛世界生成和端到端規劃開辟了新的途徑。

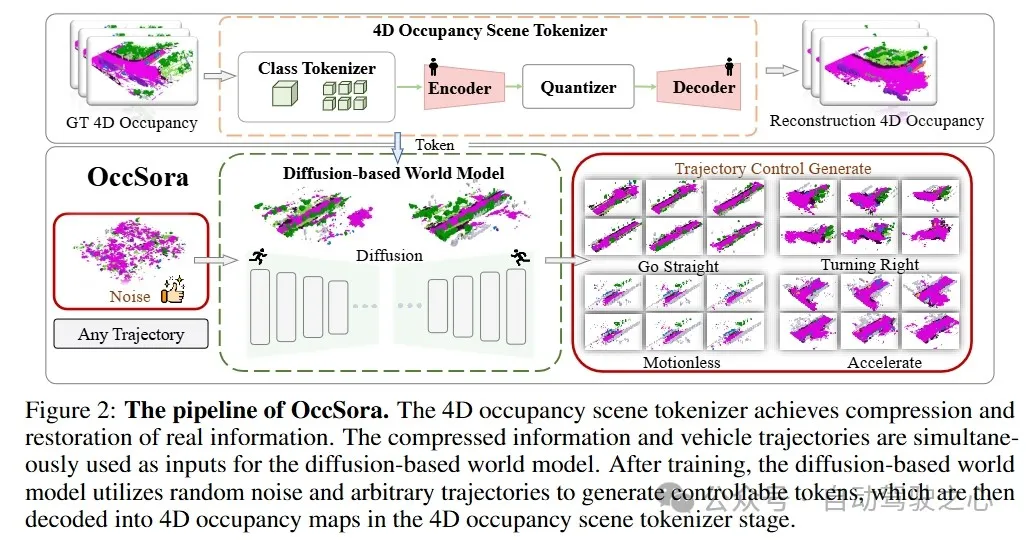

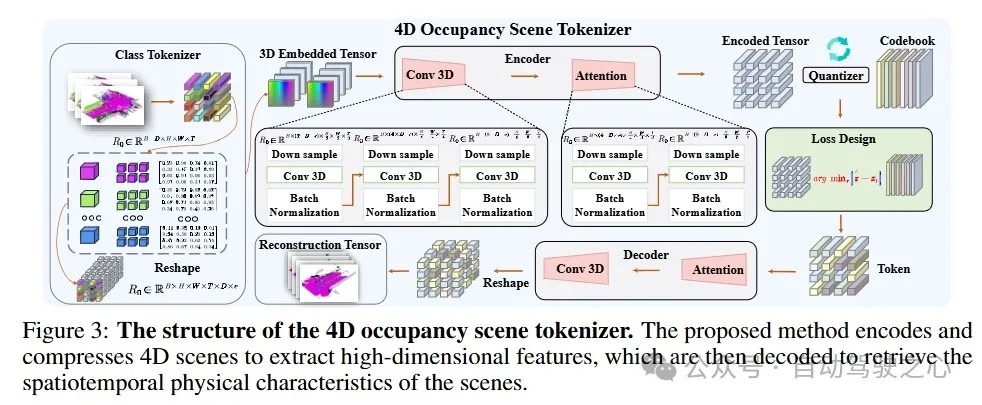

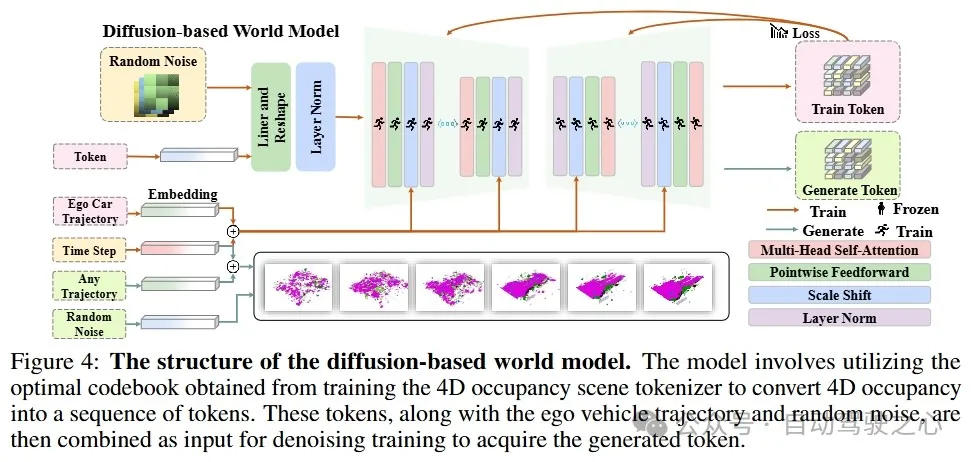

OccSora: 4D Occupancy Generation Models as World Simulators for Autonomous Driving

- paper: https://arxiv.org/abs/2405.20337

- code: https://github.com/wzzheng/OccSora

理解 3D 場景的演變對于實現有效的自動駕駛至關重要。雖然傳統方法通過單個實例的運動來建模場景的發展,但世界模型作為一種生成框架,能夠描述一般的場景動態。然而,大多數現有的方法采用自回歸框架來進行下一個token預測,這在對長期時間演變進行建模時效率低下。為了解決這個問題,我們提出了一種基于擴散的 4D 占有率生成模型 OccSora,用于模擬自動駕駛中的 3D 世界的發展。我們采用 4D 場景tokenizer來獲取 4D 占有率輸入的緊湊離散時空表示,并實現對長序列占有率視頻的高質量重建。然后,我們在時空表示上學習擴散Transformer,并根據軌跡提示生成 4D 占有率。我們在廣泛使用的 nuScenes 數據集上進行了大量實驗,該數據集帶有 Occ3D 占有率注釋。OccSora 能夠生成具有真實 3D 布局和時間一致性的 16 秒視頻,這表明它能夠理解駕駛場景的空間和時間分布。憑借軌跡感知的 4D 生成能力,OccSora 有可能成為自動駕駛決策的世界模擬器。

DOME: Taming Diffusion Model into High-Fidelity Controllable Occupancy World Model

- paper: https://arxiv.org/abs/2410.10429

- project page: https://gusongen.github.io/DOME

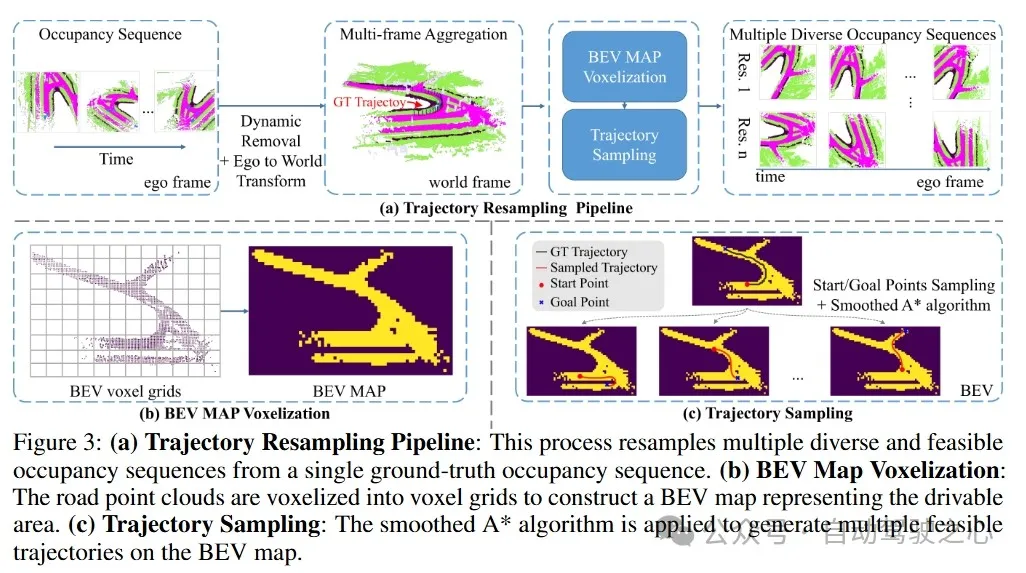

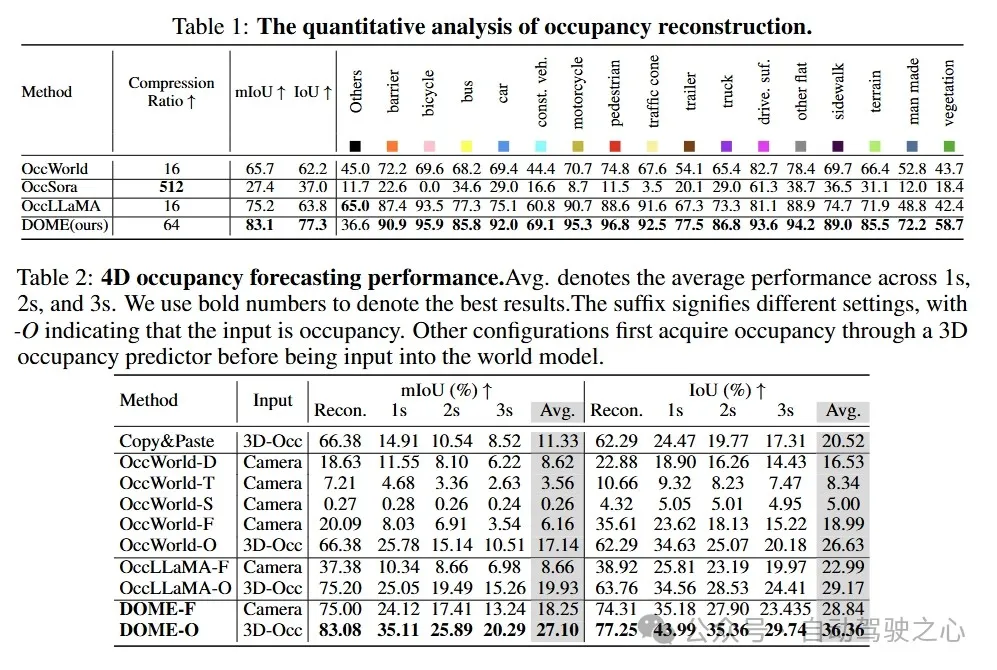

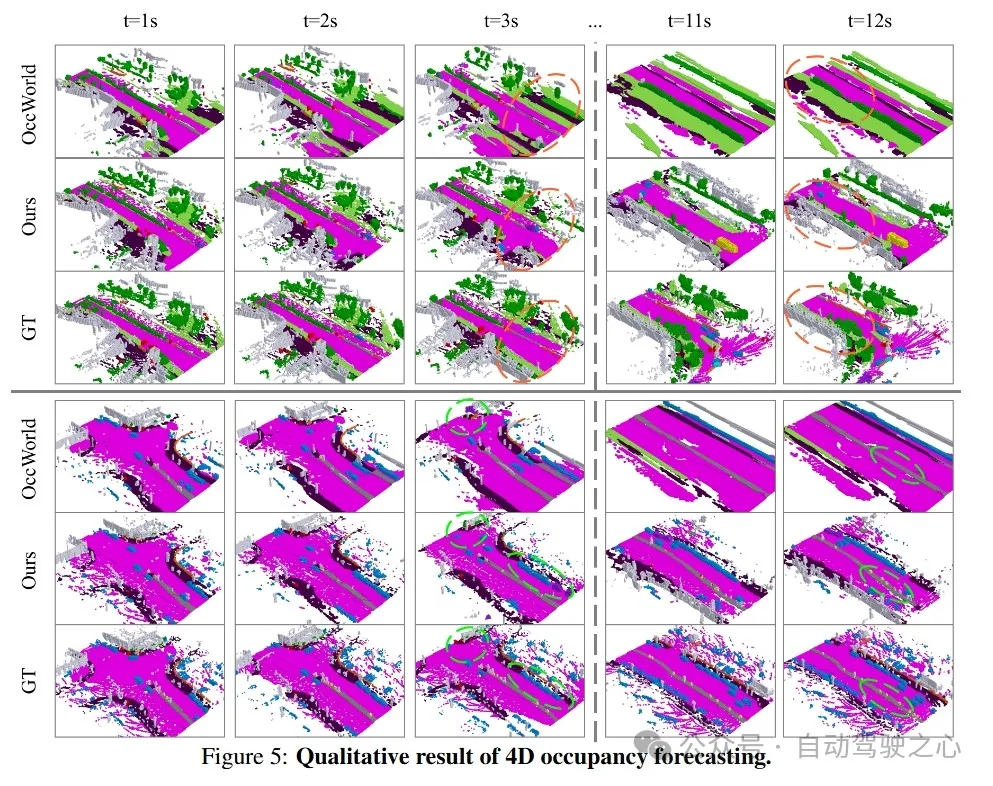

我們提出了一種基于擴散的世界模型 DOME,它能夠根據過去的占用情況預測未來的占用幀。這種世界模型捕捉環境演變的能力對于自動駕駛中的規劃至關重要。與基于 2D 視頻的世界模型相比,占用世界模型利用了原生的 3D 表示,具有易于獲取的標注且不受模態限制。這種靈活性有可能促進更先進世界模型的發展。現有的占用世界模型要么因離散tokens而損失細節,要么依賴于簡單的擴散架構,導致預測未來占用情況時效率低下且難以實現可控性。我們的 DOME 具有兩個關鍵特性:(1)高保真度和長時生成。我們采用時空擴散Transformer,基于歷史上下文預測未來的占用幀。這種架構能夠高效地捕捉時空信息,從而實現高保真度的細節,并具備長時間生成預測的能力。(2)細粒度可控性。我們通過引入一種軌跡重采樣方法來應對預測中的可控性挑戰,這顯著增強了模型生成可控預測的能力。在廣泛使用的 nuScenes 數據集上進行的大量實驗表明,我們的方法在定性和定量評估中均超越了現有的基準,在 nuScenes 上建立了新的最先進性能。具體而言,在占用重建方面,我們的方法在 mIoU 上比基準高出 10.5%,在 IoU 上高出 21.2%;在 4D 占用預測方面,在 mIoU 上高出 36.0%,在 IoU 上高出 24.6%。

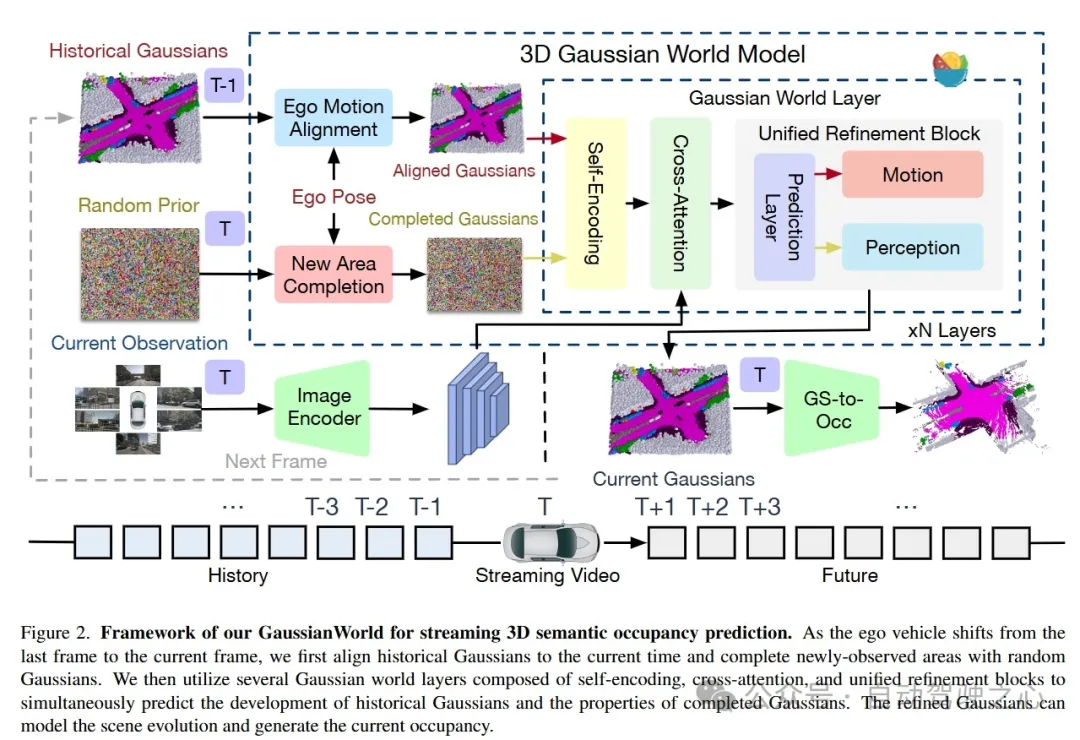

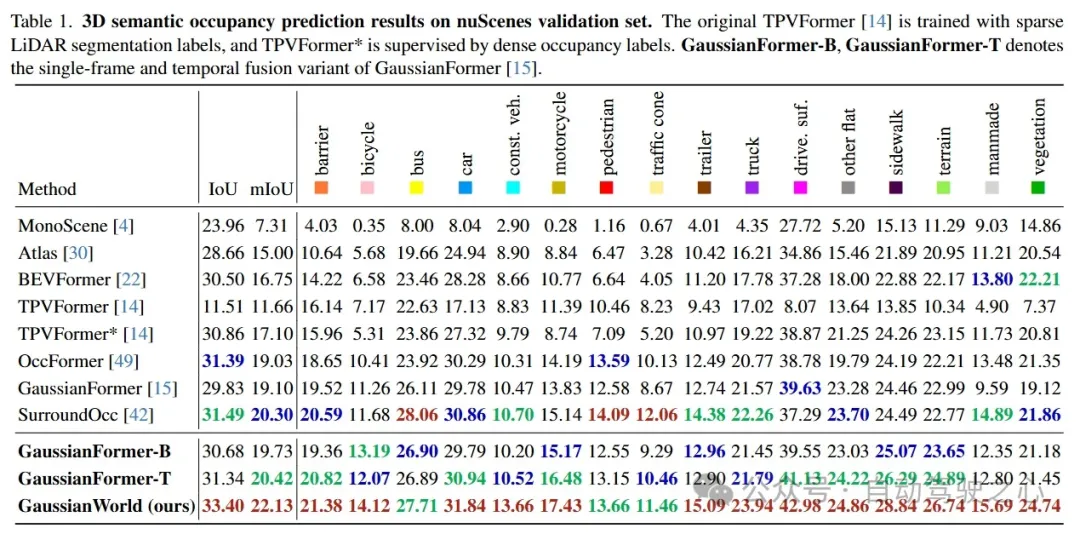

GaussianWorld: Gaussian World Model for Streaming 3D Occupancy Prediction

- paper: https://arxiv.org/abs/2412.10373

- code: https://github.com/zuosc19/GaussianWorld

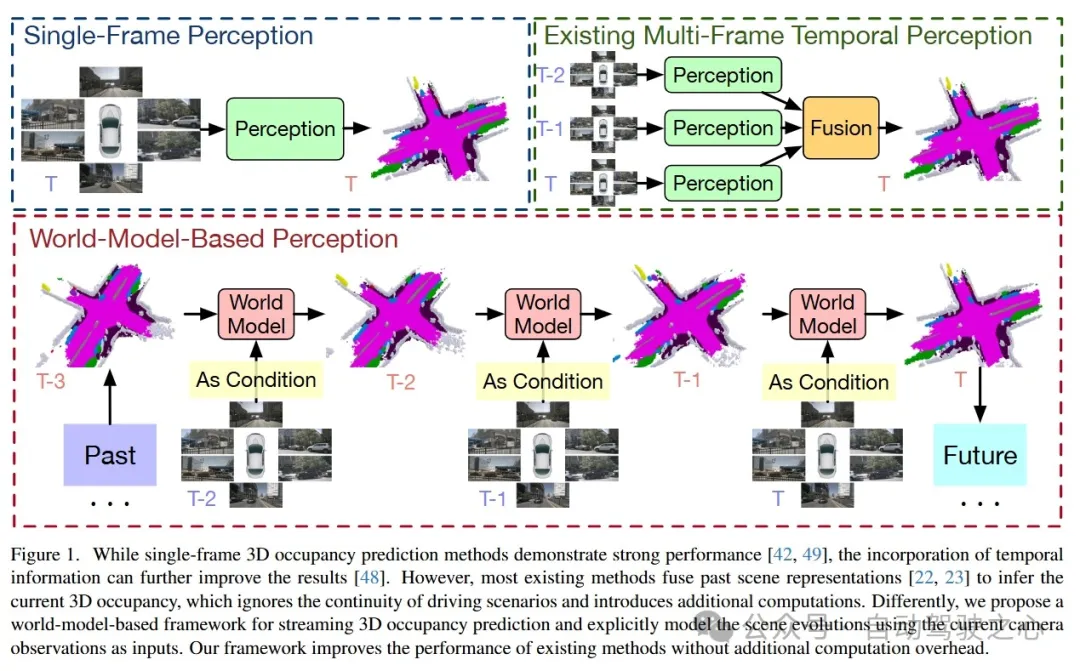

3D 占有率預測對于自動駕駛至關重要,因為它能全面感知周圍環境。為了融合序列輸入,大多數現有方法將先前幀的表示融合起來以推斷當前的 3D 占有率。然而,它們未能考慮駕駛場景的連續性,并且忽略了 3D 場景演變所提供的強大先驗信息(例如,只有動態物體在移動)。在本文中,我們提出了一種基于世界模型的框架,以利用場景演變進行感知。我們將 3D 占有率預測重新表述為一個基于當前傳感器輸入的 4D 占有率預測問題。我們將場景演變分解為三個因素:1)靜態場景的自身運動對齊;2)動態物體的局部移動;3)新觀察到場景的補全。然后,我們采用高斯世界模型(GaussianWorld)來明確利用這些先驗信息,并在考慮當前 RGB 觀測的情況下,在 3D 高斯空間中推斷場景演變。我們在廣泛使用的 nuScenes 數據集上評估了我們框架的有效性。我們的GaussianWorld在不增加額外計算量的情況下,將單幀對應模型的 mIoU 性能提高了 2% 以上。

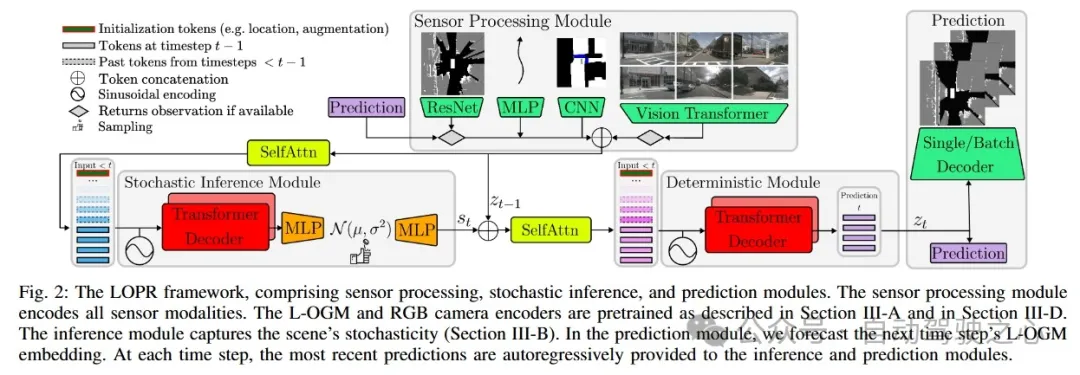

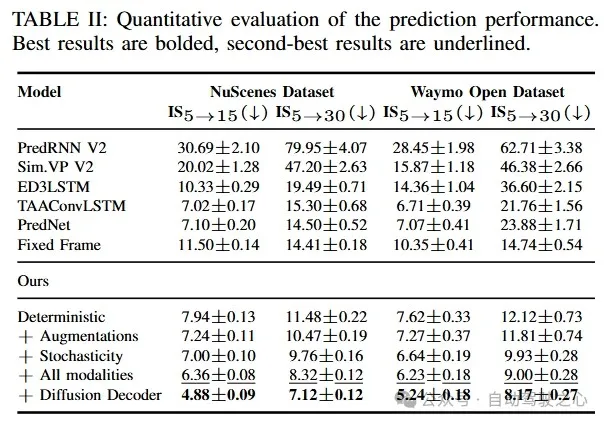

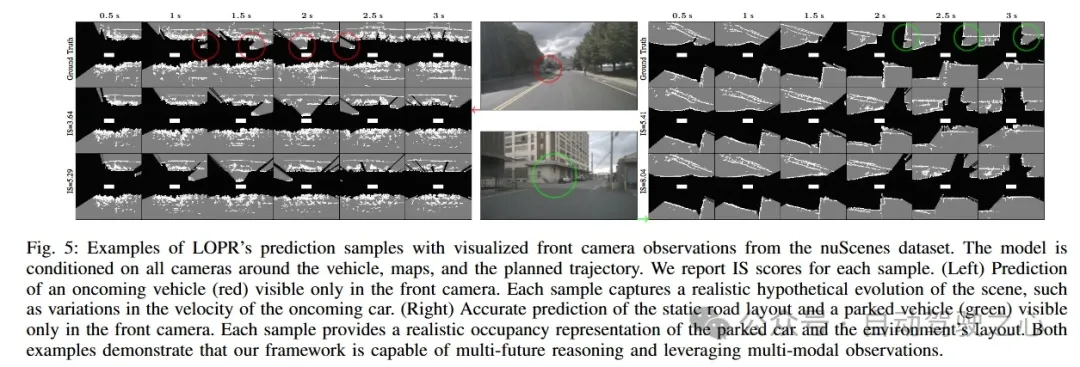

Self-supervised Multi-future Occupancy Forecasting for Autonomous Driving

- paper: https://arxiv.org/abs/2407.21126

環境預測框架對于自動駕駛汽車(AV)在動態環境中的安全導航至關重要。激光雷達生成的占用網格地圖(L-OGM)為場景表示提供了可靠的鳥瞰視角,能夠實現自監督的聯合場景預測,同時對部分可觀測性和感知檢測失敗具有較強的魯棒性。先前的方法主要集中在網格單元空間內的確定性 L-OGM 預測架構上。盡管這些方法取得了一定的成功,但它們經常產生不切實際的預測,并且無法捕捉環境的隨機性。此外,它們還不能有效地整合自動駕駛汽車中現有的其他傳感器模態。我們提出的框架在生成架構的潛在空間中進行隨機 L-OGM 預測,并允許基于 RGB 相機、地圖和規劃軌跡進行條件設置。我們使用單步解碼器來解碼預測,該解碼器能夠實時提供高質量的預測,或者使用基于擴散的批處理解碼器,該解碼器可以進一步優化解碼幀,以解決時間一致性問題并減少壓縮損失。我們在 nuScenes 和 Waymo Open 數據集上進行的實驗表明,我們方法的所有變體在定性和定量方面都優于先前的方法。

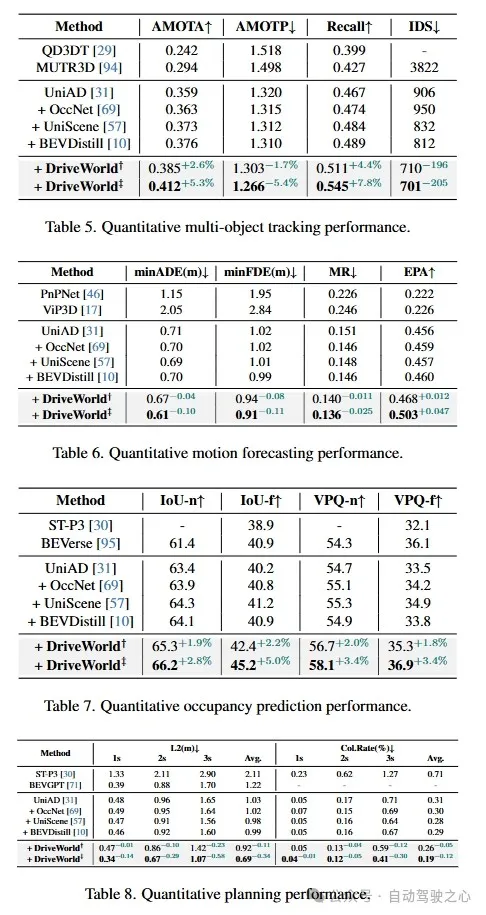

DriveWorld: 4D Pre-trained Scene Understanding via World Models for Autonomous Driving

- paper: https://arxiv.org/abs/2405.04390

以視覺為中心的自動駕駛由于成本較低,近來受到了廣泛關注。預訓練對于提取通用表示至關重要。然而,當前以視覺為中心的預訓練通常依賴于 2D 或 3D 的預訓練任務,忽略了自動駕駛作為 4D 場景理解任務的時間特性。在本文中,我們通過引入一個基于世界模型的自動駕駛 4D 表示學習框架來解決這一挑戰,該框架被稱為DriveWorld,能夠從多攝像頭駕駛視頻中以時空方式預訓練。具體而言,我們提出了一種用于時空建模的記憶狀態空間模型,它由一個動態記憶庫模塊組成,用于學習具有時間感知的潛在動態以預測未來變化,以及一個靜態場景傳播模塊,用于學習具有空間感知的潛在靜態以提供全面的場景上下文。我們還引入了一個任務提示,以解耦適用于各種下游任務的任務感知特征。實驗表明,DriveWorld 在各種自動駕駛任務中取得了令人鼓舞的結果。在使用 OpenScene 數據集進行預訓練時,DriveWorld 在 3D 物體檢測方面實現了 7.5% 的 mAP 提升,在在線地圖繪制方面實現了 3.0% 的 IoU 提升,在多目標跟蹤方面實現了 5.0% 的 AMOTA 提升,在運動預測方面實現了 0.1 米的 minADE 降低,在占用預測方面實現了 3.0% 的 IoU 提升,在規劃方面實現了平均 L2 誤差 0.34 米的減少。

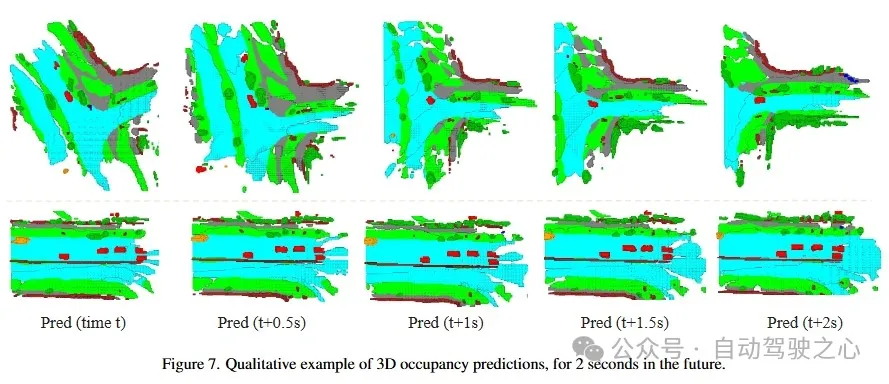

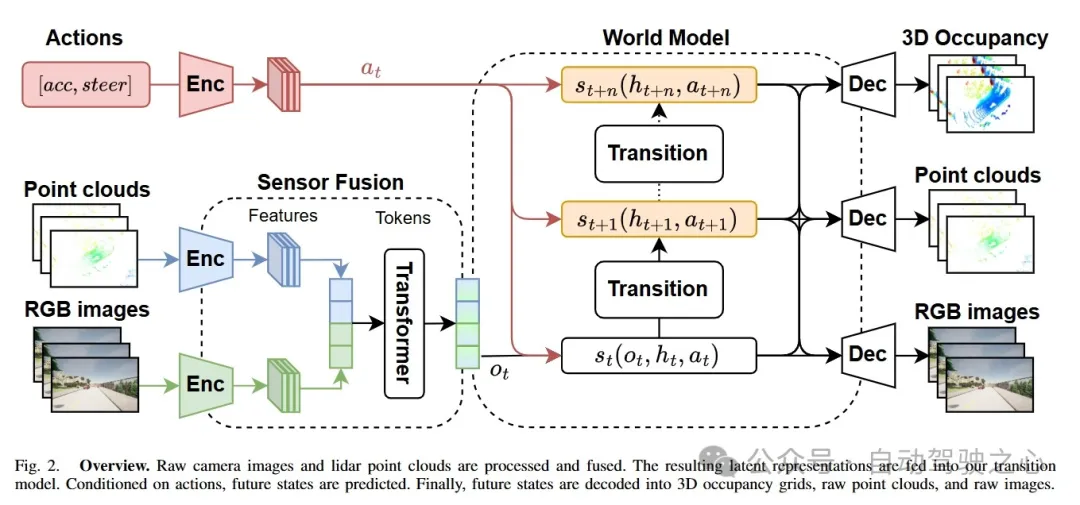

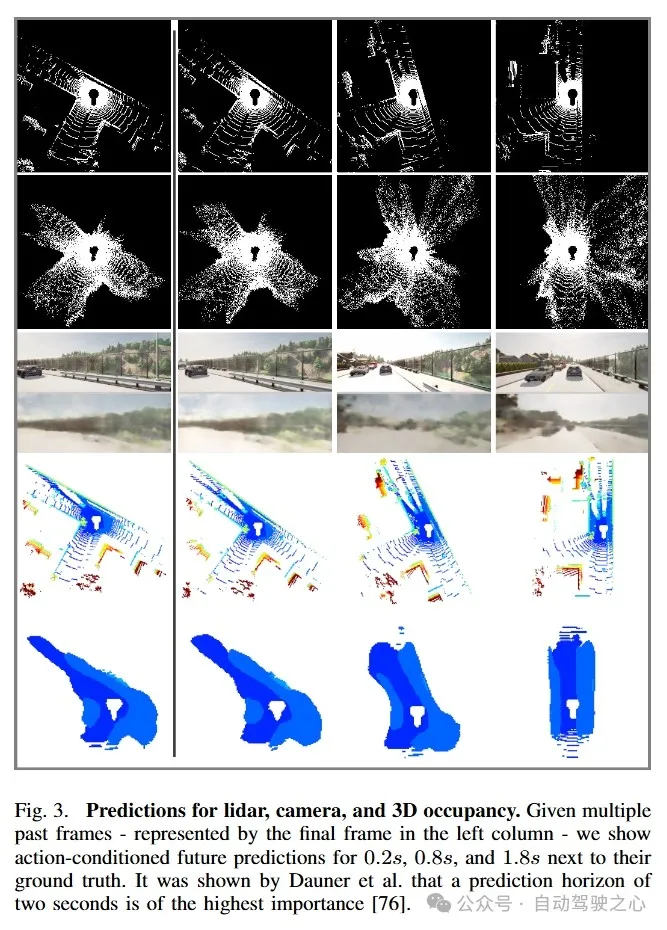

MUVO: A Multimodal World Model with Spatial Representations for Autonomous Driving

- paper: https://arxiv.org/abs/2311.11762

- code: https://github.com/fzi-forschungszentrum-informatik/muvo

為自動駕駛學習無監督世界模型有可能極大地提升當今系統的推理能力。然而,大多數工作都忽略了世界的物理屬性,僅關注傳感器數據。我們提出了 MUVO,一種具有空間體素表示的多模態世界模型,以應對這一挑戰。我們利用原始的攝像頭和激光雷達數據來學習一種與傳感器無關的世界幾何表示。我們展示了多模態的未來預測,并表明我們的空間表示提高了攝像頭圖像和激光雷達點云的預測質量。

總結

- OCC+世界模型的范式具有很大的潛力,相信接下來會有更多的相關工作;

- 使用diffusion-base的世界模型生成未來時刻的數據這個過程比較耗時,同時多幀以及多傳感器的融合策略也可能會影響實時性;

- OCC的演變本身依賴于世界模型的生成能力,但是目前訓練一個精確理解物理世界演變的世界模型非常困難,因此一定程度上會影響這類模型的性能;

- Gaussian的強大表達能力有助于提高幀間的一致性,而且相比NeRF,占用更少的資源,有待進一步探索。