邁向System 2推理,100頁論文硬核講述Meta-CoT

「我們有一份關于『推理時間計算』的新研究,以及我們過去幾個月一直在研究的內容!我們提出了一些理論,說明為什么它是必要的,它是如何工作的,我們為什么需要它,以及它對超級智能意味著什么。」

剛剛,斯坦福博士生 Rafael Rafailov 在 X 上官宣了一項他參與的新研究《 Towards System 2 Reasoning in LLMs: Learning How to Think With Meta Chain-of-Thought 》。

Rafailov 進一步表示,「我們需要高級推理的主要原因在于問題的復雜性。模型訓練數據中雖然包含了難題的解決方案,但并未涵蓋這些解決方案的真實數據生成過程。解決方案本身是某種復雜的元思維鏈(Meta-CoT)的輸出,而這一過程并未被明確記錄下來。」

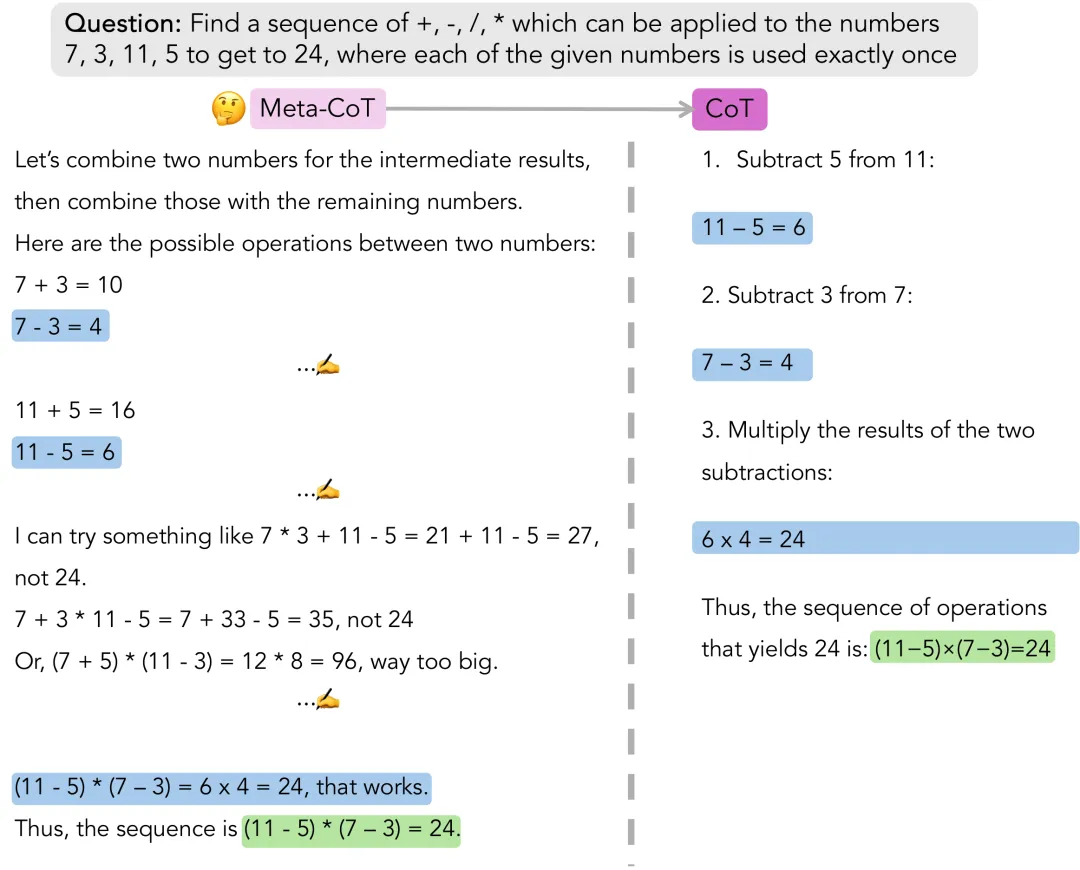

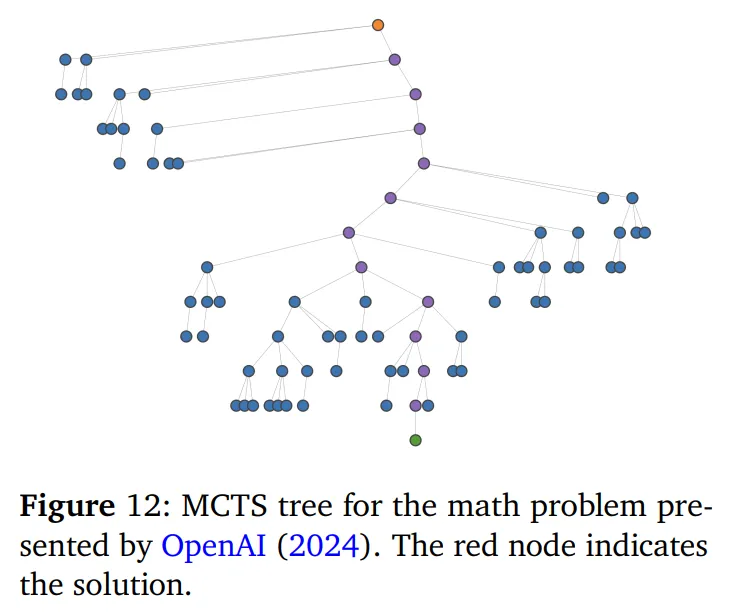

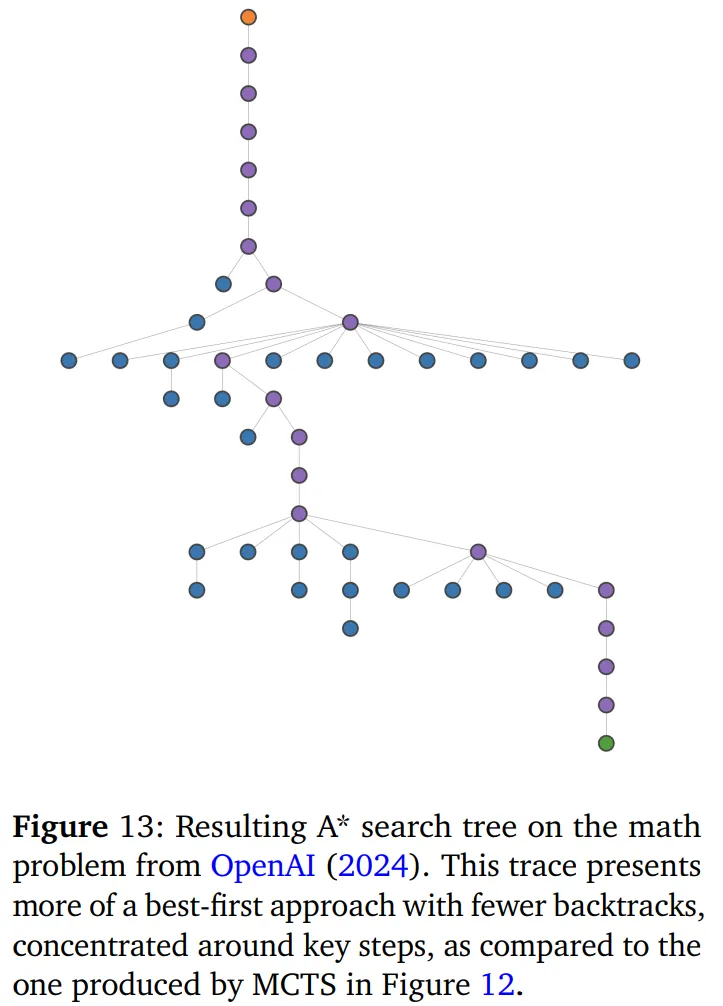

圖為解決一個數學問題的過程,這個問題是要找到一種運算符序列(包括加號 +、減號 -、乘號 * 和除號 /),使得數字 7、3、11、5 通過這些運算恰好使用一次得到結果 24。

Rafailov 所說的 Meta-CoT,是一種新穎的框架,它通過顯式建模生成特定思維鏈(CoT)所需的底層推理過程,擴展了傳統的思維鏈方法。

該研究認為,傳統的 CoT 方法雖然在解決簡單問題時有效,但未能捕捉到復雜推理的真實數據生成過程,這一過程通常涉及非線性、迭代性和潛在的探索與驗證。Meta-CoT 通過顯式建模這種潛在的「思考」過程,擴展了 CoT 方法。本文認為,這種建模對于解決需要高級推理能力的問題至關重要。

- 論文地址:https://arxiv.org/pdf/2501.04682

該研究從認知科學的雙過程理論中汲取靈感,將 Meta-CoT 框架看作為一種 System 2 推理形式。本文奠定了 Meta-CoT 理論基礎,展示了如何通過系統搜索過程實現這一框架,以及如何將這些過程內化到一個單一的自回歸模型中。隨后,本文提供了實證證據,包括對 OpenAI 的 o1 和 DeepSeek-R1 等頂尖模型的分析,這些模型展現出了與內化(上下文)搜索一致的行為。接著本文進一步探索了通過過程監督來訓練 Meta-CoT 模型的方法,以及通過蒙特卡洛樹搜索(MCTS)和 A * 等搜索算法生成合成數據的技術。

最后,本文概述了一個在單一端到端系統中實現 Meta-CoT 的具體流程,該流程結合了帶有線性化搜索痕跡的指令調整和強化學習(RL)后訓練。

本文還介紹了一個名為 Big MATH 的項目,該項目整合了超過 100 萬個高質量、可驗證的數學問題,以促進這一領域進一步研究。

該研究不僅提供了理論洞見,還為在 LLM 中啟用 Meta-CoT 提供了一條實踐路線圖,為人工智能實現更強大和更類人的推理鋪平了道路。

為什么要提出 Meta-CoT?

Meta-CoT 是什么樣的?

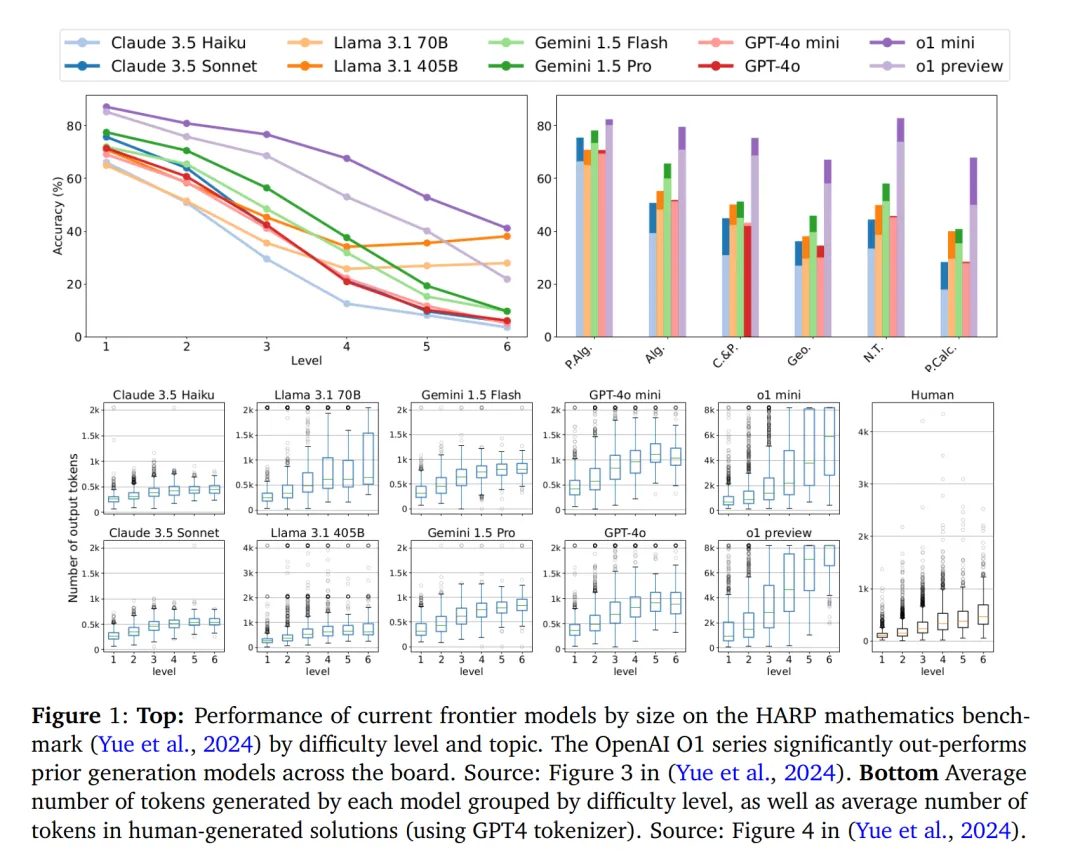

我們要問自己一個問題:具有「思維鏈」提示功能的語言模型是否真的能夠表達任何函數,從而解決任意復雜的問題?今天,前沿模型的能力足以解決一大類數學推理問題。但是,它們仍然難以解決高級問題,如 HARP 和 Omni-MATH(通用奧林匹克級別數學基準)。作者提出了以下理論來解釋這些經驗觀察結果:

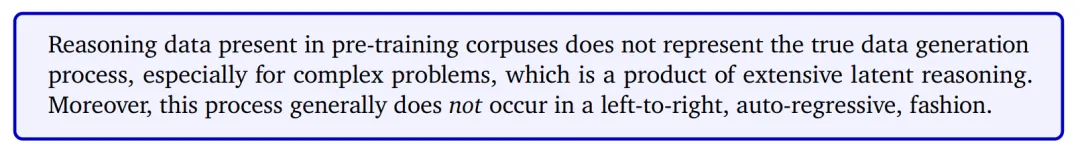

預訓練語料庫中的推理數據并不代表真正的數據生成過程,尤其是復雜問題的數據生成過程,它是大量潛在推理的產物。此外,這一過程一般不會以從左到右、自回歸的方式進行。

更詳細地說,預訓練語料庫和后訓練指令微調中普遍存在的思維鏈(CoT)推理數據遵循簡單問題(如代數計算、計數、基礎幾何等)解決方案的真實數據生成過程。例如,解決高中代數問題的教科書展示了生成答案的一般過程。如果我們遵循現有教科書中呈現的一些步驟或方法,我們最終可以得出解答。因此,這些可以通過具有恒定深度的 transformer 來學習,這些 transformer 能夠表達過程中每個單獨步驟的復雜性。

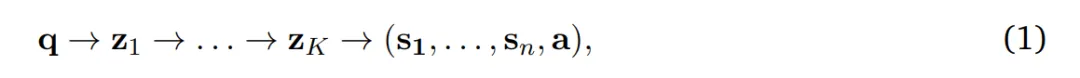

相比之下,復雜推理問題并不遵循這種模式。我們可能有一組三元組(q, S, a),其中 q 是問題,S = (s_1, ..., s_n) 是解答步驟,a 是(可選的)答案,但真實的數據生成過程并非自回歸的:

z_??是解答步驟中遺漏的潛在「思考」,這些可以通過從左到右的生成來完全表示,而數據集中的解答步驟 S = (s_1, ..., s_n) 是聯合生成的。

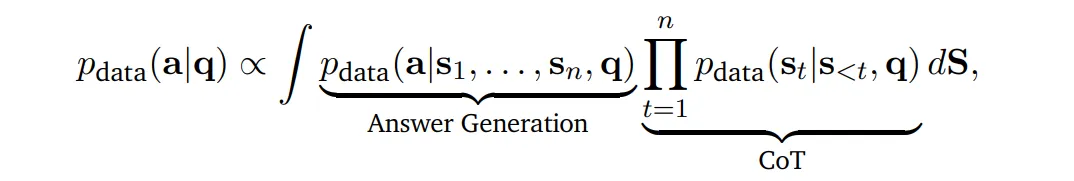

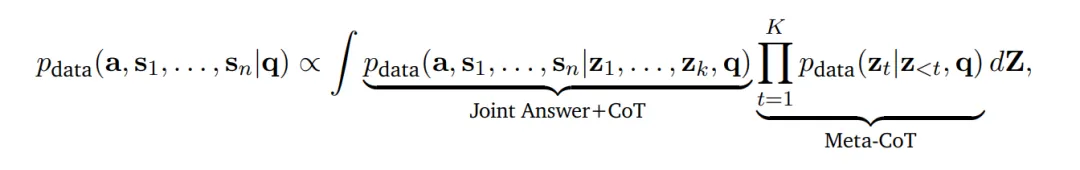

我們可以通過將推理解釋為潛在變量過程來形式化這一論證。具體來說,經典的思維鏈(CoT)可以被看作是:

即,最終答案產生的概率是通過對潛在推理鏈的邊緣化得到的。作者主張,對于復雜問題,真實的解生成過程應該被視為:

即,解(a,s_1, . . . , s_n)的聯合概率分布以潛在生成過程為條件。請注意,這個參數是先前的 CoT 參數的 meta-generalization,因此作者將過程 q→z_1 → . . . → z_K 稱為 Meta-CoT。

傳統 CoT 有什么問題?

根據之前的討論,一個問題自然地浮出水面:為什么 LLM 在這些高級推理任務上失敗了?如上所述,作者提出了預訓練和指令微調語料庫由類型為(q, s_1, ..., s_n, a)的數據組成,這些數據并不包含如方程 1 所示的真實數據生成過程。這個現象很常見 —— 教科書包含高級證明,但不包含推導這些證明的完整思考過程。

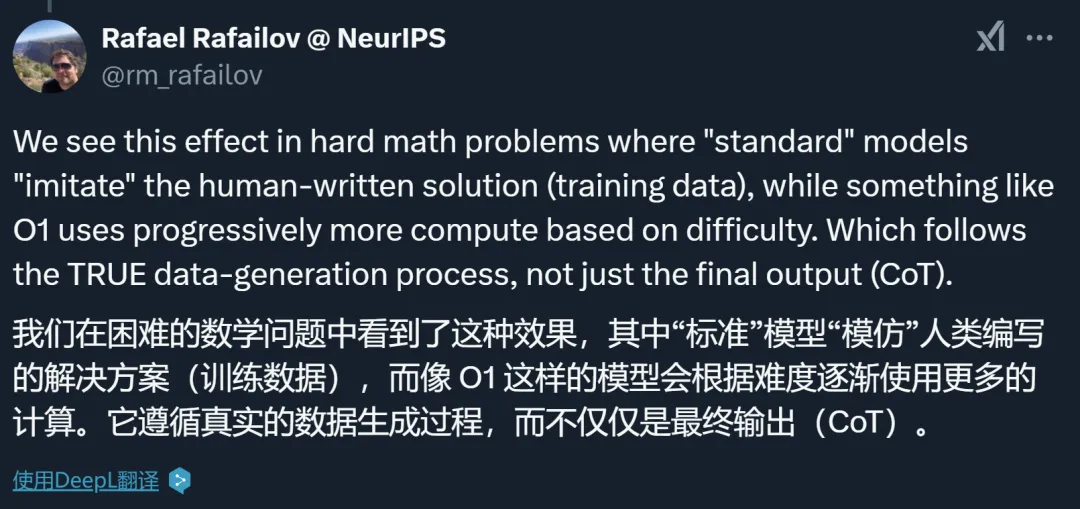

很多使用傳統思維鏈的工作受此影響,但 OpenAI 的 o1 系列看起來是個例外。作者表示,他們在困難的數學問題上看到了這種差異:「標準」模型會「模仿」人類編寫的解決方案(訓練數據),而像 o1 這樣的模型則根據難度逐步使用更多的計算。它似乎遵循真正的數據生成過程,而不僅僅是最終輸出(CoT)。

用語言模型進行深思熟慮的推理 —— 搜索

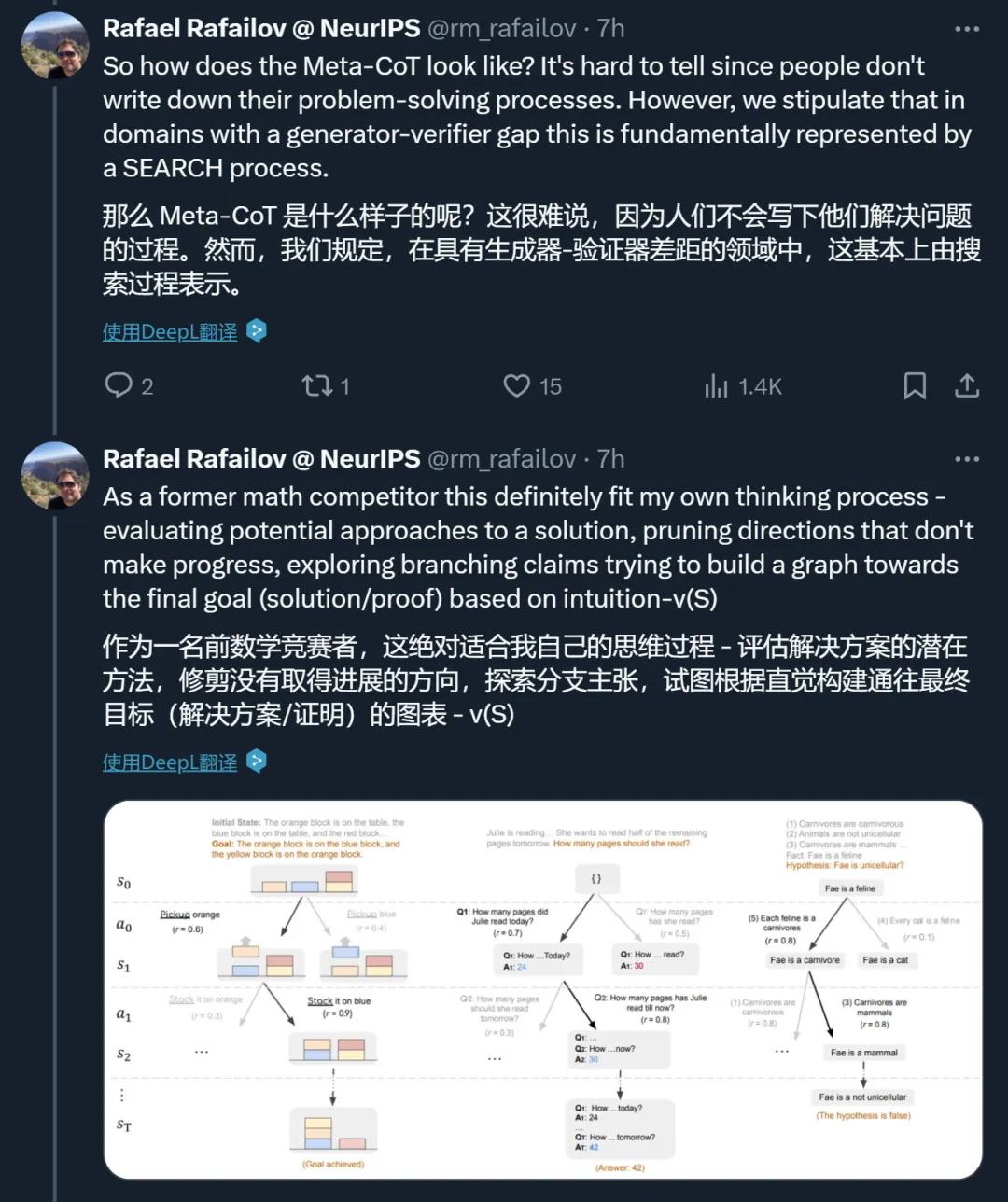

上一節介紹了 Meta-CoT 過程,并指出 LLM 在高級推理任務上表現不佳的原因是訓練數據未能充分代表真實的數據生成過程,即文本語料庫中未包含(或僅包含有限數量的)Meta-CoT 數據。因此,剩下的問題是:真實的數據生成過程是什么樣的?

首先,本文主張對于許多高級推理或目標導向問題,生成(問題的解決過程)和驗證(解決方案的正確性檢驗)之間存在顯著的復雜性 gap。

其次,假設存在一個不可忽視的生成器 - 驗證器 gap,作者認為文本語料庫中呈現的挑戰性問題的解決方案是一個擴展搜索過程的結果,這個過程本身在數據中并沒有得到體現。

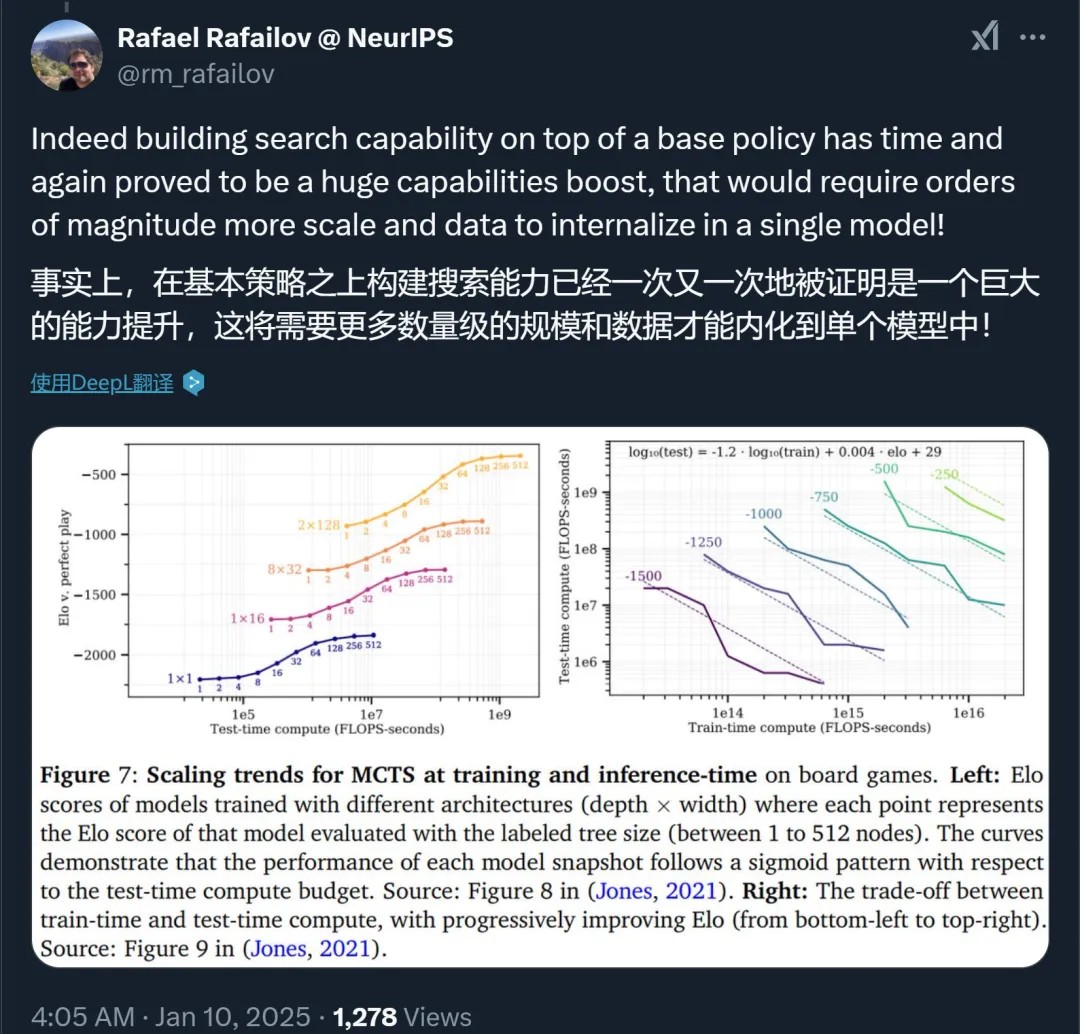

作者表示,事實上,在基本策略之上構建搜索能力已經一次又一次地被證明會帶來巨大的能力提升。不過,這需要更多數量級的 scale 和數據才能內化到單個模型中。

邁向 Meta-CoT 推理

為什么需要將深思熟慮的推理過程內化到一個單一模型中?作者提出了兩個主要原因:

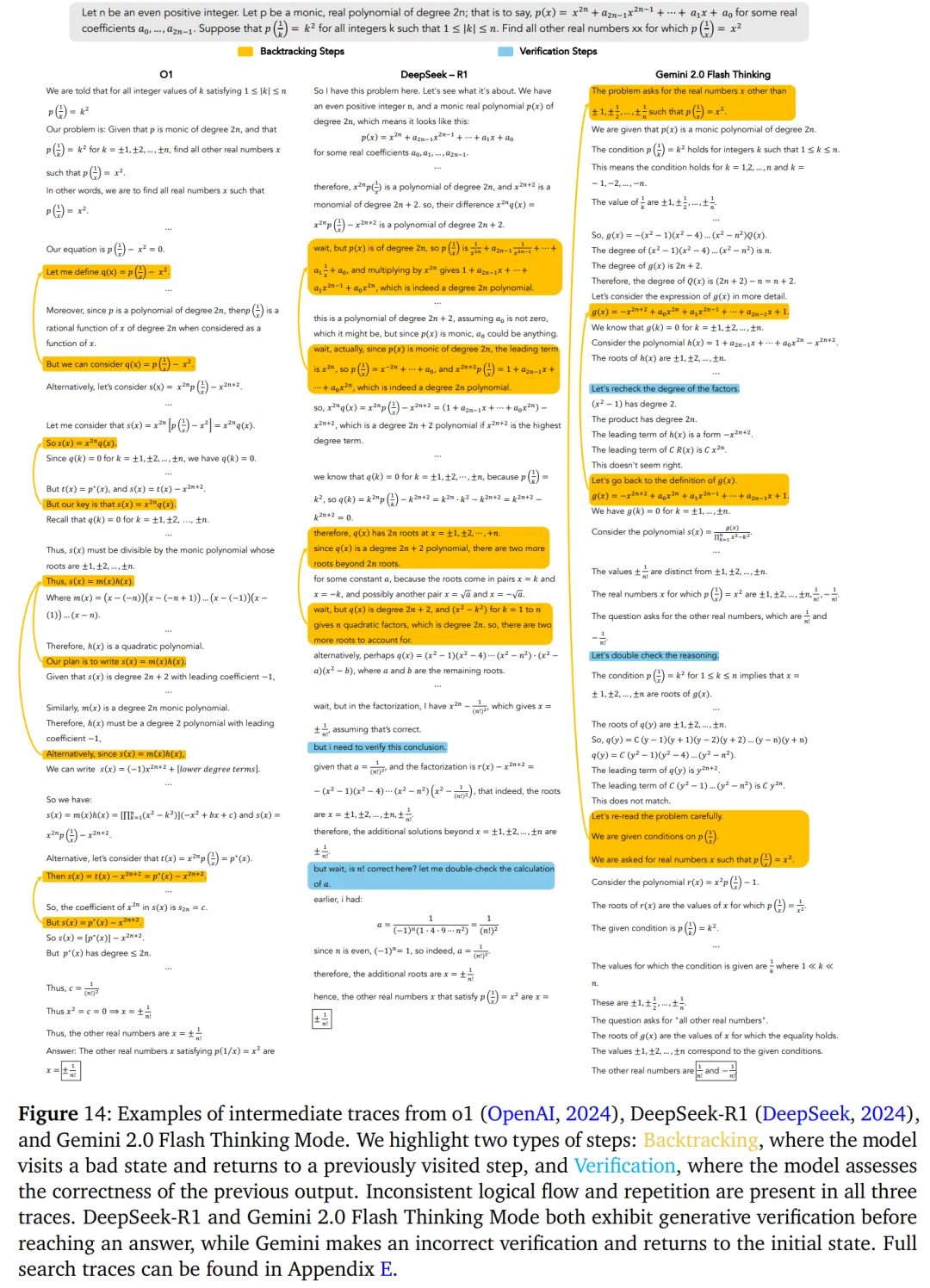

首先是效率:通過在自回歸模型的上下文中整合搜索,可以有效地完成探索,因為模型可以訪問上下文中所有先前訪問過的節點。事實上,正如圖 14 所示,即使是高級推理模型也會執行許多語義相同的重復推理步驟。

其次是超級智能:如果一個自回歸模型能夠學會在上下文中實現搜索算法,那么額外的強化學習(RL)訓練可能使模型發現新的推理方法。這將可能使模型能夠解決在基于符號的樹搜索方法下解決以前無法解決的問題類別。

在接下來的部分,作者進一步探討了如何訓練一個模型來內化這樣一個推理系統。

作者介紹了 STaR(Self-Taught Reasoner)方法背后的核心思想,該方法用于引導中間 CoT 步驟,以及如何將類似的概念泛化到元推理策略中。

具體而言,STaR 方法引入了一種迭代 bootstrapping 方法,旨在提高 LLM 的推理能力。STaR 專注于訓練模型以生成和完善推理過程,特別是對于需要復雜推理的任務,其采用了基于強化學習的方式來進行。

之后作者將 STaR 的思路擴展到 Meta-CoT。

通過搜索合成 Meta-CoT

本文探索了兩種用于生成合成訓練數據的主要搜索算法:蒙特卡洛樹搜索 (MCTS) 和 A* 變體。

蒙特卡洛樹搜索如下:

與圖 12 中由蒙特卡洛樹搜索(MCTS)產生的路徑相比,A* 搜索具有更少的回溯步驟,主要集中在關鍵步驟上。

過程監督

搜索方法的一個關鍵組成部分是評估函數??(q, S_??),它對推理鏈中的中間狀態進行評分。這些評估函數被廣泛稱為過程獎勵模型(Process Reward Models,簡稱 PRM)。通過整合過程監督,搜索機制獲得了在遇到次優路徑時回溯到早期有前景狀態的靈活性,從而實現了更有效的探索。然而,如何有效地獲取這些能力仍然是一個未解決的問題。

作者概述了構建此類過程指導模型的策略:

- 學習過程獎勵模型;

- PRM 質量及其對搜索的影響;

- 可驗證問題與開放式問題。

在論文第 6 章,作者從元學習和元強化學習的角度對推理問題和 Meta-CoT 進行解釋。

在前面章節中,作者通過計算復雜性和生成器 - 驗證器 gap 的范例來激發上下文搜索的需求。在本節中,作者建立了一個替代公式,以幫助形式化強化學習訓練的實證結果。

作者假設獎勵函數??(S, q) → {0, 1} 是提示 q 的確定性(但先驗未知)函數,它只接受特定的解決方案集。在新的提示下進行測試時,這會產生獎勵函數的認知不確定性,即我們事先不知道該任務(提示問題)的完整接受或拒絕的解決方案集。

在接下來的第 7 章,作者提出了一種基于搜索的高級推理理論,以及一些早期的實證研究結果。作者建議遵循現代后訓練的整體結構,包括指令微調和強化學習訓練。感興趣的讀者,可以查看原論文了解更多內容。

總結

本文引入了 Meta-CoT 框架,用于理解和增強大型語言模型(LLMs)的推理能力。作者認為傳統的思維鏈并不能完全代表推理問題背后的數據生成過程。通過融入搜索、驗證和迭代優化的概念,Meta-CoT 為高級問題解決所需的認知過程提供了一個更完整的模型。

Meta-CoT 是實現大型語言模型更強大、更具泛化性推理能力的一種有前景的途徑。當前最先進模型的表現,以及在上下文探索和回溯方面的實驗,都支持了內部搜索過程對于復雜任務表現至關重要的假設。此外,本文提出的訓練流程為開發具有增強 Meta-CoT 能力的大型語言模型提供了一種具體的方法。

了解更多內容,請參考原論文。