Meta-CoT:通過元鏈式思考增強大型語言模型的推理能力

大型語言模型(LLMs)在處理復雜推理任務時面臨挑戰,這突顯了其在模擬人類認知中的不足。盡管 LLMs 擅長生成連貫文本和解決簡單問題,但在需要邏輯推理、迭代方法和結果驗證的復雜任務(如高級數學問題和抽象問題解決)中,其能力有所欠缺。

這種局限性源于 LLMs 的信息處理方式。大多數模型采用類似于系統 1 的思維模式——一種快速、基于模式的反應,類似于直覺。雖然這種方法適用于許多任務,但它在需要系統性推理、嘗試多種策略和檢查結果的問題上表現不佳。系統 2 思維,即人類解決難題時采用的緩慢、逐步且通常需要回溯以完善結論的方法,是解決這些挑戰的關鍵。

為了彌合這一差距,研究人員引入了元鏈式思考(Meta-CoT)。Meta-CoT 基于鏈式思考(CoT)方法,使 LLMs 不僅能夠建模推理步驟,還能夠模擬“思考”過程。這種轉變類似于人類在面對難題時的探索、評估和迭代方式。

本文探討 Meta-CoT 如何拓展 AI 推理的邊界,深入研究其理論基礎、實際應用和實證支持。同時我們將分析搜索算法、強化學習以及在大型語言模型中擴展審慎推理的挑戰。

解鎖 AI 中的審慎推理

大型語言模型(LLMs)在處理事實性問題、撰寫清晰文本以及解決基本推理問題方面已取得顯著進展。但是在高復雜度任務(如高級數學、科學證明或戰略決策)中,它們常常表現出不足。這揭示了 AI 在認知能力方面存在的明顯差距:缺乏仔細規劃和審慎推理能力。

本文基于 Xiang 等人(2025)的研究論文《Towards System 2 Reasoning in LLMs: Learning How to Think With Meta Chain-of-Thought》中的思想,探討了一種名為元鏈式思考(Meta-CoT)的新方法。該方法旨在擴展傳統鏈式思考(CoT)推理能力。

盡管傳統的 CoT 方法引導 LLMs 逐步解決問題,但它忽略了解決復雜問題所需的迭代和探索過程。Meta-CoT 通過在 AI 的問題解決步驟中引入結構化的搜索、驗證和系統性思考來解決這一問題。

除了對論文進行總結,本文還提供了實際應用、更多示例,以及對 Meta-CoT 如何融入 AI 審慎推理的更廣泛計劃的視角。對于熟悉認知科學的人來說,這與 Daniel Kahneman 所描述的系統 2 思維密切相關——一種緩慢且邏輯的處理過程。通過將這些概念引入 AI,Meta-CoT 推進了 LLMs 處理需要超越模式識別的任務的能力。

本文接下來的部分將探討 Meta-CoT 的基礎、訓練方法及其在實際應用中的影響。這些見解共同展示了 Meta-CoT 如何為賦予 AI 類人問題解決能力提供藍圖。

什么是元鏈式思考?

要理解元鏈式思考(Meta-CoT),需要回顧傳統的鏈式思考(CoT)方法。CoT 推理引導語言模型通過將問題分解為更小的、連續的步驟來解決問題,類似于在數學中展示解題過程。這種方法在簡單任務中確實提高了性能,因為它促使模型“逐步思考”。但是對于更復雜的問題,傳統的 CoT 則會遇到困難。原因在于,現實世界的推理很少是線性的,它通常涉及循環和非線性的路徑。

Xiang 等人(2025)在其關鍵論文中引入了 Meta-CoT,將 CoT 推理向前推進,通過建模解決問題所需的潛在思考過程。與假設線性和確定性推理不同,Meta-CoT 認識到真正的問題解決包含探索循環、驗證和回溯。這使得模型能夠模仿人類在面對復雜挑戰時使用的迭代式“思考”。

Meta-CoT 的核心是整合系統 2 類型的推理——專注于解決復雜問題的審慎策略。例如考慮解決一個高級數學問題:傳統的 CoT 方法可能會嘗試直接求解;但是Meta-CoT 引入了以下機制:

- 搜索:探索各種可能的解決方案路徑。

- 驗證:檢查解決方案或步驟是否符合問題約束。

- 回溯:識別錯誤并返回到之前的步驟進行修正。

這種從線性生成到迭代式問題解決的轉變標志著一個根本性的改進。他們認為,Meta-CoT 可以更好地處理中間步驟或思考過程在訓練數據中不明確的問題,而這正是高級推理任務的常見情況。

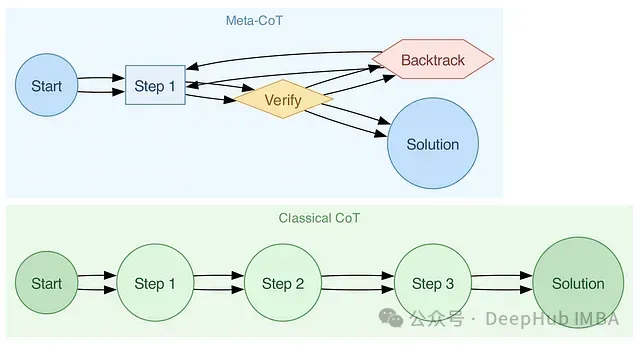

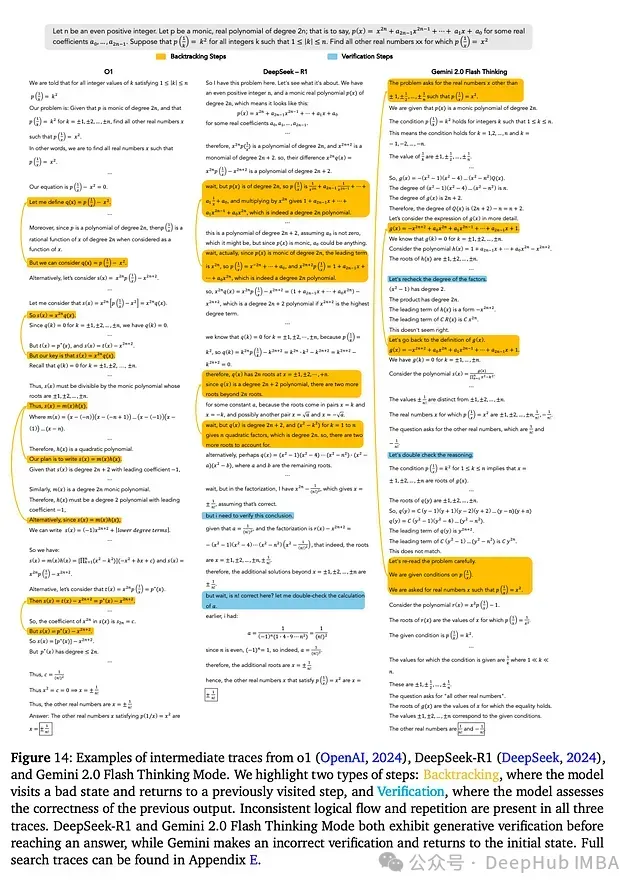

下圖展示了語言模型中兩種不同的思考方式:

經典鏈式思考(CoT):從頭到尾逐步移動,適用于簡單任務,但對于非線性問題則存在不足。

元鏈式思考(Meta-CoT):引入迭代思考、檢查和回溯,類似于人類處理模糊和復雜問題的方式。

為什么經典 CoT 會失敗?

要理解 Meta-CoT 的創新之處,有必要了解舊版 CoT 的局限性。經典 CoT 使用固定的提示進行逐步思考,假設其符合訓練數據的模式。諸如數學證明或科學問題等任務通常涉及隱藏的步驟。經典 CoT 無法模仿人類的探索策略,從而導致錯誤的答案。

對于國際數學奧林匹克中的一道難題,CoT 模型通常采用簡單的技巧而非深入探索。Meta-CoT 將問題視為一個潛在變量過程,使模型能夠通過組合多個中間步驟進行思考,即使這些步驟在數據中不存在。

推理中的搜索和驗證

人類通過嘗試不同的方法來解決困難問題。我們思考可能的答案,檢查其是否可行,并在必要時調整計劃。這種探索和檢驗想法的能力構成了審慎思考的基礎。大多數語言模型缺乏這些能力。其線性的思維模式在需要探索和檢驗的任務中會失效。

元鏈式思考(Meta-CoT)通過添加兩個關鍵組件來彌補這一不足:搜索和驗證。這些工具使模型能夠嘗試多種解決方案路徑并檢查其正確性,類似于人類的推理過程。

搜索:嘗試多種解決方案路徑

Meta-CoT 中的搜索使語言模型能夠在解決方案空間內嘗試不同的步驟。與之前只生成單一的步驟序列不同,Meta-CoT 將推理視為一個分支過程:

- 模型在每個階段考慮多種可能的下一步。

- 啟發式方法或概率檢查選擇最佳路徑。

- 如果在某個路徑上遇到困難,模型會回溯并嘗試其他選擇。

這種搜索工具類似于蒙特卡洛樹搜索(MCTS)或 A* 算法,但針對推理進行了調整。例如,在求解數學方程時,模型可能會嘗試不同的因式分解方法,測試其有效性,并最終縮小至正確的選擇。

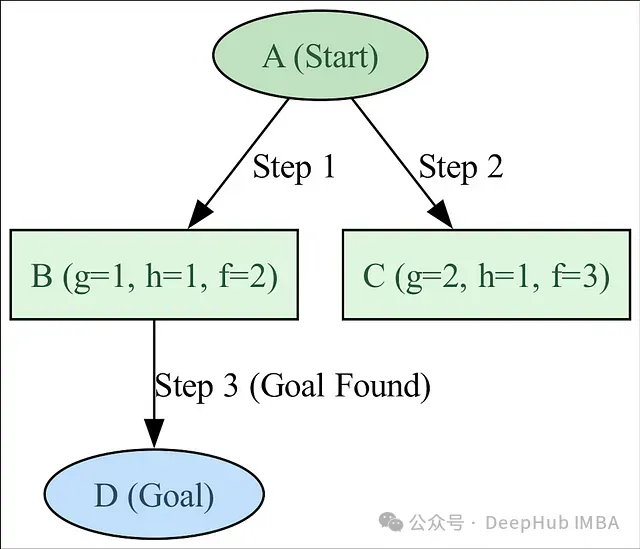

A* 算法是一種通過結合以下要素來找到目標最優路徑的搜索算法:

- 路徑成本 (g):從起點到當前節點的路徑成本。

- 啟發式 (h):從當前節點到目標的估計成本。

它優先探索總成本最低的路徑:

- f(n) = g(n) + h(n)

以下是其工作原理:

- 算法從節點 A 開始。

- 它探索 A 的相鄰節點(B 和 C)并評估其成本。

- 它選擇總成本(f)最小的節點并繼續搜索。

- 如果遇到目標(D),則終止并返回解決方案。

- 如果某個路徑導致死胡同,算法會回溯并探索替代路徑。

以下是搜索樹圖的圖形表示:

沿途確保正確性

單獨的搜索缺乏強大的驗證機制。驗證作為模型的內部“檢查和平衡”系統,負責檢查特定解決步驟是否有效。在 Meta-CoT 中,驗證是通過以下方式實現的:

- 顯式驗證:使用預定義的規則或約束。

- 學習驗證:訓練模型基于過去的經驗來識別正確的模式或結果。

例如在解決難題時,Meta-CoT 會檢查中間步驟,從而消除偏離問題約束的路徑。這可以防止模型將計算資源浪費在錯誤的解決方案上。

搜索和驗證的結合構成了 Meta-CoT 的骨干,使模型能夠自適應地探索和改進解決方案。在下一節中,我們將研究如何訓練 Meta-CoT 以內化這些機制,從而使審慎推理成為語言模型的基本能力。

Meta-CoT 訓練:超越標準方法

元鏈式思考(Meta-CoT)不僅僅涉及提示設計或調整簡單的數據集。掌握搜索、檢查和回溯步驟需要先進的訓練方法。這些方法訓練語言模型不僅要生成推理步驟,還要即時檢查、改進和修復這些步驟。

Meta-CoT 的關鍵訓練方法

自學推理器(Self-Taught Reasoner,STaR): STaR 采用迭代的自舉方法。模型生成推理路徑,去除錯誤的路徑,然后使用正確的解決方案來調整自身。這類似于教模型“從錯誤中學習”。

其工作的關鍵步驟:

- 使用模型生成推理路徑。

- 僅保留結果正確的路徑。

- 在這些“自舉”路徑上調整模型以改進推理。

Meta-STaR: Meta-STaR 通過在訓練中添加搜索路徑來擴展 STaR。它在中間步驟(如探索路徑和回溯)上訓練模型,從而允許有背景的搜索推理。

訓練數據不再僅包含單個推理路徑,還包含展示迭代和非線性思考過程的搜索樹。

通過搜索算法生成合成數據: 真實的數據集很少包含復雜的思考軌跡,因此 Meta-CoT 經常使用合成數據進行訓練。像蒙特卡洛樹搜索(MCTS)或 A* 這樣的算法可以模擬搜索軌跡,從而訓練模型進行類似的任務。

以下是 Meta-STaR 方法的簡化 Python 示例,展示了如何生成和使用搜索軌跡進行訓練:

import random

class MetaSTaR:

def __init__(self, environment):

self.environment = environment

self.q_table = {} # Q-learning 表格

def generate_search_traces(self, num_episodes):

traces = []

for _ in range(num_episodes):

# 生成探索軌跡

trace = self._explore_episode()

traces.append(trace)

return traces

def _explore_episode(self):

# 模擬一個探索回合的搜索軌跡

state = self.environment.reset()

trace = [state]

done = False

while not done:

# 選擇動作

action = self._choose_action(state)

# 執行動作

next_state, reward, done = self.environment.step(action)

# 更新軌跡

trace.append((action, next_state, reward))

state = next_state

return trace

def _choose_action(self, state):

# 使用 epsilon-greedy 策略選擇動作

if random.random() < 0.1:

return random.choice(self.environment.actions)

else:

return max(self.environment.actions,

key=lambda a: self.q_table.get((state, a), 0))

# 訓練方法示例

def train_meta_star(environment, num_episodes=100):

meta_star = MetaSTaR(environment)

# 生成搜索軌跡

search_traces = meta_star.generate_search_traces(num_episodes)

# 分析和處理搜索軌跡

processed_traces = process_traces(search_traces)

return processed_traces

def process_traces(traces):

# 處理搜索軌跡的邏輯

# 可以包括:

# 1. 過濾無效軌跡

# 2. 提取關鍵學習點

# 3. 準備用于模型微調的數據

processed_traces = []

for trace in traces:

# 這里添加具體的處理邏輯

processed_traces.append(trace)

return processed_traces諸如 Meta-STaR 之類的訓練方法可以開發出能夠進行審慎思考的模型。那么這些策略如何轉化為實際性能?

實證結果:審慎推理的證據

性能基準

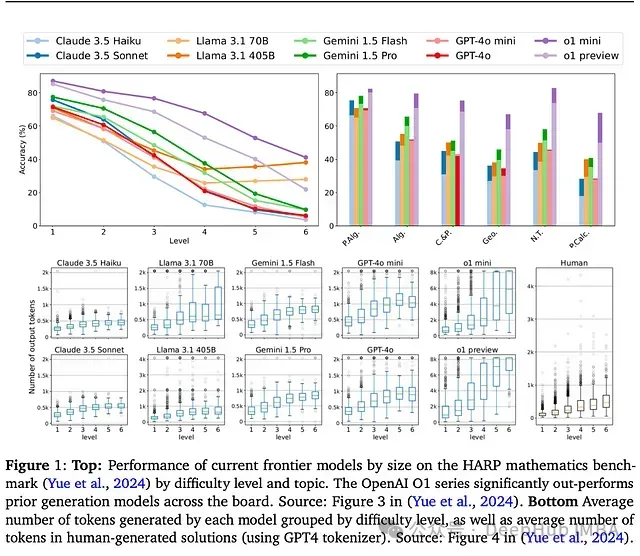

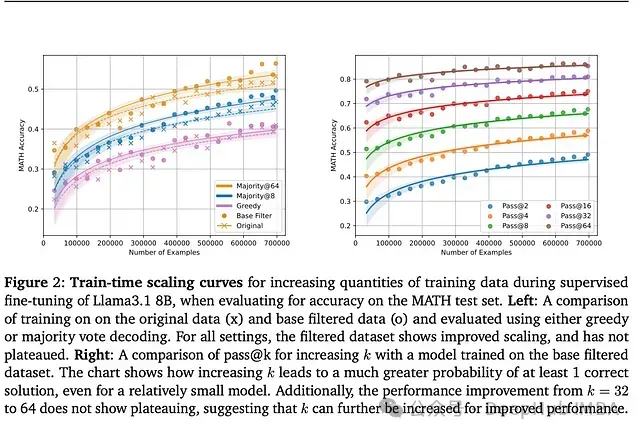

Meta-CoT 在 HARP、MATH 和 Omni-MATH 等基準測試中進行了嚴格的評估,這些測試考察了超越基本標記預測的推理能力。以下是結果:

使用 Meta-CoT 改進的 OpenAI o1 模型系列在 5 級 HARP 問題上的準確性比基線推理模型提高了 70%。

在 MATH 數據集上,Meta-CoT 改進的模型表現出 85% 的 pass@64 準確率,顯著優于停留在約 40% 的經典 CoT 模型。

在數學定理證明中,Gemini 2.0 使用 Meta-CoT 推理,通過回溯和檢查來解決復雜的問題,包括那些非 Meta-CoT 模型給出錯誤或不完整答案的問題。

在迷宮任務中,A* 算法(Meta-CoT 的一個關鍵組成部分)使得效率比類似的采樣方法提高了 4 倍。

o1 模型為棘手問題生成了更多的標記,同時保持了解決方案的準確性。這展示了 Meta-CoT 逐步思考的方式(見上面的圖 1)。

通過將迭代探索嵌入到思維模型中,Meta-CoT 使模型能夠以前所未有的方式處理復雜性。這標志著進步不僅在 AI 推理方面,也在現實生活中的問題解決方面。

元強化學習:學習如何思考

訓練機器進行審慎思考并非易事。這不僅涉及找到答案,還需要探索、失敗,并不斷嘗試,直到找到正確的解決方案。元強化學習(Meta-RL)通過將推理視為試錯過程來解決這個問題,類似于人類解決困難問題的方式。

我們如何教會機器思考?

元強化學習將推理轉變為學習過程。以下是該過程的概述:

探索:模型首先嘗試各種可能的解決方案。想象一下,一個學生在面對拼圖時,在不知道答案的情況下嘗試猜測。

反饋:每次嘗試后,模型會使用“獎勵函數”來檢查進度。例如,它是否更接近正確的答案?

調整:通過反饋,模型會調整其方法,探索新的方法或改進當前的方法。

總結

構建像人類一樣思考和推理的機器不再是遙不可及的夢想。通過 Meta-CoT,我們開始將基于直覺的系統與進行逐步推理的系統連接起來。這種從認知科學家所稱的系統 1 思維到系統 2 思維的轉變具有深遠的意義。它意味著要超越模式識別和本能,轉向更加審慎的方法,即理解如何得出答案的方法。

Meta-CoT 改變了 AI 處理復雜問題的方式。傳統模型經常難以應對需要超越線性思維的挑戰。涉及探索或回溯的問題超出了它們的舒適區。但是Meta-CoT 使 AI 能夠處理這些復雜性,它測試想法、檢查進展,并在發現更好選擇時調整推理——類似于科學家測試想法或國際象棋選手在看到更好的走法后重新思考棋步。