給大模型制作圖文并茂的教科書: 從2.5年的教學視頻里挖掘多模態語料

近期關于 scaling law 的討論甚囂塵上,很多觀點認為 scale law is dead. 然而,我們認為,高質量的 “無監督” 數據才是 scaling law 的關鍵,尤其是教科書級別的高質量的知識語料。此外,盡管傳統的語料快枯竭了,但是互聯網上還有海量的視頻并沒有被利用起來,它們囊括了豐富的多種模態的知識,可以幫助 VLMs 更好好地理解世界。

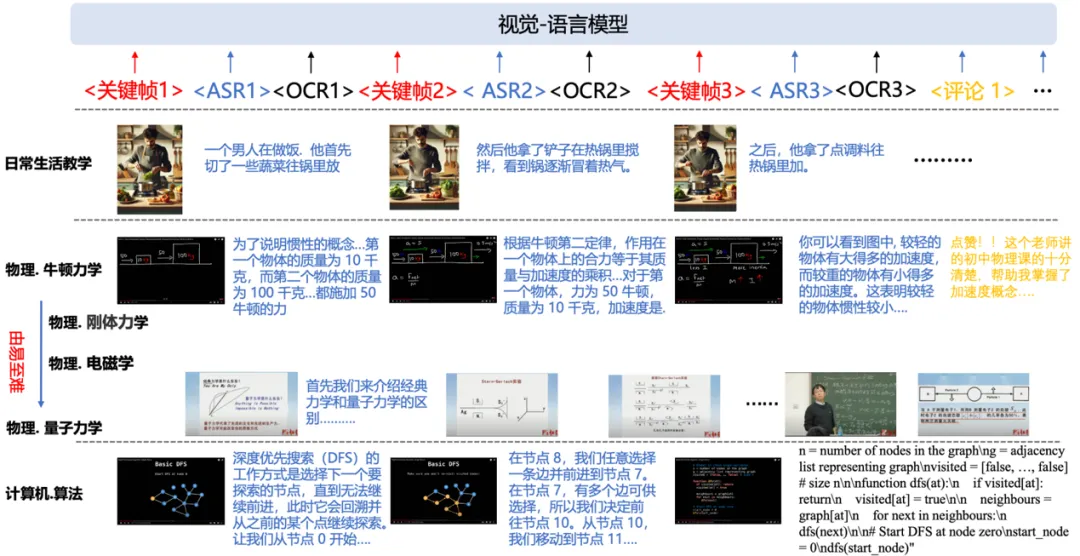

浙大和阿里巴巴達摩院聯合提出一個圖文交織的多模態知識語料:他們收集互聯網上超過 22000 課時 (兩年半) 的教學視頻,提取關鍵步驟的畫面和音頻(轉錄成文本),組織成連貫、圖文交織的格式,制作成數學,物理,化學等多個學科的圖文教科書 (textbook)。基于這些 textbook,VLMs 可以像人類上課一樣學習這些圖文交織,由易至難的學科知識。

- 論文地址: arxiv.org/abs/2501.00958

- Code: https://github.com/DAMO-NLP-SG/multimodal_textbook

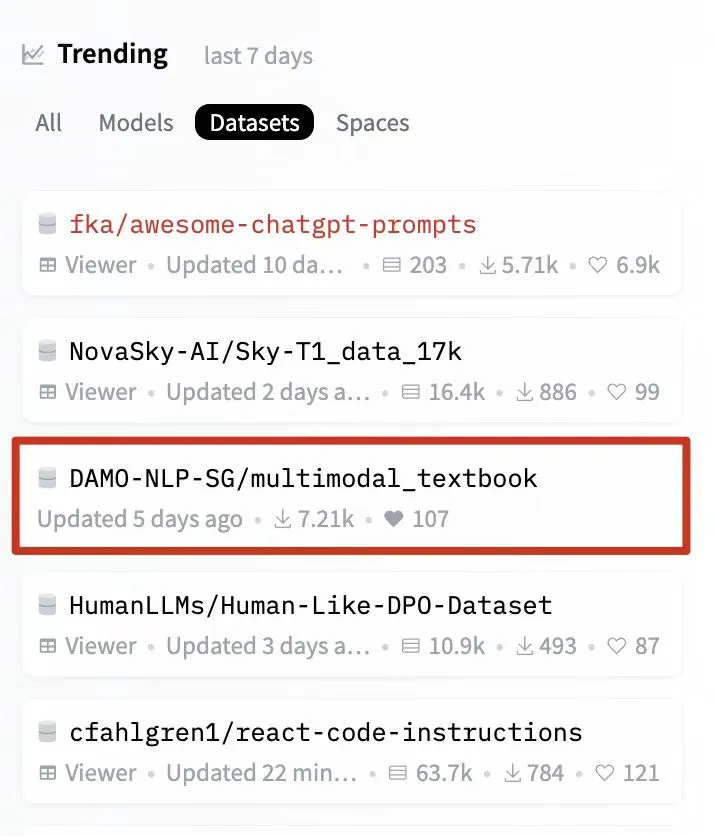

該研究還登上了huggingface dataset trending榜單,不到兩周下載量已經7000+。

1. 背景和動機

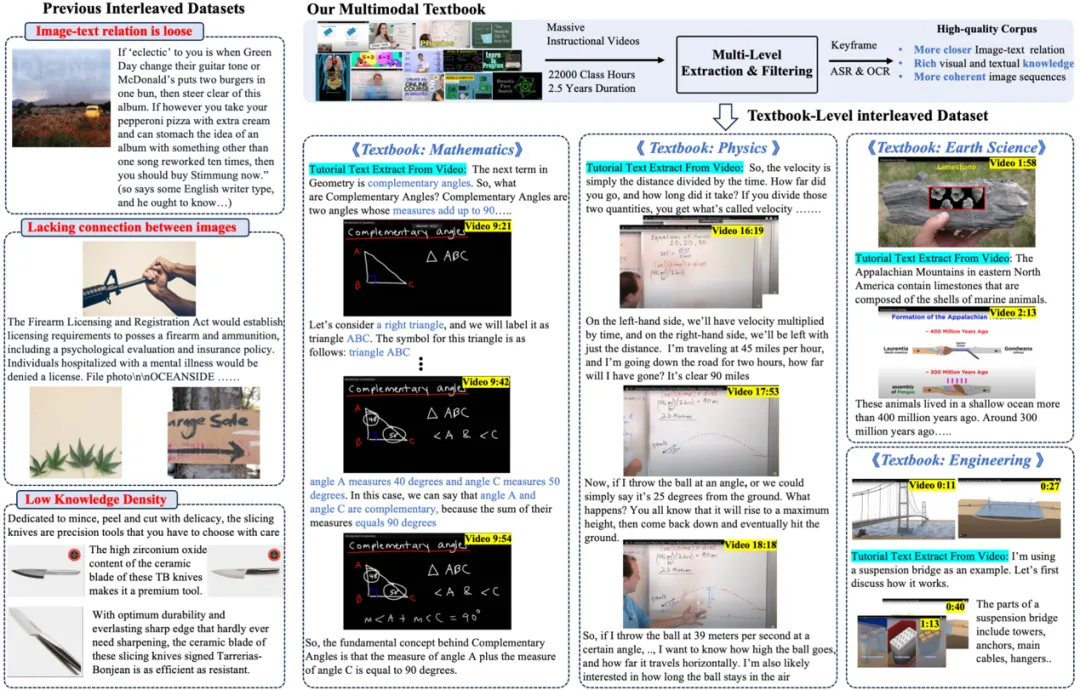

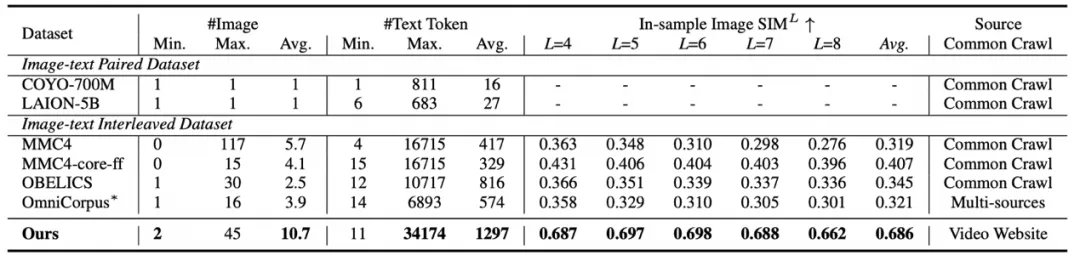

當前多模態大模型(VLMs)的預訓練語料主要有兩種形式:圖像 - 文本對語料以及圖文交織語料:

- 圖文對數據 (image-text pair corpus):多模態模型通常依賴大量圖文對數據進行預訓練,這種數據能快速對齊圖像與文本。

- 圖文交錯數據集 (image-text Interleaved corpus):如 MMC4, OBELICS 等數據集,它們引入了更加自然,更加靈活的圖文任意交織形式。這些語料由穿插著圖像的文本段落組成,通常是從網頁和文檔(如 Common Crawl)中抓取的。與圖像 - 文本對數據相比,圖文交錯語料庫使 VLMs 能夠更自然地處理任意輸入,像人類一樣理解世界。

然而當前的 interleaved corpus 大多爬取自網頁或者文檔,存在以下問題:

(1)文本與圖像關系松散:網頁中的圖像和文本之間的關聯通常很松散,甚至可能包括不相關的圖像,例如徽標或廣告。

(2)圖像序列缺乏邏輯連貫性:大多數網頁包含的圖像相對較少,更重要的是,圖像之間的邏輯關系往往很模糊,使得學習復雜的視覺推理變得困難。

(3)知識密度低:抓取的網頁不可避免地包括新聞、娛樂和廣告推薦等內容,很少涉及專業知識,即知識密度較低。

因此,探索如何構建高質量、教科書級別的 interleaved 數據集是非常必要的。此外我們還注意到互聯網中存在的海量的教學視頻 (例如 Youtube 上的在線課程),這些視頻包含豐富的知識,人們經常使用這些視頻來學習基礎學科知識,但這些寶貴資源在 VLMs 訓練中仍未得到充分利用。基于此,我們思考如何讓 VLMs 像人類一樣,利用這些教學視頻進行高質量的預訓練,從而提升其知識水平和推理能力。為實現這一目標,關鍵在于將這些教學視頻轉化為教科書級別的圖文交織訓練語料。

2. 方法:如何利用教學視頻構建高質量的知識語料

2.1 LLM 輔助分門別類地收集教學視頻

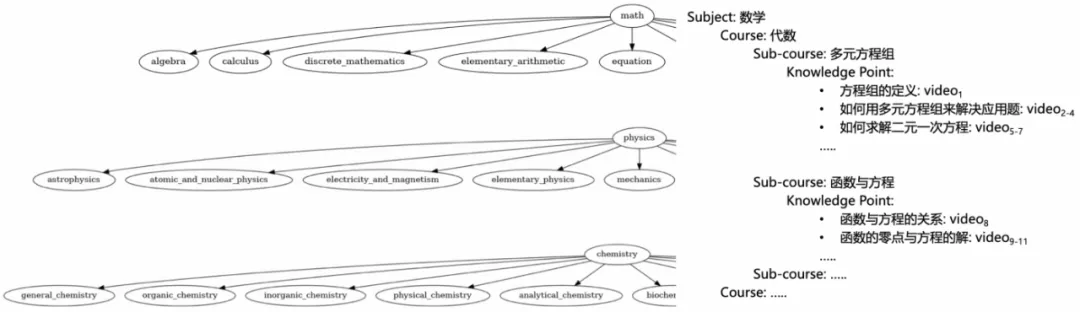

- 知識分類體系的構建:我們創建了一個四層的知識分類體系,包括學科(Subject)、課程(Course)、子課程(Sub-course)和知識點(Knowledge Point),然后使用 LLM 來自動構建這個分類體系。

- 涵蓋數學、物理、化學、地球科學、工程學和計算機科學六大學科,共計 55 門課程,細化為 3915 個知識點。

- 示例:數學(學科) → 小學數學(課程) → 有理數與無理數 (子課程) → 無理數的定義 (知識點)。

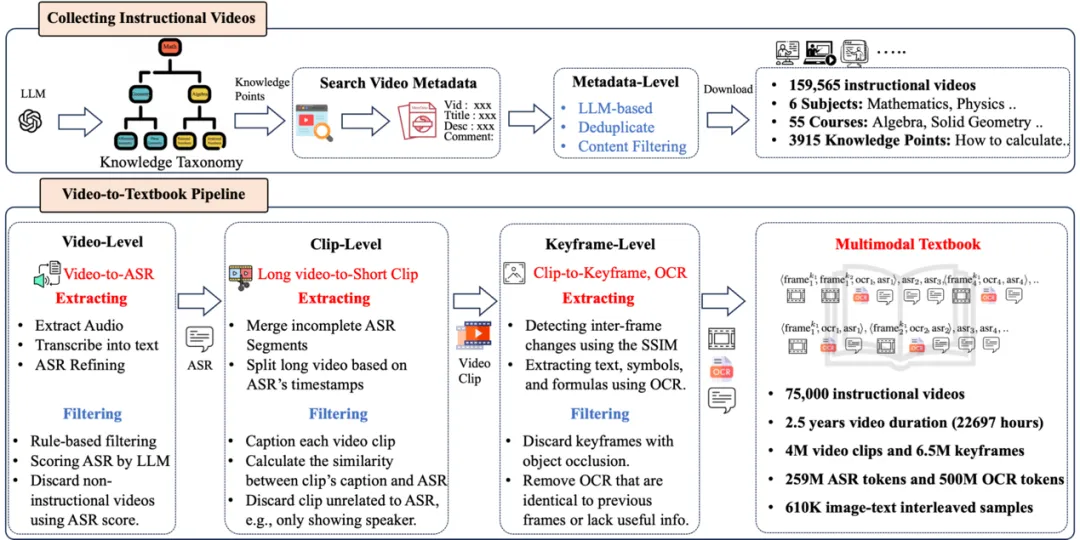

- 教學視頻的收集和過濾:

- 以構建的知識體系中的每個知識點為檢索關鍵詞,利用在線視頻網站 (例如 YouTube) 的 API 搜索相關教學視頻的元數據,每個知識點保留排名靠前的 50 個視頻。然后我們利用 LLM 對所有視頻元數據進行審查 (視頻標題,簡介,評論等),過濾不合適的視頻,并且去除重復的視頻。

2.2 Video-to-Textbook Pipeline

為了將教學視頻轉化為多模態教科書,我們設計了一個多層級的處理流程,包括 video-level、clip-level 和 keyframe-level,確保數據的高質量和知識的密集性。

(1) Long Video-Level

- 音頻提取與轉錄(ASR):使用 FFmpeg 提取音頻,并通過 Whisper 模型進行轉錄,將視頻的講解轉化為文本。

- 轉錄文本質量:由于教程語音的口語化特點,ASR 文本的困惑度(PPL)較高。我們通過 LLM 重寫轉錄文本,提升其流暢性與連貫性,同時保持原始語義不變。

- 視頻質量評估:通過 LLM 對轉錄文本進行分析,按以下標準過濾低質量視頻:

- 相關性:確保轉錄文本與目標知識點匹配,剔除與教學內容無關的視頻(如廣告、綜藝片段)。

- 知識密度:剔除知識點稀疏、包含大量無意義填充詞的視頻,如 “嗯”“然后我們得到這個” 等口語表達。

- 轉錄質量:刪除 Whisper 轉錄質量較低的文本,例如重復、識別錯誤的文本。

最終我們保留了 75,000 個高質量教學視頻和對應的 ASR。

(2)Video Clip-Level

- 視頻分割:為實現文本與幀的時間對齊。我們現合并多個 ASR 片段,形成具有完整語義的句子。然后利用合并后的 ASR 的時間戳將長視頻切分為 10-20 秒的短片段 (video clip),每個 video clip 包含一段語音文本和對應的視頻幀。

- 視覺知識和文本知識匹配:

- 使用 VideoLlama2 為每個 video clip 生成詳細描述 (caption);

- 計算 video clip 的 caption 與 ASR 文本的相似度,剔除視覺內容與文本內容不匹配的片段,或者剔除無信息量的 clips(例如如過渡場景,僅有演講者的畫面或者嚴重遮擋的畫面)。這些 clips 的視覺信息雖然過濾了,但是對應的 ASR 依然保留在 textbook 中。

(3)Keyframe-Level

- 關鍵幀檢測:通過計算連續幀之間的結構相似性( Structural Similarity Index, SSIM),提取視覺變化顯著的幀,迭代式地過濾掉重復或冗余的畫面。

- OCR 文本提取:由于教學視頻中常包含文本、公式和符號等重要知識,我們使用先進的 VLMs(如 InternVL)對關鍵幀進行 OCR,這些內容往往蘊含重要的教學知識,作為 ASR 的補充。

最后,我們將處理后的關鍵幀、OCR 文本和 ASR 轉錄按時間順序排布,交錯組織成多模態教科書。

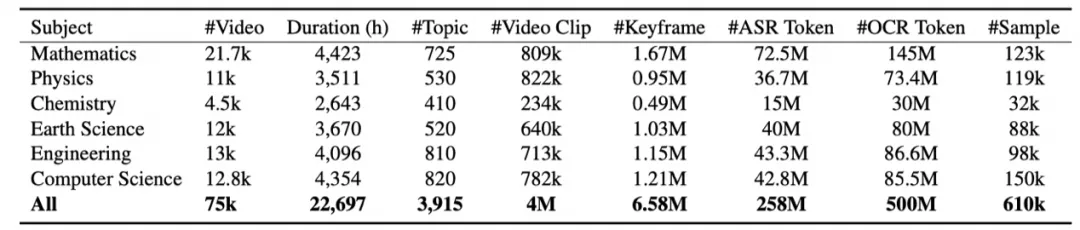

3. 數據集統計和分析

- 教學視頻和知識點統計

我們收集了 15.9 萬個教學視頻,經過元數據審查,去重和 ASR 過濾后保留了 7.5 萬個長視頻,視頻總時長超過 22000 小時 (2.5 年)。這些教學視頻囊括數學,物理,化學,地科,工程,計算機六大學科,3915 個知識點。

- Textbook 統計

經過 video-to-textbook pipeline,我們生成了 6.5M 個關鍵幀、258M ASR tokens 和 500M OCR tokens。我們將其拼接成 610k 個樣本,每個樣本平均包含 10.7 張圖片,1297 個 text tokens。我們觀察到樣本內圖像之間的相似度顯著高于先前的 interleaved dataset,例如 MMC4 和 OBELICS。這體現了我們的 textbook 語料中圖片之間關系更緊密,知識密度更高。

4. 實驗和分析

4.1 實驗設置

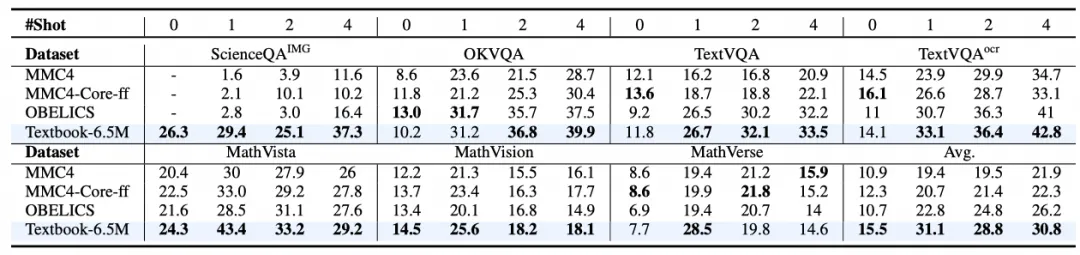

我們使用主流的多模態模型 LLaVA-1.5-7B 和 Idefics2-8B 作為基座模型,對比 textbook 數據集與 webpage-centric interleaved datasets (MMC4 和 OBELICS) 的持續預訓練的效果。

4.2 持續預訓練的實驗效果

模型性能提升顯著:在 Textbook-6.5M 上預訓練后,LLaVA-1.5 和 Idefics-8B 在多個基準上表現出顯著改進。在 0-shot 到 4-shot 設置下,分別提升了 +3.2%、+8.3%、+4.0% 和 +4.6%。即使對于像 Idefics2 這樣的原本支持圖文交織輸入的 VLM,該 textbook 仍帶來了額外 +1.4% 的提升,突出了其豐富的知識內容和高數據質量。

在知識和推理基準上優勢明顯:在知識導向和推理相關基準上,該數據集相比其他數據集改進顯著。例如在 ScienceQA 上,與 MMC4 相比,零樣本和少樣本設置下均有超過 20% 的提升。在 MathVista 等數學相關基準上,與 OBELICS 相比,平均改進 +5.3% 和 +6.4%。

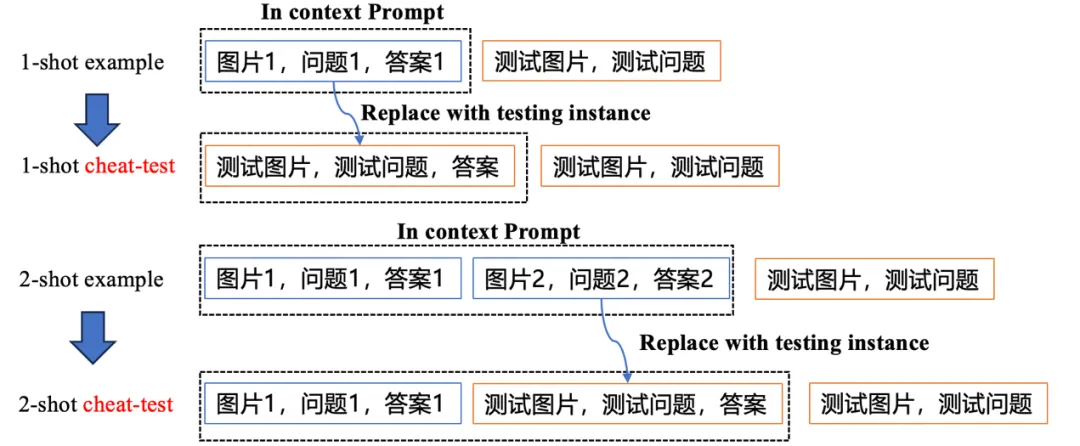

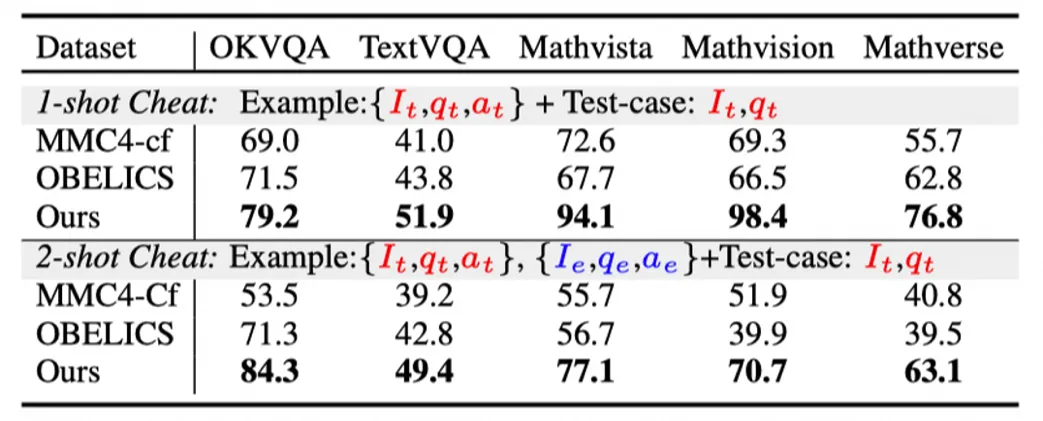

4.3 “作弊測試” 檢驗上下文感知 (in-context awareness) 能力

- 我們設計了一個作弊測試(cheat test) 來測試 VLMs 是否能有效感知圖文交織的上下文。

- Cheat-test: 我們將 few-shot example 中的某個示例替換成測試樣本,觀察模型是否能快速識別 prompt 中的已經包含了測試樣本。

- Cheat-test 顯示在 1-shot 和 2-shot 場景下,相比 MMC4 和 OBELICS,textbook 有近 20% 的顯著優勢。這表明來自視頻的 textbook 訓練語料讓 VLMs 能更關注輸入圖文交織的 context,并且能利用 context 中的線索回答問題。例如在 MathVista 任務中,Textbook 訓練的模型在 1-shot 設置下準確率達到 94.1%,遠超 MMC4 的 72.6%。

4.4 其他實驗

除了上述實驗,作者還研究了數據集中圖像順序的影響,指令微調后下游任務性能,以及一系列的消融實驗。通過這些實驗表明了數據集的高質量。

總結和展望

我們引入了一種多模態教科書來預訓練視覺語言模型,使它們能夠以自然且圖文交織的方式學習專業知識。通過收集海量的在線教育視頻并將其轉換為關鍵幀 - 自動語音識別(ASR)交錯數據集,這本教科書提供了一個更加連貫且相互關聯的學習語境,補充了傳統的圖像 - 文本對齊方法。實驗證明了其有效性,特別是在 VLMs 的上下文感知和數學推理等方面。此外,這些 textbook 語料不僅僅可以用來做多模態的理解,未來還可以探索利用它們實現任意模態的連續生成,實現更好的世界模型。

作者介紹

本文一作是張文祺 (浙江大學博士生),他的研究基礎是基于大模型智能體,多模態模型等,開發了數據分析智能體 Data-Copilot,在 github 上獲得超過 1400 stars。共同通訊包括魯偉明 (浙江大學副教授),李昕(阿里巴巴達摩院算法工程師),其中李昕和張航(本文二作)主導開發了 VideoLlama 系列視頻理解模型。其他作者包括浙江大學莊越挺教授,趙德麗(阿里巴巴達摩院基礎智能中心主管), 邴立東(達摩院語言技術實驗室主管),沈永亮(浙大百人計劃研究員),孫嘉碩 (達摩院算法工程師)。