推理模型規劃任務成功率從5%到95%,DeepMind遺傳算法新研究火了

瞄準推理時擴展(Inference-time scaling),DeepMind新的進化搜索策略火了!

所提出的“Mind Evolution”(思維進化),能夠優化大語言模型(LLMs)在規劃和推理中的響應。

由于提升顯著,Reddit/??一時間出現了大量討論:

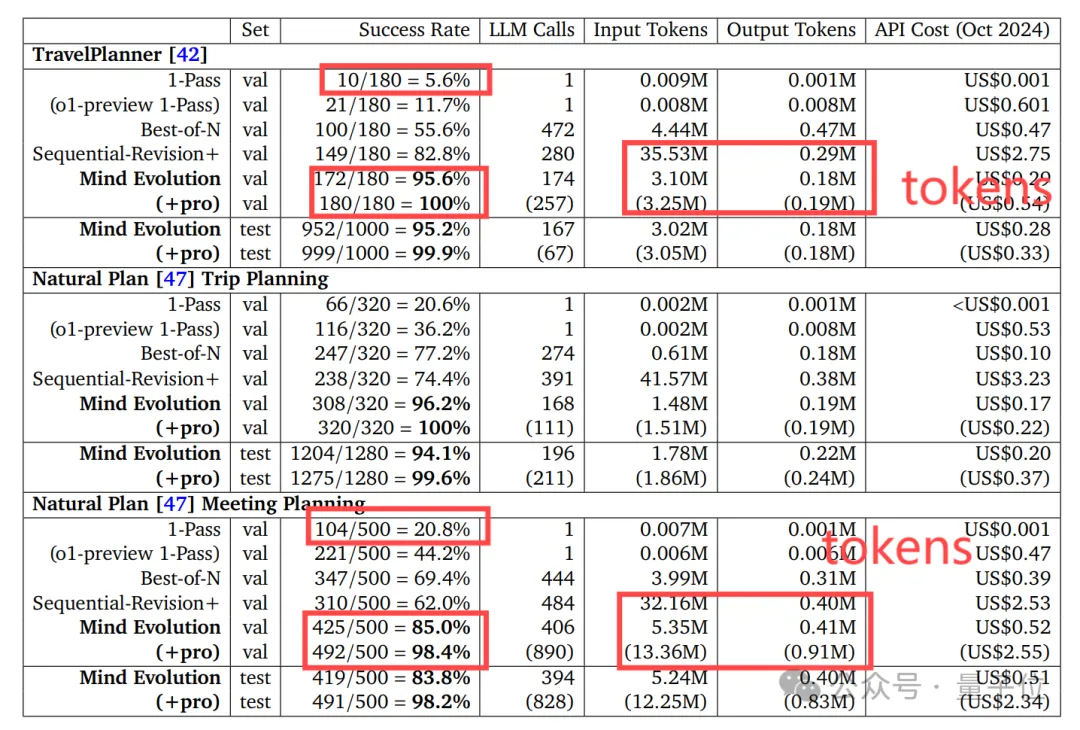

由于結合了遺傳算法,使用Mind Evolution能讓Gemini 1.5 Flash任務成功率從原本的5%左右,一下提升90個百分點。

而且成本方面,和最接近這一性能的傳統方法Sequential-Revision+相比,所使用的tokens數量僅為后者的幾分之一。

響應更好,成本還降低了,還是無需微調的結果。

這令人熟悉的配方又直接“迷倒”了一大片網友:

與此同時,Mind Evolution還有一大優勢也令人津津樂道:

它可以直接處理自然語言問題,而無需像傳統一樣需要將任務問題進一步形式化(即將實際問題轉化為精確的、可被算法處理的數學或邏輯形式)。

也就是說,僅需一個最終檢查解決方案是否正確的評估器,任務形式化也不需要了。

將問題形式化,需要大量領域專業知識和對問題的透徹理解,才能找出所有需用符號表示的關鍵元素及其關系,這大大限制了Inference-time scaling的適用范圍。

總之按網友形容,這項研究就像給大語言模型升級大腦而不刷爆信用卡,酷酷酷!!

下面來看具體是如何做到的。

結合了進化搜索原理和LLMs的自然語言能力

首先,OpenAI的o1系列模型率先引入了推理時擴展(inference-time scaling)的概念,通過增加思維鏈(Chain-of-Thought)推理過程的長度,在數學、編程、科學推理等任務上取得了顯著的性能提升。

換句話說,通過讓模型思考更多、更深,其響應也會越來越好。

而為了更多利用推理時擴展,先前研究還提出了自一致性(self-consistency)、基于反饋的順序修正(如Sequential-Revision +),以及由輔助驗證器或評估器引導的搜索(如Best-of-N)。

基于同樣目的,DeepMind提出了Mind Evolution這一針對LLMs的新進化搜索策略。

結合了進化搜索原理與LLMs的自然語言能力,既允許對可能的解決方案進行廣泛探索,也允許對有希望的候選方案進行深入細化。

具體而言,Mind Evolution依賴于兩個關鍵組件:搜索算法和遺傳算法。

搜索算法比較常見,一般用來讓LLMs找到最佳推理路徑以獲得最優解;而遺傳算法結合大語言模型,在自然語言處理任務中,通過迭代優化候選解決方案,以更好地滿足任務目標。

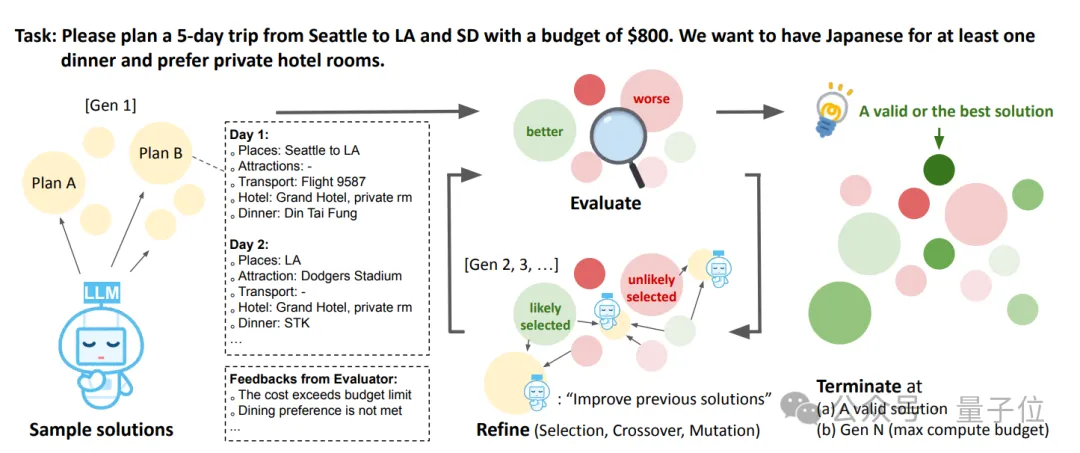

舉個例子,假如面臨上圖中的任務:

請計劃從西雅圖到洛杉磯和南達科他州的5天旅行,預算為800美元。我們希望至少有一頓晚餐吃日本料理,并且偏好入住私人酒店客房。

Mind Evolution整體處理流程如下(類似遺傳算法):

- 樣本解決方案生成(Sample solutions):使用LLMs生成多個初始旅行計劃;

- 評估(Evaluate):對生成的解決方案給出反饋,指出問題,如成本超出預算限制、用餐偏好未滿足等;

- 改進(Refine,包括選擇、交叉、變異):根據評估反饋,對解決方案進行改進;

- 終止條件(Terminate):當滿足以下條件之一時終止,如找到有效或最佳解決方案,或達到最大計算預算(Gen N)。

這里尤其需要提到改進過程,其中選擇是指依據評估反饋,選擇更有可能改進的解決方案;交叉指將不同解決方案的部分內容進行組合,實現類似生物基因重組的效果,生成新的候選解決方案;變異是指對解決方案進行隨機調整,增加種群多樣性,以探索更多可能的解決方案。

最終,評估、選擇和重組的循環將持續進行,直到算法達到最優解或耗盡預設的迭代次數。

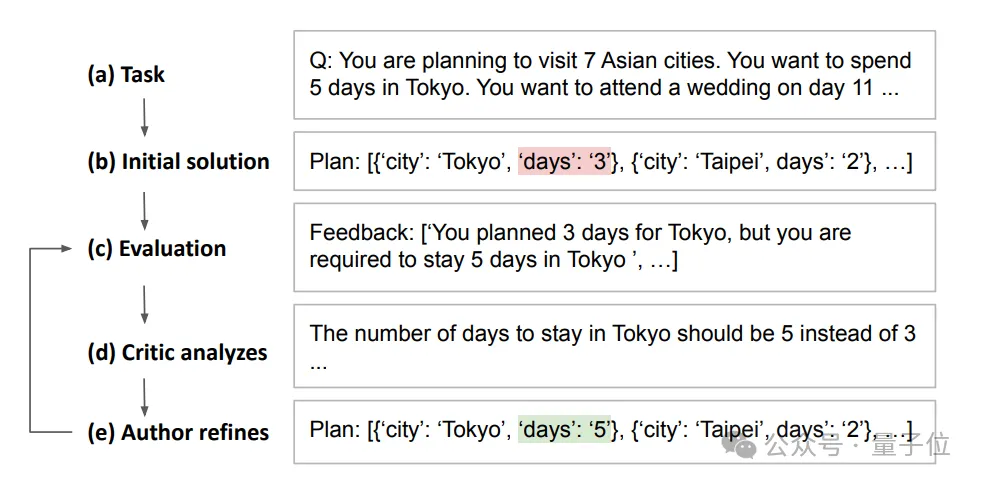

另外值得一提的是,Mind Evolution具體是通過“The fitness function”(適應度函數)來消除任務形式化問題。

簡單說,適應度函數適配自然語言規劃任務,解決方案以自然語言呈現。

如此一來,在有程序性解決方案評估器時,系統可規避問題形式化,并且除給出數值評分外,還能提供文本反饋,幫助LLMs理解具體問題并開展針對性優化。

此外,Mind Evolution還采用“island”(島嶼)方法來確保多樣化探索。

在每一個階段,算法都會創建各自獨立進化的解決方案組。然后,它將最優解從一組“遷移”到另一組,以結合并創造新的解決方案。

那么,Mind Evolution實際表現如何呢?

規劃表現均優于其他基線方法

實驗階段,研究人員將它和其他基線進行了對比。

- 1-pass:使用o1-preview,模型只生成一個答案;

- Best-of-N,模型生成多個答案并選擇最佳答案;

- Sequential Revisions+:模型獨立提出10個候選解決方案,然后分別對80次迭代進行修訂。

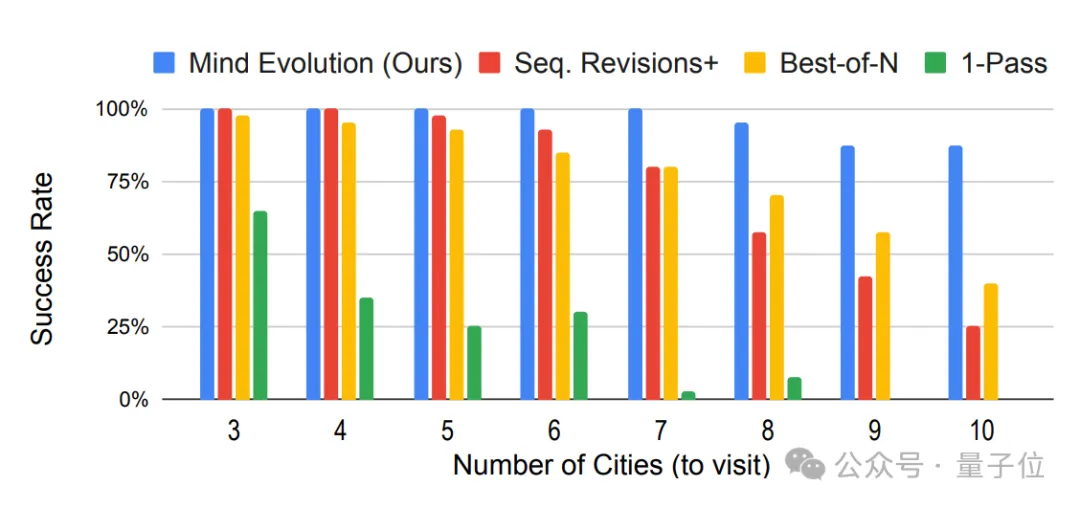

可以看出,盡管缺少遺傳算法組件,Sequential Revisions+在旅行規劃上的成功率最為接近Mind Evolution。

不過隨著從左至右任務復雜性的增加,Mind Evolution與其他方法之間的差距越來越大,優勢愈發凸顯。

整體來看,在所有測試中,Mind Evolution的表現都遠遠超過了基線,尤其是在任務變得更加困難時。

在TravelPlanner(評估旅行規劃)和Natural Plan(評估會議規劃)這兩項基準測試中,未采用Mind Evolution的Gemini 1.5 Flash任務成功率分別為5.6%和20.8%,而采用Mind Evolution之后,其任務成功率分別提升至95.6%和85.0%。

而且,如果繼續將Gemini 1.5 Flash未解決的問題丟給1.5Pro,其成功率更是上升至100%和98.4%。

另外成本方面,和最接近上述性能的傳統方法Sequential-Revision+相比,所使用的tokens數量僅為后者的幾分之一。

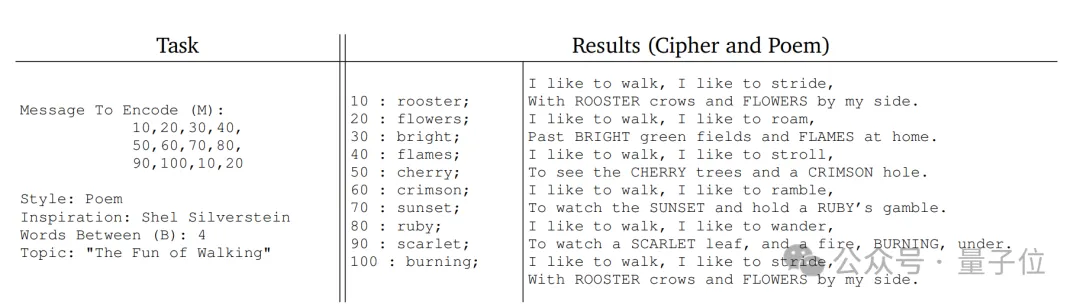

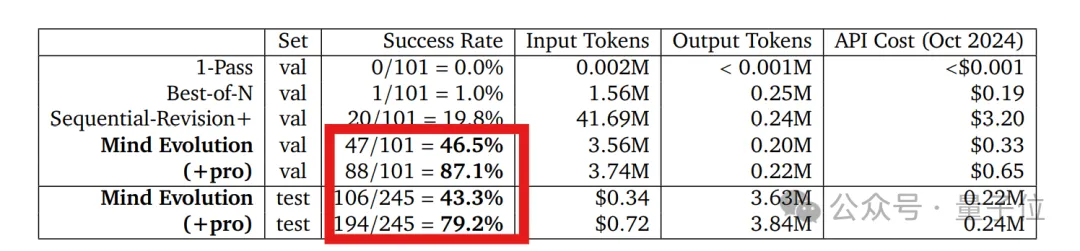

除此之外,研究人員引入了一項新測試任務——StegPoet。

需要在創意寫作中嵌入隱寫信息,屬于自然語言規劃任務范疇。

簡單說,它要求在創作富有創意的文本內容時,還要將特定的信息以隱寫的方式巧妙融入其中,這既需要邏輯推理能力,也對LLMs在創造性表達方面的能力提出了更高要求。

而從相關實驗來看,Mind Evolution也經受住了這一復雜任務的考驗。

總體來說,這項研究通過將廣泛搜索(隨機探索)與深度搜索(利用LLM進行解決方案細化)相結合,進一步提升了模型在規劃和推理上的響應。

更多細節歡迎查閱原論文。

論文:https://arxiv.org/abs/2501.09891