六大維度,LLM「問題生成」首次正面PK人類!伯克利等發布最新研究

長期以來,問題生成(Question Generation)任務都是根據「給定事實」來編寫各種相關問題,已經發展出了很多自動化的方法。

大型語言模型(LLM)的興起,極大提升了各種自然語言處理(NLP)任務的性能,其中也包括問題生成,雖然應用廣泛,但還沒有研究討論過「用LLMs生成問題的特點」。

沒有額外提示約束時,LLMs是更傾向于生成較長還是較短的問題?傾向于問什么類型的問題?LLMs生成的問題與人類編寫的問題又有哪些不同?

最近,加州大學伯克利分校、阿卜杜勒阿齊茲國王科技城、華盛頓大學的研究人員提出了一種基于LLMs的自動化評估方法,重點關注問題的長度、類型、上下文覆蓋范圍和可回答性等維度,結果發現LLMs傾向于生成需要描述性、較長答案的問題;

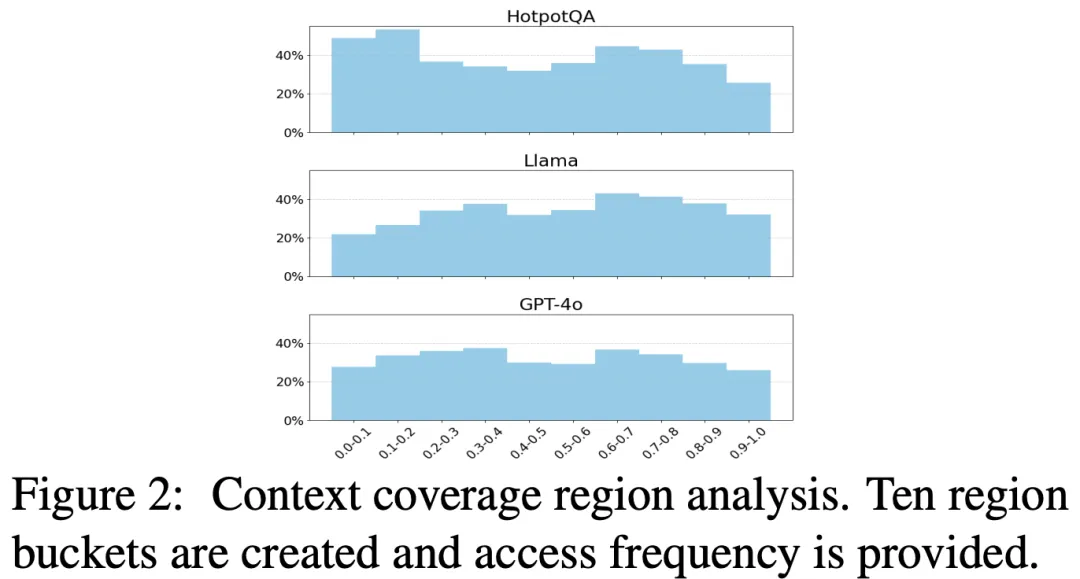

常見的問答任務中,人類更傾向于選擇文章的開始結束位置生成問題,LLMs對整個上下文的關注更加均衡。

論文鏈接:https://arxiv.org/pdf/2501.03491

雖然已經有研究通過實證來評估人類一致性,但還沒有將LLMs生成問題的質量標準與人類生成問題進行對比。

這篇文章首次揭示了LLMs在問題生成中的偏好,通過引入自動評估流程,擴展了現有的統計問題質量標準,研究發現為評估下游應用(如RAG系統和幻覺檢測)的提示工程優化提供了經驗,可以防止在不當情境下的濫用,更深入地了解LLMs在問題生成中的行為傾向。

生成流程與指標

從上下文中生成問題

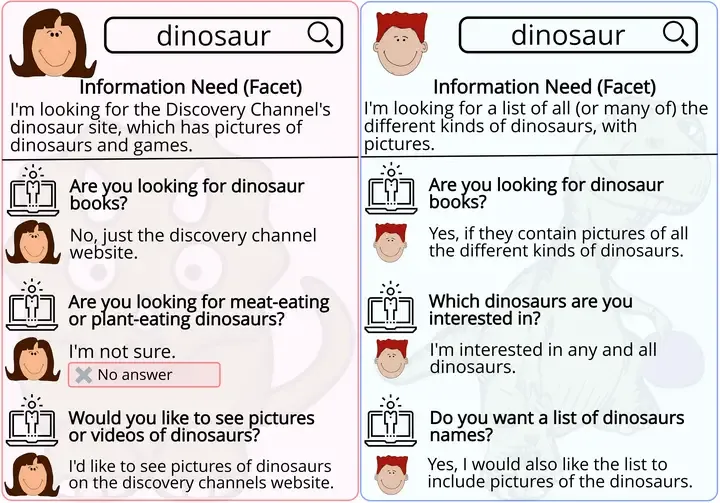

問題的輸入包括:一個段落文本作為上下文C,一個問題生成指令提示P;大模型M的輸出為N個問題Q,其中每個問題都可以用上下文中的事實來回答。

不能直接使用LLM進行問題生成:問題假定讀者對上下文的某個特定范圍很熟悉;生成的問題可能沒有標準答案;有些問題直接引用了上下文,如果沒有上下文就無法回答。

所以研究人員設計了一段提示詞:

You are to generate [N] self-contained short answer questions based on the facts mentioned in the following content. Avoid questions that reference the content directly. Each question should include all relevant context and directly name any referenced items, avoiding pronouns like "it," "the game," or "the person." Do not include phrases that reference the source or context, such as "mentioned in the article" or "according to the text." Provide the questions in an ordered list.

你需要根據以下內容中提到的事實生成[N]個自成一體的簡短答案問題。避免直接引用內容的問題。每個問題都應包含所有相關的上下文,并直接提及任何被引用的項目,避免使用「它」「這款游戲」或「這個人」等代詞。不要包含引用來源或上下文的短語,如「文章中提到的」或「根據文本」。將問題以有序列表的形式提供。

為了構建上下文C,研究人員將WikiText數據集分割成86萬個段落,同時保留章節結構作為元數據;在過濾掉過短的段落并清理特殊字符后,通過整合段落文本并附加相關章節標題來組成上下文。

該流程類似于HotpotQA的先上下文后問題的方法,眾包人員根據維基百科的多個證據段落生成問題;作為對比,TriviaQA是一個由知識競賽愛好者編纂的問答數據集,標注人員根據問題在文章中尋找證據。

與答案無關的評估指標

問題類型

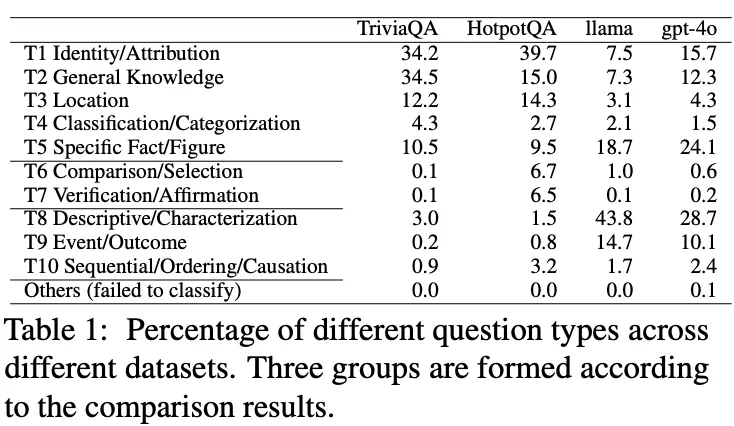

對于人類來說,選擇提出哪種問題是主觀的,研究人員探索了在沒有額外約束的情況下LLMs能夠生成的問題類型,分析了十個手動定義類別的問題類型(通過觀察HotpotQA、TriviaQA和論文數據集中的混合問題得到),并將其與人類的偏好進行比較。

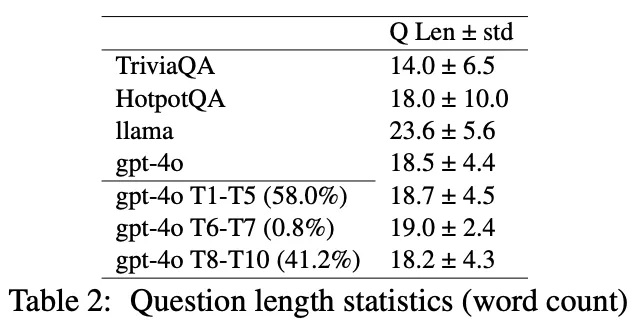

問題長度

長度是生成問題的一個直觀統計指標,研究人員主要統計單詞數量;除了直接比較人類生成和LLMs生成數據集中的問題長度外,還考察了問題長度與問題類型之間的關系。

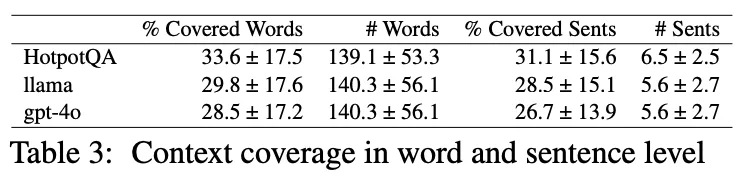

上下文覆蓋范圍

一個問題可能需要跨多個句子進行推理,研究人員擴展了基于提示的句子級測量方法,還研究了單詞級上下文覆蓋范圍;分析了在生成過程中LLMs傾向于關注上下文的哪些具體部分。

結果可以看到,問題生成并不遵循之前研究中討論問答中的類似位置偏差。

與答案有關的評估指標

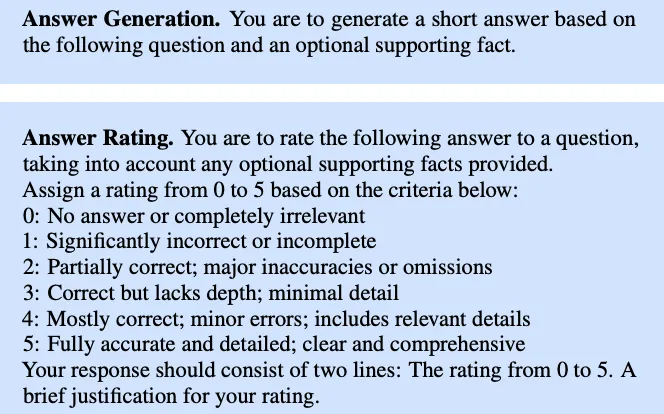

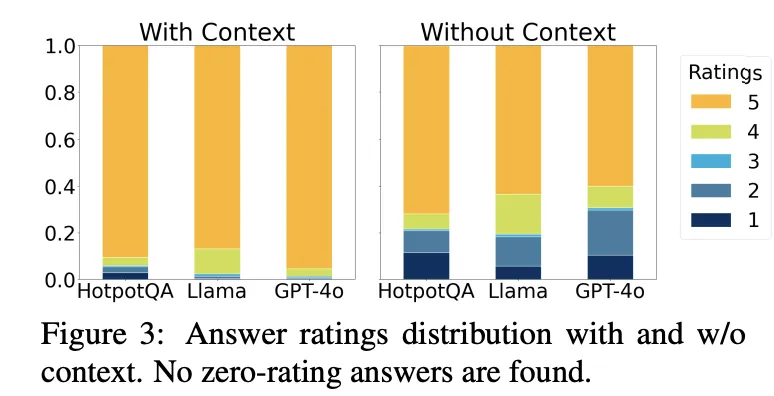

可回答性(Answerability)

問題的關鍵質量標準是,在給定特定知識的情況下,是否能夠被精確回答,即在提供上下文時,生成的問題應該是可回答的。

研究人員提示LLMs使用給定的上下文作為輸入來生成答案;由于答案的正確性也是基于相同的上下文來評估的,因此在大多數情況下,生成的問題都是可回答的。

非常見性(Uncommonness)

LLMs的預訓練數據基于互聯網上廣泛可用的常識,即使沒有明確提供上下文,LLMs仍然可能回答問題。

與可回答性評估相比,關鍵區別在于在答案生成過程中省略了上下文,而其他因素保持不變;結果也可以看到,去除上下文會顯著降低答案質量,也表明,生成的問題對于評估RAG系統或進行自動幻覺測試很有價值。

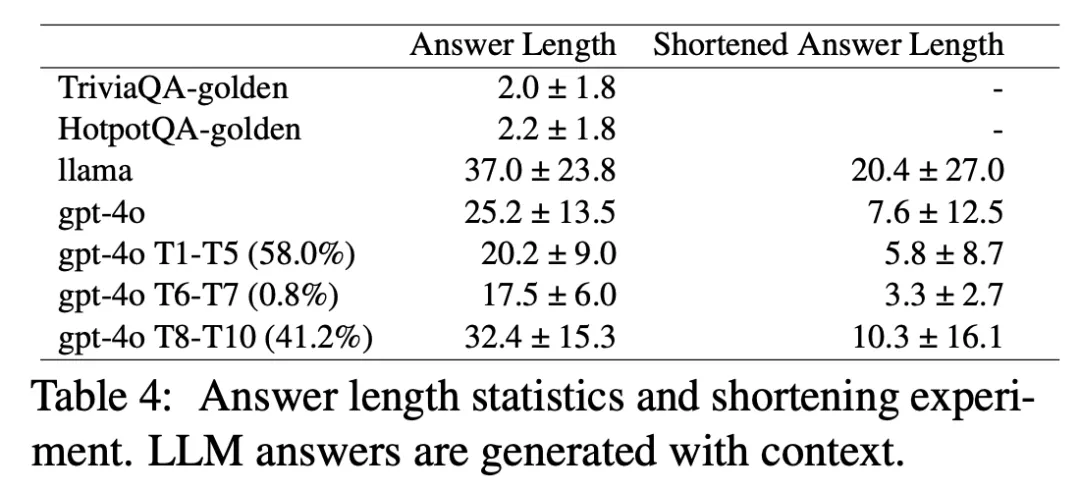

所需答案長度(Required answer length)

除了問題長度外,所需答案的長度也是衡量問題信息量的有效的指標。

由于生成模型的特性,生成的答案往往更長,包含更多細節;為了從帶有上下文生成的答案中篩選出不必要的信息,研究人員使用了兩種策略來測量答案的基本長度:1)要求模型生成的文字答案最短;2)設置生成字數限制。

結果顯示,該方法可以用更少的字數實現相同的質量評級,并顯著降低答案長度,第二種策略通常來說更好。

實驗結果

研究人員使用兩個具有代表性的大型語言模型(LLMs)進行評估:閉源的GPT-4o和開源的LLaMA-3.1-70b-Instruct,每個模型都使用相同的256個采樣的維基百科上下文(N=4)生成1024個問題;大約使用了5萬次聊天調用。

在答案評分方面,人工標注與GPT-4o評估之間的平均皮爾遜相關系數為0.77,表明存在很強的正線性相關性。

LLMs會提什么類型的問題?

根據預定義的問題類型,研究人員將其分為三組:LLaMA和GPT模型都強烈傾向于詢問具體的事實和數字,可能與訓練數據的分布有關;不太容易提出的問題是根據上下文中的多個事實進行推理,與HotpotQA更相似;大模型也更傾向于詢問描述類、需要詳細答案的問題,這種偏好也導致了答案更長。

生成的問題有多長?

盡管整體的問題長度大致相似,約為20個單詞,但不同的LLMs傾向于表現出對長度的不同偏好;人類生成的問題長度變化更大。

使用了多少上下文以及具體是哪部分?

人類生成的問題傾向于覆蓋更多的上下文,無論是句子級還是單詞級測量結果都是一致的。

人類生成的問題傾向于集中在上下文的開頭,但LLMs生成的問題呈現出更均衡的分布,表明基于LLMs的問題生成與問答相比顯示出幾乎相反的位置關注焦點。

生成的問題是否可以在有/無上下文的情況下回答?

通過結合答案生成和評分,可以觀察到,在有上下文的情況下,LLMs通常能生成令人滿意的答案,符合預期。

當不提供上下文時,性能會下降,大約四分之一的生成問題無法得到合適的回答,GPT-4o生成的問題與人類構建的HotpotQA數據集相比,顯示出更高比例的非常見問題。

回答問題需要多少信息?

LLMs生成的答案通常比人類標注的正確答案要長得多,可能是因為生成模型的特性。

為了更準確地衡量所需信息量,將LLMs生成的答案壓縮,在保持評分的情況下生成最短版本。