MetaDiff:用擴散模型重塑元學習,攻克小樣本學習瓶頸!

1. 一眼概覽

MetaDiff 提出了一種基于條件擴散模型的創新元學習方法,通過將梯度下降優化建模為去噪過程,有效提升了小樣本學習(FSL)的性能,顯著減少了內循環優化中的內存負擔和梯度消失風險。

2. 核心問題

小樣本學習的主要挑戰在于:如何在訓練數據有限的情況下快速適應新任務,而不引入過擬合或內存瓶頸。傳統基于梯度的元學習方法需要計算內循環路徑上的二階導數,導致內存消耗高和梯度消失問題,從而影響性能。

3. 技術亮點

1. 創新建模:首次揭示梯度下降算法與擴散模型之間的密切聯系,提出將梯度下降建模為擴散去噪過程;

2. 條件擴散元學習:設計了基于條件擴散模型的元學習框架,通過噪聲預測優化任務特定權重;

3. 高效性與魯棒性:避免內循環路徑的反向傳播,大幅降低內存開銷,提升小樣本學習的效率和穩定性。

4. 方法框架

MetaDiff 的核心流程如下:

- 特征編碼:通過共享的嵌入網絡將支持集和查詢集樣本編碼為特征向量;

- 噪聲初始化:為任務特定的基礎分類器隨機初始化權重;

- 擴散去噪:通過任務條件 UNet,逐步去除權重中的噪聲,優化至目標權重;

- 分類預測:利用優化后的基礎分類器對查詢集樣本進行分類。

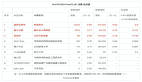

5. 實驗結果速覽

在 MiniImagenet 和 TieredImagenet 數據集上的實驗結果顯示,MetaDiff 超越了多種最先進的基于梯度的元學習方法:

? 在 5-way 1-shot 設置中,MetaDiff 的準確率提升了 1%-3%;

? GPU 內存占用在增加內循環步數時保持不變,相比傳統方法顯著降低。

6. 實用價值與應用

MetaDiff 的優勢在于其通用性和高效性,適用于小樣本場景的快速學習任務,如醫學影像分析、冷啟動推薦系統等。其擴展潛力包括其他優化算法的建模和低資源領域的應用。

7. 開放問題

? MetaDiff 能否擴展至處理多模態數據的小樣本學習?

? 在梯度計算較復雜的場景中,MetaDiff 的條件 UNet 是否需要進一步優化?