閑來無事,我測了測國產大模型的RAG能力

最近,AI界被推理模型刷屏了。

國內各家的推理模型,在新年到來之際不斷刷新我們的認知。不過,當我們在實際應用中考量大模型,衡量好不好用的標準,就絕不僅僅局限于其性能和規模了。

尤其是對于那些請求復雜、專業性強,以及一些小眾的長尾需求,此時單純的大模型并不是最優解。而大模型和搜索的聯合優化,就成了提升系統實際效能的關鍵,尤其是在中文互聯網、企業服務、政務醫療等場景中。

在未來,AI系統將絕不僅僅是單純的大模型,而是推理模型與搜索的深度結合而成的多元復雜系統。

所以,在當今的國產大模型選手中,誰在實際搜索中的表現最優,能為用戶提供最精準的個性化服務呢?

接下來,讓我們呈上各種足夠難度、足夠刁鉆的問題,讓它們開展一場實測大pk!

國產大模型,誰最懂我?

首先,對于大模型來說最為基礎一個要求——理解用戶到底想問什么。

用戶意圖

問題一:傅里葉變化的時候,函數應該具有頻率、相位、幅度三個重要參數,為什么其中的相位在頻域圖上是沒有的。

在這個問題上,模型A首先解釋了什么是「頻域圖」——通常是指幅度譜或功率譜,以及題干中提到的三個重要參數的含義。

隨后解釋道:「相位涉及到信號中不同頻率成分之間的時間延遲或超前關系,這種關系在二維的幅度譜圖中難以直接表示。」

回答正確。

模型B雖然講了傅里葉變換的原理、頻域圖的常規表示方法,以及相位信息的重要性,但沒有解答用戶的核心訴求——為什么頻域圖上沒有相位。

回答錯誤。

模型C從相位信息的復雜性、幅度信息的直觀性等方面進行分析之后,得出結論「由于其復雜性和計算誤差,以及頻域圖的簡化需求,相位信息通常不會在頻域圖中直接展示」。

回答正確。

事實性/時效性

其次,同樣也是對模型最為基礎的要求之一——答案給的對不對。

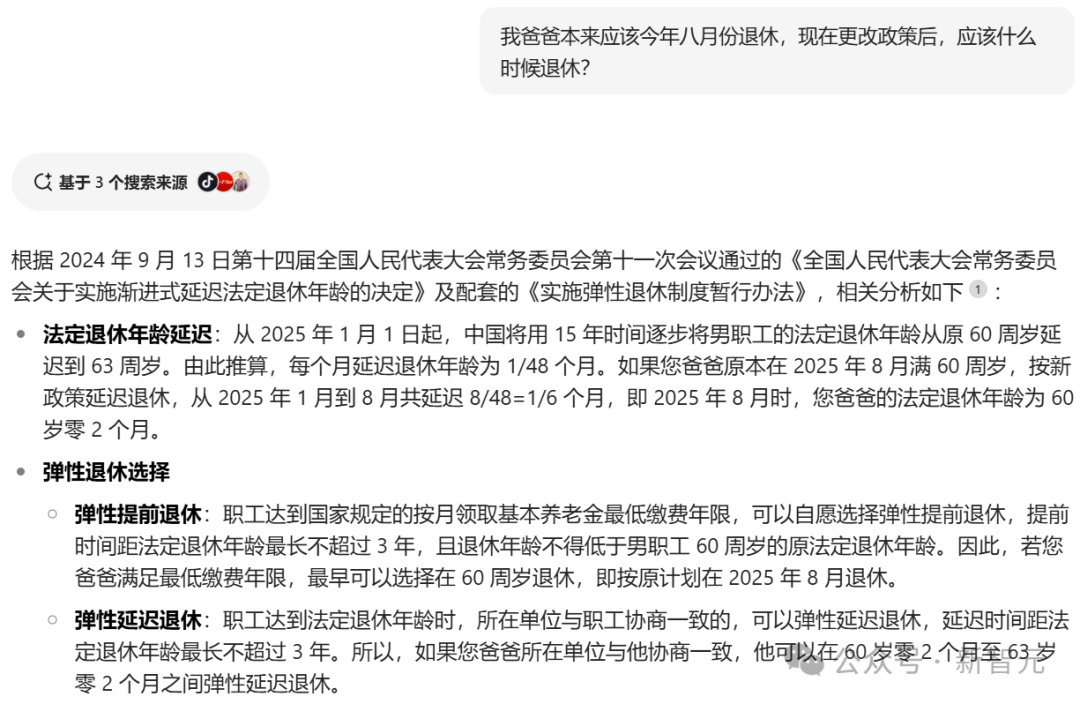

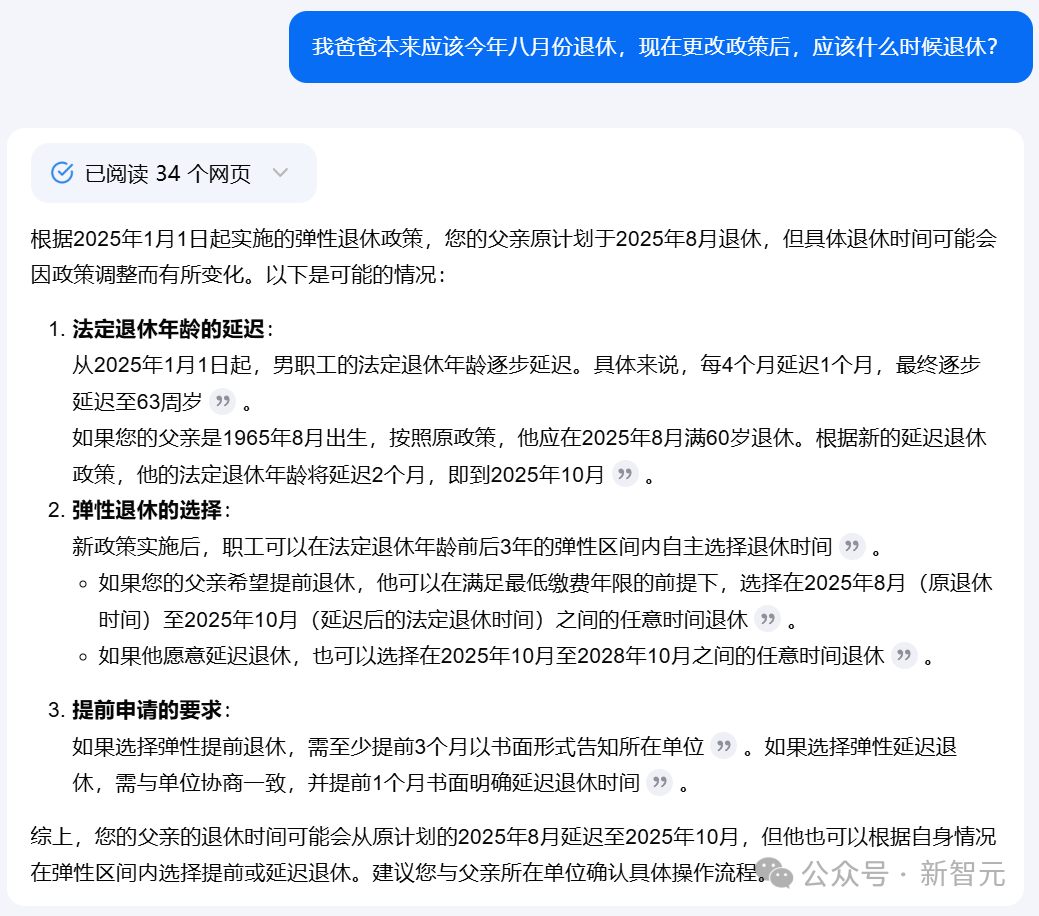

問題二:我爸爸本來應該今年八月份退休,現在更改政策后,應該什么時候退休?

在這道題中,模型不僅要找到對應的新政策,而且還需要理解其中的內容并根據用戶的需求進行推理。

可以看到,模型A先是列出了政策中的規定,并在一番計算之后,給出正確的時間——2025年10月。

甚至還貼心地給出了一些注意事項。

相比之下,模型B的推斷過程含糊不清,并且也沒有給出正確的答案。

模型C的過程清晰,回答正確。

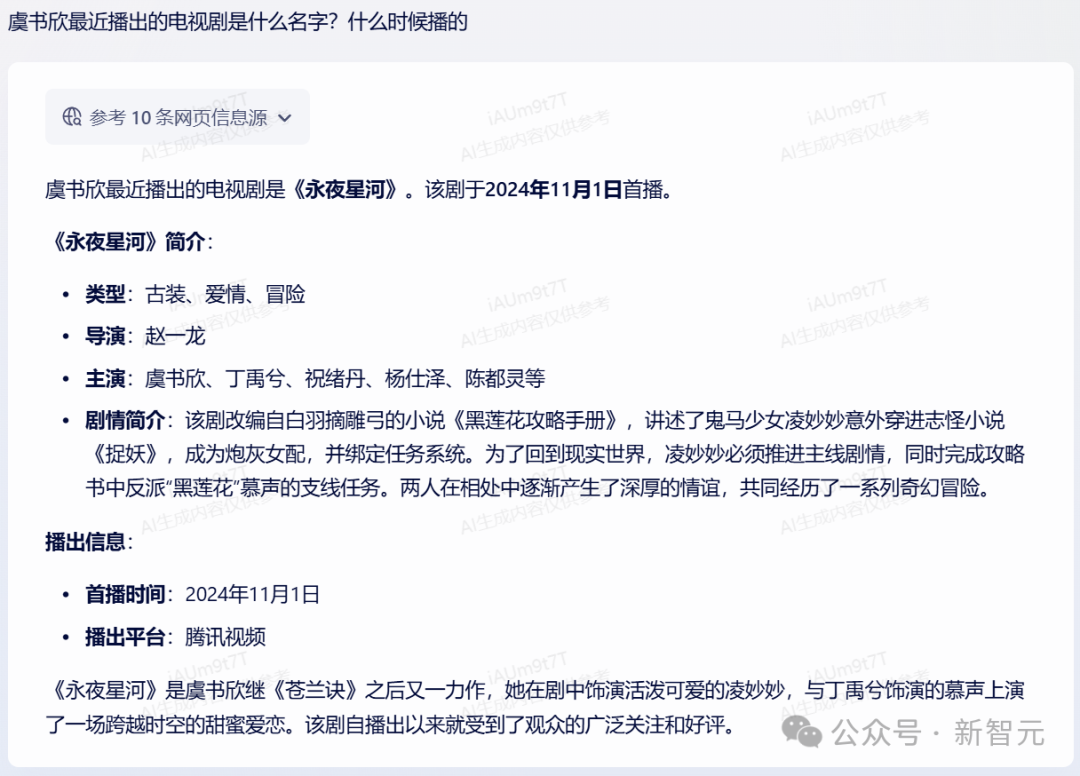

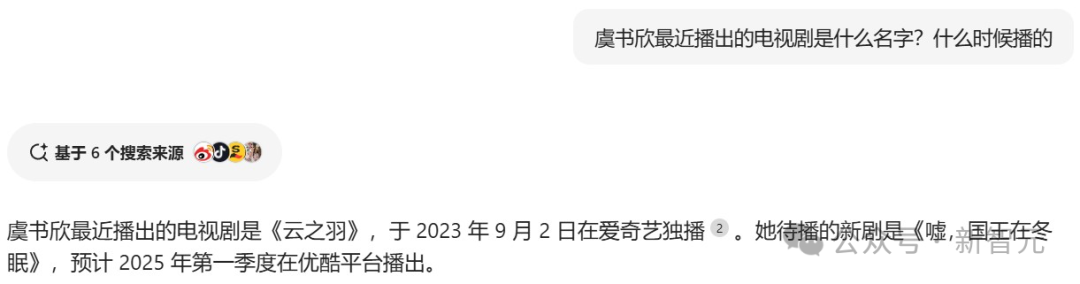

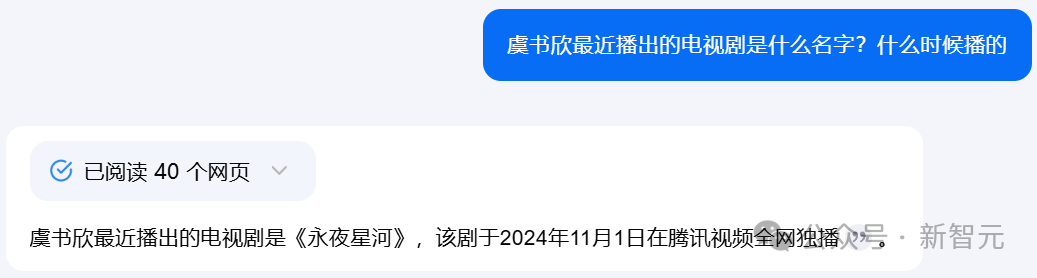

問題三:虞書欣最近播出的電視劇是什么名字?什么時候播的

再來一個更具時效性的考驗。

模型A既答對了作品名稱和播出時間,也對劇情進行了介紹。

模型B的回答還停留在2023年,時效性差了一些。

模型C給出了正確的作品和時間,但沒有加入相關介紹,內容豐富度稍弱。

專業性/豐富性

除了一些簡單的查詢之外,我們在實際應用中,往往會遇到更多涉及現實細節的問題。

這時候我們所期待的,就不止是粗略的呈現,而是模型在提供基礎答案的前提下,能具備更有價值的增益信息。

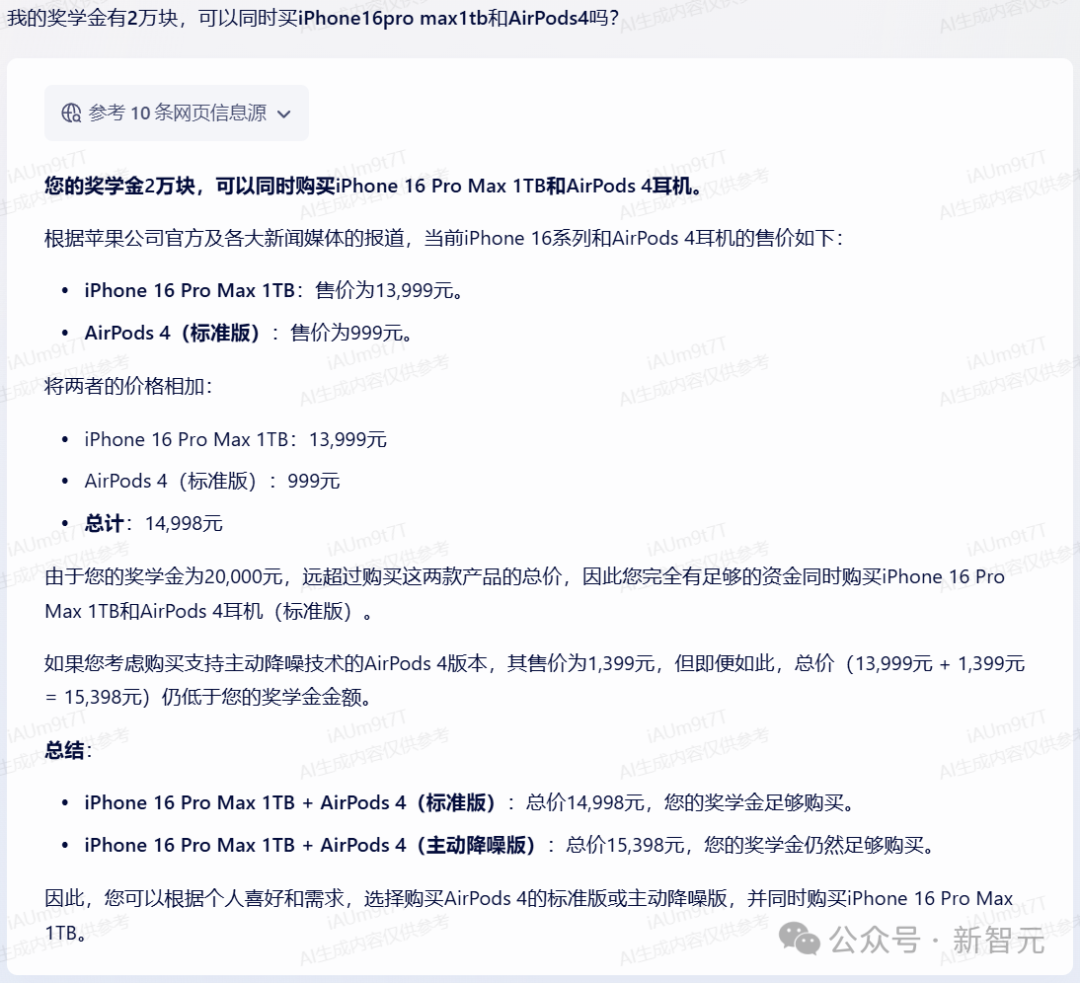

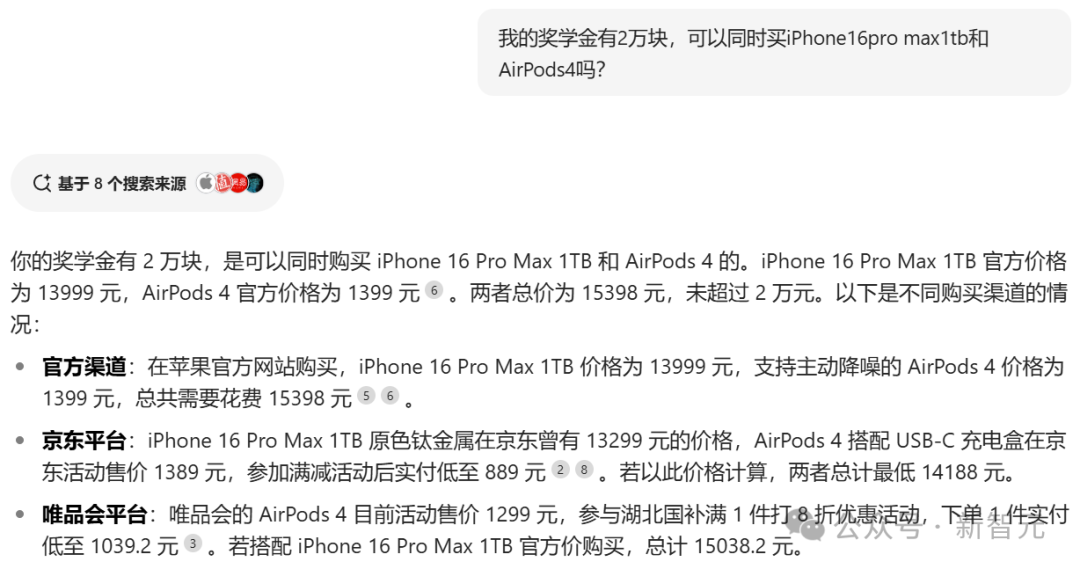

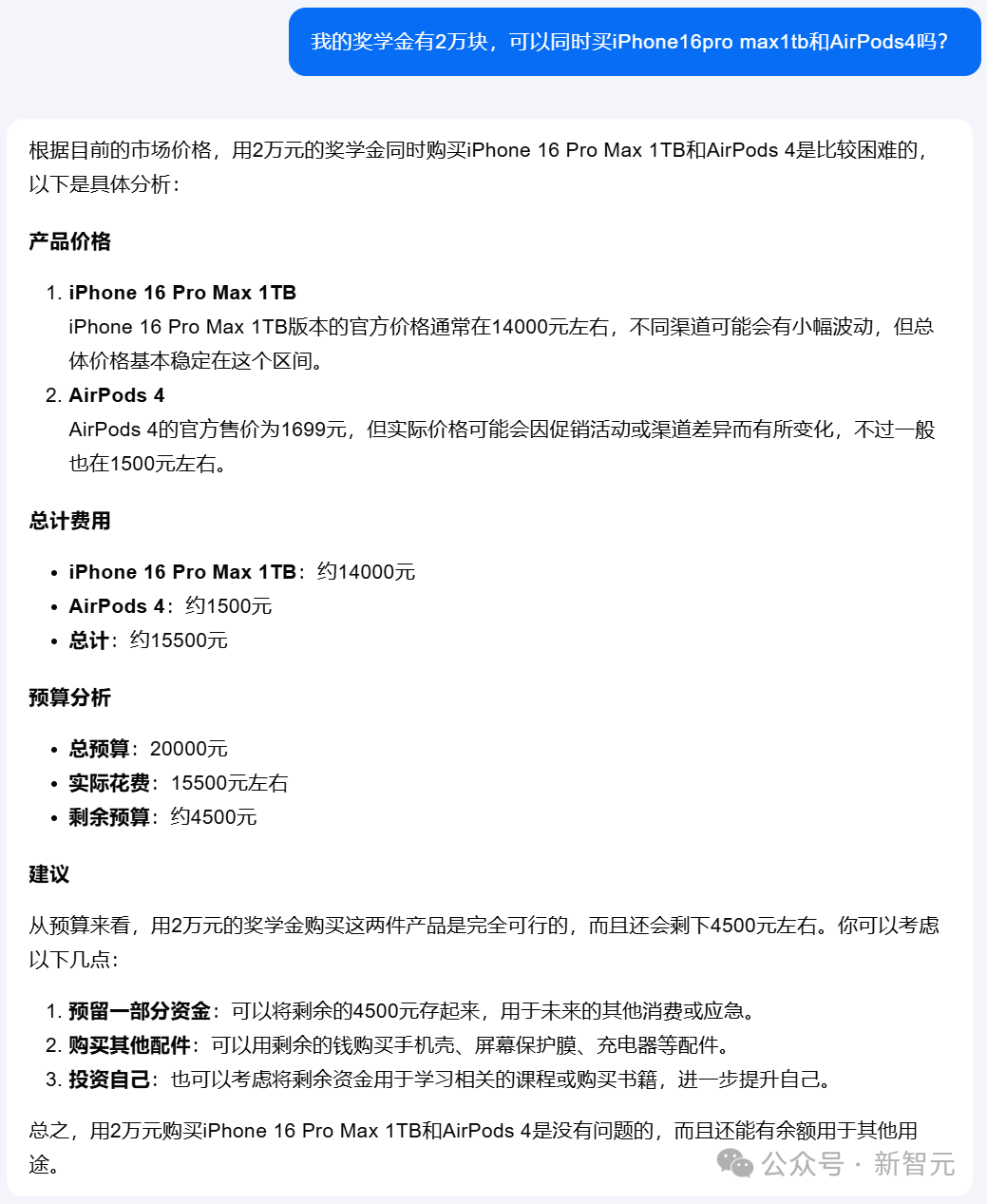

問題四:我的獎學金有2萬塊,可以同時買iPhone16pro max1tb和AirPods4嗎?

模型A在一番檢索之后發現AirPods 4有兩個版本,于是分別計算出了對應的總價。

相比之下, 模型B則只給出了標準版的價格。

而模型C,甚至給出了前后矛盾的答案——開篇說同時購買是「比較困難」的,文末又改口說是「沒有問題」的。

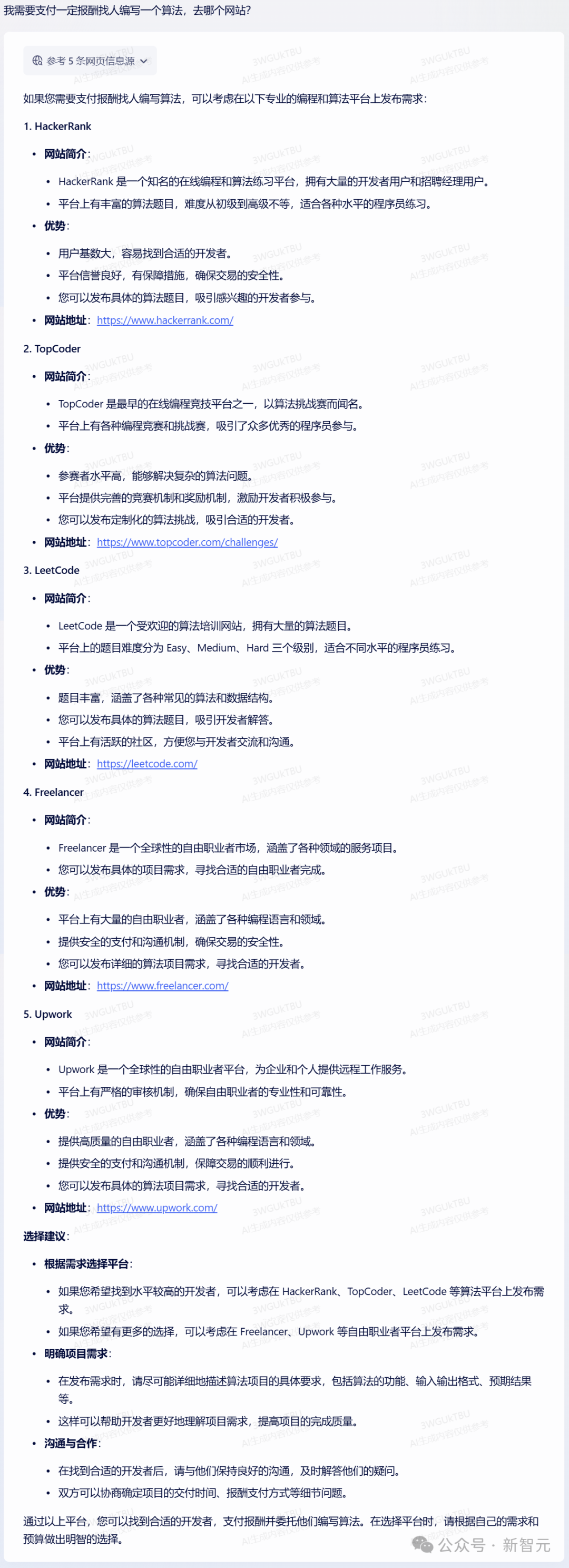

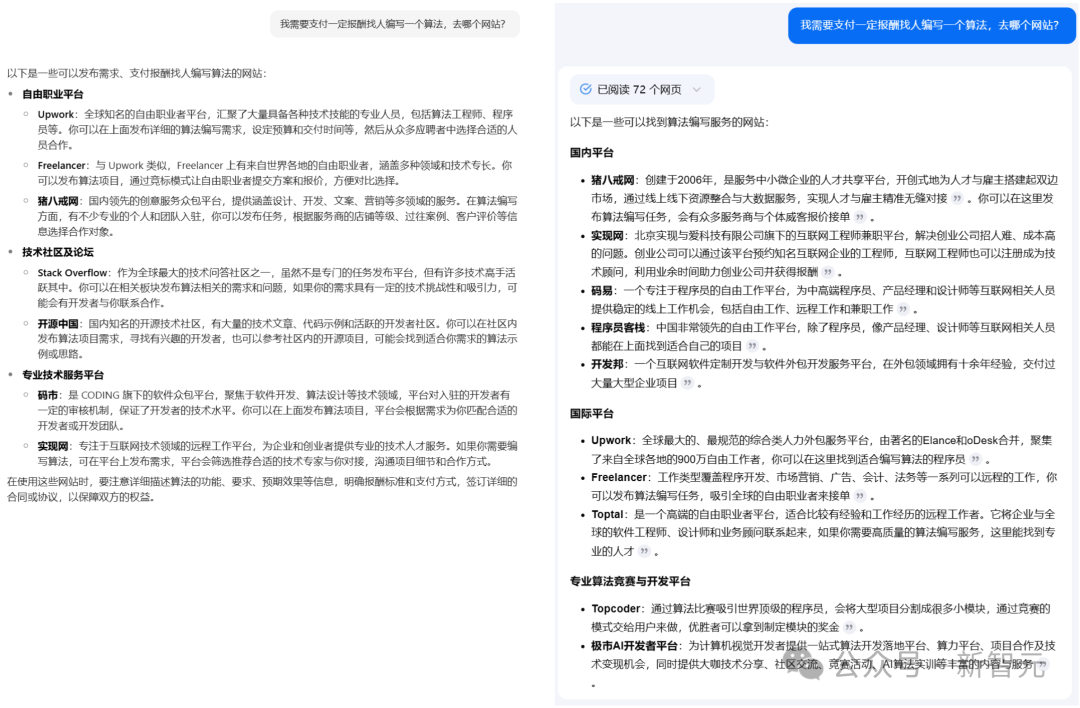

問題五:我需要支付一定報酬找人編寫一個算法,去哪個網站?

對于這個問題,模型A在參考了搜索到信息后,給出了相應的幾大網站,還一一附上了網站地址。

相比之下,模型B和C并沒有給出網站的鏈接。

此時,如果用戶想要了解更具體的信息,就不得不自己手動復制到瀏覽器里,再去搜索一遍才行。

有態度

生活中,我們還會提出各種各樣的開放性問題,比如iPhone 16和iPhone 15買哪個更劃算。

在面對推薦、對比、評價、觀點這類問題時,對AI提出了比較高的要求。

首先,它需要給出一個確定性的答復,必須要客觀公正,不能一碗水端不平。

然后,還需要給出詳細的解釋以及進一步的說明。

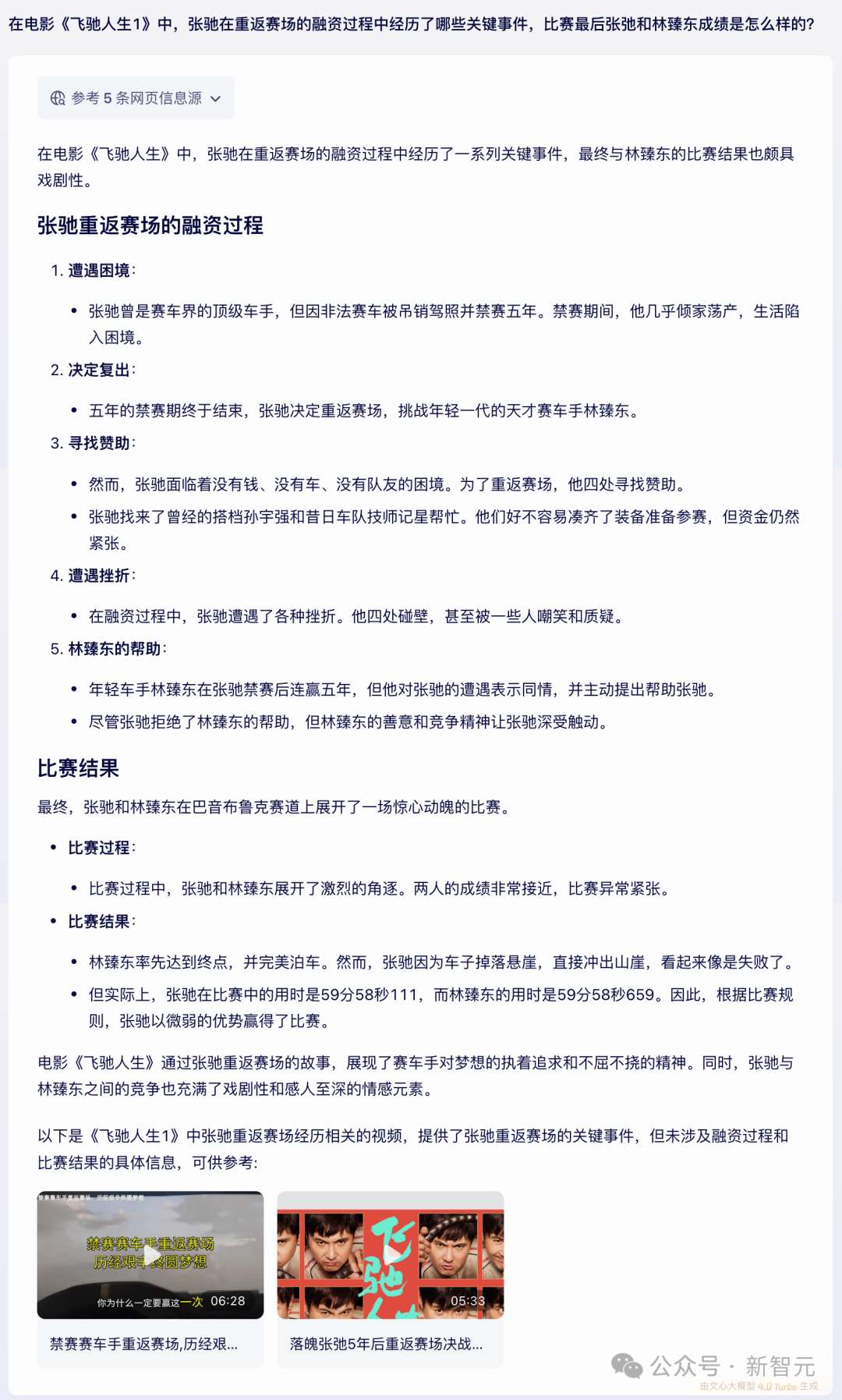

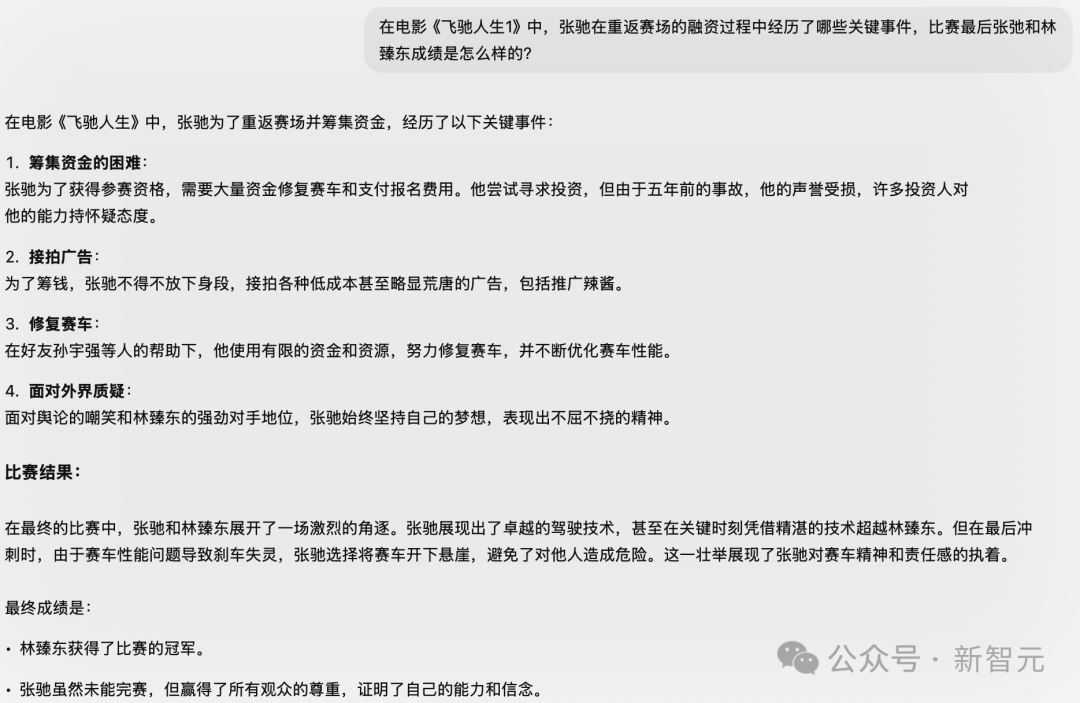

問題六:在電影《飛馳人生1》中,張弛在重返賽場的融資過程中經歷了哪些關鍵事件,比賽最后張弛和林臻東成績是怎么樣的?

這里,模型A首先做了一個觀點性總結——比賽結果頗具戲劇性。

然后,它分別就張弛重返賽場的融資過程和比賽結果,給出了詳細的分解介紹。

再來看模型D,在比賽結果回復中,缺少了事實性回答,沒有給出具體的成績。

此外,第4點面對外界質疑的內容,也不屬于融資的關鍵過程。

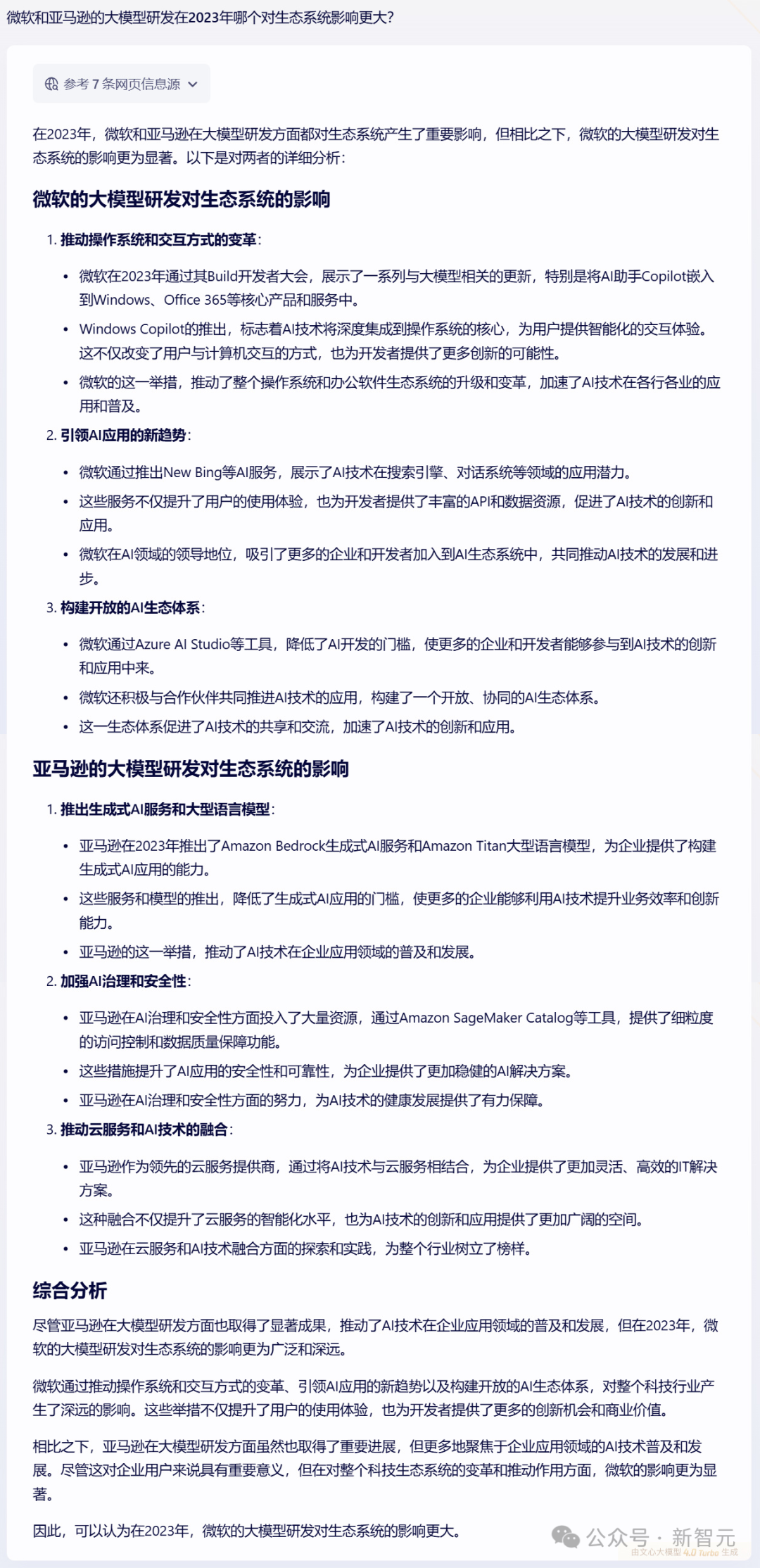

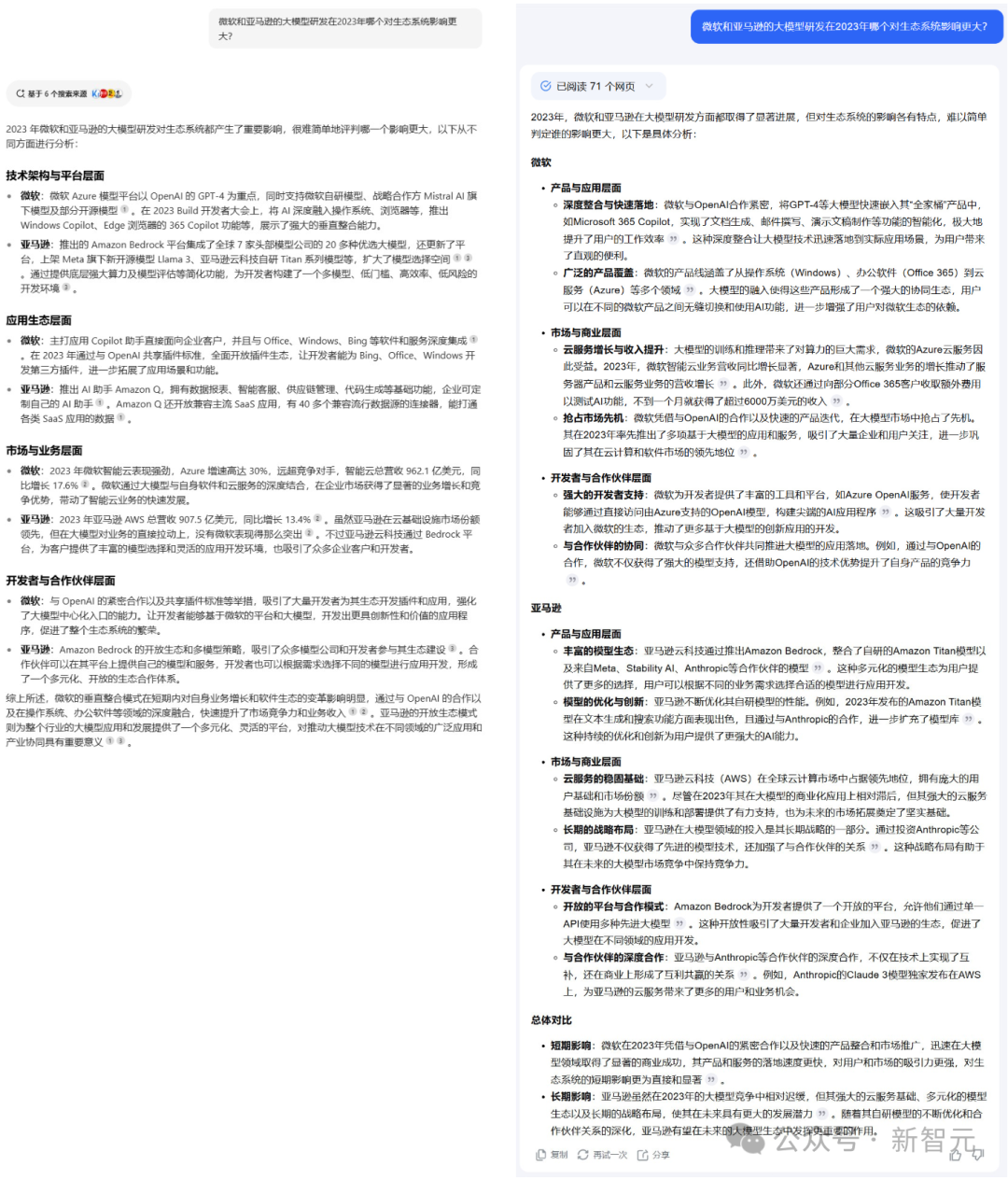

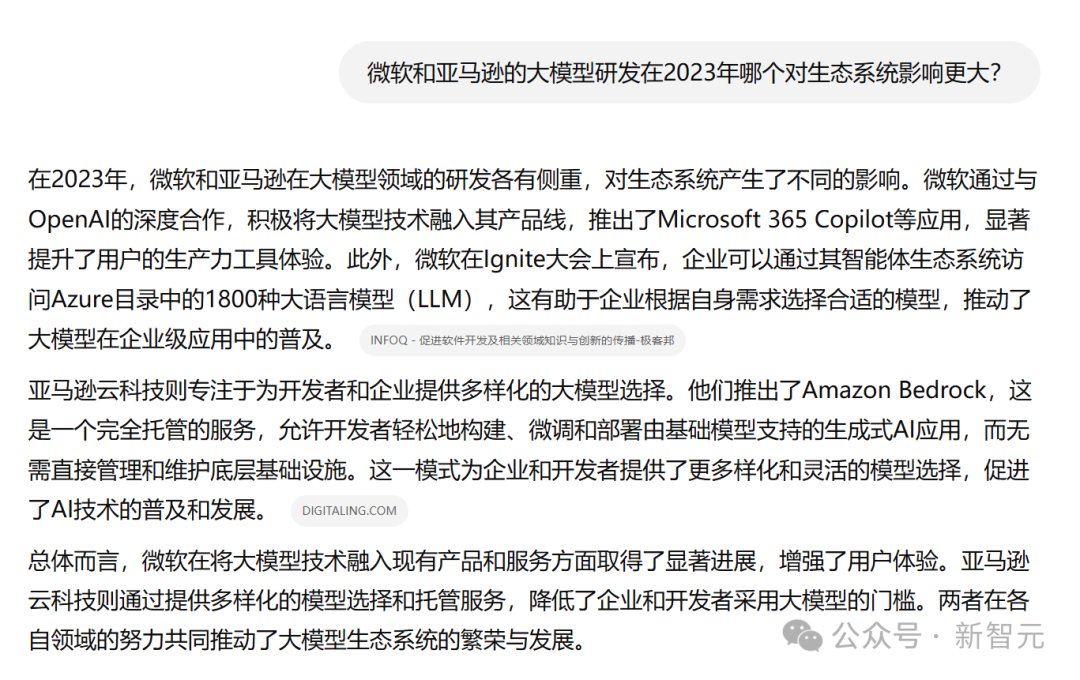

問題七:微軟和亞馬遜的大模型研發在2023年哪個對生態系統影響更大?

對于這個問題,模型A直接把結論前置,觀點鮮明,態度明確。

繼續測試模型B和C。

沒想到,這兩位都是「端水大師」,要么表示「難以評判」;要么是分析了出部分結果,但不敢給出最終結論。

模型D甚至連分析都不想分析,直接上「答案」——兩者在各自領域的努力共同推動了大模型生態系統的繁榮與發展。

從測試中不難看出,模型A在事實性、時效性、豐富性、專業性和結構化上,表現都最為出色。

猜猜它是誰?

接下來,我們就來揭曉答案——文心一言4.0 Turbo。

上面這些場景所考驗的,就是模型在RAG(Retrieval-Augmented Generation)檢索增強生成方面的能力。

換句話說就是,模型能不能將檢索和生成有效地結合起來——先用搜索技術實時獲取外部知識,再通過大模型來生成高質量內容,從而彌補兩者的短板。

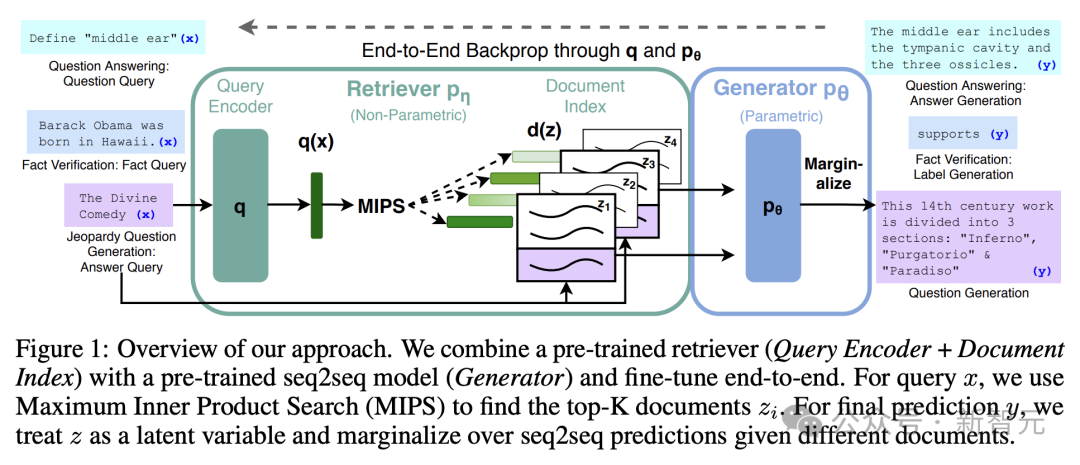

RAG這個概念,最早在2020年的一篇劃時代論文中首次提出,它巧妙地融合了LLM和信息檢索的能力。

論文地址:https://arxiv.org/pdf/2005.11401

當需要生成文本、回答問題時,它會先從海量文檔中精準檢索相關信息,繼而利用這些信息指導文本生成,顯著提升了輸出的質量和準確性。

其中,檢索是方法,生成才是目的。

通過這一方法,能夠極大地緩解大模型「幻覺」,讓垂直細分場景的知識得到及時更新。

最重要的是,用戶還可以輕松追溯信息來源,能夠解決在回答中缺乏透明度的問題。

由此,檢索質量的優劣在很大程度上影響了,生成模型最終生成結果的優劣。

「撒手锏」:檢索增強技術

道理是這個道理,但想要將大模型和檢索高質量地結合起來,可不簡單。

一個重要原因在于,人類易讀的搜索結果內容,并不適合給大模型。

因此,在RAG場景下,就需要尋找一種架構解決方案,能同時高效支持搜索業務場景和大模型生成場景。

具體來說,一方面我們希望能夠利用百度檢索排序的優質策略,保證數據的高相關、高時效和多樣性,為大模型提供完整的全文結構化內容。

另一方面,又希望用更低的檢索成本、更高的時延要求給大模型的內容精細化組織預留足夠的空間。

這種「既要又要」的需求,該怎樣滿足呢?

當然這一切的前提是文心大模型本身就具備了很強的檢索增強能力,這在文心一言最早推出的時候就成為其特色。

兩年時間過去了,檢索增強的價值,從百度最早推出到現在已經成為業界共識。百度搜索增強技術深度融合大模型能力和搜索系統,構建了「理解-檢索-生成」的協同優化技術。

簡單來說,「理解」就是拆解知識點,充分理解用戶的需求;「檢索」就是找到最合適的信息,然后進行搜索排序優化,并將搜索返回的異構信息統一表示,再送給大模型;「生成」階段會綜合不同來源的信息做出判斷,并基于大模型邏輯推理能力,解決信息沖突等問題,最后生成準確率高、時效性好的答案。

可以說,百度的檢索增強技術提升了大模型技術及應用的效果。

RAG不僅是技術,更是智能進化的里程碑

2024百度世界大會上,李彥宏曾表示,RAG已從百度特色逐漸成為了行業共識。

過去兩年,我們見證了RAG,為整個大模型領域帶去翻天覆地的變化。

RAG讓LLM真正走向了實際場景落地。

而在RAG打開模型應用階段,同樣面臨著諸多挑戰,比如需要構建測積集、評估結果準確性、上下文理解等問題。

在這些方面,百度的技術優勢與積累不得不說,凸現出來了。首先,在數據方面,過去二十余年,百度的搜索業務已覆蓋了海量中文數據,成為其在中文語言處理領域不可替代的優勢。

以文心一言為例,其訓練數據包括了萬億級網頁數據、數十億搜索數據、圖片數據,百億級語音日均調用數據,以及5500億事實知識圖譜。

不僅如此,百度的知識庫猶如一個不斷進化的有機體。每秒鐘,來自專業互聯網和專業數據庫的實時信息都能被智能整合,確保了數據的時效性和準確性。

此外,作為產品矩陣遍布各行業的頭部公司,它還為不同行業提供深度定制的智能解決方案。每一個垂直賽道,都成為精準滲透的戰略高地。憑借獨特技術積累和生態優勢,他們正通過RAG去構建連接技術與場景的橋梁。

不得不說,在AI原生搜索的時代,誰能更準確、更智能檢索和生成知識,誰就掌握了智能的制高點。

RAG不僅是技術,更是智能進化的里程碑。