NeurIPS | 對比采樣鏈:讓擴散模型更快、更準、更清晰的秘密武器

論文 Contrastive Sampling Chains in Diffusion Models 的精煉解讀。

一眼概覽

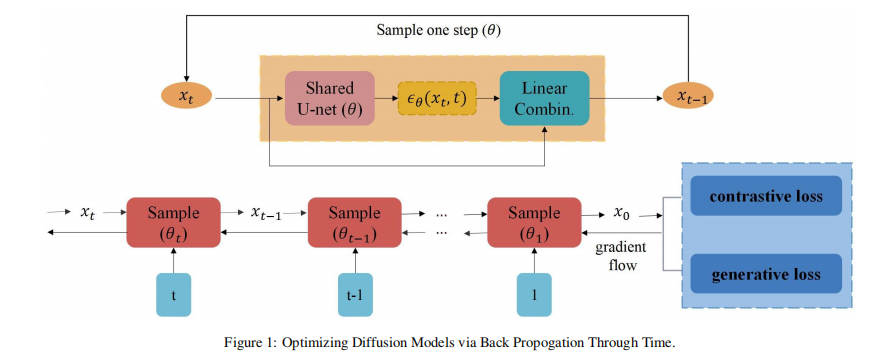

該論文提出了一種 對比采樣鏈(Contrastive Sampling Chains, CSC) 方法,通過對比損失和得分匹配相結(jié)合,優(yōu)化擴散模型(DMs)的采樣過程,從而 減少離散化誤差,提高生成圖像的質(zhì)量,同時提升采樣速度。

核心問題

擴散模型在使用數(shù)值求解方法進行采樣時 不可避免地引入離散化誤差,導致生成樣本與真實數(shù)據(jù)分布之間存在偏差。現(xiàn)有方法嘗試減少采樣步驟以加速生成,但會導致圖像質(zhì)量下降。本研究的核心問題是:

? 如何減少離散化誤差,在 不增加計算開銷 的情況下,提高生成圖像的質(zhì)量?

? 如何在采樣過程中 使模型生成的分布更接近真實數(shù)據(jù)分布?

技術(shù)亮點

1. 提出對比采樣鏈:使用對比損失構(gòu)建采樣鏈,通過正樣本對(同一圖像不同時間步的采樣結(jié)果)和負樣本對(不同圖像的采樣結(jié)果)優(yōu)化模型,使不同時間步的生成樣本更加一致,從而減少誤差積累。

2. 優(yōu)化 KL 散度上界:理論分析表明,合適的對比損失和得分匹配組合可作為真實數(shù)據(jù)分布與模型分布 KL 散度的上界,從而有效減少離散化誤差。

3. 提升質(zhì)量或加速采樣:方法適用于各種 預訓練擴散模型(無論是否使用快速采樣算法),在 相同計算量下提升圖像質(zhì)量,或在 保持質(zhì)量的同時減少采樣步驟。

方法框架

圖片

圖片

論文的方法流程如下:

1. 構(gòu)建對比采樣鏈:

? 在擴散模型的采樣過程中,選擇同一圖像不同時間步的生成結(jié)果作為正樣本對,不同圖像的生成結(jié)果作為負樣本對。

? 使用 MoCov2 預訓練模型 提取 128 維特征并計算 InfoNCE 對比損失。

2. 聯(lián)合優(yōu)化損失:

? 結(jié)合原始得分匹配損失(JSM)和對比損失(InfoNCE)。

3. 采用 BPTT 進行優(yōu)化:

? 采用 時間反向傳播(BPTT) 傳播梯度,優(yōu)化整個采樣鏈,而非單步優(yōu)化,從而進一步減少全局誤差。

實驗結(jié)果速覽

? 在 CIFAR-10 數(shù)據(jù)集上:

結(jié)合 EDM 預訓練模型,在 相同采樣步數(shù)(35 NFEs)下,F(xiàn)ID 從 2.04 降至 1.88(質(zhì)量提升)。

相同 FID(2.04)下,采樣步數(shù)從 35 降至 25(計算量減少)。

? 適用于不同快速采樣方法:

在 DPM-Solver、DEIS 等快速采樣方法上應用本方法,可在相同計算量下降低 FID,或在相同 FID 下減少計算量。

實用價值與應用

該方法可用于 圖像生成、視頻生成、文本到圖像生成 等任務,尤其適用于:

? 自動駕駛(減少傳感器噪聲,提高環(huán)境感知能力)

? 醫(yī)學影像(降低數(shù)據(jù)采樣誤差,提高合成數(shù)據(jù)質(zhì)量)

? 計算機視覺(提升圖像生成質(zhì)量,提高數(shù)據(jù)增強效果)

開放問題

1. 對比采樣鏈能否適用于三維點云生成或視頻生成?

2. 是否可以進一步結(jié)合自監(jiān)督學習,優(yōu)化對比損失的構(gòu)造方式?

3. 如何在計算資源受限的情況下,實現(xiàn)更高效的優(yōu)化策略?

其他

? 論文的官方期刊或會議來源:https://proceedings.neurips.cc/paper_files/paper/2023/file/e8ff788779f2e9e74ccd0d6b84607437-Paper-Conference.pdf

? 注:所有免費資料獲取鏈接:https://link3.cc/soragpt