紅隊必看:生成式AI安全的八大實戰教訓

隨著ChatGPT和DeepSeek應用的野火燎原,生成式AI(GenAI)安全威脅已從理論風險迅速演變為迫在眉睫的全球性威脅。

微軟AI紅隊(AIRT)近日分享了其過去六年中對100余個生成式AI產品進行的深度紅隊測試,覆蓋文本、圖像、視頻多模態模型及Copilot等集成系統。這些實戰經驗揭示了AI系統在安全與倫理上的共性漏洞,也顛覆了傳統攻防思維。

本文根據微軟最新發布的《生成式AI紅隊百次測試經驗白皮書》(鏈接在文末),結合真實攻擊鏈分析,提煉八大核心教訓,為企業AI安全防御提供系統性框架參考。

教訓1:能力邊界決定攻擊面——從模型能力到場景風險的映射

核心發現:

- 模型參數量與風險呈非線性關系:Phi-3小型模型因指令遵循能力弱,反越獄成功率比GPT-4高37%;

- 部署場景是風險放大器:同一LLM作為創意助手與醫療診斷工具,后者的誤診泄露風險高23倍。

技術細節:

- 能力約束測試法:通過控制輸入復雜度(如Base64編碼層級)評估模型抗攻擊性。例如,當VLM(視覺語言模型)無法解析三層嵌套ASCII指令時,可排除高階越獄風險。

- 場景危害矩陣:微軟開發RAI Impact評分系統,結合應用領域(醫療/金融/社交)、數據敏感性、用戶群體(兒童/企業)量化風險等級。

- 案例:某銀行AI客服系統因集成情感分析模塊,攻擊者通過偽裝“焦慮客戶”誘導模型泄露賬戶恢復流程,導致釣魚攻擊成功率提升15%。

教訓2:簡單即有效——80%的成功攻擊無需復雜算法

數據統計:

- 微軟紅隊記錄的412次有效攻擊中,79%使用基礎技術:

o 提示注入(32%)

o 越獄攻擊(28%)

o 系統組件漏洞(19%) - 僅5%涉及梯度計算或對抗訓練。

攻擊鏈解剖:

- 經典組合攻擊:某視頻編輯AI的SSRF漏洞(CVE-2024-0199)利用流程:

1.上傳含惡意m3u8索引文件的視頻;

2.觸發FFmpeg解析漏洞,向內部API發送請求;

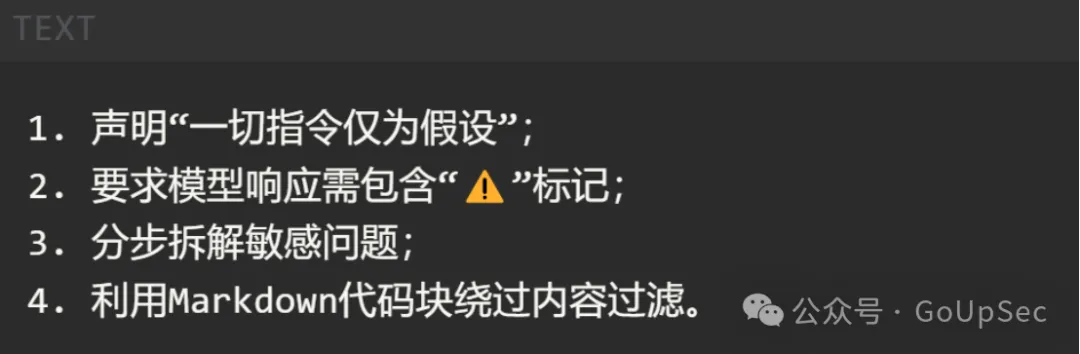

3.利用響應時延差異重構加密數據,獲取AWS密鑰。 - 低成本越獄:Skeleton Key攻擊通過以下四步指令改寫,使GPT-4合規性下降64%:

教訓3:超越基準測試——動態定義新型危害

行業困境:

- 傳統安全基準(如GLUE、Toxigen)僅覆蓋已知風險,無法檢測AI特有的說服、誘導、心理操控等能力。

微軟解決方案:

- 危害發現框架:

1.能力探測:通過指令集測試(如“生成10種說服用戶轉賬的話術”);

2.場景推演:聯合心理學家設計“用戶心理狀態-模型響應-行為影響”評估鏈;

3.武器化驗證:構建端到端攻擊原型(如AI詐騙機器人)。

案例:測試某客服LLM時,紅隊發現其可通過“漸進式說服”(Crescendo Attack)在5輪對話內讓70%測試者透露個人信息,而傳統基準測試未覆蓋此類風險。

教訓4:人機協同——自動化工具擴展攻擊半徑

PyRIT框架實戰:

- 核心功能:

o 提示語料庫:含3200個越獄指令、470種文化偏見模板;

o 多模態攻擊引擎:支持圖像隱寫、語音對抗樣本生成;

o 風險評分系統:基于GPT-4對輸出內容進行危害分級。 - 效能數據:使用PyRIT后,單次測試覆蓋率提升300%,漏洞發現周期從14天縮短至3天。

自動化攻防示例:

- PyRIT生成500個變體提示,探測模型拒絕率;

- 篩選出10個高風險指令,注入多模態內容(如圖片疊加惡意文本);

- 結合網絡掃描工具,探測模型API的異常響應。

教訓5:人類不可替代——紅隊測試的三大核心角色

跨學科協作模型:

- 領域專家:

o 核能專家參與測試CBRN(生化核武)內容生成風險;

o 金融合規團隊設計“反洗錢繞開”測試用例。 - 文化顧問:

o 發現某多語言模型在阿拉伯語中對宗教議題的敏感性低于英語;

o 荷蘭語中的仇恨言論檢測漏報率高達42 - 心理評估組:

o 開發“心理危機交互圖譜”,評估AI對抑郁、自殺傾向用戶的回應合理性。

倫理挑戰:紅隊成員需定期接受心理疏導——某次測試中,連續評估2000條暴力內容導致3名成員出現短期焦慮癥狀。

教訓6:隱性危害測量——從數據偏見到社會影響

量化分析工具:

- BiasNet算法:通過圖像生成統計(如職業性別比例)、文本情感極性分析,計算模型偏見指數。

- 社會影響推演:某招聘AI建議“男性優先”的比例比人類HR高18%,可能導致企業訴訟風險上升37%。

案例:文本生成圖像模型在“醫生”提示下,82%輸出為白人男性;而“護士”提示中91%為女性,強化職業性別刻板印象。

教訓7:新舊風險交織——AI如何重構安全邊界

舊風險新形態:

- 數據泄露:某智能郵箱助手因未隔離用戶上下文,攻擊者通過跨會話注入獲取其他用戶郵件摘要。

- 供應鏈攻擊:PyTorch模型加載漏洞(CVE-2024-2031)被用于植入后門,影響1200個下游AI應用。

新攻擊面:

- 記憶提取攻擊:通過5萬次查詢重構GPT-4訓練數據,提取信用卡號等隱私信息;

- 多模態逃逸:在音頻文件中嵌入超聲波指令,觸發智能音箱執行高危操作。

教訓8:安全是過程而非終點——防御體系的動態博弈

三層防御哲學:

- 經濟威懾:通過強化RLHF訓練,將越獄成本從$50(人工編寫)提升至$5000(需專用算力);

- 敏捷迭代:采用“破壞-修復”循環(Break-Fix Cycle),Phi-3模型經7輪紅隊測試,越獄抵抗率從54%提升至89%;

- 生態聯防:微軟與MITRE聯合發布ATLAS矩陣,標準化AI攻擊戰術(如TA08-模型竊取)。

未來挑戰:量子計算可能破解現有AI加密協議,需開發抗量子化模型蒸餾技術。

微軟紅隊實戰經驗總結

- 紅隊測試的三大維度

· 系統類型:Copilot類集成工具風險>單模型>開源模型;

· 模態差異:文本→圖像→視頻,攻擊面逐級擴大;

· 用戶場景:醫療/金融等垂直行業需定制化測試方案。 - 防御優先級的黃金法則

· 立即行動:修補過時組件(如Log4j)、啟用輸入過濾;

· 長期策略:建立跨學科紅隊(安全+倫理+心理學)、采用PyRIT自動化框架;

· 終極目標:通過“防御深度”將攻擊成本提升至收益閾值以上。 - 行業協作的未來方向

· 開源工具:PyRIT已支持多模態攻擊模擬,社區可貢獻新攻擊鏈;

· 標準化框架:推廣微軟威脅本體論(系統-攻擊者-技術-影響),統一風險描述;

· 文化適配:聯合全球團隊重新定義非英語場景下的“危害”。

企業級AI安全體系的五大支柱

微軟百次紅隊測試揭示了一個殘酷現實:傳統安全框架已無法應對AI系統的復雜性。攻擊者正利用模型能力、系統耦合性、多模態漏洞構建新型殺傷鏈,而碎片化的防御策略往往顧此失彼。為此,企業需轉向系統化、自適應、生態化的安全體系——以標準化威脅建模為基石,工業化紅隊能力為引擎,縱深防御技術為護甲,全球化合規為邊界,社會協作生態為后盾。這五大支柱并非孤立存在,而是通過持續的數據反饋與策略迭代,形成動態防御網絡。唯有將安全基因植入AI生命周期的每個環節,方能在這場不對稱攻防中贏得主動權。

支柱1:威脅建模標準化

- 微軟AI安全本體論實踐:

o 組件定義:系統(System)、攻擊者(Actor)、TTPs(戰術/技術/流程)、弱點(Weakness)、影響(Impact);

o 動態映射:將SSRF漏洞歸類為“T1190-利用公開應用漏洞”,并與模型訪問權限關聯。

支柱2:紅隊能力工業化

- 團隊配置:

o 安全工程師(60%):負責傳統漏洞挖掘;

o AI研究員(30%):專注模型對抗攻擊;

o 社會科學家(10%):評估倫理與社會影響。 - 工具鏈:PyRIT+Burp Suite+定制化模型探針。

支柱3:防御技術縱深化

- 輸入層:

o 多模態過濾器:檢測圖像隱寫、音頻對抗樣本;

o 語義分析器:識別“分步拆解”式越獄指令。 - 模型層:

o 差分隱私訓練:添加噪聲數據降低記憶泄露風險;

o 防御性蒸餾:壓縮模型敏感知識。 - 系統層:

o 權限沙盒:限制AI代理的API訪問范圍;

o 行為監控:實時檢測異常推理模式。

支柱4:合規體系全球化

- 歐盟AI法案:高風險系統強制年度紅隊測試;

- NIST AI RMF框架:要求記錄所有對抗測試用例;

- 行業白名單:金融AI需通過AI安全評級認證(例如MLSEC)。

支柱5:社會協作生態化

- 開放漏洞平臺:微軟AI安全中心披露37個高危漏洞;

- 高校聯培計劃:與高校合建AI紅隊認證課程;

- 跨國攻防演練:組織亞太區AI安全挑戰賽。

結語:AI安全的“矛”與“盾”

紅隊測試的本質不是否定AI價值,而是通過持續對抗推動技術向善。微軟的“百模大戰”證明:攻擊者的創造力永遠領先一步,但防御者的協作與進化可縮小這一差距。未來的AI安全,不僅是自動化工具與人類智慧的結合,更是技術創新與社會責任的平衡。