全球首個「視頻教學」基準!南洋理工、CMU發布Video-MMMU

想象一下,你正在觀看吳恩達老師的機器學習課程,視頻講解清晰、動畫直觀,你很快掌握了核心概念,并能在考試中靈活應用,人類對這個過程再熟悉不過。

那么,如果AI也能這樣學習呢?

圖1 Video-MMMU提出知識獲取的3大認知階段

這正是Video-MMMU試圖回答的核心問題:AI能否通過觀看視頻獲取并應用知識?

對于多模態大模型(LMMs)來說,視頻不僅是它們感知世界的窗口,更是獲取知識的重要途徑。南洋理工大學S-Lab團隊推出Video-MMMU數據集是首個評測LMMs從多學科專業視頻中提取、理解并運用知識能力的創新基準。

通過Video-MMMU,我們不再滿足于模型「看懂」視頻,而是探索它能否真正「學會」視頻中的新知識,并運用這些知識解決實際問題。

論文地址:https://arxiv.org/abs/2501.13826

開源代碼:https://github.com/EvolvingLMMs-Lab/VideoMMMU

項目主頁:https://videommmu.github.io/

數據集:https://huggingface.co/datasets/lmms-lab/VideoMMMU

三大認知階段:從感知到應用

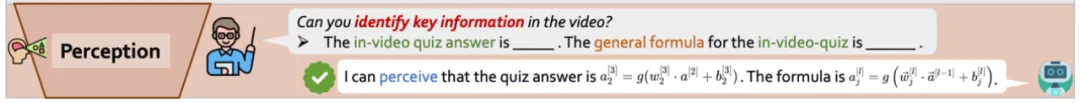

教育學認為,學習是一個漸進的認知過程 [1],而Video-MMMU正是圍繞這個過程設計的,將學習新知識拆解為三個認知階段:感知(Perception)、理解(Comprehension)和運用(Adaptation),系統評估模型在知識獲取不同層次的能力。

感知(Perception)——信息獲取的起點,模型需要從視頻中提取關鍵信息,這是獲取知識的基礎。

理解(Comprehension)——從感知到掌握,模型不僅需要「看清」,還要理解知識的深層次含義。

運用(Adaptation)——真正的學以致用,模型需要將從視頻中學到的知識運用到全新的場景中。這是測試學習能力的最終環節。

知識增益(?knowledge):衡量模型的能力提升

Video-MMMU 的另一大亮點在于設計了「知識增益」(?knowledge)指標。這一創新不僅關注模型的「絕對能力」,更評估其在觀看視頻前后的在應用階段的表現提升。

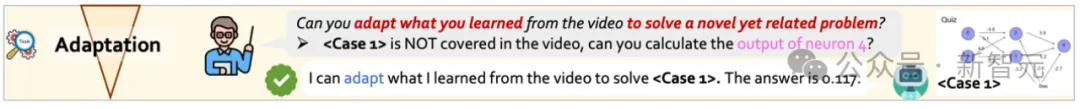

圖2 模型通過觀看視頻,將原本無法解決的問題做對。「解題」的能力不是唯一的檢驗標準,能獲取知識,并把原本做錯的問題做對,也是一種重要的能力。

與傳統評測不同,Video-MMMU更關注模型是否能通過觀看視頻解決原本無法解答的問題。從Video-MMMU的角度,智能不僅僅是「解題」的能力,更是快速學習和應用新技能的能力。

對于多模態大模型來說,視頻就是它們的課堂。通過視頻「上課」,模型可以獲取新知識,并靈活應用于實際生活中的未知挑戰,不僅是對「智能」概念的重新思考,更是邁向通用智能(AGI)的一次有趣探索。

Video-MMMU 的發布,為評估和改進LMMs的知識獲取能力提供了全新視角。如果人類的課堂是學習的起點,那么 Video-MMMU 就是LMMs走向課堂的一扇大門。

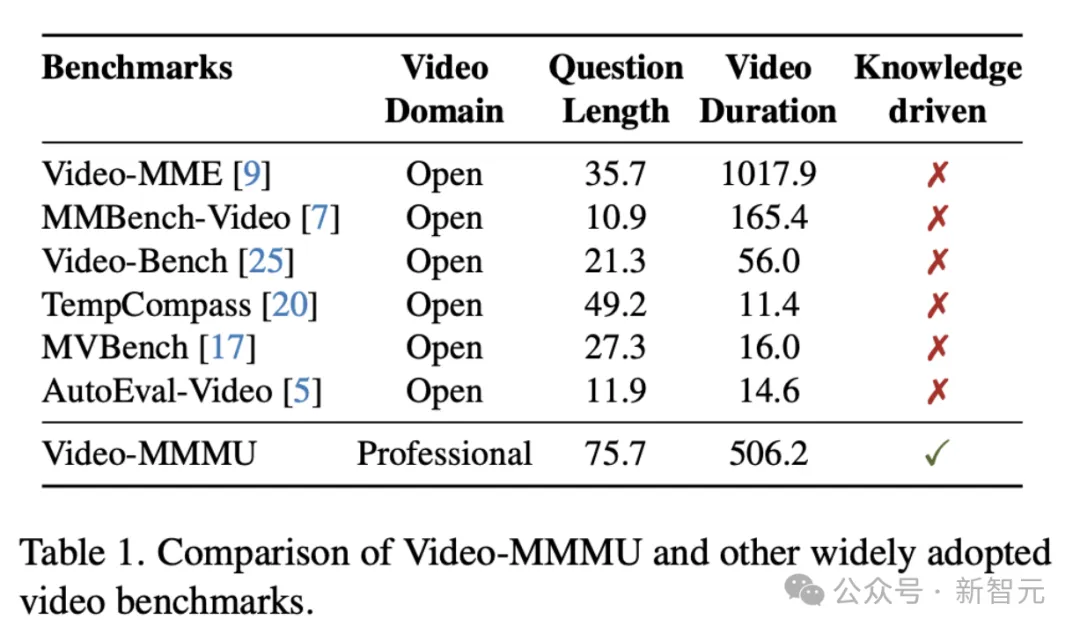

數據集的獨特性

Video-MMMU的獨特之處在于首次將視頻作為知識傳播的核心渠道,從傳統的視頻場景理解轉向視頻內容的知識學習。數據集專注于高質量教育視頻,平均時長506.2秒,覆蓋多個學科領域。其問題平均長度達75.7字,遠超其他基準,體現出高度專業性和挑戰性。

數據集設計

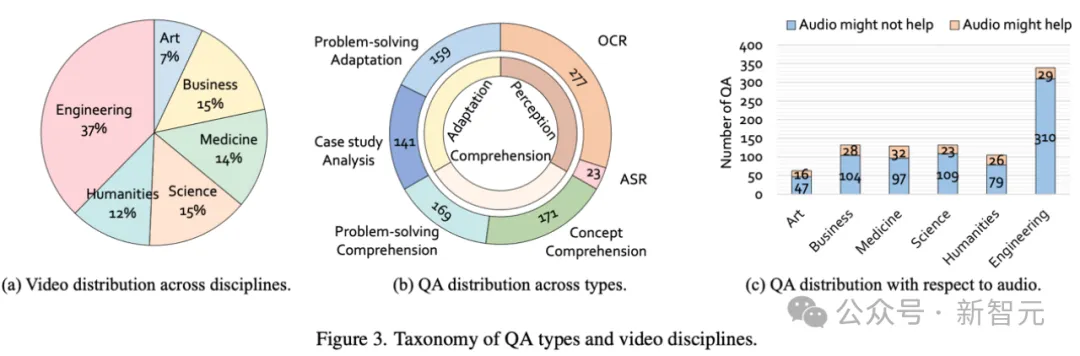

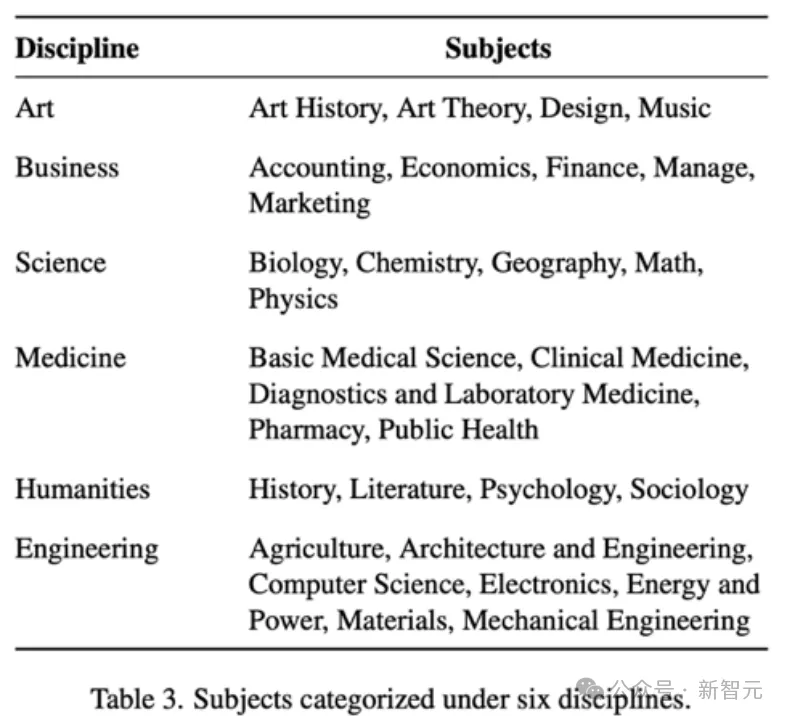

Video-MMMU覆蓋6大專業領域(藝術、商業、醫學、科學、人文、工程)中的30個學科。數據集包含精心篩選的300個大學水平的教育視頻和900個高質量的問答對。

問題設計

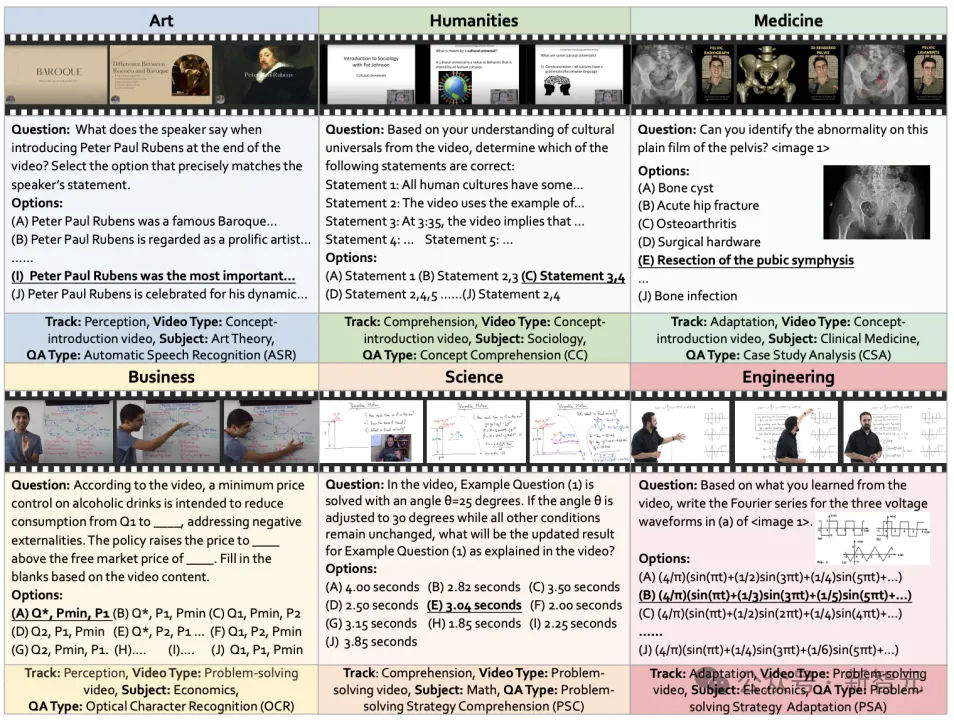

感知階段的問題類型

- ASR(自動語音識別):要求模型準確轉錄視頻中的口述內容。示例:如上圖中Art(左上)的例子。

- OCR(光學字符識別):從公式、圖表或手寫筆記中提取關鍵細節。示例:如上圖中Business(左下)的例子。

理解階段的問題類型

- 概念理解(Concept Comprehension):通過不定項選擇題評估模型對視頻中概念的理解。示例:如上圖中Humanities(中上)的例子。

- 解題方法理解(Problem-solving Strategy Comprehension):在視頻中演示的解決問題基礎上,通過改變輸入值測試模型是否掌握了解題方法。示例:如上圖中Science(中下)的例子。

運用階段的問題類型

- 案例分析(Case Study Analysis):將視頻中講解的知識應用于新的實際情境。示例:如上圖Medicine(右上)的例子。

- 解題方法運用(Problem-solving Strategy Adaptation):將視頻中演示的解決方法應用于實際的問題。示例:如上圖中Engineering(右下)的例子。

實驗結果分析

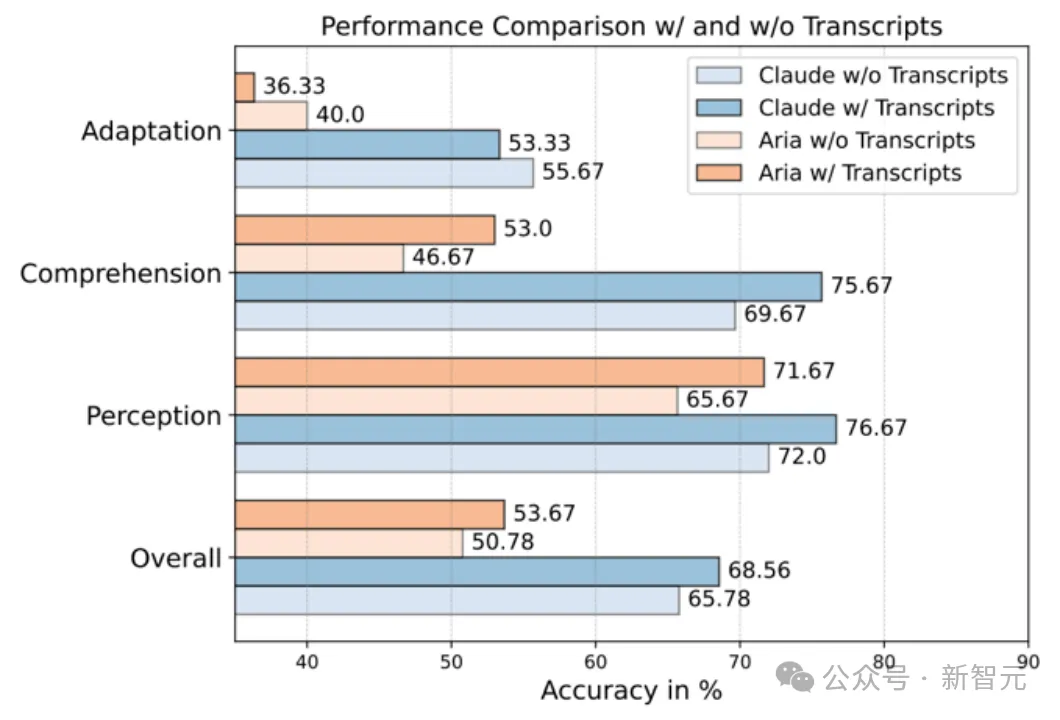

各認知階段的表現

- 人類 vs. AI:人類專家在所有階段的表現都優于模型,盡管Claude-3.5-Sonnet在模型中得分最高,但仍明顯落后于人類。

- 難度逐級遞增:無論是人類還是AI,從感知到理解再到運用,準確率逐步下降,說明越深層次的認知任務對能力要求越高。

- 知識運用的挑戰:運用階段(Adaptation Track) 是知識獲取的最大瓶頸,模型得分普遍低于50%。這表明,盡管模型在可能表面理解了視頻知識,但在實際應用時仍存在明顯短板,難以靈活遷移和運用所學內容。

音頻文本的影響

作者使用 OpenAI Whisper 生成音頻轉錄文本,以測試其對模型表現的影響。

結果顯示:

- 感知與理解階段:音頻文本有助于模型更精準地理解視頻內容,提高表現。

- 運用階段的挑戰:模型表現反而下降,可能因為音頻中存在冗余信息,干擾了模型對關鍵知識的提取和遷移能力。這說明,盡管音頻文本能幫助AI“聽懂”視頻,但真正的知識應用依然是重大挑戰。

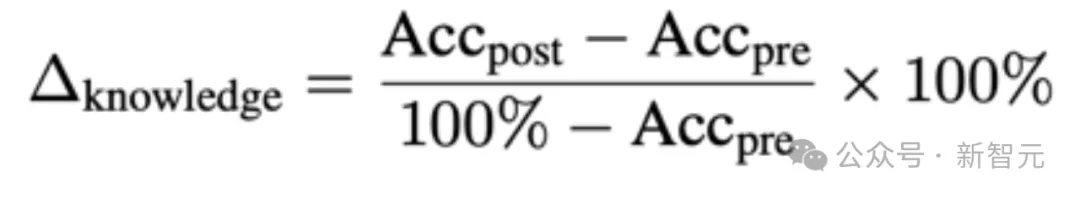

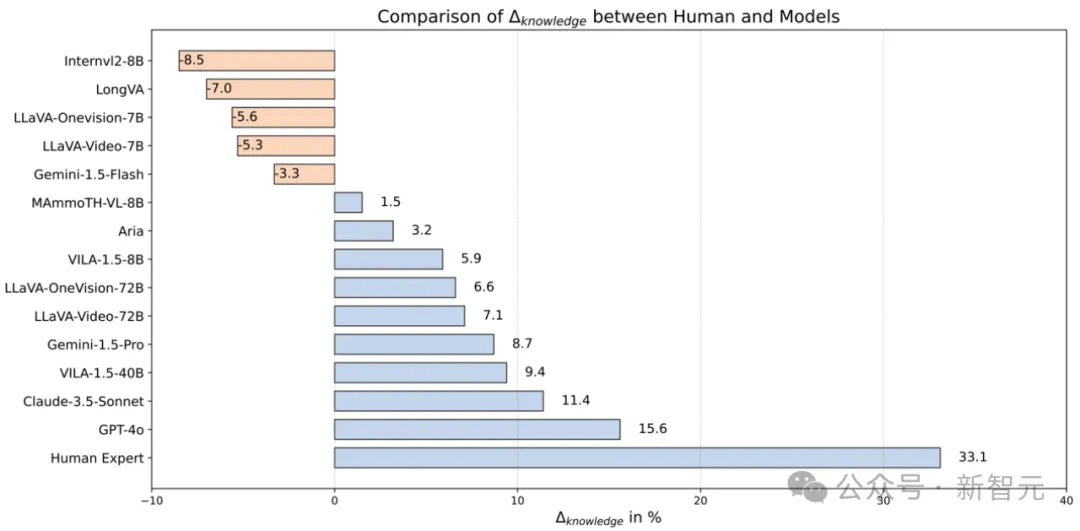

知識增益的定量分析

Video-MMMU 的核心創新之一是引入「知識增益」指標(?knowledge)用于評估模型通過觀看視頻學習新知識的能力。與傳統評測不同,該指標關注模型是否能通過視頻學習,解決原本不會的問題,而不僅僅是靜態的解題能力。(?knowledge)定義為:

人類 vs. AI:學習能力差距

人類在觀看視頻后,知識增益達33.1%,而表現最好的模型(GPT-4o)僅為15.6%,多數模型低于10%。更令人意外的是,一些模型在觀看視頻后反而表現下降,表明它們在知識學習和應用方面仍遠不及人類。

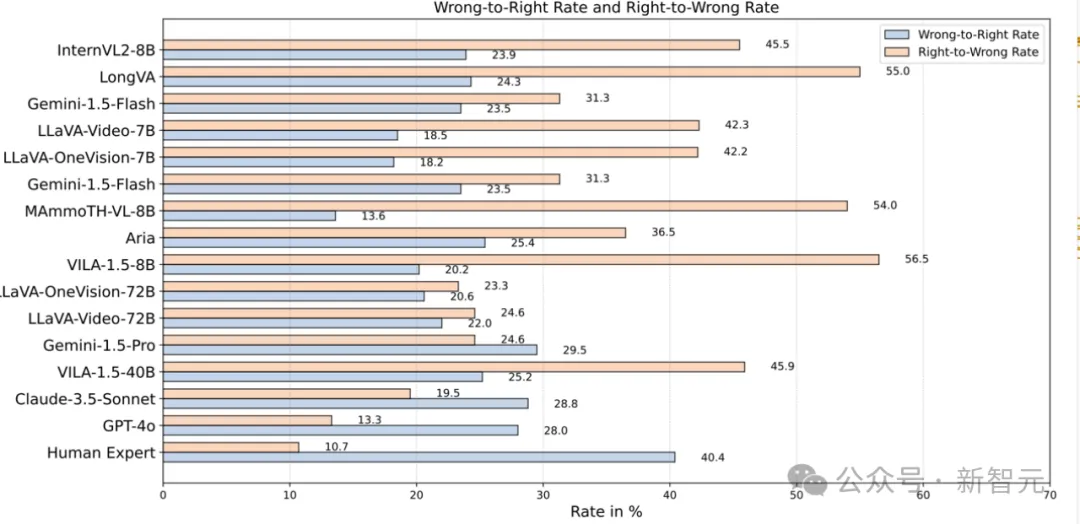

模型的知識獲取兩面性

僅憑知識增益(?knowledge)并不能全面衡量模型的真實學習能力。因此,作者進一步引入兩個關鍵指標:

- 錯誤轉正確率(Wrong-to-Right Rate):模型能否通過視頻學習,把原本錯誤的答案修正?定義為:

- 正確轉錯誤率(Right-to-Wrong Rate):模型是否看視頻之后,把原本做對的題做錯了?

實驗發現,大多數模型取得較為不錯的錯誤轉正確率,顯示出一定的學習能力。但是,大多數模型的正確轉錯誤率遠高于人類,表明它們在吸收視頻知識時仍存在明顯不足。

人類的認知優勢

人類在這兩個指標上的表現更加平衡:

- 錯誤轉正確率:40.4% → 說明人類能更有效地學習新知識。

- 正確轉錯誤率:10.7% → 這表明,人類能夠自然整合新舊知識,而模型在處理視頻信息時,往往會修改原本正確的答案,這成為其學習能力的核心短板之一。

結論:模型的瓶頸

實驗結果揭示了當前多模態大模型(LMMs)在視頻學習中的兩大挑戰:

- 學習能力有限:難以高效獲取并應用新知識。

- 模型回答的不穩定性:原本會做的題,看完視頻后反而不會了。

如何提升LMMs的學習效率和穩定性,將是提升視頻知識獲取能力的關鍵。

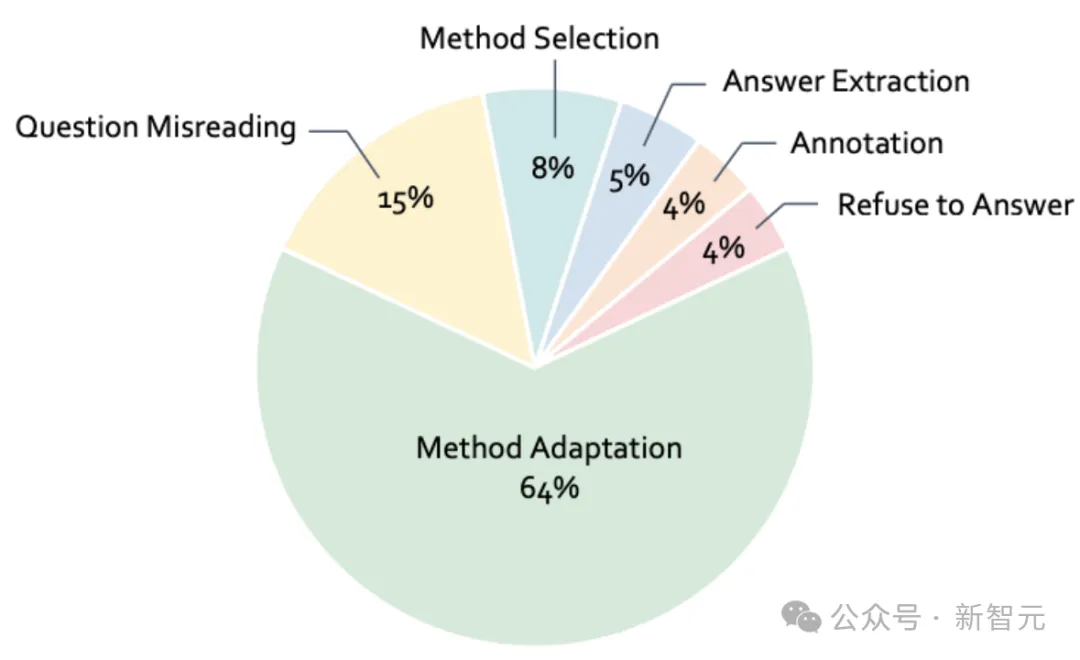

錯誤分析

作者對Claude-3.5-Sonnet在運用階段的100個錯誤進行了分類,分析模型做錯的根本原因。

- 方法選擇錯誤(8%):模型選擇了錯誤的解題方法,也就是說,它未能理解視頻中講解的正確策略。簡單來說,模型看了視頻,但沒有選對路。

- 方法運用錯誤(64%):這是最常見的錯誤。模型記住了視頻中的方法,但在新情境下無法靈活應用。比如,它理解了視頻中的解題方法,但無法正確運用到另一個場景中。

- 問題誤讀錯誤(15%):模型沒讀懂題目,比如錯看了數值或條件。這些錯誤和知識獲取無關,更像是「粗心大意」。

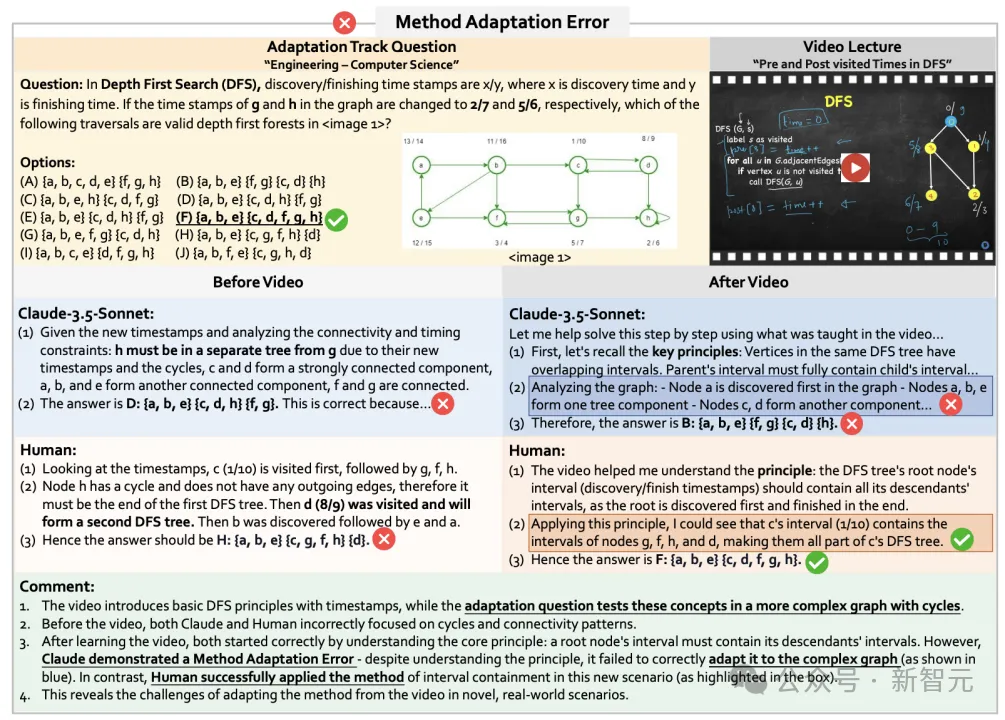

作者詳細分析了模型方法運用錯誤的例子:

總結

Video-MMMU首次系統性評測了LMMs從視頻中學習、理解和應用知識的能力,揭示了當前多模態大模型在學習效率和知識遷移上的顯著不足。提升模型從視頻中獲取知識的能力,將是邁向AGI的重要一步。