DeepSeek-V3深入解讀!

上一篇文章對DeepSeek-R1進行了詳細的介紹,今天來看看DeepSeek-R1的基座模型DeepSeek-V3。

項目地址:https://github.com/deepseek-ai/DeepSeek-V3

簡單介紹下研究動機:現有的開源模型在性能和訓練成本之間往往難以達到理想的平衡。一方面,為了提升模型性能,需要增加模型規模和訓練數據量,這會導致訓練成本急劇上升;另一方面,高效的訓練和推理架構對于降低計算資源消耗至關重要。因此,研究動機在于開發一種既能實現強大性能,又能有效控制訓練成本的開源語言模型,以推動開源模型的發展,并為更廣泛的研究和應用提供支持。

1、模型架構

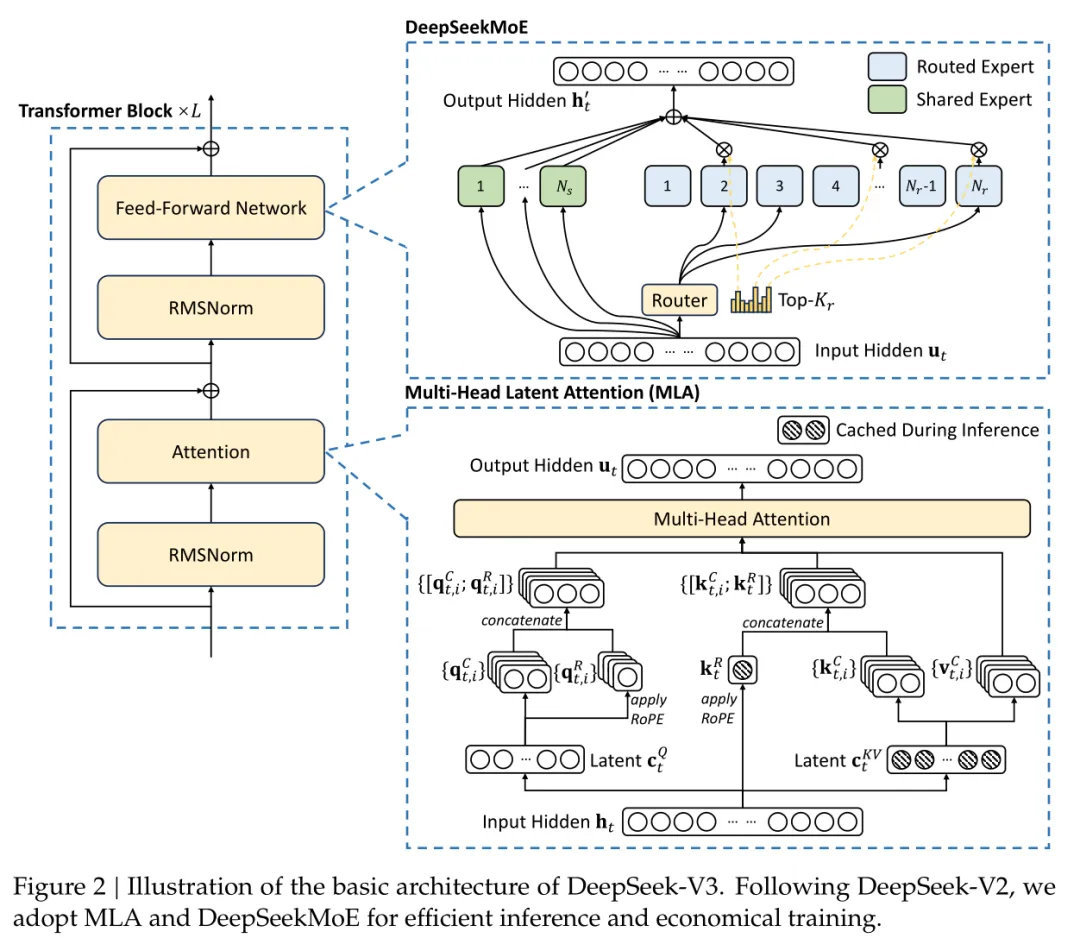

DeepSeek-V3的架構基于Transformer框架,旨在通過高效的推理和經濟的訓練實現強大的模型性能。它繼承了DeepSeek-V2中驗證過的多頭潛在注意力(MLA)和DeepSeekMoE架構,并在此基礎上進行了擴展和優化。下面來詳細介紹下DeepSeek-V3的三個關鍵模塊:

多頭潛在注意力MLA

MLA的核心思想是通過低秩聯合壓縮來減少注意力機制中的查詢(query)、鍵(Key)和值(Value)的維度,從而在推理時顯著減少KV緩存的存儲需求。這種壓縮方法不僅減少了內存占用,還通過保持性能與標準多頭注意力相當,實現了高效的推理。

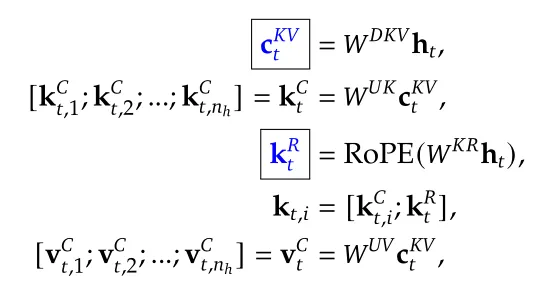

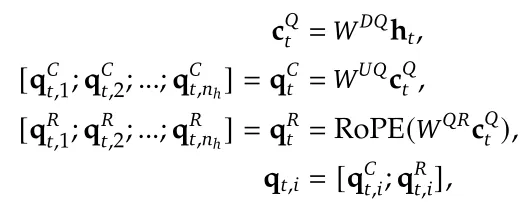

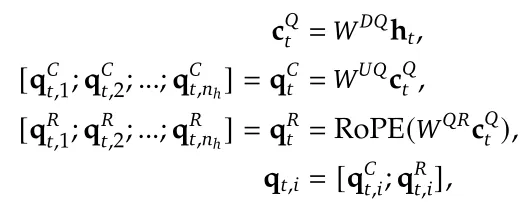

結合圖2和公式,簡單做下MLA的解釋:

- 壓縮潛在向量

計算,用于后續的鍵(Key)和值(Value)的生成;

計算,用于后續的鍵(Key)和值(Value)的生成; - 將壓縮后的潛在向量

映射回原始維度空間以生成鍵

映射回原始維度空間以生成鍵 ;

; - 應用旋轉位置編碼(RoPE)引入位置信息得到

,拼接壓縮后的鍵

,拼接壓縮后的鍵 ,得到

,得到 ;

; - 將壓縮后的潛在向量

映射回原始維度空間得到值

映射回原始維度空間得到值 ;

; - 查詢

的計算方式同理。

的計算方式同理。

這些步驟共同構成了MLA機制中的關鍵部分,通過壓縮和恢復操作減少了計算和存儲需求,同時通過RoPE引入位置信息以保持注意力機制的有效性。這種方法在保持模型性能的同時,提高了推理效率。

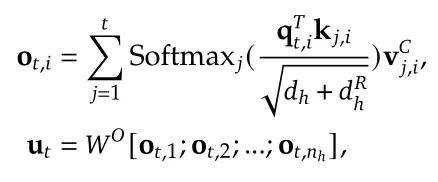

最后通過注意力機制計算公式得到最終的輸出。

DeepSeekMoE

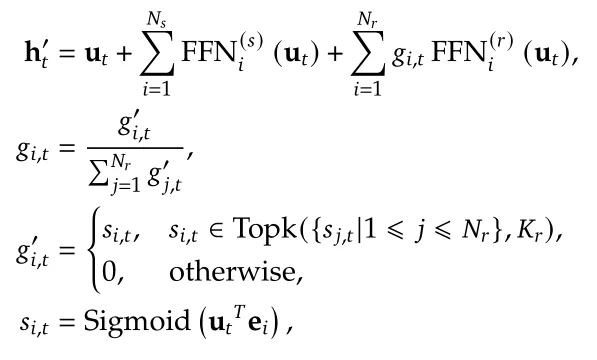

在DeepSeek-V3中,對于前饋網絡(Feed-Forward Networks, FFNs)采用DeepSeekMoE架構。與其它MoE架構(例如GShard)相比,DeepSeekMoE使用更細粒度的專家,并且將一些專家隔離為共享專家。給定輸入 ,其FFN輸出

,其FFN輸出 計算如下:

計算如下:

和

和 分別表示共享專家和路由專家的數量;

分別表示共享專家和路由專家的數量; 和

和 分別表示第 i 個共享專家和第 i 個路由專家;

分別表示第 i 個共享專家和第 i 個路由專家; 表示激活的路由專家數量;

表示激活的路由專家數量; 是第 i 個專家的門控值;

是第 i 個專家的門控值; 是token到專家的親和度,表示第i個token與第i個路由專家之間的相關性或匹配程度;

是token到專家的親和度,表示第i個token與第i個路由專家之間的相關性或匹配程度; 是第 i 個路由專家的中心向量,是每個路由專家的固定表示,用于捕捉專家的特性或專長;Topk(?,K) 表示包含第t 個Token與所有路由專家計算的親和度分數中前 K 個最高分數的集合。

是第 i 個路由專家的中心向量,是每個路由專家的固定表示,用于捕捉專家的特性或專長;Topk(?,K) 表示包含第t 個Token與所有路由專家計算的親和度分數中前 K 個最高分數的集合。

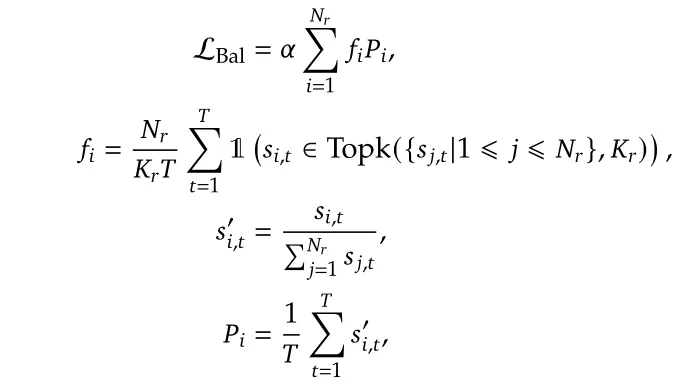

無輔助損失的負載均衡:

MoE模型中,專家負載的不均衡會導致路由崩潰(routing collapse),從而降低計算效率。傳統解決方案通常依賴輔助損失來避免負載不均衡,但過大的輔助損失可能會損害模型性能。

簡單介紹下輔助損失:輔助損失是一種顯式的損失函數,用于鼓勵負載均衡。它通常是一個正則化項,添加到模型的總損失函數中,以懲罰負載不均衡的情況。具體來說,輔助損失會計算每個專家的負載,并對負載不均衡的情況施加懲罰。

為了在負載均衡和模型性能之間取得更好的平衡,DeepSeek-V3引入了無輔助損失的負載均衡策略,無輔助損失是一種不依賴顯式輔助損失函數的負載均衡策略。通過動態調整每個專家的偏置項,而不是通過顯式的損失函數來實現負載均衡。這種策略的目標是在不引入額外損失的情況下,實現高效的負載均衡。

- 偏置項的引入:

其中 是僅用于路由的每個專家的偏置項。

是僅用于路由的每個專家的偏置項。

- 動態調整:

在訓練過程中,持續監控每個訓練步驟中整個批次的專家負載。在每個步驟結束時,如果相應的專家過載,將偏置項減少γ;如果相應專家負載不足,則將其增加γ,γ是一個超參數,稱為偏置更新速度。通過動態調整,DeepSeek-V3在訓練期間保持專家負載均衡,并實現了比通過純輔助損失鼓勵負載均衡的模型更好的性能。

序列級平衡損失:

盡管DeepSeek-V3主要依賴無輔助損失策略來實現負載均衡,但為了防止單個序列內的極端不平衡,DeepSeek-V3還采用了序列級平衡損失:

表示第i個專家在整個序列上的負載比例,

表示第i個專家在整個序列上的負載比例, 衡量第i個專家在整個訓練批次中的負載均衡程度。

衡量第i個專家在整個訓練批次中的負載均衡程度。

另外,為了限制訓練期間的通信成本,V3版本中還采用了節點限制的路由(Node-Limited Routing)這一通信優化策略,通過根據每個節點上分布的專家的最高 親和度分數的總和,確保每個token在訓練過程中最多被發送到M個節點。

親和度分數的總和,確保每個token在訓練過程中最多被發送到M個節點。

由于實施了有效的負載均衡策略,DeepSeek-V3在整個訓練過程中維持了專家之間的負載均衡,避免了過載情況的發生。因此,在訓練階段不會丟棄任何token,確保了訓練數據的完整性和模型性能的穩定性。此外,為了在推理階段也保持負載均衡,DeepSeek-V3實現了特定的部署策略,這樣在推理時也不會丟棄任何token,進一步確保了模型在實際應用中的性能和可靠性。

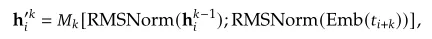

多Token預測

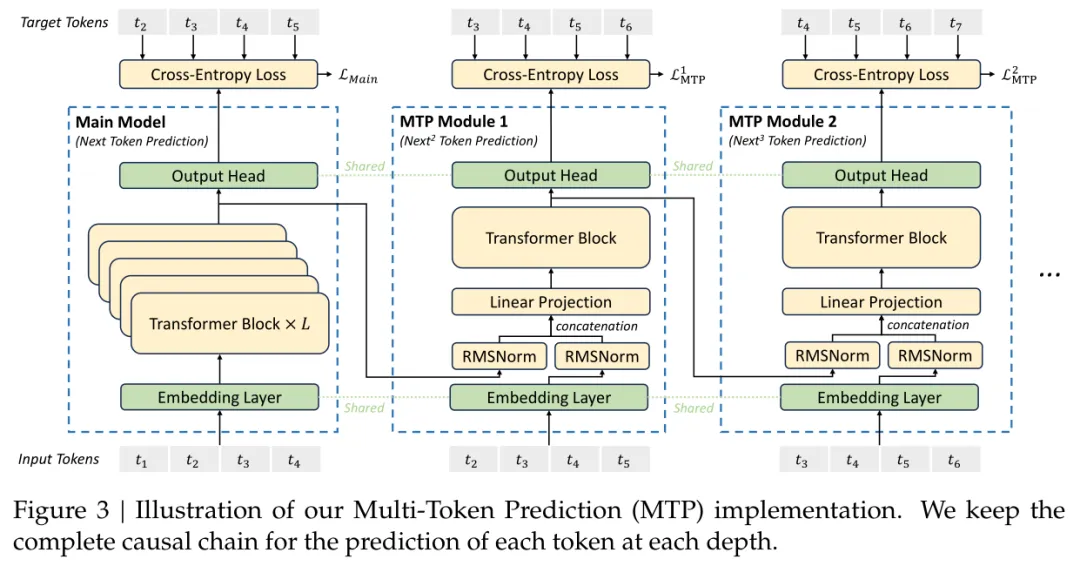

多token預測(MTP)是一種通過擴展模型預測范圍來增強模型性能的訓練策略。通過在訓練期間預測多個未來tokens,MTP可以提高數據效率并可能使模型能夠更好地規劃其表示以進行更遠未來的預測。在推理階段,MTP模塊可以被丟棄,而主模型可以獨立運行,同時也可以用于推測性解碼以提高生成速度。這種方法在提高模型性能的同時,也為推理加速提供了可能性。

MTP模塊由多個順序排列的子模塊組成,每個子模塊負責預測一個額外的未來Token。每個子模塊包含以下組件:

- 共享嵌入層(Embedding Layer):與主模型共享,用于將輸入Token映射到嵌入空間。

- 投影矩陣(Projection Matrix):用于將當前Token的表示與后k個Token的嵌入組合起來,作為Transformer塊的輸入。

- Transformer塊(Transformer Block):用于處理輸入表示并生成輸出表示。

- 輸出頭(Output Head):與主模型共享,用于將Transformer塊的輸出映射到詞匯表的概率分布。

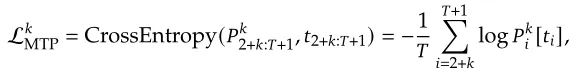

- 訓練目標:對于每個MTP模塊,計算一個交叉熵損失(Cross-Entropy Loss),衡量預測分布與真實Token之間的差異:

總損失:將所有MTP模塊的損失加權平均,得到最終的MTP損失:

2、預訓練Pre-training

數據構建

與DeepSeek-V2相比,DeepSeek-V3的數據集在多語言覆蓋上進行了優化,特別是增加了數學和編程樣本的比例,并擴展了除英語和中文之外的多語言覆蓋。另外數據處理流程經過優化,以減少冗余并保持數據集的多樣性。最終DeepSeek-V3的預訓練語料庫由14.8萬億個高質量和多樣化的token組成。

Fill-in-Middle (FIM) 策略:FIM策略能夠使模型在保持下一個Token預測能力的同時,能夠使模型根據上下文線索準確預測中間文本。

具體來說,采用前綴-后綴-中間(Prefix-Suffix-Middle, PSM)框架來結構化數據,如下所示:

<|fim_begin|>/pre<|fim_hole|>/sur<|fim_end|>/middle<|eos_token|>.

其中,/pre和/suf是上下文文本,/middle是需要預測的中間文本。這種結構在文檔級別上作為預打包過程的一部分應用。

DeepSeek-V3的Tokenizer采用了字節級BPE(Byte-level BPE),擴展了詞匯表到128K個token。并且在此基礎上,Tokenizer的預處理和訓練數據經過優化,與DeepSeek-V2相比,新的預處理引入了結合標點符號和換行符的token,以提高多語言壓縮效率。但這種技巧可能會在處理多行提示時引入邊界偏差,為了緩解這種邊界偏差,DeepSeek團隊在訓練中隨機分割了一定比例的這種組合token,使模型能夠接觸到更廣泛的特殊情況,從而減輕偏差。

長上下文擴展

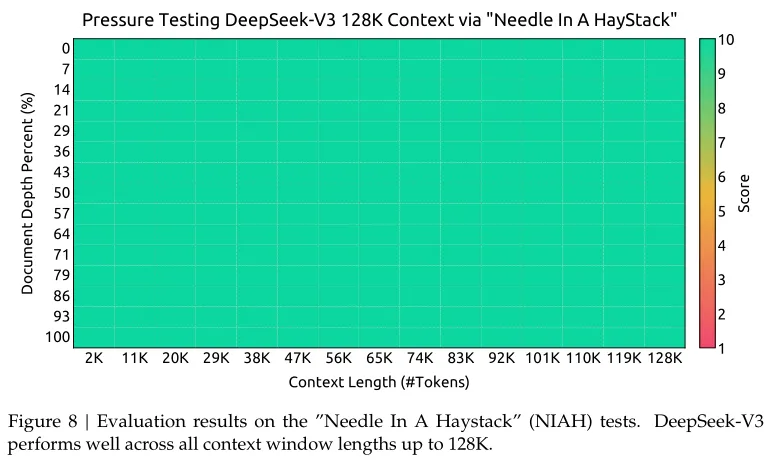

在預訓練階段之后,應用YaRN進行上下文擴展,并執行兩個額外的訓練階段,每個階段包含 1000 步,以逐步將上下文窗口從 4K 擴展到 32K,然后再擴展到 128K。

通過這兩個階段的擴展訓練,DeepSeek-V3 能夠處理長達 128K 的輸入,同時保持強大的性能。圖 8 展示了 DeepSeek-V3 在經過監督微調后,在“Needle In A Haystack”(NIAH)測試中的顯著表現,展示了其在長達 128K 的上下文窗口長度上的一致性魯棒性。

3、后訓練Post-training

推理數據構建

對于與推理相關的數據集,包括數學、代碼競賽問題和邏輯謎題,數據是通過內部的DeepSeek-R1模型生成的。盡管R1生成的數據具有較高的準確性,但存在過度思考、格式不佳和長度過長等。為了平衡高準確性和清晰簡潔性,作者采用了以下方法:

- 開發專家模型:針對特定領域(如代碼、數學或一般推理),開發了一個專家模型,使用結合監督微調(SFT)和強化學習(RL)的訓練流程。這個專家模型作為最終模型的數據生成器。

- 生成SFT樣本:訓練過程中,為每個實例生成兩種不同類型的SFT樣本:

原始響應樣本:將問題與其原始響應配對,格式為<問題, 原始響應>。

系統提示樣本:將系統提示與問題和R1響應結合,格式為<系統提示, 問題, R1響應>。

系統提示經過精心設計,包含指導模型生成帶有反思和驗證機制的響應的指令。在 RL 階段,模型利用高溫采樣生成結合了 R1 生成數據和原始數據模式的響應,經過數百個 RL 步驟后,中間 RL 模型學會了整合 R1 模式,從而戰略性地提升整體性能。

專家模型作為數據生成源,在完成 RL 訓練階段后,實施拒絕采樣以篩選高質量的 SFT 數據用于最終模型。這種方法確保最終訓練數據保留了 DeepSeek-R1 的優勢,同時生成簡潔且有效的響應。

非推理數據構建

對于非推理數據,如創意寫作、角色扮演和簡單問答,使用 DeepSeek-V2.5 生成響應,并由人工標注員驗證數據的準確性和正確性。

強化學習

強化學習同R1,這里不過多介紹,簡單附上相關內容:

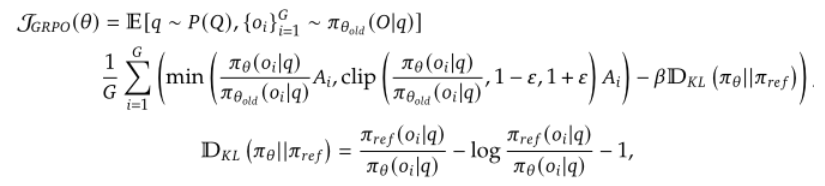

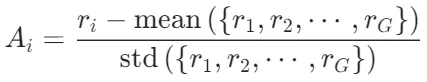

組相對策略優化(GRPO):在傳統的強化學習設置中,通常需要一個與策略模型大小相同的批評模型來估計基線。為了降低RL訓練成本,DeepSeek-R1-Zero采用了GRPO方法。

對于每個問題q,GRPO從舊策略 中采樣一組輸出

中采樣一組輸出 ,然后通過最大化目標函數來優化策略模型

,然后通過最大化目標函數來優化策略模型 :

:

其中?和β是超參數,分別控制裁剪范圍和KL散度的權重, 是優勢值,計算方式如下:

是優勢值,計算方式如下:

是第i個輸出對應的獎勵,而均值和標準差是基于整個組的獎勵計算得出的。這種標準化處理有助于穩定訓練過程,并使得不同輸出間的比較更加公平。

是第i個輸出對應的獎勵,而均值和標準差是基于整個組的獎勵計算得出的。這種標準化處理有助于穩定訓練過程,并使得不同輸出間的比較更加公平。

獎勵模型

在 RL 過程中使用了基于規則的獎勵模型(Rule-Based RM)和基于模型的獎勵模型(Model-Based RM)。

基于規則的獎勵模型:對于可以通過特定規則驗證的問題,采用基于規則的獎勵系統來確定反饋。例如,某些數學問題具有確定性的結果,要求模型在指定格式(例如在一個框中)提供最終答案,從而允許應用規則來驗證其正確性。

基于模型的獎勵模型:對于具有自由形式真實答案的問題,依賴獎勵模型來確定響應是否符合預期的真實答案。相反,對于沒有明確真實答案的問題(如涉及創意寫作的問題),獎勵模型的任務是根據問題和相應的答案提供反饋。獎勵模型是從 DeepSeek-V3 SFT 檢查點訓練的。

4、Infra

- 對于Infra,了解較少,簡單介紹下,后續再深度解讀這一章節。

計算集群

DeepSeek-V3的訓練是在一個強大的計算集群上完成的,該集群配備了2048個NVIDIA H800 GPU。這種大規模的GPU集群為模型的訓練提供了強大的計算能力。具體來說:

- 節點配置

每個節點包含8個GPU,這些GPU通過NVLink和NVSwitch在節點內部進行高速連接。這種連接方式能夠實現節點內部的高效通信,減少數據傳輸的延遲。

- 跨節點通信

不同節點之間的通信則通過InfiniBand(IB)網絡實現。IB網絡以其高帶寬和低延遲的特點,能夠有效地支持大規模分布式訓練中的數據傳輸需求。

這種集群配置結合了節點內部的高速NVLink連接和跨節點的IB網絡,為DeepSeek-V3的分布式訓練提供了強大的硬件支持。

訓練框架

DeepSeek-V3的訓練由HAI-LLM框架支持,這是一個高效且輕量級的訓練框架,專為大規模模型訓練設計。該框架采用了多種并行化策略來提高訓練效率,具體包括:

- 16路管道并行(Pipeline Parallelism, PP)

將模型的不同層分配到不同的GPU上,通過流水線的方式進行并行計算,減少單個GPU的計算負擔。

- 64路專家并行(Expert Parallelism, EP)

跨越8個節點,支持大規模的Mixture-of-Experts(MoE)架構,通過并行化專家層的計算來提高效率。

- ZeRO-1數據并行(Data Parallelism, DP)

通過優化內存管理和通信效率,進一步提升訓練速度。

為了進一步優化訓練過程,DeepSeek-V3實施了以下工程優化策略:

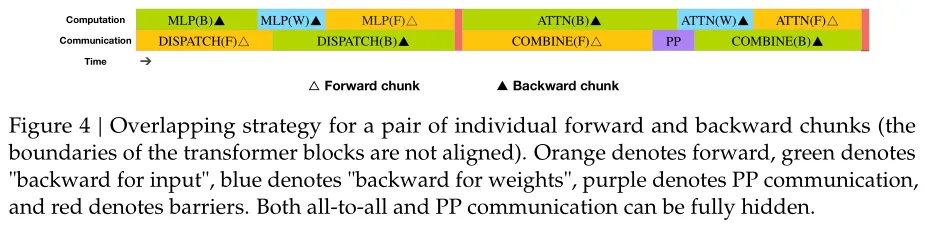

- DualPipe與計算-通信重疊

DualPipe算法是DeepSeek-V3的一個關鍵創新,旨在解決跨節點專家并行帶來的通信開銷問題。具體優化措施包括:

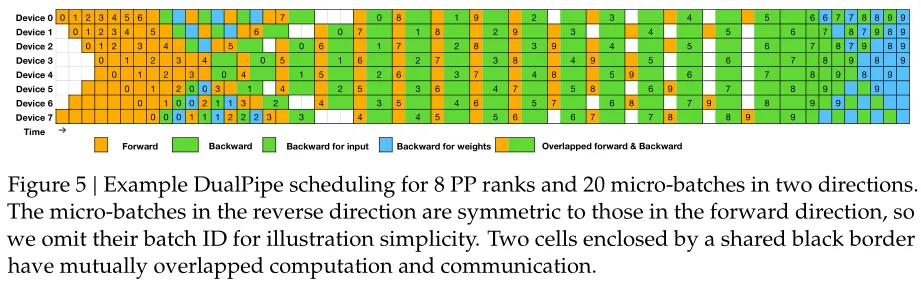

重疊計算和通信:DualPipe算法通過在前向和后向過程中重疊計算和通信階段,減少了管道氣泡,提高了訓練效率。每個塊被分為四個組件:注意力、全對全分發、MLP和全對全組合。后向塊中的注意力和MLP進一步分為輸入的后向和權重的后向,類似于ZeroBubble算法。

雙向管道調度:采用雙向管道調度,同時從管道的兩端輸入微批次,大部分通信可以完全重疊,從而實現接近零的全對全通信開銷。這種策略確保了即使模型進一步擴展,只要保持恒定的計算與通信比例,就可以在跨節點上使用細粒度專家,而不會增加額外的通信成本。

- 跨節點全對全通信的高效實現

為了充分利用IB和NVLink的帶寬,DeepSeek-V3開發了高效的跨節點全對全通信內核。具體措施包括:

限制Token分發:每個Token最多分發到4個節點,減少IB流量。

通信重疊:通過NVLink即時轉發Token,確保IB和NVLink的通信完全重疊,提高通信效率。

Warp specialization技術:將20個SM劃分為10個通信通道,動態調整每個通信任務的warp數量,減少對計算資源的占用。

定制PTX指令:采用定制的PTX指令,自動調整通信塊大小,減少L2緩存的使用和對其他SM的干擾。

這些優化措施顯著提高了跨節點通信的效率,減少了通信開銷。

- 極低內存占用與最小開銷

為了減少訓練期間的內存占用,DeepSeek-V3采用了以下技術:

RMSNorm和MLA上投影的重計算:在反向傳播期間重新計算所有RMSNorm操作和MLA上投影,避免了持久存儲其輸出激活的需求,顯著減少了內存占用。

CPU中的指數移動平均(EMA):將EMA參數存儲在CPU內存中,并在每個訓練步驟后異步更新,避免了額外的內存和時間開銷。

多Token預測的共享嵌入和輸出頭:通過將模型的最淺層和最深層部署在同一個PP等級上,實現MTP模塊和主模型之間的物理共享,進一步提高了內存效率。

這些內存優化措施使得DeepSeek-V3能夠在不使用昂貴的張量并行(TP)的情況下進行訓練,顯著降低了訓練成本。

FP8 訓練

FP8訓練是DeepSeek-V3的一個重要創新,旨在通過低精度計算提高訓練效率,同時保持模型的數值穩定性。

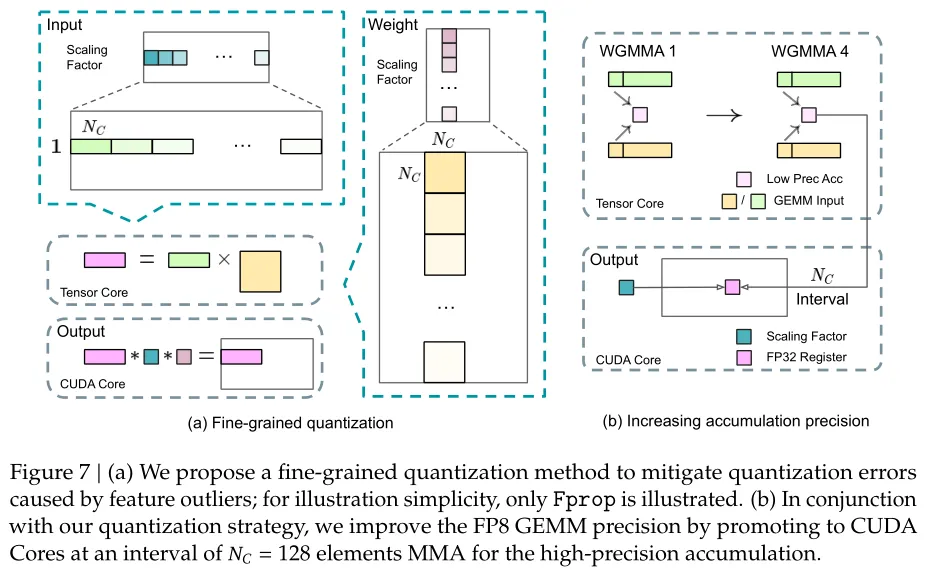

DeepSeek-V3采用了一種細粒度的混合精度框架,利用FP8數據格式進行訓練。該框架的主要特點包括:

- 核心計算的低精度化:

GEMM操作:大多數核心計算內核(如矩陣乘法GEMM)以FP8精度執行。這些操作接受FP8張量作為輸入,并生成BF16或FP32輸出。例如,前向傳播(Fprop)、激活反向傳 播(Dgrad)和權重反向傳播(Wgrad)均以FP8精度執行。這種設計理論上比BF16方法快一倍,并且顯著減少了內存消耗。

存儲優化:FP8 Wgrad GEMM允許激活以FP8格式存儲,用于反向傳播,進一步減少了內存使用

- 關鍵操作的高精度保留:

嵌入模塊、輸出頭、MoE門控模塊、歸一化算子和注意力算子:這些操作對精度較為敏感,因此保留其原始精度(如BF16或FP32),以確保訓練的數值穩定性。

主權重、權重梯度和優化器狀態:這些關鍵參數以更高精度存儲,以保證訓練過程中的數值穩定性。通過在分布式訓練系統中跨多個數據并行(DP)等級進行分片,可以最小化這些高精度組件帶來的內存開銷。

為了提高低精度訓練的準確性,DeepSeek-V3引入了多種策略,重點關注量化方法和乘法過程:

- 細粒度量化:

激活量化:激活值以1x128的瓦片為基礎進行分組和縮放,即每個Token每128個通道。這種方法能夠更好地適應激活值中的異常值,減少量化誤差。

權重量化:權重以128x128的塊為基礎進行分組和縮放,即每128個輸入通道每128個輸出通道。這種塊級量化方法能夠有效管理權重中的異常值。

每組縮放因子:在GEMM操作的內部維度上引入每組縮放因子,這在標準FP8 GEMM中并不直接支持。結合精確的FP32累積策略,可以高效實現這一功能。

- 增加累積精度:

提升到CUDA Core:為了提高FP8 GEMM的精度,DeepSeek-V3采用了一種策略,將中間結果從Tensor Core提升到CUDA Core進行高精度累積。具體來說,當累積間隔達到128個元素時,將部分結果復制到CUDA Core上的FP32寄存器中,進行全精度累積。這種策略顯著提高了計算精度,同時保持了Tensor Core的高利用率。

最小累積間隔:實驗表明,設置累積間隔為128個元素(相當于4個WGMMA操作)是提高精度與引入開銷之間的最佳平衡點。

- 尾數優先于指數:

E4M3格式:與之前工作采用的混合FP8格式(如E4M3用于前向傳播,E5M2用于反向傳播)不同,DeepSeek-V3在所有張量上采用E4M3格式(4位指數和3位尾數),以獲得更高精度。這種方法的可行性歸因于細粒度量化策略,即瓦片和塊級縮放。

- 在線量化:

動態縮放:在線計算每個1x128激活瓦片或128x128權重塊的最大絕對值,并基于此導出縮放因子,然后將激活或權重在線量化為FP8格式。這種方法避免了延遲量化中保留歷史最大值的復雜性,簡化了框架設計。

結合FP8訓練框架,DeepSeek-V3進一步減少了內存消耗和通信開銷:

- 低精度優化器狀態:

BF16格式:采用BF16數據格式跟蹤AdamW優化器中的第一和第二矩,顯著減少了內存占用,同時保持了訓練精度。

主權重和梯度:主權重和梯度仍然以FP32格式存儲,以確保數值穩定性。

- 低精度激活:

FP8緩存:在Wgrad操作中,激活以FP8格式緩存,顯著減少了內存使用。

- 特殊處理:

注意力算子后的線性算子輸入:這些激活對精度較為敏感,因此采用定制的E5M6數據格式,并在反向傳播中從1x128量化瓦片轉換為128x1瓦片。

MoE中的SwiGLU算子輸入:為了進一步減少內存成本,這些激活在反向傳播中重新計算,采用FP8格式存儲,以平衡內存效率和計算精度。

- 低精度通信:

激活量化:在MoE上投影之前,將激活量化為FP8,然后應用分發組件,以減少通信開銷。

保留關鍵部分的高精度:對于前向和后向組合組件,仍然以BF16格式保留,以保持訓練精度。

5、預訓練結果

基準數據集

- 多學科多項選擇:MMLU、MMLU-Redux、MMLU-Pro、MMMLU、C-Eval 和 CMMLU。

- 語言理解和推理:HellaSwag、PIQA、ARC 和 BigBench Hard(BBH)。

- 閉卷問答:TriviaQA 和 NaturalQuestions。

- 閱讀理解:RACE、DROP、C3 和 CMRC。

- 指代消解:CLUEWSC 和 WinoGrande。

- 語言建模:Pile。

- 中文理解和文化:CCPM。

- 數學:GSM8K、MATH、MGSM 和 CMath。

- 代碼:HumanEval、LiveCodeBench-Base(0801-1101)、MBPP 和 CRUXEval。

- 標準化考試:AGIEval,包括英語和中文子集。

指標

- 準確率(EM, Exact Match):用于衡量模型生成的文本與參考答案完全匹配的比例。

- F1分數:用于衡量模型生成的文本與參考答案的重疊程度,通常用于閱讀理解和問答任務。

- 通過率(Pass@1):用于衡量模型生成的代碼或解決方案通過測試的比例,通常用于代碼生成和編程競賽任務。

- 困惑度(Perplexity):用于衡量模型對文本序列的預測不確定性,數值越低表示模型的預測越準確。

- 每字節比特數(BPB, Bits-Per-Byte):用于衡量模型對每個字節的預測不確定性,數值越低表示模型的預測越準確,適用于語言建模任務。

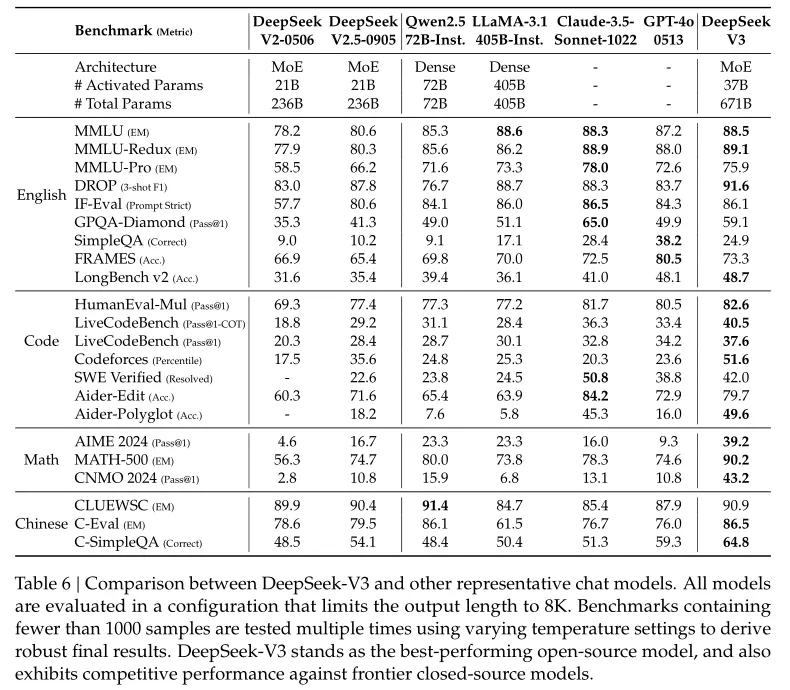

主要結果

DeepSeek-V3-Base在幾乎所有基準測試中都顯著優于DeepSeek-V2-Base和 Qwen2.5 72B Base,并且在大多數基準上超越了 LLaMA-3.1 405B Base(激活參數是DeepSeek-V3的11倍),基本上成為了最強的開源模型。

多Token預測(MTP)策略的影響

在多個基準測試中,使用MTP策略在大多數評估基準上一致地提升了模型性能

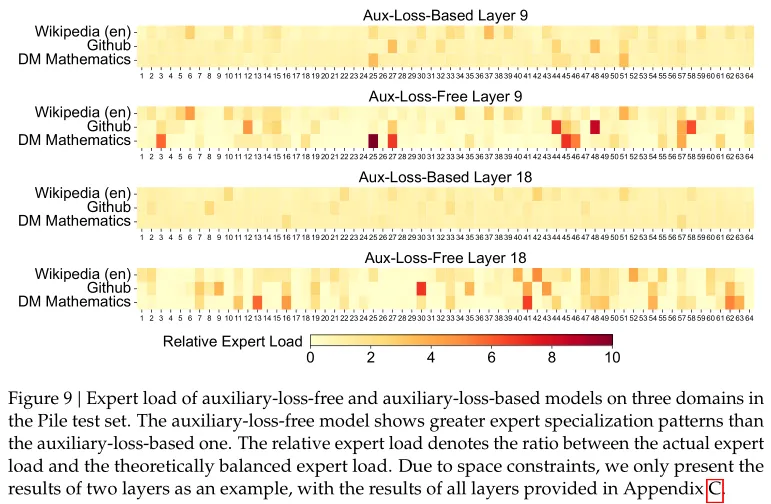

無輔助損失的負載平衡策略

從表5中可以看出,與傳統的基于輔助損失的負載平衡方法相比,DeepSeek-V3采用的無輔助損失策略在大多數評估基準上一致地實現了更好的模型性能。

批次級負載均衡與序列級負載均衡

通過對比無輔助損失方法(即批次級負載均衡)與序列級輔助損失方法,研究兩者在平衡范圍上的不同(批次級 vs 序列級),以及這種差異如何影響專家模型的專業化程度。

實驗結果顯示,批次級負載均衡不僅促進了專家的專業化,還可能帶來更好的模型性能或至少不劣于序列級負載均衡方法。

盡管無輔助損失策略是主要方法,但為了防止極端不平衡,作者還是引入了序列級輔助損失。這個輔助損失的權重非常小(α\alphaα=0.0001),其主要目的是避免在單個序列中出現極端不平衡的情況,而不是強制每個序列內的負載完全均衡。

6、后訓練結果

基準數據集

除基礎模型測試基準外,仍使用了下列基準數據集:

- 語言理解與問答:IFEval、FRAMES、LongBench v2、GPQA、SimpleQA、C-SimpleQA、

- 代碼生成與軟件工程:SWE-Bench Verified、Aider 1、LiveCodeBench(2024年8月至11月的問題)、Codeforces 2

- 數學問題解決:CNMO 2024(中國國家高中數學奧林匹克)、AIME 2024(美國數學邀請賽)

- 多語言能力:C-SimpleQA

- 開放性對話與生成:IFEval、FRAMES

結果

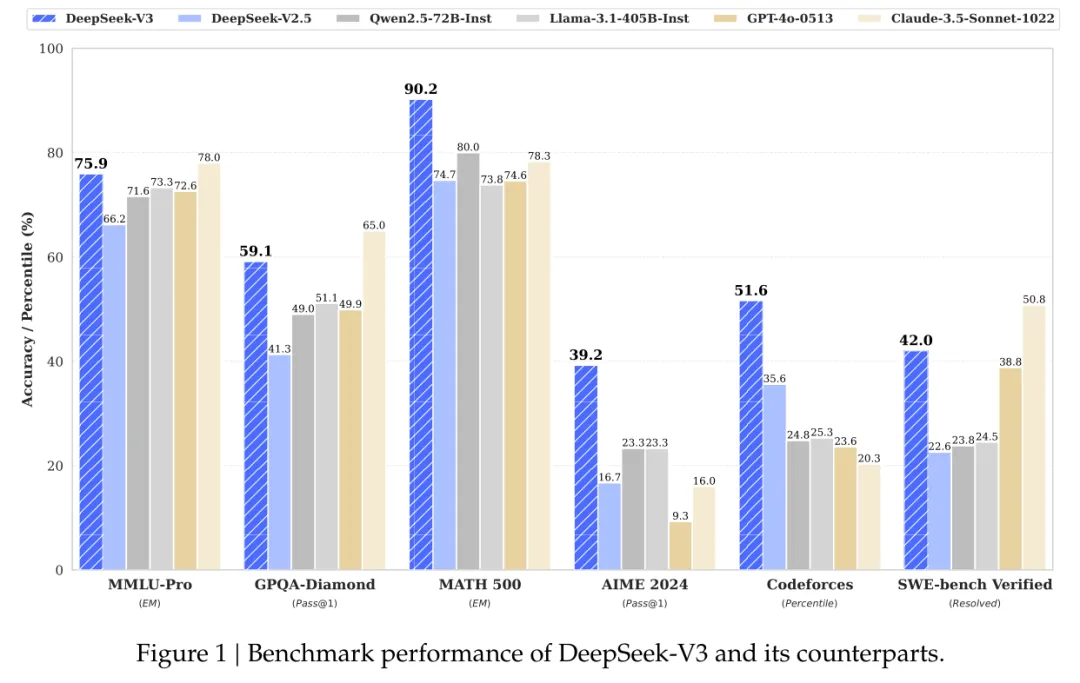

在所有評估基準中,幾乎全部超越頂級開源模型Qwen-2.5 72B-Inst和LLaMA-3.1 405B-Inst,與頂級閉源模型如GPT-4o和Claude-3.5-Sonnet的競爭中也展現出相當的競爭力

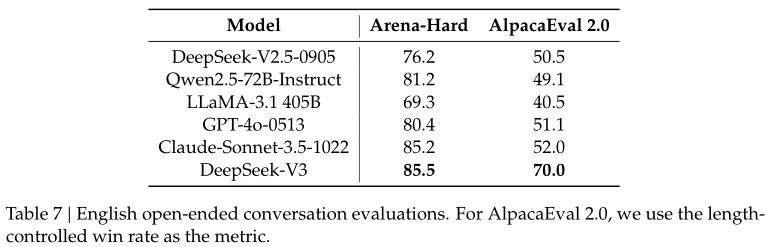

開放性評估

AlpacaEval 2.0:在簡單任務寫作和問答場景中,DeepSeek-V3的準確率達到70.0,顯著優于其他模型。

Arena-Hard:在復雜提示處理任務中,DeepSeek-V3的勝率達到85.5,與Claude-3.5-Sonnet相當,成為首個超過85%的開源模型。

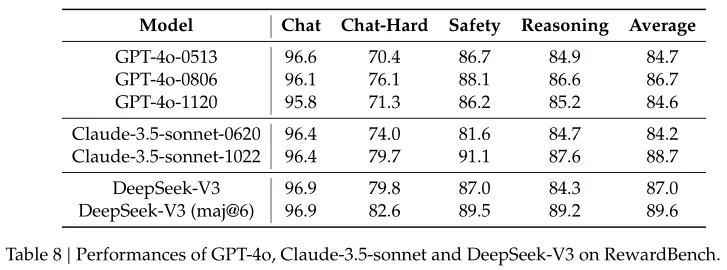

作為生成式獎勵模型

DeepSeek-V3在RewardBench上的表現與GPT-4o和Claude-3.5-Sonnet相當,顯示出其作為生成式獎勵模型的潛力。通過投票機制,DeepSeek-V3的性能可以進一步提升。

知識蒸餾的有效性

基于 DeepSeek-V2.5 消融了從 DeepSeek-R1 進行蒸餾的貢獻。通過從DeepSeek-R1系列模型中蒸餾推理能力,DeepSeek-V2.5在代碼生成和數學問題解決任務中表現出顯著提升。

文中提出:研究表明,從推理模型進行知識蒸餾為后訓練優化提供了一個有前景的方向。雖然目前的工作集中在從數學和編碼領域蒸餾數據,但這種方法顯示出在需要復雜推理的其他認知任務中增強模型性能的潛力。這些特定領域的有效性表明,長 CoT 蒸餾對于增強其他領域的模型性能可能具有重要價值。進一步探索這一方法在不同領域的應用仍然是未來研究的重要方向。

自我獎勵機制

在強化學習(RL)中,獎勵信號對于指導模型的學習過程至關重要。然而,在很多實際應用場景中,并沒有簡單的方法來獲得準確的外部獎勵信號,特別是在那些難以通過自動化工具驗證的任務中。DeepSeek-V3采用了所謂的“憲法AI”方法,這是一種利用模型自身能力來評估結果并提供反饋作為獎勵信號的技術。

具體來說,這種方法依賴于DeepSeek-V3模型自己對生成內容進行投票評估,以此作為自我獎勵的基礎。這種策略不僅增強了模型與人類價值觀的一致性(即對齊),而且提高了其在主觀評估任務中的表現。此外,通過整合額外的“憲法輸入”,即一組預定義的原則或指導方針,可以引導模型朝著更符合預期的方向優化。

多Token預測的評估:DeepSeek-V3通過多Token預測(MTP)技術,在推理過程中實現了顯著的加速。實驗表明,額外預測的Token接受率在85%到90%之間,表現出了一致的可靠性,使得模型的解碼速度提升了1.8倍。

7、總結

從結構上來看,DeepSeek-V3的三大貢獻主要是:

- 多頭潛在注意力機制MLA,通過低秩壓縮注意力鍵(Key)和值(Value),減少了在推理時需要緩存的KV空間,在保證模型的表達能力的同時提高了訓練和推理的效率,并降低了內存消耗。

- MoE,根據輸入數據的特點,動態路由輸入數據到最合適的專家子集,只激活相關的專家,從而減少不必要的計算,提高計算效率。并且MoE結構可以增加更多的專家,很容易擴展到更大的規模以處理更復雜的任務,不同的專家也可以專門化處理不同類型的數據或任務,從而提高模型在特定任務上的性能。

- 多Token預測MTP,在傳統的訓練過程中,模型通常只預測下一個Token。而MTP策略要求模型預測多個未來的Tokens,這增加了訓練信號的數量,從而可能提高模型的學習效率和性能。并且MTP通過預測多個未來的Tokens,可以幫助模型更好地規劃其內部表示,從而改善對長序列的建模能力。在推理階段,MTP可以被用來實現推測性解碼(speculative decoding),即模型可以并行生成多個Tokens,而不是一個接一個地生成。這種方法可以顯著提高生成速度,從而減少推理時間。

在DeepSeek-V3的技術報告中,還詳細介紹了工程訓練中算法、框架和硬件的協同設計,尤其是設計了FP8混合精度訓練框架,解決了跨節點MoE訓練中的通信瓶頸問題,實現了計算與通信的高效重疊,顯著降低了訓練成本。對大模型開發具有非常強的指導和參考意義。

這里還有一個細節,在DeepSeek-V3的開發過程中,DeepSeek-R1就已經被用作知識蒸餾的源模型,以提升DeepSeek-V3的推理能力。這里猜測R1是根據V2.5訓練得到,并且報告中提到DeepSeek-R1生成的數據存在過度思考、格式不佳和長度過長等問題,這里猜測是DeepSeek-R1-Zero版本。從這里猜測,DeepSeek團隊在V3發布之前就已經有了R1的初代模型訓練和使用,并在V3發布之后,繼續基于V3訓練了更強大更完善的R1模型。