簡單示例提升DeepSeek-R1美國數學邀請賽AIME分數:以步驟為粒度對齊上下文學習與推理

僅需簡單提示,滿血版DeepSeek-R1美國數學邀請賽AIME分數再提高。

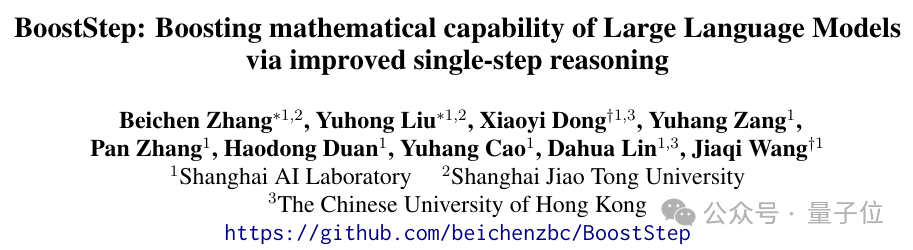

上海交大、港中文、上海AI實驗室等帶來最新成果BoostStep對齊推理和上下文學習粒度,大幅提升上下文學習性能,突破少樣本學習上限。

圖片

圖片

大語言模型使用多步推理解決復雜數學問題,即先將復雜問題分解為多個步驟并逐步進行推理。

研究人員實驗發現后者是推理效果的瓶頸:大模型雖能進行有效的問題拆解,但在單步推理時往往出現錯誤。

上下文學習則通過引入相似例子為大語言模型提供完整思路與單步推理的指導,而傳統的上下文學習在步驟粒度沒有與推理進行對齊,在輔助關鍵的單步推理時仍有顯著缺陷。

具體而言,傳統的少樣本學習往往以題目為粒度進行檢索與指導,因此會缺乏解決關鍵推理步驟所需的示例。此外,無關的步驟甚至還對推理有負面影響。

為此,來自上海交通大學,香港中文大學和上海人工智能實驗室的研究人員提出BoostStep策略,以步驟為粒度對上下文檢索和推理的粒度進行了對齊,通過“首次嘗試”策略為每個推理步驟提供高度相關的ICL示例。

BoostStep提供了更細粒度的指導,避免無關信息干擾,在不同數學測試集上為GPT-4o帶來4.6%的提升,大幅超過傳統少樣本學習的1.2%。

此外,BoostStep具有傳統少樣本學習不具備的“簡單指導困難”的潛力,僅用MATH數據集簡單示例就能幫助Deepseek-R1-671B模型在美國數學邀請賽(AIME)上獲得2.2%的提升。

△圖1:BoostStep效果與應用場景總覽

△圖1:BoostStep效果與應用場景總覽

動機:傳統的少樣本學習無法有效提升單步推理能力

上下文學習是提升模型數學推理能力常用的策略。

具體而言,引入相似的例題有兩種指導效果,其一是可以給模型提供大致的推理思路,其二是在具體單步推理時提供指引,這也對應模型在解決復雜問題時采用的多步分解,逐一推理策略。

研究人員實驗發現后者是制約當前模型推理的關鍵:給GPT-4o-mini提供標準解答過程,讓其判斷另一段錯誤的解答過程是由于總體推理思路出錯還是具體單步推理有誤。

針對較弱的模型(如LLama-3.1-8B),有91.3%的錯誤是由于單步推理,而到了更加先進的模型(如GPT-4o),這個數字提升到了99.2%這個夸張的比例,說明相較于問題分解,單步推理能力是目前大模型推理的短板。

然而,以題目為粒度的上下文學習很難在單步推理時的指導有限。由于傳統的少樣本學習是以整道題目為粒度進行檢索和引導,無法在更細粒度的步驟層面確保例題和正在進行的推理依然具有強相關性,而這些無關的步驟甚至還會對推理產生負面作用。此外,例題是在推理開始前就提供給模型,因此缺乏在推理過程中的實時指導。

由此,研究人員提出BoostStep策略,將上下文學習中檢索和指導的粒度由整道題目細化到每一個步驟,來確保提供的示例在步驟粒度仍然高度一致。

方法:通過“初次嘗試”策略以步驟為粒度提供指導

想要實驗步驟粒度的上下文學習,需要構建步驟粒度的題庫,并設計出更加合適的檢索策略,以下會對BoostStep的方法進行詳細闡述。

步驟粒度題庫的構建

目前的開源數學數據集往往只包含題目和其對應的完整解答過程,并沒有細分到每一步。某些方法(如PRM800K)通過明確的語義分割,如句號、換行符等將一段完整的解答分割為不同的步驟。這種策略簡潔有效,然而,其并不符合步驟的本質。步驟之所以成為推理的原子粒度,正是由于每一步只負責解決一個很小的目標,包含一個完整的思維過程。而通過語義分隔符會破壞這種原子性,如將一個完整的枚舉過程拆成很多步。

由此,研究人員以推理內容本身為依據,通過提示詞讓GPT-4o進行步驟的分解,這種策略保證了分割好的步驟的粒度與未來進行的推理高度一致,從而能夠給出全面而有效的指導。實驗證明這種策略相較于語義分割策略有顯著的優勢,在AMC和MATH評測集上能獲得約3.5%的提升。

“首次嘗試”檢索策略

上下文學習的核心在于檢索到高度相關的例子,因而檢索策略對上下文學習的效果至關重要。傳統以題目為粒度的少樣本學習通常是從題庫中搜索與待測題目最為接近的題目,這種策略簡潔有效,因為相似的題目往往包含相似的解答過程。

然而,到了更加細粒度的步驟粒度,情況則更加復雜。以上一步為檢索根據會搜索到無關的步驟,這是由于步驟之間具有一定的獨立性,相似的上一步完全可以用于得到截然不同的下一步。而根據之前所有步驟進行檢索又會喪失對當下步驟的突出,無法檢索到最合適的例子。

研究人員認為最準確的預估當下步驟的策略正是讓模型嘗試進行一次推理,并基于此提出了“首次嘗試”的檢索策略。

具體而言,在每一步進行推理時,模型首先進行一次零樣本嘗試,并根據該嘗試從題庫中檢索得到最相似的步驟,在這一步的指導下完成最終的推理。

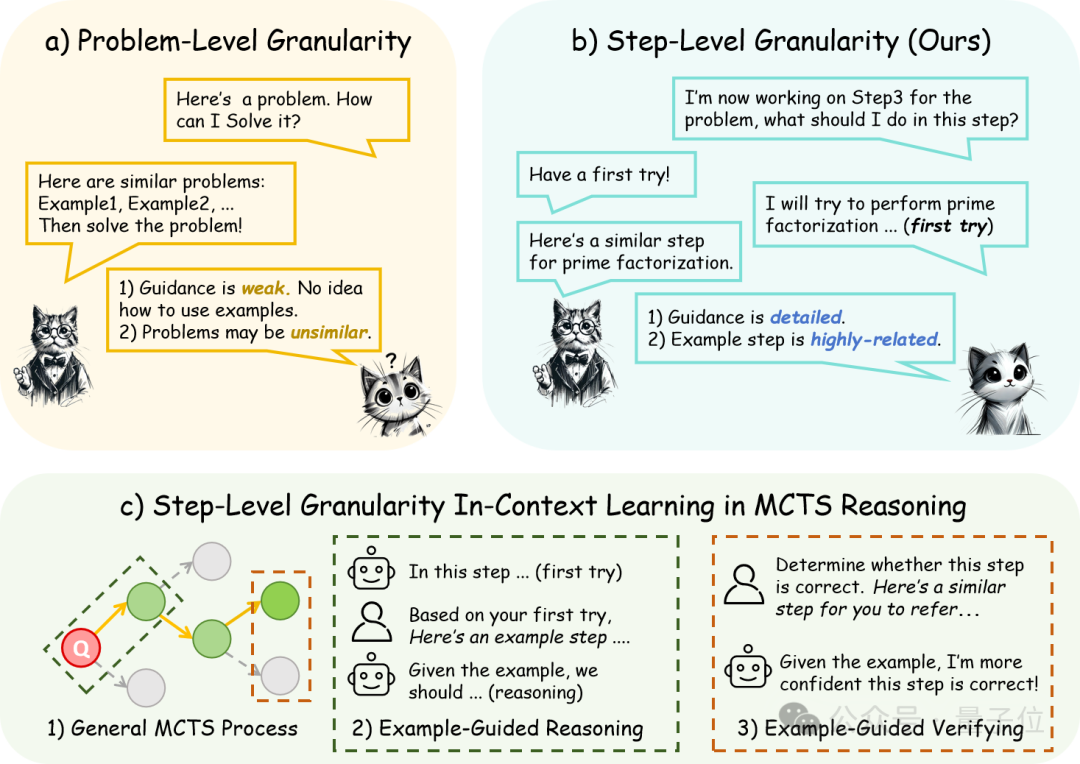

下圖是一個BoostStep進行首次嘗試、例題查找與再次推理的具體示例。在首次嘗試時正切公式運用錯誤,但得以精確了解當前步驟的推理內容,從而檢索到合適的例子,并在正式推理時正確應用正切公式。

圖片

圖片

實驗:BoostStep在性能、潛力、泛化等方面均大幅優于傳統的少樣本學習

3.1性能

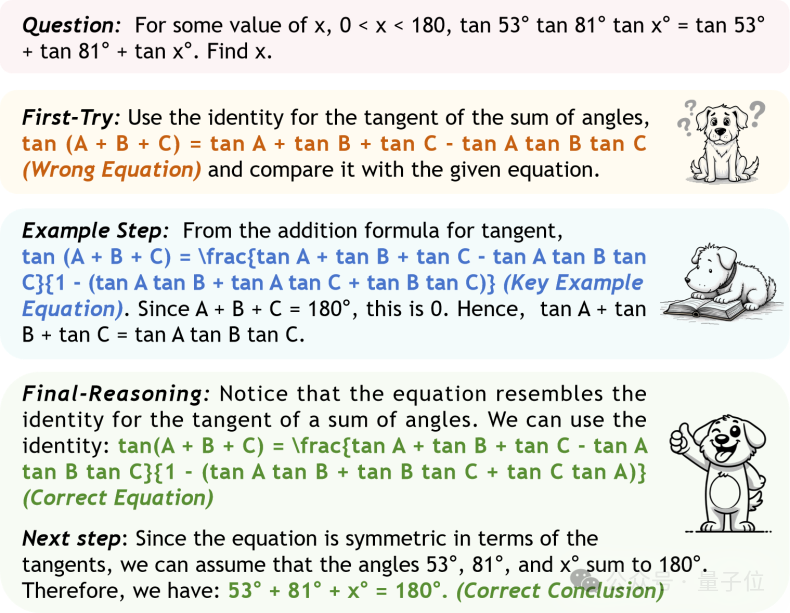

BoostStep能夠在推理中根據當前的step實時提供更加合適的步驟示例,因而能提供更加有效的引導。BoostStep在不同數學評測集上能夠為GPT-4o和Qwen2.5-Math-72B帶來4.6%與2.2%的進一步提升,遠遠超過傳統題目粒度的少樣本學習。

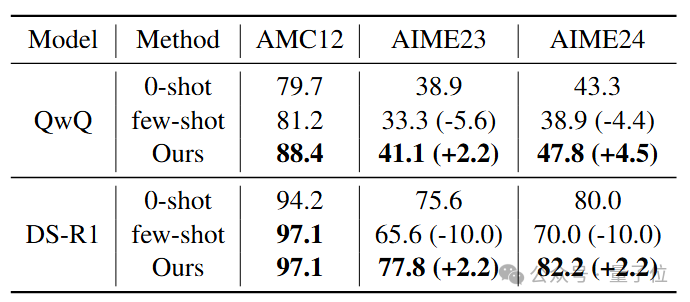

△圖3:在不同數學評測集與不同基模型上BoostStep的效果均優于傳統少樣本學習

3.2潛力

傳統的少樣本學習很難做到通過簡單的示例提升困難問題上的推理性能,這限制了上下文學習的潛力。而BoostStep通過將引導細分到步驟層級突破了這層限制。借助MATH數據集中較為簡單的示例,BoostStep能夠幫助最強的推理模型Qwen-QwQ和DeepseekR1在最難的美國數學邀請賽(AIME)上分別獲得平均3.4%和2.2%的提升。

圖片

圖片

△圖4:BoostStep能夠利用簡單示例提升強推理模型在高難度評測集上的推理性能

3.3 泛化性

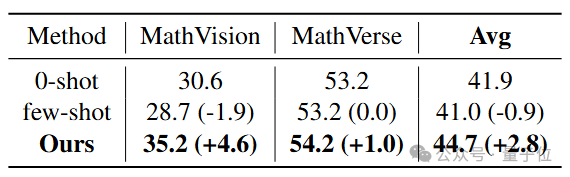

傳統的少樣本學習需要提供的例子與待解決的問題高度相似,否則不僅無法提供有效的引導,甚至會對推理帶來負面效果,這大大限制了上下文學習的泛化性。而由于不同的題目仍然可能包含高度相似的步驟,BoostStep可以有效降低對題目相似性的要求,從而大幅提升上下文學習的泛化性。研究人員以MATH中的題目為示例,嘗試指導模型在多模態數學評測集MathVision和MathVerse上的推理。當例題與待解決問題不相似時,傳統的少樣本學習甚至不如直接推理,而BoostStep能夠取得持續可觀的提升。

圖片

圖片

△圖5BoostStep在與題庫相似度較低的多模態數學評測集上能取得持續提升,具有更好的泛化性

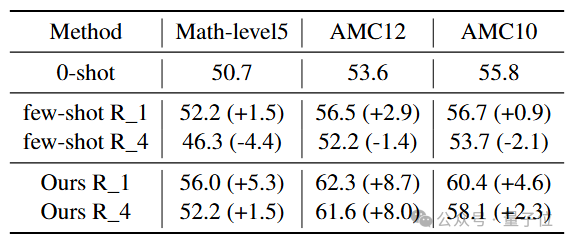

3.4魯棒性

為了測試不同方法的魯棒性,研究人員在檢索時通過手動選取第t像的例子來降低例題的相似度,模擬檢索不匹配的情況。實驗證明傳統的少樣本學習會在t=4時出現顯著的性能下降,甚至低于直接推理,而BoostStep下降幅度較小,且持續優于零樣本推理,敏感性較低。

圖片

圖片

△圖6:BoostStep對題庫的相似度有較低的敏感性,從而具有更強的魯棒性

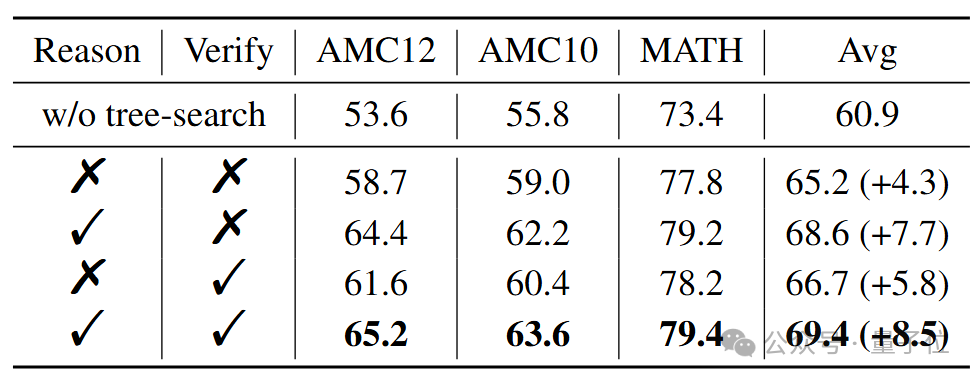

擴展應用:與樹搜索策略結合獲取進一步提升

樹搜索是數學推理中常用的策略,通常的策略包含兩個階段:在每步生成時生成多個候選節點,并通過過程監督模型進行篩選。而Booststep在以上兩個階段均可以通過引入相似的步驟樣例提升單步推理生成與正確性判斷的質量。

研究人員使用GPT-4o作為生成模型,GPT-4o-mini作為過程監督模型,并且采用逐對過程監督模型的設置,通過消融實驗證明在推理和判斷階段引入步驟樣例均能顯著提升總體推理質量,帶來8.5%的巨大提升。

圖片

圖片

△圖7:在樹搜索的生成與判斷是否引入過程示例的消融實驗

結論

本文提出BoostStep算法,以步驟為粒度對齊推理與上下文學習,能夠在推理過程中實時提供與當前步驟高度相關的示例提升推理質量,相較于傳統少樣本學習具有更強的表現、潛力、泛化性和魯棒性,且可即插即用地應用于樹搜索算法中提升生成和篩選的質量。