DeepSeek開源第二日!全球首個開源 EP 通信庫,MoE 訓練算力省了!

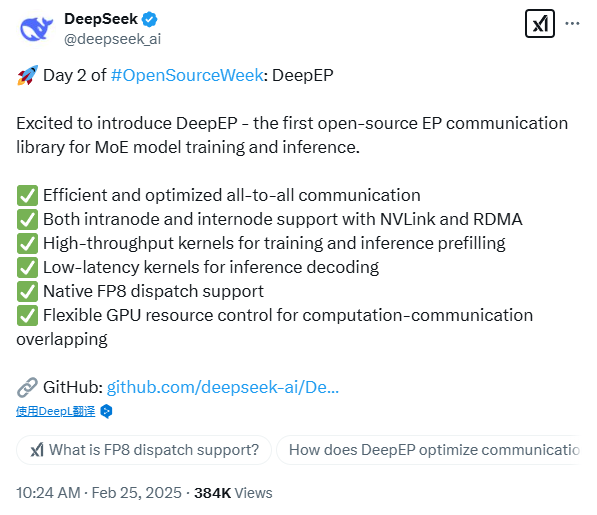

原創DeepSeek開源第二日!又是重磅炸彈——DeepEP。

這可是用于 MoE 模型訓練和推理的全球首個開源 EP 通信庫!

今天的開源項目仍然圍繞著GPU資源優化的主題,看來DS真的很懂怎么榨干英偉達芯片的算力。

??特點:

1??高效、優化的全對全通信(All-to-All Communication)

2??利用 NVLink 和 RDMA 支持節點內和節點間通信

3??用于訓練和推理預填充的高吞吐量內核

4??用于推理解碼的低延遲內核

5??本機 FP8 調度支持

6??用于計算-通信重疊的靈活 GPU 資源控制

??DeepEP通信庫是什么:

首先來看EP,EP(Expert Parallelism)是一種并行計算方法,專門用于稀疏專家(MoE, Mixture of Experts)模型的訓練和推理。MoE 模型會根據輸入數據選擇性地激活部分專家(Experts),而不是讓所有參數都參與計算,這樣可以在保持較大模型容量的同時提高計算效率。

EP(Expert Parallelism)本身的難點主要來自 MoE(Mixture of Experts)模型的動態計算分配,MoE 訓練不同于普通 Transformer 訓練,由于專家被分散在多個 GPU 上,大量數據需要跨 GPU 傳輸,導致 All-to-All(全對全)通信 成為瓶頸。

EP 通信庫是專門為 MoE 模型設計的高效通信庫,優化了專家之間的數據傳輸,主要用于 訓練和推理時的分布式計算加速。MoE 需要動態選擇激活的專家,EP 通信庫可以高效地在不同 GPU/節點之間分配計算任務。

??意義:

傳統的模型并行方式(如張量并行 TP、流水線并行 PP)無法很好地處理 MoE 模型的動態專家選擇,而 EP 專門針對 MoE 進行優化,能提高計算利用率、減少 GPU 閑置,并讓更大的 MoE 模型訓練和推理變得更加高效。

眾所周知,DeepSeek才是真正的“OpenAI”!

有了這一波的技術分享,相信我們“揭開 AGI 的神秘面紗”的那一天又近了一步。