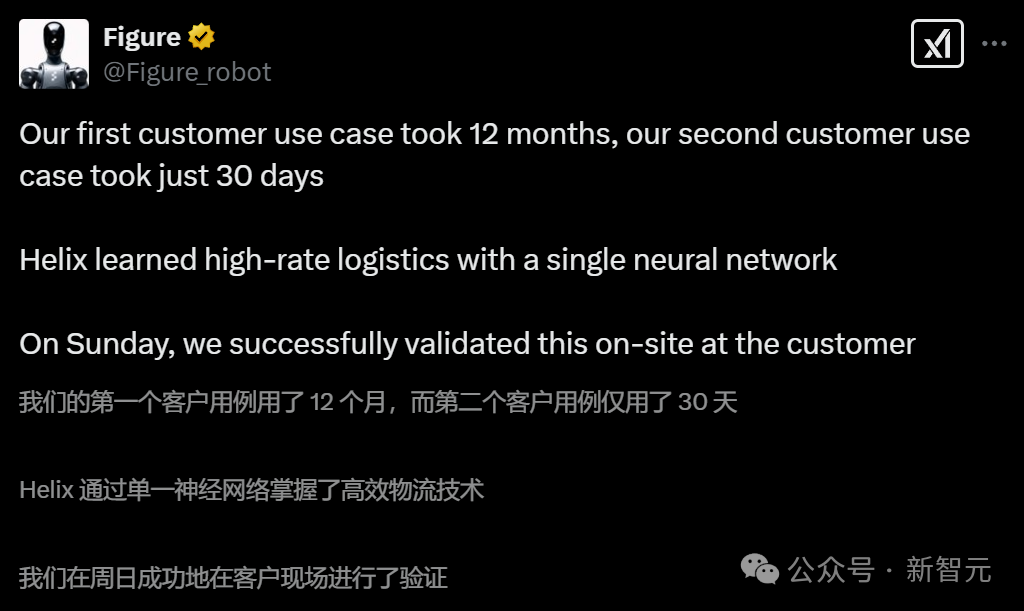

Figure機器人進廠打工,8小時速成物流分揀大師!自研VLA模型全面升級

踹掉OpenAI之后,F(xiàn)igure的迭代堪稱神速!

幾天前才發(fā)布了第一款自研視覺-語言-動作(VLA)模型Helix,統(tǒng)一了感知、語言理解和學習控制。。

就在剛剛,他們又在一個全新場景中實現(xiàn)了機器人應用的落地——物流包裹操作和分揀。

而且,只用了短短30天。

圖片

圖片

圖片

圖片

為了達到人類級別的速度、精確度和適應性,F(xiàn)igure對自研模型Helix的系統(tǒng)1(S1),也就是底層視覺運動控制策略,做出了全面的改進:

- 隱式立體視覺(implicit stereo vision):Helix系統(tǒng)1現(xiàn)在具有豐富的3D理解能力,實現(xiàn)更精確的深度感知運動。

- 多尺度視覺表征(Multi-scale visual representation):底層策略可以捕捉精細細節(jié),同時保持場景層面的理解,實現(xiàn)更準確的操作。

- 學習式視覺本體感知(learned visual proprioception):每個Figure機器人現(xiàn)在都可以自我校準,使跨機器人遷移變得無縫。

- 運動模式(sport mode):使用簡單的測試時加速技術,Helix 達到了比示范者更快的執(zhí)行速度,同時保持高成功率和靈巧度。

結(jié)果顯示,在這個特定場景中,僅需8小時精心策劃的示范數(shù)據(jù),就能產(chǎn)生靈活多變的操作策略。

只見,F(xiàn)igure機器人軍團同時走向自己的工位,站成一排,同步開啟打工模式。

圖片

圖片

看它靈活的雙手,拿起包裹后,識別物流碼逐一分揀。

整條流水線上,全由Figure完成,無需人類插手。

圖片

圖片

值得一提的是,它們還會自我校準。

圖片

圖片

對此網(wǎng)友紛紛表示,「工廠工人將被迅速取代!」

還有網(wǎng)友感慨道,「將現(xiàn)有勞動力轉(zhuǎn)換為機器人會比我們想象的要快得多。」

圖片

圖片

圖片

圖片

圖片

圖片

極具挑戰(zhàn)性的物流場景

包裹處理和分揀是物流中的基本操作。這通常涉及將包裹從一條傳送帶轉(zhuǎn)移到另一條傳送帶,同時確保運輸標簽正確朝向以便掃描。

這項任務面臨幾個關鍵挑戰(zhàn):包裹的尺寸、形狀、重量和剛性(如硬盒或軟袋),都各不相同。

為此,系統(tǒng)必須能夠:

- 確定抓取移動物體的最佳時機和方法,并重新調(diào)整每個包裹的朝向使標簽可見

- 跟蹤持續(xù)移動的傳送帶上眾多包裹的動態(tài)流動,并保持高吞吐量

- 實現(xiàn)自我調(diào)整,因為環(huán)境無法被完全預測

而這些,在仿真環(huán)境中是很難進行復刻的。

值得注意的是,解決這些挑戰(zhàn)不僅是Figure業(yè)務的關鍵應用,它還為Helix系統(tǒng)1帶來了全新的通用改進,從而使所有其他用例都從中受益。

圖片

圖片

圖片

圖片

圖片

圖片

對Helix視覺-運動策略(系統(tǒng)1)的架構改進

視覺表征

此前的系統(tǒng)1依賴于單目視覺輸入,而現(xiàn)在的新系統(tǒng)采用了立體視覺主干網(wǎng)絡,結(jié)合多尺度特征提取網(wǎng)絡來捕捉豐富的空間層次結(jié)構。

新系統(tǒng)不再單獨處理每個攝像頭的圖像特征token,而是會在token化之前將兩個攝像頭的特征在多尺度立體網(wǎng)絡中合并,這樣保持了輸入到交叉注意力Transformer的視覺token總數(shù)不變,同時避免了額外的計算開銷。

多尺度特征使系統(tǒng)能夠同時識別精細細節(jié)和更廣泛的上下文信息,共同提升了基于視覺的控制可靠性。

圖片

圖片

跨機器人遷移

在多個機器人上部署同一策略時,需要解決因個體機器人硬件細微差異導致的觀測和動作空間分布偏移問題。

這些差異主要包括傳感器校準差異(影響輸入觀測)和關節(jié)響應特性(影響動作執(zhí)行),若不進行適當補償,將會顯著影響策略性能。

尤其是在涉及高維度的整個上半身動作空間時,傳統(tǒng)的手動機器人校準方法難以適用于大規(guī)模機器人群組。

為解決這一問題,F(xiàn)igure訓練了一個視覺本體感知模型,該模型完全基于每個機器人自身的視覺輸入來估計末端執(zhí)行器的六自由度(6D)姿態(tài)。

這種在線「自我校準」機制使得跨機器人策略遷移能夠高效進行,同時將停機時間降至最低。

圖1:可擴展的實時視覺校準技術實現(xiàn)強大的跨機器人遷移能力

圖1:可擴展的實時視覺校準技術實現(xiàn)強大的跨機器人遷移能力

數(shù)據(jù)篩選

數(shù)據(jù)方面,F(xiàn)igure在篩選時排除了那些速度較慢、失誤或完全失敗的人類示范。

但有意保留了一些自然包含糾正行為的示范,前提是造成失敗的原因是環(huán)境的隨機因素,而非操作者的錯誤。

與遠程操作者密切合作,可以改進和統(tǒng)一操控策略,并帶來顯著的性能提升。

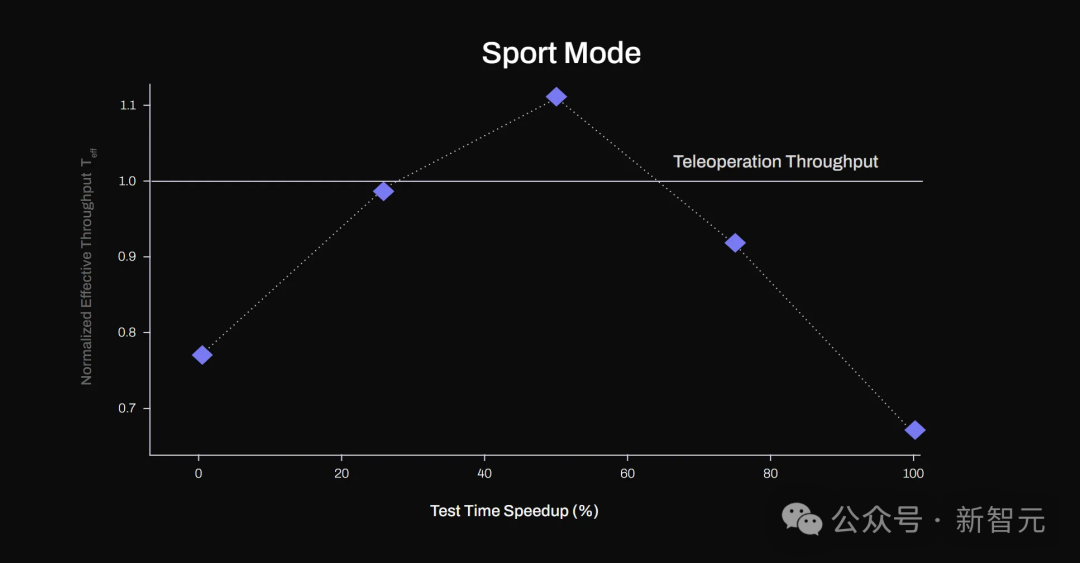

推理階段操作加速

為了讓系統(tǒng)能夠接近并最終超越人類操作速度,F(xiàn)igure應用了一種簡單但有效的測試階段技術,從而實現(xiàn)了比示范者更快的學習行為——對策略動作塊輸出進行插值(「運動模式」)。

其中,S1策略輸出動作「塊」,即以200Hz頻率執(zhí)行的一系列機器人動作。

在實踐中,可以在不修改訓練程序的情況下實現(xiàn)20%的測試階段加速。

方法是,將一個[T x action_dim]的動作塊(表示一個T毫秒的軌跡)線性重采樣為一個更短的[0.8 * T x action_dim]軌跡,然后以原始的200Hz控制率執(zhí)行這個更短的動作塊。

結(jié)果與討論

使用標準化有效吞吐量* T_eff 來衡量系統(tǒng)性能,可以反映系統(tǒng)處理包裹的速度與訓練數(shù)據(jù)中演示者速度的比值。(這一指標考慮到了系統(tǒng)重置所花費的時間)

例如,當T_eff > 1.1時,表示系統(tǒng)操作速度比訓練所用的專家軌跡快10%。

立體視覺的重要性

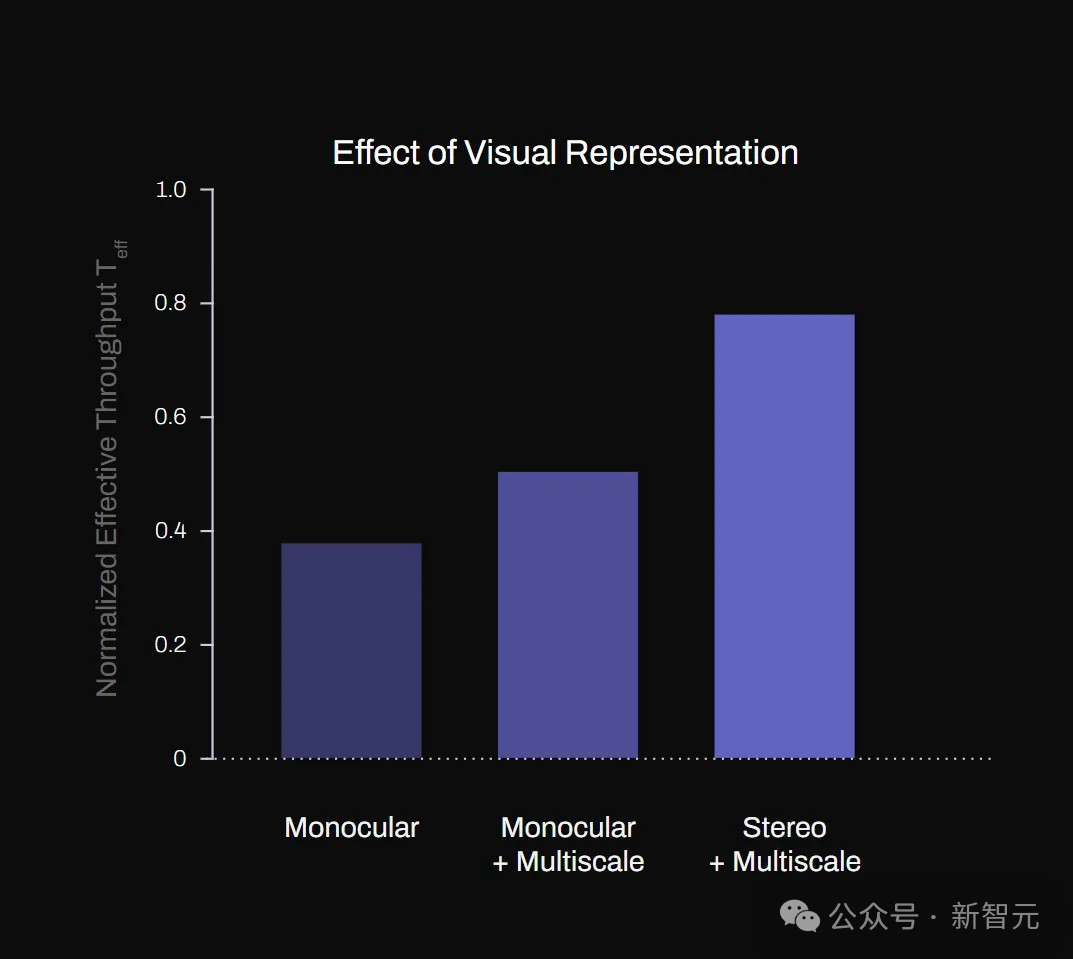

圖2(a)展示了多尺度特征提取器和立體視覺輸入對系統(tǒng)T_eff的影響。

其中,多尺度特征提取和隱式立體輸入顯著提升了系統(tǒng)性能,立體視覺也顯著增強了系統(tǒng)處理各種尺寸包裹的穩(wěn)健性。

相比于非立體基線模型,立體模型實現(xiàn)了高達60%的吞吐量提升。

圖2:(a)不同視覺表示方法對系統(tǒng)性能影響的消融研究

圖2:(a)不同視覺表示方法對系統(tǒng)性能影響的消融研究

此外,配備立體視覺的S1系統(tǒng)能夠成功處理系統(tǒng)從未訓練過的平信封,表現(xiàn)出良好的泛化能力。

圖片

圖片

機器人可以將信封分揀出來。

可以看出機器人的手部活動十分靈活。

圖片

圖片

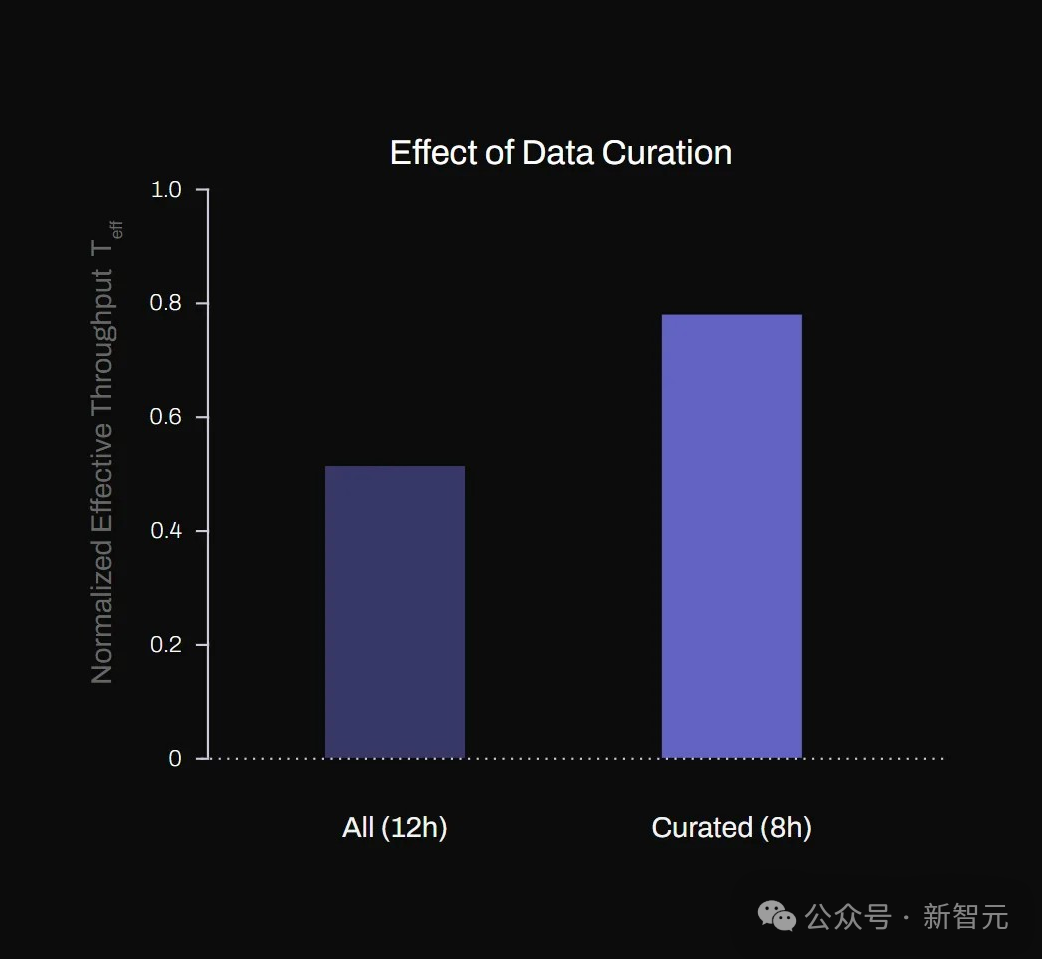

質(zhì)量勝于數(shù)量

Figure發(fā)現(xiàn),對于單個應用場景,數(shù)據(jù)質(zhì)量和一致性比數(shù)據(jù)數(shù)量更為重要。

如圖2(b)所示,盡管訓練數(shù)據(jù)量減少了三分之一,但使用精心篩選的高質(zhì)量示范數(shù)據(jù)訓練的模型仍然實現(xiàn)了40%更高的吞吐量。

圖2(b):數(shù)據(jù)篩選對有效吞吐量的影響

圖2(b):數(shù)據(jù)篩選對有效吞吐量的影響

運動模式

通過線性重采樣技術(即「運動模式」)加速策略執(zhí)行,在提速不超過50%的范圍內(nèi)表現(xiàn)出奇地有效。這可能歸功于動作輸出塊的高時間分辨率(200Hz)。

然而,當速度提高超過50%時,有效吞吐量開始大幅下降,因為動作變得過于不精確,系統(tǒng)需要頻繁重置。

圖3顯示,在速度提高50%的情況下,策略能夠?qū)崿F(xiàn)比其訓練所基于的專家軌跡更快的物體處理速度(T_eff>1)。

圖片

圖片

圖3:通過動作塊重采樣實現(xiàn)測試階段加速。在測試階段速度提高50%的情況下,S1系統(tǒng)實現(xiàn)了比示范數(shù)據(jù)更高的有效吞吐量(T_eff>1)

跨機器人遷移

最后,通過利用學習型校準和視覺本體感知模塊,F(xiàn)igure成功將最初僅在單個機器人數(shù)據(jù)上訓練的策略應用到多臺不同機器人上。

盡管各機器人間存在傳感器校準差異和細微硬件不同,系統(tǒng)在所有平臺上仍保持了相當一致的操作性能水平。

這種一致性凸顯了學習型校準在減輕數(shù)據(jù)分布偏移方面的有效性,大大減少了繁瑣的單機器人重新校準需求,使大規(guī)模部署變得更加實用。

總結(jié)

綜上,F(xiàn)igure展示了如何通過高質(zhì)量數(shù)據(jù)集,結(jié)合立體多尺度視覺、實時校準和測試階段加速等架構優(yōu)化,在實際物流優(yōu)先級分揀場景中實現(xiàn)超越示范者速度的靈巧機器人操作——這一切僅使用了相對適量的示范數(shù)據(jù)。

研究結(jié)果表明,端到端視覺-運動控制策略在速度和精度至關重要的復雜工業(yè)應用中具有巨大的擴展?jié)摿Α?/span>