微軟首個多模態Phi-4問世,56億參數秒殺GPT-4o!LoRA華人大佬帶隊

今天,微軟CEO納德拉官宣,Phi系列家族新增兩員:Phi-4-multimodal和Phi-4-mini。

這是微軟Phi系列小模型(SLM)中的最新模型,尤其是Phi-4-multimodal是微軟的首款多模態模型。

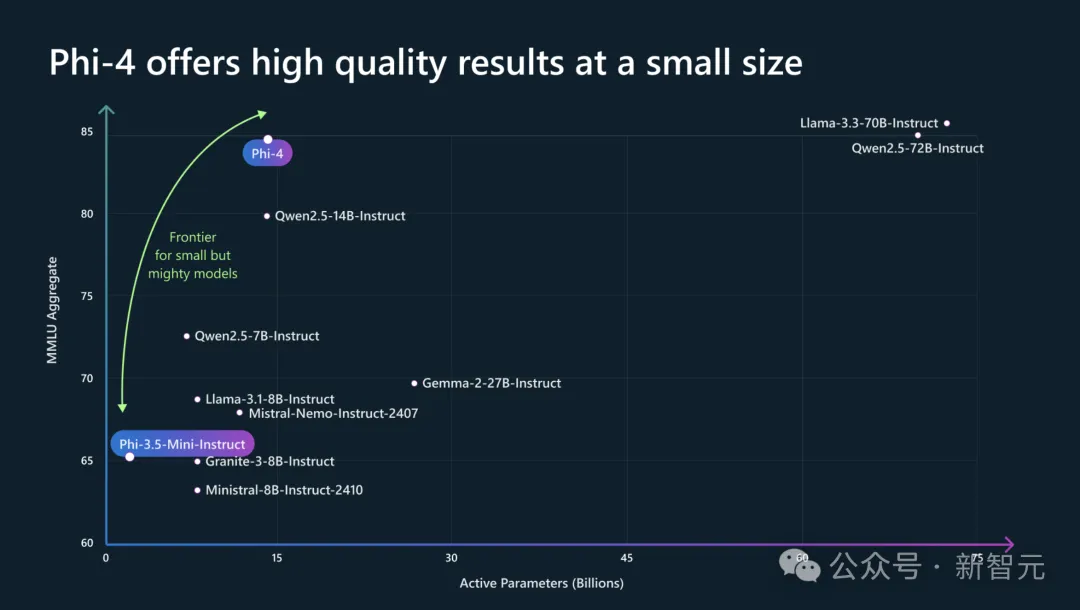

這兩款模型雖然參數不大(56億和38億),但性能強勁,甚至不輸一些大型的開源模型,例如Llama-3.3-70B-Instruct、Qwen2.5-72B-Instruct。

其中,Phi-4-multimodal是一款單體模型,采用混合LoRA技術,集成了語音、視覺和文本多模態能力,皆可在同一表示空間內同時處理。

Phi-4-mini支持128k上下文,還可以借用函數調用功能,在基于文本的任務中表現出色,以緊湊的形式提供了高精度和可擴展性。

與此同時,Phi-4新款模型39頁技術報告新鮮出爐了。

論文地址:https://huggingface.co/microsoft/Phi-4-multimodal-instruct/blob/main/phi_4_mm.tech_report.02252025.pdf

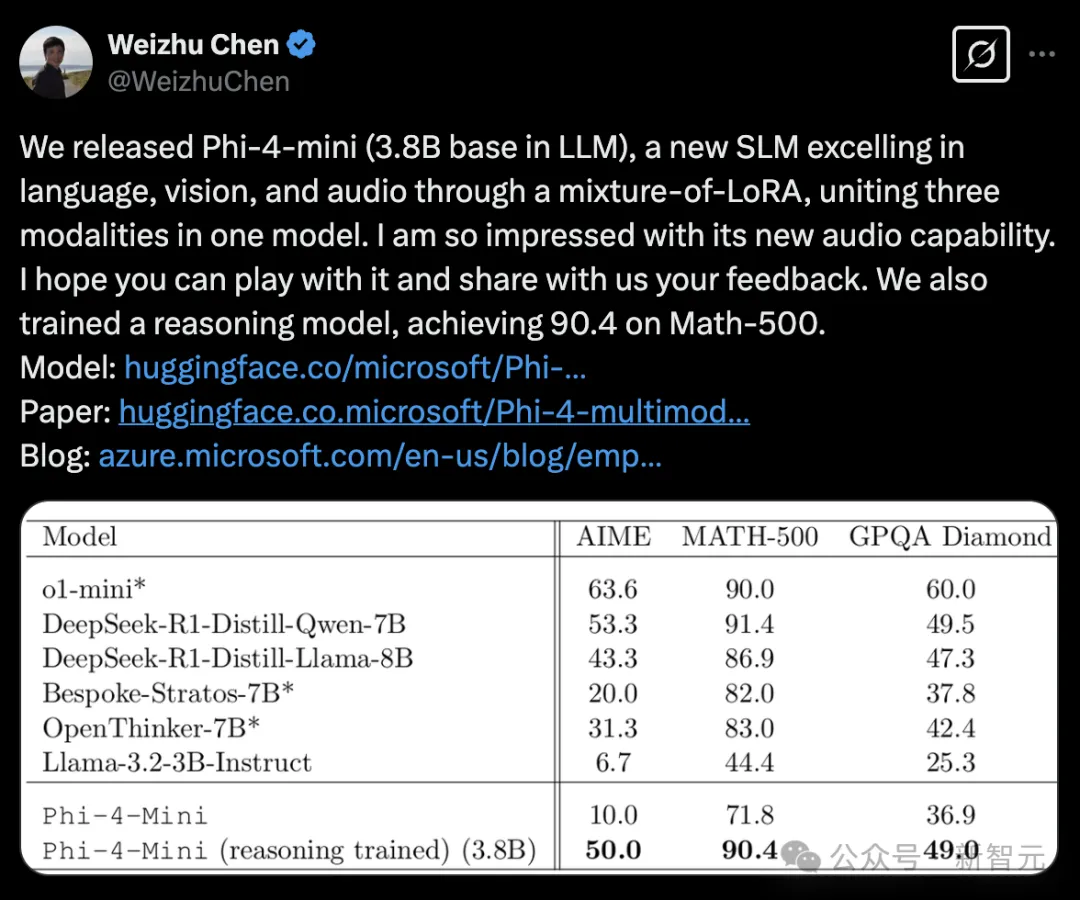

值得一提的是,Phi-4-mini在Math-500數學測試集中,拿下了90.4分驚人的成績,與蒸餾千問7B后的DeepSeek R1、o1-mini不相上下。

現在,Phi-4-multimodal可以在Azure AI Foundry、HuggingFace和NVIDIA API Catalog中使用,開發者可以在NVIDIA API Catalog上探索Phi-4-multimodal的全部潛力,從而輕松地進行實驗和創新。

傳送門:https://huggingface.co/microsoft/Phi-4-multimodal-instruct

Phi-4-multimodal,微軟首個多模態

Phi-4-multimodal作為微軟首個全模態語言模型,標志著微軟人工智能開發的一個新里程碑。

它是一個56億參數的模型,將語音、視覺和文本處理無縫集成到一個統一的架構中。

通過利用先進的跨模態學習技術,該模型實現了更自然、更具上下文感知能力的交互,使設備能夠同時理解和推理多種輸入模態。

無論是解釋口語、分析圖像還是處理文本信息,它都能提供高效、低延遲的推理——同時還針對設備端執行和減少計算開銷進行了優化。

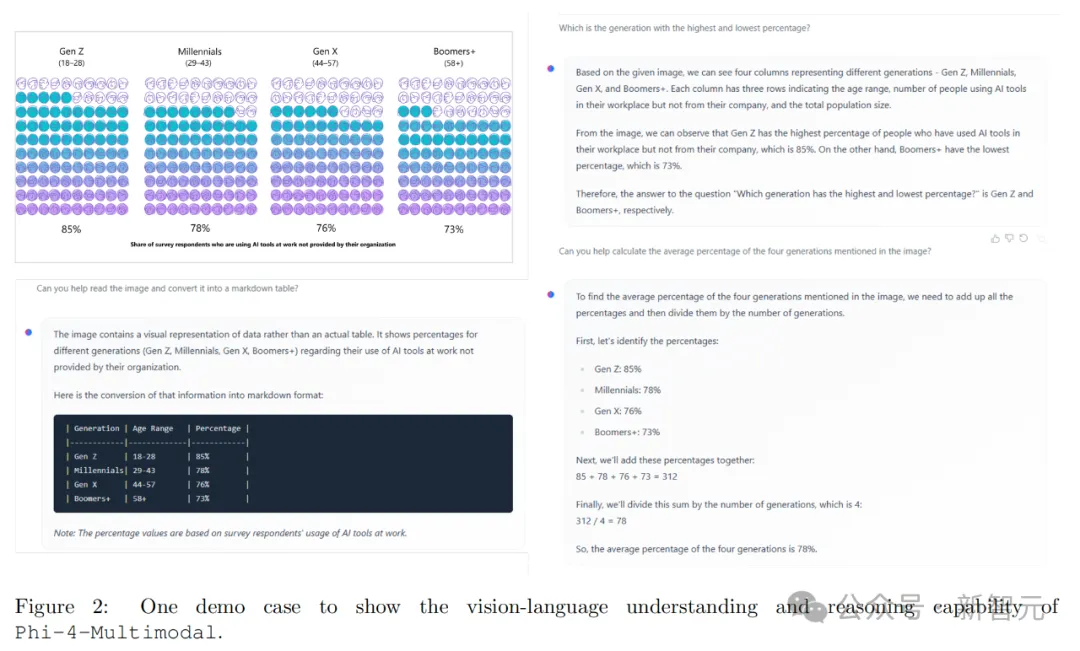

舉個栗子,上傳一張與不同時代(Z世代、千禧一代、X世代、嬰兒潮一代等)在工作中使用非組織提供的AI工具的百分比圖像。

Phi-4-multimodal看懂圖之后,就能幫你出一個Markdown形式的表格,并且與之相關的問題均可以答對。

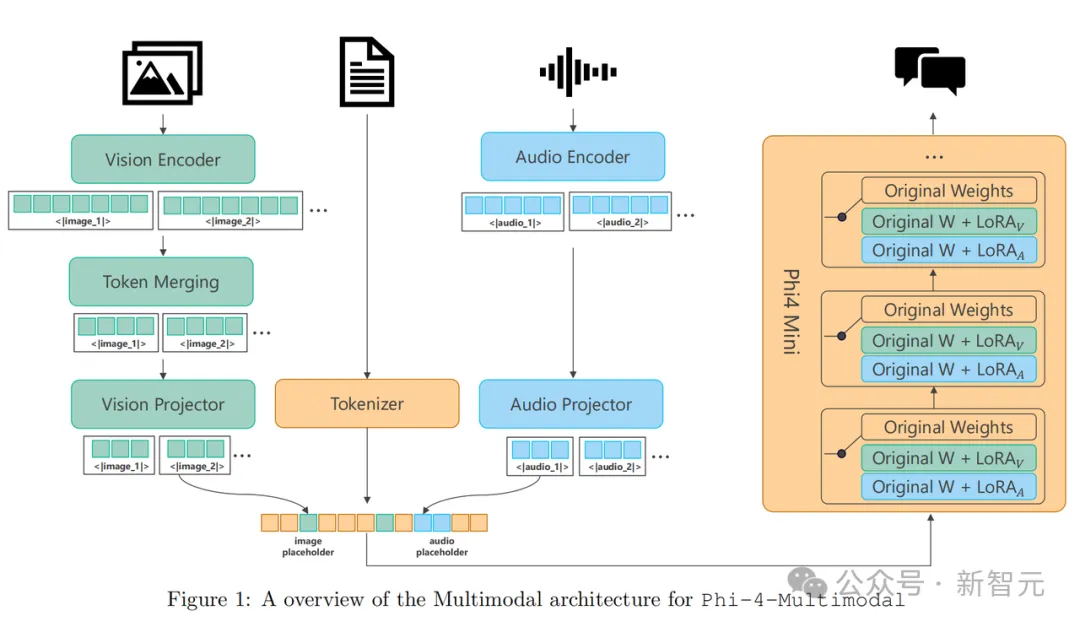

原生支持多模態

Phi-4-multimodal是一個單一模型,采用了混合LoRA(Low-Rank Adaptation)技術,集成了語音、視覺和語言功能,所有這些都在同一個表示空間內同時處理。

其結果是一個統一的單一模型,能夠處理文本、音頻和視覺輸入,無需復雜的處理流程或為不同模態使用單獨的模型。

Phi-4-multimodal基于一種全新的架構,顯著提升了效率和可擴展性。它擁有更大的詞匯量以改進處理能力,支持多語言功能,并將語言推理與多模態輸入相結合。所有這些都集成在一個強大、緊湊且高效的模型中,非常適合在設備端和邊緣計算平臺上部署。

Phi-4-multimodal整體架構

Phi-4-multimodal整體架構

解鎖新能力

Phi-4-multimodal能夠同時處理視覺和音頻內容。

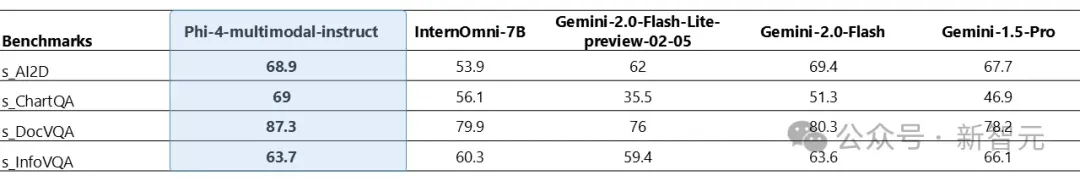

下圖1展示了當視覺內容的輸入為合成語音時,模型在圖表/表格理解和文檔推理任務上的表現。與其他現有的能夠同時處理音頻和視覺信號作為輸入的最先進多模態模型相比,Phi-4-multimodal在多項基準測試中取得了顯著更強的性能。

Phi-4-Multimodal-Instruct音頻和視覺基準

Phi-4-Multimodal-Instruct音頻和視覺基準

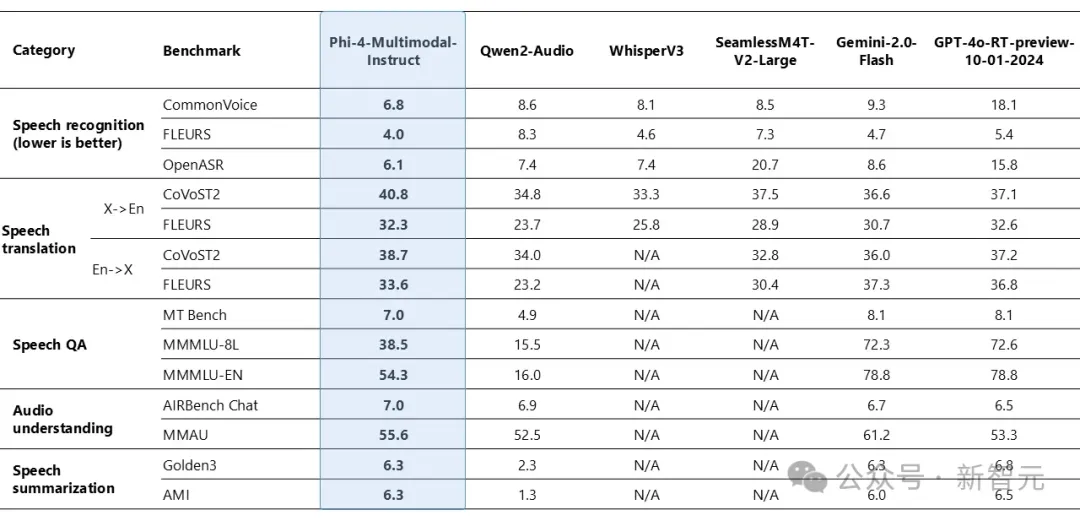

Phi-4-multimodal在語音相關任務中展現了卓越的能力,成為多個領域的領先開源模型。

它在自動語音識別 (ASR) 和語音翻譯 (ST) 方面超越了WhisperV3和SeamlessM4T-v2-Large等專業模型。該模型以驚人的6.14%詞錯誤率登頂Huggingface OpenASR排行榜,超過了截至2025年2月之前的最佳表現6.5%。

此外,Phi-4-multimodal是少數成功實現語音摘要并達到與GPT-4o模型相當性能水平的開源模型之一。

在語音問答 (QA) 任務中,該模型與Gemini-2.0-Flash和GPT-4o-realtime-preview等相近模型存在差距,因為其較小的模型規模導致事實性問答知識的能力較弱。

下圖2比較了不同AI模型在語音識別、語音翻譯、語音問答、音頻理解和語音摘要等類別中的表現。模型包括Phi-1-Multimodal-Instruct、Qwen-2-Audio、WhisperV3、SeamlessM4T-V2-Large、Gemini-2.0-Flash和GPT-4-turbo-preview-10-01-2024。

Phi-4-Multimodal-Instruct在語音識別和翻譯中表現優異,而Gemini-2.0-Flash和GPT-4o-RT-preview在問答和音頻理解任務中領先。

圖2:Phi-4-Multimodal-Instruct語音基準測試

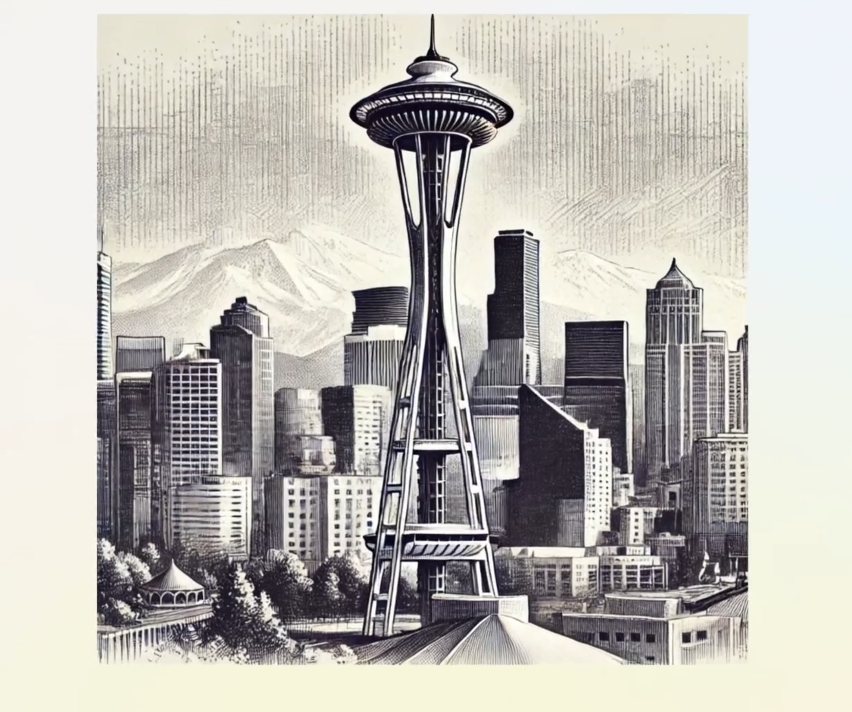

以下視頻為Phi-4 Multimodal分析口語語言,以幫助規劃前往西雅圖的旅行,展示了其先進的音頻處理和推薦能力。

Phi-4-multimodal僅擁有56億個參數,卻在多個基準測試中展現了卓越的視覺能力,尤其在數學和科學推理方面表現突出。

盡管其規模較小,該模型在通用多模態能力上仍保持競爭力,例如文檔和圖表理解、光學字符識別 (OCR) 以及視覺科學推理,甚至超過了Gemini-2-Flash-lite-preview和Claude-3.5-Sonnet等模型。

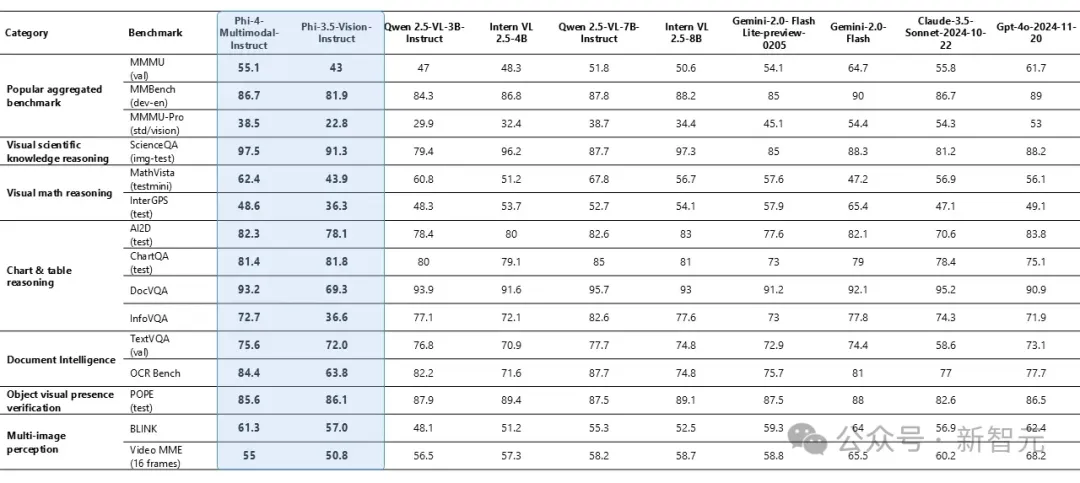

如下圖3所示,Phi-4-Multimodal-Instruct在多個任務中表現出色,如MMMU (55.1)、ScienceQA (97.5) 和 ChartQA (81.4),而GPT-4o和Gemini-2.0-Flash在綜合性能上得分較高。

圖3:Phi-4-Multimodal-Instruct視覺基準測試

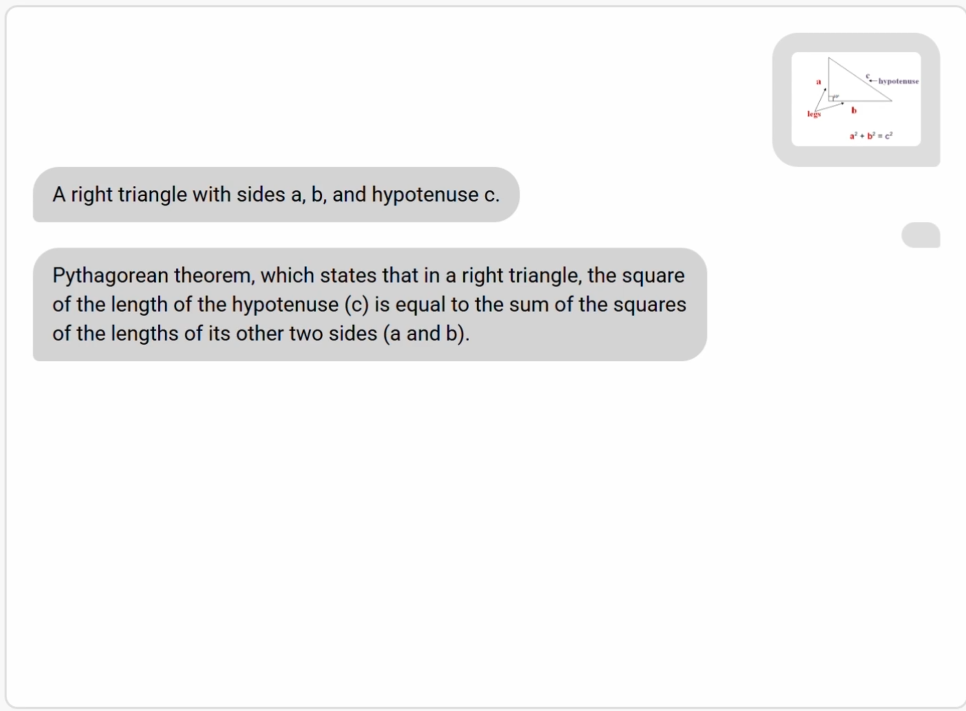

以下視頻為Phi-4-Multimodal如何通過視覺輸入解決復雜的數學問題,展示了其處理和解決圖像中呈現的方程的能力。

Phi-4-mini,數學媲美o1-mini

Phi-4-mini擁有38億參數,它是一個稠密、僅包含解碼器的Transformer模型,具有分組查詢注意力、20萬詞匯量和共享輸入輸出嵌入,旨在提高速度和效率。

盡管規模小巧,但在推理、數學、編程、指令跟隨和函數調用等任務中,它的表現優于更大的模型。

該模型支持長達128K token的序列,提供高精度和可擴展性,使其成為先進AI應用的強大解決方案。

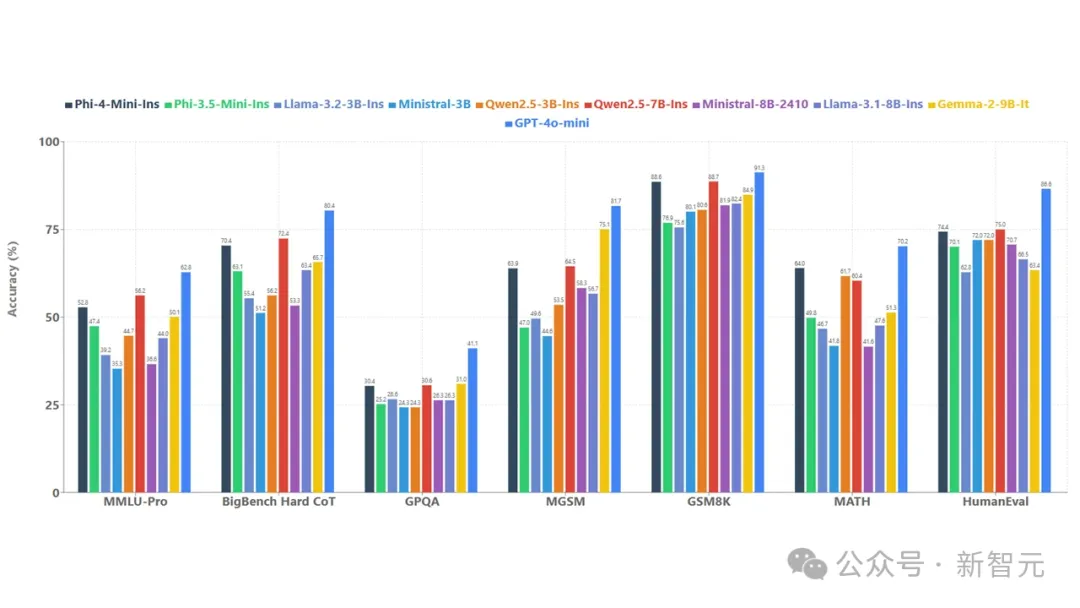

為了了解模型質量,微軟將Phi-4-mini與一系列模型在如下圖4所示的多個基準上進行比較。

Phi-4-mini語言基準測試

在多種基準測試中,Phi-4-mini展現出了出色的性能。函數調用、指令跟隨、長上下文處理和推理等強大能力,使它能夠訪問外部知識和功能。

通過標準化協議,函數調用使模型能夠與結構化編程接口無縫集成,當用戶發出請求時,它可以對查詢進行推理,識別并調用帶有適當參數的相關函數,接收函數輸出,并將這些結果融入到響應中,創建了一個基于智能體的可擴展的系統。

定制化與跨平臺

Phi-4-mini和Phi-4-multimodal模型的規模較小,這一特點讓它們能在計算資源有限的推理環境中使用。

在設備端,通過ONNX Runtime進一步優化后,兩款模型可以跨平臺使用。它們對計算資源需求低,延遲表現也更理想。

同時,模型擁有更長的上下文窗口,推理和邏輯能力強大,非常適合用于分析任務。較小的模型規模讓微調或定制變得更輕松,成本也更低。

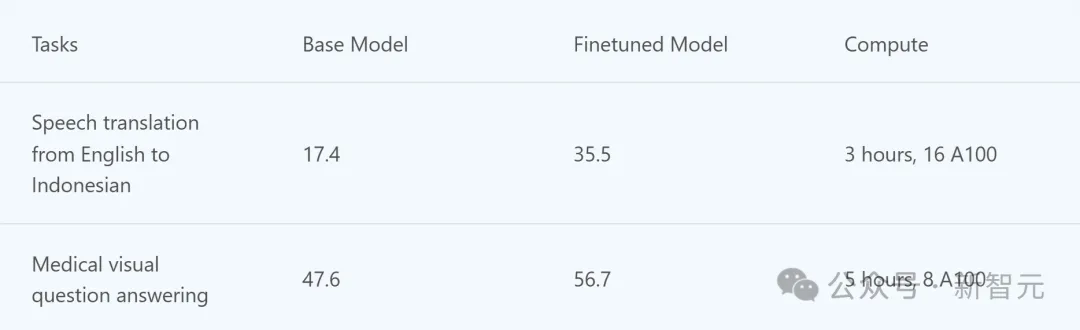

下表是Phi-4-multimodal在微調場景中的示例。

小模型,跑起來了

從一開始,微軟設計Phi系列模型的初衷,便是加速SLM實際落地應用。

而如今,有了多模態Phi-4-multimodal,以及參數更少、數推更強的Phi-4-mini,又能賦能一大片應用了。

嵌入智能設備

手機制造商可以將Phi-4-multimodal直接集成到手機中,用戶可以使用先進功能,如實時語言翻譯、增強的照片和視頻分析,能理解并回應復雜查詢的智能個人助理。

這將在手機上直接提供強大的AI能力,提升用戶體驗,確保低延遲和高效率。

汽車領域

汽車公司將模型集成到車載輔助系統中,車輛可以理解并回應語音指令、識別駕駛員手勢,以及分析來自攝像頭的視覺輸入。

它可以通過面部識別檢測駕駛員的疲勞狀態并提供實時警報,從而提高駕駛安全性。

此外,它還能提供無縫的導航輔助、解讀路標并提供情境信息,在聯網及離線狀態下,都能創造更直觀、更安全的駕駛體驗。

金融服務

金融服務公司集成Phi-4-mini模型,以實現復雜金融計算的自動化、生成詳細報告,并翻譯成多種語言。

例如,該模型可以通過執行風險評估、投資組合管理和財務預測所需的復雜數學計算,為分析師提供幫助。

此外,它還能將財務報表、監管文件和客戶溝通內容翻譯成多種語言,有助于改善全球客戶關系。

以下視頻為Phi-4-mini作為智能體的功能,展示了其在復雜場景中的推理和任務執行能力。

微軟19年老將,LoRA核心締造者帶隊

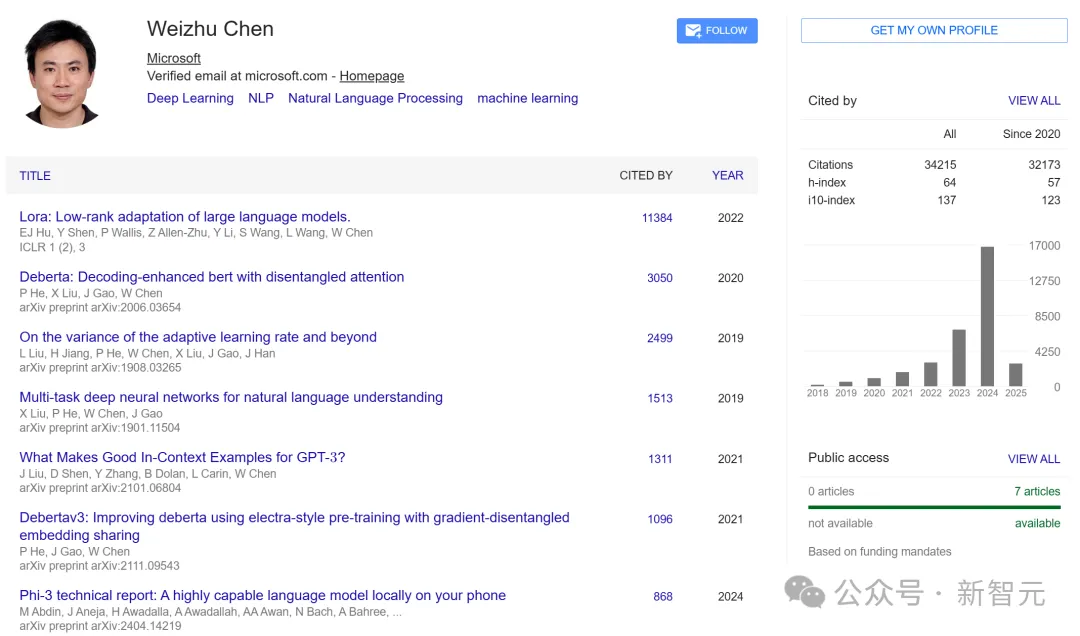

作為微軟副總裁和GenAI團隊負責人,19年老將Weizhu Chen的研究為AI領域帶來了多項突破性貢獻,包括LoRA、DeBERTa、Phi和Rho-1等技術。

他開創的LoRA技術革新了大語言模型的應用方式,使其更加高效、經濟且易于部署,不僅為眾多微軟產品提供了強大支持,還對整個行業產生了深遠影響。

在微軟,他的工作讓公司能夠為特定產品場景訓練專業模型,尤其專注于OpenAI模型的應用。并且,還為Azure AI、GitHub、Office、Biz Apps、MAI、DevDiv和Security等多個產品部門創造了顯著的業務價值。

比如在2022年共同推出的GitHub Copilot,就一舉成為了微軟首個極為成功的Copilot產品。

同時,他還將BerryRL流程整合到微軟產品中的工作,顯著提升了Codex-V2和SWE-Agent等多個應用的模型訓練效率和質量。

在此之前,他在香港科技大學獲得計算機科學博士學位。