為什么Qwen能自我改進推理,Llama卻不行?斯坦福找到了原理

給到額外的計算資源和「思考」時間,為什么有的模型能好好利用,把性能提升一大截,而有的模型就不行?

當遇到困難問題時,人類會花時間深入思考以找到解決方案。在 AI 領域,最近的一些大語言模型在通過強化學習進行自我改進訓練時,也已經開始表現出類似的推理行為。

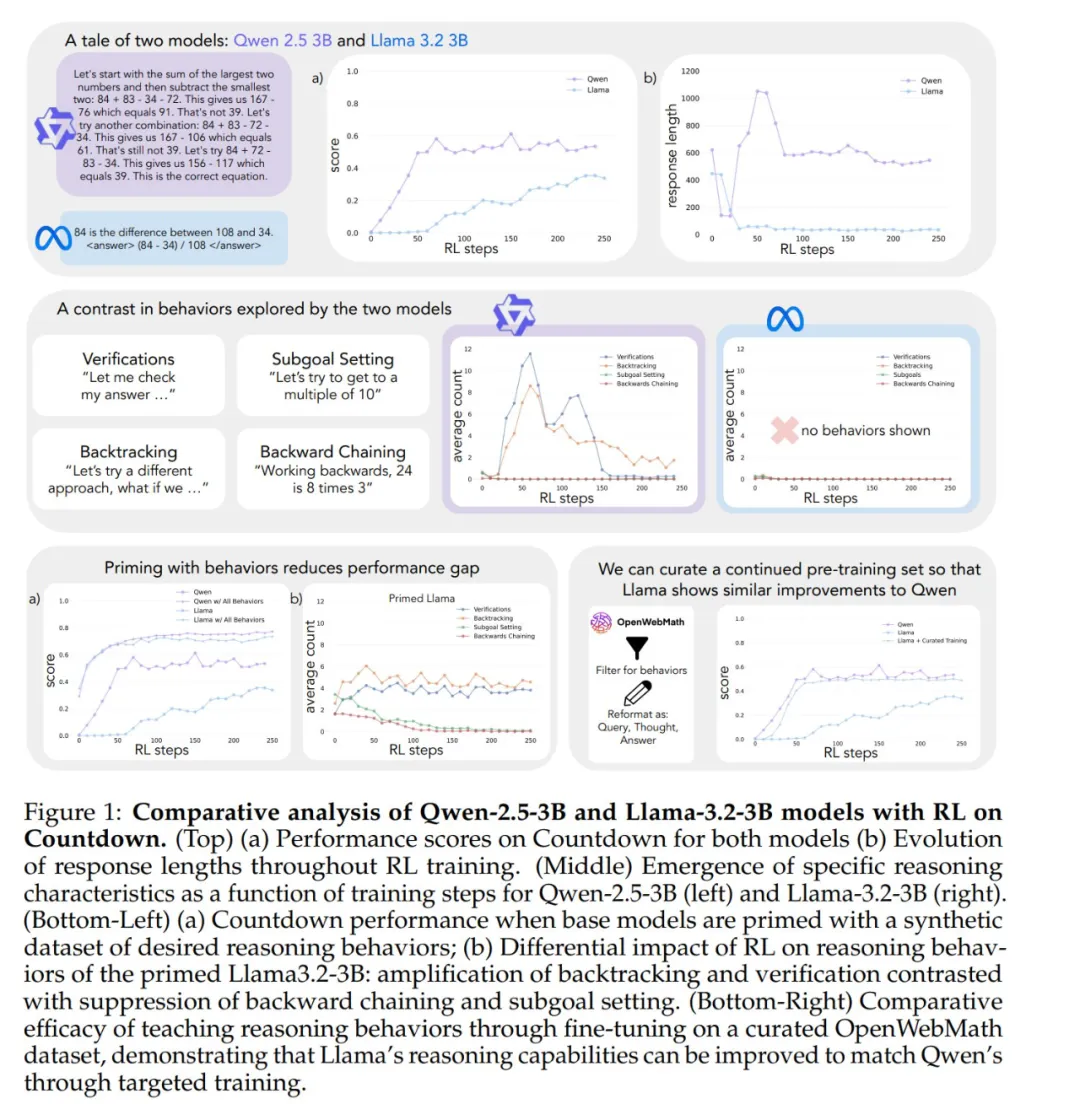

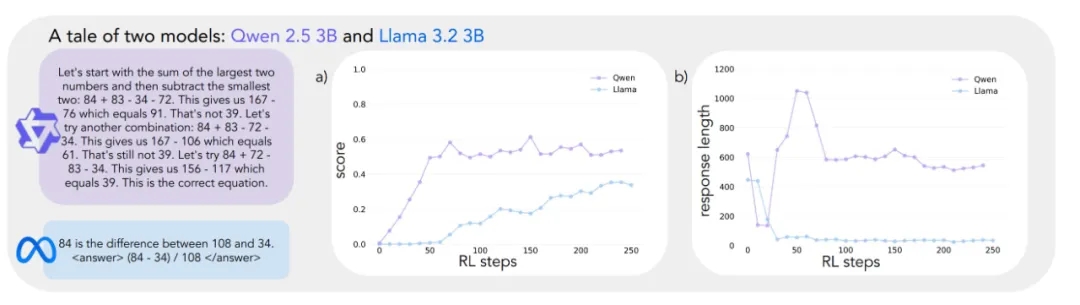

但是,在同樣的強化學習訓練下,不同模型自我改進的能力卻存在很大差異。比如在一個游戲中,Qwen-2.5-3B 的自我改進能力遠遠超過 Llama-3.2-3B(兩個模型初始都很差,但強化學習訓練結束后,Qwen 達到約 60% 的準確率,Llama 只有 30%)。這是什么原因?

在最近斯坦福大學提交的一項工作中,大模型自我改進能力背后的機制被挖掘了出來。該研究重點關注的是基礎語言模型中關鍵的認知行為的存在。

- 論文標題:Cognitive Behaviors that Enable Self-Improving Reasoners, or, Four Habits of Highly Effective STaRs

- 論文鏈接:https://arxiv.org/abs/2503.01307

這項研究一發布就引來眾多討論,比如 Synth Labs CEO 認為這個發現非常激動人心,因為其可被整合進任何模型中!

作者將研究重點放在兩個基礎模型 ——Qwen-2.5-3B 和 Llama-3.2-3B 上,當使用強化學習對 Countdown 游戲進行訓練時,它們之間顯示出明顯的差異 ——Qwen 解決問題的能力大幅提高,Llama2 在相同的訓練過程中卻提升有限。語言模型的哪些屬性帶來了這種不同?

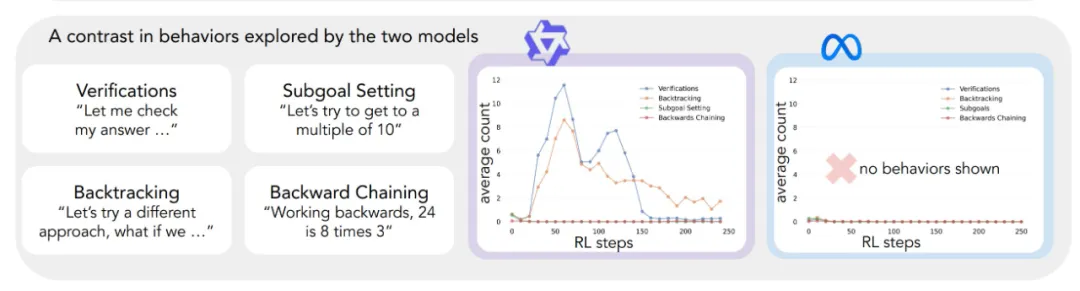

為了系統地研究這個問題,作者開發了一個框架來分析對解決問題有用的認知行為,其中描述了四種關鍵的認知行為:驗證(系統錯誤檢查)、回溯(放棄失敗的方法)、子目標設定(將問題分解為可管理的步驟)和逆向思考(從期望結果推理到初始輸入)。這些行為反映了專家級問題解決者處理困難任務的方式 —— 數學家會驗證證明的每個步驟、遇到矛盾時回溯以及將復雜定理分解為更簡單的引理。

初步分析表明,Qwen 自然地表現出了這些推理行為,特別是驗證和回溯,而 Llama 則缺乏這些行為。從這些觀察中作者得出了核心假設:初始策略中的某些推理行為對于通過擴展推理序列有效利用增加的測試時間計算(test-time compute)是必不可少的。也就是說,AI 模型要想在有更多時間思考時真正變得更聰明,必須先具備一些基本的思考能力(比如檢查錯誤、驗證結果的習慣)。如果模型一開始就不會這些基本思考方法,即使給它再多的思考時間和計算資源,它也無法有效利用這些資源來提高自己的表現。這就像人類學習一樣 —— 如果一個學生不具備基本的自我檢查和糾錯能力,單純給他更多的考試時間也不會讓他的成績有顯著提高。

研究人員又通過對初始模型進行干預來檢驗這一假設。

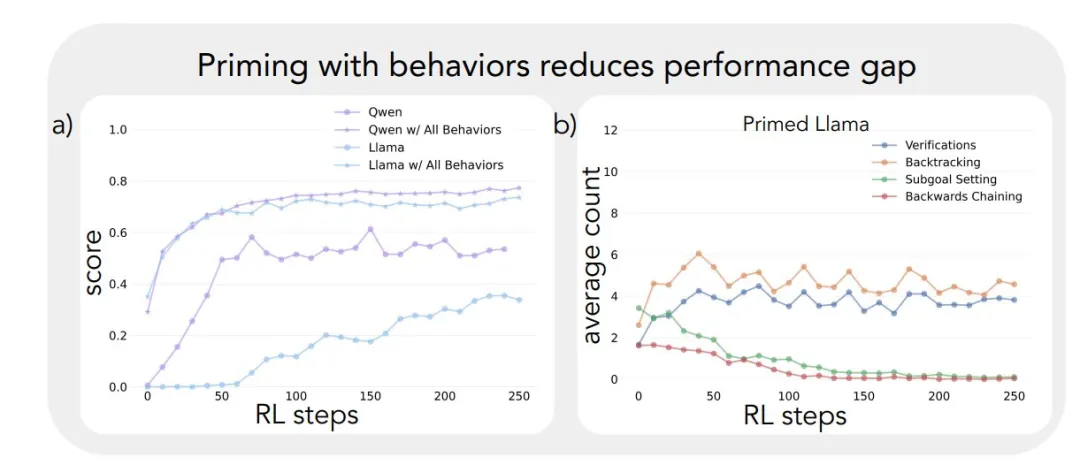

首先,他們發現,通過用包含這些行為(尤其是回溯)的人工合成推理軌跡對 Llama 進行引導,可以使其在強化學習過程中表現大幅改善,甚至能達到與 Qwen 相當的性能提升。其次,即使這些引導用的推理軌跡包含錯誤答案,只要它們展現出正確的推理模式,Llama 依然能取得進步。這表明,推理行為的存在,而不是正確答案本身,才是實現成功自我改進的關鍵因素。最后,他們從 OpenWebMath 數據集中篩選出強調這些推理行為的內容,用于對 Llama 進行預訓練。結果表明,這種有針對性的預訓練數據調整能夠成功誘導出高效利用計算資源所需的推理行為模式 ——Llama 的性能提升軌跡與 Qwen 一致。

這項研究揭示了模型的初始推理行為與其自我改進能力之間存在緊密聯系。這種聯系有助于解釋為什么有些語言模型能夠找到有效利用額外計算資源的方法,而另一些模型則停滯不前。理解這些動態變化可能是開發能夠顯著提升問題解決能力的 AI 系統的關鍵。

如何讓 AI 學會自我改進?

參與對比的模型:Qwen-2.5-3B 和 Llama-3.2-3B

研究開始于一個令人驚訝的觀察結果:規模相當但來自不同家族的語言模型通過強化學習表現出差異巨大的提升能力。

Countdown 游戲作為主要測試平臺 —— 這是一個數學難題,玩家必須使用四種基本算術運算(+、?、×、÷)組合一組輸入數字以達到目標數字。例如,給定數字 25、30、3、4 和目標 32,玩家需要通過一系列操作將這些數字組合起來,得到精確的 32:(30 ? 25 + 3) × 4。

選擇 Countdown 進行分析是因為它需要數學推理、規劃和搜索策略。與更復雜的領域不同,Countdown 提供了一個受限的搜索空間,使得可行的分析成為可能,同時仍然需要復雜的推理。此外,與其他數學任務相比,Countdown 游戲中的成功更依賴于問題解決能力而非數學知識。

研究者使用兩個基礎模型來對比不同模型家族之間的學習差異:Qwen-2.5-3B 和 Llama-3.2-3B。強化學習實驗基于 VERL 庫,利用 TinyZero 實現。他們使用 PPO 方法訓練模型 250 步,每個提示采樣 4 個軌跡。選擇 PPO 而非 GRPO 和 REINFORCE 等替代方案,是因為它在各種超參數設置下表現出更優的穩定性,盡管各算法的性能非常相似。

結果揭示了截然不同的學習軌跡。盡管這兩種模型在任務開始時表現相似,得分都很低,但 Qwen 在第 30 步左右表現出質的飛躍,特點是響應明顯變長且準確性提高,如下圖所示。到訓練結束時,Qwen 達到了約 60% 的準確率,大大超過 Llama 的 30%。

在訓練后期,可以觀察到 Qwen 行為的一個有趣變化:模型從語言中的顯式驗證語句「8*35 是 280,太高了」過渡到隱式解決方案檢查,模型依次嘗試不同的解,直到找到正確的答案,而不使用文字來評估自己的工作。

這種對比引出了一個基本問題:哪些潛在的能力能夠成功地實現基于推理的改進?要回答這個問題,需要一個系統的框架來分析認知行為。

分析認知行為的框架

為了理解這些不同的學習軌跡,研究者開發了一個框架來識別和分析模型輸出中的關鍵行為。他們重點關注四種基本行為:

1、回溯或在檢測到錯誤時顯式修改方法(例如,「這種方法行不通,因為...」);

2、驗證或系統地檢查中間結果(例如,「讓我們通過... 來驗證這個結果」);

3、子目標設定,即將復雜問題分解為可管理的步驟(例如,「要解決這個問題,我們首先需要...」);

4、逆向思考,即在目標導向的推理問題中,從期望的結果出發,逐步向后推導,找到解決問題的路徑。(例如,「要達到 75 的目標,我們需要一個能被... 整除的數字」)。

選擇這些行為是因為它們代表了與語言模型中常見的線性、單調推理模式不同的問題解決策略。這些行為使更加動態、類似搜索的推理軌跡成為可能,解決方案可以非線性地演變。雖然這組行為并非詳盡無遺,但選擇這些行為是因為它們容易識別,并且自然地與 Countdown 游戲和更廣泛的數學推理任務(如證明構建)中的人類問題解決策略相一致。

每種行為都可以通過其在推理 token 中的模式來識別。回溯被視為顯式否定并替換先前步驟的 token 序列,驗證產生將結果與解決方案標準進行比較的 token,逆向思考從目標出發,逐步構建通往初始狀態的解決方案路徑的 token,而子目標設定則顯式提出在通往最終目標的路徑上要瞄準的中間步驟。研究者開發了一個使用 GPT-4o-mini 的分類 pipeline,可靠地識別模型輸出中的這些模式。

初始行為在自我提升中的作用

將這個框架應用于初始實驗揭示了一個關鍵洞察:Qwen 的顯著性能改進與認知行為的出現相吻合,特別是驗證和回溯(圖 1(中))。相比之下,Llama 在整個訓練過程中幾乎沒有表現出這些行為的證據。

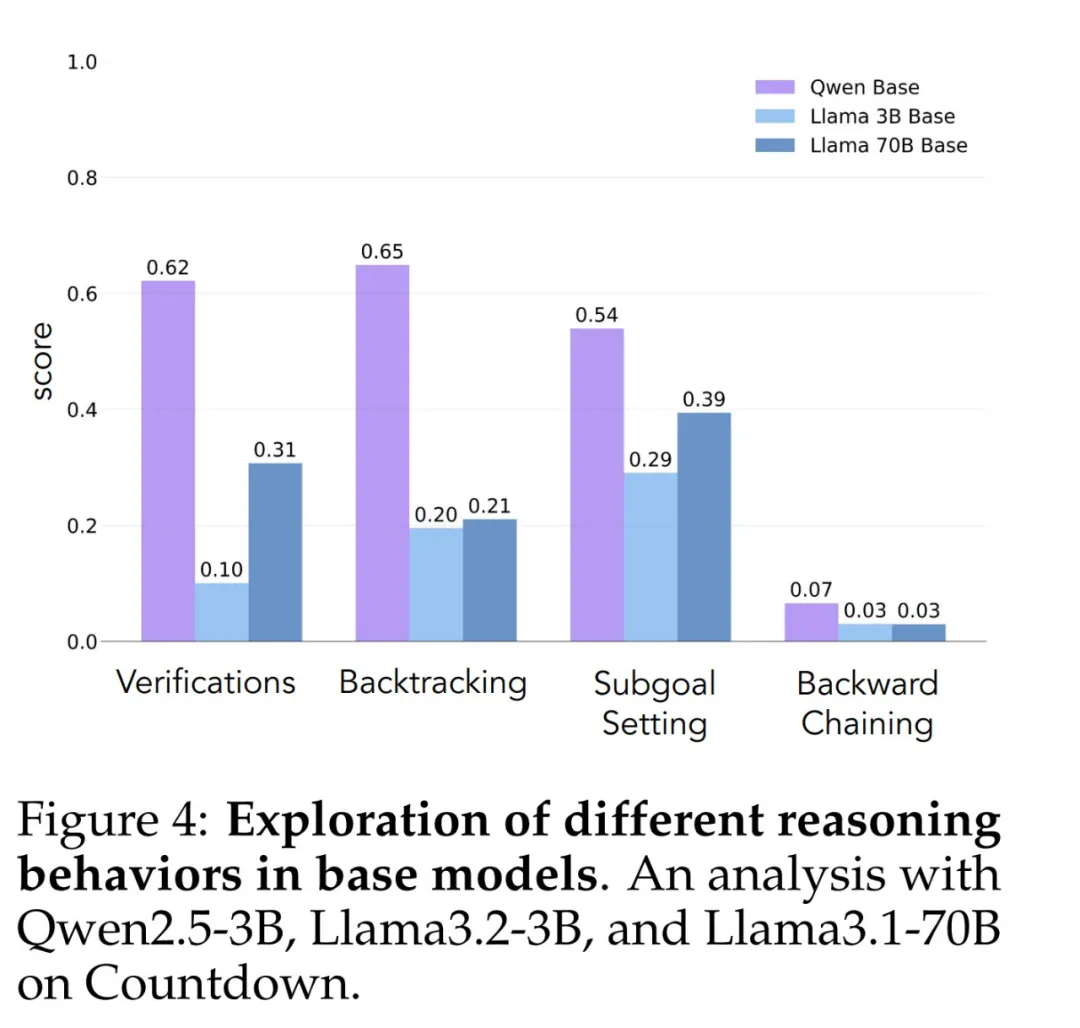

為了更好地理解這種差異,研究者分析了三個模型的基線推理模式:Qwen-2.5-3B、Llama-3.2-3B 和 Llama-3.1-70B。分析揭示,與兩種 Llama 變體相比,Qwen-2.5-3B 產生各種行為的比例都要更高(圖 4)。盡管較大的 Llama-3.1-70B 在這些行為的激活頻率上普遍高于 Llama-3.2-3B,但這種提升并不均衡 —— 特別是回溯行為,即便在更大的模型中,其表現仍然有限。

這些觀察結果表明兩個洞察:

1、初始策略中的某些認知行為可能是模型通過擴展推理序列有效利用增加的測試時間計算所必需的;

2、增加模型規模可以改善這些行為的上下文激活。這種模式尤為重要,因為強化學習只能放大成功軌跡中出現的行為 —— 使這些初始行為能力成為有效學習的先決條件。

干預初始行為

在確立了基礎模型中認知行為的重要性之后,接下來研究是否可以通過有針對性的干預人為誘導這些行為。

研究者提出的假設是,通過在 RL 訓練前創建選擇性表現特定認知行為的基礎模型變體,可以更好地理解哪些行為模式對于實現有效學習至關重要。

他們首先使用 Countdown 問題策劃了七個不同的啟動數據集。其中五個數據集強調不同的行為組合:所有策略組合、僅回溯、回溯與驗證、回溯與子目標設定以及回溯與逆向思考。他們使用 Claude-3.5-Sonnet 生成這些數據集,利用其能夠產生具有精確指定行為特征的推理軌跡的能力。

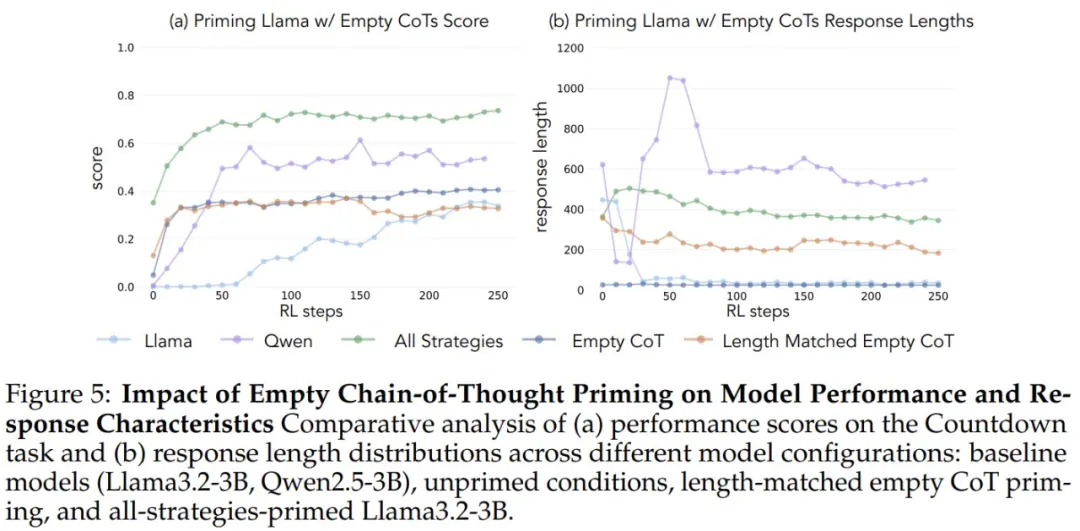

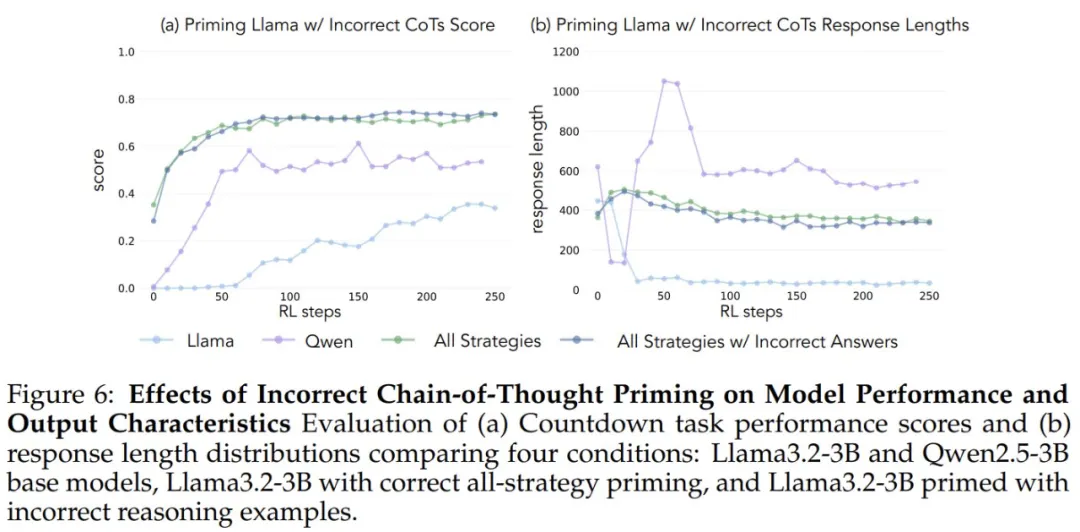

為了驗證改進源于特定的認知行為而非簡單的計算時間增加,研究引入了兩個控制條件:一個空的思維鏈和一個與所有策略數據集的數據點長度匹配的填充占位符 token 的鏈。這些控制數據集幫助作者驗證觀察到的任何改進是否源于特定的認知行為,而非簡單的計算時間增加。作者還創建了全策略數據集的變體,其中僅包含不正確的解決方案,同時保持所需的推理模式。此變體使作者能夠將認知行為的重要性與解決方案的準確性區分開來。

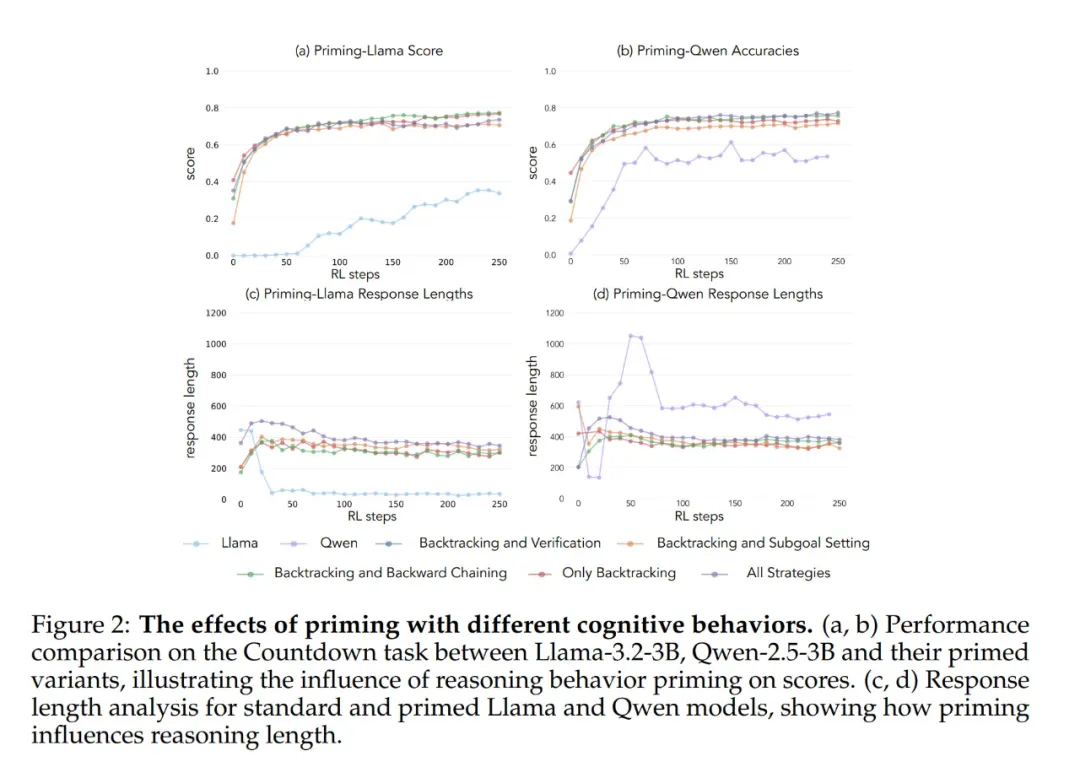

當使用包含回溯行為的數據集進行初始化時,Llama 和 Qwen 都通過 RL 訓練表現出明顯的改進(圖 2)。

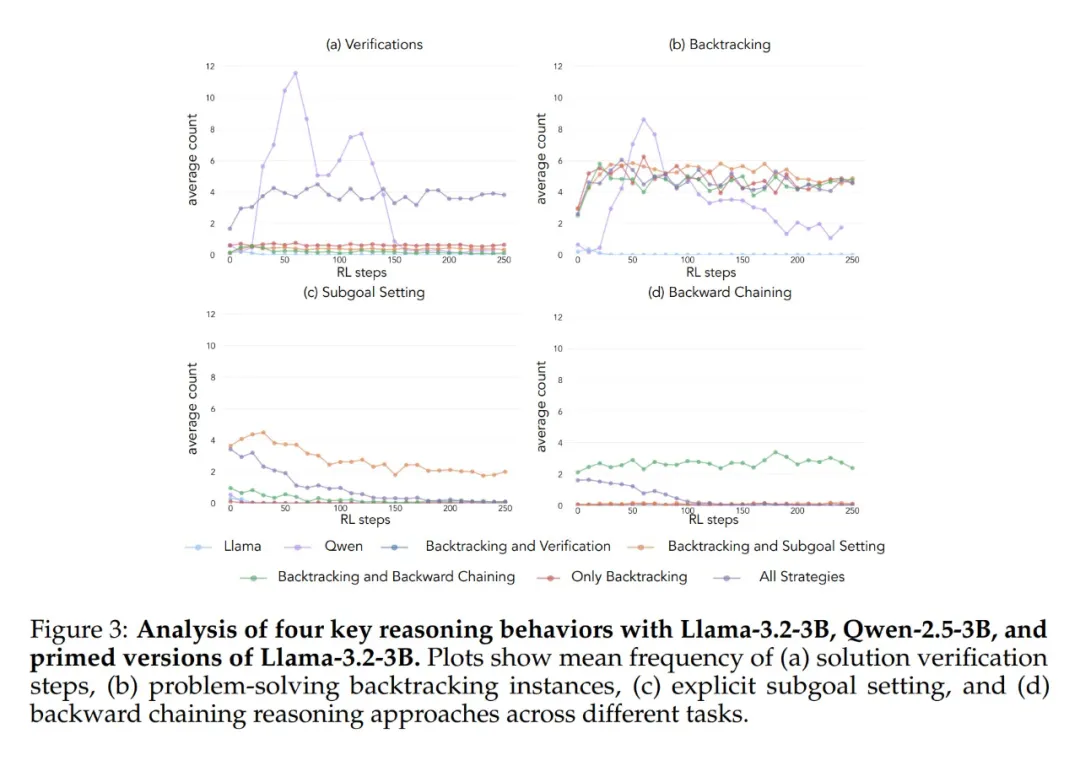

行為分析表明,RL 會選擇性地放大經驗上有用的行為,同時抑制其他行為(圖 3)。

例如,在全策略條件下(圖 1(左下)),模型保留并加強回溯和驗證,同時減少逆向思考和子目標設定。然而,當僅與回溯配對時,被抑制的行為(逆向思考和子目標設定)會在整個訓練過程中持續存在。

當用空的思維鏈控制進行啟動時,在兩種情況下,模型的性能都與基本 Llama 模型相當(≈30-35%;見圖 5),這表明僅僅分配額外的 token 而不包含認知行為無法有效利用測試時間計算。此外,使用空的思維鏈進行訓練會產生不利影響,Qwen 模型會停止探索行為。這表明這些認知行為對于模型通過更長的推理序列有效利用擴展計算是特別必要的。

令人驚訝的是,用不正確的解決方案啟動但具有正確行為的模型,與在具有正確解決方案的數據集上訓練的模型具有相同的性能(圖 6)。這表明認知行為存在(而不是獲得正確的解決方案)是通過強化學習成功實現自我改進的關鍵因素。因此,來自較弱模型的推理模式可以有效地引導學習過程以構建更強大的模型,這表明認知行為的存在比結果的正確性更重要。

在預訓練數據中選擇性地放大行為

上述結果表明,某些認知行為對于自我完善是必要的。然而,作者在初始模型中誘導行為的啟動方法是領域特定的,依賴于 Countdown 游戲。這可能會對最終推理的泛化產生不利影響。我們能否通過修改模型的預訓練分布來增加有益推理行為的頻率,從而實現自我完善?

為了探究預訓練數據中的行為頻率,作者首先分析了預訓練數據中認知行為的自然頻率,重點關注 OpenWebMath 和 FineMath,它們是專門為數學推理而構建的。使用 Qwen-2.5-32B 作為分類器,研究分析了 20 萬份隨機抽樣的文檔,以查找目標行為的存在。即使在這個以數學為重點的語料庫中,回溯和驗證等認知行為也很少出現,這表明標準預訓練對這些關鍵模式的接觸有限(見圖 7)。

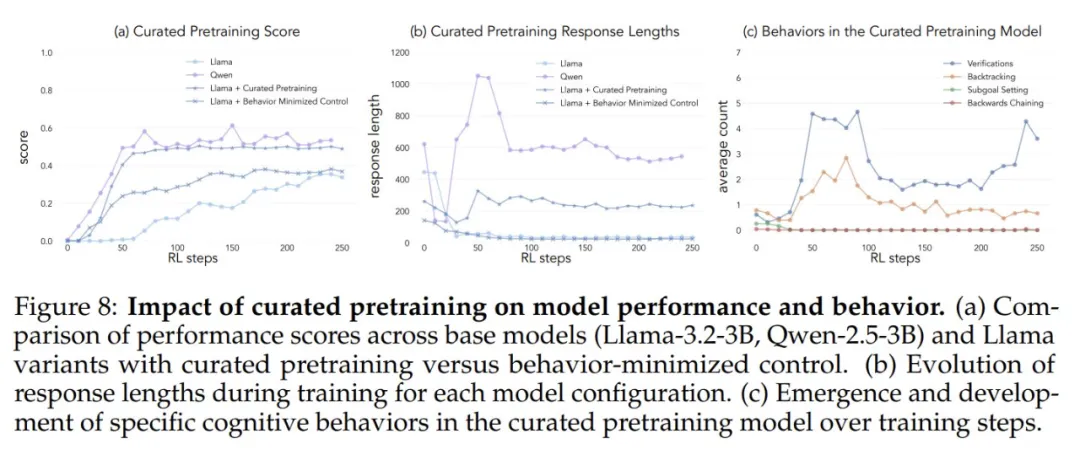

為了測試人為增加認知行為的接觸是否會增強自我提升的潛力,作者從 OpenWebMath 開發了一個有針對性的持續預訓練數據集。首先使用 Qwen-2.5-32B 作為分類器,分析來自預訓練語料庫的數學文檔,以了解目標推理行為的存在。以此為基礎人們創建了兩個對比集:一個具有認知行為,另一個極少認知內容的控制集。

然后,他們使用 Qwen-2.5-32B 將集合中的每個文檔重寫為結構化的問答格式,保留源文檔中認知行為的自然存在或缺失。最終的預訓練數據集每個都包含總共 830 萬 token。這種方法使作者能夠隔離推理行為的影響,同時控制預訓練期間數學內容的格式和數量。

在這些數據集上對 Llama-3.2-3B 進行預訓練并應用強化學習后,作者能觀察到:1)行為豐富模型實現了與 Qwen 相當的性能,而控制模型的改進有限(圖 8a);2)對訓練模型的行為分析表明,行為豐富變體在整個訓練過程中保持推理行為的高激活度,而控制模型表現出與基本 Llama 模型類似的行為(圖 8c)。

這些結果表明,有針對性地修改預訓練數據,可以通過強化學習成功生成有效自我改進所必需的認知行為。

更多信息請參見原論文。