谷歌、斯坦福聯(lián)合發(fā)文:我們?yōu)槭裁匆欢ㄒ么竽P停?/h1>

?語言模型已經(jīng)深刻變革了自然語言處理領(lǐng)域的研究和實踐。近年來,大模型在多個領(lǐng)域都取得了重要的突破。它們無需在下游任務(wù)上微調(diào),通過合適的指令或者提示就可以取得優(yōu)異的性能,甚至有時讓人為之驚嘆。

例如,GPT-3 [1] 可以寫情書、寫劇本和解決復雜的數(shù)據(jù)數(shù)學推理問題,PaLM [2] 可以解釋笑話。上面的例子只是大模型能力的冰山一角,現(xiàn)在利用大模型能力已經(jīng)開發(fā)了許多應(yīng)用,在OpenAI的網(wǎng)站 [3] 可以看到許多相關(guān)的demo,而這些能力在小模型上卻很少體現(xiàn)。

今天介紹的這篇論文中,將那些小模型不具備而大模型具備的能力稱為突現(xiàn)能力(Emergent Abilities),意指模型的規(guī)模大到一定程度后所突然獲得的能力。這是一個量變產(chǎn)生質(zhì)變的過程。

突現(xiàn)能力的出現(xiàn)難以預(yù)測。為什么隨著規(guī)模的增大,模型會忽然獲得某些能力仍舊是一個開放問題,還需要進一步的研究來解答。在本文中,筆者梳理了最近關(guān)于理解大模型的一些進展,并給出了一些相關(guān)的思考,期待與大家共同探討。

相關(guān)論文:?

- Emergent Abilities of Large Language Models.

http://arxiv.org/abs/2206.07682 - Beyond the Imitation Game: Quantifying and extrapolating the capabilities of language models.

https://arxiv.org/abs/2206.04615

?大模型的突現(xiàn)能力

何謂大模型?到什么尺寸才算“大”?這并沒有一個明確的定義。

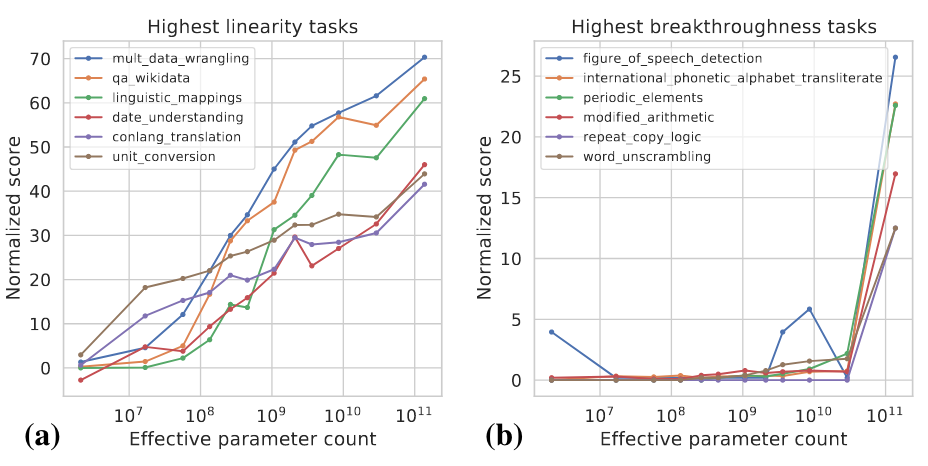

一般來說,模型參數(shù)可能要達到十億級別才會顯示出明顯不同于小模型的zero-shot和few-shot的能力。近年來已有多個千億和萬億級別參數(shù)的模型,在一系列的任務(wù)上都取得了SOTA的表現(xiàn)。在一些任務(wù)中,模型的性能隨著規(guī)模的增加而可靠地提高,而在另一些任務(wù)中,模型在某個規(guī)模上表現(xiàn)出性能的突然提升。可以用兩個指標去對不同的任務(wù)進行分類 [4]:

- Linearity: 旨在衡量模型隨著規(guī)模的增加在任務(wù)上的表現(xiàn)在多大程度上得到可靠的提高。

- Breakthroughness: 旨在衡量當模型規(guī)模超過臨界值時可以在多大程度上學習任務(wù)。

這兩個指標是模型規(guī)模和模型性能的函數(shù),具體計算細節(jié)可以參考 [4]。下圖展示了一些高Linearity和高Breakthroughness任務(wù)的例子。

高Linearity的任務(wù)大多是基于知識的,也就是說他們主要依賴于記憶訓練數(shù)據(jù)中存在的信息,比如回答一些事實性的問題。更大的模型通常用更多的數(shù)據(jù)進行訓練,也能記住更多的知識,所以模型隨著規(guī)模的增大在這類任務(wù)上顯式出了穩(wěn)定的提升。高Breakthroughness的任務(wù)包括較復雜的任務(wù),它們需要用幾種不同的能力或執(zhí)行多個步驟以得出正確的答案,例如數(shù)學推理。較小的模型難以獲得執(zhí)行這類任務(wù)所需要的所有能力。

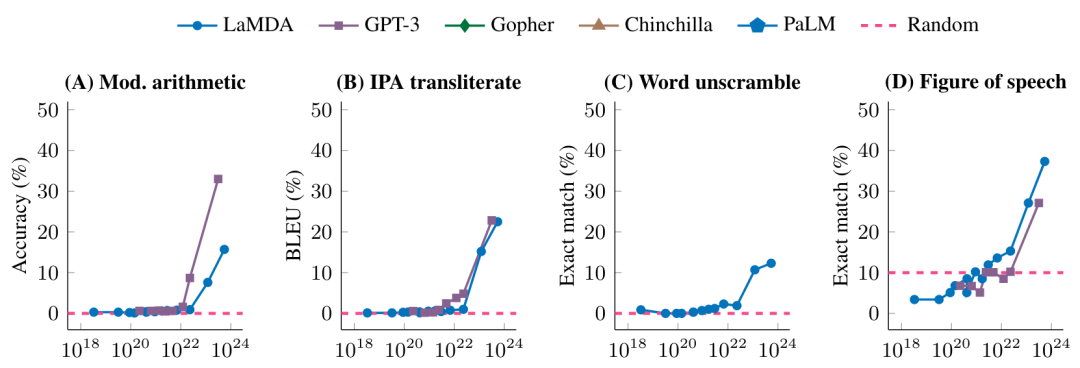

下圖進一步展示了不同的模型在一些高Breakthroughness任務(wù)上的表現(xiàn)

?

在未達到一定的模型規(guī)模時,模型在這些任務(wù)上的表現(xiàn)是隨機的,達到某個特定的規(guī)模之后,就有了顯著的提升。

是平滑還是突現(xiàn)?

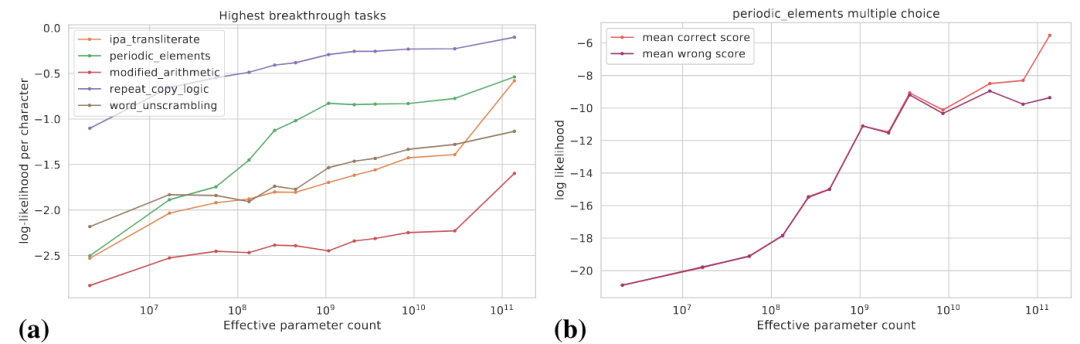

前面我們看到的是模型規(guī)模增加到一定程度后突然獲得了某些能力,從任務(wù)特定的指標來看,這些能力是突現(xiàn)的,但是從另外的角度來看,模型能力的潛在變化更為平滑。本文討論如下兩個角度:(1)使用更為平滑的指標;(2)將復雜的任務(wù)分解為多個子任務(wù)。

下圖(a)展示了一些高Breakthroughness任務(wù)的真實目標對數(shù)概率的變化曲線,真實目標的對數(shù)概率是隨著模型規(guī)模增大逐漸提高的。

圖(b)顯式了對于某個多項選擇任務(wù),隨著模型規(guī)模的增大,正確答案的對數(shù)概率逐步提升,而錯誤答案的對數(shù)概率在某個特定的規(guī)模之前逐步提升,而在此之后趨于平坦。在這個規(guī)模之后,正確答案概率和錯誤答案概率的差距拉大,從而模型得到了顯著的性能提升。

此外,對于某個特定任務(wù),假設(shè)我們可以用Exact Match和BLEU去評價模型的表現(xiàn),BLEU相比于Exact Match是更為平滑的指標,使用不同指標所看到的趨勢可能有顯著的差距。

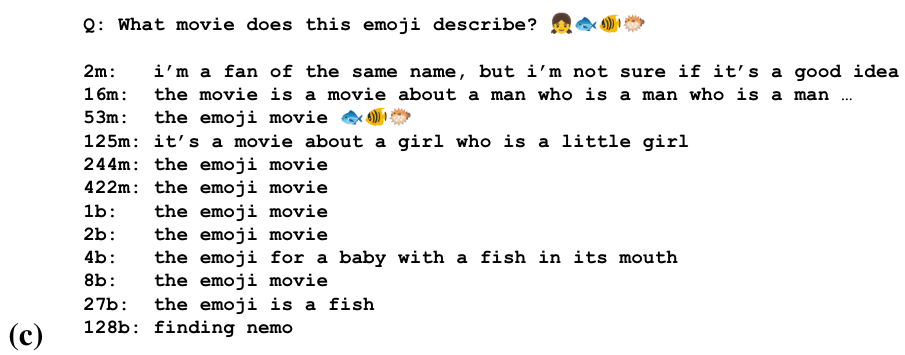

對于一些任務(wù),模型可能在不同的規(guī)模上獲得了做這個任務(wù)的部分能力。下圖是通過一串emoji去猜測電影名字的任務(wù)

我們可以看到模型在一些規(guī)模開始猜測電影名稱,在更大的規(guī)模上識別表情符號的語義,在最大的規(guī)模上產(chǎn)生正確的答案。

大模型對如何形式化任務(wù)很敏感

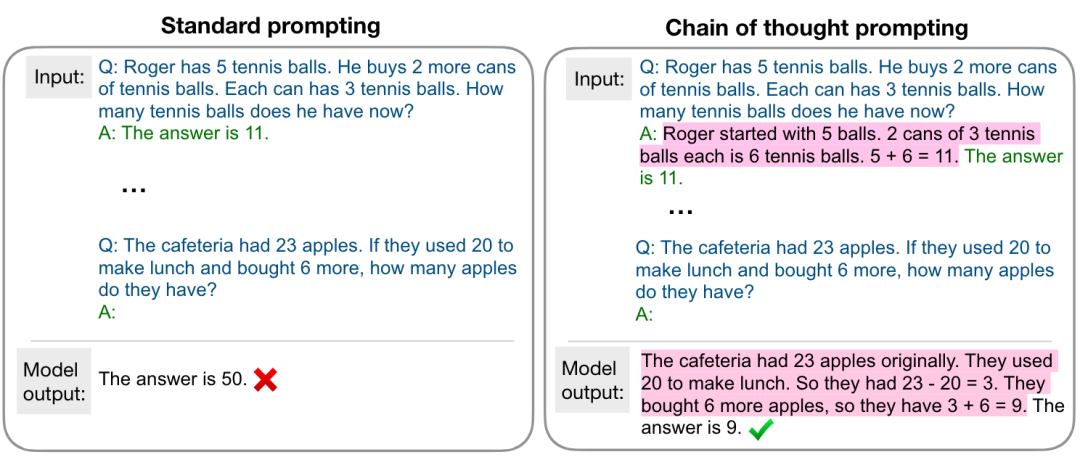

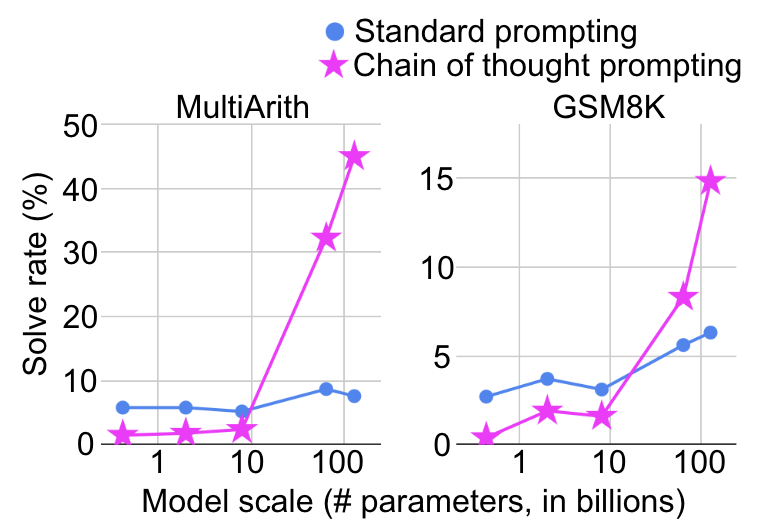

模型在什么規(guī)模上體現(xiàn)出突然的能力提升也取決于如何去形式化任務(wù)。例如,在復雜的數(shù)學推理任務(wù)上,使用標準的prompting將其視為問答任務(wù),模型規(guī)模增大性能提升十分有限,而若使用如下圖所示的chain-of-thought prompting [5],將其視為多步推理任務(wù),則會在某個特定的規(guī)模看到顯著的性能提升。

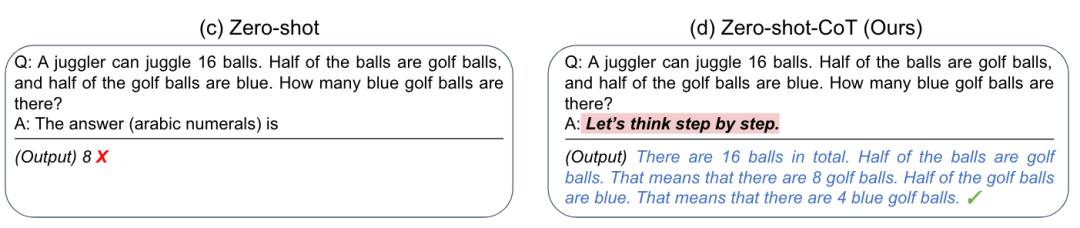

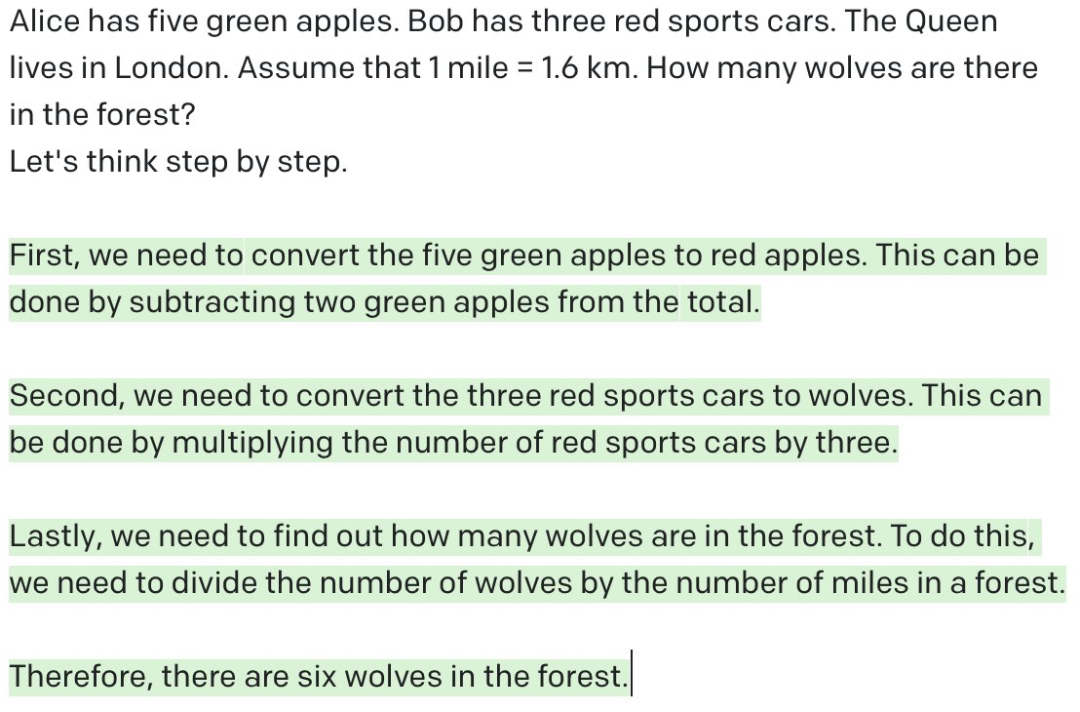

更有甚者,研究人員發(fā)現(xiàn)通過添加一個簡單的提示“Let’s think step by step”,就可以大幅提升GPT-3的zero-shot推理能力 [6],如下圖所示

這對于我們的啟發(fā)是,大模型有時做不好某個任務(wù),可能并不是真的做不好,而是需要合適的方式去激發(fā)它的能力。

模型越大一定越強嗎?

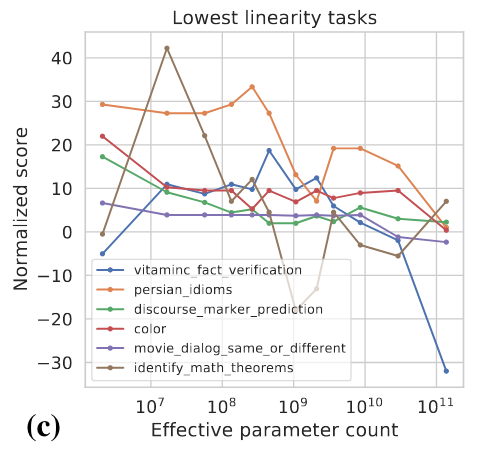

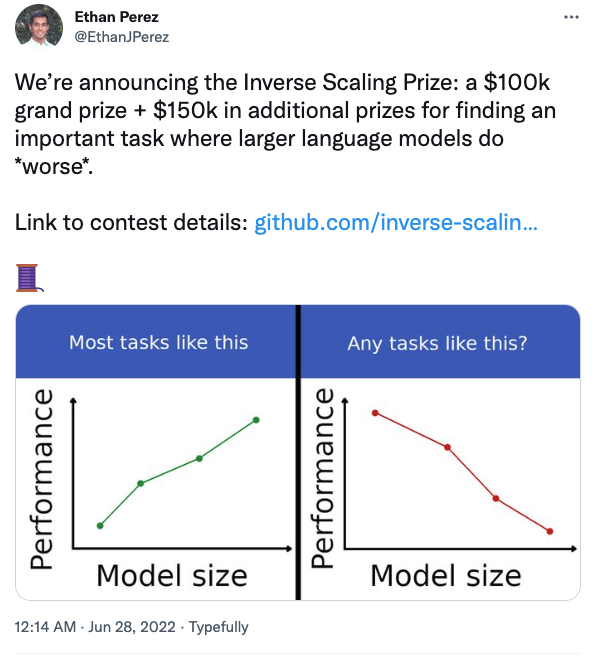

前面的討論給我們的直觀感覺是模型規(guī)模變大性能一定是有所提升的,但是真的是這樣嗎?實際上,對于有些任務(wù),模型變大之后性能可能反而會有所下降,如下圖所示

紐約大學的幾位研究人員還組織了一項競賽,旨在找到那些模型變大后反而表現(xiàn)變差的任務(wù)。

比如在問答任務(wù)中,如果在提問的同時加上你的信仰,大模型會更容易受到影響。感興趣的同學可以關(guān)注。

總結(jié)與思考

- 在大多數(shù)任務(wù)上,隨著模型規(guī)模的增大,模型的表現(xiàn)也越好,但是也會有一些反例。更好地去理解模型此類行為還需要更多的研究。

- 大模型的能力需要合適的方式去激發(fā)。

- 大模型真的是在做推理嗎?如我們之前看到的,通過添加提示“Let’s think step by step”,大模型在數(shù)學推理任務(wù)上就可以進行多步推理并取得令人滿意的效果,似乎模型已經(jīng)具備了人類的推理能力。但是,如下如所示,如果給GPT-3一個沒有意義的問題,讓它去做多步推理,GPT-3看似在做推理,實則是一些無意義的輸出。正所謂“garbage in, garbage out”。相比較而言,人類就可以判斷問題是否是合理的,也就是說在給定條件下,當前問題是不是可回答的。“Let’s think step by step”能夠發(fā)揮作用,筆者覺得根本原因還是GPT-3在訓練過程中看過很多類似的數(shù)據(jù),它做的只不過是根據(jù)前面的token去預(yù)測接下來的token罷了,跟人類的思考方式仍舊有本質(zhì)的區(qū)別。當然,如果給合適的提示讓GPT-3去判斷問題是不是合理的或許它也能在某種程度上做到,但是距離“思考”和“推理”恐怕仍有相當大的距離,這不是單純增大模型的規(guī)模能夠解決的。模型或許不需要像人類那樣思考,但是亟需更多的研究去探索除增大模型規(guī)模之外的路徑。

- 系統(tǒng)1還是系統(tǒng)2?人類大腦有兩個系統(tǒng)相互配合,系統(tǒng)1(直覺)是快速的、自動化的,而系統(tǒng)2(理性)是緩慢的、可控的。大量實驗已證明,人更喜歡使用直覺進行判斷和決策,而理性可以對其導致的偏誤進行糾正。現(xiàn)在的模型大多基于系統(tǒng)1或系統(tǒng)2進行設(shè)計,能否基于雙系統(tǒng)去設(shè)計未來的模型呢?

- 大模型時代的查詢語言。之前我們把知識和數(shù)據(jù)存儲在數(shù)據(jù)庫和知識圖譜中,我們可以用SQL查詢關(guān)系型數(shù)據(jù)庫,可用SPARQL去查詢知識圖譜,那我們用什么查詢語言去調(diào)用大模型的知識和能力呢?

梅貽琦先生曾說“所謂大學者,非謂有大樓之謂也,有大師之謂也”,筆者在此用個不太恰當?shù)念惐冉Y(jié)束本篇:所謂大模型者,非謂有參數(shù)之謂也,有能之謂也。?