重磅!阿里深夜推出全新推理模型,僅1/20參數媲美DeepSeek R1

就在剛剛,阿里Qwen 團隊 正式發布了他們最新的研究成果 —— QwQ-32B 大語言模型! 這款模型不僅名字萌萌噠 (QwQ),實力更是不容小覷!??

相信關注大模型領域的朋友們都知道,模型參數量的大小往往與性能成正比。但這次,Qwen 團隊卻用 320億參數 的 QwQ-32B,硬剛擁有 6710億參數 的 DeepSeek-R1,并且在多項評測中取得了媲美甚至超越后者的驚人成績!背后究竟是什么黑科技? 答案就是 —— 強化學習 (Reinforcement Learning, RL)!

劃重點:強化學習,大模型的新引擎!??

Qwen 團隊在博文中提到,他們深入探索了強化學習 (RL)在提升大語言模型智能方面的巨大潛力。QwQ-32B 的成功發布,有力地證明了 RL 是提升模型性能的強大引擎!

多項基準評測硬剛 DeepSeek-R1

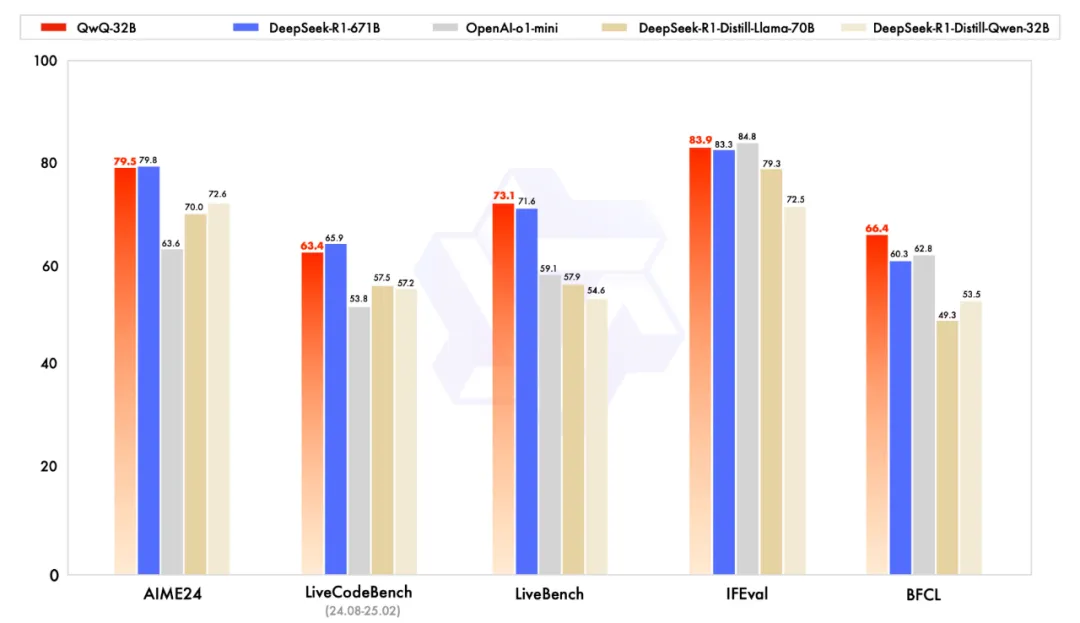

QwQ-32B 的實力究竟有多強? 官方給出基準評測結果,涵蓋了數學推理、代碼能力和通用問題解決等多個方面

從數據中我們可以清晰地看到,在 AIME24 和 IFEval 等關鍵基準測試中,QwQ-32B 的表現相當或者略微超過了參數量巨大的 DeepSeek-R1! 而在其他基準測試中,也基本與 DeepSeek-R1 持平,遠超其他對比模型。

這意味著 QwQ-32B 在 僅有 DeepSeek-R1 約 1/20 參數量 的情況下, 用強化學習,實現了性能上的驚人跨越!

技術揭秘:冷啟動 + 結果導向的強化學習策略

Qwen 團隊在博文中也簡單介紹了 QwQ-32B 背后的強化學習方法。他們采用了 冷啟動 (cold-start checkpoint) 的方式,并實施了 結果導向 (outcome-based rewards) 的強化學習策略。

? 冷啟動: 從一個預訓練模型的檢查點開始訓練。

? 結果導向: 在初始階段,主要針對數學和代碼任務進行 RL 訓練。

a.數學問題: 使用 準確率驗證器 (accuracy verifier) 來確保答案的正確性。

b.代碼生成: 使用 代碼執行服務器 (code execution server) 來評估生成的代碼是否能夠成功運行。

? 通用獎勵模型和規則驗證器: 后續階段,會逐步引入更通用的獎勵模型和規則驗證器,提升模型在其他通用能力方面的表現。

這種策略的核心在于 不依賴傳統的獎勵模型,而是直接根據任務結果(答案是否正確,代碼是否運行成功)來指導模型的學習,更加高效和直接。

開源開放

QwQ-32B 模型是 開源開放 (open-weight) 的! 你可以在 Hugging Face 和 ModelScope 上找到它,并基于 Apache 2.0 協議 自由使用和研究! 同時,你也可以通過 Qwen Chat 平臺直接體驗 QwQ-32B 的對話能力

HF:https://huggingface.co/Qwen/QwQ-32B

ModelScope:https://modelscope.cn/models/Qwen/QwQ-32B

Demo:https://huggingface.co/spaces/Qwen/QwQ-32B-Demo

Qwen Chat:https://chat.qwen.ai

寫在最后

Qwen 團隊表示,QwQ-32B 的發布只是他們在強化學習方向上的初步嘗試。未來,他們將繼續深入探索 RL 的潛力,并將其與更強大的基礎模型相結合,利用更大的計算資源,致力于打造 下一代 Qwen 模型,并最終邁向 通用人工智能 (AGI) 目標!

同時,他們還將積極探索 Agent 與 RL 的結合,實現更長程的推理能力,解鎖更高級別的智能