「DeepSeek接班OpenAI」,最新開源的R1推理模型,讓AI圈爆了

昨晚,大模型領域再次「熱鬧起來」,月之暗面發布在數學、代碼、多模態推理能力層面全面對標 OpenAI 的滿血版 o1 的多模態思考模型 K1.5。而最近大熱的 DeepSeek 正式推出了 DeepSeek-R1,同樣在數學、代碼和自然語言推理等任務上比肩 OpenAI o1 正式版。

去年 12 月開源的大模型 DeepSeek-V3 剛剛掀起了一陣熱潮,實現了諸多的不可能。這次開源的 R1 大模型則在一開始就讓一眾 AI 研究者感到「震驚」,人們紛紛在猜測這是如何做到的。

AutoAWQ 作者 Casper Hansen 表示,DeepSeek-R1 使用一種多階段循環的訓練方式:基礎→ RL →微調→ RL →微調→ RL。

UC Berkeley 教授 Alex Dimakis 則認為 DeepSeek 現在已經處于領先位置,美國公司可能需要迎頭趕上了。

目前,DeepSeek 在網頁端、App 端和 API 端全面上線了 R1,下圖為網頁端對話界面,選擇 DeepSeek-R1 就能直接體驗。

體驗地址:https://www.deepseek.com/

此次,DeepSeek 發布了兩個參數為 660B 的 DeepSeek-R1-Zero 和 DeepSeek-R1,并選擇開源了模型權重,同時允許用戶使用 R1 來訓練其他模型。

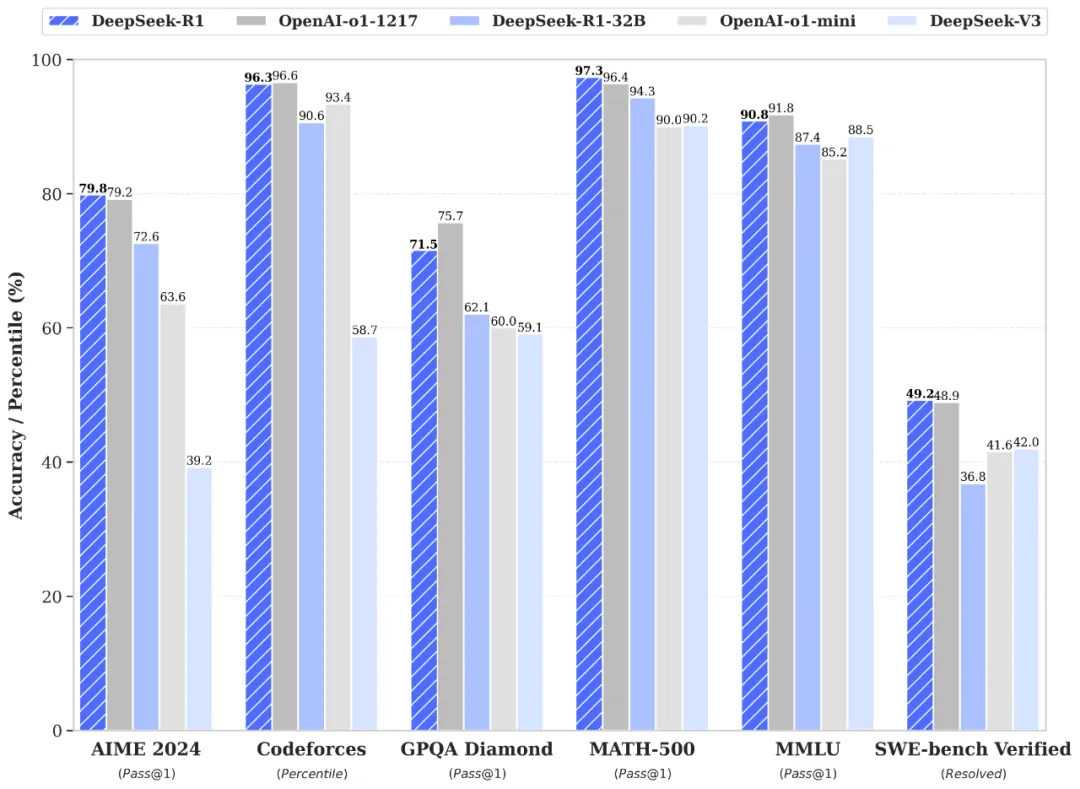

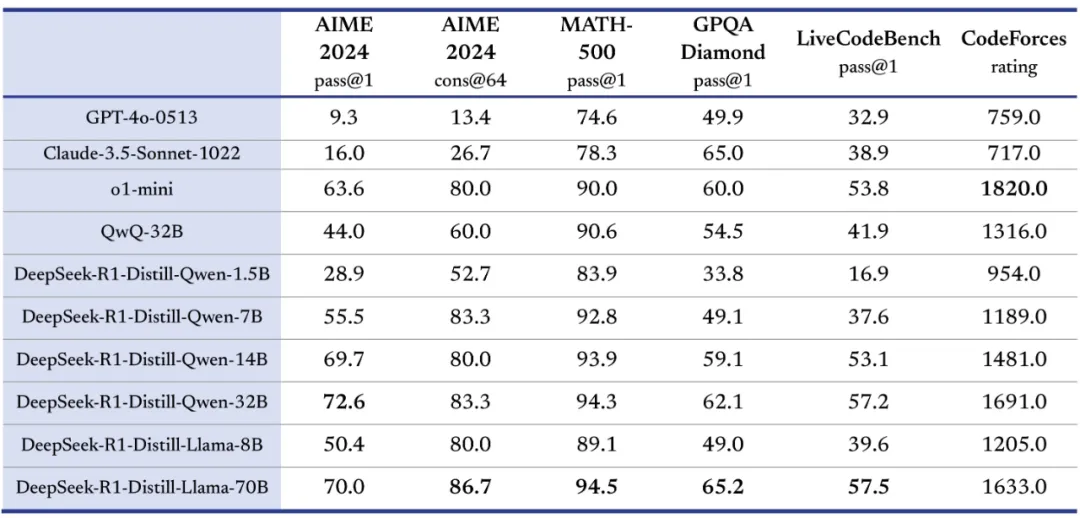

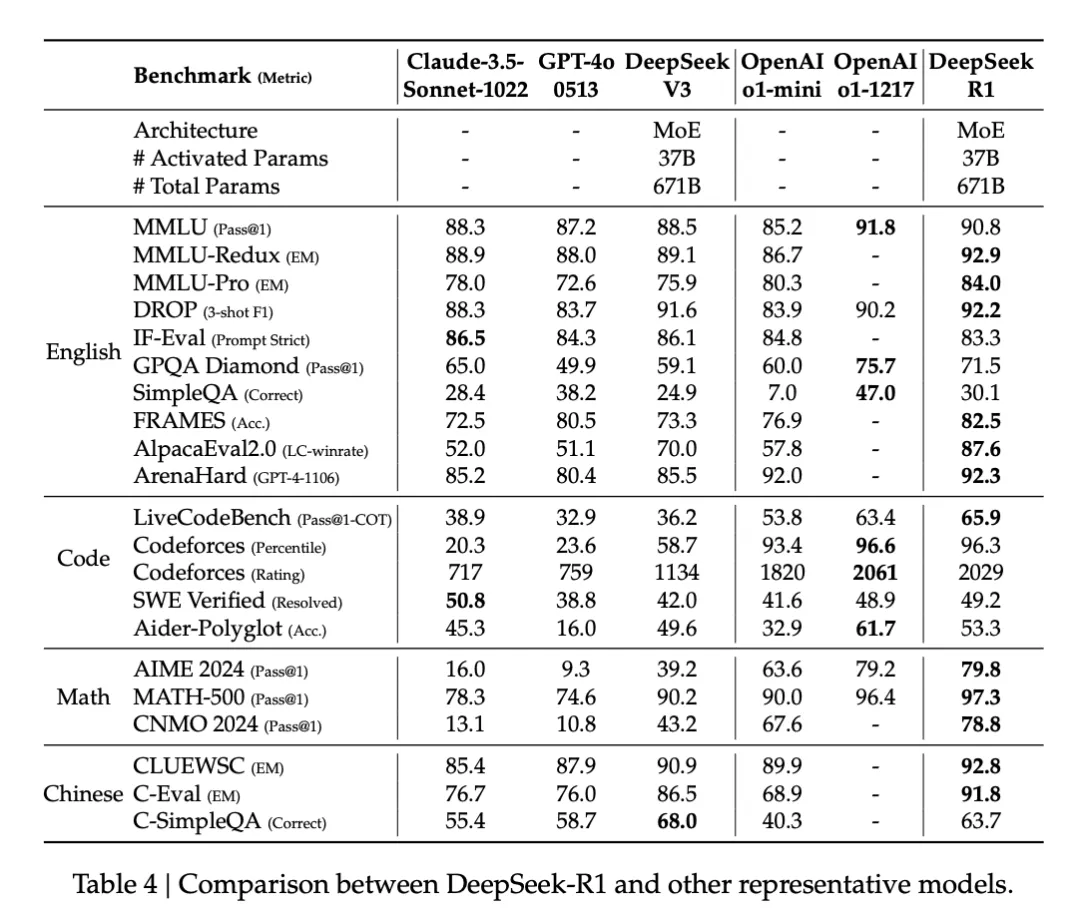

在技術層面,R1 在后訓練階段大規模使用了強化學習(RL)技術,在僅用非常少標注數據的情況下,極大提升了模型推理能力。下圖為 R1 與 o1-1217、o1-mini、自家 DeepSeek-V3 在多個數據集上的性能比較,可以看到,R1 與 o1-1217 不相上下、互有勝負。

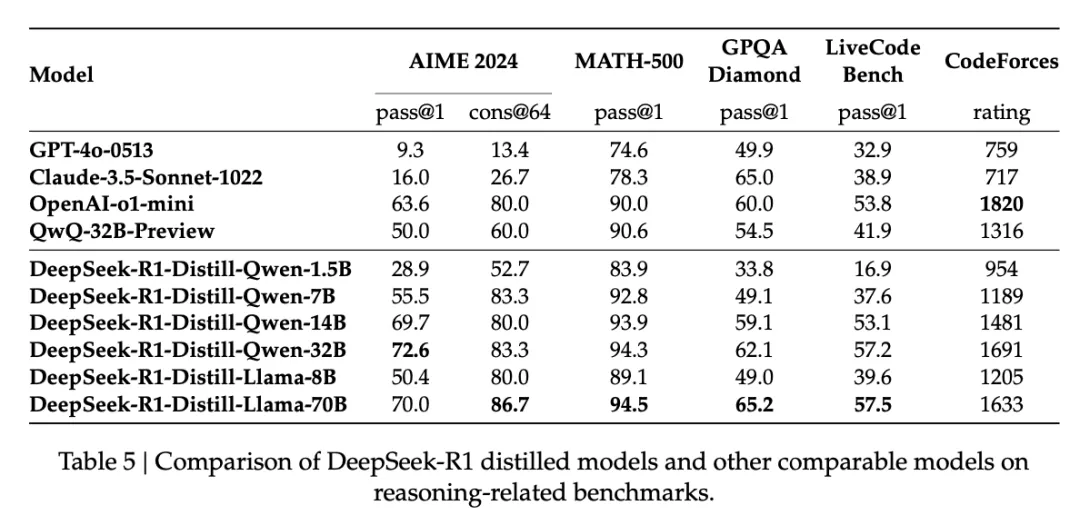

另外,DeepSeek-R1 蒸餾出了六個小模型,參數從小到大分別為 1.5B、7B、8B、14B、32B 以及 70B。這六個模型同樣完全開源,旨在回饋開源社區,推動「Open AI」的邊界。

模型下載地址:https://huggingface.co/deepseek-ai?cnotallow=f18057c998f54575cb0608a591c993fb

性能方面,蒸餾后的 R1 32B 和 70B 版本遠遠超過了 GPT-4o、Claude 3.5 Sonnet 和 QwQ-32B,并逼近 o1-mini。

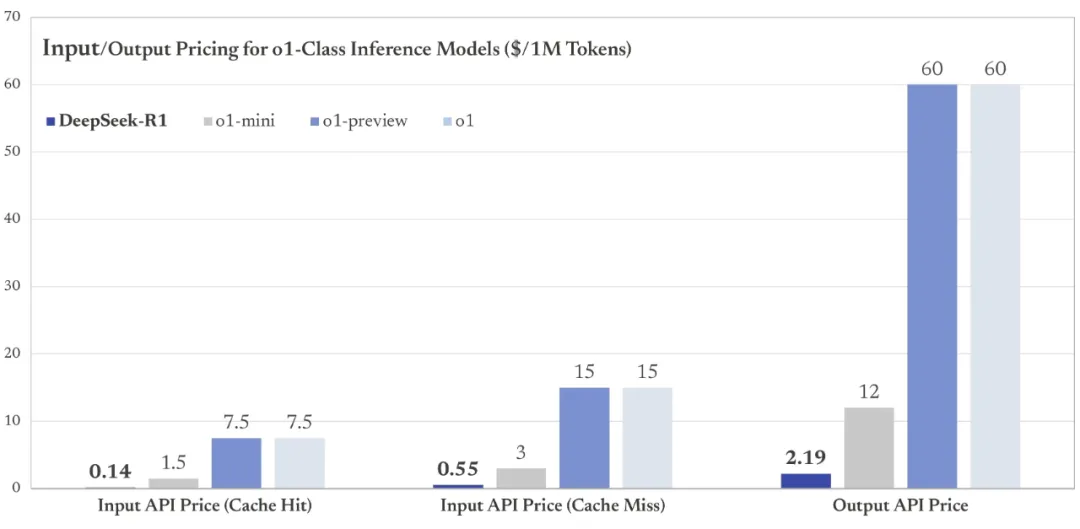

至于很多開發者關心的 DeepSeek-R1 API 價格,可以說是一如既往地給力。

DeepSeek-R1 API 服務的定價為每百萬輸入 tokens 1 元(緩存命中)/ 4 元(緩存未命中),每百萬輸出 tokens 16 元。

顯然,與 o1 的 API 定價比起來(每百萬輸入 tokens 15 美元、每百萬輸出 tokens 60 美元),DeepSeek 具有極高的性價比。

DeepSeek 秉持了開源到底的決心,將 R1 模型的訓練技術全部開放,放出了背后的研究論文。

論文鏈接:https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

R1 技術報告

以往的研究主要依賴大量的監督數據來提升模型性能。DeepSeek 的開發團隊則開辟了一種全新的思路:即使不用監督微調(SFT)作為冷啟動,通過大規模強化學習也能顯著提升模型的推理能力。如果再加上少量的冷啟動數據,效果會更好。

為了做到這一點,他們開發了 DeepSeek-R1-Zero。具體來說,DeepSeek-R1-Zero 主要有以下三點獨特的設計:

首先是采用了群組相對策略優化(GRPO)來降低訓練成本。GRPO 不需要使用與策略模型同樣大小的評估模型,而是直接從群組分數中估算基線。

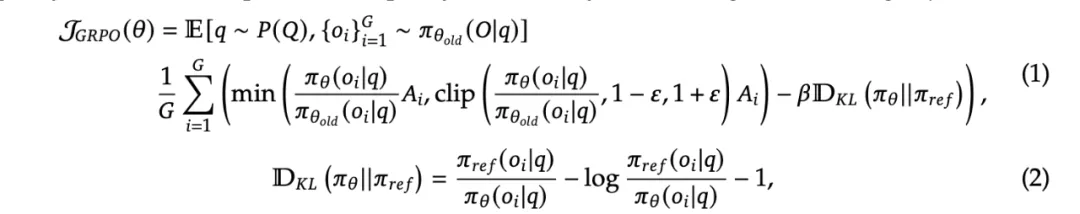

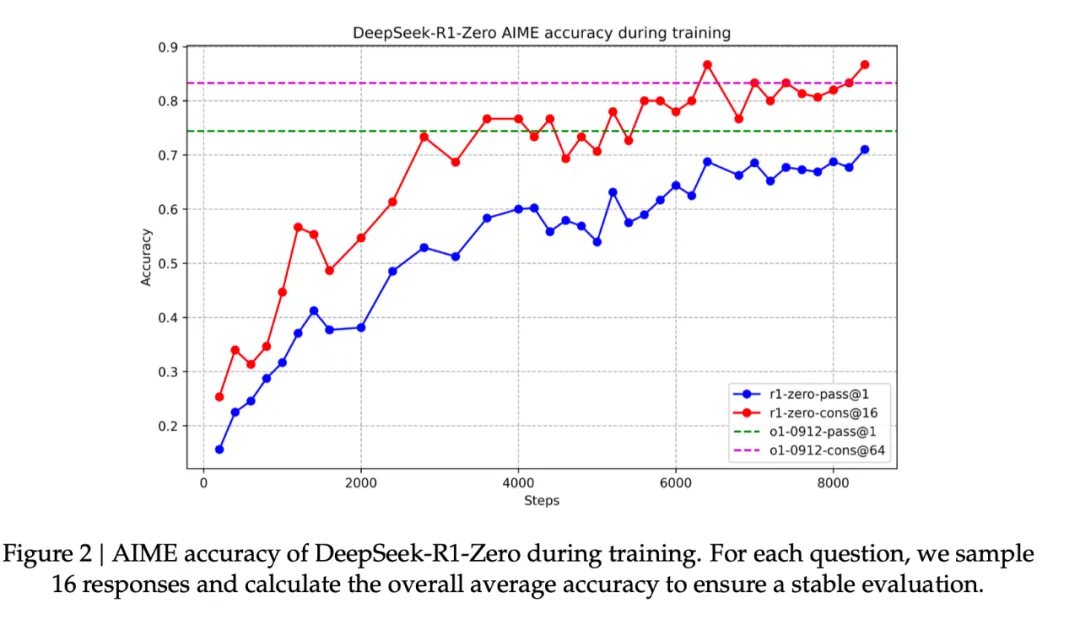

對于每個輸入問題 q,GRPO 算法會從舊策略中采樣一組輸出 {o1, o2, ..., oG},形成評估群組,然后通過最大化目標函數來優化策略模型:

其中,優勢值 A_i 通過標準化每個輸出的獎勵來計算:

其次是獎勵設計。如何設計獎勵,決定著 RL 優化的方向。DeepSeek 給出的解法是采用準確度和格式兩種互補的獎勵機制。

準確度獎勵用于評估回答的正確性。在數學題中,模型需要用特定格式給出答案以便驗證;在編程題中,則通過編譯器運行測試用例獲取反饋。

第二種是格式獎勵,模型需要將思考過程放在 '<think>' 和 '</think>' 這兩個特定的標簽之間,提升輸出的規范性。

該團隊沒有使用常用的神經網絡獎勵模型,是因為在大規模強化學習過程中,模型可能會出現「作弊」問題。同時也避免了重新訓練獎勵模型需要額外資源,簡化了訓練流程。

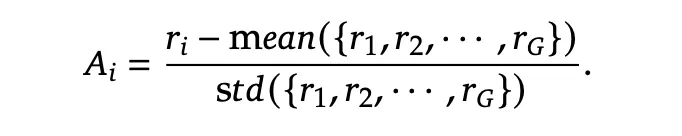

第三點是訓練模版,在 GRPO 和獎勵設計的基礎上,開發團隊設計了如表 1 所示的簡單模板來引導基礎模型。這個模板要求 DeepSeek-R1-Zero 先給出推理過程,再提供最終答案。這種設計僅規范了基本結構,不對內容施加任何限制或偏見,比如不強制要求使用反思性推理或特定解題方法。這種最小干預的設計能夠清晰地觀察模型在 RL 的進步過程。

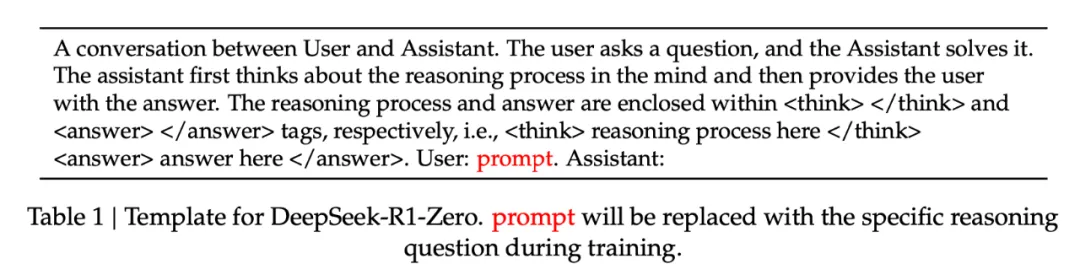

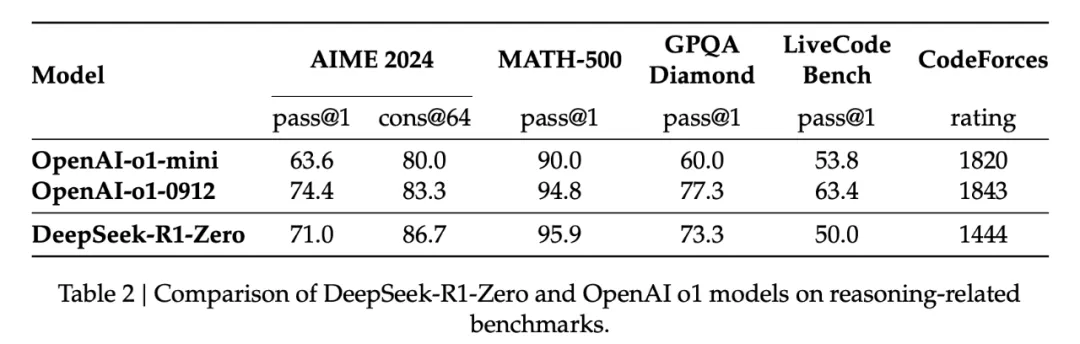

DeepSeek-R1-Zero 的提升也非常顯著。如圖 2 所示,做 2024 年的 AIME 數學奧賽試卷,DeepSeek-R1-Zero 的平均 pass@1 分數從最初的 15.6% 顯著提升到了 71.0%,達到了與 OpenAI-o1-0912 相當的水平。在多數投票機制中,DeepSeek-R1-Zero 在 AIME 中的成功率進一步提升到了 86.7%,甚至超過了 OpenAI-o1-0912 的表現。

DeepSeek-R1-Zero 與 OpenAI 的 o1-0912 在多個推理相關基準測試上的得分對比。

在訓練過程中,DeepSeek-R1-Zero 展現出了顯著的自我進化能力。它學會了生成數百到數千個推理 token,能夠更深入地探索和完善思維過程。

隨著訓練的深入,模型也發展出了一些高級行為,比如反思能力和探索不同解題方法的能力。這些都不是預先設定的,而是模型在強化學習環境中自然產生的。

特別值得一提的是,開發團隊觀察到了一個有趣的「Aha Moment」。在訓練的中期階段,DeepSeek-R1-Zero 學會了通過重新評估初始方法來更合理地分配思考時間。這可能就是強化學習的魅力:只要提供正確的獎勵機制,模型就能自主發展出高級的解題策略。

不過 DeepSeek-R1-Zero 仍然存在一些局限性,如回答的可讀性差、語言混雜等問題。

利用冷啟動進行強化學習

與 DeepSeek-R1-Zero 不同,為了防止基礎模型在 RL 訓練早期出現不穩定的冷啟動階段,開發團隊針對 R1 構建并收集了少量的長 CoT 數據,以作為初始 RL actor 對模型進行微調。為了收集此類數據,開發團隊探索了幾種方法:以長 CoT 的少樣本提示為例、直接提示模型通過反思和驗證生成詳細答案、以可讀格式收集 DeepSeek-R1-Zero 輸出、以及通過人工注釋者的后處理來細化結果。

DeepSeek 收集了數千個冷啟動數據,以微調 DeepSeek-V3-Base 作為 RL 的起點。與 DeepSeek-R1-Zero 相比,冷啟動數據的優勢包括:

- 可讀性:DeepSeek-R1-Zero 的一個主要限制是其內容通常不適合閱讀。響應可能混合多種語言或缺乏 markdown 格式來為用戶突出顯示答案。相比之下,在為 R1 創建冷啟動數據時,開發團隊設計了一個可讀模式,在每個響應末尾包含一個摘要,并過濾掉不友好的響應。

- 潛力:通過精心設計具有人類先驗知識的冷啟動數據模式,開發團隊觀察到相較于 DeepSeek-R1-Zero 更好的性能。開發團隊相信迭代訓練是推理模型的更好方法。

推理導向的強化學習

在利用冷啟動數據上對 DeepSeek-V3-Base 進行微調后,開發團隊采用與 DeepSeek-R1-Zero 相同的大規模強化學習訓練流程。此階段側重于增強模型的推理能力,特別是在編碼、數學、科學和邏輯推理等推理密集型任務中。

為了緩解語言混合的問題,開發團隊在 RL 訓練中引入了語言一致性獎勵,其計算方式為 CoT 中目標語言單詞的比例。雖然消融實驗表明這種對齊會導致模型性能略有下降,但這種獎勵符合人類偏好,更具可讀性。

最后,開發團隊將推理任務的準確率和語言一致性的獎勵直接相加,形成最終獎勵。然后對微調后的模型進行強化學習 (RL) 訓練,直到它在推理任務上實現收斂。

拒絕采樣和監督微調

當面向推理導向的強化學習收斂時,開發團隊利用生成的檢查點為后續輪次收集 SFT(監督微調)數據。此階段結合了來自其他領域的數據,以增強模型在寫作、角色扮演和其他通用任務中的能力。

開發團隊通過從上述強化學習訓練的檢查點執行拒絕采樣來整理推理提示并生成推理軌跡。此階段通過合并其他數據擴展數據集,其中一些數據使用生成獎勵模型,將基本事實和模型預測輸入 DeepSeek-V3 進行判斷。

此外,開發團隊過濾掉了混合語言、長段落和代碼塊的思路鏈。對于每個提示,他們會抽取多個答案,并僅保留正確的答案。最終,開發團隊收集了約 60 萬個推理相關的訓練樣本。

用于所有場景的強化學習

為了進一步使模型與人類偏好保持一致,這里還要實施第二階段強化學習,旨在提高模型的有用性和無害性,同時完善其推理能力。

具體來說,研究人員使用獎勵信號和各種提示分布的組合來訓練模型。對于推理數據,遵循 DeepSeek-R1-Zero 中概述的方法,該方法利用基于規則的獎勵來指導數學、代碼和邏輯推理領域的學習過程;對于一般數據,則采用獎勵模型來捕捉復雜而微妙的場景中的人類偏好。

最終,獎勵信號和多樣化數據分布的整合使我們能夠訓練出一個在推理方面表現出色的模型,同時優先考慮有用性和無害性。

蒸餾:讓小模型具備推理能力

為了使更高效的小模型具備 DeekSeek-R1 那樣的推理能力,開發團隊還直接使用 DeepSeek-R1 整理的 80 萬個樣本對 Qwen 和 Llama 等開源模型進行了微調。研究結果表明,這種簡單的蒸餾方法顯著增強了小模型的推理能力。

得益于以上多項技術的創新,開發團隊的大量基準測試表明,DeepSeek-R1 實現了比肩業內 SOTA 推理大模型的硬實力,具體可以參考以下結果:

更多技術細節請參閱原論文。