ICLR 2025 Spotlight |「免費」多模態信息助力3D小樣本分割

該文章的第一作者安照崇,目前在哥本哈根大學攻讀博士學位,導師為 Serge Belongie。他碩士畢業于蘇黎世聯邦理工學院(ETH Zurich),在碩士期間,他跟隨導師 Luc Van Gool 進行了多個研究項目。他的主要研究方向包括場景理解、小樣本學習以及多模態學習。

當人形機器人能夠辨識身邊的一切,VR/AR 設備呈現出定制化的虛擬世界,自動駕駛汽車實時捕捉路面狀況,這一切都依賴于對 3D 場景的精確理解。然而,這種精準的 3D 理解往往需要大量詳細標注的 3D 數據,極大推高了時間成本和資源消耗,而每當出現新場景或特定目標時,又不得不重復這一繁重過程。

Few-shot 學習是一種有效的解決思路——通過極少量標注樣本,讓模型迅速掌握新類別,從而大幅改善了這一局限性。但當前研究都局限于單模態點云數據,忽略了多模態信息的潛在價值。對此,University of Copenhagen、ETH Zurich 等團隊填補了這一空白,提出了一個全新的多模態 Few-shot 3D 分割設定和創新方法:在無需額外標注成本的前提下,融合了文本,2D,3D 信息,助力模型更好地適應到新類別。

這篇文章已被 ICLR 2025 接收為 Spotlight 論文,歡迎關注論文和代碼,了解更多細節!

- 論文:Multimodality Helps Few-shot 3D Point Cloud Semantic Segmentation

- 論文鏈接:https://arxiv.org/abs/2410.22489

- GitHub鏈接:https://github.com/ZhaochongAn/Multimodality-3D-Few-Shot

3D Few-shot 分割結果示例

引言

3D 場景理解在具身智能、VR/AR 等領域至關重要,幫助設備準確感知和解讀三維世界。然而,傳統全監督模型雖在特定類別上表現出色,但其能力局限于預定義類別。每當需要識別新類別時,必須重新收集并標注大量 3D 數據以及重新訓練模型,這一過程既耗時又昂貴,極大地制約了模型的應用廣度。

3D Few-shot 學習旨在利用極少量的示例樣本以適應模型來有效的識別任意的全新類別,大大降低了新類適應的開銷,使得傳統的 3D 場景理解模型不再局限于訓練集中有限的類別標簽,對廣泛的應用場景有重要的價值。

具體而言,對于 Few-shot 3D 點云語義分割(FS-PCS)任務,模型的輸入包括少量支持樣本(包含點云及對應新類標簽)和查詢點云。模型需要通過利用支持樣本獲得關于新類別的知識并應用于分割查詢點云,預測出查詢點云中關于新類別的標簽。在模型訓練和測試時使用的目標類別無重合,以保證測試時使用的類均為新類,未被模型在訓練時見過。

目前,該領域涌現出的工作 [1,2] 都只利用點云單模態的輸入,忽略了利用多模態信息的潛在的益處。對此,這篇文章提出一個全新的多模態 Few-shot 3D 分割設定,利用了文本和 2D 模態且沒有引入額外的標注開銷。在這一設定下,他們推出了創新模型——MultiModal Few-Shot SegNet (MM-FSS)。該模型通過充分整合多模態信息,有效提升小樣本上新類別的學習與泛化能力,證明了利用普遍被忽略的多模態信息對于實現更好的小樣本新類泛化的重要性,為未來研究開辟了全新方向。

Multimodal FS-PCS Setup

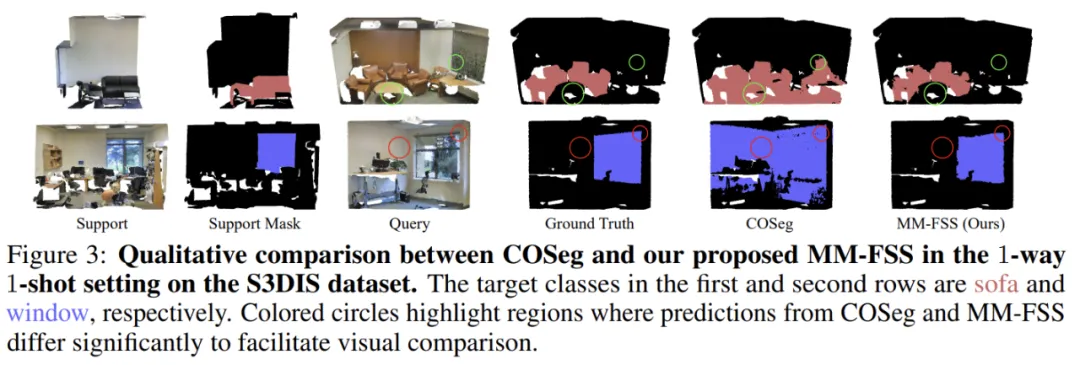

圖 1. 多模態 FS-PCS 設定

為便于討論,以下都將 Few-shot 3D 點云語義分割簡稱為 FS-PCS。

傳統的 FS-PCS 任務:模型的輸入包含少量的支持點云以及對應的新類別的標注(support point cloud & support mask)。此外,輸入還包括查詢點云(query point cloud)。模型需借助 support 樣本中關于新類別的知識,在 query 點云中完成新類別分割。

多模態 FS-PCS 任務:作者引入的多模態 FS-PCS 包括了除 3D 點云之外的兩個額外模態:文本和 2D。文本模態相應于支持樣本中的目標類別 / 新類的名稱。2D 模態相應于 2D 圖片,往往伴隨 3D 場景采集同步獲得。值得注意的是,2D 模態僅用于模型預訓練,不要求在 meta-learning 和測試時作為輸入,保證了其 Few-shot 輸入形式與傳統 FS-PCS 對齊,僅需要相同的數據且無需額外標注。

新的 Multimodal FS-PCS 模型 MM-FSS

模型概覽

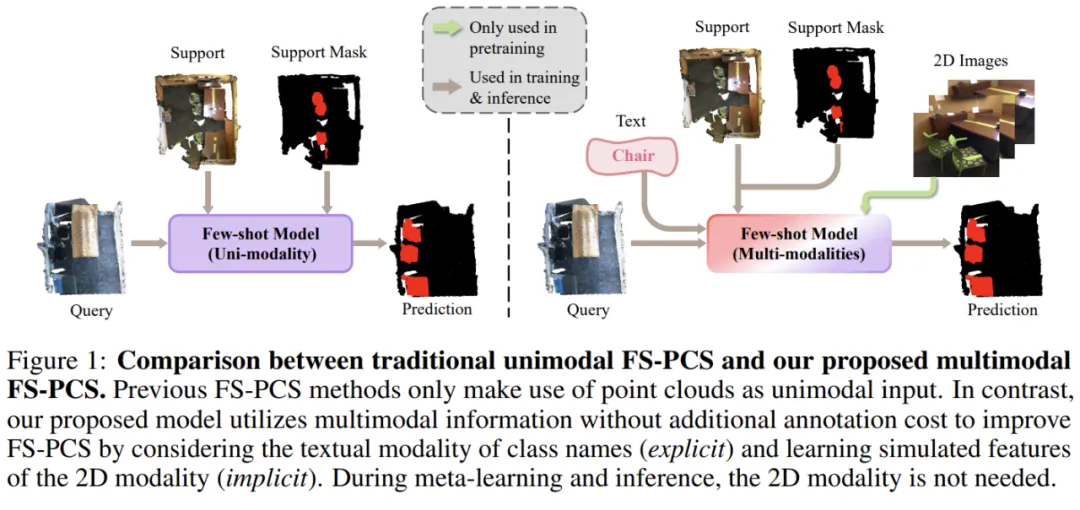

圖 2. MM-FSS 架構

關鍵模塊解析

MM-FSS 在 Backbone 后引入兩個特征提取分支:

- Intermodal Feature (IF) Head(跨模態特征頭):學習與 2D 視覺特征對齊的 3D 點云特征。

- Unimodal Feature (UF) Head(單模態特征頭):提取 3D 點云本身的特征。

① 預訓練階段

MM-FSS 先進行跨模態對齊預訓練,通過利用 3D 點云和 2D 圖片數據對,使用 2D 視覺 - 語言模型(VLM)輸出的 2D 特征監督 IF head 輸出的 3D 特征,使得 IF Head 學習到與 2D 視覺 - 語言模型對齊的 3D 特征。這一階段完成后:

- Backbone 和 IF Head 保持凍結,確保模型在 Few-shot 學習時能利用其預訓練學到的 Intermodal 特征。這樣,在 Few-shot 任務中無需額外的 2D 輸入,僅依賴 Intermodal 特征即可獲益于多模態信息。

- 此外,該特征也隱式對齊了 VLM 的文本特征,為后續階段利用重要的文本引導奠定基礎。

② Meta-learning 階段

在 Few-shot 訓練(稱為 meta-learning)時,給定輸入的 support 和 query 點云,MM-FSS 分別將 IF Head 和 UF Head 輸出的兩套特征計算出對應的兩套 correlations(correlations 表示每個 query 點和目標類別 prototypes 之間的特征相似度)。

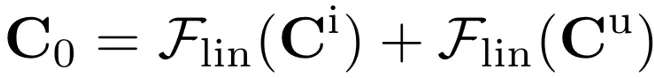

- 兩套 correlations 會通過 Multimodal Correlation Fusion (MCF) 進行融合,生成初始多模態 correlations,包含了 2D 和 3D 的視覺信息。這個過程可以表示為:

其中 和

和  分別表示用 IF Head 和 UF Head 特征算得的 correlations。

分別表示用 IF Head 和 UF Head 特征算得的 correlations。 為 MCF 輸出的初始多模態 correlations。

為 MCF 輸出的初始多模態 correlations。

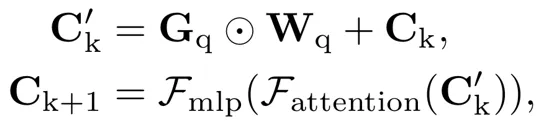

- 當前獲得的多模態 correlations 融合了不同的視覺信息源,但文本模態中的語義信息尚未被利用,因此設計了 Multimodal Semantic Fusion (MSF) 模塊,進一步利用文本模態特征作為語義引導,提升多模態 correlations:

其中  為文本模態的語義引導,

為文本模態的語義引導, 為文本和視覺模態間的權重(會動態變化以考慮不同模態間變化的相對重要性),

為文本和視覺模態間的權重(會動態變化以考慮不同模態間變化的相對重要性), 為多模態 correlations。

為多模態 correlations。

③ 測試階段

為緩解 Few-shot 模型對于訓練類別的 training bias(易被測試場景中存在的訓練類別干擾,影響新類分割),MM-FSS 在測試時引入 Test-time Adaptive Cross-modal Calibration (TACC) :利用跨模態的語義引導(由 IF Head 生成)適應性地修正預測結果,實現更好的泛化。

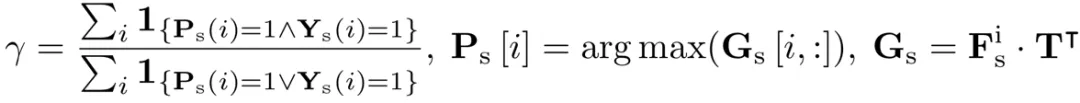

跨模態的語義引導未經 meta-learning 訓練,有更少的 training bias。為了有效的執行測試時修正,作者提出基于支持樣本及其標簽估算可靠性指標,用于自動調整修正程度(當該語義引導可靠性更高時,分配更大的修正權重,否則分配更小的權重):

為模型的預測,

為模型的預測, 為跨模態語義引導,γ 為適應性指標。通過借助 support point cloud 以及可用的 support mask 可以如下計算 γ 作為修正可靠程度的估計:

為跨模態語義引導,γ 為適應性指標。通過借助 support point cloud 以及可用的 support mask 可以如下計算 γ 作為修正可靠程度的估計:

實驗結果

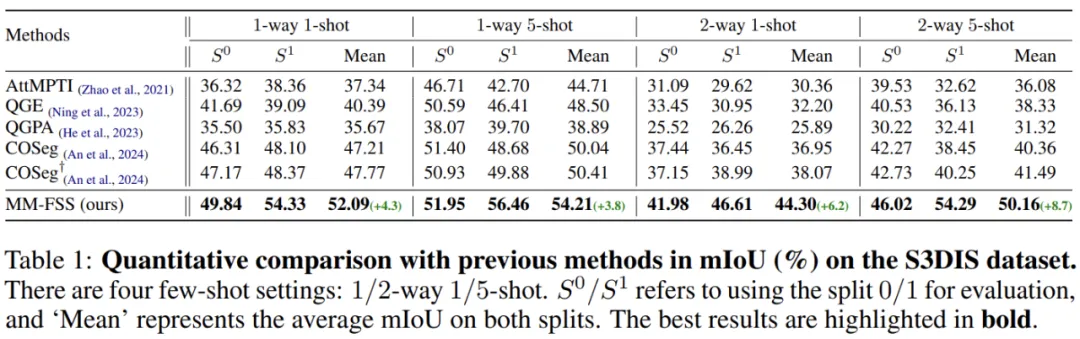

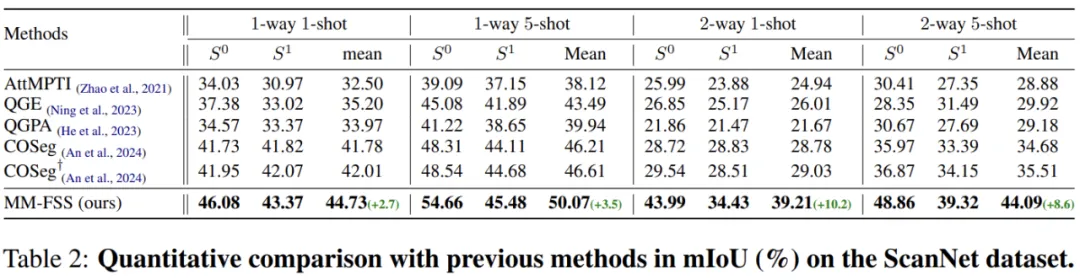

表 1. 實驗結果

表 2.實驗結果

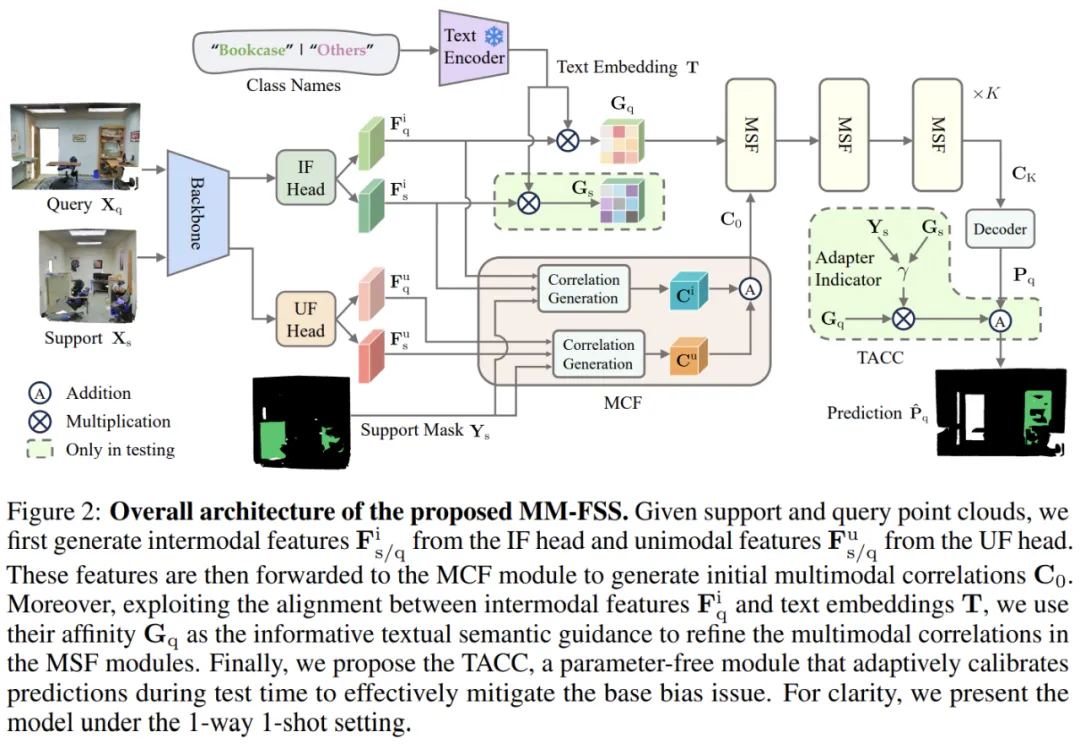

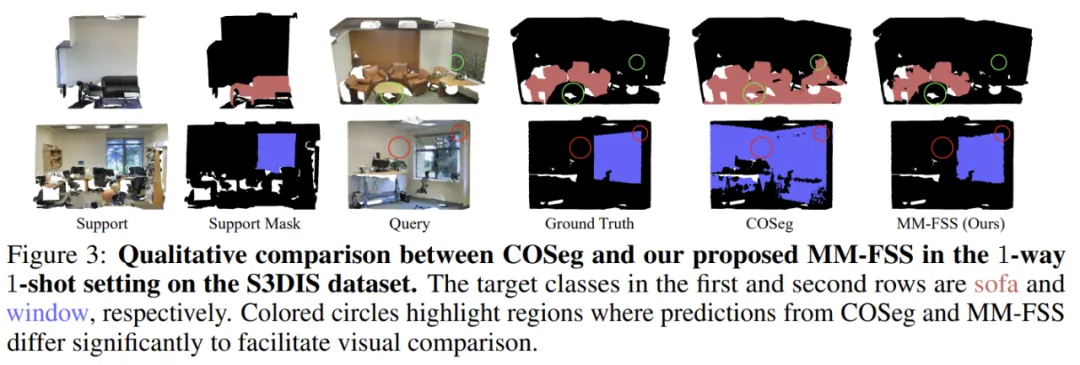

圖 3. MM-FSS 的可視化對比結果

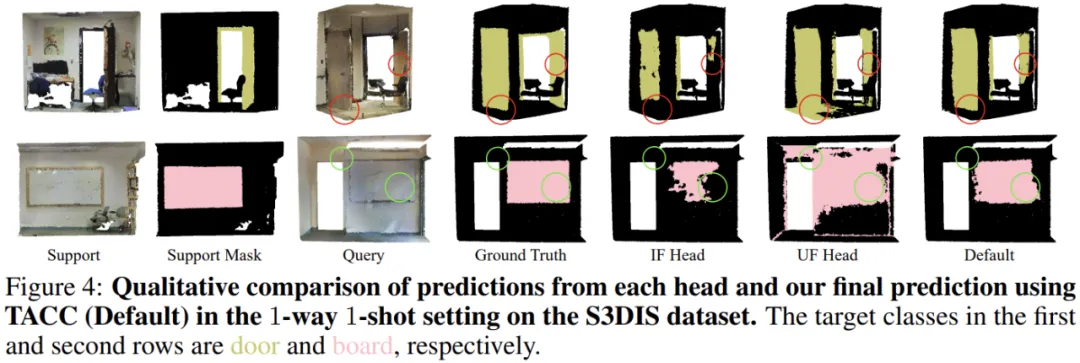

圖 4. MM-FSS 的可視化消融實驗結果

實驗在兩個標準的 FS-PCS 數據集上進行,證明了 MM-FSS 在各類 few-shot 任務中都實現了最佳性能。可視化也清楚表明了模型能夠實現更優的新類分割,展示了更強的新類泛化能力。更多詳細實驗和分析內容請參見論文。

總結

這項工作首次探索了融合多模態以提升 FS-PCS 任務的可能性。文中首先提出了全新的多模態 FS-PCS 設定,無額外開銷地融合文本和 2D 模態。在該設定下,作者提出首個多模態 FS-PCS 模型 MM-FSS,顯式的利用文本模態,隱式的利用 2D 模態,最大化其靈活性和各場景下的應用性。

MM-FSS 包含了 MCF 和 MSF 來有效的從視覺線索和語義信息雙重角度高效聚合多模態知識,增強對新類概念的全面理解。此外,為了協調 few-shot 模型的 training bias,作者設計了 TACC 技術,在測試時動態的修正預測。

綜合來看,該工作展示了過往被普遍忽略的「免費」多模態信息對于小樣本適應的重要性,為未來的研究提供了寶貴的新視野且開放了更多有趣的潛在方向。可參考的方向包括性能的提升 [2,3],訓練和推理效率的優化 [4],更深入的模態信息利用等。