出人意料!DeepSeek-R1用的GRPO其實(shí)沒必要?規(guī)模化強(qiáng)化學(xué)習(xí)訓(xùn)練用PPO就夠了

DeepSeek-R1 非常熱門,而在其公布的訓(xùn)練配方中,GRPO(Group Relative Policy Optimization)非常關(guān)鍵,是 DeepSeek-R1 核心的強(qiáng)化學(xué)習(xí)算法。

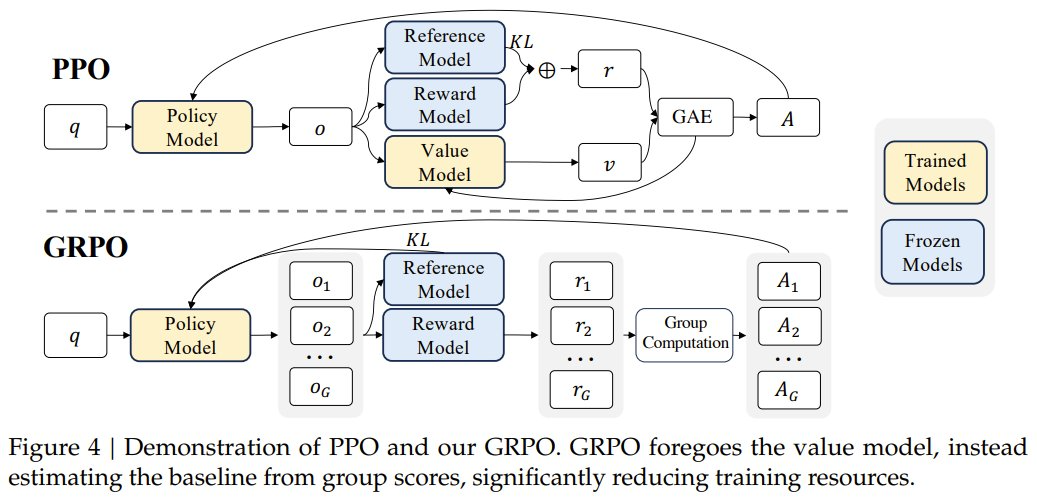

PPO 與 GRPO 的對比,來自論文《DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models》

相較于 PPO,GRPO 去掉了價值模型,而是通過分組分?jǐn)?shù)來估計基線,從而可極大減少訓(xùn)練資源。

DeepSeek-R1 技術(shù)報告中寫到:「具體來說,我們使用 DeepSeek-V3-Base 作為基礎(chǔ)模型,并采用 GRPO 作為強(qiáng)化學(xué)習(xí)框架來提高模型的推理性能。在訓(xùn)練過程中,DeepSeek-R1-Zero 自然地涌現(xiàn)出了許多強(qiáng)大而有趣的推理行為。經(jīng)過數(shù)千個強(qiáng)化學(xué)習(xí)步驟后,DeepSeek-R1-Zero 在推理基準(zhǔn)上表現(xiàn)出超強(qiáng)的性能。」

但現(xiàn)在,有一項研究卻證明 GRPO 對推理模型來說并不很重要。

階躍星辰與清華大學(xué)近期的一項研究發(fā)現(xiàn),只需使用帶 GAE (λ= 1,γ= 1)的普通 PPO 以及基于規(guī)則的簡單獎勵函數(shù),無需任何 KL 正則化,就足以擴(kuò)展在推理任務(wù)上的響應(yīng)長度和基準(zhǔn)性能,類似于在 DeepSeek-R1-Zero 上觀察到的現(xiàn)象。

使用這種極簡方法,他們打造了 Open-Reasoner-Zero,這是首個面向大規(guī)模推理的強(qiáng)化學(xué)習(xí)訓(xùn)練的開源實(shí)現(xiàn)。并且該實(shí)現(xiàn)在 GPQA Diamond 基準(zhǔn)上的表現(xiàn)優(yōu)于 DeepSeek-R1-Zero-Qwen-32B,同時僅需使用 1/30 的訓(xùn)練步數(shù)。需要強(qiáng)調(diào),該團(tuán)隊不僅開源了代碼,還發(fā)布了參數(shù)設(shè)置、訓(xùn)練數(shù)據(jù)和模型權(quán)重。

- 論文標(biāo)題:Open-Reasoner-Zero: An Open Source Approach to Scaling Up Reinforcement Learning on the Base Model

- 論文地址:https://github.com/Open-Reasoner-Zero/Open-Reasoner-Zero/blob/main/ORZ_paper.pdf

- 項目地址:https://github.com/Open-Reasoner-Zero/Open-Reasoner-Zero

- Hugging Face:https://huggingface.co/Open-Reasoner-Zero

從基礎(chǔ)模型開始擴(kuò)展強(qiáng)化學(xué)習(xí)

下面首先將介紹基礎(chǔ)又關(guān)鍵的設(shè)置,括數(shù)據(jù)整編、獎勵函數(shù)和近端策略優(yōu)化 (PPO) 算法的詳細(xì)設(shè)置。然后會討論從消融實(shí)驗中得出的關(guān)鍵見解,這些見解可以成功實(shí)現(xiàn)規(guī)模化強(qiáng)化學(xué)習(xí)訓(xùn)練。

基礎(chǔ)設(shè)置

實(shí)驗中,基礎(chǔ)模型使用的是 Qwen2.5-{7B, 32B},并且不經(jīng)過任何微調(diào)(如蒸餾或 SFT)即開始規(guī)模化強(qiáng)化學(xué)習(xí)訓(xùn)練。在 Qwen2.5-{7B, 32B} 基礎(chǔ)模型的基礎(chǔ)上,該團(tuán)隊擴(kuò)展了標(biāo)準(zhǔn) PPO 算法,以用于面向推理的強(qiáng)化學(xué)習(xí)訓(xùn)練,同時仔細(xì)考慮了可擴(kuò)展性和穩(wěn)健性。

數(shù)據(jù)集方面,該團(tuán)隊精心編排了涉及 STEM、數(shù)學(xué)和推理任務(wù)的數(shù)萬對問答數(shù)據(jù),目標(biāo)是增強(qiáng)模型在多樣化和復(fù)雜問題求解場景中的能力。

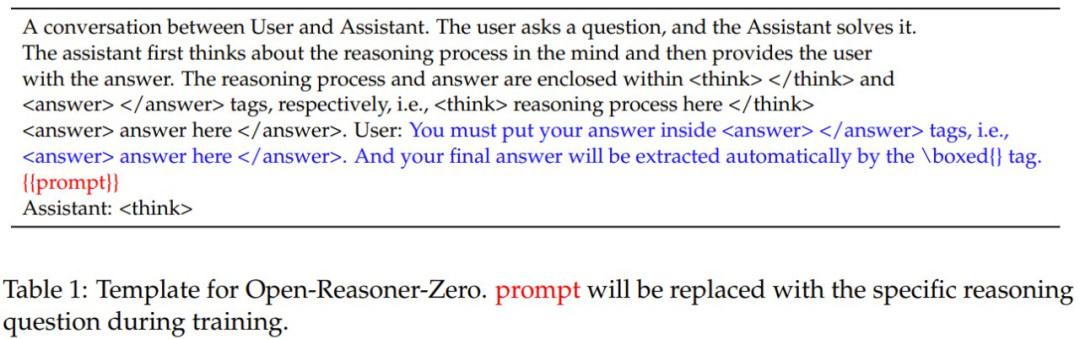

受 DeepSeek-R1 啟發(fā),他們設(shè)計的提示詞模板可以引導(dǎo)模型利用推理計算,逐步掌握針對復(fù)雜任務(wù)的推理能力,如表 1 所示。

此外,他們還基于 OpenRLHF 開發(fā)了一個高效的大規(guī)模強(qiáng)化學(xué)習(xí)訓(xùn)練框架,通過引入更靈活的訓(xùn)練器,實(shí)現(xiàn)了 GPU 共置生成(collocation generation)以及支持卸載和回載的訓(xùn)練。

數(shù)據(jù)集

高質(zhì)量訓(xùn)練數(shù)據(jù)對可擴(kuò)展 Reasoner-Zero 訓(xùn)練來說非常關(guān)鍵。這里作者關(guān)注了三個關(guān)鍵方面:數(shù)量、多樣性和質(zhì)量。

詳細(xì)的收集整理過程請閱讀原論文。最終,他們得到的數(shù)據(jù)集包含 57k 樣本,涵蓋 STEM、數(shù)學(xué)和推理領(lǐng)域。

獎勵函數(shù)

不同于 DeepSeek-R1-Zero,這里的規(guī)模化強(qiáng)化學(xué)習(xí)訓(xùn)練采用了簡單的規(guī)則式獎勵函數(shù) —— 該函數(shù)僅檢查答案的正確性,沒有任何額外的格式獎勵。

具體來說,這個獎勵函數(shù)會在訓(xùn)練時提取 <answer> 與 </answer> 標(biāo)簽之間的內(nèi)容,并將其與參考答案比較。

為了保證規(guī)模化強(qiáng)化學(xué)習(xí)清晰又簡單,他們實(shí)現(xiàn)了一種二元獎勵方案:如果與參考答案完全匹配,則獎勵為 1;所有其他情況的獎勵為 0。

為了確保評估嚴(yán)格且一致,他們采用了被廣泛使用的 Math-Verify 庫,圖 3 展示了其用法。

出人意料的是,該團(tuán)隊發(fā)現(xiàn),使用新設(shè)計的提示,即使是未對齊的基礎(chǔ)模型也能以很高的概率產(chǎn)生格式良好的響應(yīng)。在早期訓(xùn)練階段,基礎(chǔ)模型僅通過簡單的基于規(guī)則的獎勵函數(shù)就能快速學(xué)會和強(qiáng)化正確的推理和回答格式,如圖 4 所示。更重要的是,初步實(shí)驗表明,復(fù)雜的獎勵函數(shù)不僅是不必要的,而且可能為獎勵 hacking 留下潛在的空間。

強(qiáng)化學(xué)習(xí)算法

不同于 DeepSeek-R1-Zero 使用的 GRPO,該團(tuán)隊為規(guī)模化訓(xùn)練采用的強(qiáng)化學(xué)習(xí)算法是近端策略優(yōu)化(PPO)算法。

具體來說,對于每個問題 q(即提示詞),模型會根據(jù)基于規(guī)則的獎勵函數(shù)生成一組響應(yīng) {o_1, o_2, ..., o_n} 并接收相應(yīng)的獎勵 {r_1, r_2, ..., r_n},其中 n 表示采樣軌跡的數(shù)量(即每個提示詞的 rollout 大小)。

對于時間步驟 t (即 token t)處的每個響應(yīng) o_i ,令 s_t 表示時刻 t 的狀態(tài),包括問題和所有之前生成的 token,并令 a_t 表示在該步驟生成的 token。

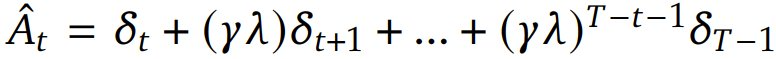

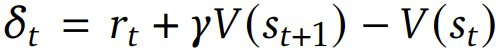

對于每個 token,使用 Generalized Advantage Estimation(GAE)計算其優(yōu)勢估計 。一般來說,GAE 能在優(yōu)勢估計中提供偏差與方差的權(quán)衡,做法是通過一個由參數(shù) λ 控制的指數(shù)加權(quán)平均值將 n 步優(yōu)勢估計組合起來。該優(yōu)勢估計的計算方式是:

。一般來說,GAE 能在優(yōu)勢估計中提供偏差與方差的權(quán)衡,做法是通過一個由參數(shù) λ 控制的指數(shù)加權(quán)平均值將 n 步優(yōu)勢估計組合起來。該優(yōu)勢估計的計算方式是: ,其中

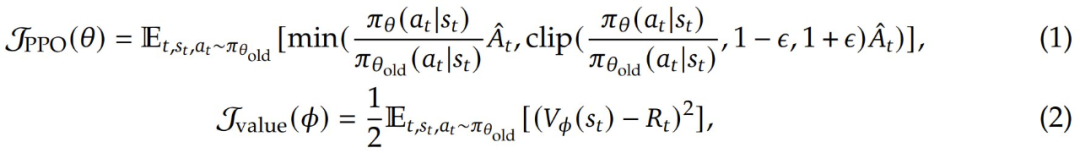

,其中 是 TD(temporal difference)殘差,γ 是折扣因子,它決定了未來獎勵相對于即時獎勵的價值。該 PPO 算法通過優(yōu)化以下目標(biāo)函數(shù)來更新策略模型參數(shù) θ 以最大化預(yù)期獎勵和價值模型參數(shù) Φ,從而最小化價值損失:

是 TD(temporal difference)殘差,γ 是折扣因子,它決定了未來獎勵相對于即時獎勵的價值。該 PPO 算法通過優(yōu)化以下目標(biāo)函數(shù)來更新策略模型參數(shù) θ 以最大化預(yù)期獎勵和價值模型參數(shù) Φ,從而最小化價值損失:

其中 ε 是 clipping 參數(shù),π_θ 是當(dāng)前策略,π_θ_old 是更新前的舊策略,V_Φ 是價值函數(shù), 是折扣回報。

是折扣回報。

具體到實(shí)例上,該團(tuán)隊為該 PPO 算法精心挑選了一些超參數(shù):GAE 參數(shù) λ = 1.0、折扣因子 γ = 1.0 和 clipping 參數(shù) ε = 0.2。

主要發(fā)現(xiàn)

該團(tuán)隊得到了以下主要發(fā)現(xiàn):

強(qiáng)化學(xué)習(xí)算法關(guān)鍵實(shí)現(xiàn):實(shí)證研究表明,原始的 PPO 在不同模型規(guī)模和訓(xùn)練持續(xù)時間內(nèi)能夠提供非常穩(wěn)定和強(qiáng)大的訓(xùn)練過程,而無需進(jìn)行額外的修改。通過廣泛的實(shí)驗,他們發(fā)現(xiàn) GAE 參數(shù)在 PPO 推理任務(wù)中起著關(guān)鍵作用。具體來說,設(shè)置 λ = 1.0 和 γ = 1.0。雖然這種設(shè)置在傳統(tǒng)強(qiáng)化學(xué)習(xí)場景中通常被認(rèn)為是次優(yōu)的,但它卻能實(shí)現(xiàn)規(guī)模化強(qiáng)化學(xué)習(xí)訓(xùn)練的理想平衡。

最小獎勵函數(shù)設(shè)計:該團(tuán)隊研究表明,簡單的基于規(guī)則的獎勵函數(shù)不僅足夠而且是最佳的,因為最小設(shè)計不會留下任何潛在的獎勵 hacking 空間。值得注意的是,即使是未對齊的基礎(chǔ)模型也能快速適應(yīng)所需的格式,這表明這是一項簡單的任務(wù),不需要復(fù)雜的獎勵工程設(shè)計。

損失函數(shù):該團(tuán)隊在不依賴任何基于 KL 的正則化技術(shù)(例如 KL 形狀的獎勵和損失)的情況下實(shí)現(xiàn)了穩(wěn)定的訓(xùn)練,這不同于 RLHF 社區(qū)和推理器模型普遍使用的方法。這也有很好的潛力實(shí)現(xiàn)進(jìn)一步大規(guī)模強(qiáng)化學(xué)習(xí)。

擴(kuò)大訓(xùn)練數(shù)據(jù)規(guī)模:該團(tuán)隊發(fā)現(xiàn)擴(kuò)大數(shù)據(jù)量和多樣性對于 Reasoner-Zero 訓(xùn)練至關(guān)重要。雖然在有限的學(xué)術(shù)數(shù)據(jù)集(如 MATH)上進(jìn)行訓(xùn)練會導(dǎo)致性能快速停滯,但該團(tuán)隊精細(xì)編排的大規(guī)模多樣化數(shù)據(jù)集能夠?qū)崿F(xiàn)持續(xù)擴(kuò)展,而不會在訓(xùn)練和測試集上出現(xiàn)飽和跡象。

實(shí)驗表現(xiàn)如何?

下面介紹 Open-Reasoner-Zero 模型的全面實(shí)驗結(jié)果和分析。其中包括兩個方面的初步實(shí)驗結(jié)果:利用訓(xùn)練得到的推理器進(jìn)行蒸餾,在蒸餾得到的模型上使用 Open-Reasoner-Zero 訓(xùn)練流程以進(jìn)一步增強(qiáng)其推理能力(類似 DeepSeek-R1 的方法)。訓(xùn)練的細(xì)節(jié)和超參數(shù)請參閱原論文,這里我們重點(diǎn)來看結(jié)果。

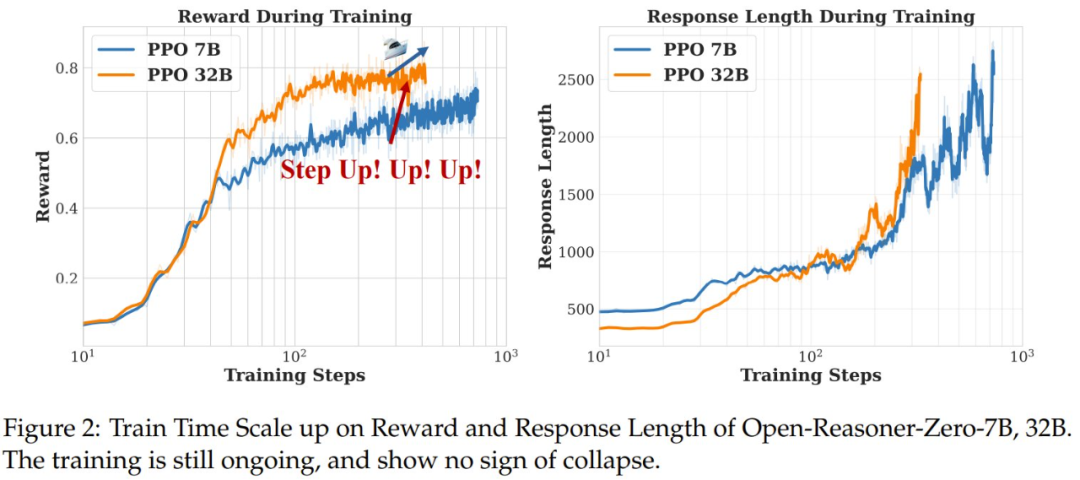

訓(xùn)練曲線

圖 2 顯示了在 Open-Reasoner-Zero 7B 和 32B 上的實(shí)驗的訓(xùn)練獎勵和平均響應(yīng)長度曲線,而圖 5 展示了在訓(xùn)練和評估集上對 Open-Reasoner-Zero 7B 的實(shí)驗的獎勵 / 準(zhǔn)確度和平均響應(yīng)長度曲線。訓(xùn)練獎勵曲線和響應(yīng)長度曲線分別表示生成的響應(yīng)的平均獎勵和每個生成步驟中生成的響應(yīng)的平均長度。

可以看到,這些指標(biāo)在整個訓(xùn)練過程中在兩個模型和所有基準(zhǔn)上都得到了持續(xù)的改進(jìn),并有值得注意的觀察結(jié)果:OpenReasoner-Zero 表現(xiàn)出一種有趣的「階躍時刻」現(xiàn)象,其中響應(yīng)指標(biāo)在訓(xùn)練過程中突然增加,這表明其涌現(xiàn)出了推理能力。

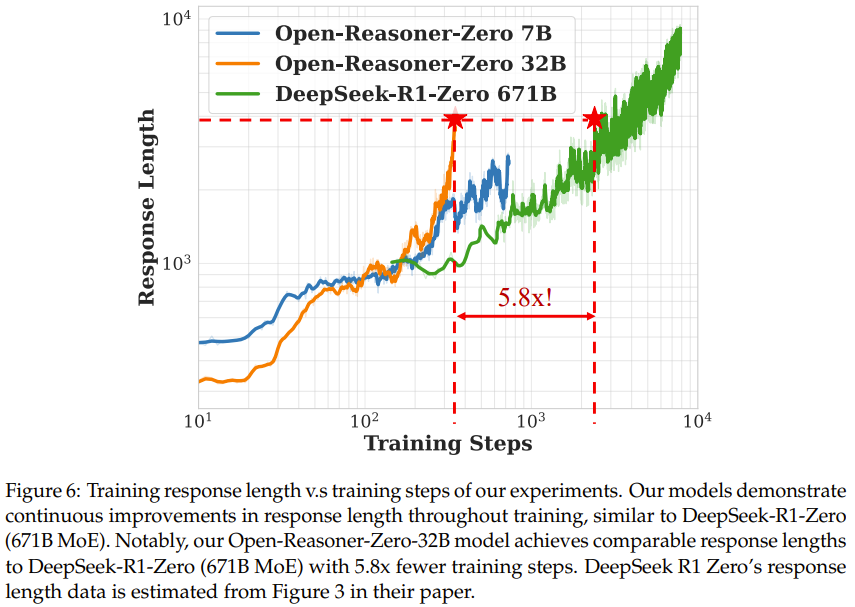

響應(yīng)長度擴(kuò)展與 DeepSeek-R1-Zero

如圖 6 所示,可以看到整個訓(xùn)練過程中響應(yīng)長度持續(xù)增加,沒有飽和跡象,類似于 DeepSeek-R1-Zero 中看到的行為。

值得注意的是,雖然模型大小和訓(xùn)練步驟都有助于改善響應(yīng)長度,但 Open-Reasoner-Zero-32B 模型僅用 1/5.8 的訓(xùn)練步數(shù)就實(shí)現(xiàn)了與 DeepSeek-R1-Zero (671B MoE) 相當(dāng)?shù)捻憫?yīng)長度。這種卓越的訓(xùn)練效率證明了新的極簡主義方法對大規(guī)模強(qiáng)化學(xué)習(xí)訓(xùn)練的有效性。

質(zhì)量分析

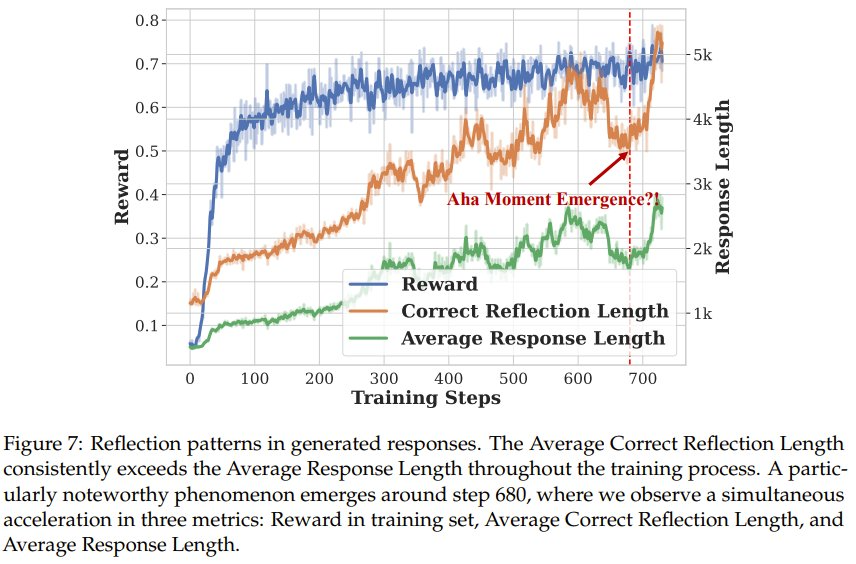

該團(tuán)隊也對 Open-Reasoner-Zero 模型生成的響應(yīng)進(jìn)行了一些定性分析。為了分析模型的反思能力并觀察像 DeepSeek-R1-Zero 這樣的頓悟時刻,他們遵從之前的方法確定了五種代表性的反思模式(wait、recheck、retry、alternatively、however)。他們將包含任何這些模式的響應(yīng)數(shù)量計為「反思響應(yīng)」,并確定平均正確反思長度(包含獲得正確答案的反思模式的響應(yīng)的長度)。

如圖 7 所示,在整個訓(xùn)練過程中,平均正確反思長度始終超過平均響應(yīng)長度,這表明包含反思模式的響應(yīng)利用了更多的「思考時間」來獲得正確答案,類似于 OpenAI o1 中描述的測試時間擴(kuò)展。

一個特別值得注意的現(xiàn)象出現(xiàn)在步驟 680 左右,該團(tuán)隊觀察到三個指標(biāo)同時加速:獎勵、平均正確反思長度和平均響應(yīng)長度。通過手動檢查步驟 680 之前和之后的模型輸出,該團(tuán)隊發(fā)現(xiàn)之后的響應(yīng)中有更明顯的反思模式。這種涌現(xiàn)行為值得進(jìn)一步研究,該團(tuán)隊表示目前正在進(jìn)行詳細(xì)分析,以了解這種現(xiàn)象的潛在機(jī)制。

該團(tuán)隊也研究了新模型在知識和指令遵從基準(zhǔn) MMLU_PRO 和 IFEval 上的泛化能力,結(jié)果見表 2。

可以看到,Open-Reasoner-Zero 32B 模型表現(xiàn)出了強(qiáng)大的泛化能力:無需任何額外的指令微調(diào),在 MMLU、MMLU_PRO 基準(zhǔn)上,通過純規(guī)模化強(qiáng)化學(xué)習(xí)訓(xùn)練在面向推理的任務(wù)上顯著優(yōu)于 Qwen2.5 Instruct 32B。

該團(tuán)隊也進(jìn)行了詳細(xì)的消融實(shí)驗,詳見原論文。