深度學習的平衡之道:港科大、港城大等團隊聯合發布多目標優化最新綜述

本文作者來自香港科技大學、香港科技大學(廣州)、香港城市大學以及UIUC等機構。其中,港科大在讀博士生陳巍昱、港城大在讀博士生張霄遠和港科廣在讀博士生林百炅為共同第一作者;林熙博士目前擔任港城大博士后研究員;UIUC趙晗助理教授、港城大張青富教授以及港科大郭天佑教授為共同通訊作者。趙晗博士的研究方向主要集中在機器學習理論和可信機器學習領域,涵蓋算法公平,可解釋性和多任務優化等多個方向,其研究成果曾獲Google Research Award。張青富教授 (IEEE Fellow) 長期致力于多目標優化的研究,所提出MOEA/D方法至今已被引用近萬次,成為多目標優化經典范式之一。郭天佑教授 (IEEE Fellow) 專注于機器學習中的優化問題研究,曾獲AI 2000最具影響力學者榮譽提名,并擔任IJCAI-2025程序主席。

近年來,深度學習技術在自動駕駛、計算機視覺、自然語言處理和強化學習等領域取得了突破性進展。然而,在現實場景中,傳統單目標優化范式在應對多任務協同優化、資源約束以及安全性 - 公平性權衡等復雜需求時,逐漸暴露出其方法論的局限性。值得注意的是,在大語言模型(LLM)與生成式 AI 系統的多維度價值對齊(Multi-Dimensional Alignment)領域,如何協調模型性能、安全倫理邊界、文化適應性及能耗效率等多元目標,已成為制約人工智能系統社會應用的關鍵挑戰。多目標優化(Multi-Objective Optimization, MOO)作為一種協調多個潛在沖突目標的核心技術框架,正在成為破解復雜系統多重約束難題的關鍵方法。

近日,由香港科技大學、香港科技大學(廣州)、香港城市大學以及 UIUC 等團隊聯合發布的基于梯度的多目標深度學習綜述論文《Gradient-Based Multi-Objective Deep Learning: Algorithms, Theories, Applications, and Beyond》正式上線。這篇綜述從多目標算法設計、理論分析到實際應用與未來展望,全方位解析了如何在多任務場景下高效平衡各目標任務,呈現了這一領域的全景。

- 論文題目:Gradient-Based Multi-Objective Deep Learning: Algorithms, Theories, Applications, and Beyond

- 論文鏈接:https://arxiv.org/pdf/2501.10945v2

- 倉庫鏈接:https://github.com/Baijiong-Lin/Awesome-Multi-Objective-Deep-Learning

背景

在深度學習中,我們常常需要同時優化多個目標:

- 多任務學習:在許多實際問題中,我們常常需要同時優化多個任務,并在不同任務之間尋求平衡,以解決它們之間的潛在沖突(例如,在分子性質預測領域,我們通常需要對一個分子預測多種性質);

- 大語言模型的多維度價值對齊:在大語言模型的訓練過程中,我們期望其生成的回復能夠與人類多維度的價值偏好相匹配,涵蓋有用性、安全性、幽默度等多個方面;

- 資源約束、安全性、公平性等因素的權衡:在許多工業場景中,除了性能指標外,安全、能耗、延遲等實際工程指標也是需要兼顧的重要目標。

多目標優化算法旨在尋找一系列 「折中解」(也稱為 Pareto 最優解),在不同目標間達到平衡,從而滿足應用場景中對協同優化的要求。

算法設計

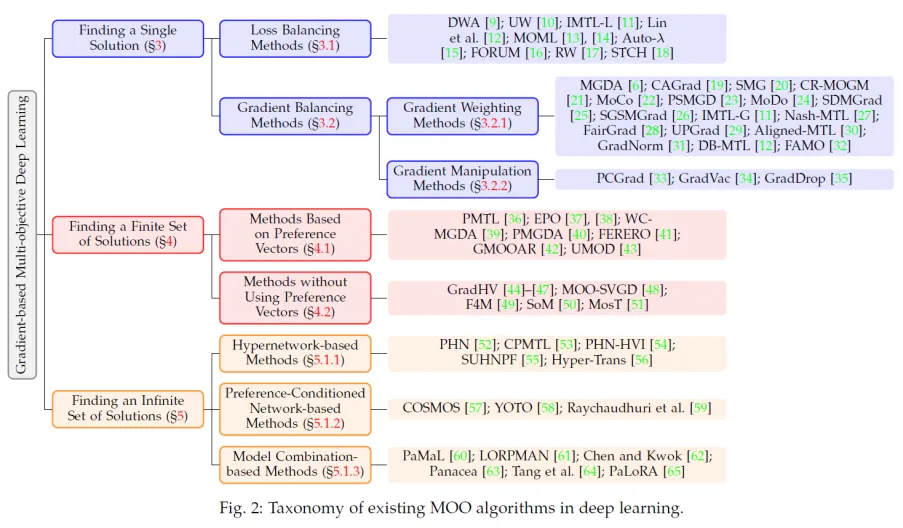

基于梯度的多目標優化方法主要分為三類:尋找單個 Pareto 最優解的算法,尋找有限個 Pareto 最優解的算法以及尋找無限個 Pareto 最優解的算法。

尋找單個 Pareto 最優解

在多任務學習等場景中,通常只需找到一個平衡的解,以解決任務之間的沖突,使每個任務的性能都盡可能達到最優。為此,研究者們提出了多種方法,這些方法可進一步分為損失平衡方法和梯度平衡方法。

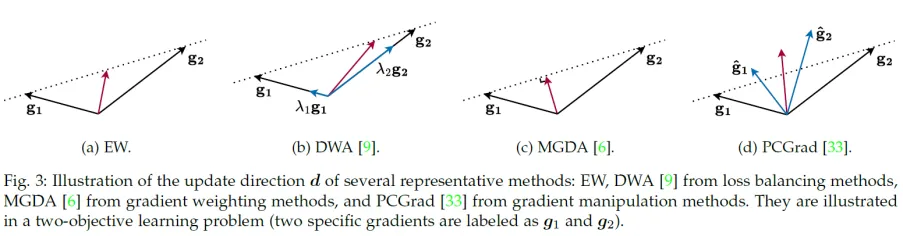

- 損失平衡方法:通過動態計算或學習目標權重,平衡不同任務的損失。例如,動態權重平均(DWA)通過每個目標的訓練損失的下降速度更新權重;不確定性加權(UW)基于每個目標的不確定性動態優化目標權重;多目標元學習(MOML)通過驗證集性能自適應調整目標權重。

- 梯度平衡方法:通過計算多個任務梯度的 「最優平衡方向」,使模型在更新參數時能夠兼顧所有任務的優化需求。這類方法又可以細分為梯度加權方法和梯度操縱方法。例如,多梯度下降算法(MGDA)通過求解優化問題找到更新方向,使該方向上的梯度更新能夠最大化地減少所有任務的損失函數;PCGrad 方法將每個任務的梯度投影到與其他任務梯度沖突最小化的方向上,從而有效解決任務間的梯度沖突。

一些有代表性的方法如下圖所示:

尋找有限個 Pareto 最優解

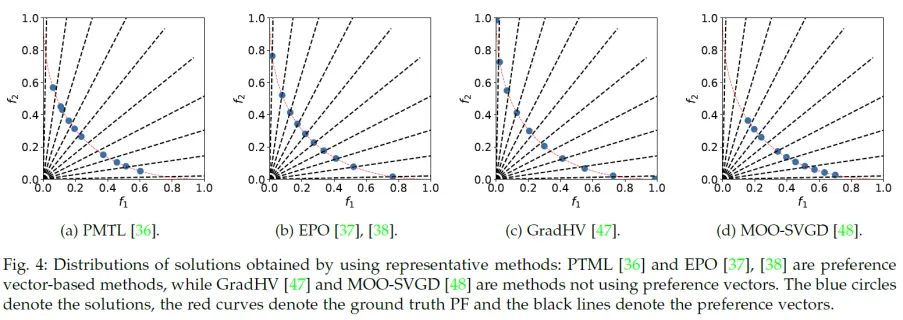

在尋找有限個 Pareto 解集時,需要同時考慮兩個關鍵因素:解的快速收斂性(確保解迅速逼近 Pareto 最優前沿)和解集的多樣性(保證解在 Pareto 前沿上的均勻分布)。目前主要有兩類方法:

- 基于偏好向量的方法:利用偏好向量來指定特定的 Pareto 解。通過均勻分布的偏好向量,可以生成具有多樣性的 Pareto 解集,覆蓋 Pareto 前沿的不同區域。

- 無需偏好向量的方法:通過優化 Pareto 解集的某個指標來提高解的多樣性。例如,最大化超體積(Hypervolume),使解集在目標空間中覆蓋更大的區域;或者最大化最小距離,確保解集中的解彼此遠離,從而提升分布均勻性。由于該類方法無需指定偏好向量,因此具有更高的適應性和靈活性。

一些有代表性的方法如下圖所示:

尋找無限個 Pareto 最優解

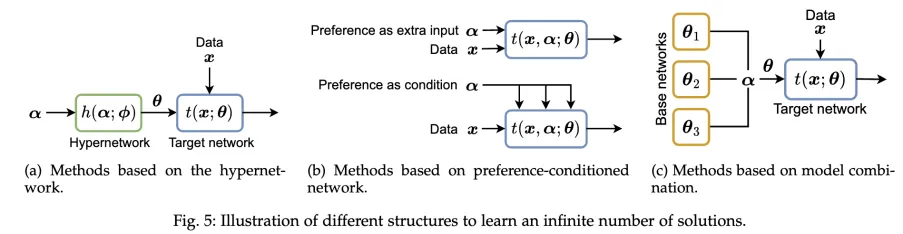

為滿足用戶在任一偏好下都能獲得合適解的需求,研究者設計了直接學習整個 Pareto 集的方法,主要包括:

- 超網絡:利用專門的網絡根據用戶偏好生成目標網絡的參數;

- 偏好條件網絡:在原模型中增加偏好信息作為額外條件;

- 模型組合:通過組合多個基模型的參數(如 PaMaL、LORPMAN 等方法)實現對所有 Pareto 解的緊湊表達。

在訓練過程中,這些方法通常采用隨機采樣用戶偏好,利用端到端的梯度下降優化映射網絡參數,同時結合標量化目標或超體積最大化等策略,確保映射網絡能夠覆蓋整個解集并實現穩定收斂。

理論分析

我們從收斂性和泛化性兩個角度總結了現有的 MOO 的理論分析:

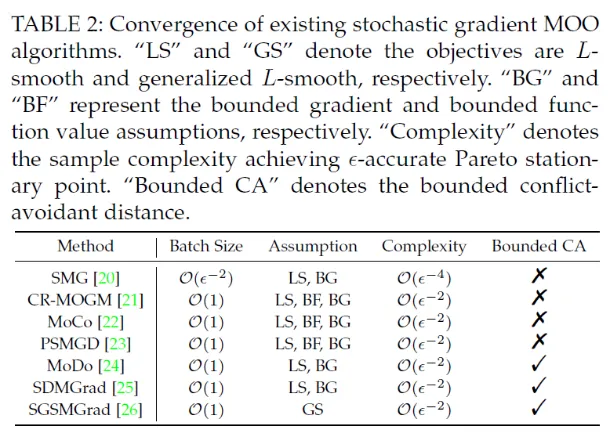

- 收斂性:針對確定性(全梯度)和隨機梯度的情況,許多工作從 Pareto Stationary 角度出發,提供了收斂性證明。通過雙采樣、平滑移動平均以及近似求解子問題等策略,有效降低了隨機梯度帶來的偏差,加快了整體收斂速度,理論上可以達到單目標優化相近的收斂速率。

- 泛化性:許多工作探討了多目標深度學習模型的泛化能力,利用 Rademacher 復雜度等工具分析了標量化方法與梯度平衡方法在未見數據上的表現。

應用與挑戰

基于梯度的多目標優化方法已在多個前沿應用中展現出巨大潛力,主要包括:

- 計算機視覺(CV):應用于多任務密集預測(如語義分割、深度估計、表面法向預測),實現任務間的協同提升。

- 強化學習(RL):在多目標強化學習中,同時優化獎勵、多樣性和安全性指標,使智能體在復雜環境下表現更均衡。

- 神經架構搜索(NAS):兼顧模型準確性與資源消耗(如 FLOPs、參數量、延遲),尋找適合嵌入式設備的高效架構。

- 推薦系統:除準確度外,整合新穎性、多樣性、用戶公平等指標,為個性化推薦提供優化支撐。

- 大語言模型(LLM):(1)多任務微調:在預訓練語言模型的基礎上,針對多個下游任務同時微調,可以提高模型的效率和泛化能力;(2)多目標對齊:在訓練階段,通過多目標算法同時優化多個目標(如安全性、有用性、幽默性等),以使模型的輸出更好地滿足用戶在不同方面的偏好。

盡管多目標優化方法已取得諸多進展,但仍面臨一些亟待解決的問題:比如:理論泛化分析不足, 計算開銷與高效性問題, 高維目標與偏好采樣挑戰, 分布式訓練與協同優化以及大語言模型的多目標優化。

多目標算法庫

我們開源了多目標深度學習領域的兩大的算法庫:LibMTL 和 LibMOON。

- LibMTL 是一個專為多任務學習設計的開源庫,支持超過 20 種多任務算法。它在 GitHub 上已收獲超過 2200 個 Star,并被機器學習頂刊《Journal of Machine Learning Research》(JMLR)接收。

項目地址:https://github.com/median-research-group/LibMTL - LibMOON 是一個專注于多目標優化的開源框架,支持超過 20 種多目標算法,能夠高效尋找多個 Pareto 最優解。其相關工作已被人工智能頂會 NeurIPS 2024 接收。

項目地址:https://github.com/xzhang2523/libmoon

結語

本綜述旨在為多目標深度學習領域提供一份全面的資源整合。我們系統地梳理了從算法設計、理論分析到實際應用的各個方面,并深入探討了未來發展面臨的挑戰。無論您的研究重點是多任務學習、強化學習,還是大語言模型的訓練與對齊,相信都能在本文中找到有價值的見解與啟發。我們也認識到,當前的工作可能未能完整涵蓋該領域的所有研究成果,如果你有任何建議或補充,歡迎訪問我們的 GitHub 倉庫,并提交 Issue 或 Pull Request,讓我們攜手推動這一領域的發展,共同進步!