首個多模態連續學習綜述,港中文、清華、UIC聯合發布

本文作者來自于港中文、清華和UIC。主要作者包括:余甸之,港中文博士生;張欣妮,港中文博士生;陳焱凱,港中文博士;劉璦瑋,清華大學博士生;張逸飛,港中文博士;Philip S. Yu,UIC教授;Irwin King,港中文教授。

- 論文標題:Recent Advances of Multimodal Continual Learning: A Comprehensive Survey

- 論文鏈接:https://arxiv.org/abs/2410.05352

- GitHub地址:https://github.com/LucyDYu/Awesome-Multimodal-Continual-Learning

多模態連續學習的最新進展

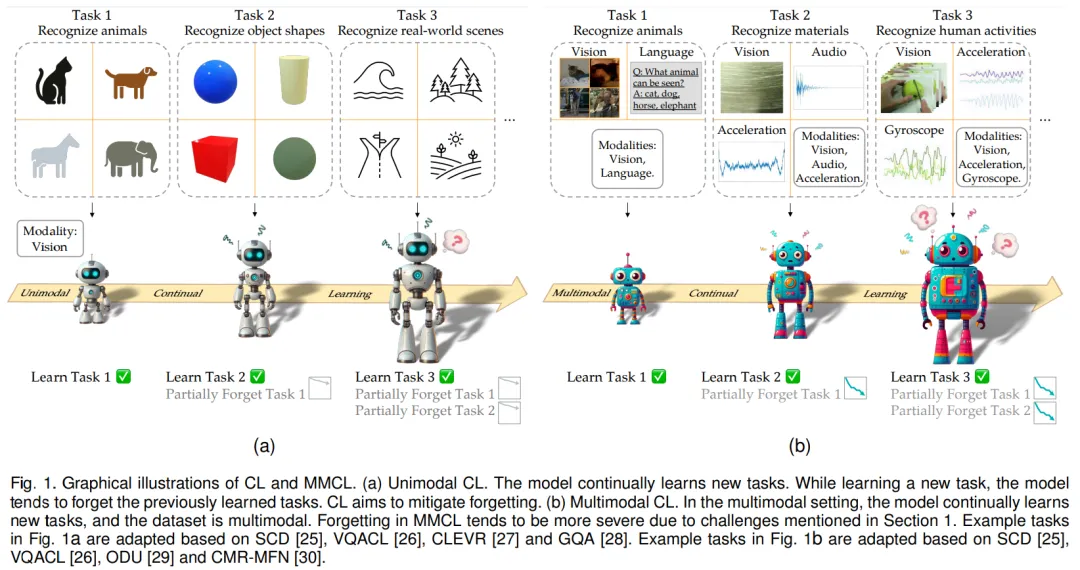

連續學習(CL)旨在增強機器學習模型的能力,使其能夠不斷從新數據中學習,而無需進行所有舊數據的重新訓練。連續學習的主要挑戰是災難性遺忘:當任務按順序訓練時,新的任務訓練會嚴重干擾之前學習的任務的性能,因為不受約束的微調會使參數遠離舊任務的最優狀態。盡管連續學習取得了重大進展,但大多數工作都集中在單一數據模態上,如視覺,語言,圖,或音頻等。這種單模態的關注忽略了現實世界環境的多模態本質,因為現實世界環境本身就很復雜,由不同的數據模態而不是單一模態組成。

隨著多模態數據的快速增長,發展能夠從多模態來源中連續學習的 AI 系統勢在必行,因此出現了多模態連續學習(MMCL)。這些 MMCL 系統需要有效地集成和處理各種多模態數據流,同時還要在連續學習中設法保留以前獲得的知識。

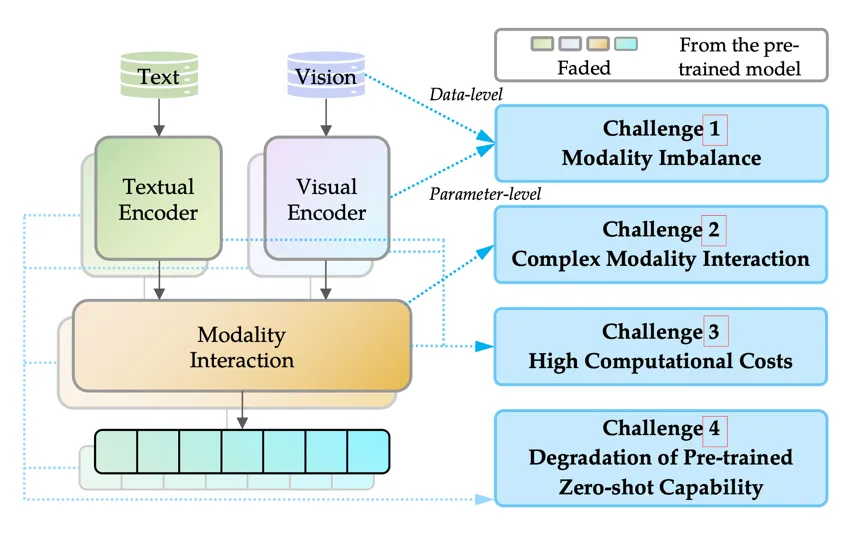

盡管傳統的單模態 CL 與多模態 CL 之間存在聯系,但多模態 CL 所面臨的挑戰并不僅僅是簡單地將 CL 方法用于多模態數據。這種直接的嘗試已被證明會產生次優性能。具體而言,如圖所示,除了現有的 CL 災難性遺忘這一挑戰外,MMCL 的多模態性質還帶來了以下四個挑戰。

- 挑戰 1 模態失衡:模態失衡是指多模態系統中不同模態的處理或表示不均衡,表現在數據和參數兩個層面。在數據層面,不同模態的數據可用性可能會在 CL 過程中發生顯著變化,出現極度不平衡的情況,如缺乏某些模態。在參數層面,不同模態組件的學習可能會以不同的速度收斂,從而導致所有模態的學習過程整體失衡。

- 挑戰 2 復雜模態交互:模態交互發生在模型組件中,在這些組件中,多模態輸入信息的表征明確地相互作用。這種交互給 MMCL 帶來了獨特的挑戰,主要體現在兩個交互過程中:模態對齊和模態融合。在模態對齊過程中,單個數據樣本的不同模態特征往往會在連續學習過程中出現分散,這種現象被稱為 MMCL 中的空間紊亂。這種發散可能會導致更嚴重的性能下降。在模態融合方面,在非 CL 環境中使用的經典多模態融合方法在 MMCL 環境中可能會表現較差,因為不同的融合技術對解決遺忘問題有不同的效果。

- 挑戰 3 高計算成本:在 MMCL 中加入多種模態會大大增加計算成本,無論是在模型層面還是在任務層面都是如此。在模型層面,增加模態不可避免地會增加可訓練參數的數量。許多 MMCL 方法利用預訓練的多模態模型作為基礎。然而,不斷對這些大規模模型進行整體微調會帶來沉重的計算開銷。同樣,在特定任務層面,MMCL 方法可能會導致特定任務可訓練參數的持續積累,這些參數可能會超過預訓練模型中的參數數量,從而抵消了采用連續學習訓練模式的效率優勢。

- 挑戰 4 預訓練零樣本能力的退化:隨著預訓練模型的進步,MMCL 方法可以用這些強大的模型。這些預先訓練好的多模態模型經常會表現出零樣本能力。然而,在訓練過程中,該能力可能會減弱。這種退化風險可能導致未來任務上的嚴重性能下降,這被稱為 MMCL 中的負前向知識轉移。

MMCL 算法匯總

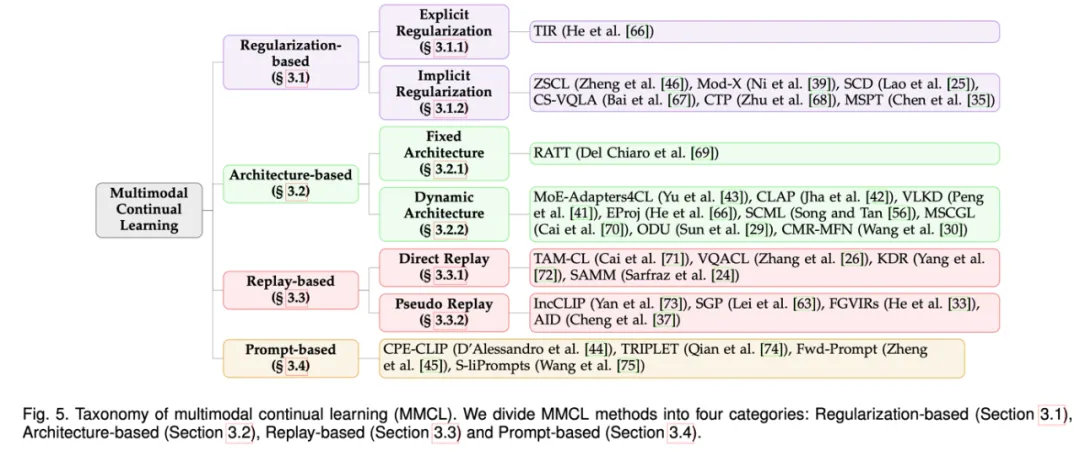

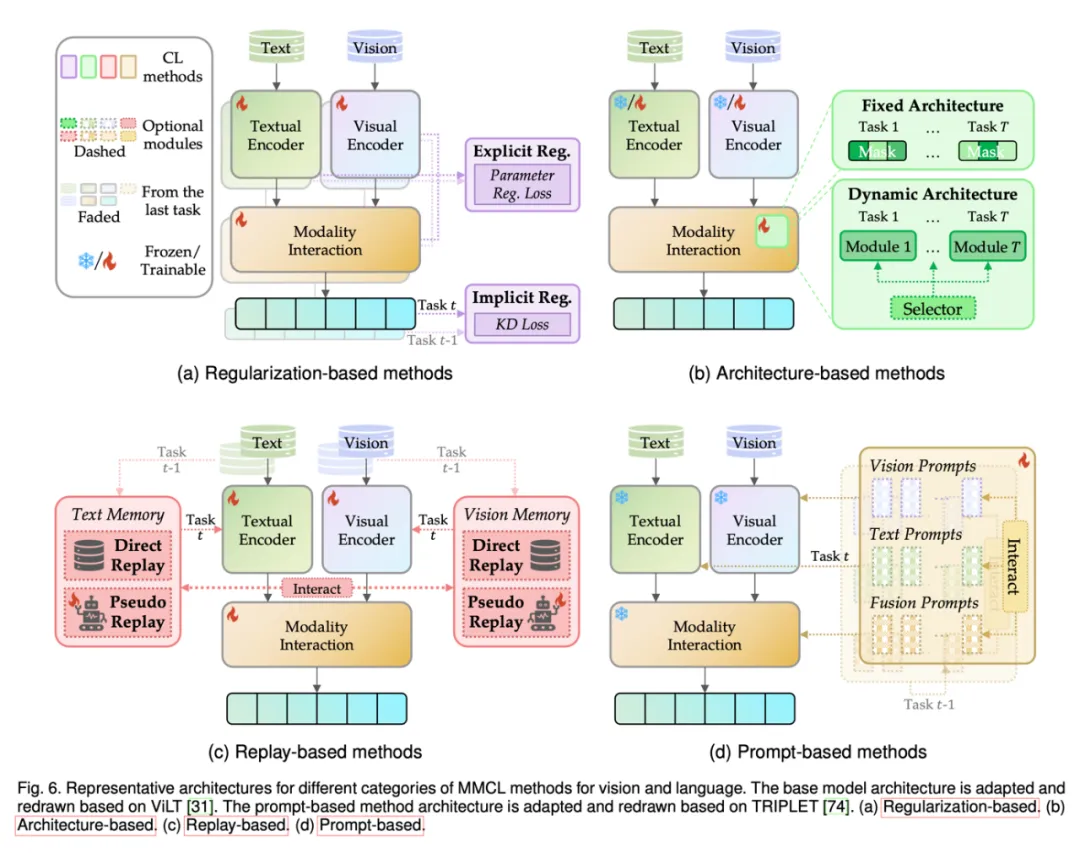

為了應對上述挑戰,研究人員越來越關注 MMCL 方法。作者將 MMCL 方法分為四類主要方法,即基于正則化、基于架構、基于重放和基于提示的方法。

- 基于正則化的方法:由于訓練中參數的自由移動導致災難性遺忘,基于正則化的方法旨在對參數施加約束來減少遺忘。

- 基于架構的方法:該類方法使用不同的模型參數處理不同的任務。基于正則化的方法共享所有參數來學習任務,這使得它們容易受到任務間干擾:即記住舊任務會嚴重干擾新任務的學習,導致性能下降,尤其是在前向知識轉移為負時。相比之下,基于架構的方法通過引入特定于任務的組件來減少任務間干擾。

- 基于重放的方法:該類方法利用一個情節記憶緩沖區來重放來自先前任務的歷史實例,例如數據樣本,從而幫助在學習新任務時保持早期知識。這種重放實例的方法避免了基于正則化的方法的嚴格約束,并規避了在架構基于的方法中動態修改網絡架構的復雜性。

- 基于提示的方法:隨著大型模型的快速發展及其在連續學習環境中的應用,基于提示的方法最近應運而生,以更好地利用預訓練過程中獲得的豐富知識。這些方法的優勢在于只需最小的模型調整,減少了廣泛微調的需求,而與之前通常需要顯著微調或架構修改的方法不同。基于提示的方法的范式通過在連續空間中應用少量提示參數來修改輸入,使得模型在學習額外的特定任務信息時能夠保留其原有知識。

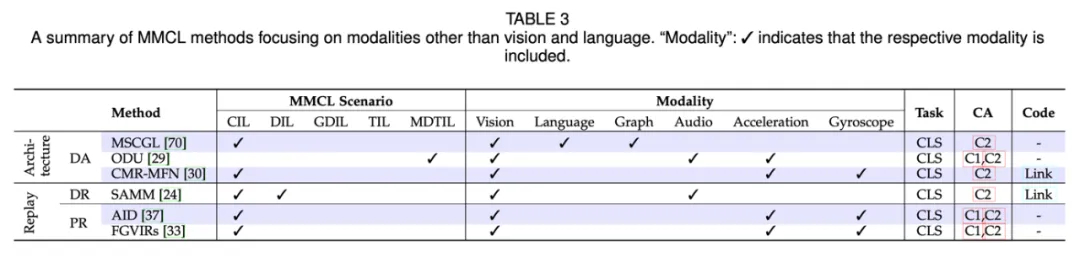

這些方法主要集中用于視覺和語言模態,同時也有其他方法關注圖、音頻等其他模態。下圖中展示了 MMCL 方法的代表性架構。

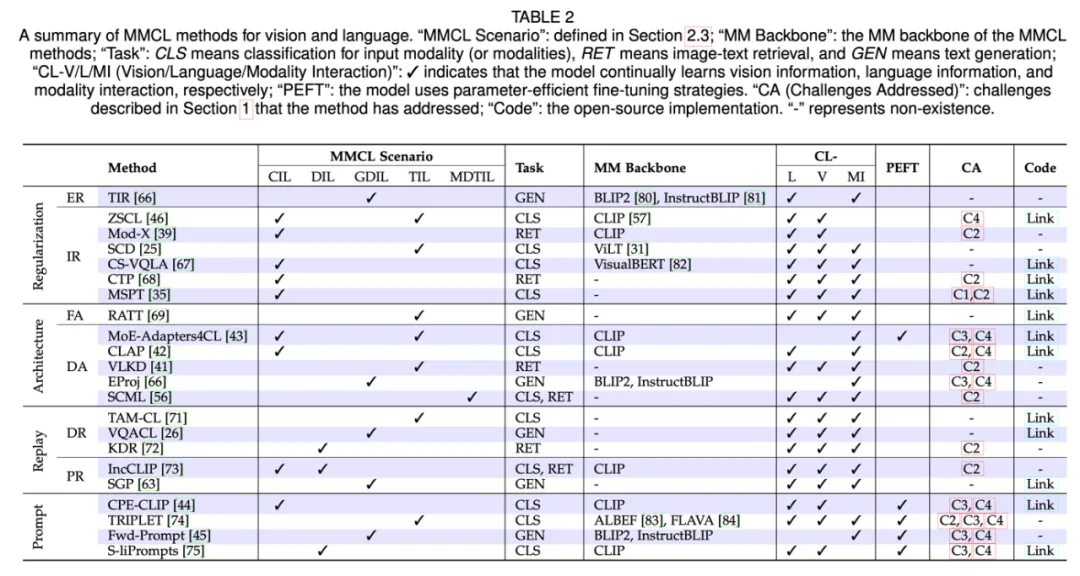

以下兩張表總結了 MMCL 方法的詳細屬性。

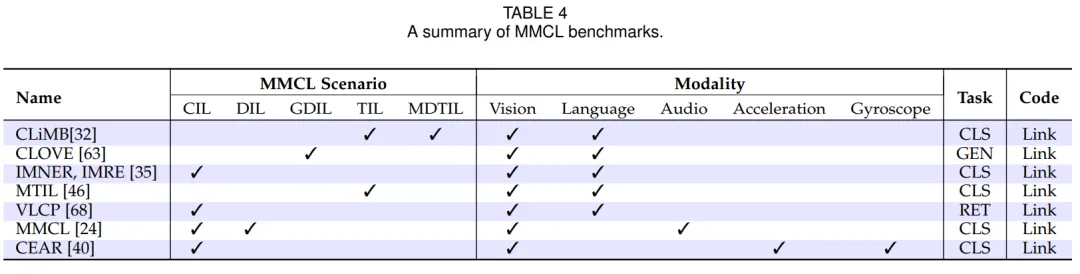

數據集和基準

大多數 MMCL 數據集是從最初為非連續學習任務設計的知名數據集中改編而來的,研究人員通常會利用多個數據集或將單個數據集劃分為多個子集,以模擬 MMCL 環境中的任務。此外,也存在一些專門用于 MMCL 的數據集,例如 P9D 和 UESTC-MMEA-CL。下表總結了涵蓋各種連續學習場景、模態和任務類型的 MMCL 基準。

未來方向

多模態連續學習已成為一個活躍且前景廣闊的研究主題。以下是幾個未來進一步探索和研究的方向。

- 提高模態的數量與質量:表 3 中顯示,只有少數 MMCL 方法關注視覺和語言以外的模態。因此,在整合更多模態方面還有巨大的研究空間。此外,模態并不限于表 3 中列出的內容,還可能包括生物傳感器、基因組學等,從而增強對新興挑戰的支持,尤其是在科學研究中的人工智能應用(AI for science)。

- 更好的模態交互策略:許多現有的 MMCL 方法僅僅在網絡架構中融合模態,而沒有深入理解或分析它們在訓練中的相互影響。因此,測量這種跨模態影響將是一個有趣且有前景的研究方向,以實現更細粒度的多模態交互。

- 參數高效微調的 MMCL 方法:參數高效微調(PEFT)方法提供了一種有效的解決方案,以優化訓練成本。雖然基于提示的方法是參數高效的,但在表 2 中可以看到,其他類別中僅有 MoE-Adapters4CL 利用了 PEFT 方法。因此,考慮到近年來涌現出眾多 PEFT 方法,將它們應用于減少 MMCL 方法的訓練成本是一個值得探索的方向。此外,除了簡單地應用現有 PEFT 方法,一個有前景的方向是為 MMCL 設置提出新的 PEFT 方法,并將其與其他 MMCL 技術良好集成。

- 更好的預訓練知識維護:由于許多 MMCL 方法使用了強大的多模態預訓練模型,因此在訓練過程中自然希望能夠記住其預訓練知識。遺忘預訓練知識可能會顯著影響未來任務性能。

- 基于提示的 MMCL 方法:基于提示的 MMCL 方法能有效應對挑戰 3:高計算成本,以及挑戰 4:預訓練零樣本能力退化。然而,如表 2 所示,基于提示的 MMCL 方法目前是最少的一類。鑒于基于提示的方法仍處于起步階段,因此進一步研究和發展的潛力巨大。

- 可信賴的多模態連續學習:隨著人們越來越關注隱私以及政府實施更多相關法規,對可信賴模型的需求正在上升。諸如聯邦學習(FL)等技術可以被用于使服務器模型在不共享原始數據的情況下學習所有客戶端的數據知識。隨著眾多聯邦連續學習(FCL)方法的發展,將 FCL 方法擴展到 MMCL 將是一個有前景的發展方向,從而增強 MMCL 模型的可信賴性。

總結

本文呈現了一份最新的多模態連續學習(MMCL)綜述,提供了 MMCL 方法的結構化分類、基本背景知識、數據集和基準的總結。作者將現有的 MMCL 工作分為四類,即基于正則化、基于架構、基于重放和基于提示的方法,還為所有類別提供了代表性的架構示意圖。此外,本文討論了在這一快速發展的領域中有前景的未來研究方向。希望 MMCL 的發展進一步增強模型使其展現出更多人類的能力。這種增強包括在輸入層面處理多模態的能力以及在任務層面獲取多樣化技能,從而使人們更接近于在這個多模態和動態世界中實現通用智能的目標。