清華推出開源具身智能框架:用VLM解決機器人動作異構一致性難題,性能超越14倍參數對手

具身智能當中,動作空間的異構一致性問題帶來的泛化瓶頸有解了!

清華智能產業研究院(AIR)團隊聯合商湯研究院等機構發布了首個基于通用動作空間的具身基礎模型框架UniAct。

UniAct以視覺語言模型為核心,構建了首個tokenized通用動作空間,解決了具身智能中的通用動作異構一致性難題。

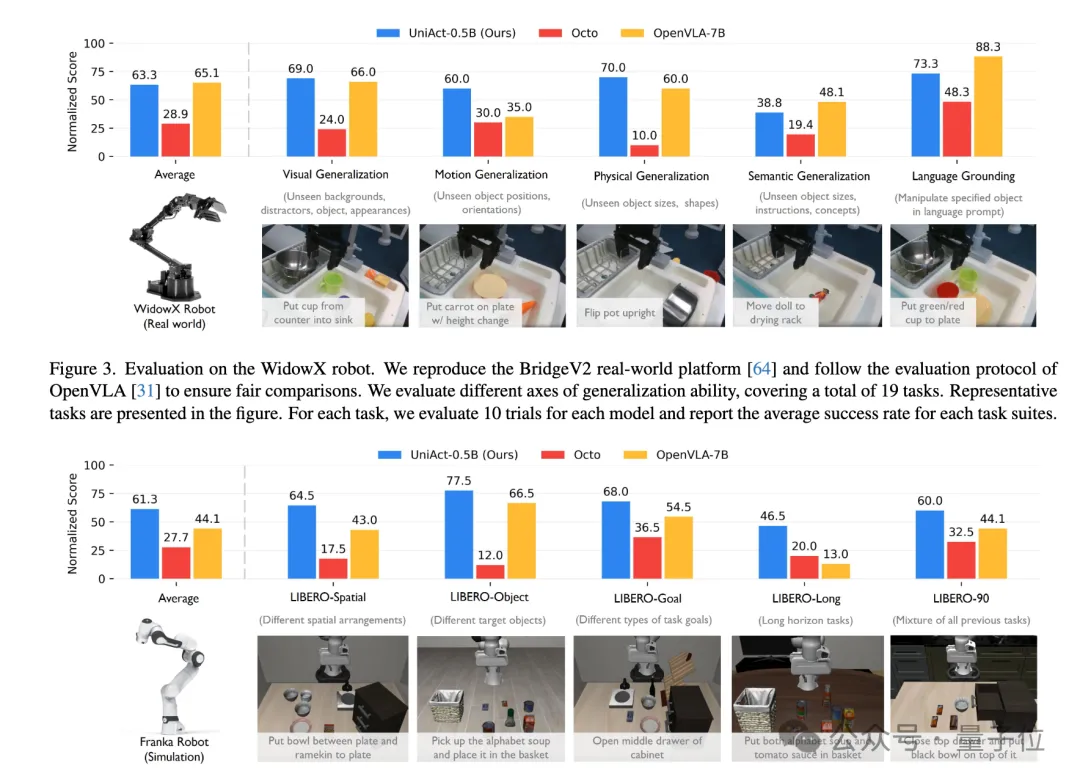

在多項權威評測中,UniAct都超越了參數量達14倍的頂尖對手OpenVLA。

目前,UniAct代碼與論文已開源。

制約智能體泛化的瓶頸

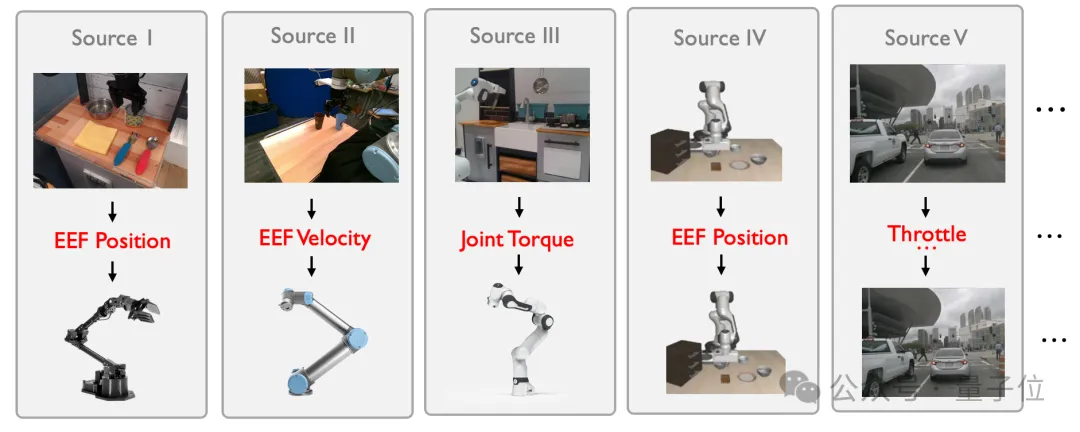

在人工智能領域,視覺、語言類基礎模型通過海量數據訓練實現跨模態泛化,但具身智能的構建卻因動作空間的異質性陷入瓶頸。

不同機器人(如機械臂、四足機器人、汽車)因物理形態、控制接口差異,其動作指令在物理空間中呈現“不相交流形”,具體來說可以體現在三個方面:

- 本體差異:機械臂的末端執行器(EEF)位置與四足機器人的關節角度,物理含義截然不同;

- 控制接口多樣性:同一指令(如“抓取物體”)在不同機器人中可能轉化為EEF速度或關節扭矩;

- 多模態干擾:人類操作者的動作風格差異進一步加劇數據沖突。

傳統方法嘗試通過微調或聚合異構數據緩解問題,但收效甚微。

多數研究被迫將異構動作空間“強行對齊”,導致相似編碼代表不同物理行為,甚至引發控制邏輯混亂。

從“通用原子行為”到“跨具身泛化”

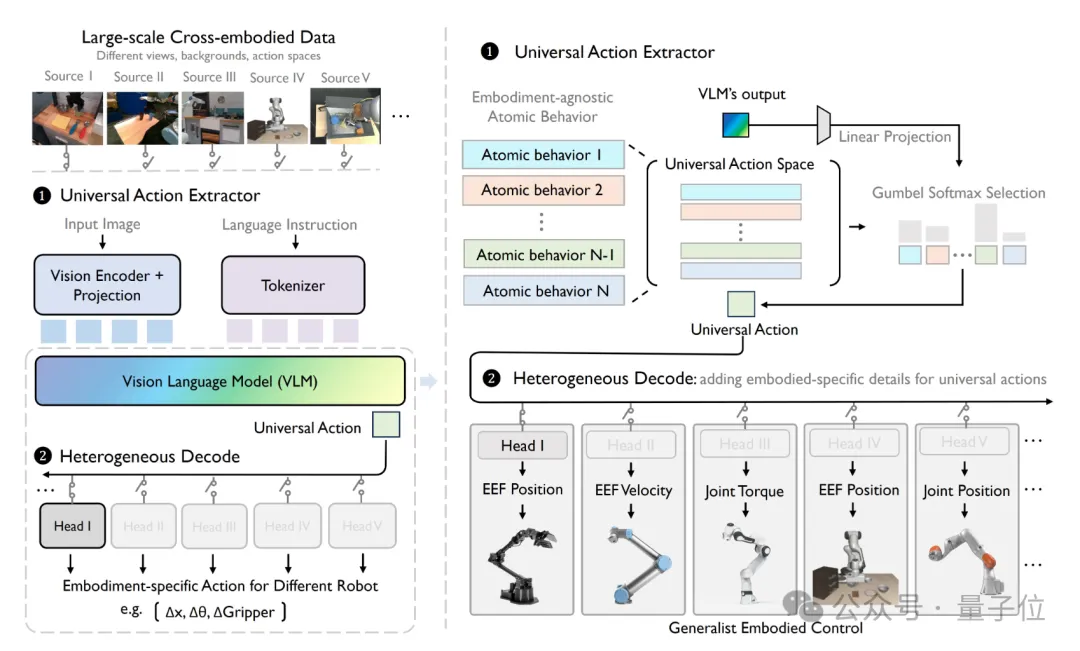

團隊提出的UniAct框架,以視覺語言模型(VLM)為核心,構建了首個tokenized通用動作空間。

UniAct通過三大創新實現突破。

一是通用動作編碼,也就是將不同機器人的原子行為(如“移動到目標位置”“避開障礙物”)封裝為向量量化的codebook,每個token代表可跨機器人共享的通用技能。

這種設計既保留了動作的物理因果性,又消除了異構性

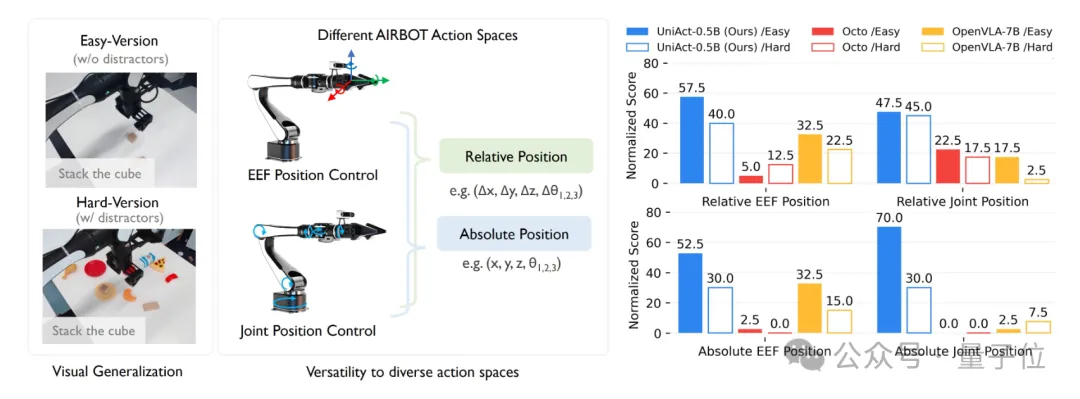

二是異質解碼器,即針對不同機器人平臺,通過輕量化解碼器添加本體感受特征(如關節力矩)或不同攝像頭視角下的圖像,將通用動作轉換為可執行指令。

例如,機械臂需EEF位置控制,而四足機器人需關節角度指令,解碼器可動態適配。

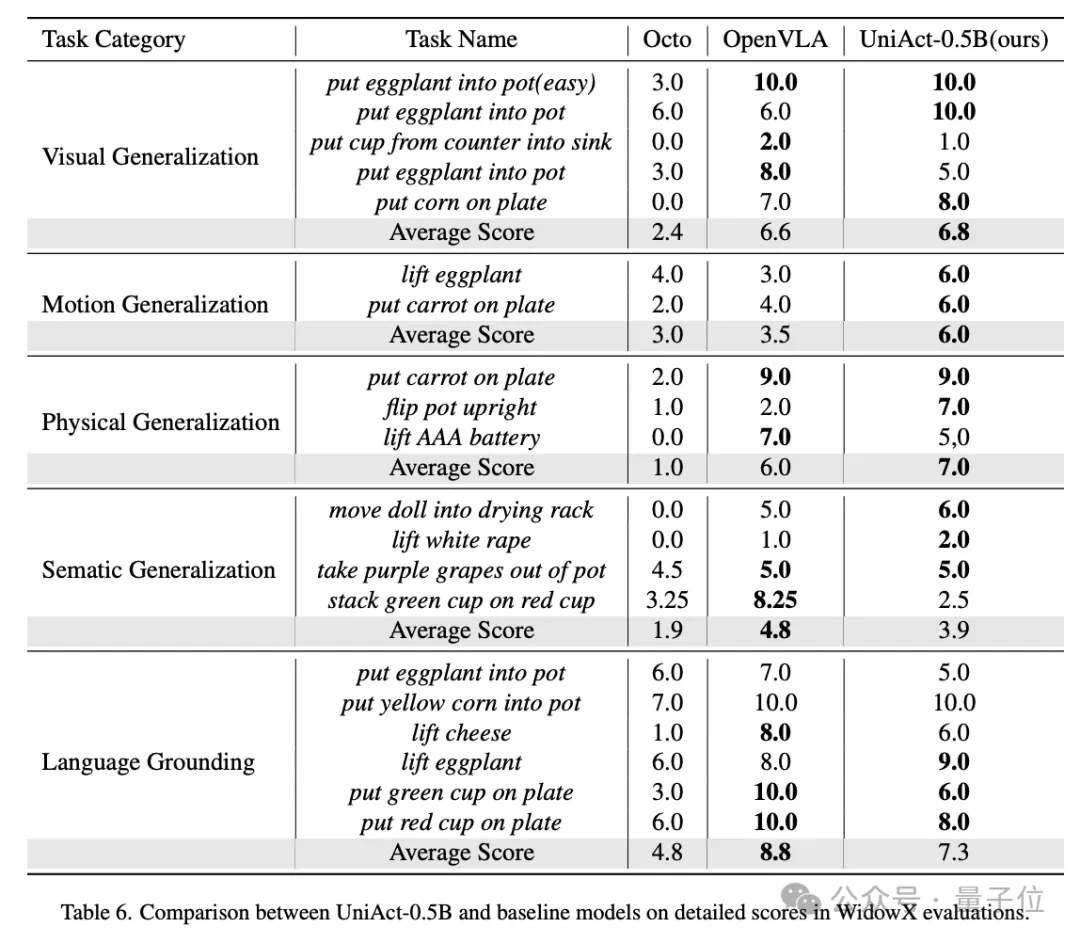

三是輕量化架構,UniAct-0.5B模型僅用0.5億參數,即在對現實與模擬機器人任務的測試中超越14億參數的OpenVLA,驗證了通用動作的高效性。

復雜場景下的“全能選手”

在包含大視角變化(如第三人稱轉第一人稱)和未見機器人類型(如雙臂機械臂)的測試中,UniAct展現了驚人的泛化能力。

UniAct憑借跨機器人遷移與復雜環境適應能力,在真實世界和仿真環境的不同機械臂任務下,大幅提升任務成功率。

并且擁有極高的數據效率,僅需50條示教的機器人專用數據即可完成模型到新環境的微調。

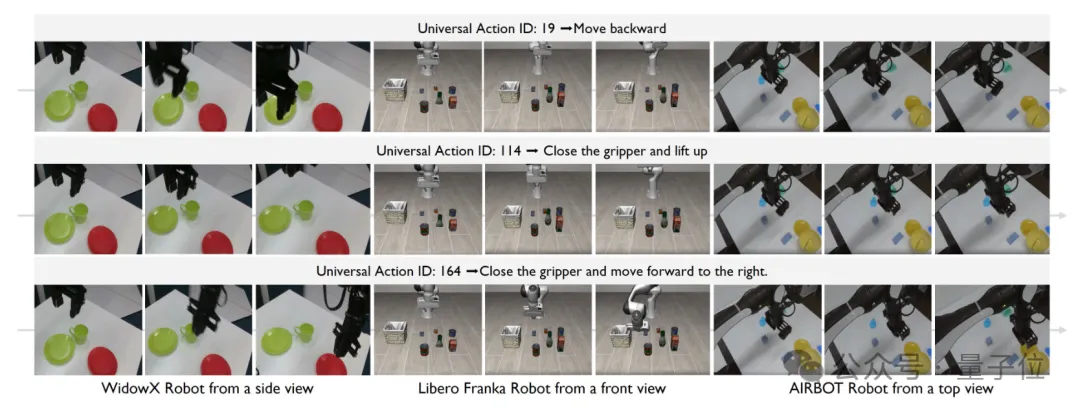

在通用動作異構一致性上,通過大量的異構數據預訓練,UniAct框架也探索出了具有高度一致的通用動作空間。

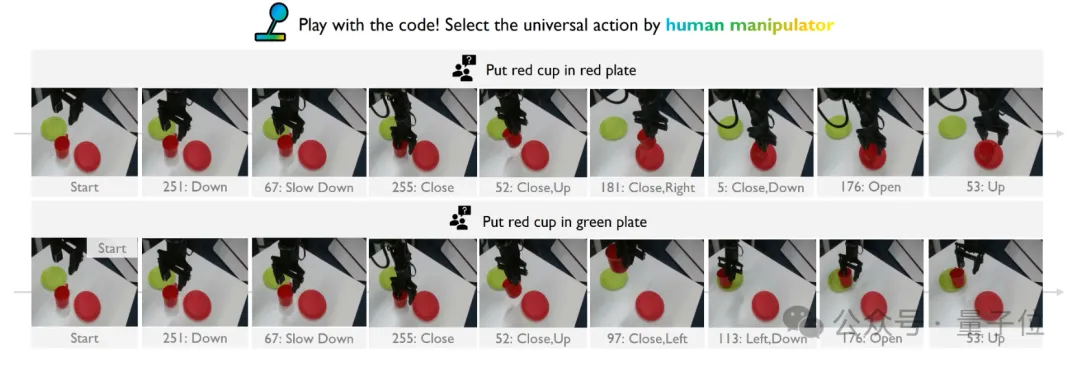

如下圖所示,同一個通用動作表征可以在完全不同的部署場景和具身智能體上表現出一致的行為模式。

此外,高效的異構解碼機制讓UniAct具備了可直接快速部署的通用動作,為控制具身智能體提供了新的方式,通過從碼本中直接挑選通用動作即可控制不同具身智能體完成指定的任務,play with code!

作者表示,UniAct的突破為具身智能的Scaling Law探索提供新思路。

UniAct證明了通用動作是解鎖具身基礎模型潛力的關鍵鑰匙。

傳統方法依賴單一機器人數據,而UniAct通過共享通用動作空間,使模型能吸收全球眾包數據的精華,有望突破數據規模限制。

項目主頁:https://2toinf.github.io/UniAct/

論文地址:https://arxiv.org/abs/2501.10105

GitHub:https://github.com/2toinf/UniAct