騰訊混元、英偉達都發混合架構模型,Mamba-Transformer要崛起嗎?

在過去的一兩年中,Transformer 架構不斷面臨來自新興架構的挑戰。

在眾多非 Transformer 架構中,Mamba 無疑是聲量較大且后續發展較好的一個。然而,與最初發布時那種仿佛「水火不容」的局面不同,最近一段時間,這兩種架構似乎正在走向融合。

上周五,騰訊宣布推出自研深度思考模型「混元 T1」正式版,這是一個能秒回、吐字快、擅長超長文處理的強推理模型。而之所以具備這些優勢,很大程度上是因為騰訊采用了 Hybrid-Mamba-Transformer 融合架構。這一架構有效降低了傳統 Transformer 架構的計算復雜度,減少了 KV-Cache 的內存占用,從而顯著降低了訓練和推理成本,讓混元 T1 實現首字秒出,吐字速度最快可達 80 token/s。

與此同時,英偉達也推出了一個采用 Mamba-Transformer 混合架構的模型家族 ——Nemotron-H,其速度是同體量競品模型的三倍。

速度的提升與成本的降低,是 AI 大模型邁向更廣泛應用與普及的必經之路。如今,騰訊、英偉達等科技巨頭對 Mamba-Transformer 混合架構的高度關注與投入,釋放出一個極為重要的信號:此類架構所蘊含的巨大價值,值得我們深入挖掘與探索。

恰好,滑鐵盧大學計算機科學助理教授陳文虎(Wenhu Chen)最近發帖,盤點了一下最近的幾款 Mamba-Transformer 模型。我們對他的盤點進行了整理,希望能帶給大家一些啟發。

Mamba-Transformer 簡介

Mamba-Transformer 混合架構,顧名思義,就是將 Mamba 與 Transformer 架構組合到一起。

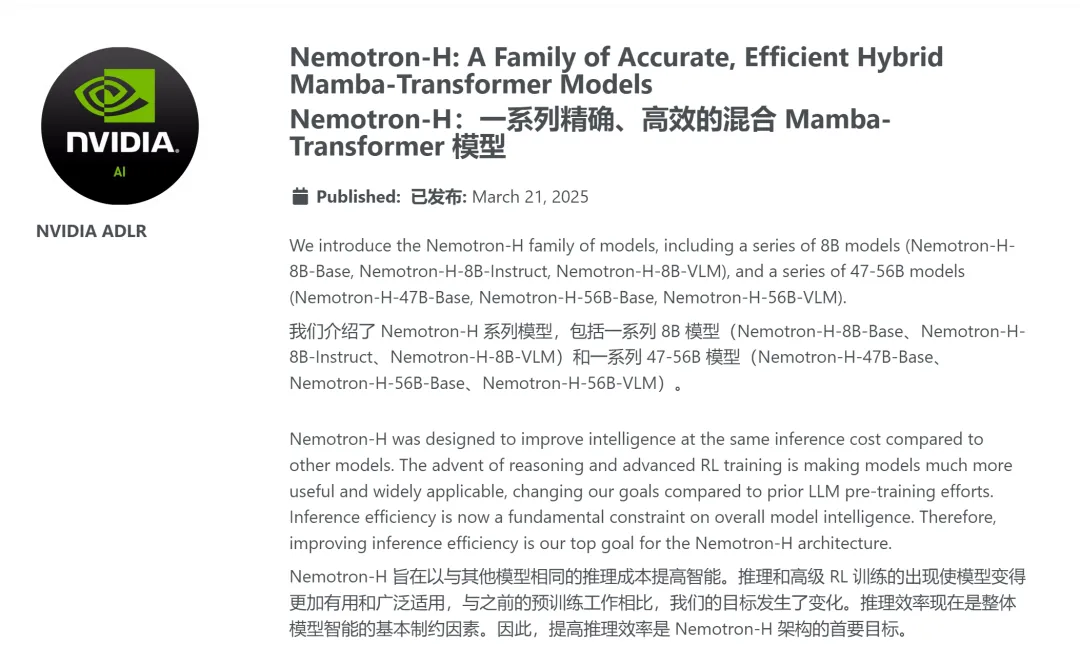

Transformer 想必大家已經非常熟悉了,簡單來說:Transformer 架構是一種以自注意力機制為核心的深度學習模型,自 2017 年由 Ashish Vaswani 等人提出以來,便革新了傳統序列模型的設計理念。其關鍵在于多頭自注意力機制能夠在全局范圍內捕捉輸入序列中各元素之間的復雜依賴關系,同時通過位置編碼保留序列位置信息,加上殘差連接和層歸一化等技術確保了高效的并行計算和穩定的訓練過程。這種架構不僅顯著提升了機器翻譯、文本生成等自然語言處理任務的性能,也為后續 BERT、GPT 等預訓練模型的快速發展奠定了堅實基礎。

經典 Transformer 架構

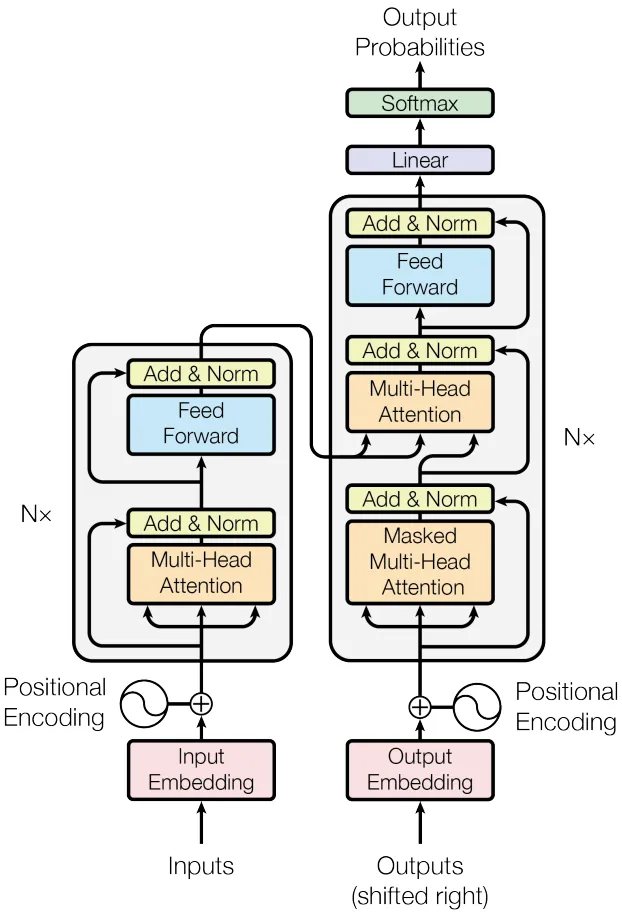

而 Mamba 則是一種狀態空間模型(SSM)—— 該架構的一大顯著優勢是能高效地捕獲序列數據中的復雜依賴關系,并由此成為 Transformer 的一大強勁對手。

經典的狀態空間模型可被視為循環神經網絡(RNN)和卷積神經網絡的(CNN 融合模型。它們可使用循環或卷積運算進行高效地計算,從而讓計算開銷隨序列長度而線性或近線性地變化,由此大幅降低計算成本。

作為 SSM 最成功的變體架構之一,Mamba 的建模能力已經可以比肩 Transformer,同時還能維持隨序列長度的線性可擴展性。

Mamba 首先引入了一個簡單卻有效的選擇機制,可根據輸入對 SSM 進行重新參數化,從而可讓模型在濾除不相關信息的同時無限期地保留必要和相關的數據。然后,Mamba 還包含一種硬件感知型算法,可使用掃描(scan)而非卷積來循環地計算模型,這在 A100 GPU 上能讓計算速度提升 3 倍。

憑借強大的建模復雜長序列數據的能力和近乎線性的可擴展性,Mamba 已經崛起成為一種重要的基礎模型架構。

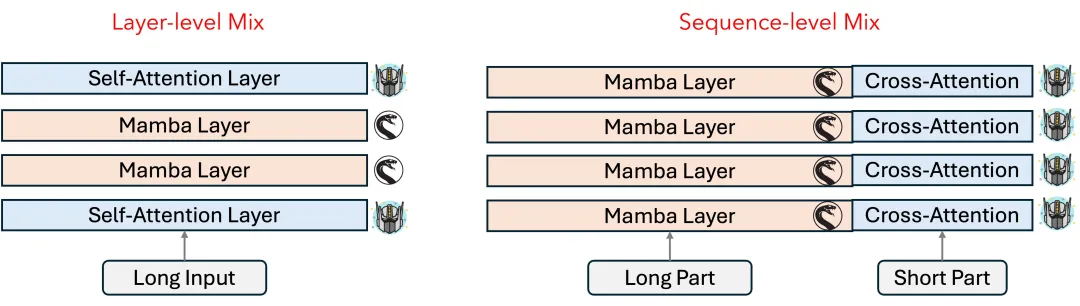

而要將 Mamba 與 Transformer 混合到一起,常見的方式有兩種:層級混合與序列級混合。如下圖所示,當前的 Mamba-Transformer 混合架構模型會根據自身需要選擇不同的混合策略。

Nemotron-H

3 月 21 日,英偉達推出了 Nemotron-H 系列的 Mamba-Transformer 混合架構模型,其中包含多種規模的多種模型,比如 Nemotron-H-8B-Base、Nemotron-H-8B-Instruct、Nemotron-H-8B-VLM、Nemotron-H-47B-Base、 Nemotron-H-56B-Base、Nemotron-H-56B-VLM。其中 47B 版本可以在單臺商品級 NVIDIA RTX 5090 GPU 上以 FP4 精度支持 100 萬 token 長度上下文的推理。

實際上,Nemotron-H 就是英偉達近期發布的用于物理 AI 的強大 VLM 模型 Cosmos-Reason 1 背后的骨干網絡。

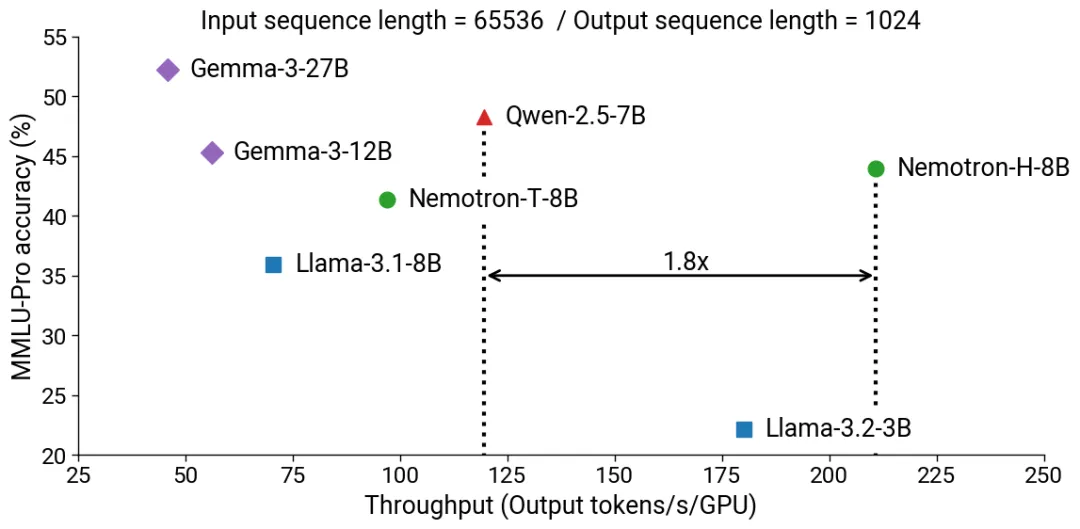

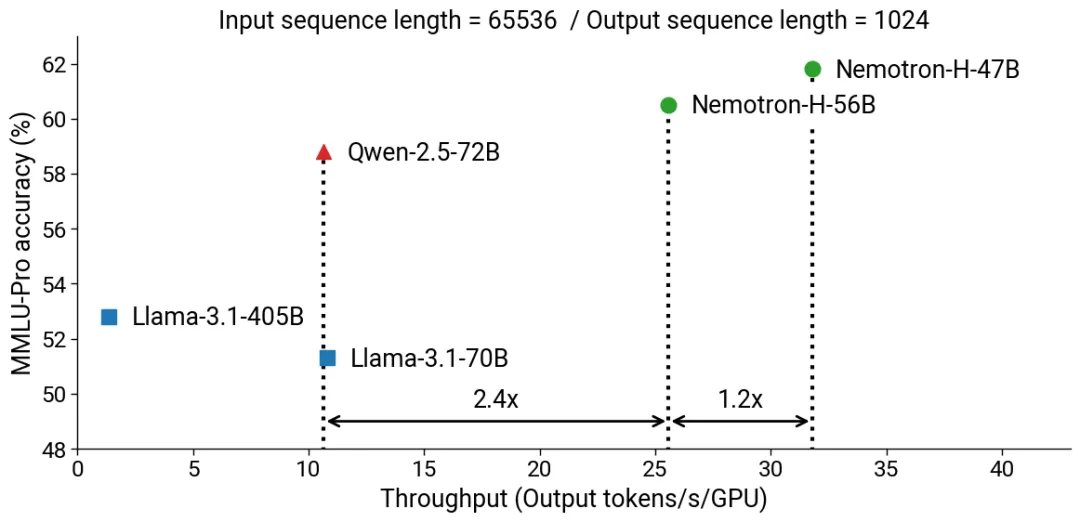

據介紹,通過采用 Mamba-Transformer 混合架構,相比于 SOTA 的開源純 Transformer 模型,Nemotron-H 在保證了相當乃至更好的準確度的同時,可以提供遠遠更快的推理速度(高達 3 倍)。下面兩圖展示了在 MMLU-Pro 基準上,Nemotron-H 與同等數量級參數的開源 Transformer 模型的準確度與吞吐量對比。可以看到,Nemotron-H 具有非常明顯的效率優勢。

此外,英偉達也公布了 Nemotron-H 的其它一些細節,包括 Nemotron-H-56B-Base 的訓練使用了 6144 臺 H100 GPU 和 20 萬億 token,訓練精度為 FP8(是 FP8 預訓練的一次大規模展示);Nemotron-H-47B-Base 是 Nemotron-H-56B-Base 的蒸餾版 —— 蒸餾精度為 FP8 并使用了 630 億訓練 token。

Hunyuan-Turbo-S 和 Hunyuan-T1

3 月 21 日同一天,騰訊也宣布推出了深度思考模型混元 T1 正式版,并同步在騰訊云官網上線。而在此之前,他們已于 3 月初發布了混元 Turbo S 基礎模型以及之后的混元 T1-preview 模型。

這些模型都采用了 Mamba-Transformer 混合架構,其中 T1 更是一款使用了大規模強化學習的強推理模型,在數學、邏輯推理、科學和代碼等理科難題具有非常明顯的優勢。當然,Mamba-Transformer 高效率的優勢也在這里有非常明顯的體現。

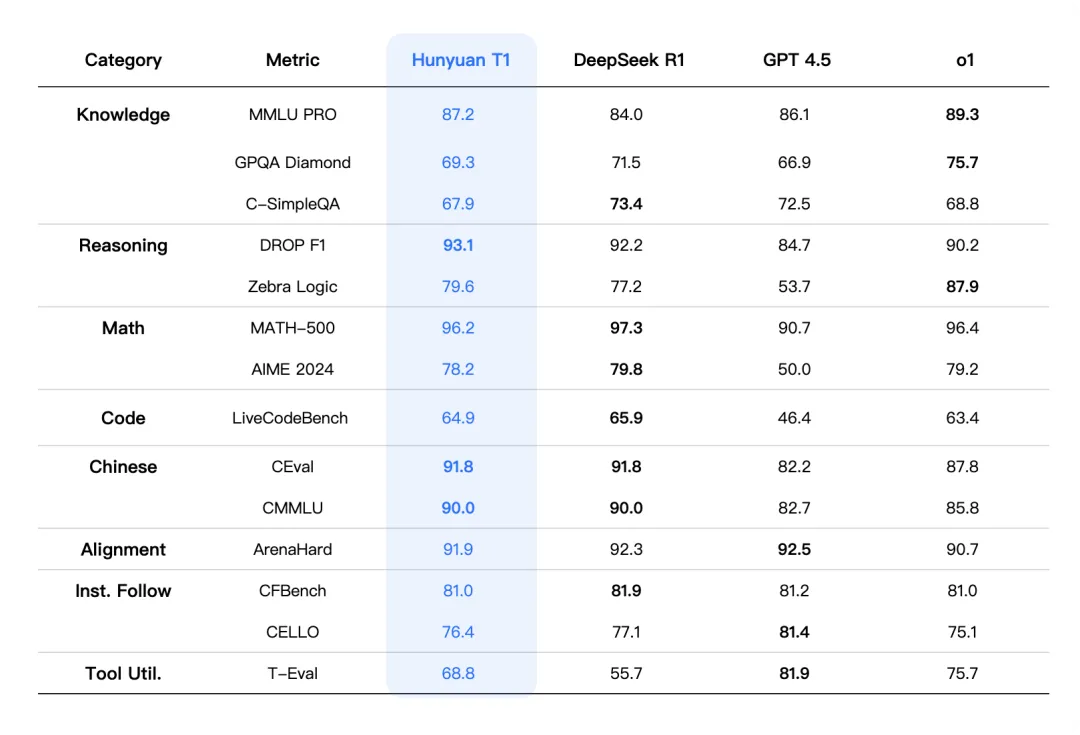

比如在大語言模型評估增強數據集 MMLU-PRO 上,混元 T1 取得了 87.2 分,僅次于 o1。在 CEval、AIME、Zebra Logic 等中英文知識及競賽級數學、邏輯推理的公開基準測試中,混元 T1 的成績也達到業界領先推理模型的水平。

據介紹,混元 T1 正式版沿用了混元 Turbo S 的創新架構,采用 Hybrid-Mamba-Transformer 融合模式。這是工業界首次將混合 Mamba 架構無損應用于超大型推理模型。

這一架構有效降低了傳統 Transformer 結構的計算復雜度,減少了 KV-Cache 的內存占用,從而顯著降低了訓練和推理成本,讓混元 T1 實現首字秒出,吐字速度達到最快 80 token/s。

混元 T1 與 DeepSeek-R1 的吐字速度對比

混元 T1 在超長文本推理領域也展現出獨特優勢。基于出色的長文捕捉能力,混元 T1 能有效解決長文推理中常見的上下文丟失和長距離信息依賴問題。同時,混合 Mamba 架構針對長序列處理進行了專項優化,通過高效的計算方式,在確保長文本信息捕捉能力的同時大幅降低資源消耗,在相近的激活參數量下,實現了解碼速度提升 2 倍。

在體現推理模型基礎能力的常見 benchmark 上,如大語言模型評估增強數據集 MMLU-PRO 中,混元 T1 取得 87.2 分,僅次于 o1。在 CEval、AIME、Zebra Logic 等中英文知識及競賽級數學、邏輯推理的公開基準測試中,混元 T1 的成績也達到業界領先推理模型的水平。

STORM

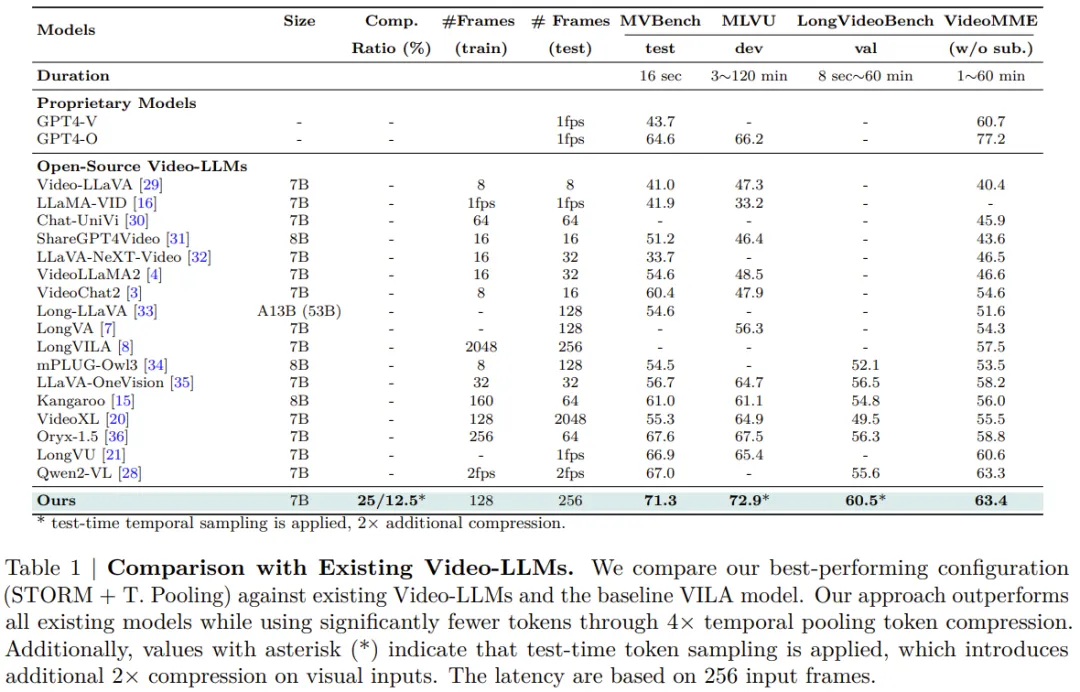

STORM 同樣來自英偉達,是一款基于視頻的多模態大型語言模型(Video-LLM)。相關研究論文已于本月初發布。

- 論文標題:Token-Efficient Long Video Understanding for Multimodal LLMs

- 論文地址:https://arxiv.org/pdf/2503.04130

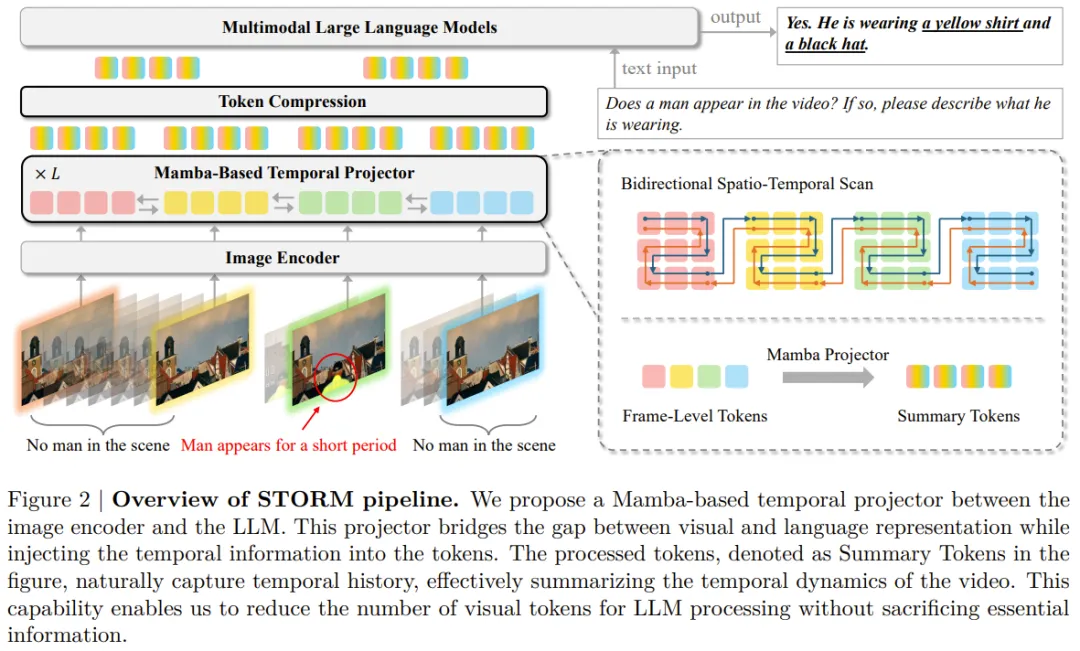

具體技術上,STORM 在圖像編碼器和 LLM 之間引入了一種新的時間編碼器,從而將視覺和語言表征整合到了一起。該架構在工作流程早期引入了時間動態,從而可以顯著提升 Video-LLM 的時間推理能力,同時還能大幅提升的下游計算效率。該團隊表示:「通過將時間信息直接注入視覺 token,可以減輕 LLM 的時間推理負擔,使其能夠專注于更高級的語言任務。」

架構上,他們采用了 Mamba 狀態空間模型作為時間層的核心,這既能高效處理長視頻,同時也可增強對經過擴展的時間上下文的泛化。這個時間層對圖像和視頻輸入的處理方式不同 —— 對于圖像,它的作用是空間掃描器,通過結合全局空間上下文來增強 token;對于視頻,它同時執行空間和時間掃描,以捕獲全面的時空信息。

Mamba 層的主要優勢在于它能夠將歷史信息壓縮為狀態表征。由于視頻輸入中的連續幀通常包含冗余信息,因此時間編碼器可以有效地處理和傳播整個視頻序列的時間信息。這樣一來,生成的視覺 token 本身就封裝了時間歷史,并有效地總結了視頻的時間動態。

有了這一特性,LLM 處理所需的視覺 token 就更少了,同時還能保留關鍵信息。

他們的實驗表明,新提出的方法效果很好,并且可以成功擴展到長上下文視頻理解模型,而不會影響訓練效率。

Vamba

Vamba 則是一個用于長視頻理解的 Mamba-Transformer 混合模型,來自前文中提到的陳文虎團隊。

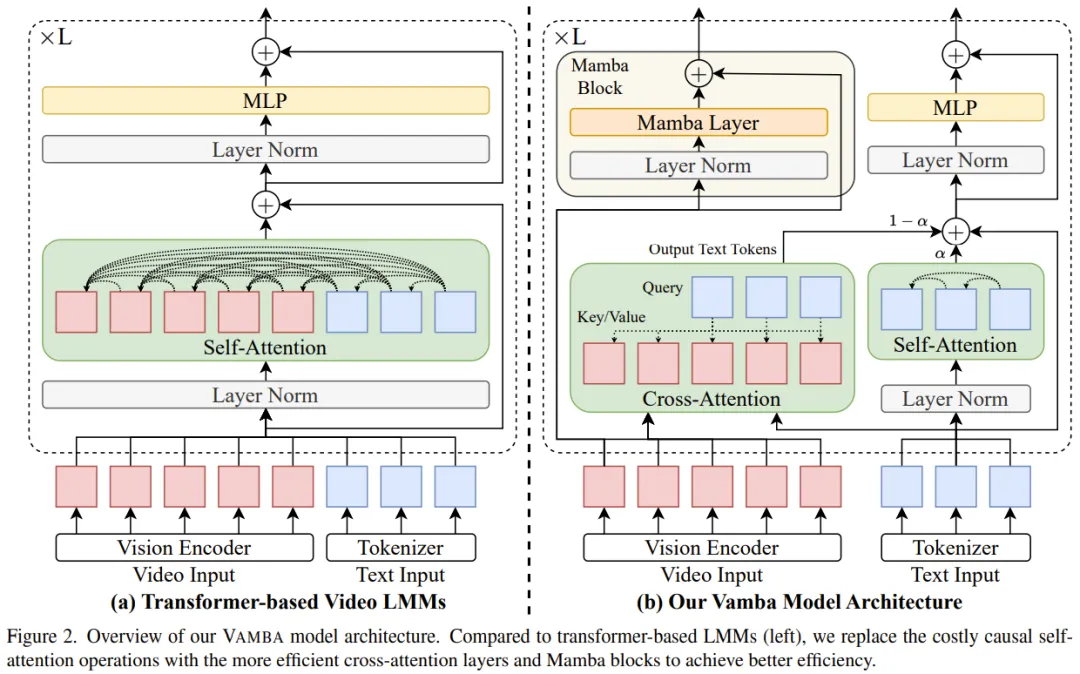

我們知道,由于因果自注意力運算的二次復雜度(會導致訓練和推理的計算成本很高),當前領先的 Transformer LMM 其實很難處理長視頻,尤其是當視頻長度長達 1 個小時以上時。現在雖有一些 token 壓縮方法可以減少視頻 token 的數量,但往往會丟失一些信息,并且處理極長序列的效率很低。

于是 Vamba 團隊探索了另一個方向:不對視頻 token 進行壓縮,而是使用另一種模型架構來提高在訓練和推理預填充階段處理視頻 token 的效率。

VAMBA 由此誕生!這款混合 Mamba-Transformer 模型可以對長達 1 個小時的視頻實現高效的理解。該團隊說明了設計這一架構的關鍵見解:可以設計高效的模塊來近似基于 Transformer 的 LMM 中文本和視頻 token 的因果自注意力運算。

- 論文標題:VAMBA: Understanding Hour-Long Videos with Hybrid Mamba-Transformers

- 論文地址:https://arxiv.org/pdf/2503.11579

- 項目地址:https://tiger-ai-lab.github.io/Vamba/

具體來說,他們提出:

1、利用交叉注意力機制根據視頻 token 更新文本 token,由于文本 token 的長度較短,這種方法成本較低;

2、采用 Mamba-2 以線性復雜度處理大量視頻 token。

假設輸入序列為 M + N 個 token,其中 M 是視頻 token 的數量,N 是文本 token 的數量,該團隊發現在許多長視頻任務(M ? N)上,M 至少是 N 的 100 倍。

而該團隊提出的新模型可以將訓練 / 預填充計算復雜度從 O (d (M + N)2) 降低到 O (dMN + d2M),其中 d 是隱藏維度。不過該團隊也指出,在實踐中,由于目前 Mamba 的硬件優化不足,這種理論上的改進可能無法完全實現。

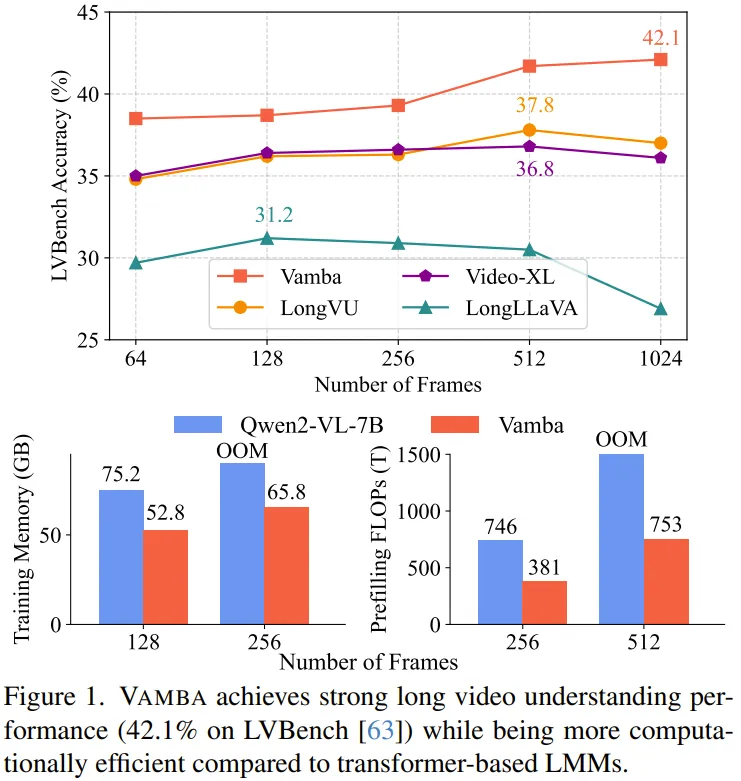

盡管如此,他們仍然觀察到,在長視頻輸入的訓練和推理過程中,GPU 內存使用量和 FLOP / 運行時間減少了 50% 以上。

VAMBA 可以使用 8 臺 A100 GPU 進行有效訓練,而 LongVU 和 LongLLaVA 分別需要 64 和 24 臺 GPU 進行訓練。通過進行兩階段訓練,新提出的 VAMBA 在高難度的小時級視頻理解基準 LVBench 上比之前最高效的視頻 LMM 提高了 4.3%。在其他長視頻理解數據集上,如 Video-MME、MLVU 和 LongVideoBench ,VAMBA 也表現出色。

看起來,Mamba-Transformer 混合架構已經開始在推理以及多模態任務中展露頭角。通過合理的設計,Transformer 強大的性能可以與 Mamba 在長上下文和效率上的優勢整合到一起,為大型語言模型(LLM)和大型多模態模型(LMM)帶來新的可能性。