編輯 |言征

小模型王座一夜易主了!冷不防,英偉達就丟出了一個新混合架構,以后不再只是Transformer的天下了。

日前,NVIDIA剛剛發布了Hymba-1.5B-Base,這是一個將Transformer注意力機制與狀態空間模型(SSM)集成的小型語言模型。

這種全新的混合架構只使用1.5T的Tokens進行訓練,性能、速度卻全面超越了市面上主流的所有小模型!英偉達的科學家兼研究經理Pavlo Molchanov在X上宣布了這一最新發展。

圖片

圖片

Hugging Face 的技術負責人及大型語言模型(LLMs)專家 Philipp Schmid 對此發展發表評論說:“Hymba 在僅使用1.5萬億個標記進行訓練的條件下,性能超越了其他小型大型語言模型,如Meta 3.2或SmolLM v2。”

圖片

圖片

1.雙重架構、精確回憶、高效上下文

據“抱抱臉”上公開資料顯示,Hymba-1.5B-Base是在今年年9月1日至2024年11月10日期間進行訓練的,許可證方面則根據NVIDIA開放模型許可協議發布。

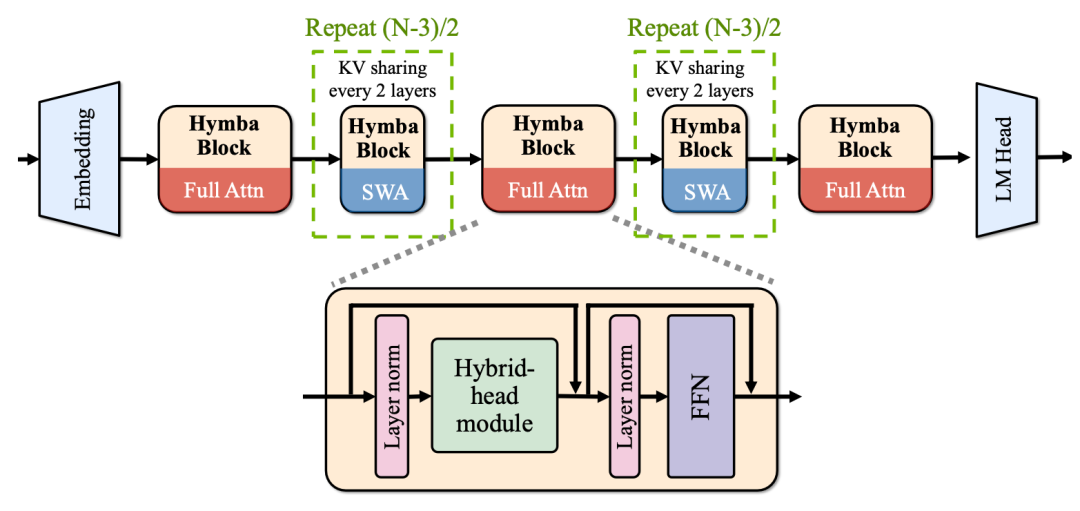

Hymba模型使用雙重結構,具有精確回憶的注意力頭和高效上下文總結的SSM頭。

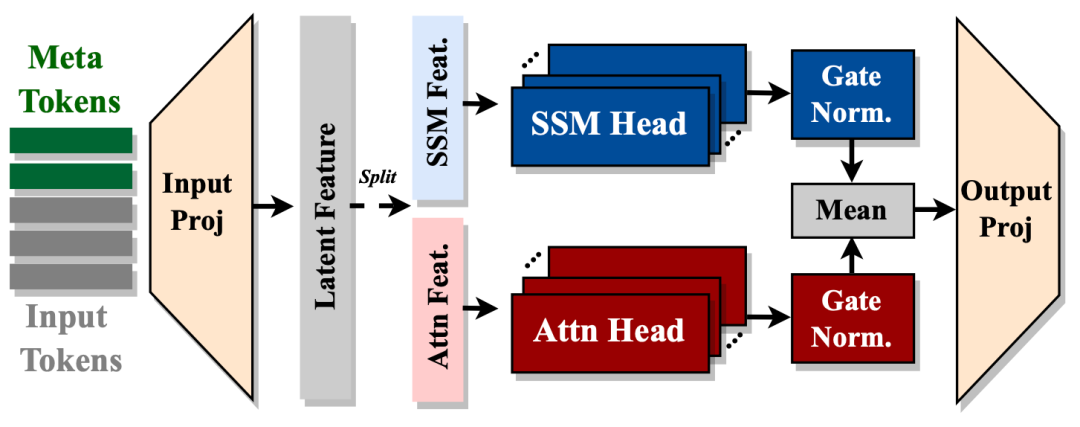

具體來講,其特點在于采用了混合頭并行架構,該架構將Transformer注意力機制與狀態空間模型(SSM)相結合,以提高效率。注意力頭提供高分辨率的回憶能力,而SSM頭則實現高效的上下文總結。此外,模型還引入了可學習的Meta標記,這些標記被添加到提示之前,用于存儲關鍵信息,并減輕與注意力機制相關的“被迫關注”負擔。通過引入跨層鍵值(KV)共享和部分滑動窗口注意力,該模型得到了進一步優化,從而實現了緊湊的緩存大小。

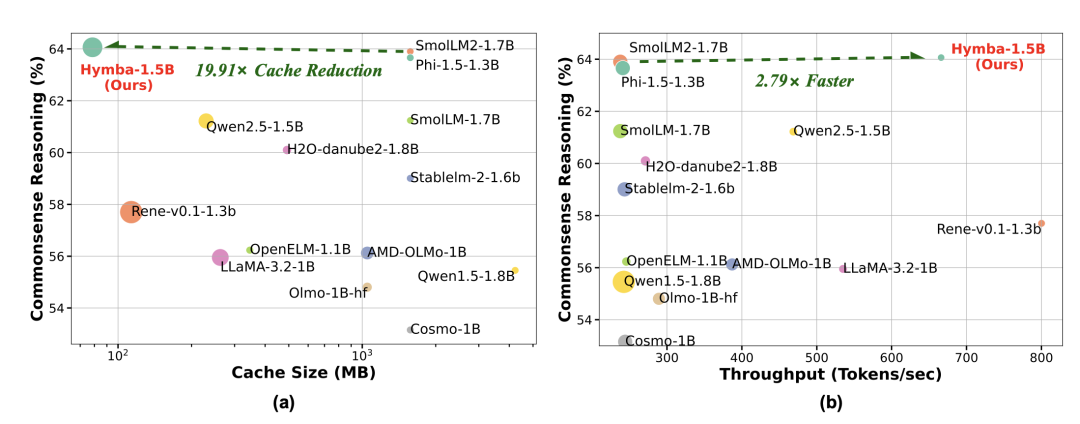

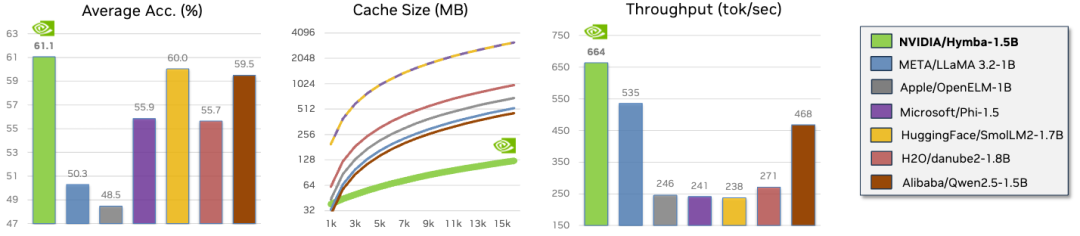

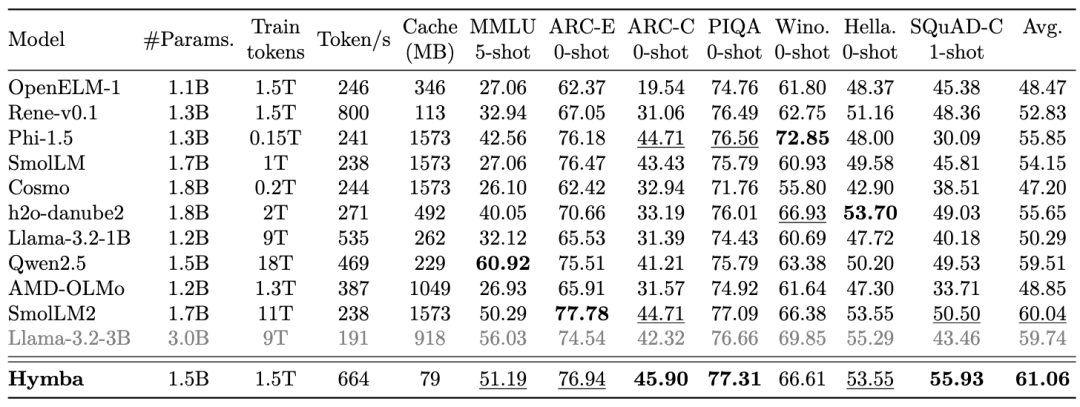

在一項對比相同設置下不同架構的受控研究中,Hymba-1.5B-Base 展現出了顯著優勢。

它在所有公開可用的、參數少于20億的模型中表現優異,并以平均準確率高出1.32%、緩存大小減少11.67倍、吞吐量提升3.49倍的成績超越了Llama-3.2-3B。

2.模型架構非常巧妙

Hymba-1.5B-Base是一款基礎文本到文本的模型,可用于多種自然語言生成任務。論文《Hymba: A Hybrid-head Architecture for Small Language Models》進一步闡述了模型的思想和實驗對比。

論文地址:https://arxiv.org/pdf/2411.13676

該模型采用混合架構,其中Mamba和注意力頭并行運行。每個提示前都會添加一組可學習的標記(稱為Meta標記),以提高模型的有效性。該模型在兩層之間以及單層內的各個頭之間共享鍵值(KV)緩存。90%的注意力層采用滑動窗口注意力機制。

Hymba-1.5B-Base的模型嵌入大小為1600,擁有25個注意力頭,MLP中間維度為5504,總層數為32層,16個SSM狀態,3個全注意力層,其余為滑動窗口注意力層。與標準Transformer不同,Hymba中的每個注意力層都并行結合了標準注意力頭和Mamba頭的混合組合。此外,它還使用了分組查詢注意力(GQA)和旋轉位置嵌入(RoPE)。

圖片

圖片

概括來講,這架構有三個值得注意的特點:

首先,在同一層內融合注意力頭和SSM頭,對相同輸入進行并行且互補的處理;此外,還引入了元標記(meta tokens),這些標記被添加到輸入序列的前面,并與所有后續標記進行交互,從而存儲重要信息并減輕注意力中“必須關注”的負擔;最后,還結合了跨層KV共享和全局-局部注意力,進一步提升內存和計算效率。

圖片

圖片

3.性能超越所有主流小模型,包括Llama3.2

Hymba-1.5B-Base在所有低于20億的公開模型中表現優異。

圖片

圖片

研究人員從準確率、緩存大小、處理速度三個方面綜合評估了現在主流的小語言模型,比如Meta的Llama3.2-1B、Apple的OpenELM-1B、微軟的Phi-1.5B、抱抱臉的SmoILM2-1.7B、阿里巴巴的Qwen2.5-1.5B等。

綜合評估和消融研究表明,Hymba不僅在眾多具有代表性的任務中樹立了新的最優(SOTA)基準性能,而且在效率方面相比Transformer和之前的混合模型也更高。例如,在常識推理任務中,Hymba-1.5B的平均準確率比Llama-3.2-3B高出1.32%,而所需的緩存大小卻小了11.67倍,速度快了3.49倍。

圖片

圖片

NVIDIA 還提供了一個設置腳本,以簡化環境配置,支持CUDA 12.1和12.4版本。

4.不過,需要小心

英偉達承認該模型是利用從互聯網上原始抓取的數據進行訓練的,這就意味著訓練數據包含有毒語言、不安全內容和社會偏見。因此,該模型可能會放大這些偏見,并在接收到有毒提示時返回有毒的回應。

即使提示本身不包含任何明顯冒犯性的內容,該模型也可能生成不準確、遺漏關鍵信息或包含不相關或冗余文本的答案,從而產生社會不可接受或不受歡迎的文本。

除了有毒內容方面需要注意,工程方面也需要注意:

用戶應在生成期間將批處理大小設置為1,因為當前設置不完全支持帶有滑動窗口注意的填充元標記。然而,任何批次大小都適用于訓練和預填充。

5.本月25日公開模型權重,可商用

英偉達非常強調在創建值得信賴的人工智能方面分擔責任的重要性,并為其發展制定了道德準則。建議用戶負責任地使用該模型,同時注意其局限性。

“在按照我們的服務條款下載或使用時,開發者應與內部模型團隊合作,確保該模型滿足相關行業和使用場景的要求,并解決產品濫用等不可預見的問題。”

Molchanov 評論道:“我不確定我們是否應該為使用1.5萬億個標記的訓練感到自豪。原因是我們要追求速度;在接下來的兩周里,就會有人做得更好。”

不過好消息是,Hymba模型已準備好用于商業用途了,而且模型權重也即將推出,預計11月25日發布!

相信大家這兩天就可以快速用上這款非常nice的小模型了。