五分鐘讀懂 LLM:DeepSeek、ChatGPT 背后的核心技術(shù)

LLM(Large Language Model)是大型語(yǔ)言模型的簡(jiǎn)稱,像DeepSeek、ChatGPT等都屬于不同公司開發(fā)的LLM。你可以把它想象成一個(gè)超級(jí)聰明的聊天機(jī)器人和寫作助手,它通過學(xué)習(xí)了海量文字資料,變得非常擅長(zhǎng)理解和生成人類語(yǔ)言。簡(jiǎn)單來說,它能聽懂你說什么,也能像模像樣地跟你聊天、寫文章等等。

一、LLM到底是什么?

1. 咱們先拆開看看

- 語(yǔ)言模型 (Language Model):你可以把它想象成一個(gè)學(xué)習(xí)了海量文字資料的“學(xué)霸”。它讀了很多很多書、新聞、網(wǎng)頁(yè)等等,所以它對(duì)我們平時(shí)說話、寫文章的規(guī)律非常熟悉。它知道哪些詞語(yǔ)經(jīng)常一起出現(xiàn),一句話說完之后接下來可能會(huì)說什么。

- 大型 (Large):這個(gè)“大型”就厲害了!它意味著這個(gè)“學(xué)霸”讀過的書實(shí)在是太多太多了,比你我讀過的書加起來還要多得多!正是因?yàn)樽x得多,它才能更好地理解和運(yùn)用語(yǔ)言。

所以,LLM合起來就是:一個(gè)超級(jí)超級(jí)厲害的語(yǔ)言“學(xué)霸”,它通過學(xué)習(xí)大量的文字,掌握了人類語(yǔ)言的規(guī)律,然后就能做很多事情:

- 跟你聊天:你可以像跟朋友一樣跟它說話,問它問題,它會(huì)盡力理解你的意思并給出回答。

- 幫你寫東西:你可以讓它幫你寫郵件、寫文章、寫詩(shī),甚至寫代碼!當(dāng)然,它寫出來的東西可能還需要你稍微修改一下。

- 總結(jié)信息:你給它一篇很長(zhǎng)的文章,它可以幫你提煉出最重要的信息。

- 翻譯語(yǔ)言:它可以幫你把一種語(yǔ)言翻譯成另一種語(yǔ)言。

- 生成各種文本:比如,你給它一些關(guān)鍵詞,它可以幫你生成一段相關(guān)的文字。

你可以把LLM想象成一個(gè)非常聰明的鸚鵡,但它不僅僅是簡(jiǎn)單地模仿你說話,它還能理解你說話的意思,并且能根據(jù)它學(xué)到的知識(shí)來生成新的、有意義的語(yǔ)言。

2. 舉個(gè)例子

就像你用手機(jī)上的輸入法打字,它會(huì)根據(jù)你已經(jīng)輸入的內(nèi)容,預(yù)測(cè)你接下來想輸入什么詞語(yǔ),這就是一個(gè)簡(jiǎn)單的語(yǔ)言模型在工作。而LLM就像一個(gè)超級(jí)升級(jí)版的輸入法,它能理解更復(fù)雜的語(yǔ)境,生成更長(zhǎng)的、更連貫的文本。

總而言之,LLM就是一個(gè)非常強(qiáng)大的、能夠理解和生成人類語(yǔ)言的計(jì)算機(jī)程序,它通過學(xué)習(xí)大量的文本數(shù)據(jù),變得非常“聰明”,能夠幫助我們處理各種與語(yǔ)言相關(guān)的任務(wù)。

希望這個(gè)解釋能讓你明白什么是LLM!是不是沒有想象中那么復(fù)雜?

二、LLM工作原理

咱們來詳細(xì)介紹一下LLM(大型語(yǔ)言模型)的原理,我會(huì)盡量用通俗易懂的方式來解釋。你可以把LLM想象成一個(gè)非常非常聰明的語(yǔ)言學(xué)習(xí)機(jī)器,它的“聰明”來自于學(xué)習(xí)了海量的文本數(shù)據(jù)。

1. 核心原理:預(yù)測(cè)下一個(gè)詞語(yǔ)

LLM最核心的原理其實(shí)非常簡(jiǎn)單:預(yù)測(cè)序列中的下一個(gè)詞語(yǔ)。

想象一下,你正在輸入一句話:“今天天氣真...”。你大腦里可能會(huì)自動(dòng)浮現(xiàn)出很多可能的下一個(gè)詞,比如“好”、“不錯(cuò)”、“糟糕”等等。LLM的工作方式跟這個(gè)很像,只不過它比你的大腦要厲害得多,因?yàn)樗鼘W(xué)習(xí)了海量的文本數(shù)據(jù),知道在什么語(yǔ)境下哪個(gè)詞語(yǔ)出現(xiàn)的可能性更高。

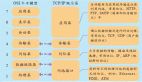

2. 關(guān)鍵技術(shù):Transformer架構(gòu)

現(xiàn)在主流的LLM,比如GPT系列、BERT系列等等,都基于一種叫做 Transformer 的神經(jīng)網(wǎng)絡(luò)架構(gòu)。這個(gè)架構(gòu)是讓LLM變得如此強(qiáng)大的關(guān)鍵。Transformer架構(gòu)主要包含以下幾個(gè)核心組件:

(1) 嵌入層 (Embedding Layer):

當(dāng)你輸入一段文字時(shí),首先每個(gè)詞語(yǔ)都會(huì)被轉(zhuǎn)換成一個(gè)叫做“詞向量”的東西。你可以把詞向量想象成一個(gè)包含了這個(gè)詞語(yǔ)各種信息的數(shù)字列表。比如,“貓”這個(gè)詞的詞向量可能會(huì)包含“動(dòng)物”、“可愛”、“有胡須”等信息。

這樣做的好處是,計(jì)算機(jī)可以更好地理解詞語(yǔ)之間的關(guān)系。比如,“貓”和“狗”的詞向量在某種程度上會(huì)比較接近,因?yàn)樗鼈兌际莿?dòng)物。

(2) 自注意力機(jī)制 (Self-Attention Mechanism):

這是Transformer架構(gòu)中最核心、最關(guān)鍵的部分。它的作用是讓模型在處理一個(gè)句子中的某個(gè)詞語(yǔ)時(shí),能夠同時(shí)關(guān)注到句子中的其他詞語(yǔ),從而更好地理解這個(gè)詞語(yǔ)的含義。

舉個(gè)例子,在句子“小明喜歡踢足球,他踢得很好”中,當(dāng)模型處理“他”這個(gè)詞的時(shí)候,自注意力機(jī)制會(huì)幫助模型注意到“他”指的是“小明”,而不是“足球”。

你可以把它想象成,當(dāng)你在閱讀一篇文章的時(shí)候,你會(huì)根據(jù)上下文來理解每個(gè)詞語(yǔ)的意思。自注意力機(jī)制就是讓模型也具備這種能力。

模型會(huì)對(duì)句子中的每個(gè)詞語(yǔ)都計(jì)算出一個(gè)“注意力權(quán)重”,權(quán)重高的詞語(yǔ)表示模型認(rèn)為它與當(dāng)前正在處理的詞語(yǔ)更相關(guān)。

(3) 多頭注意力 (Multi-Head Attention):

為了讓模型能夠從不同的角度去理解詞語(yǔ)之間的關(guān)系,Transformer使用了多個(gè)“注意力頭”。每個(gè)注意力頭都進(jìn)行一次自注意力計(jì)算,然后將結(jié)果合并起來。

這就像你從不同的角度觀察一個(gè)事物,可以獲得更全面的認(rèn)識(shí)。

(4) 前饋神經(jīng)網(wǎng)絡(luò) (Feed-Forward Neural Network):

在自注意力機(jī)制之后,每個(gè)詞語(yǔ)的表示會(huì)通過一個(gè)前饋神經(jīng)網(wǎng)絡(luò)進(jìn)行進(jìn)一步的處理,提取更復(fù)雜的特征。

(5) 位置編碼 (Positional Encoding):

由于Transformer架構(gòu)本身并沒有像循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)那樣天然的時(shí)序性(即知道詞語(yǔ)的先后順序),因此需要通過位置編碼來告訴模型句子中每個(gè)詞語(yǔ)的位置信息。

(6) 層歸一化和殘差連接(Layer Normalization and Residual Connections):

這些是訓(xùn)練深度神經(jīng)網(wǎng)絡(luò)常用的技術(shù),可以幫助模型更好地訓(xùn)練,避免梯度消失等問題。

3. 訓(xùn)練過程:海量數(shù)據(jù)和預(yù)測(cè)任務(wù)

LLM之所以能夠如此強(qiáng)大,很大程度上歸功于其龐大的訓(xùn)練數(shù)據(jù)和訓(xùn)練方式:

(1) 海量文本數(shù)據(jù):LLM通常會(huì)在非常龐大的文本數(shù)據(jù)集上進(jìn)行訓(xùn)練,這些數(shù)據(jù)可能包括互聯(lián)網(wǎng)上的網(wǎng)頁(yè)、書籍、新聞文章、代碼等等。數(shù)據(jù)量越大,模型學(xué)到的語(yǔ)言規(guī)律就越多,能力也就越強(qiáng)。

(2) 無監(jiān)督學(xué)習(xí) (Self-Supervised Learning):LLM的訓(xùn)練通常采用一種叫做“無監(jiān)督學(xué)習(xí)”的方式。這意味著我們不需要人工標(biāo)注大量的數(shù)據(jù)來告訴模型什么是對(duì)的,什么是錯(cuò)的。

- 掩碼語(yǔ)言模型:隨機(jī)遮蓋輸入文本中的一些詞語(yǔ),然后讓模型預(yù)測(cè)被遮蓋的詞語(yǔ)是什么。這迫使模型理解上下文信息。

- 下一個(gè)句子預(yù)測(cè):給模型兩個(gè)句子,讓它判斷第二個(gè)句子是不是第一個(gè)句子的下一個(gè)句子。這幫助模型理解句子之間的邏輯關(guān)系。

- 最常見的訓(xùn)練任務(wù)就是“掩碼語(yǔ)言模型(Masked Language Model)”和“下一個(gè)句子預(yù)測(cè) (Next Sentence Prediction)”(在早期的模型中,比如BERT)。

- 對(duì)于像GPT這樣的生成式模型,主要的訓(xùn)練任務(wù)是“語(yǔ)言模型 (Language Modeling)”,也就是給定一段文本,讓模型預(yù)測(cè)下一個(gè)最有可能出現(xiàn)的詞語(yǔ)。模型會(huì)不斷地預(yù)測(cè)下一個(gè)詞,直到生成完整的文本。

(3) 反向傳播和梯度下降:在訓(xùn)練過程中,模型會(huì)不斷地預(yù)測(cè)下一個(gè)詞語(yǔ),并將其與實(shí)際的下一個(gè)詞語(yǔ)進(jìn)行比較,計(jì)算出“損失”。然后,模型會(huì)通過反向傳播和梯度下降等優(yōu)化算法來調(diào)整自身的參數(shù),使得預(yù)測(cè)結(jié)果越來越接近真實(shí)答案。

4. 預(yù)訓(xùn)練和微調(diào) (Pre-training and Fine-tuning)

LLM的訓(xùn)練通常分為兩個(gè)階段:

- 預(yù)訓(xùn)練 (Pre-training):在海量的通用文本數(shù)據(jù)上進(jìn)行訓(xùn)練,讓模型學(xué)習(xí)到通用的語(yǔ)言知識(shí)和模式。這個(gè)階段通常需要消耗大量的計(jì)算資源和時(shí)間。

- 微調(diào) (Fine-tuning):在特定的任務(wù)數(shù)據(jù)集上進(jìn)行訓(xùn)練,讓模型更好地適應(yīng)特定的任務(wù)。比如,如果你想讓LLM做情感分析,你可以在一個(gè)標(biāo)注了情感的文本數(shù)據(jù)集上對(duì)預(yù)訓(xùn)練好的模型進(jìn)行微調(diào)。

5. 總結(jié)一下LLM的原理

- 核心是預(yù)測(cè)下一個(gè)詞語(yǔ)。

- 主要基于Transformer架構(gòu),核心組件是自注意力機(jī)制,讓模型能夠理解上下文。

- 通過在海量文本數(shù)據(jù)上進(jìn)行無監(jiān)督學(xué)習(xí)來訓(xùn)練,學(xué)習(xí)語(yǔ)言的規(guī)律。

- 通常分為預(yù)訓(xùn)練和微調(diào)兩個(gè)階段。

希望這個(gè)詳細(xì)的介紹能夠幫助你更好地理解LLM的原理!雖然其中涉及到一些技術(shù)細(xì)節(jié),但核心思想就是讓計(jì)算機(jī)通過學(xué)習(xí)大量的語(yǔ)言數(shù)據(jù),學(xué)會(huì)像人類一樣理解和生成語(yǔ)言。

三、具體案例

我們來用一個(gè)詳細(xì)的案例來理解LLM是如何工作的。這次我們以一個(gè)常見的應(yīng)用場(chǎng)景為例:生成一個(gè)在線商店的產(chǎn)品描述。

場(chǎng)景:假設(shè)你是一家銷售手工制作陶瓷杯子的商店,你想為你的一個(gè)新款杯子生成一個(gè)吸引人的產(chǎn)品描述。你可能會(huì)給LLM提供一些關(guān)鍵信息作為輸入。

輸入 (Prompt):

請(qǐng)為一款手工制作的陶瓷杯子寫一段產(chǎn)品描述。這款杯子是淡藍(lán)色的,上面有手繪的白色小花圖案。杯子的容量大約是350毫升,非常適合喝咖啡或茶。它是由高質(zhì)量的陶瓷制成的,手感舒適,并且可以放入微波爐和洗碗機(jī)。強(qiáng)調(diào)其獨(dú)特性和手工制作的溫暖感。1. LLM內(nèi)部處理過程 (簡(jiǎn)化版):

(1) 理解輸入 (Tokenization and Embedding):

LLM首先會(huì)將你輸入的這段文字切分成一個(gè)個(gè)小的單元,叫做“token”(可以理解為詞語(yǔ)或標(biāo)點(diǎn)符號(hào))。比如,“請(qǐng)”、“為”、“一”、“款”、“手工”、“制作”等等。

然后,每個(gè)token會(huì)被轉(zhuǎn)換成一個(gè)叫做“詞向量”的數(shù)字表示。這個(gè)詞向量包含了這個(gè)詞的語(yǔ)義信息,以及它與其他詞語(yǔ)的潛在關(guān)系。

(2) 利用Transformer架構(gòu)進(jìn)行理解 (Self-Attention):

接下來,LLM會(huì)利用Transformer架構(gòu)中的自注意力機(jī)制來分析這些詞向量之間的關(guān)系。

當(dāng)模型處理到“淡藍(lán)色”這個(gè)詞的時(shí)候,自注意力機(jī)制會(huì)幫助它注意到“杯子”這個(gè)詞,從而理解“淡藍(lán)色”是用來描述杯子的顏色。

同樣地,當(dāng)處理到“手繪”的時(shí)候,模型會(huì)注意到“白色小花圖案”,理解這是杯子上的裝飾方式。

自注意力機(jī)制會(huì)為每個(gè)詞語(yǔ)都計(jì)算出一個(gè)“注意力權(quán)重”,告訴模型哪些詞語(yǔ)在理解當(dāng)前詞語(yǔ)時(shí)更重要。比如,在理解“適合喝咖啡或茶”時(shí),“咖啡”和“茶”的權(quán)重可能會(huì)比較高。

(3) 預(yù)測(cè)下一個(gè)詞語(yǔ) (Iterative Generation):

LLM的目標(biāo)是生成一段連貫的產(chǎn)品描述。它會(huì)從一個(gè)起始標(biāo)記(通常是表示開始的特殊符號(hào))開始,然后根據(jù)它對(duì)輸入信息的理解,以及它之前學(xué)習(xí)到的海量文本數(shù)據(jù)中的語(yǔ)言模式,來預(yù)測(cè)下一個(gè)最有可能出現(xiàn)的詞語(yǔ)。

例如,在理解了這是一個(gè)淡藍(lán)色、有白色小花圖案的手工陶瓷杯子之后,模型可能會(huì)預(yù)測(cè)下一個(gè)詞是“這款”。

(4) 重復(fù)預(yù)測(cè),逐步生成:

預(yù)測(cè)出“這款”之后,LLM會(huì)將“這款”作為新的輸入,再次進(jìn)行預(yù)測(cè),預(yù)測(cè)下一個(gè)最有可能出現(xiàn)的詞語(yǔ)。可能是“精致”或者“獨(dú)特”。

這個(gè)過程會(huì)不斷重復(fù),直到模型生成一個(gè)完整的句子或者段落,或者遇到一個(gè)表示結(jié)束的特殊標(biāo)記。

在生成每個(gè)詞語(yǔ)的時(shí)候,LLM會(huì)考慮之前已經(jīng)生成的詞語(yǔ),以及輸入的提示信息,確保生成的內(nèi)容是連貫和有意義的。

(5) 考慮提示中的強(qiáng)調(diào):

LLM也會(huì)注意到你在提示中強(qiáng)調(diào)了“獨(dú)特性”和“手工制作的溫暖感”。這會(huì)影響它在生成描述時(shí)選擇的詞語(yǔ)和表達(dá)方式。它可能會(huì)使用一些更具情感色彩的詞語(yǔ),比如“匠心獨(dú)運(yùn)”、“溫潤(rùn)”、“細(xì)膩”等等。

輸出 (Generated Product Description - 可能的例子):

**感受手工的溫暖,品味生活的精致。** 這款淡藍(lán)色的手工陶瓷杯,以其手繪的白色小花圖案,為您帶來一份寧?kù)o與雅致。杯身線條流暢,容量約為350毫升,是您享用早晨咖啡或午后茶歇的理想伴侶。

這款杯子由高品質(zhì)的陶瓷精心制作而成,不僅手感溫潤(rùn)舒適,更兼具實(shí)用性,可安全放入微波爐和洗碗機(jī)。每一朵小花都由匠人手工繪制,賦予了這款杯子獨(dú)一無二的藝術(shù)魅力,也傳遞著手工制作的溫暖與用心。無論是自用還是作為禮物,這款手工陶瓷杯都能為您和您的親友帶來一份美好的體驗(yàn)。關(guān)鍵原理回顧:

- 預(yù)測(cè)下一個(gè)詞語(yǔ):LLM在生成描述時(shí),本質(zhì)上就是在不斷預(yù)測(cè)下一個(gè)最合適的詞語(yǔ)。

- Transformer架構(gòu)和自注意力機(jī)制:模型通過自注意力機(jī)制理解了輸入提示中的關(guān)鍵信息,比如顏色、圖案、材質(zhì)、用途等,并建立了它們之間的聯(lián)系。

- 海量數(shù)據(jù)學(xué)習(xí):LLM之所以能生成如此流暢和自然的文本,是因?yàn)樗诤A康奈谋緮?shù)據(jù)中學(xué)習(xí)了各種表達(dá)方式和語(yǔ)言模式。

- 提示引導(dǎo):你提供的提示信息有效地引導(dǎo)了LLM生成符合你要求的描述,包括強(qiáng)調(diào)獨(dú)特性和手工感。

2. 為什么LLM能做到這一點(diǎn)?

LLM通過學(xué)習(xí)海量的文本數(shù)據(jù),已經(jīng)掌握了非常豐富的語(yǔ)言知識(shí),包括詞語(yǔ)的含義、語(yǔ)法規(guī)則、不同語(yǔ)境下的表達(dá)方式等等。當(dāng)它接收到你的提示時(shí),它會(huì)利用這些知識(shí),結(jié)合你提供的具體信息,來預(yù)測(cè)最有可能出現(xiàn)的下一個(gè)詞語(yǔ),從而逐步生成一段符合你要求的文本。

這個(gè)案例展示了LLM是如何理解輸入,利用其內(nèi)部的機(jī)制進(jìn)行處理,并最終生成符合要求的輸出的。當(dāng)然,實(shí)際的LLM的內(nèi)部運(yùn)作要比這個(gè)簡(jiǎn)化描述復(fù)雜得多,但核心原理是相通的。像DeepSeek 和 ChatGPT 等都是不同公司開發(fā)的LLM模型。