跟李沐學ChatGPT背后技術:67分鐘讀透InstructGPT論文

在 ChatGPT 走紅之后,很多關注技術的同學都在問一個問題:有沒有什么學習資料可以讓我們系統地了解 ChatGPT 背后的原理?由于 OpenAI 還沒有發布 ChatGPT 相關論文,這一問題變得棘手起來。

不過,從 OpenAI 關于 ChatGPT 的博客中我們知道,ChatGPT 用到的方法和它的兄弟模型 ——InstructGPT 一樣,只不過 InstructGPT 是在 GPT-3 上微調的,而 ChatGPT 則是基于 GPT-3.5。在數據收集工作上,二者也存在一些差別。

博客鏈接:https://openai.com/blog/chatgpt/

InstructGPT 的論文發布于 2022 年 3 月,不過 OpenAI 早在 1 月份就發布了相關博客(參見《GPT-3 胡言亂語怎么辦?OpenAI:我們重新調教了一下,新版本更「聽話」》)。當時,OpenAI 明確提到,InstructGPT 利用了人類反饋的強化學習方法(RLHF)對 GPT-3 進行微調,使得該模型的輸出更加符合人類偏好,這點在 ChatGPT 的訓練中得到了延續。

論文鏈接:https://arxiv.org/pdf/2203.02155.pdf

除此之外,InstructGPT 和 ChatGPT 之間還有很多一脈相承之處。因此,吃透 InstructGPT 論文對于想要在 ChatGPT 方向上做些工作的同學來說將大有裨益。這也是我們力薦李沐這節精講課的原因。

課程地址:https://jmq.xet.tech/s/2lec6b (點擊「閱讀原文」可直達)

李沐博士是亞馬遜的資深首席科學家,之前和 Aston Zhang 等人共同撰寫了《動手學深度學習》。最近兩年,他一直通過視頻向大家介紹各種 AI 知識,制作了幾十篇論文的精讀課程。很多同學已經養成了跟著李沐精讀論文的習慣。

李沐博士在 B 站的賬號是「跟李沐學 AI」。

這節針對 InstructGPT 的解讀課程總共 67 分鐘,基本按照論文撰寫的順序進行介紹。

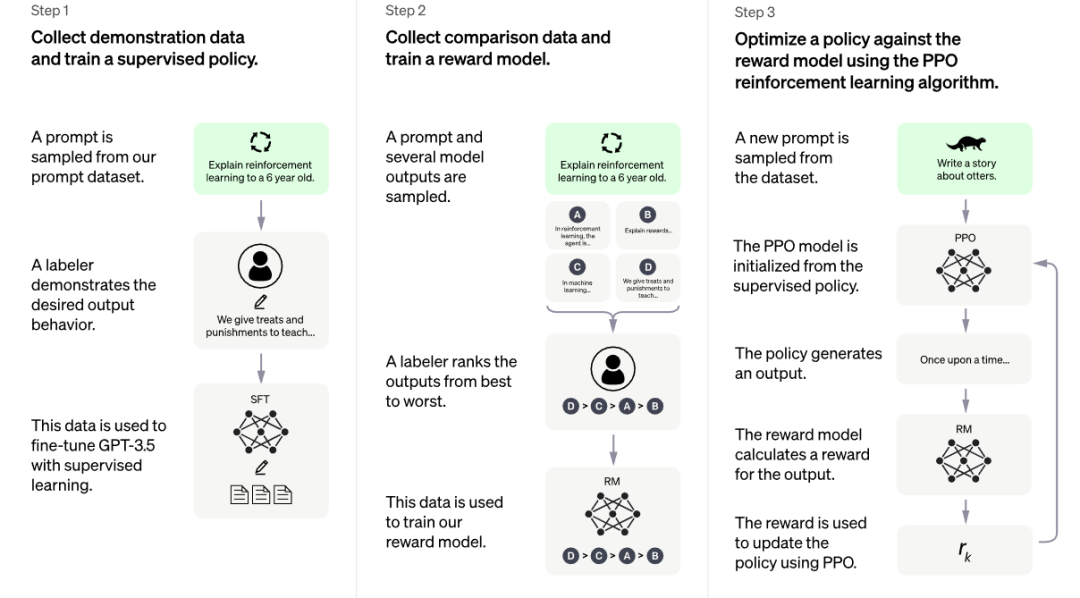

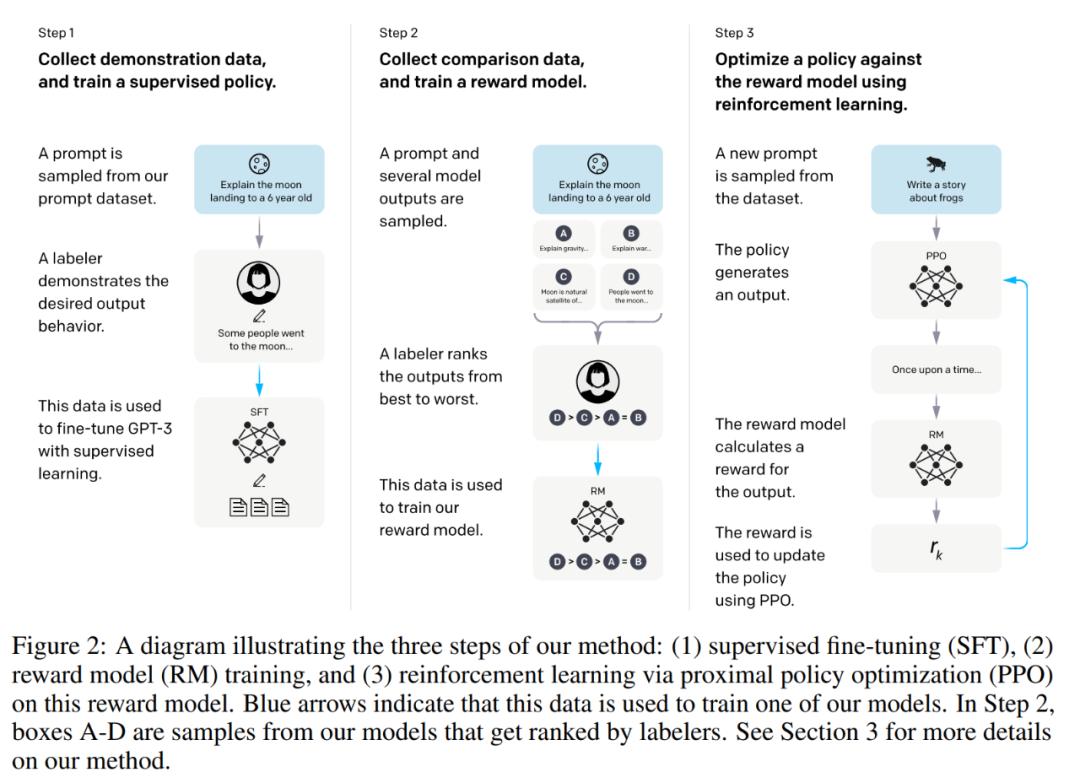

看過 ChatGPT 博客的同學都知道,它的技術原理基本用一張圖就能概括,這也是 InstructGPT 論文中就已經出現的一張圖(二者有細微差別)。在解讀論文的摘要和引言部分時,李沐詳細介紹了圖上的三個步驟。

ChatGPT 博客中的技術原理圖。

InstructGPT 論文中的技術原理圖。

在論文的第三章,InstructGPT 的作者首先介紹了他們的數據獲取方法和過程,李沐也帶著大家詳細讀了一下。這部分在工程方面非常有價值。正如李沐所說,如果你之前沒有做過這樣的事情(數據標注等),需要找人幫你標數據,那么你可以看它的附錄部分,里面有很多模板可以直接拿來用,論文作者甚至描述了他們標注網站的 UI 長什么樣,非常值得借鑒。

接下來,李沐重點解讀了第三章寫到的 3 個模型(見 3.5 Models )——SFT (Supervised fine-tuning) 模型、RM (Reward modeling) 模型和 RL (Reinforcement learning) 模型,包括這些模型涉及的參數和目標函數等細節。

最后,李沐總結說,從技術上來講,InstructGPT 還是一個非常實用的技術。它告訴了大家一個方法:給定一個大型語言模型,你怎樣通過一些標注數據迅速地提升它在某一個你關心的領域中的性能,使它達到實用的程度。所以,它給想用生成模型做產品的人提供了一個可操作的思路。

當然,正如李沐博士所說,科研工作是循序漸進的,InstructGPT 也是建立在之前研究的基礎上,所以想要吃透 ChatGPT 的同學不免還要回頭去讀更多論文。在之前的課程中,李沐也詳細解讀過 GPT、GPT-2、GPT-3 的論文:

課程地址:https://jmq.xet.tech/s/2lec6b