字體控狂喜!Liblib AI 黑科技 RepText:無需理解文字,AI就能 1:1 復刻多國語言視覺效果

Liblib AI提出了 RepText,可以使預訓練的單語文本轉圖像生成模型能夠以用戶指定的字體準確渲染,或者更準確地說,復制多語種視覺文本,而無需真正理解這些字體。這樣不管是中文、日文、韓文還是其他語言都可以精準的生成!從某種意義上說也算是打破了AI圖文生成語言的壁壘!

相關鏈接

- 文章:https://arxiv.org/abs/2504.19724

- 主頁:https://reptext.github.io/

- 代碼:https://github.com/Shakker-Labs/RepText

- 試用:https://huggingface.co/spaces/Shakker-Labs/RepText

論文介紹

盡管當代的文本到圖像生成模型在生成視覺吸引力方面取得了顯著突破,但它們生成精確靈活的排版元素(尤其是非拉丁字母)的能力仍然受到限制。這種固有限制主要源于文本編碼器無法有效處理多語言輸入或訓練集中多語言數據分布的偏差。為了滿足特定語言需求的文本渲染,一些研究采用專用文本編碼器或多語言大型語言模型來替換現有的單語言編碼器,并從頭開始重新訓練模型,以增強基礎模型的原生渲染能力,但這不可避免地會造成高資源消耗。其他研究通常利用輔助模塊對文本和字形進行編碼,同時保持基礎模型的完整性以實現可控的渲染。然而,現有研究大多基于 UNet 模型構建,而非近期基于 DiT 模型(SD3.5、FLUX),這限制了它們的整體生成質量。

盡管當代的文本到圖像生成模型在生成視覺吸引力方面取得了顯著突破,但它們生成精確靈活的排版元素(尤其是非拉丁字母)的能力仍然受到限制。這種固有限制主要源于文本編碼器無法有效處理多語言輸入或訓練集中多語言數據分布的偏差。為了滿足特定語言需求的文本渲染,一些研究采用專用文本編碼器或多語言大型語言模型來替換現有的單語言編碼器,并從頭開始重新訓練模型,以增強基礎模型的原生渲染能力,但這不可避免地會造成高資源消耗。其他研究通常利用輔助模塊對文本和字形進行編碼,同時保持基礎模型的完整性以實現可控的渲染。然而,現有研究大多基于 UNet 模型構建,而非近期基于 DiT 模型(SD3.5、FLUX),這限制了它們的整體生成質量。

為了解決這些限制,論文從一個樸素的假設出發,即文本理解只是文本渲染的充分條件,而非必要條件。基于此提出了 RepText,旨在賦能預訓練的單語文本轉圖像生成模型,使其能夠以用戶指定的字體精準渲染(更準確地說,是復制)多語種視覺文本,而無需真正理解這些字體。具體而言,作者借鑒了 ControlNet 的設置,并額外集成了語言無關的字形和渲染文本位置,從而能夠生成協調一致的視覺文本,允許用戶根據自身需求自定義文本內容、字體和位置。

為了提高準確率,RepText結合了文本感知損失和擴散損失。此外,為了穩定渲染過程,在推理階段直接使用帶噪聲的字形潛在向量進行初始化,而非隨機初始化,并采用區域掩碼將特征注入限制在文本區域,以避免其他區域的失真。大量的實驗驗證 RepText 相對于現有方法的有效性。

方法

RepText 旨在通過復制字形來實現基于最新單語基礎模型的文本渲染。并未使用額外的圖像或文本編碼器來理解單詞,而是通過使用以 Canny 和位置圖像為條件的文本控制網絡 (ControlNet) 來訓練模型復制字形。此外,作者創新性地在初始化過程中引入了字形潛在復制,以提高文本準確性并支持色彩控制。最后采用區域遮罩方案來確保良好的生成質量并防止背景區域受到干擾。論文的貢獻主要有三方面:

- 提出了 RepText,一個用于可控多語言可視化文本渲染的有效框架。

- 創新性地引入了字形潛在復制,以提高排版準確性并實現色彩控制。此外還采用了區域遮罩,以獲得良好的視覺保真度且不受背景干擾。

- 定性實驗表明,提出的方法優于現有的開源方法,并取得了與原生多語言閉源模型相當的結果。

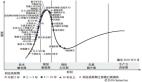

RepText 的推理框架及其突出策略:(1)從無噪聲字形潛在特征進行復制,提高文本準確率并實現色彩控制。(2)對文本區域采用區域遮罩,避免非文本區域的干擾,確保整體質量。

與之前方法比較

與其他作品的兼容性