OpenAI 和谷歌 DeepMind已風險重重,13位硅谷AI大廠員工聯名上信:我們需要對前沿AI發出警告的權利! 原創

出品 | 51CTO技術棧(微信號:blog51cto)

忍無可忍!

面對AI技術發展的各種風險隱患,這些前沿AI企業的一線員工再也不堪忍受任人捂嘴的現狀了!

他們想要掙脫保密協議和公司報復的重重風險,獲得對公眾發出警告的權利。

昨日,13名來自OpenAI和Google DeepMind的現任及前員工上了聯名信。內容直指對AGI和人類對齊失敗的擔憂,他們呼吁“獲得權利,去分享OpenAI、 DeepMind及其他前沿公司正在構建的技術可能帶來的“嚴重風險”,并且能獲得必要的保護避免因為言論而遭受報復。”

圖片

圖片

公開信地址:https://righttowarn.ai/

AI圈員工苦捂嘴久矣!

這篇公開信也得到了AI大佬Jan Leike的轉發。此前他高調出走OpenAI,并開懟公司風氣,表示這幾年早已“忽視安全準則,將快速推出“吸引眼球”的產品作為最重要的事情”。

圖片

圖片

員工對于企業報復的擔憂并非空穴來風,出于良心和責任的發聲可能代價高昂!此前,Ilya的兩位親密盟友 Leopold Aschenbrenner 和 Pavel Izmailov就曾因“泄密”而被OpenAI解雇。

根據Leopold的自述,所謂的泄密只是他寫了一份有關通往AGI之路上所需的準備、安全性及安全措施的頭腦風暴文件,并與三位外部研究人員分享了這份文件以獲取反饋,并且文件在發出前已經經過嚴格的脫敏。

不久前,Ilya的離職,讓大眾再次關注到AI對齊團隊和相應的安全問題,OpenAI的“不貶低協議”也讓輿論一片嘩然。該協議規定,任何員工離職后不可以公開說OpenAI的“壞話”,否則就有丟失天價股權的風險。

但沉默可能給人類帶來更加難以預測的危險。正如公開信中所說“只要沒有有效的政府監管這些(AI)公司,現任和前員工就是少數能夠督促他們對公眾負責的人。”

廣泛的保密協議猶如一圈圈繩索,困住了這些想要表達擔憂的員工。在此情況下,他們可以表達觀點的對象似乎只剩下制造這些隱患的公司本身。

因此,這篇聯文語氣沉重地警告大家,如果沒有適當的監管,AI系統有足夠的能力造成嚴重的傷害。信中寫道:“這些風險包括從進一步加深現有的不平等,到操縱及偽造信息,到失去對AI系統的控制,甚至可能導致人類滅絕”!

一、公開信:不簽協議、匿名發聲、支持批評、反對報復

公開信提到,OpenAI等人工智能公司有強烈的財務動機避免有效的監督,僅憑這些公司的“自律”分享相關的風險信息幾乎是“天方夜譚”。

因此,爭取員工的警告權是必要的。他們在信的主體內容中提出了“警告權”的四條原則:

公司不會簽訂或執行任何禁止因與風險相關的擔憂而“詆毀”或批評公司的協議,也不會因與風險相關的批評而報復,阻礙任何既得經濟利益;

- 公司將為現任和前員工提供一個可驗證的匿名程序,可以向公司董事會、監管機構和具有相關專業知識的相關獨立組織提出與風險相關的擔憂;

- 公司將支持開放批評的文化,并允許其現任和前員工向公眾、公司董事會、監管機構或具有相關專業知識的相關獨立組織提出與其技術相關的與風險相關的擔憂,只要適當保護公司商業機密和其他知識產權利益;

- 公司不會報復那些現任和前員工,當其他發聲渠道失靈時,他們應該被允許公開分享與風險相關的機密信息。我們同意,公開表達對AI風險的擔憂時應該避免發布不必要的機密信息。因此,一旦存在一個適當的程序,允許匿名向公司董事會、監管機構和具有相關專業知識的相關獨立組織提出擔憂,我們接受應該通過這樣的程序匿名提出擔憂。然而,只要這樣的程序不存在,現任和前員工應該保留向公眾報告他們擔憂的自由。

圖片

圖片

OpenAI在給媒體的回應中表示,公司為其“提供最有能力和最安全的AI系統并相信我們科學的方法來處理風險”的記錄感到自豪。發言人補充說:“我們同意,鑒于這項技術的重要性,進行嚴格的辯論至關重要,我們將繼續與政府、民間社會和世界各地的其他社區進行交流。”

二、13人聯名“上書”,7人實名警告

為“A Right to Warn about Advanced Artificial Intelligence”聯名寫信的13名員工中,有11位來自OpenAI,其中有7位前員工和4位現任員工。其他兩位為谷歌DeepMind的現員工和前員工各一人。

在13中,共有7位勇士實名寫信,他們對AI安全的責任感和對公眾福祉的追求讓人動容。

1.Jacob Hilton,formerly OpenAI

Jacob Hilton是OpenAI的前研究員,他曾承擔了各種強化學習相關課題的研究,例如語言模型(ChatGPT、WebGPT 和 TruthfulQA)的真實性、RL 的縮放規律和過度優化等項目。

周二簽署這封信后,他在X上分享了自己的經歷,一年多前,當他離開OpenAI時,他就曾簽署過那份臭名昭著的“非貶損協議”。當時,為了自身的利益,他簽署了這一規定,并按照要求對協議本身保密。

圖片

圖片

他肯定了奧特曼將該協議取消的規定,但他提到“員工可能仍然擔心披露的其他形式的報復,例如被解雇并因損害而被起訴。”

圖片

圖片

離開OpenAI后,他加入了對齊研究中心(ARC),繼續關注AI安全工作。對齊研究中心是一家非營利性研究機構,其使命是使未來的機器學習系統與人類利益相一致。

2.Daniel Kokotajlo,formerly OpenAI

Daniel Kokotajlo是 OpenAI 的前工程師。和其他人不同,Daniel是一位哲學博士,加入OpenAI之前曾在AI Impacts,以及Center on Long-Term Risk(長期風險中心)工作。這就不難理解他所持有的立場。

長期以來,Daniel對壓制研究人員的聲音以及開發 AGI 的潛在風險表示擔憂。因此,他冒著在 60 天內失去既得股權的風險,毅然決然地拒絕了在非貶損條款上簽字。

圖片

圖片

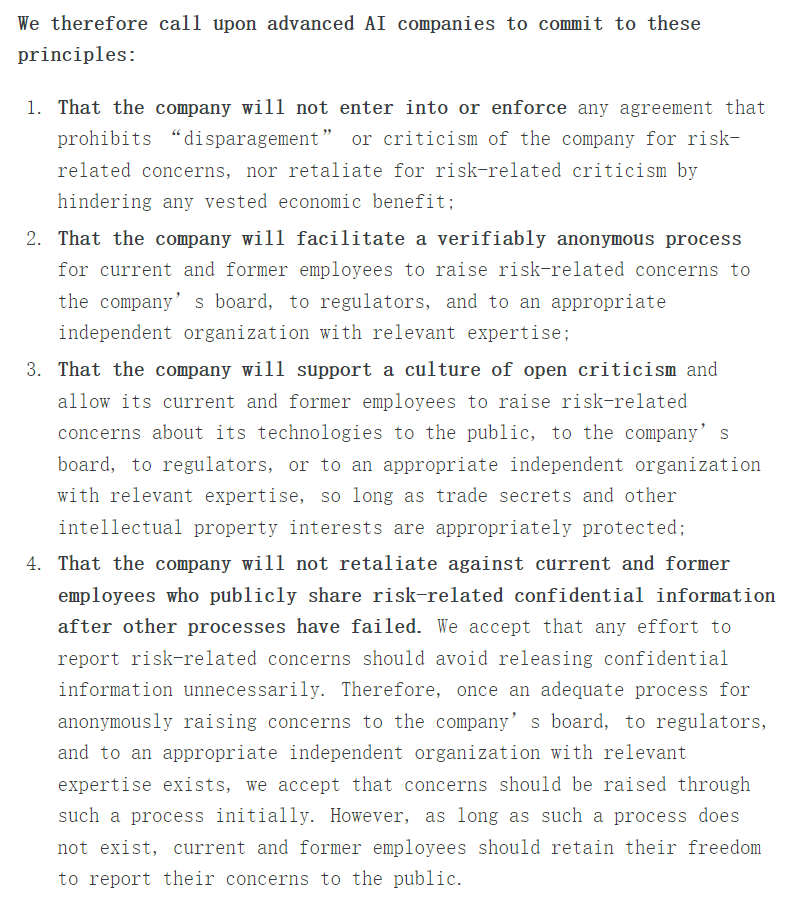

3.Ramana Kumar,formerly Google DeepMind

拉馬納-庫馬爾(Ramana Kumar)是一名高級研究員,曾在谷歌 DeepMind 工作。他因在人工智能安全、形式驗證和交互式定理證明方面的貢獻而聞名。

今年3月,他剛發表了名為《評估前沿模型的危險能力》的論文。

圖片

圖片

4.Neel Nanda,currently Google DeepMind, formerly Anthropic

尼爾-南達(Neel Nanda)是實名上信的唯一一位在職員工,目前是倫敦谷歌 DeepMind 的研究工程師,在機制可解釋性團隊工作。在此之前,他擁有多段學術研究經歷,他曾作為技術人員在克里斯-奧拉(Chris Olah)領導下研究語言模型的可解釋性。

圖片

圖片

5.William Saunders,formerly OpenAI

威廉-桑德斯(William Saunders)是 OpenAI 的前安全研究員,也是超級對齊團隊的元老級人物,于 2024 年 2 月辭職。

他加入2021年加入Alignment 團隊時,該團隊還沒被命名為“超級對齊”。根據他的領英主頁,William主要從事可擴展的監督工作,是開發批評技術的團隊成員之一,該技術用于使用語言模型發現其他語言模型中的錯誤。

之后,他被提升為管理一個 4 人團隊的負責人,該團隊致力于理解語言模型在上下文中的特征,最終發布了開源的 "transformer 調試器 "工具。

圖片

圖片

6.Carroll Wainwright,formerly OpenAI

Carroll在OpenAI工作了近三年之久。

從領英主頁發現,他一直有份“副業”,即 Metaculus 公司的聯合創始人。該公司是一個以公共利益為導向的組織,提供一個預測技術,它能以最佳方式匯總對未來事件的定量預測,其使命是“建設認識論基礎設施,使全球社會能夠模擬、理解、預測和駕馭世界上最重要、最復雜的挑戰。”

圖片

圖片

7.Daniel Ziegler,formerly OpenAI

丹尼爾-齊格勒(Daniel Ziegler)是 OpenAI 的前工程師,曾于 2018 年至 2021 年在 OpenAI 工作。離開OpenAI后,Daniel繼續進行人工智能對齊的研究工作,領導 Redwood Research 的對抗訓練團隊。

他也是一位長期關注公共利益的人,在學生期間,我參與創立了麻省理工學院的有效利他主義(Effective Altruism)組織,并在 2017 年畢業前運營了一年。

圖片

圖片

三、風險重重:2027或實現AGI,但人類還沒準備好

在信中參與聯名的Daniel Kokotajlo表示,他擔心AI公司及整個社會是否準備好了迎接AGI,這是AI的一種假設版本——即AI可以在許多任務上超越人類。Kokotajlo表示,他認為到2027年達到AGI的可能性為50%。

Kokotajlo說:“沒有什么真正阻止公司構建AGI并將其用于各種事情,而且透明度不高。”他冒著放棄股權的風險,未在不詆毀協議上簽字。“我辭職是因為我覺得我們還沒有準備好。我們作為一個公司沒有準備好,我們作為一個社會對這個問題沒有準備好,我們需要真正投入更多的準備和思考其含義。”

這封聯名信是否可以作為一個支點,撬動OpenAI這樣的龐然大物?

Ilya的盟友、因為“泄密事件”被解雇的Leopold,在前日發出165頁的系列長文,以論述AGI 戰略圖景。

圖片

圖片

完整PDF地址:https://situational-awareness.ai/wp-content/uploads/2024/06/situationalawareness.pdf

在扉頁他非常鄭重地寫到“獻給Ilya”,同時無不謹慎地說“盡管我曾經在OpenAI工作,但所有這些都是基于公開可獲得的信息、我自己的想法、一般領域的知識,或者是科幻小說的閑談。”

圖片

圖片

在長文中,Leopold提出了一種避免盲目樂觀和悲觀的“AGI現實主義”,其中有三個原則:

- 超級智能是國家安全問題。我們正在迅速建造比最聰明的人類還要聰明的機器……它將是人類有史以來建造的最強大的武器。

- 美國必須掌握AGI的領導權(編者注:本條為Leopold基于自身立場出發,僅作翻譯)。人工智能實驗室必須把國家利益放在首位。

- 我們可以不搞砸它。認識到超級智能的力量也意味著認識到它的危險。…… 隨著加速的加劇,我只希望討論變得更加尖銳。但我最大的希望是,那些能感受到AGI即將到來有多么重量的人,能將其視為莊嚴的職責召喚。?

本文轉載自??51CTO技術棧??,作者:伊風