亞馬遜、微軟、谷歌DeepMind 聯(lián)合團(tuán)隊(duì)的杰作,POLYMATH 引領(lǐng)MLLMs多模態(tài)推理新基準(zhǔn)

多模態(tài)大語言模型(MLLMs)的發(fā)展迅速,成為了人工智能研究的一個(gè)關(guān)鍵領(lǐng)域。這些模型不僅能夠處理文本,還能夠理解并生成視覺信息,使其在許多應(yīng)用中展現(xiàn)出卓越的潛力。盡管在某些領(lǐng)域取得了顯著進(jìn)展,但在復(fù)雜的視覺和數(shù)學(xué)推理任務(wù)上,MLLMs的表現(xiàn)仍有待提高。為此,來自亞馬遜、微軟、谷歌DeepMind 聯(lián)合研究團(tuán)隊(duì)開發(fā)了POLYMATH,這是一個(gè)具有挑戰(zhàn)性的基準(zhǔn),旨在系統(tǒng)地分析和評估這些模型在視覺復(fù)雜場景下的數(shù)學(xué)推理能力。通過5000個(gè)多模態(tài)推理問題,涵蓋10個(gè)不同類別,POLYMATH為MLLMs的認(rèn)知能力提供了全面的測試平臺(tái)。

此次研究由一支由各領(lǐng)域?qū)<医M成的團(tuán)隊(duì)完成。核心團(tuán)隊(duì)成員包括Himanshu Gupta(亞利桑那州立大學(xué),現(xiàn)供職于亞馬遜)、Shreyas Verma(Asurion)、Ujjwala Anantheswaran(亞利桑那州立大學(xué),現(xiàn)供職于微軟)、Kevin Scaria(亞利桑那州立大學(xué),現(xiàn)供職于亞馬遜)、Mihir Parmar(亞利桑那州立大學(xué))、Swaroop Mishra(亞利桑那州立大學(xué),現(xiàn)供職于Google DeepMind)和Chitta Baral(亞利桑那州立大學(xué))。團(tuán)隊(duì)成員均在各自領(lǐng)域有著深厚的專業(yè)背景,確保了POLYMATH基準(zhǔn)的科學(xué)嚴(yán)謹(jǐn)性和技術(shù)先進(jìn)性。

該項(xiàng)目的代碼庫可以在GitHub上找到,地址為:https://github.com/kevinscaria/PolyMATH,數(shù)據(jù)集則托管在Hugging Face上,地址是:???https://huggingface.co/datasets/him1411/polymath??,為研究人員提供了便捷的訪問和使用途徑。

相關(guān)工作

MLLMs的核心優(yōu)勢在于其能夠同時(shí)處理文本和視覺信息,具備跨模態(tài)理解和生成能力。這些模型不僅在語言理解和生成上表現(xiàn)出色,還能夠處理復(fù)雜的視覺任務(wù),為多種應(yīng)用場景提供了解決方案。

多模態(tài)大語言模型的發(fā)展得益于大語言模型(LLMs)和大型視覺模型的進(jìn)步。近年來,OpenAI的GPT系列和Google的Gemini系列等模型在處理多模態(tài)任務(wù)上取得了顯著成就。例如,GPT-4V不僅能夠生成高質(zhì)量的文本,還能夠理解復(fù)雜的圖像內(nèi)容,展現(xiàn)了強(qiáng)大的視覺推理能力。這些模型通過結(jié)合自然語言處理(NLP)和計(jì)算機(jī)視覺(CV)技術(shù),能夠在教育、醫(yī)療、科學(xué)研究等多個(gè)領(lǐng)域中提供創(chuàng)新的解決方案。

在數(shù)學(xué)推理方面,MLLMs同樣展現(xiàn)了巨大的潛力。現(xiàn)有的研究表明,這些模型在解決幾何問題、圖表理解和數(shù)學(xué)運(yùn)算等任務(wù)中表現(xiàn)出色。盡管如此,MLLMs在處理涉及空間關(guān)系和抽象邏輯推理的復(fù)雜數(shù)學(xué)問題時(shí),仍存在一定的局限性。這是因?yàn)檫@些問題不僅需要模型具備良好的視覺理解能力,還需要其能夠進(jìn)行深層次的邏輯推理和認(rèn)知過程。

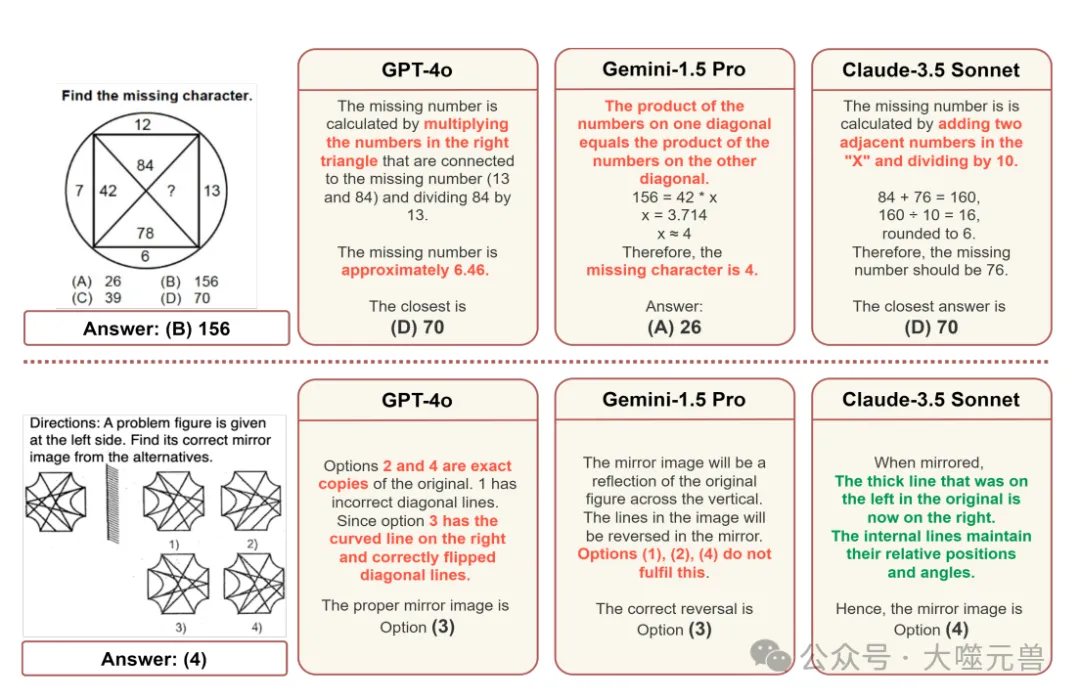

圖1:MLLM在面對涉及視覺信息的問題時(shí)所采用的推理模式示例。在第一行,模型無法感知相鄰半圓之間的關(guān)系;在最后一行,模型無法理解答案圖像中的細(xì)節(jié)。

在評價(jià)MLLMs性能的過程中,研究人員開發(fā)了多種基準(zhǔn)數(shù)據(jù)集,其中比較著名的包括GeoQA、VQA和UniGeo。這些基準(zhǔn)在推動(dòng)多模態(tài)模型的發(fā)展中起到了重要作用,但它們也存在一定的局限性。

GeoQA是一個(gè)專注于地理問題的問答數(shù)據(jù)集,主要評估模型在處理地理信息和地理推理任務(wù)上的能力。盡管GeoQA包含了一些復(fù)雜的地理問題,但其問題類型相對單一,未能全面覆蓋多種數(shù)學(xué)和視覺推理任務(wù)。

VQA(Visual Question Answering)則是一個(gè)視覺問答數(shù)據(jù)集,旨在評估模型在理解圖像內(nèi)容和回答相關(guān)問題方面的能力。VQA的數(shù)據(jù)集包含了大量的日常場景和常識(shí)性問題,雖然在一定程度上考察了模型的視覺理解能力,但其數(shù)學(xué)推理任務(wù)相對較少,未能充分評估模型在復(fù)雜數(shù)學(xué)問題上的表現(xiàn)。

UniGeo是一個(gè)專注于幾何問題的數(shù)據(jù)集,評估模型在處理幾何圖形和幾何推理任務(wù)上的能力。盡管UniGeo在幾何推理方面取得了一定的進(jìn)展,但其數(shù)據(jù)集規(guī)模較小,問題類型也較為有限,未能全面反映模型在多模態(tài)任務(wù)中的綜合能力。

為了解決現(xiàn)有基準(zhǔn)的局限性,研究團(tuán)隊(duì)提出了POLYMATH這一具有挑戰(zhàn)性的多模態(tài)數(shù)學(xué)推理基準(zhǔn)。POLYMATH旨在全面評估MLLMs在復(fù)雜視覺場景下的數(shù)學(xué)推理能力,其數(shù)據(jù)集包含了5000個(gè)高質(zhì)量的認(rèn)知文本和視覺挑戰(zhàn),涵蓋了圖案識(shí)別、空間推理等10個(gè)類別。通過多樣化的任務(wù)設(shè)置,POLYMATH能夠全面測試模型的認(rèn)知推理能力,特別是在處理復(fù)雜數(shù)學(xué)和視覺推理任務(wù)時(shí)的表現(xiàn)。

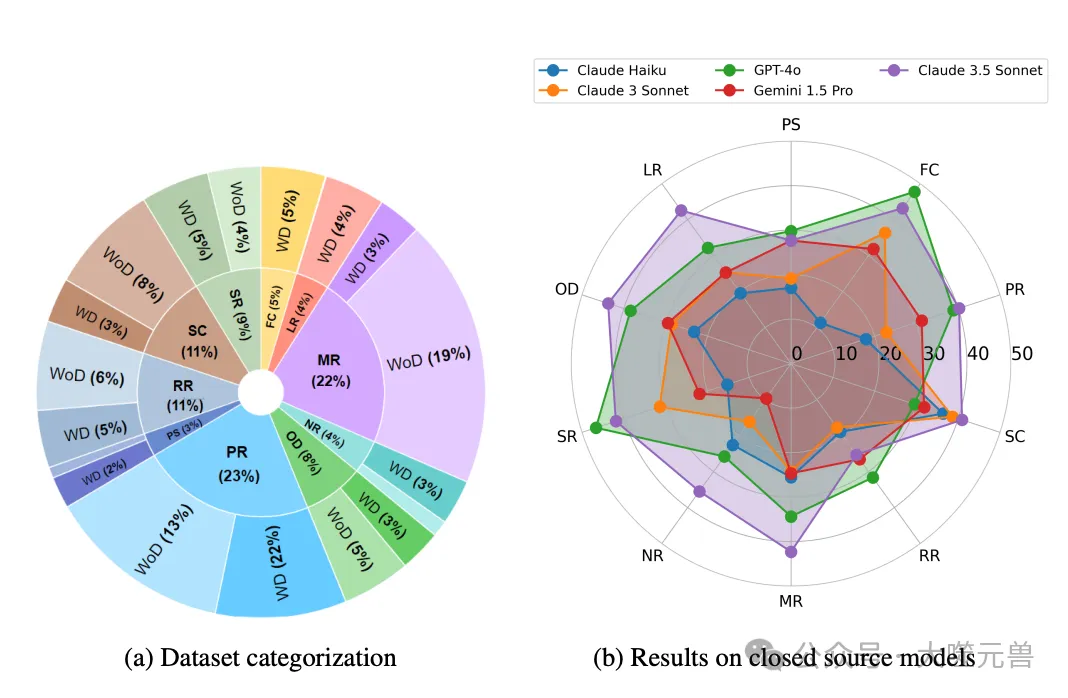

圖2:POLYMATH的分布和難度概述(a)顯示了數(shù)據(jù)集中5000個(gè)問題的類別劃分,以及該類別的有圖(WD)和無圖(WoD)劃分;(b) 比較各種MLLM的每類別性能。

POLYMATH不僅在數(shù)據(jù)規(guī)模上領(lǐng)先于現(xiàn)有基準(zhǔn),其任務(wù)設(shè)置也更加多樣化和復(fù)雜化,能夠全面評估模型在多模態(tài)任務(wù)中的綜合表現(xiàn)。研究團(tuán)隊(duì)通過嚴(yán)格的數(shù)據(jù)收集和質(zhì)量控制流程,確保了POLYMATH數(shù)據(jù)集的高質(zhì)量和高可信度。此外,研究團(tuán)隊(duì)還提供了詳細(xì)的文本描述和圖像內(nèi)容,以支持基于文本和視覺的雙重評估。

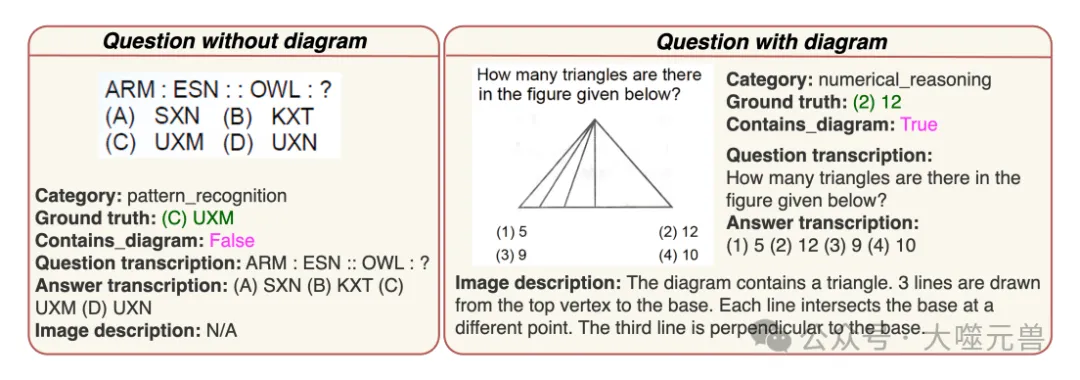

圖3:帶圖和不帶圖問題的示例。除了問題圖像外,POLYMATH還包括上面顯示的元數(shù)據(jù)。沒有圖表的問題不會(huì)出現(xiàn)在測試img中,而這兩種問題都會(huì)出現(xiàn)在testmini中。

POLYMATH數(shù)據(jù)集的整理

為了系統(tǒng)地評估多模態(tài)大語言模型(MLLMs)在復(fù)雜視覺場景下的數(shù)學(xué)推理能力,研究團(tuán)隊(duì)開發(fā)了POLYMATH這一具有挑戰(zhàn)性的基準(zhǔn)。該數(shù)據(jù)集的整理過程包括精細(xì)的數(shù)據(jù)收集流程、嚴(yán)格的質(zhì)量保證措施以及科學(xué)的分類架構(gòu),確保數(shù)據(jù)集的高質(zhì)量和多樣性。

數(shù)據(jù)收集是確保POLYMATH數(shù)據(jù)集高質(zhì)量的關(guān)鍵。研究團(tuán)隊(duì)采用了手動(dòng)和自動(dòng)化相結(jié)合的方式,經(jīng)過五個(gè)步驟來收集和整理數(shù)據(jù):

- 生成唯一標(biāo)識(shí)符:為每份試卷生成一個(gè)唯一標(biāo)識(shí)符(UUID),以便識(shí)別并整理從中收集到的所有問題。

- 手動(dòng)收集圖像片段:標(biāo)注人員手動(dòng)收集每個(gè)問題及其相關(guān)背景信息的圖像片段,包括可能適用于多個(gè)問題的分離片段。

- 圖像合并:使用圖像合并腳本自動(dòng)識(shí)別并合并被頁面分隔的問題圖像及其相關(guān)背景圖像,以保證完整性。

- 文本轉(zhuǎn)錄和元數(shù)據(jù)生成:使用大語言模型(LLM)轉(zhuǎn)錄問題及其標(biāo)準(zhǔn)答案,并生成包括類別、是否包含圖表、圖像描述等附加元數(shù)據(jù)。所有元數(shù)據(jù)都經(jīng)過人工檢查,確保質(zhì)量。

- 生成標(biāo)注文件:自動(dòng)創(chuàng)建并填充注釋文件,每行對應(yīng)一個(gè)問題,詳細(xì)記錄相關(guān)信息。

這一系統(tǒng)化的數(shù)據(jù)收集流程確保了POLYMATH數(shù)據(jù)集的高質(zhì)量和多樣性,為模型評估提供了堅(jiān)實(shí)基礎(chǔ)。

在數(shù)據(jù)收集和標(biāo)注過程后,研究團(tuán)隊(duì)進(jìn)行了全面的質(zhì)量檢查,以確保數(shù)據(jù)集的高質(zhì)量和可信度。

- 樣本篩選:剔除分辨率低、超出類別范圍或缺少關(guān)鍵信息的樣本。

- 視覺噪聲處理:去除帶有顯著水印或視覺噪聲的樣本,確保樣本清晰可讀。

- 答案校正:領(lǐng)域?qū)<覙?biāo)注員糾正提取錯(cuò)誤的標(biāo)準(zhǔn)答案。

- 類別驗(yàn)證:確保每個(gè)問題都屬于指定類別,糾正觀察到的分類錯(cuò)誤。

這些質(zhì)量保證措施確保了數(shù)據(jù)集的準(zhǔn)確性和一致性,使POLYMATH成為評估MLLMs性能的可靠工具。

為全面評估模型的多模態(tài)認(rèn)知推理能力,研究團(tuán)隊(duì)開發(fā)了一個(gè)分類架構(gòu),根據(jù)提供的信息和評估的推理技能對問題進(jìn)行分類。POLYMATH數(shù)據(jù)集包含以下10個(gè)類別,每個(gè)類別都有其定義和示例。

- 視角轉(zhuǎn)換(PS):給定一個(gè)圖形,要求解決者根據(jù)指示(如翻轉(zhuǎn)、鏡像、旋轉(zhuǎn)等)進(jìn)行變換。

- 圖形完成(FC):給定一個(gè)圖形,要求完成圖形并識(shí)別標(biāo)記位置的缺失元素。

- 圖案識(shí)別(PR):要求理解并復(fù)制一對一關(guān)系或圖案,例如根據(jù)a和b的關(guān)系,確定b和c的對應(yīng)關(guān)系。

- 序列完成(SC):給定一系列數(shù)字或圖形,要求找到系列中的下一個(gè)元素。

- 相對推理(RR):包含不同數(shù)據(jù)點(diǎn)及其相互關(guān)系,要求解決者推斷未明確提到的關(guān)系。

- 數(shù)學(xué)推理(MR):涉及數(shù)學(xué)計(jì)算,例如解方程。

- 數(shù)值推理(NR):涉及計(jì)數(shù)提到的元素?cái)?shù)量,元素可能是單一圖形的一部分或符合指定圖案。

- 空間推理(SR):要求解決者通過觀察進(jìn)行推理,以得出答案。

- 找出不同(OD):給定一組元素,要求識(shí)別與其他不同的元素。

- 邏輯推理(LR):涉及簡單的邏輯推理,例如蘊(yùn)涵和矛盾。

這一分類架構(gòu)不僅涵蓋了多種推理技能,還確保了數(shù)據(jù)集的多樣性和復(fù)雜性,使其能夠全面評估MLLMs在多模態(tài)任務(wù)中的表現(xiàn)。通過精細(xì)的數(shù)據(jù)收集流程、嚴(yán)格的質(zhì)量保證措施和科學(xué)的分類架構(gòu),POLYMATH數(shù)據(jù)集為評估和提升MLLMs的性能提供了重要工具。

實(shí)驗(yàn)設(shè)計(jì)

為了深入分析多模態(tài)大語言模型(MLLMs)在復(fù)雜視覺場景下的數(shù)學(xué)推理能力,研究團(tuán)隊(duì)在POLYMATH基準(zhǔn)上進(jìn)行了系統(tǒng)的實(shí)驗(yàn)設(shè)計(jì)。這一實(shí)驗(yàn)設(shè)計(jì)包含了評估模型的選擇、提示策略的應(yīng)用以及具體的實(shí)驗(yàn)方法和附加實(shí)驗(yàn)分析。

評估模型的選擇

在評估模型的選擇上,研究團(tuán)隊(duì)綜合考慮了閉源和開源MLLMs,旨在全面了解不同模型在多模態(tài)推理任務(wù)中的表現(xiàn)。閉源模型包括OpenAI的GPT-4o、OpenAI O1以及Anthropic的Claude-3.5 Sonnet和Gemini-1.5 Pro等。這些模型在處理多模態(tài)任務(wù)上表現(xiàn)出色,是當(dāng)前技術(shù)前沿的代表。閉源模型的選擇使得實(shí)驗(yàn)可以評估最先進(jìn)的商業(yè)化模型的性能。

與此同時(shí),研究團(tuán)隊(duì)也選擇了多種開源MLLMs,包括LLaVA(如LLaVA-v1.6-Mistral-7B、LLaVA-v1.6-Vicuna-13B)、G-LLaVA(如G-LLaVA-7B)以及ShareGPT4V等。這些模型提供了一個(gè)開放的研究平臺(tái),允許學(xué)術(shù)界和開發(fā)者進(jìn)一步研究和改進(jìn)多模態(tài)推理能力。通過評估開源模型,研究團(tuán)隊(duì)不僅可以比較閉源和開源模型的性能,還可以識(shí)別開源模型在具體任務(wù)中的優(yōu)勢和不足。

提示策略的應(yīng)用

提示策略在多模態(tài)推理任務(wù)中扮演著重要角色,研究團(tuán)隊(duì)采用了四種不同的提示策略,分別是零樣本推理、少量樣本推理、鏈?zhǔn)剿季S提示和退一步提示。這些策略旨在測試模型在不同信息量和提示方式下的表現(xiàn)。

- 零樣本推理:在沒有提供任何示例的情況下,直接對模型進(jìn)行評估。這種策略測試模型在完全陌生情況下的推理能力。

- 少量樣本推理:提供少量示例(如2個(gè))后進(jìn)行評估,測試模型在有少量上下文信息時(shí)的表現(xiàn)。

- 鏈?zhǔn)剿季S提示:使用鏈?zhǔn)剿季S提示(Chain-of-Thought),引導(dǎo)模型進(jìn)行逐步推理,幫助其在復(fù)雜任務(wù)中保持邏輯連貫性。

- 退一步提示:使用退一步提示(Step Back),鼓勵(lì)模型在解題過程中重新審視和評估其推理步驟,以提高準(zhǔn)確性和邏輯性。

通過這些提示策略,研究團(tuán)隊(duì)能夠深入分析模型在不同提示方式下的推理性能,揭示其在復(fù)雜任務(wù)中的潛在能力和不足。

附加實(shí)驗(yàn)分析

除了主要實(shí)驗(yàn)設(shè)置外,研究團(tuán)隊(duì)還進(jìn)行了三項(xiàng)附加實(shí)驗(yàn)分析,以進(jìn)一步驗(yàn)證和擴(kuò)展實(shí)驗(yàn)結(jié)果。

- test-img子集上的推理測試:test-img子集包含帶有圖表的問題,專注于評估模型的視覺理解能力。研究團(tuán)隊(duì)通過對這些問題進(jìn)行推理測試,評估模型在處理圖表信息時(shí)的表現(xiàn)。

- 無圖表問題的文本版本測試:將test-img子集中的圖表替換為詳細(xì)的文本描述,生成一個(gè)文本版本的test-img。通過對文本版本的測試,研究團(tuán)隊(duì)能夠分析模型在文本描述和圖表信息上的依賴程度和表現(xiàn)差異。

- OpenAI O1模型的無圖表問題評估:評估OpenAI O1模型在不包含圖表問題上的表現(xiàn),并與人類基準(zhǔn)進(jìn)行比較,以了解其在文本推理任務(wù)中的能力。

這些附加實(shí)驗(yàn)提供了進(jìn)一步的分析視角,有助于全面了解模型在不同場景下的性能和局限。

實(shí)驗(yàn)方法

實(shí)驗(yàn)方法包括嚴(yán)格的設(shè)置和詳細(xì)的操作步驟,以確保實(shí)驗(yàn)結(jié)果的可靠性和可重復(fù)性。具體方法包括:

- 實(shí)驗(yàn)數(shù)據(jù)集:使用POLYMATH基準(zhǔn)中的testmini子集,該子集包含1000個(gè)經(jīng)過嚴(yán)格篩選的問題,覆蓋了10個(gè)不同的推理類別。

- 提示策略實(shí)施:按照各提示策略的要求,對模型進(jìn)行提示和引導(dǎo),記錄其推理過程和結(jié)果。

- 結(jié)果評估:使用精確匹配進(jìn)行答案對比,記錄每個(gè)模型在不同提示策略下的準(zhǔn)確率和錯(cuò)誤類型。

通過這些實(shí)驗(yàn)方法,研究團(tuán)隊(duì)能夠系統(tǒng)地評估不同模型在多模態(tài)數(shù)學(xué)推理任務(wù)中的表現(xiàn),揭示其在復(fù)雜視覺場景下的推理能力和局限性。

結(jié)果分析

在這項(xiàng)研究中,研究團(tuán)隊(duì)通過系統(tǒng)的實(shí)驗(yàn),詳細(xì)評估了多種閉源和開源的多模態(tài)大語言模型(MLLMs)在POLYMATH基準(zhǔn)上的表現(xiàn)。通過比較模型在各類問題中的表現(xiàn),我們可以深入了解其在復(fù)雜推理任務(wù)中的能力和局限性。以下是實(shí)驗(yàn)結(jié)果的詳細(xì)分析。

閉源模型

在閉源模型的評估中,Claude-3.5 Sonnet和GPT-4o表現(xiàn)尤為突出。Claude-3.5 Sonnet在不同的提示策略下展現(xiàn)了強(qiáng)大的推理能力,特別是在Step Back提示策略中,準(zhǔn)確率達(dá)到了41.90%。這一策略鼓勵(lì)模型重新審視和評估其推理步驟,從而提高了準(zhǔn)確性和邏輯性。GPT-4o緊隨其后,尤其在零樣本推理和Step Back提示下表現(xiàn)優(yōu)異,顯示了其強(qiáng)大的適應(yīng)性和推理能力。

Gemini-1.5 Pro的表現(xiàn)相對中等,在所有類別中表現(xiàn)穩(wěn)定,但未能在任何特定領(lǐng)域中占據(jù)主導(dǎo)地位。相比之下,Claude Haiku作為最小的閉源MLLMs,表現(xiàn)普遍較差,未能在復(fù)雜推理任務(wù)中展現(xiàn)出足夠的能力。

開源模型

開源模型的評估結(jié)果顯示,LLaVA-v1.6-Mistral-7B在整體表現(xiàn)上名列前茅,總體得分為15.2%。特別是在找出不同(OD)、空間推理(SR)、相對推理(RR)和數(shù)學(xué)推理(MR)類別中表現(xiàn)突出。這表明LLaVA-v1.6-Mistral-7B在生成精確、一致且相關(guān)的響應(yīng)方面表現(xiàn)出色,即使在超出分布的數(shù)據(jù)樣本中也是如此。

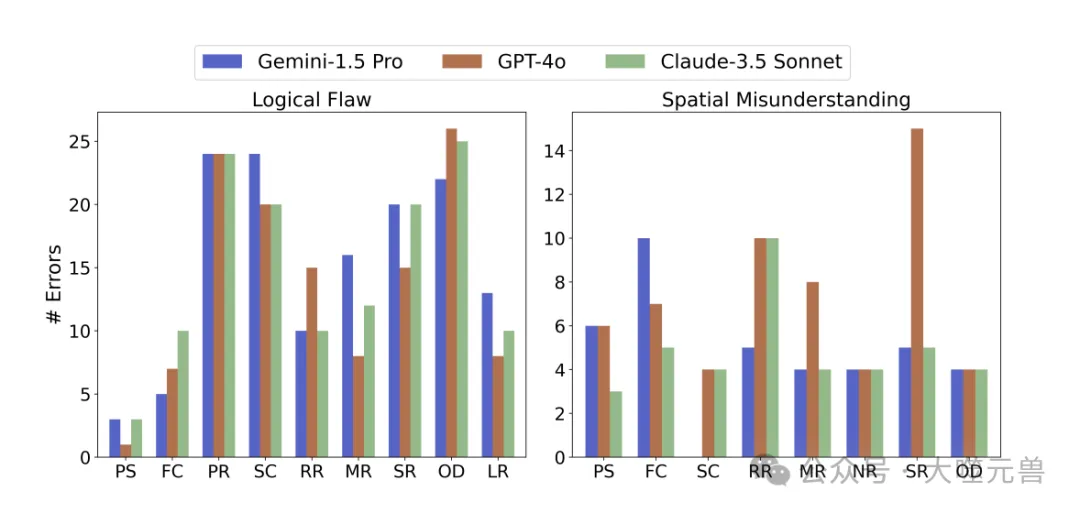

圖4:不同問題類別中邏輯缺陷(LF)和空間誤解(SM)錯(cuò)誤的頻率。我們報(bào)告每個(gè)模型的數(shù)據(jù),以便比較模型的能力。由于這些問題需要大量的邏輯跳躍和視覺推理,它們在OD、PR和SC類問題中最為普遍。

ShareGPT4V(13B)模型在PR、SC、RR、MR、SR和OD類別中的表現(xiàn)也非常優(yōu)異,總得分為12.8%。其他模型如LLaVA-v1.6-Vicuna-13B、LLaVA-1.5(13B)、G-LLaVA(13B)和LLaVA-v1.6(34B)在不同類別中表現(xiàn)各異,顯示出其在處理多樣推理任務(wù)時(shí)的個(gè)體優(yōu)勢和不足。

錯(cuò)誤類型分析

在分析錯(cuò)誤類型時(shí),研究團(tuán)隊(duì)識(shí)別出了七種常見錯(cuò)誤類型,并詳細(xì)分析了其分布。

- 邏輯缺陷(LF):推理步驟違反了既定的邏輯規(guī)則或現(xiàn)實(shí)世界的原則,如等式或基數(shù)。

- 空間誤解(SM):模型誤解了空間關(guān)系或錯(cuò)誤地讀取了給定圖像的特定細(xì)節(jié)。

- 記憶缺陷(MF):模型忘記了問題或解答過程中提供的信息。

- 計(jì)算錯(cuò)誤(CE):模型在數(shù)學(xué)計(jì)算中出錯(cuò),或在方程中代入了錯(cuò)誤的值。

- 誤對齊(MG):模型推理正確,但得出的答案錯(cuò)誤,如識(shí)別了模式但選擇了錯(cuò)誤的選項(xiàng)。

- 不完整(IC):模型生成的解決方案不完整,或輸出達(dá)到了令牌限制。

- 其他錯(cuò)誤:包括其他未分類的錯(cuò)誤。

研究團(tuán)隊(duì)通過對236個(gè)錯(cuò)誤樣本的手動(dòng)檢查,發(fā)現(xiàn)邏輯缺陷(LF)是最常見的錯(cuò)誤,接近60%的錯(cuò)誤樣本中出現(xiàn)。空間誤解(SM)位居第二,占約25%。這些錯(cuò)誤在找出不同(OD)、圖案識(shí)別(PR)和序列完成(SC)類別的問題中尤為常見,因?yàn)檫@些問題要求模型進(jìn)行不常見的邏輯跳躍和完全理解視覺信息,而這些正是模型的弱點(diǎn)所在。

此外研究還發(fā)現(xiàn),模型在推理過程中常常犯相同的錯(cuò)誤,例如假設(shè)某一模式在每行都適用,而正確的推理應(yīng)涉及跨列的模式復(fù)制。特別是在PR類別中,GPT-4o、Gemini-1.5 Pro和Claude-3.5 Sonnet在近80%的樣本中遵循了相同的錯(cuò)誤推理結(jié)構(gòu)。這表明盡管模型之間存在差異,但在實(shí)踐中它們展示了相同的優(yōu)勢和不足。

人類評估

為了確認(rèn)數(shù)據(jù)集的難度,研究團(tuán)隊(duì)邀請了六名研究生進(jìn)行人類評估。每位研究生被分配到一個(gè)特定的問題類別,以避免從同一類別的其他問題中獲得額外信息。他們只提供最終答案,沒有詳細(xì)的推理過程。

人類評估的結(jié)果顯示,盡管模型在某些類別中表現(xiàn)優(yōu)異,但與人類推理能力相比仍有顯著差距。特別是在處理復(fù)雜邏輯和空間推理任務(wù)時(shí),模型表現(xiàn)明顯遜色。這一結(jié)果為未來的研究提供了明確的方向,強(qiáng)調(diào)了開發(fā)能夠無縫結(jié)合數(shù)學(xué)推理和視覺理解的模型的必要性。

實(shí)驗(yàn)分析

在對多模態(tài)大語言模型(MLLMs)進(jìn)行系統(tǒng)評估的過程中,研究團(tuán)隊(duì)發(fā)現(xiàn)了它們在視覺推理方面的依賴性和常見錯(cuò)誤模式。以下是對模型依賴圖像描述而非圖像的表現(xiàn)差異分析,以及對模型常見錯(cuò)誤的深入探討。

模型依賴圖像描述而非圖像

通過對test-img子集的實(shí)驗(yàn)分析,研究團(tuán)隊(duì)發(fā)現(xiàn)大多數(shù)MLLMs在處理帶有圖表的問題時(shí)表現(xiàn)出明顯的局限性。具體而言,當(dāng)模型面對的是直接的圖像時(shí),其表現(xiàn)明顯不如面對詳細(xì)文本描述時(shí)的表現(xiàn)。為了驗(yàn)證這一發(fā)現(xiàn),研究團(tuán)隊(duì)將test-img子集中的圖表替換為詳細(xì)的文本描述,生成一個(gè)文本版本的test-img進(jìn)行測試。

結(jié)果顯示,所有模型在處理文本描述問題時(shí)的表現(xiàn)提升了約3-4%。這表明,盡管這些模型在處理文本數(shù)據(jù)時(shí)表現(xiàn)優(yōu)異,但在視覺推理任務(wù)中存在顯著的不足。特別是GPT-4o和Claude-3.5 Sonnet這兩個(gè)模型在文本描述中的表現(xiàn)提升尤為明顯。這種現(xiàn)象表明,當(dāng)前的MLLMs雖然在理解和生成文本方面已經(jīng)取得了顯著進(jìn)展,但在處理復(fù)雜的視覺信息時(shí),仍然依賴于能夠清晰描述圖像內(nèi)容的文本信息。

這一發(fā)現(xiàn)對未來的研究具有重要啟示:要進(jìn)一步提高M(jìn)LLMs在多模態(tài)任務(wù)中的表現(xiàn),需要增強(qiáng)其對視覺信息的理解和推理能力,減少對文本描述的依賴。

模型錯(cuò)誤的深入分析

在對模型錯(cuò)誤類型的分析中,研究團(tuán)隊(duì)識(shí)別出七種常見的錯(cuò)誤類型,其中邏輯缺陷(LF)和空間誤解(SM)最為常見。以下是對這些錯(cuò)誤類型及其對模型推理能力影響的深入探討。

邏輯缺陷(LF)

邏輯缺陷是模型在推理過程中違反既定的邏輯規(guī)則或現(xiàn)實(shí)世界的原則。例如,當(dāng)模型在解決數(shù)學(xué)問題時(shí),未能正確應(yīng)用等式或基數(shù)原則。研究發(fā)現(xiàn),邏輯缺陷在接近60%的錯(cuò)誤樣本中出現(xiàn),這一比例相當(dāng)高。特別是在圖案識(shí)別(PR)、序列完成(SC)和找出不同(OD)類別的問題中,邏輯缺陷尤為常見。這些問題通常要求模型進(jìn)行復(fù)雜的邏輯跳躍和模式識(shí)別,而模型在這方面表現(xiàn)出的不足導(dǎo)致了高頻率的邏輯錯(cuò)誤。

空間誤解(SM)

空間誤解是指模型在理解圖像的空間關(guān)系或特定細(xì)節(jié)時(shí)出現(xiàn)的錯(cuò)誤。例如,當(dāng)面對涉及空間布局和相對位置的問題時(shí),模型未能正確理解圖像中的空間信息。研究表明,空間誤解占約25%的錯(cuò)誤樣本,這一比例僅次于邏輯缺陷。特別是在涉及幾何圖形和空間推理的問題中,模型容易出現(xiàn)空間誤解。這種現(xiàn)象表明,盡管MLLMs在處理文本信息方面有一定的優(yōu)勢,但在處理需要深入理解空間關(guān)系的視覺信息時(shí),仍存在顯著的不足。

通過對邏輯缺陷和空間誤解的深入分析,我們可以看到當(dāng)前MLLMs在復(fù)雜推理任務(wù)中的局限性。為了解決這些問題,未來的研究需要專注于增強(qiáng)模型的邏輯推理能力和空間理解能力。例如,可以通過引入更多的空間推理任務(wù)和復(fù)雜邏輯推理問題來訓(xùn)練模型,從而提高其在這兩個(gè)方面的表現(xiàn)。

總結(jié)

通過深入探討模型在視覺推理方面的依賴情況和常見錯(cuò)誤模式,我們可以更好地理解當(dāng)前MLLMs在復(fù)雜推理任務(wù)中的表現(xiàn)和局限。盡管這些模型在文本描述方面表現(xiàn)優(yōu)異,但在處理復(fù)雜的視覺信息時(shí)仍存在顯著的不足。未來的研究需要專注于增強(qiáng)模型的視覺理解和邏輯推理能力,從而全面提升其在多模態(tài)任務(wù)中的表現(xiàn)。通過不斷改進(jìn)和優(yōu)化,MLLMs有望在更多應(yīng)用場景中展現(xiàn)出更加卓越的性能和能力。(END)

參考資料:https://arxiv.org/pdf/2410.14702