OpenAI首次公開前沿大模型安全:基礎架構、保護措施等

6月6日凌晨,OpenAI在官網公開了前沿大模型的安全策略,包括基礎架構、保護措施、敏感數據存儲、開發人員訪問管理等。

這也是OpenAI首次系統性的公布大模型開發安全方面的高級細節,讓外界深度了解其模型的開發流程,同時可為開發者在研究最新的前沿大模型提供技術借鑒。

下面「AIGC開放社區」就為大家解讀一下主要內容。

基礎研究架構

?

OpenAI的研究技術架構建立在微軟的Azure云服務之上,并通過Kubernetes(谷歌開源的容器平臺)進行輔助。

OpenAI的身份基礎基于 Azure Entra ID(前身為 Azure Active Directory)。

Azure Entra ID 與內部身份驗證和授權框架及控制集成。Azure Entra ID 可以對會話創建、身份驗證tokens的使用和異常登錄檢測進行基于風險的驗證。這些功能是對內部檢測工具的補充,有助于識別和阻止潛在安全威脅。

Kubernetes安全方法

?

OpenAI主要使用Kubernetes 來協調和管理基礎設施中的工作負載。研究工作負載受到 Kubernetes基于角色的訪問控制(RBAC)策略的保護,以遵守最小權限原則。

依靠現代技術為研究環境提供安全的網絡。網絡策略定義了工作負載與外部服務的通信方式。OpenAI會使用 "默認拒絕"策略,并明確允許列出授權的外部通信路徑,并廣泛使用專用鏈路網絡路由,以消除通往互聯網的必要路由,并縮短允許列表。

對于一些風險較高的任務,OpenAI會使用 gVisor(谷歌開源的沙箱環境)來解決,這是一種提供額外隔離的容器運行環境。這種深度防御方法可確保強大的安全性和工作負載的高效管理。

敏感數據保護策略

?

OpenAI使用密鑰管理服務來存儲和管理,研究基礎設施中的敏感數據,并使用基于角色的訪問控制來限制對數據的訪問,以便只有授權的工作負載和用戶才能檢索或修改它們。

所以,OpenAI建立了一項名為 AccessManager 的服務,作為管理內部授權和實現最小權限授權的可擴展機制。該服務將訪問管理決策聯合給由策略定義的審批者。這樣就能確保授權人員在適當的監督下做出訪問敏感資源(包括模型權重)的決定。

AccessManager策略可以定義為嚴格的或靈活的,根據相關資源進行定制。請求并被授予對敏感資源的訪問權限,例如,包含模型權重的研究環境中的存儲需要多方批準。

對于敏感數據,AccessManager 授權授予設置為在指定時間段后過期,這意味著如果訪問者不續訂,權限將降低到非特權狀態。

OpenAI還將GPT-4 集成到 AccessManager 中,用于最小權限角色的分配工作。用戶可以在AccessManager 中搜索資源,該服務將使用OpenAI的模型來建議可以授予該資源訪問權限的角色。將用戶連接到更具體的角色可以消除對廣泛、通用和過于寬松的角色的依賴。

模型權重保護

?

模型權重的保護非常重要,可以避免OpenAI很多未公布和重要的基礎模型出現泄漏的情況,主要使用了以下保護策略:

授權:對于包含敏感模型權重的研究存儲帳戶的訪問,需要多方批準、授權。

訪問:用于研究模型權重的存儲資源專用鏈接到 OpenAI 的環境中,以減少對互聯網的暴露,并需要通過 Azure云進行身份驗證和授權才能訪問。

出口控制:OpenAI的研究環境使用網絡控制,僅允許出口流量流向特定的預定義互聯網目標。流向不在允許列表中的主機的網絡流量將被拒絕。

模型審核與測試

?

OpenAI會通過內部和外部“安全紅隊”來模擬惡意使用方,并測試對研究環境的安全控制。目前,OpenAI已經與一家第三方的安全咨詢公司對其研究環境進行了滲透測試。

此外,OpenAI正在探索研究環境的合規制度,來保證大模型的權重安全等問題。OpenAI還在評估現有的安全標準以及專門用于保護AI技術的自定義控制措施。

OpenAI為什么頻繁公布大模型安全

?

其實,你要是經常看OpenAI的blog就能發現,最近幾個月除了發布新產品之外,關于AI模型安全的介紹與講解非常多。主要是因為OpenAI受到的安全壓力非常大。

上個月OpenAI的主要安全負責人Ilya Sutskever、Jan Leike相繼辭職,并且Jan還在社交平臺公開吐槽OpenAI不重視產品的安全,可能存在很大的潛在風險。

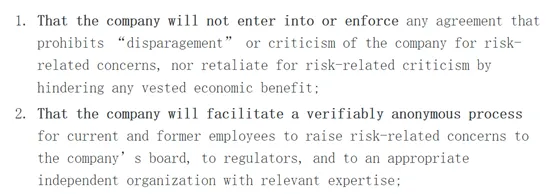

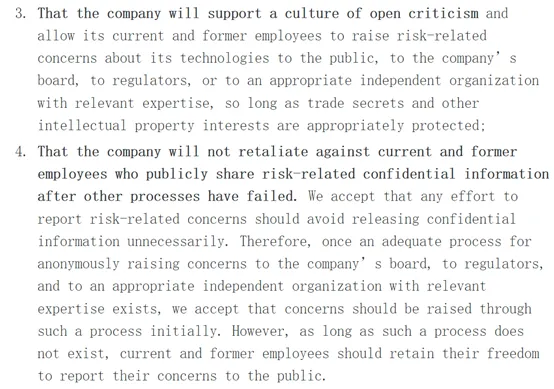

昨天,11名OpenAI現役和前員工發布了一封公開聯名信,主要警告前沿AI模型可能會帶來很大的風險。

例如,生成錯誤的內容、人為操控、不平等進一步加劇等,并且可能會出現失控的局面對社會造成巨大傷害。

他們希望通過這封聯名信,呼吁全球參與大模型的政府架構、大型企業、科研人員可以指定安全、可持續的監督條例和規則,防止人類在探索AGI(通用人工智能)的道路上發生不幸的意外。

他們呼吁先進的AI模型企業、學術機構應該遵循以下4項原則,「AIGC開放社區」會為大家做一個簡單直觀的解讀。

1、組織不會簽訂或執行任何禁止或批評AI模型相關問題的協議,也不會通過阻礙任何既得經濟利益對風險相關批評進行報復。

簡單來說,就是希望企業、政務機構支持監管條例,不要嫌棄、惡意對待提出監管條例的人。

2、公司將為在職員工和前員工向公司董事會、監管機構,以及具有相關專業知識的適當獨立組織提出與風險有關的疑慮提供可核實的匿名程序。

這個就是希望可以如實的向上匯報AI模型的進程和存在的風險,不要有瞞報的情況出現,例如,OpenAI就因為這個事情罷免過他們的CEO。

3、組織應該支持公開批評的文化,允許現任和前任員工向公眾、公司董事會、監管機構或具有相關專業知識的適當獨立組織,提出與其技術有關的風險問題,只要商業秘密和其他知識產權利益得到適當保護即可。

就是說如果AI模型確實存在風險,你應該允許員工在公開的社交平臺向大眾說明真實情況,而不是一味的隱瞞。OpenAI前幾天兩名非常重要的安全負責人離職了,其中一位在社交平臺吐槽OpenAI的安全監管很差,并且引發了離職協議等惡性事件。

反正就是,員工離職了應該有話語自由權不能遮遮掩掩的,有告知大眾真相的權利,但是涉及商業機密的事情不能說。

4、公司不會對AI項目失敗后,公開分享風險相關機密信息的現任和前任員工進行報復。當然,在報告項目風險時應該極力的避開商業機密。

因此,一旦有了向公司董事會、監管機構和具有相關專業知識的適當獨立組織匿名提出疑慮的適當程序,同意最初應通過此類程序提出疑慮。然而,只要這樣的程序還不存在,現任和前任員工就應保留向公眾報告其疑慮的自由。

簡單來說,員工向大眾報告了AI項目確實存在的風險,并且在說明的過程中避免了商業機密。公司是不能向爆料員工報復的,例如,之前的OpenAI的離職協議寫著,員工離職后不能吐槽其項目不然就拿不到股權等。

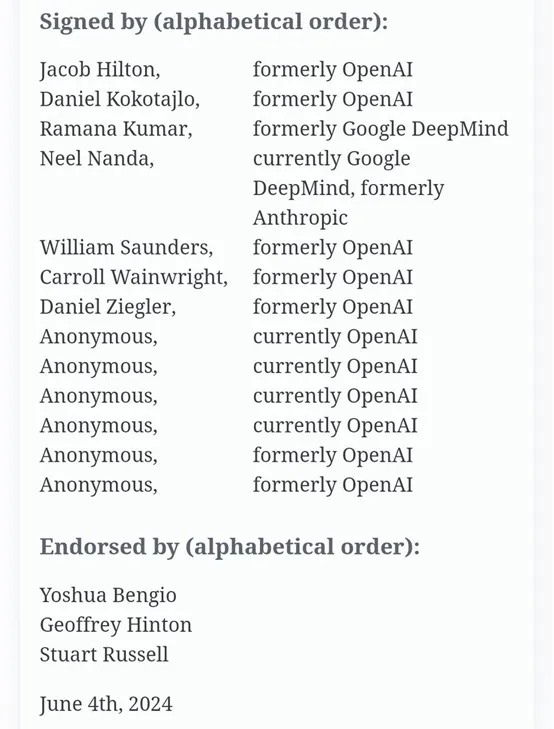

本次參與簽名的有Jacob Hilton、Daniel Kokotajlo等7名前OpenAI員工,還有4名現役員工沒有公開姓名,估計怕被OpenAI知道處罰他們。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區