ChatGPT等模型瘋狂訓練,最快2026年消耗盡公開文本數據 精華

AI發展科研機構Epochai在官網發布了一項,關于大模型消耗訓練數據的研究報告。

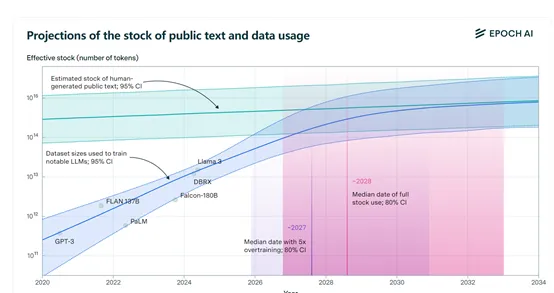

目前,人類公開的高質量文本訓練數據集大約有300萬億tokens。但隨著ChatGPT等模大型的參數、功能越來越強以及過度訓練,對訓練數據的需求呈指數級增長,預計將在2026年——2032年消耗完這些數據。

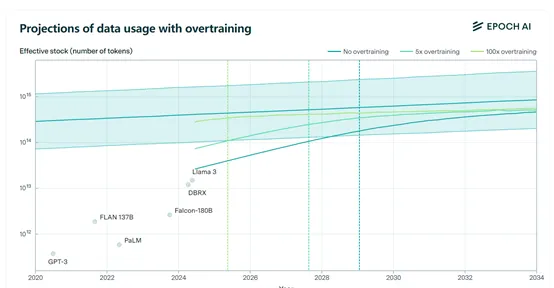

研究人員特別提到了“過度訓練”(Overtraining)是加速消耗訓練數據進程的主要原因之一。例如,Meta最新開源的Llama 3的8B版本過度訓練達到了驚人的100倍,如果其他模型都按照這個方法來訓練,數據可能在2025年就消耗盡了;70B版本還好,過度訓練只有10倍。

所以,無論是閉源還是開源大模型,已經進入比拼訓練數據的階段,誰的模型學習的數據更多、維度更廣,即便是小參數同樣可以戰勝大參數模型,尤其是在RAG、MoE、MTL等加持下效果更明顯。

什么是過度訓練

?

過度訓練是在深度學習領域,特別是在大模型的訓練過程中,開發者有意讓模型使用的訓練數據量超過計算最優模型所需的量。這種做法與傳統的機器學習中避免過擬合的目標不同。

過擬合發生在模型過于復雜或者訓練時間過長,以至于模型開始記憶訓練數據中的噪聲而非泛化到未見數據。但在大模型的過度訓練是一種優化策略,可以節省推理成本和效率,同時模型開始學習訓練數據中的噪音和細節,而不是潛在的數據分布。

這就像學生學習歷史一樣,如果只記住大量的日期和事件,而沒有理解它們之間的聯系和意義,在面對新的問題或需要綜合分析時,可能無法給出準確的邏輯答案。

此外,大模型過度訓練意味著參數量與訓練數據量的比例超過了Chinchilla縮放定律建議的最佳比例大約D/N比為20。

在Chinchilla縮放定律下,保持這個比例可以使得模型在固定的訓練計算預算下達到最低的可減少損失。不過開發者可能會選擇讓這個比例高于最優值,會讓模型使用更多的數據來訓練。

這樣做雖然會增加訓練階段的數據需求,但能夠減少模型在推理階段的算力成本。因為相對于昂貴GPU,訓練數據就便宜的多,尤其是在超大規模參數模型中的收益更明顯。

Meta最新開源的Llama 3系列模型是過度訓練的典型,GPT-3、Flan137B、Falcon-180B等模型也都存在這一現象。

如果保持在5——10倍的過度訓練量,訓練數據的消耗度還在可控范圍之內,如果在100倍以上,將呈指數級增長,而Llama 3的8B版本過度訓練就已經達到100倍。

公開訓練數據沒了,4種其他獲取方法

?

在大模型領域,訓練數據已經和AI算力一樣變得非常重要,是決定模型性能的關鍵元素之一。雖然可以再生,但消耗速度過快可能會蓋過生成速度出現無數據可用的局面。Epoch ai給出了以下4種獲取訓練數據的新方法。

1)合成數據:合成數據主要利用深度學習來模擬真實數據,來生成全新的數據。這種方法在數據短缺的情況下顯得尤為重要,因為提供了一種潛在的無限擴展數據集的方式。目前,很多科技巨頭已經在使用這個方法,不過也有很大的弊端。

合成數據的質量可能會比較差并出現過擬合行,這是因為在合成的過程中無法完全捕捉到真實數據的復雜性和多樣性。

例如,合成數據可能缺乏真實文本中的某些細微的語言特征,或者可能過于依賴模型訓練時使用的特定數據集,導致生成的文本缺乏多樣性。此外,合成數據可能會引入一些新的偏差,這些偏差可能會影響模型的性能。

2)多模態和跨領域數據學習:多模態學習是一種涉及多種數據類型的學習方法,它不僅限于文本,還包括圖像、視頻、音頻等多種形式的數據。通過結合不同模態的信息,可以更全面地理解和處理復雜的任務。

例如,GPT-4o、GPT-4V、Gemini等可以同時處理文本描述和相應的圖片,以更好地理解場景和語境。這也是目前多模態大模型的主要訓練數據方法之一。

此外,開發者也可以將目光投向其他領域,例如,金融市場數據、科學數據庫、基因數據庫等。根據預測,基因領域的數據增長每年保持在幾百萬億甚至上千萬億,可以產生源源不斷的真實數據。

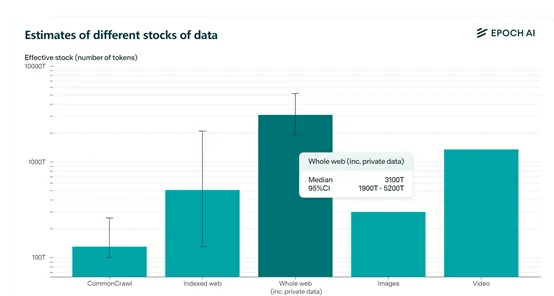

3)私有數據:根據Epoch ai調查數據顯示,目前全球文本數據包含私有總量大概在3100萬億tokens。而公開數據只有300萬億,也就是說還有90%的私有數據可以使用。

目前,已經有科技公司開始從這方面下手,例如,OpenAI成立了一個“數據聯盟”專門搜集高質量、沒公開過的私有數據,在訓練GPT系列和最新的前沿模型。

但使用私有數據很有難度,首先,隱私和安全性是最大的顧慮,非公共數據往往包含敏感信息,如果用于模型訓練,可能會引發隱私泄露的風險。例如,社交媒體上的私人對話、個人郵箱中的通信記錄,這些都是用戶不希望被公開的數據。

其次,獲取和整合非公共數據的過程可能非常復雜。與公共數據相比,非公共數據分散在不同的平臺和系統中,缺乏統一的標準和格式。這就需要開發新的技術和方法來收集、清洗和標準化這些數據,以便它們能夠被有效地用于大模型訓練

4)與真實世界實時交互學習:可以讓模型通過與真實世界的直接互動來學習和進步。與傳統的基于靜態數據集的訓練方法不同,這種學習方法強調的是大模型的自主性和適應性。在這種模式下,模型不僅僅是被動地接收數據,而是主動地探索環境,通過與人類交互來獲得知識和技能。

但這種方法對模型的架構、性能、算力要求較高,需要具備一定的自主性和決策能力。大模型需能夠準確理解用戶輸入的指令或問題,并根據這些指令在現實世界中采取行動。

例如,大模型可能需要根據用戶的請求來推薦餐廳,這不僅需要它理解用戶的偏好,還需要它能夠訪問和分析實時的餐廳信息。

此外,與真實世界互動的學習還需要模型具備處理不確定性的能力。現實世界是復雜多變的,充滿了不確定性和偶然性。

模型需要能夠適應這些不確定性,從不斷變化的環境中學習并做出合理的決策。這就涉及到概率推理、風險評估和決策制定等高級認知功能。

企業、開發者們珍惜訓練數據吧,就像我們珍惜水資源一樣。不要等著枯竭的那一天,望著荒漠干流淚。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區