港中文深圳提出ALLaVA-4V:百萬級別的開源多模態GPT-4V數據集

最近在大型視覺-語言模型(LVLMs)上的進展使得語言模型能夠處理多模態輸入,但這需要顯著的計算資源,特別是在端側設備上進行部署。本研究旨在通過采用高質量訓練數據,彌合傳統規模 LVLMs 與輕量版本之間的性能差距。

為此,我們利用 GPT-4V 構建了一個高質量的合成數據集,包含(1)具有詳細文本描述的圖文對;和(2)復雜的推理指令和詳細的答案。利用該訓練數據,我們訓練了一個輕量級的多模態模型 ALLaVA-3B,在同量級的 LVLMs 的 12 個 benchmark 中取得了有競爭力的性能。這項工作突出了采用高質量數據訓練性能優異的輕量級 LVLMs 中的可行性。

論文題目:ALLaVA: Harnessing GPT4V-synthesized Data for A Lite Vision-Language Model

論文鏈接:https://arxiv.org/abs/2402.11684

數據鏈接:https://huggingface.co/datasets/FreedomIntelligence/ALLaVA-4V

代碼鏈接:https://github.com/FreedomIntelligence/ALLaVA

Demo鏈接:https://allava.freedomai.cn/#/

一、研究背景

近幾個月來,大型視覺-語言模型(LVLMs)的發展迅速。這些模型能夠處理視覺和文本輸入,類似于人類在現實世界場景中處理信息的方式。一個 LVLM 通常由兩個關鍵組件組成,即視覺編碼器和大型語言模型(LLM)。

因此,LVLMs 不僅能夠執行傳統任務,如圖像標題生成和圖文檢索,還能夠遵循人類的指令執行復雜的視覺問答(VQA)任務,使它們成為通往人工通用智能(AGI)的一個里程碑。

盡管 LVLMs 展現出了卓越的能力,它們通常需要大量資源來進行訓練和部署。為了使 LVLMs 方便部署,一些工作致力于開發輕量級 LVLMs。盡管這些模型對于計算資源較少的用戶更加友好,但在某種程度上,它們伴隨著性能的損失,這表現在常規尺寸 LVLMs 與輕量級版本之間存在性能差距。

遵循“輸入決定輸出”原則,我們的方法從數據中心的角度重新評估多模態語言模型。在這個框架內,我們專注于兩個主要策略:“多模態對齊”和“視覺指令微調”。前者主要致力于幫助語言模型識別視覺對象并增強其視覺推理能力,后者著重于使 LVLMs 能夠跨更廣泛的指令泛化,特別是涉及視覺輸入的指令。

現有工作通常使用 caption 數據來在語言模型中對齊圖像和文本,但這些數據集由簡短和粗粒度的 caption 組成,引入噪聲信號并阻礙了視覺-語言對齊過程。此外,[1] 發現 COCO 圖像-文本對的跨模態關聯有限,這對在 COCO 基礎上合成高質量數據的有效性提出了質疑。因此,我們需要一個更合理和可擴展的方法來獲得高質量的caption數據。

與此同時,對齊數據的規模,尤其是高質量數據的規模,則相對有限。這在泛化到更廣泛的長尾視覺知識方面存在挑戰。擴大對齊數據的數量,特別是來自多樣化來源的數據,對于實現對長尾視覺知識的細致理解至關重要。

視覺指令微調數據同樣存在不足。當前的視覺指令調整數據集(如 Vision-FLAN,OCRVQA,TextVQA)更多地關注于提高基礎能力,而不是更高級的能力,如復雜推理。此外,盡管 Vision-FLAN 中的答案是由人工標注的,但它們通常由短語或短句組成,且沒有格式提示。直接學習這樣的輸出將阻礙模型性能,因此我們需要改善或重新生成指令的答案。

二、數據集生成

1. 圖像來源

我們為數據合成選擇了兩個圖像來源:Vision-FLAN(簡稱 VFLAN)和 LAION。我們選擇前者是因為這些圖像與近 200 個任務的多樣化指令相關聯。選擇后者是因為它來自“野生”互聯網的自然圖像,且圖像來源足夠多樣;此外,圖像來源也與終端用戶的實際用途保持一致。

- LAION 是一個流行的視覺-語言對齊數據集,因為它包含從網頁爬取的多樣化圖像。為了確保圖像質量,我們只下載短邊分辨率至少為 512 的圖像。

- Vision-FLAN 是一個整合了 101 個開源數據集中 191 個 VQA 任務的數據集。它包含了對提高 LVLMs 基礎能力和提升傳統 benchmark 表現至關重要的指令。

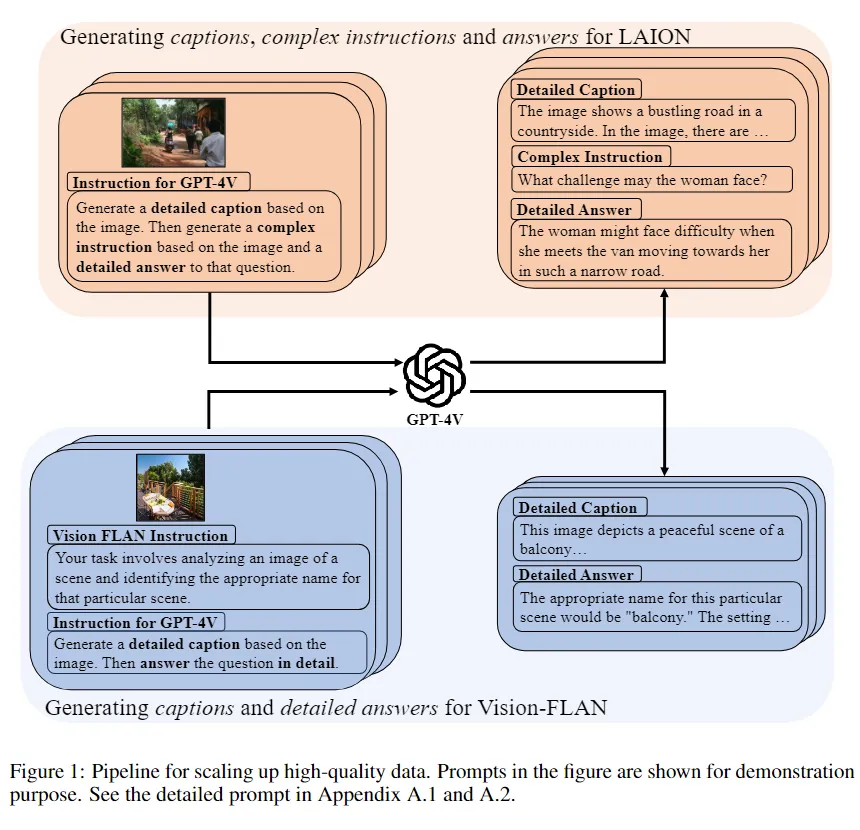

2. 使用“先標注后問答”方式進行數據合成

為了生成高質量的 caption 和視覺問答(VQA),我們提出在單個會話中為一張圖像生成一個 Caption 和一個問答對,詳見圖 1。具體來說,我們使用圖像提示 GPT-4V,要求它首先生成一個細粒度的 caption,然后是一個 VQA 對。通過這樣做,整個數據合成過程包括三個階段:描述、提問和回答。

- 描述:GPT-4V 需要生成盡可能詳細的圖片描述,用于視覺語言的模態對齊。

- 提問:GPT-4V 根據圖片生成復雜推理問題。

- 回答:GPT-4V 根據圖片、描述和問題生成詳細的答案。

為了避免潛在的倫理問題,我們 prompt 里提示 GPT-4V 拒絕為相關圖片生成圖片描述,同時避免生成帶有偏見的答案。

在 VQA 場景中,加入額外的圖片描述是有益的。補充的圖片描述可以被視為額外的上下文,有助于提高答案質量并減少幻覺現象。通過利用額外的信息,模型獲得對視覺和文本組件的全面理解,從而改善其提供準確和情境相關回應的能力。此外,由于提供了更多的上下文,它可能減輕幻覺問題。

3. 數據集卡片

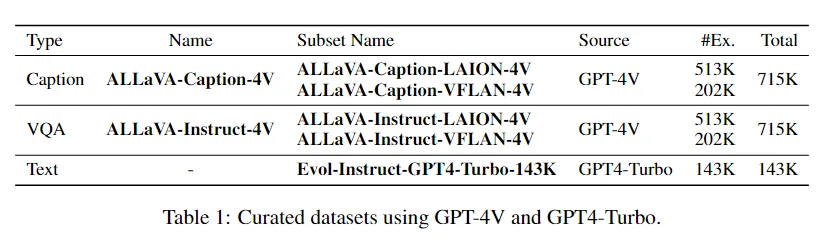

為了緩解模型的文本災難性遺忘問題,我們也使用 GPT-4-Turbo 重新生成了 WizardLM 指令數據集 [2] 的回答部分。

我們將 ALLaVA-4V 數據集的名稱、來源及樣本量匯總在表 1 中。圖片數量達 700K,總樣本量(包括文本數據)達 1.5M,是目前最大的用于 LVLM 訓練的開源高質量 GPT-4V 數據集。

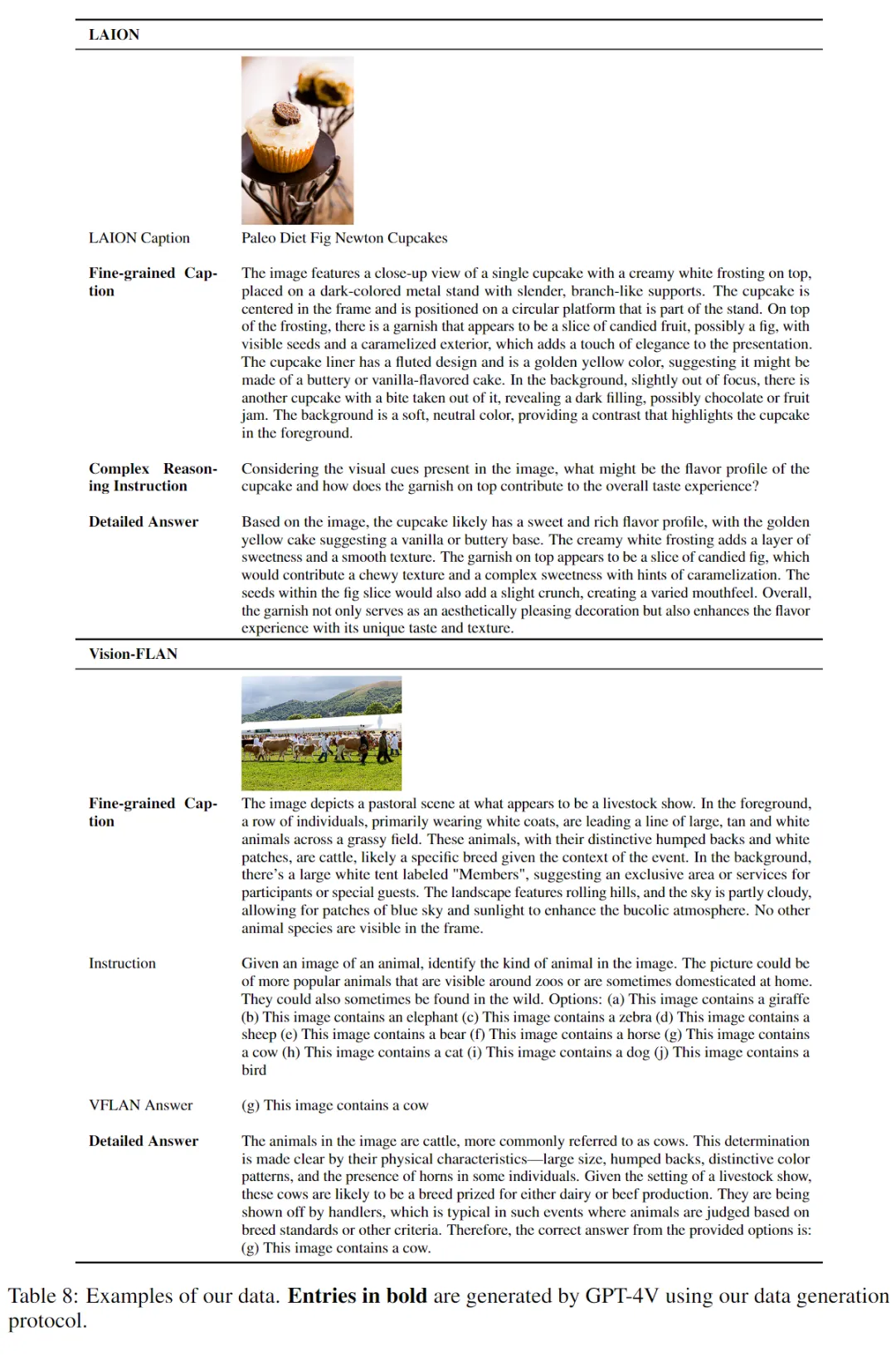

4. 數據集樣例

三、實驗

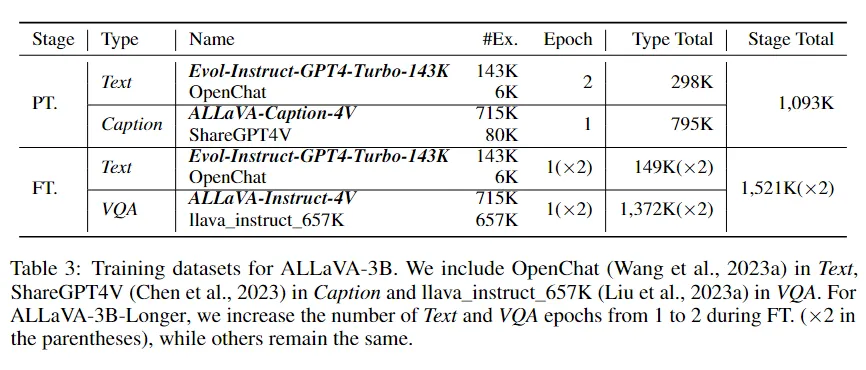

我們以 Phi-2 作為語言模型基座,采用兩階段訓練。如表 3 所示,預訓練階段,我們選用 Evol-Instruct-GPT4-Turbo-143K 和 OpenChat [3] 組成純文本數據,ALLaVA-Caption-4V 和 ShareGPT4V [4] 組成對齊數據;視覺語言指令微調階段,除了文本數據,我們用 ALLaVA-Instruct-4V 和 llava_instruct_657K [5] 組成指令數據。

我們推出兩個模型:ALLaVA-3B 和 ALLaVA-3B-Longer。兩個模型的區別僅在第二階段,后者比前者多訓練一個 epoch。

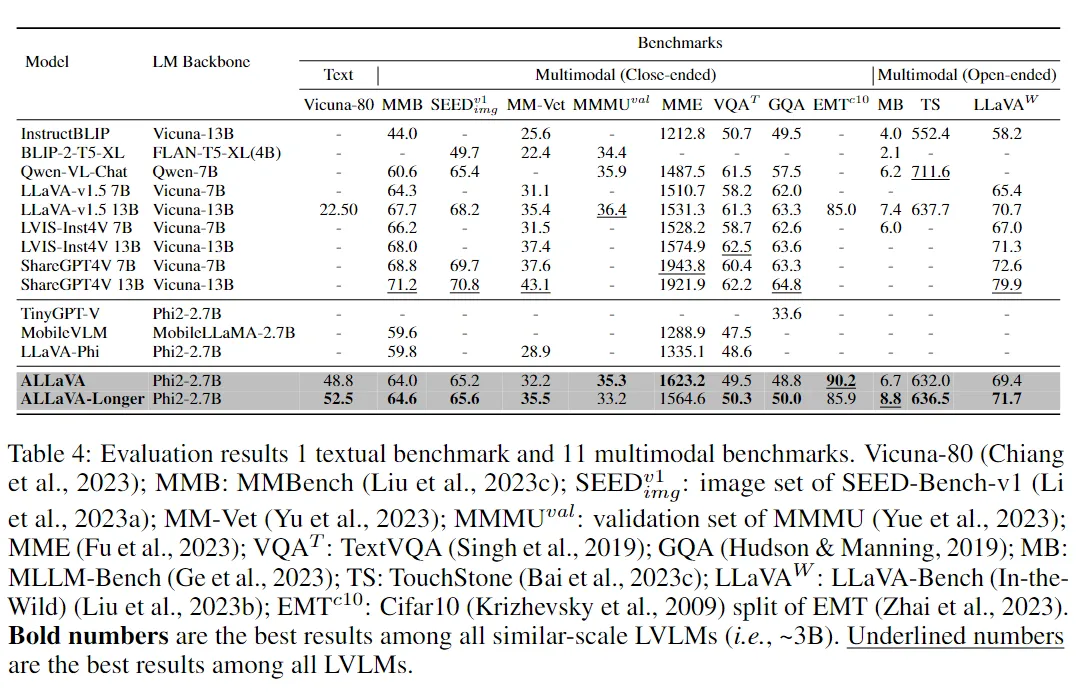

1. Benchmark結果

我們的模型展示了卓越的語言能力,在 Vicuna-80 上獲得了 52.5% 的勝率,超過了 LLaMA2-7B-Chat 提供的 anchor 答案。這個結果也大幅超過了 LLaVA-v1.5-13B,這表明我們文本數據的高質量以及從 base 模型構建 LVLM 的有效性。

對于多模態能力,我們根據答案的形式將我們的 benchmark 分為多項選擇或簡答(8 個 benchmark)和自由形式生成(3 個 benchmark)。

對于多項選擇或簡答 benchmark,ALLaVA-3B 在 MMB、SEEDBench、MM-Vet、MME 和 GQA 上大幅超過了同規模的 LVLMs。ALLaVA-3B-Longer 甚至在 MM-Vet、MME 和 EMT 上超過了 LLaVA-v1.5-13B,盡管其參數只有后者的 25%。

對于自由形式生成 benchmark,ALLaVA-3B-Longer 在用于探測復雜推理能力 MLLM-Bench上 實現了 8.8% 的 SOTA 勝率。它在 TouchStone 和 LLaVA(In-the-Wild)上的表現也與 LLaVA-v1.5-13B 相當。

2. 定性結果展示

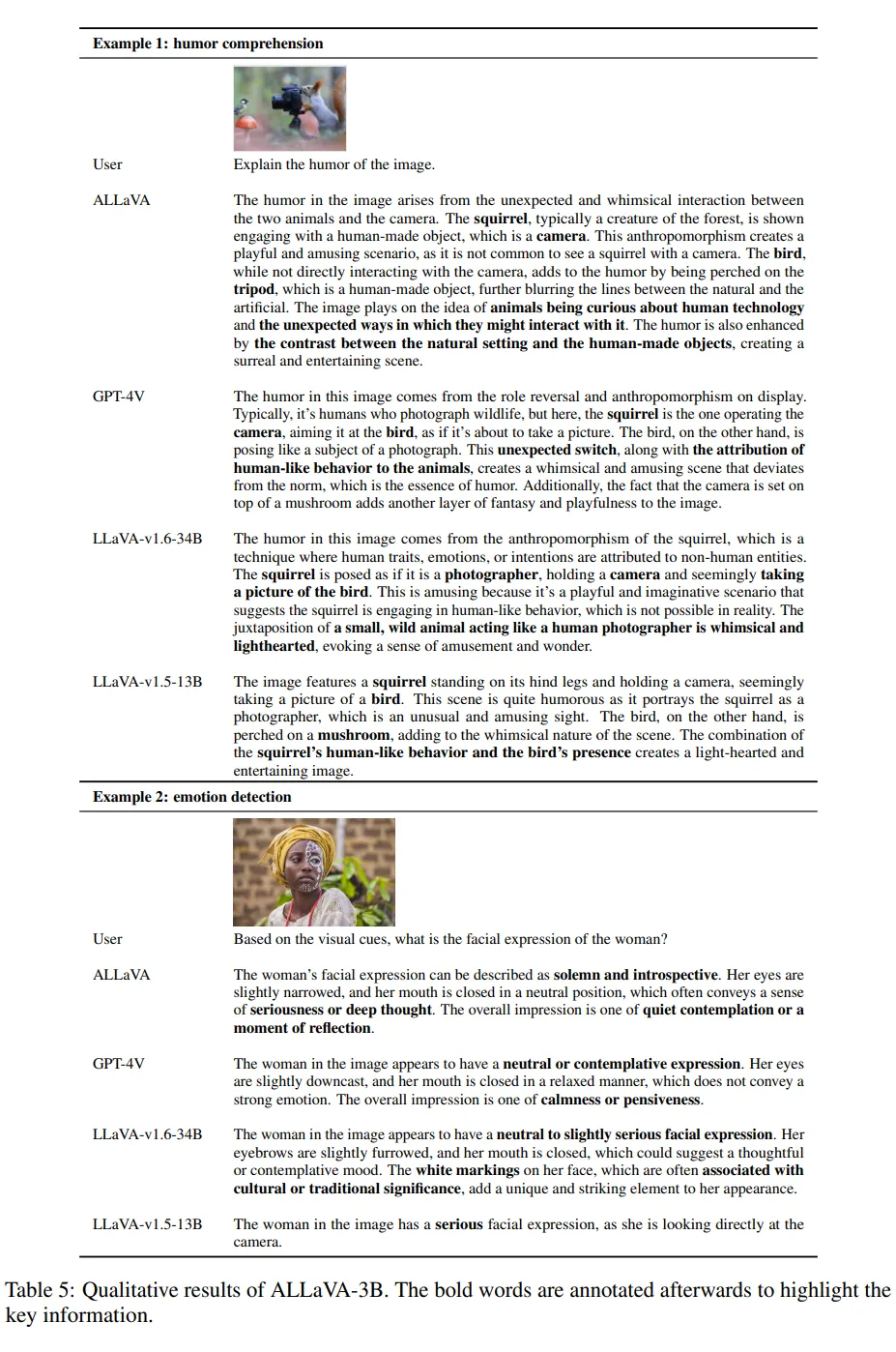

我們提供了兩個示例,并比較了 ALLaVA-3B 與其他模型(包括 GPT-4V、LLaVA-v1.5-13B 和 LLaVA-v1.6-13B)的生成結果。

示例 1 測試了模型對幽默理解的能力。這四個模型都能夠對圖片進行的描述,捕捉到松鼠和鳥的姿態并識別它們各自的角色并分析幽默的原因。

示例2測試了檢測情緒的能力。ALLaVA-3B、GPT-4V 和 LLaVA-v1.6-34B 對女性的面部表情及其潛在情緒的判斷是一致的。然而,LLaVA-v1.5-13B 只給出了粗略的描述,并聲稱她正在看向相機,但實際上并非如此。

在這兩個示例中,僅有 3B 參數的 ALLaVA 能夠與更大模型達到相似的性能,展示了它從高質量訓練集中獲得的卓越推理能力。

四、總結

在這項工作中,我們提出了一個框架,同時生成高質量的 caption、視覺指令和答案。這是一種用于獲取更多的 LVLM 訓練數據的可擴展的方法。使用我們合成的數據集,我們訓練了我們的模型 ALLaVA-3B,該模型在 3B 規模 LVLMs 的 12 個 benchmark 中取得了有競爭力的性能,并且在一些 benchmark 中與更大的 SOTA 模型如 LLaVA-v1.5-13B 的性能相當。

我們的數據可以顯著縮小輕量級 LVLMs 與常規尺寸 LVLMs 之間的性能差距。我們向研究社區開源我們的模型和數據,以更好地推動這一領域的發展。

本文轉載自PaperWeekly