14 項任務測下來,GPT4V、Gemini等多模態大模型竟都沒什么視覺感知能力?

2023-2024年,以 GPT-4V、Gemini、Claude、LLaVA 為代表的多模態大模型(Multimodal LLMs)已經在文本和圖像等多模態內容處理方面表現出了空前的能力,成為技術新浪潮。

然而,對于這些模型的評測多集中于語言上的任務,對于視覺的要求多為簡單的物體識別。相對的,計算機視覺最初試圖解讀圖像作為3D場景的投影,而不僅僅處理2D平面“模式”的數組。

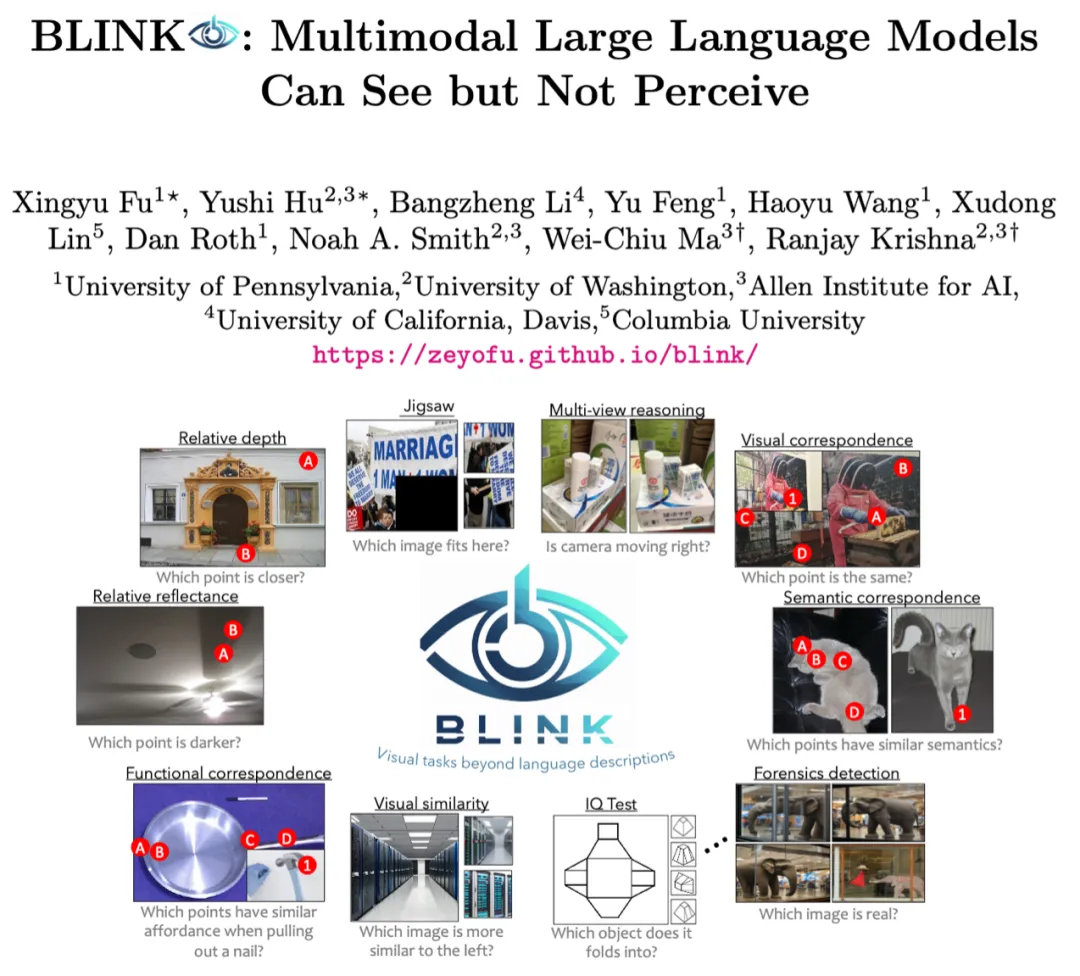

為響應這一情況,本文提出了BLINK,這是一個新的測試集,包含了重新構想的傳統計算機視覺問題,使我們能夠更全面評估多模態大模型的視覺感知能力,帶你揭開GPT4V、Gemini等大模型的視覺界限秘密。

作者相信BLINK將激勵社區幫助多模態LLMs達到與人類同等級別的視覺感知能力。

論文鏈接:https://zeyofu.github.io/blink

什么是BLINK?

BLINK 是一個針對多模態語言模型(Multimodal LLMs)的新基準測試,專注于評估其核心視覺感知能力,這些能力在其他評估中并未涉及。

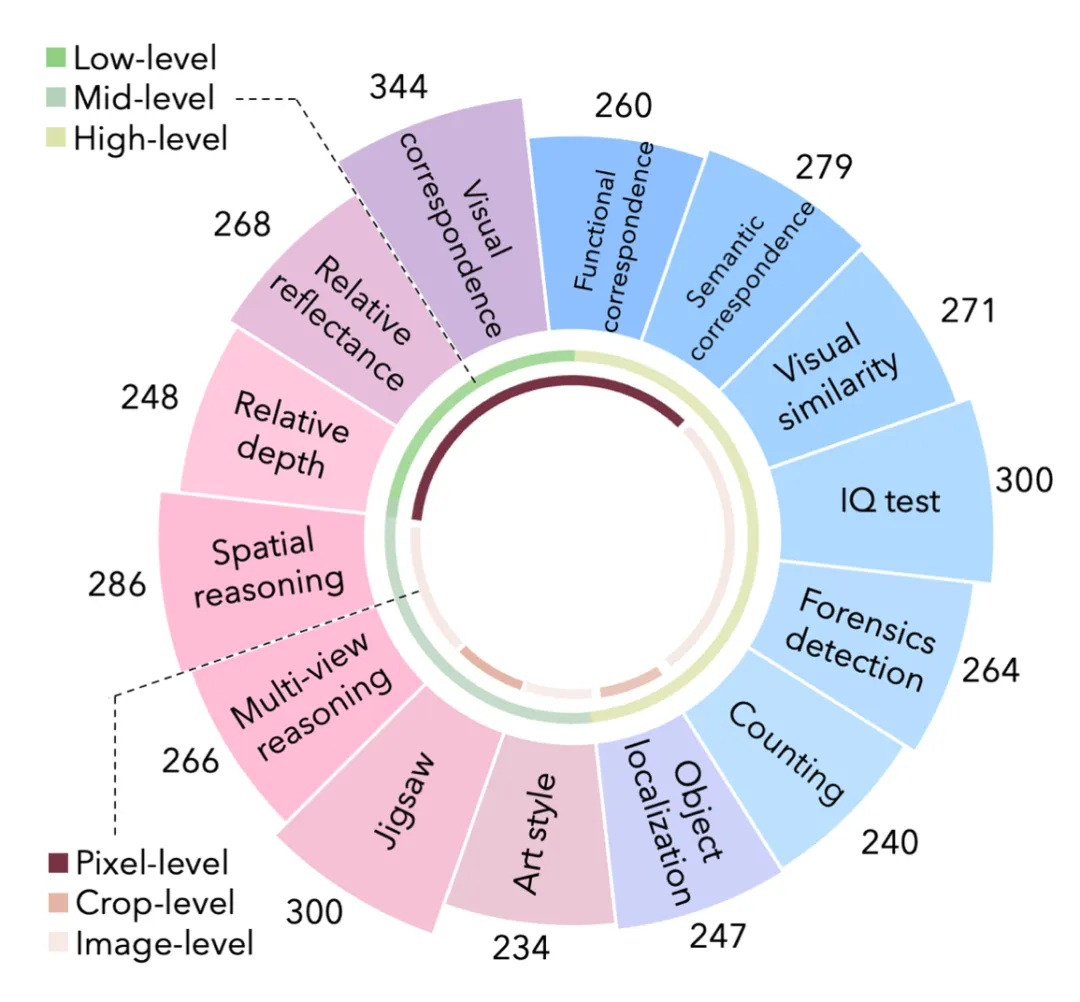

BLINK包含 14 項視覺感知任務,擁有3.8k個選擇題和7.3k張圖像。

人類可以“一眨眼”之間解決這些任務 (例如,相對視深、視覺對應、目標定位,和多視角推理等);但對當前的多模態大型語言模型(Multimodal LLMs)而言,這些任務構成了重大挑戰,因為它們難以通過自然語言處理來解決。

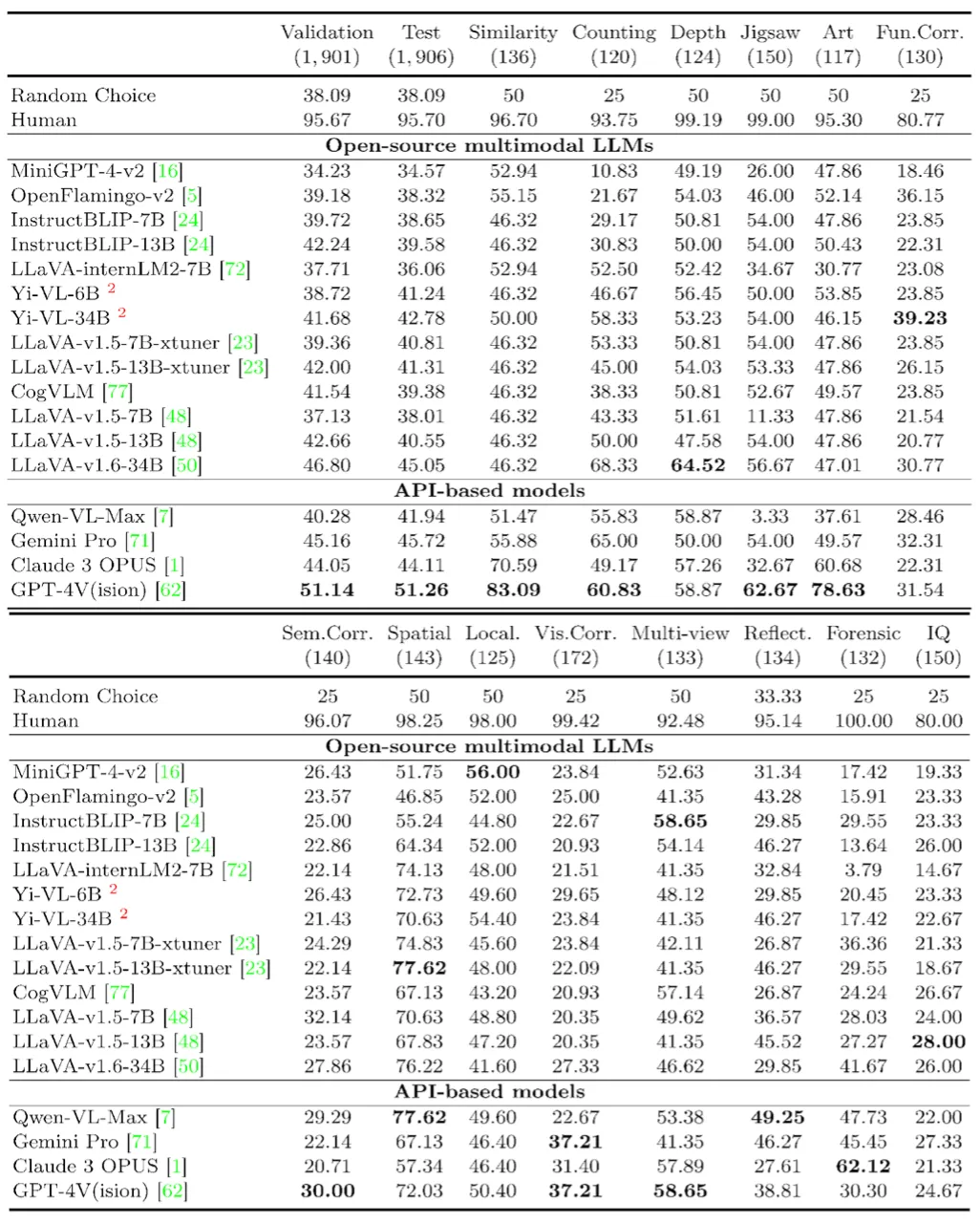

平均而言,人類在這些任務上的準確率為95.70%,然而即使是GPT-4V和Gemini也只達到了51.26%和45.72%的準確率,比隨機猜測僅高出13.17%和7.63%。

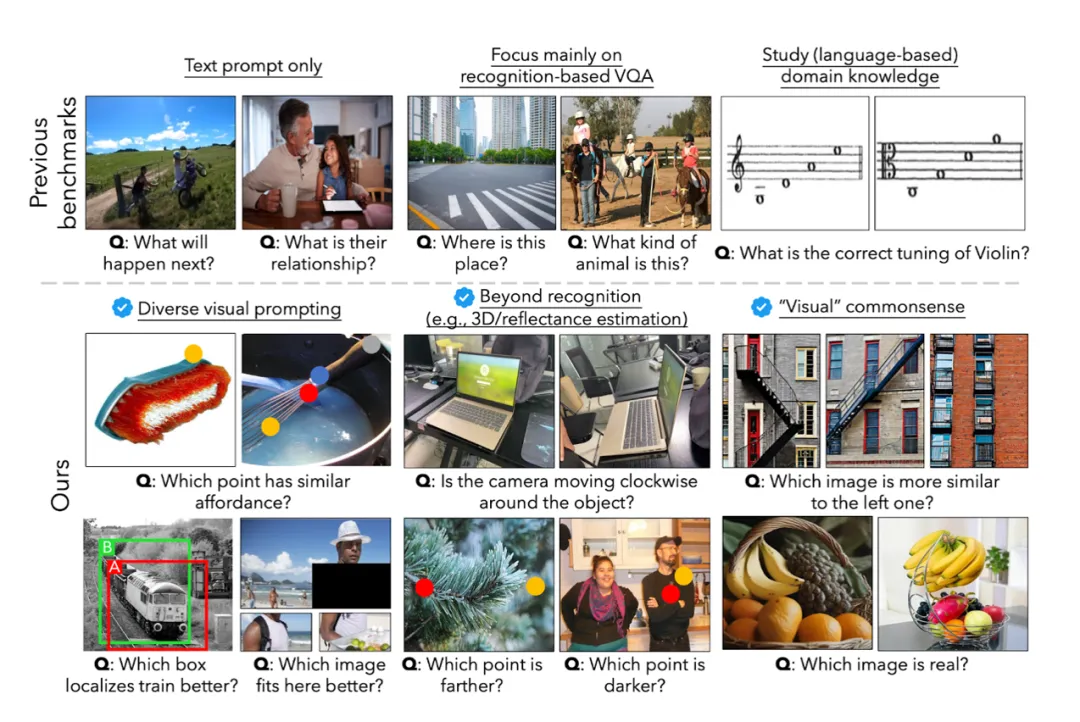

BLINK與其他基準測試的區別

(1)BLINK 運用了多種的視覺prompts, 如圓形、盒形, 和圖像遮罩 masks, 而以前的基準測試僅包含文本問題和答案。

(2)BLINK評估了更全面的視覺感知能力,如多視角推理、深度估算和反射率估算。以往的基準測試通常更側重于基于物體識別的視覺問答(VQA)。

(3)BLINK只包含“視覺”常識性問題,這些問題人類不需要接受教育就可以在一秒鐘內回答,而以前的基準測試像MMMU這樣的則需要專業領域知識。

(4)BLINK涵蓋了14個需求感知的任務,這些任務受到經典計算機視覺問題的啟發。雖然這些問題僅需人類“一眨眼”的時間即可解決,但它們超出了當前多模態大型語言模型的能力。

BLINK 實驗結果

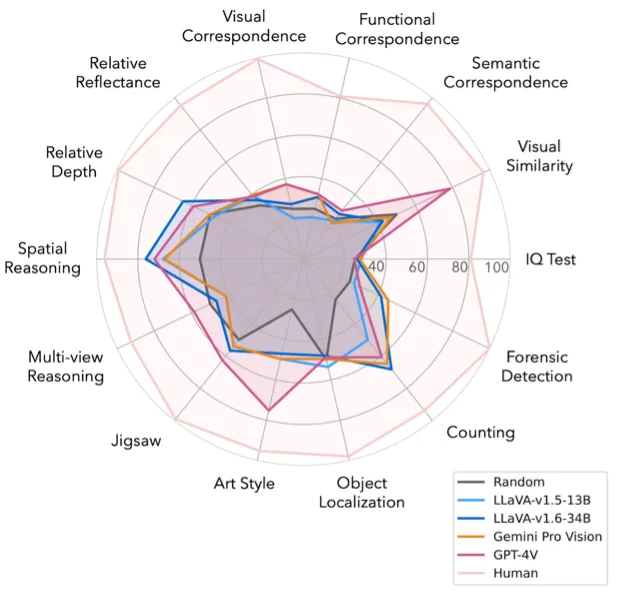

本文評估了17個不同大小(即7B,13B,34B)的多模態LLMs在BLINK上的表現。并觀察到一個悖論:盡管這些問題對于人類來說很容易(平均準確率為95.70%),但對現有機器來說卻極其困難。

7B和13B開源多模態大型語言模型(LLMs)的平均準確率大約在35-42%之間,與隨機猜測(38.09%)相似。

最好的開源模型是LLaVA-v1.6-34B,達到了45.05%的準確率。

即使是最新的大模型,如GPT-4V、Gemini Pro和Claude 3 OPUS,其準確率也僅為51.26%、45.72%和44.11%。它們的表現僅比隨機猜測好13.17%、7.63%和6.02%,并且比人類的表現差44.44%、49.98%和51.59%。

值得注意的是,在某些任務上,如拼圖、語義對應、多視角推理、對象定位和相對反射率,一些多模態LLMs甚至表現不如隨機猜測。

BLINK展示大模型的錯誤范例

對于每項任務,該文章展示了LLaVAv1.6-34B、Qwen-VL-Max、Gemini Pro、GPT-4V和人類的選擇。紅色選項指的是正確答案。請注意,為了視覺效果,作者故意放大了標記,并且將一些圖片做成插圖以節省空間。

對于智力測驗,第三張圖片是通過疊加第一張和第二張圖片構成的。

BLINK實驗分析

(1)把圖片轉換成文字是否是解決多模態問題的正確選擇?

為了回答這個問題,本文使用GPT-4V將圖片轉換為與任務無關的密集圖片字幕,并使用基于文本的LLM來完成任務(Caption + LLM)。這種密集字幕利用語言描述了圖像及視覺提示的詳細信息(例如,每個圓圈的位置)。

作者在BLINK、MMBench和MMMU上進行了實驗。令人驚訝的是,Caption + LLM的配置在MMBench和MMMU上的結果遠優于BLINK。這些結果表明,圖像字幕攜帶了回答其他基準所需的大部分視覺信息。同時,BLINK需要的高級感知能力超出了通用字幕目前可達到的范圍。

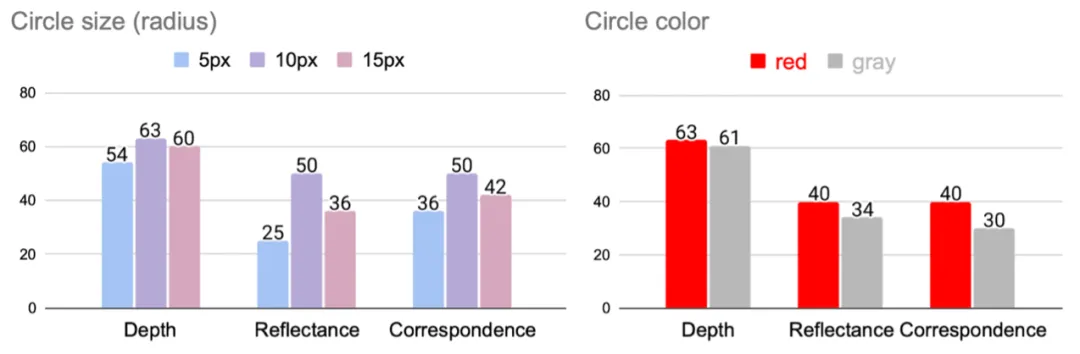

(2)視覺提示(visual prompts)對多模態大模型能產生多大的影響?

本文分析了BLINK中多個任務上圓圈大小和顏色的影響。

實驗表明,視覺提示可能對多模態LLM的性能產生重大影響,改進視覺提示或提高模型對提示變化的魯棒性是未來研究的有前景的方向。根據分析,作者發現最佳圓圈大小依賴于具體任務,平均而言,10px的圓圈效果最好。同樣,對于所有任務來說,紅色比灰色更好。

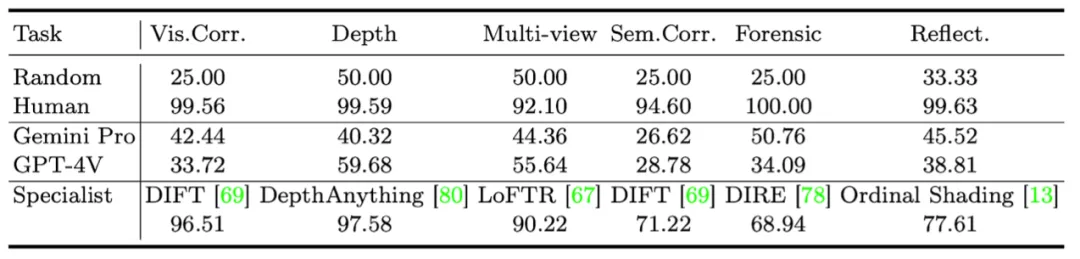

(3)傳統計算機視覺專家模型能解決BLINK任務嗎?

專家可以作為多模態LLM可能達到的上限的代理。這揭示了一個可能性,即多模態LLM可能因正確的數據和培訓策略而在這些任務上取得進展。

作者簡介:

府星妤 (Xingyu Fu)是賓夕法尼亞大學NLP組的博士生,師從Dan Roth教授。她曾在亞馬遜和微軟實習。她的研究主要專注于多模態大模型的感知和推理Reasoning。

胡雨石 (Yushi Hu)是華盛頓大學NLP組的博士生,師從Mari Ostendorf 和 Noah Smith 教授。與此同時,他還是艾倫人工智能研究所(AI2)學生研究員,此前曾在谷歌和騰訊AI 實習。他的研究主要專注于多模態大模型和基于反饋的模型訓練。

本文轉自 機器之心 ,作者:機器之心