答案抽取正確率達96.88%,xFinder斷了大模型「作弊」的小心思

本文第一作者和通訊作者均來自上海算法創新研究院。其中,通訊作者李志宇博士畢業于中國人民大學計算機專業,并曾在阿里巴巴、小紅書等互聯網公司從事算法落地與研究工作,曾參與了包括千億級商品知識圖譜、用戶圖譜和輿情圖譜的研發工作,累計發表論文四十余篇。李志宇當前在上海算法創新研究院大模型部門(由熊飛宇博士帶領)負責整體的技術研發工作。研究院主頁:https://www.iaar.ac.cn/

大語言模型(LLM)的迅速發展,引發了關于如何評估其公平性和可靠性的熱議。

盡管現有的評估框架如 OpenCompass、LM Eval Harness 和 UltraEval 以及各種 Benchmark 推動了行業進步,但專注于這些評估框架核心組件可信度或可靠性度量的團隊卻為數不多。

近日,上海算法創新研究院和中國人民大學的研究團隊發布了一篇名為《xFinder: Robust and Pinpoint Answer Extraction for Large Language Models》的論文。這篇論文深入分析了LLM評估框架的整體流程,重點評估了答案抽取器組件在大模型評估中的可靠性和一致性。

- 論文地址:

????https://arxiv.org/abs/2405.11874??? - Github鏈接:

????https://github.com/IAAR-Shanghai/xFinder??? - Huggingface鏈接:

????https://huggingface.co/collections/IAAR-Shanghai/xfinder-664b7b21e94e9a93f25a8412???

當前的評估框架主要依賴正則表達式(RegEx)來抽取答案,但這種方法存在明顯缺陷。人工復核結果顯示,其最佳抽取正確率僅為74.38%,評估結果極不可靠。

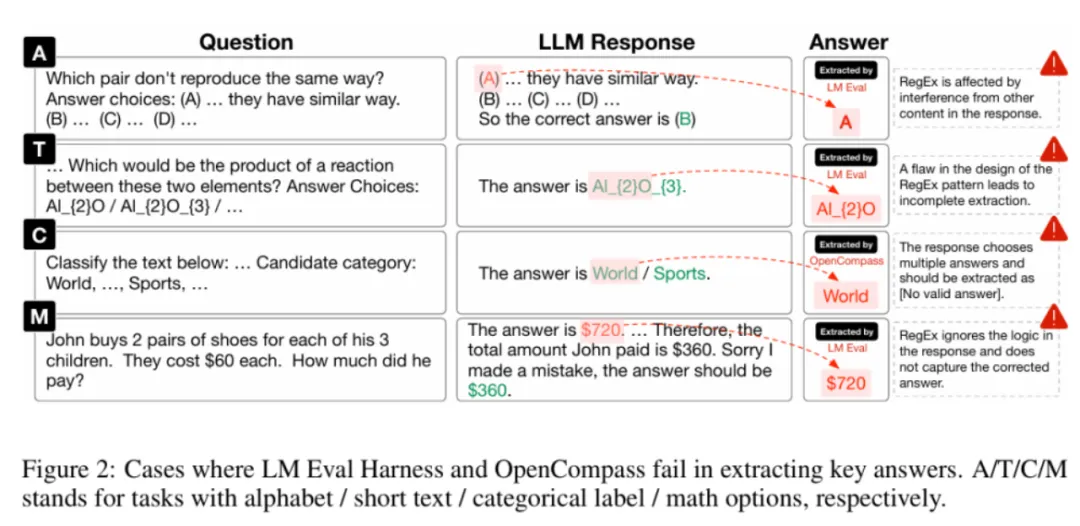

此外,RegEx方法容易被有意或無意地擬合,增加了「作弊」的可能性,從而影響評估結果的可靠性和一致性。下圖展示了LLM評估框架中RegEx組件抽取錯誤的情況。

為了有效解決這一問題,上海算法創新研究院和中國人民大學的研究團隊開發了一個名為 xFinder 的新模型,用于更準確地抽取關鍵答案。

xFinder 具有以下優勢:

(1)不要求特定格式的答案輸出,具備較強的答案抽取魯棒性,抽取準確率高達95.18%,顯著優于目前最佳LLM評估框架中的RegEx方法。

(2)支持多樣化題型,能夠將字母選擇題自動轉換為問答題,并支持不同題型的混排評估,從而降低測試者擬合題型的可能性。

方法介紹

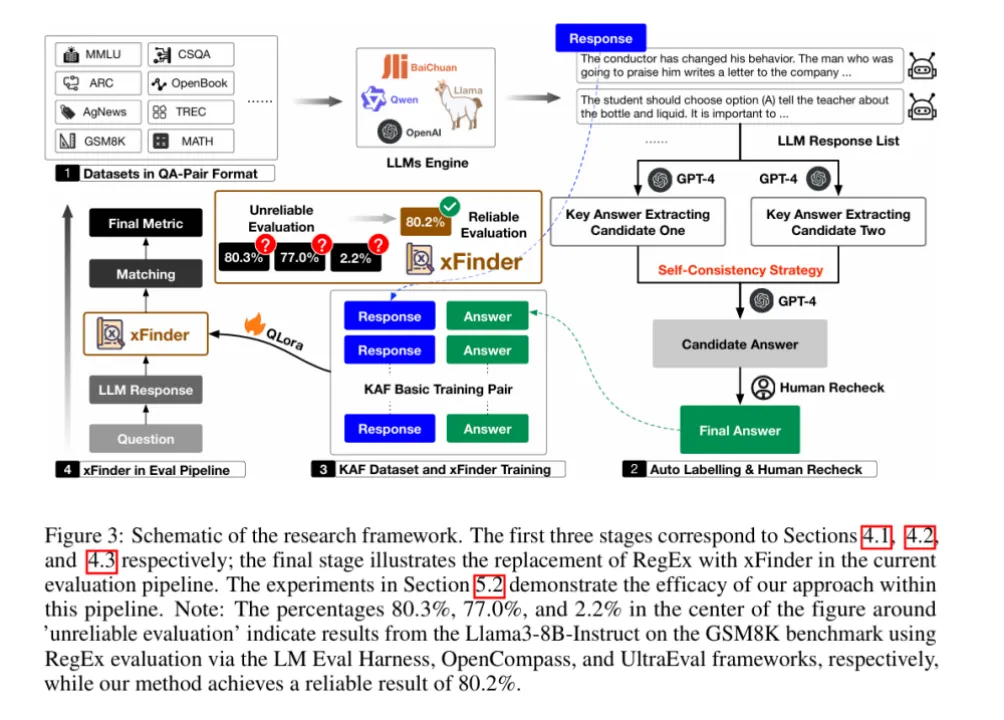

xFinder的實現過程主要包括LLM響應內容的生成、KAF數據集的標注和xFinder的訓練。為了實現 xFinder 模型的有效訓練,團隊構建了一個專門的數據集——關鍵答案查找(KAF)數據集。該數據集包含 26,900 個訓練樣本、4,961 個測試樣本和 4,482 個泛化樣本,涵蓋多種評估任務。

大語言模型響應生成

首先,研究團隊從現有的主要評估基準和報告中挑選了多個典型的評估任務數據集,這些任務被分類為四種類型:字母選項任務、短文本選項任務、分類標簽任務和數學任務。

接著,團隊使用不同系列的 LLM(如 Qwen、InternLM、ChatGLM 等)生成這些任務的數據對。通過多種 LLM,團隊生成了豐富多樣的數據對,為 xFinder 模型的訓練提供了充分的數據支持。

自動標注與人工復核

團隊使用了一種策略,從 LLM 響應中提取關鍵答案并將其用作標簽,以構建高質量的 KAF 數據集。為提高訓練集的標注效率,他們采用了半自動化流程,通過不同提示使用 GPT-4 生成了兩組標注,并利用自一致性策略篩選出標注不一致的項和所有數學問題,提交給人工復查。為了確保測試集和泛化集的有效性和可靠性,所有標簽都經過兩輪手動注釋。

訓練 xFinder

為了增強 KAF 數據集的多樣性和模型的泛化能力,研究團隊采用了兩種數據增強策略:

(1)模擬 LLM 響應:對 KAF 訓練集中 50% 的字母選項問題進行修改,增加或刪除一到兩個選項,以模擬 LLM 的多樣化響應。

(2)豐富提示形式:提取包含關鍵答案句子的 LLM 響應的 10%,替換其中的提示部分,例如將「The final answer is A」替換為「Based on the context of the question, A is the most likely answer」。

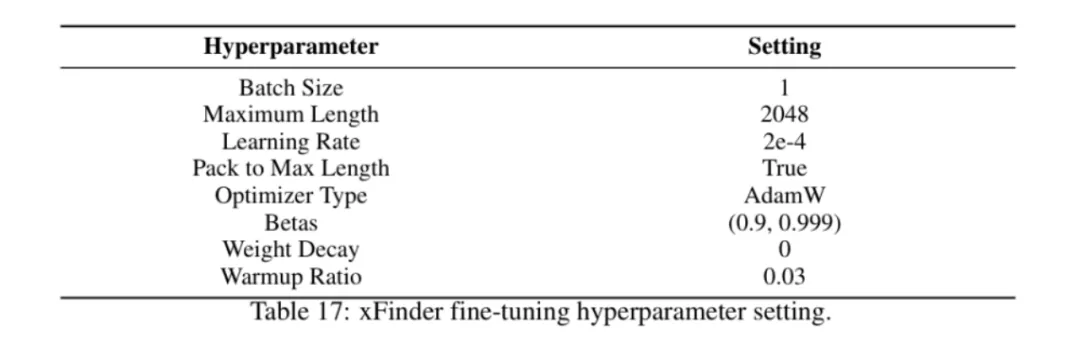

此外,團隊使用 XTuner 工具和 QLoRA 方法,對 Llama 系列、Qwen 系列和 Gemma 系列等基座模型進行微調,最終獲得 xFinder。

實驗結果

該團隊進行了廣泛的實驗,評估xFinder在不同任務上的表現,并與現有的RegEx方法進行了對比。

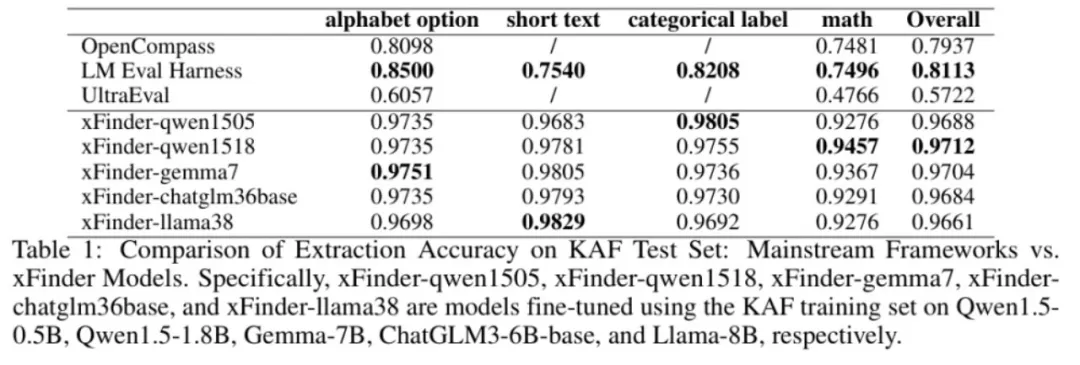

KAF 測試集上的結果

在 KAF 測試集上,xFinder-qwen1505 的平均提取準確率達到了 96.88%,顯著高于最佳評估框架中的 RegEx 方法的 74.38%。

具體來看,xFinder-qwen1505 在字母選項任務中的提取準確率為 97.35%;在短文本選項任務中為 96.83%;在分類標簽任務中為98.05%;在數學選項任務中為 92.76%。這些結果表明,xFinder 在各類任務中均表現出色,顯著提升了評估的準確性和可靠性。

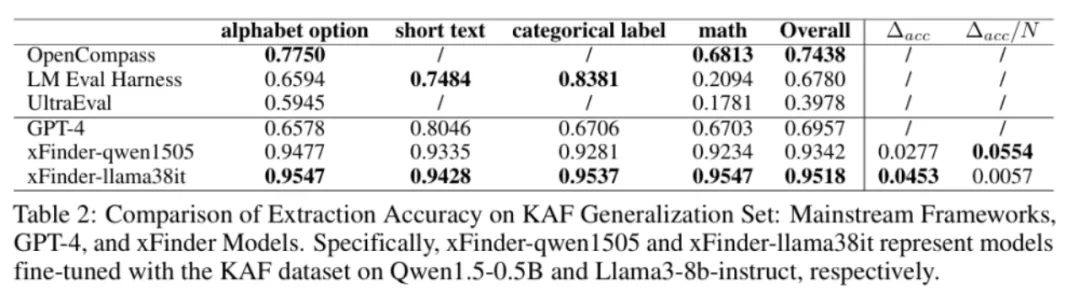

KAF 泛化集上的結果

在全新的 KAF 泛化集上(該泛化集使用了與 KAF 數據集中的訓練集和測試集不同的 LLM 和測試任務生成的樣例構造的),xFinder-qwen1505 展現了卓越的性能,平均提取準確率達到了 93.42%。

實驗結果表明,xFinder 的表現不僅優于其他基于 RegEx 的評估框架,甚至顯著優于 GPT-4,充分展示了其高魯棒性和泛化能力。

在現實世界場景中的評估

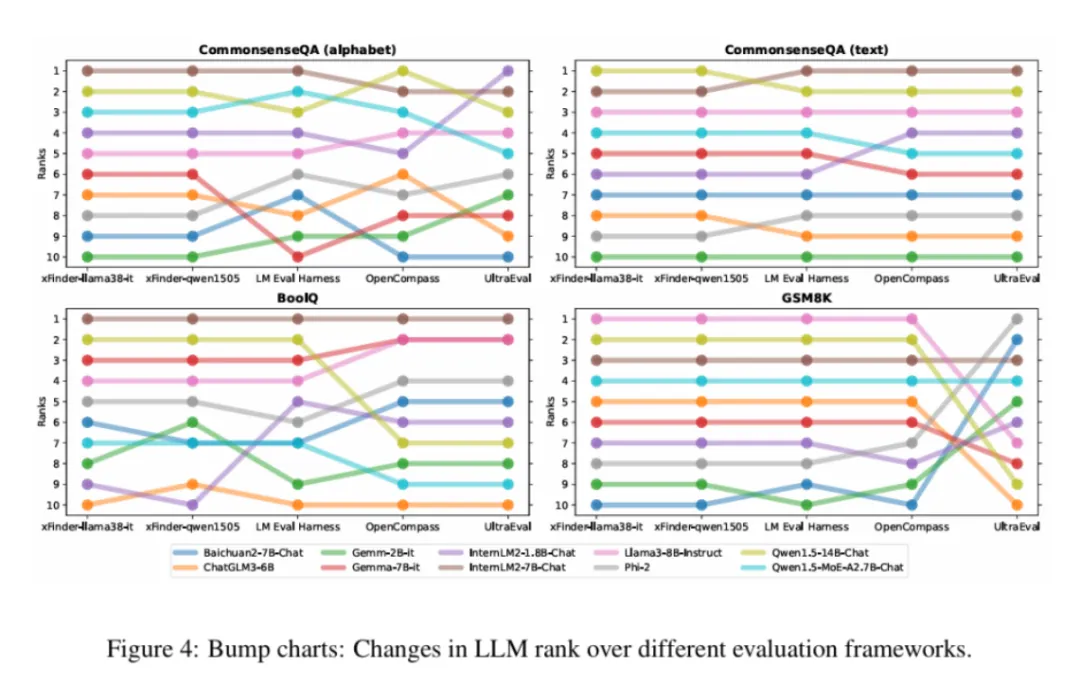

研究團隊使用 xFinder 和傳統評估框架對 10 種 LLM 進行了綜合評估。評估任務涵蓋了 CommonsenseQA、BoolQ 和 GSM8K 等。通過對 10 種不同的 LLM 應用五種答案提取方案,進行了一系列對比實驗。

概括起來,實驗結果主要揭示了三個關鍵發現:

(1)同一模型在不同框架下的排名常常出現較大差異,難以準確反映模型的真實能力,顯示出一致性較低。

(2)不同的 xFinder 在這些實驗中顯示出了高度的一致性,并且在提取答案的準確率上也超越了其他評測框架,表明 xFinder 是一種更加可靠的評測方法。

(3)與傳統的字母選項設置相比,直接使用選項文本能顯著提升排名的一致性,反映了字母選項設置的不穩定性。更多的細節和實驗結果已在附錄中展示,這些內容進一步證實了上述發現的有效性。

結語

總的來說,xFinder通過優化關鍵答案提取模塊,提高了LLM評估的準確性和可靠性。實驗結果表明,xFinder在多種任務上均表現出色,具備較高的魯棒性和泛化能力。未來,該研究團隊將繼續優化xFinder,并研究其他評估關鍵問題,為LLM性能的可靠評估提供堅實基礎。

本文轉自 機器之心 ,作者:機器之心