深度學習算法之稀疏自編碼器完整剖析 原創(chuàng)

本文將深度探索LLM可解釋性背后依賴的邏輯,并詳細解釋稀疏自動編碼器對于提取LLM可解釋性特征、增強模型的魯棒性和提升效率方面的重要作用。

Zephyra傳說

“在盧馬里亞的神秘之地,古老的魔法彌漫在空氣中。這里居住著以太獅鷲Zephyra。Zephyra擁有一個獅子的身體和一雙鷹的翅膀,是掌握宇宙秘密的古老手稿《真理圣典》的受人尊敬的保護者。

《真理圣典》隱藏在一個神圣的洞穴中,由Zephyra所保護。Zephyra有一雙淡綠色的眼睛,她可以看穿欺騙,揭示純粹的真相。一天,一個黑暗的巫師降臨在盧馬里亞的土地上,試圖通過隱藏圣典來掩蓋世界的無知。村民們把在天空中翱翔的Zephyra視為希望的燈塔。Zephyra雄壯地揮動翅膀,在小樹林周圍建造了一道保護性的光屏障,擊退了巫師,揭露了真相。

經(jīng)過長時間的決斗,人們得出結論,黑暗巫師無法與Zephyra的光芒匹敵。通過她的勇氣和警惕,真正的光芒一直照耀著盧馬里亞。隨著時間的推移,盧馬里亞在Zephyra的保護下走向繁榮,Zephyra所捍衛(wèi)的真理照亮了她的道路。這就是Zephyra的傳奇故事的由來!”

Anthropic公司“提取可解釋特征”之旅

在Zephyra的故事之后,美國加州舊金山的人工智能初創(chuàng)公司Anthropic AI深入研究了在模型中提取有意義特征的過程。這項研究背后的想法在于了解神經(jīng)網(wǎng)絡中的不同組件如何相互作用,以及每個組件扮演什么角色。

根據(jù)論文《Towards Monosemanticity: Decomposing Language Models With Dictionary Learning(走向單語義:用字典學習分解語言模型)》:https://transformer-circuits.pub/2023/monosemantic-features/index.html”,稀疏自動編碼器能夠成功地從模型中提取有意義的特征。換言之,稀疏自動編碼器有助于解決“多義性”問題——通過專注于保持單一解釋的稀疏激活特征,同時對應于多種解釋的神經(jīng)激活——換句話說,更多的是單向的。

為了充分理解稀疏自動編碼器的運行機制,我們將借助于Tom Yeh教授提供的關于自動編碼器(https://lnkd.in/g2rM9iV2)和稀疏自動編碼器(https://www.linkedin.com/posts/tom-yeh_claude-autoencoder-aibyhand-activity-7199774212759183362-msKU/?)的漂亮圖片,詳細解釋這些非凡機制的幕后工作原理。

首先,讓我們先來探究一下什么是自動編碼器以及它是如何工作的。

什么是自動編碼器?

想象一下,一個作家的桌子上堆滿了不同的紙張——有些是他正在寫的故事的筆記,有些是定稿的副本,有些又是他充滿動作的故事的插圖。現(xiàn)在,在這種混亂中,很難找到重要的部分——尤其是當作家很匆忙,出版商在電話中要求兩天內(nèi)出版一本書時。值得慶幸的是,作者有一個非常高效的助手——這個助手確保雜亂的桌子定期清潔,將類似的物品分組,整理并放在正確的位置。在需要的時候,助手會為作者檢索正確的文章,幫助他在出版商設定的截止日期前完成任務。

這個助手的名字叫自動編碼器,它主要有兩個功能——編碼和解碼。編碼是指壓縮輸入數(shù)據(jù)并提取基本特征(組織);解碼是從編碼表示中重建原始數(shù)據(jù)的過程,同時旨在最大限度地減少信息丟失(檢索)。

現(xiàn)在,讓我們看看這個助手是如何工作的。

自動編碼器是如何工作的?

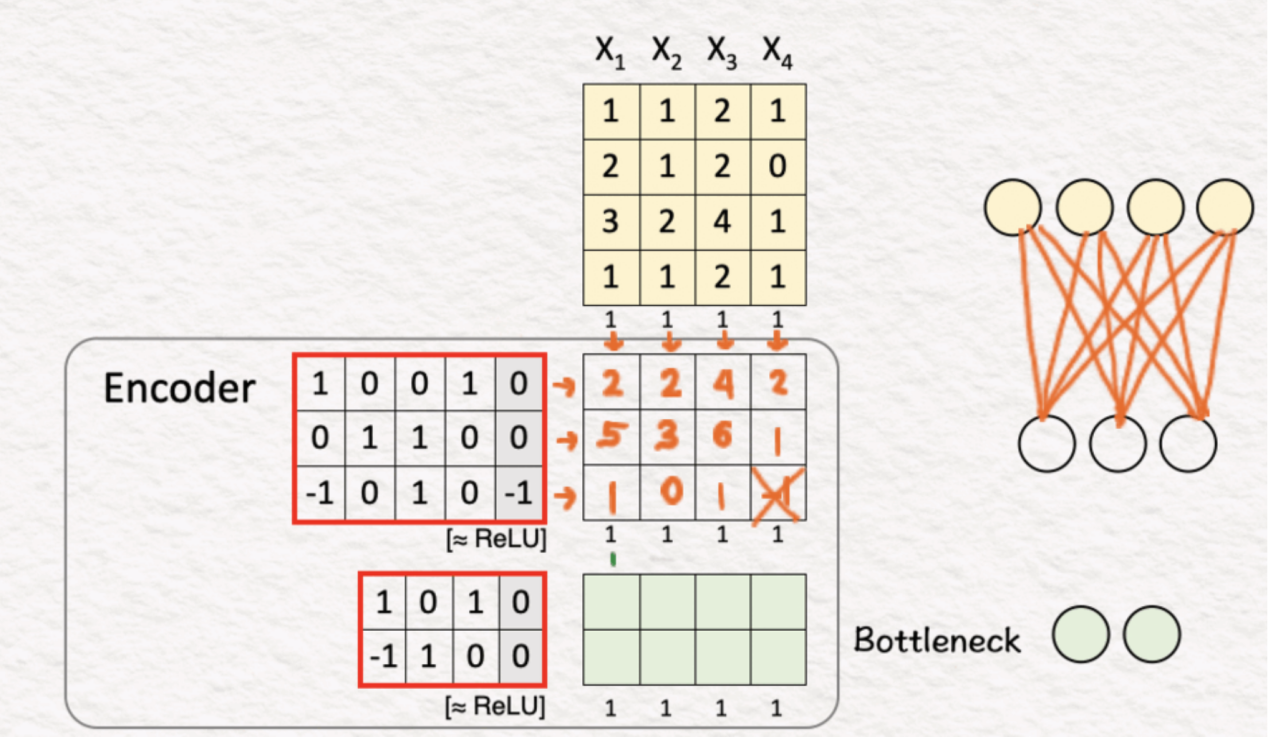

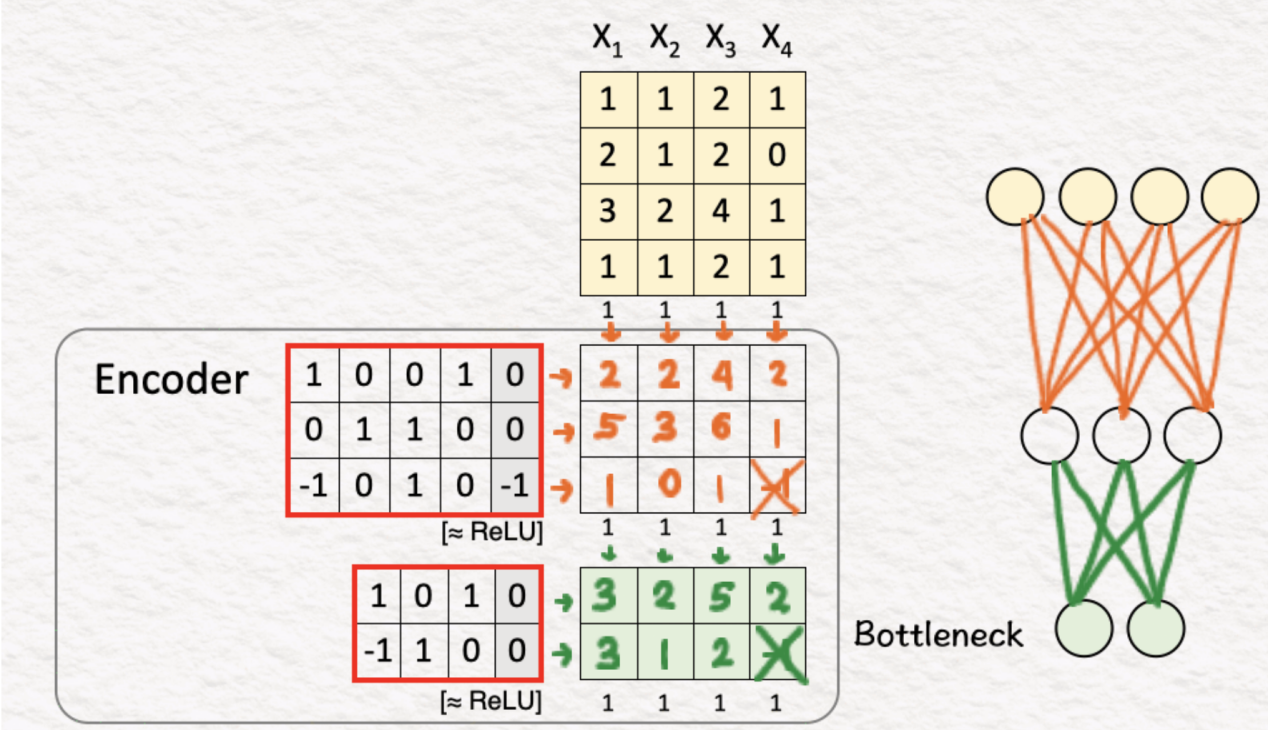

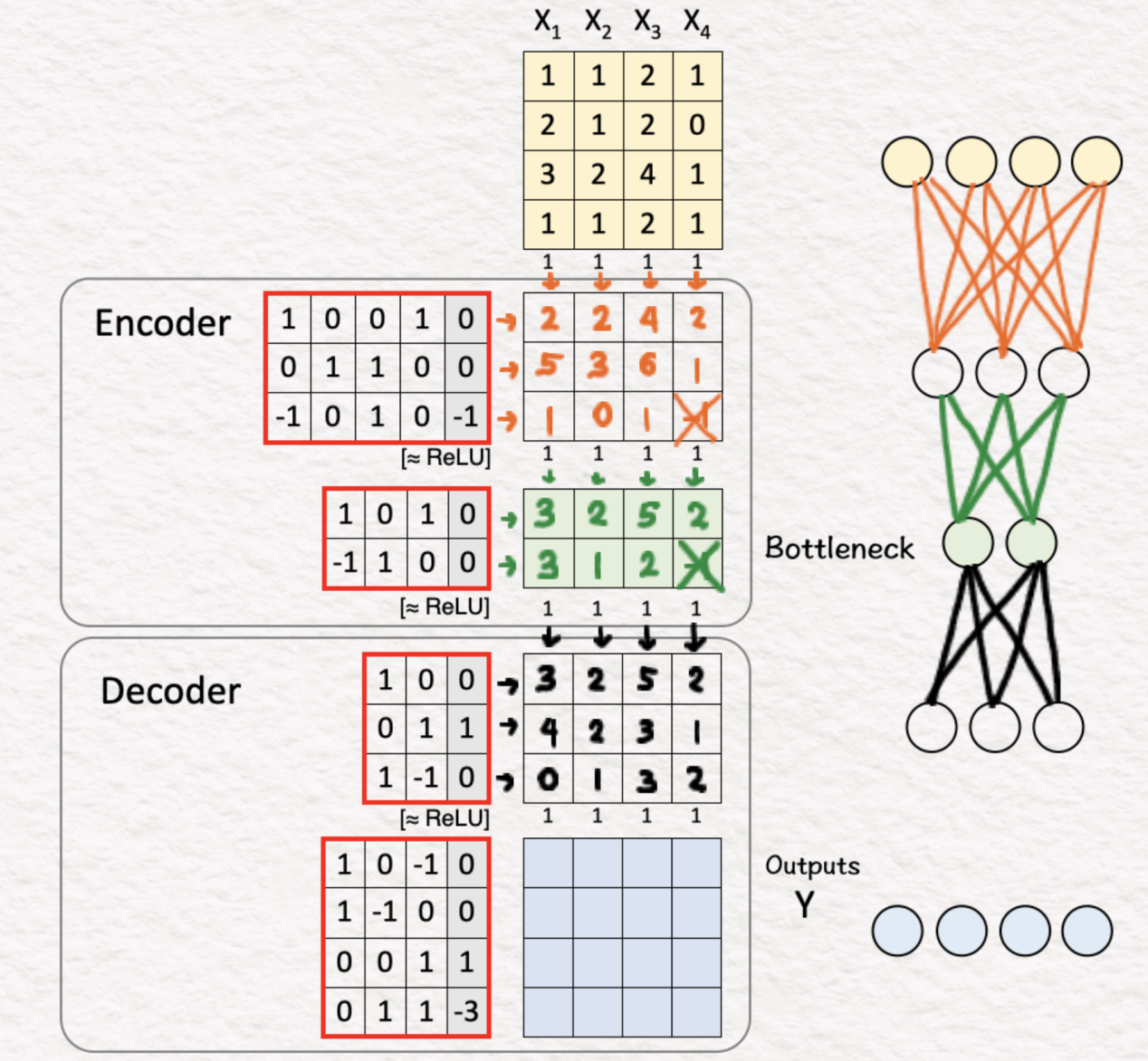

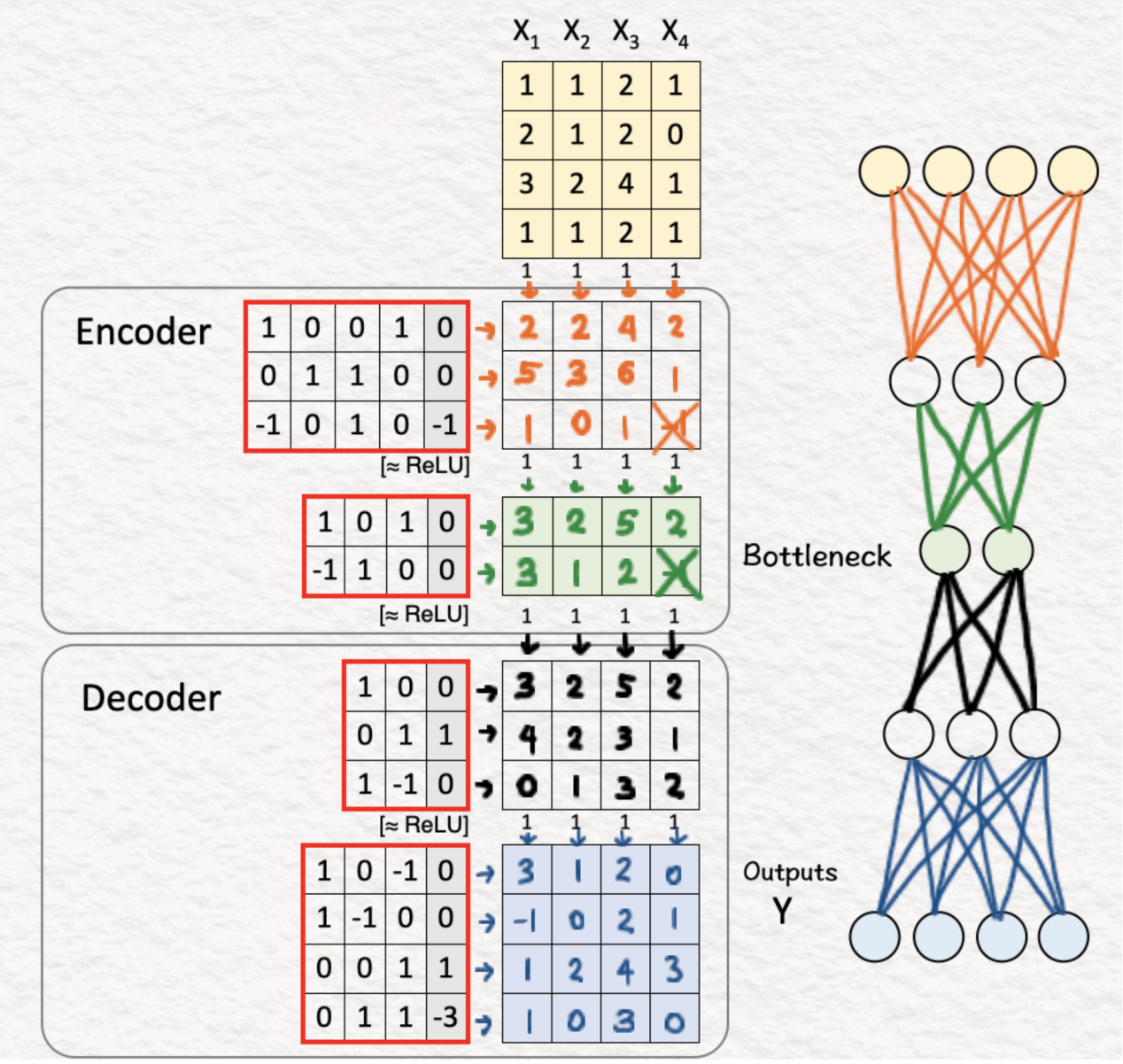

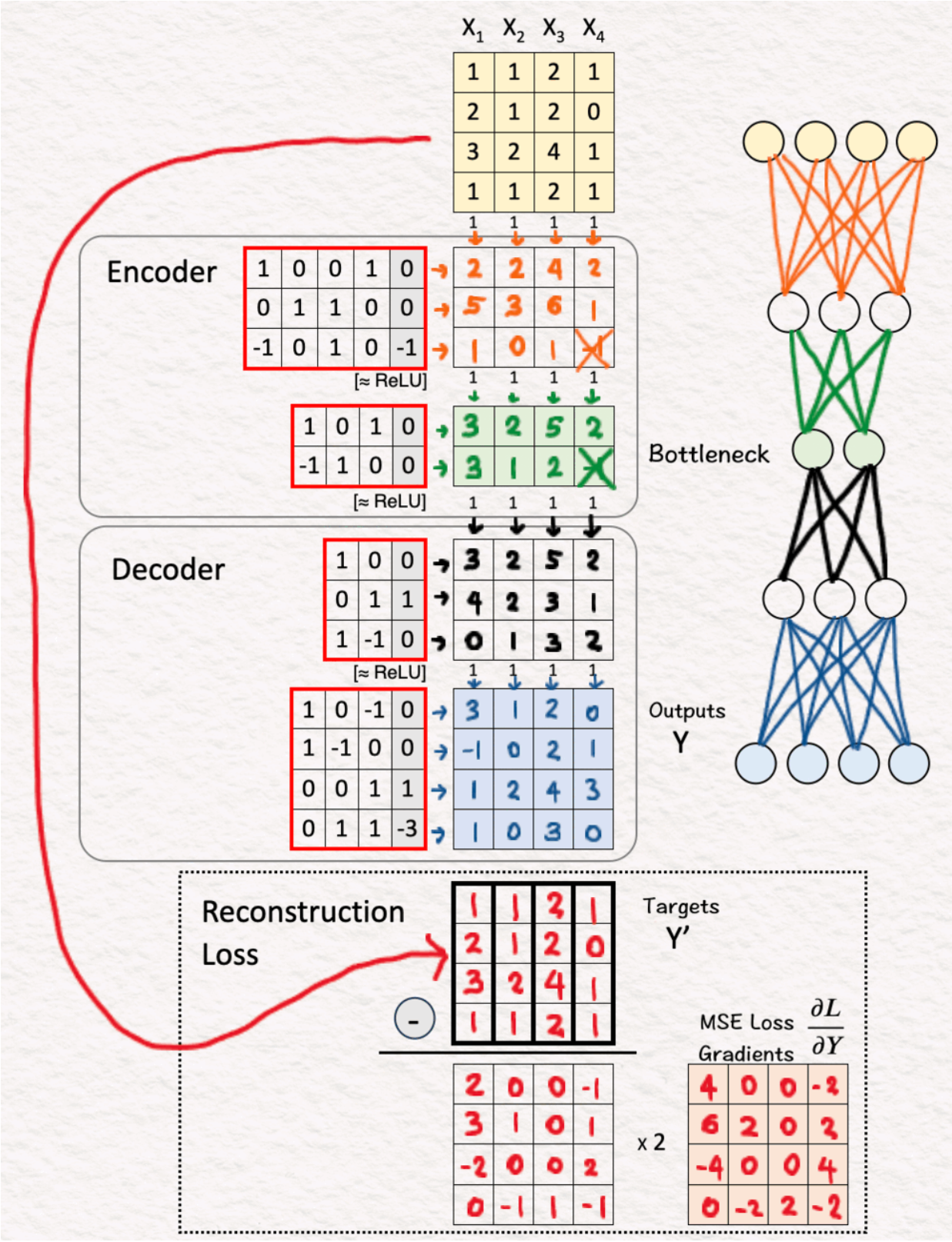

給定:四個訓練樣本X1、X2、X3、X4。

(1)自動(Auto)處理

第一步是將訓練樣本復制到目標Y'。Autoencoder的工作是重建這些訓練樣本。由于目標本身就是訓練樣本,因此使用了單詞“Auto”,這在希臘語中是“self”的意思。

(2)編碼器:第1層+ReLU

正如我們在之前的所有模型中所看到的,一個簡單的權重和偏差矩陣與ReLU相結合后其功能是強大的,能夠創(chuàng)造奇跡。因此,通過使用第一個編碼層,我們將原始特征集的大小從4x4減小到3x4。

【簡要回顧】

- 線性變換:將輸入嵌入向量乘以權重矩陣W,再加上偏置向量b,

- z=Wx+b,其中W是權重矩陣,x是我們的單詞嵌入,b是偏置向量。

- ReLU激活函數(shù):接下來,我們將ReLU應用于這個中間z。

ReLU返回輸入的元素最大值和零。從數(shù)學上講,h=max{0,z}。

(3)編碼器:第2層+ReLU

前一層的輸出由第二編碼器層處理,這將輸入大小進一步減小到2x3。這就是提取相關特征的地方。這一層也被稱為“瓶頸”,因為這一層中的輸出特征比輸入特征低得多。

(4)解碼器:第1層+ReLU

一旦編碼過程完成,下一步是解碼相關功能,以“返回”最終輸出。為此,我們將上一步的特征與相應的權重和偏差相乘,并應用ReLU層。結果是一個3x4矩陣。

(5)解碼器:第2層+ReLU

第二個解碼器層(權重、偏置+ReLU)應用于先前的輸出,以給出最終結果,即重建的4x4矩陣。我們這樣做是為了回到原始維度,以便將結果與原始目標進行比較。

(6)損失梯度和反向傳播

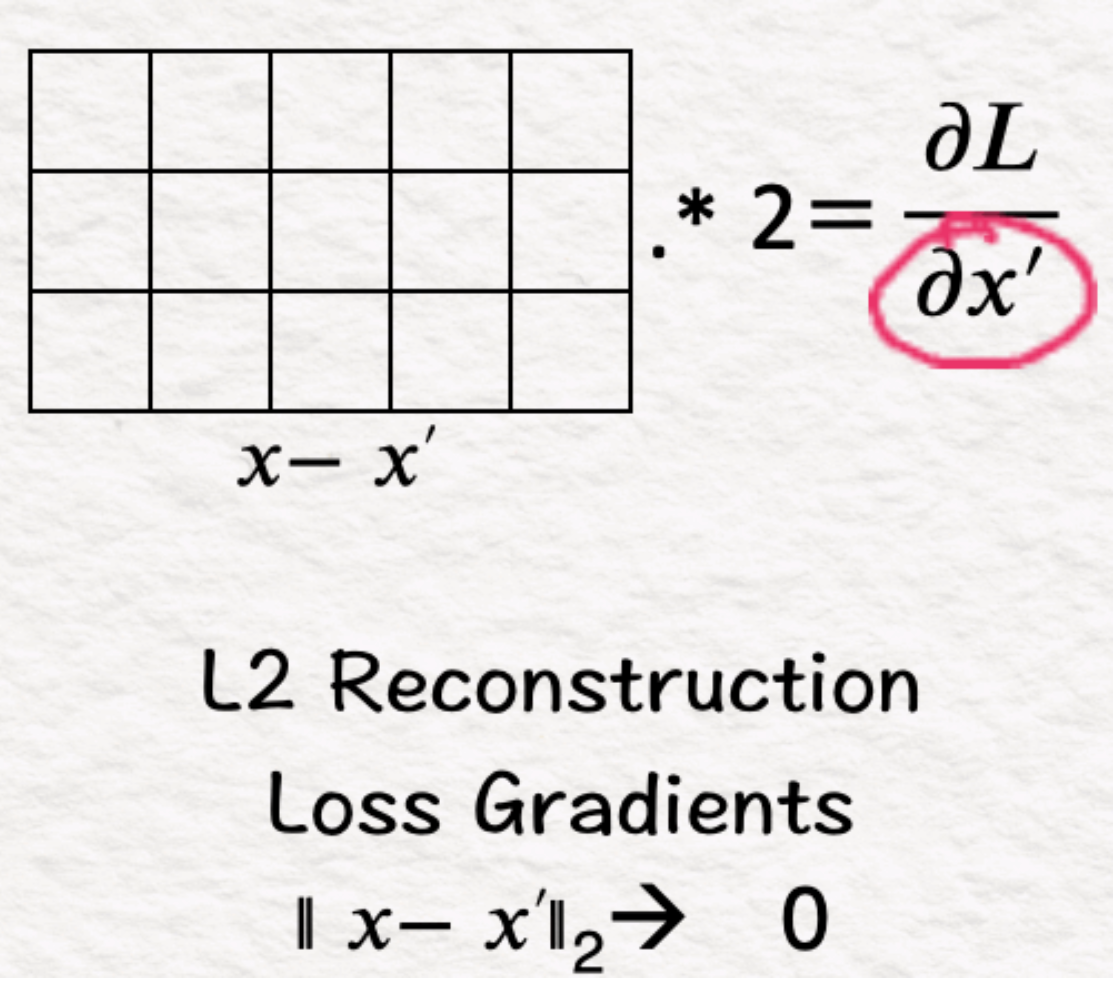

一旦獲得來自解碼器層的輸出,我們就計算輸出(Y)和目標(Y’)之間的均方誤差(MSE)的梯度。為此,我們找到2*(Y-Y'),這給了我們激活反向傳播過程的最終梯度,并相應地更新權重和偏差。

既然我們已經(jīng)了解了自動編碼器的工作原理,那么接下來,我們就可以開始探索其稀疏變體如何實現(xiàn)大型語言模型(LLM)的可解釋性了。

稀疏自動編碼器——它是如何工作的?

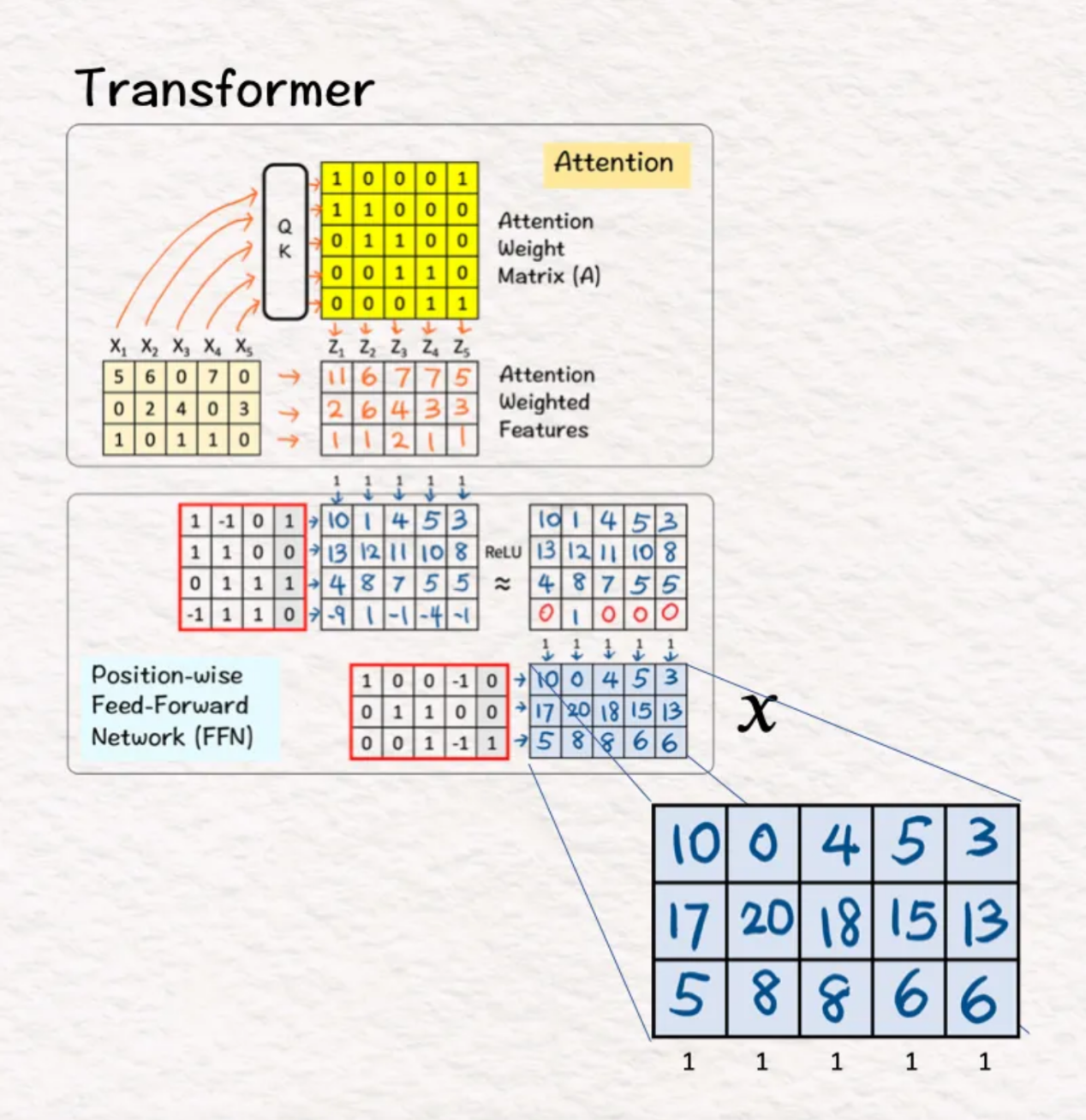

首先,假設我們得到:

- 前饋層處理之后轉換器的輸出結果,即,假設我們有五個特征(X)的模型激活。它們激活都很好,但并不能說明模型是如何做出決定或做出預測的。

這里的首要問題是:

是否有可能將每個激活(3D)映射到有助于理解的更高維度空間(6D)?

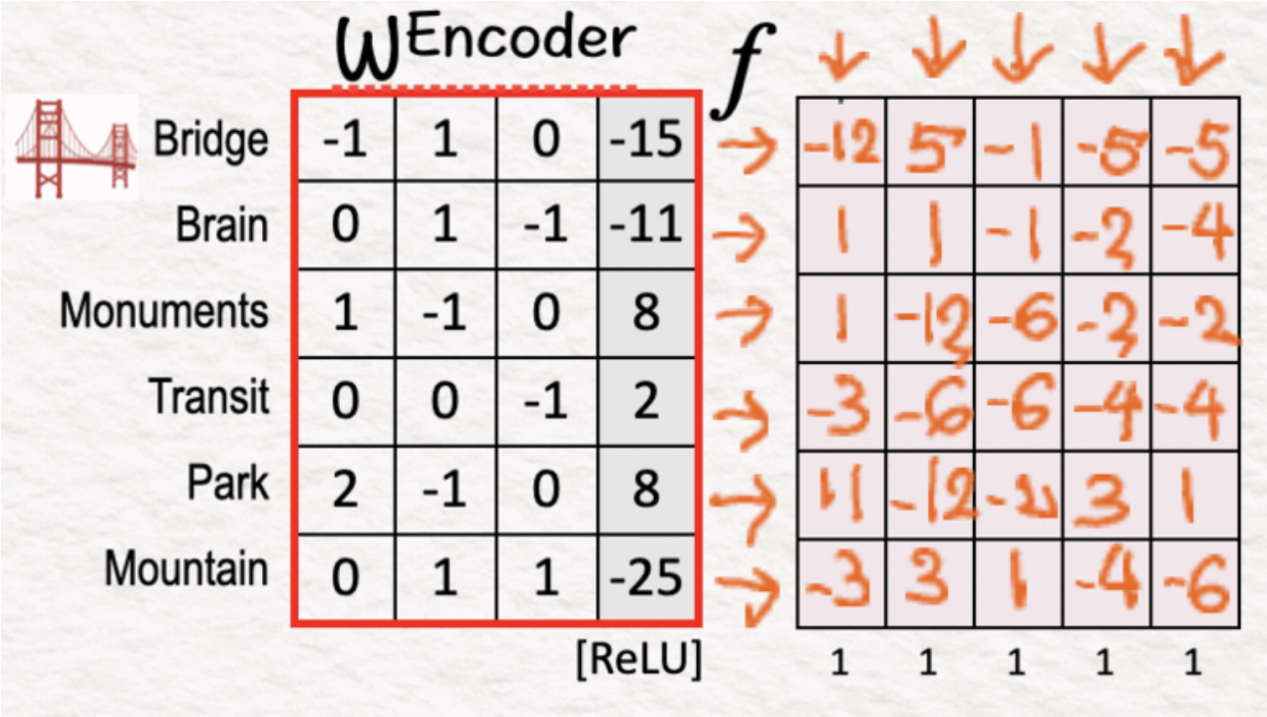

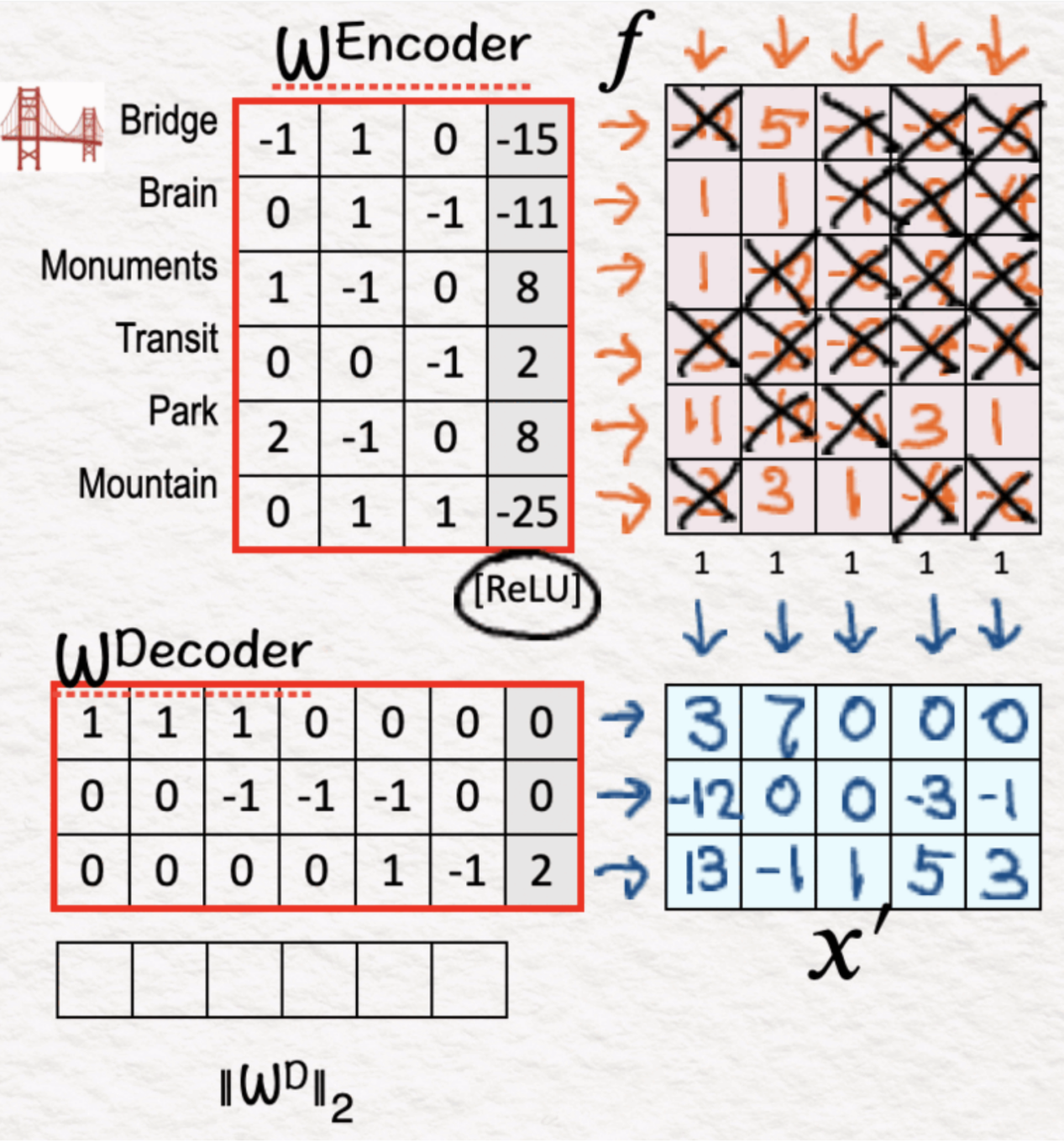

(1)編碼器:線性層

編碼器層的第一步是將輸入X與編碼器權重相乘,并添加偏差(如自動編碼器的第一步中所做的)。

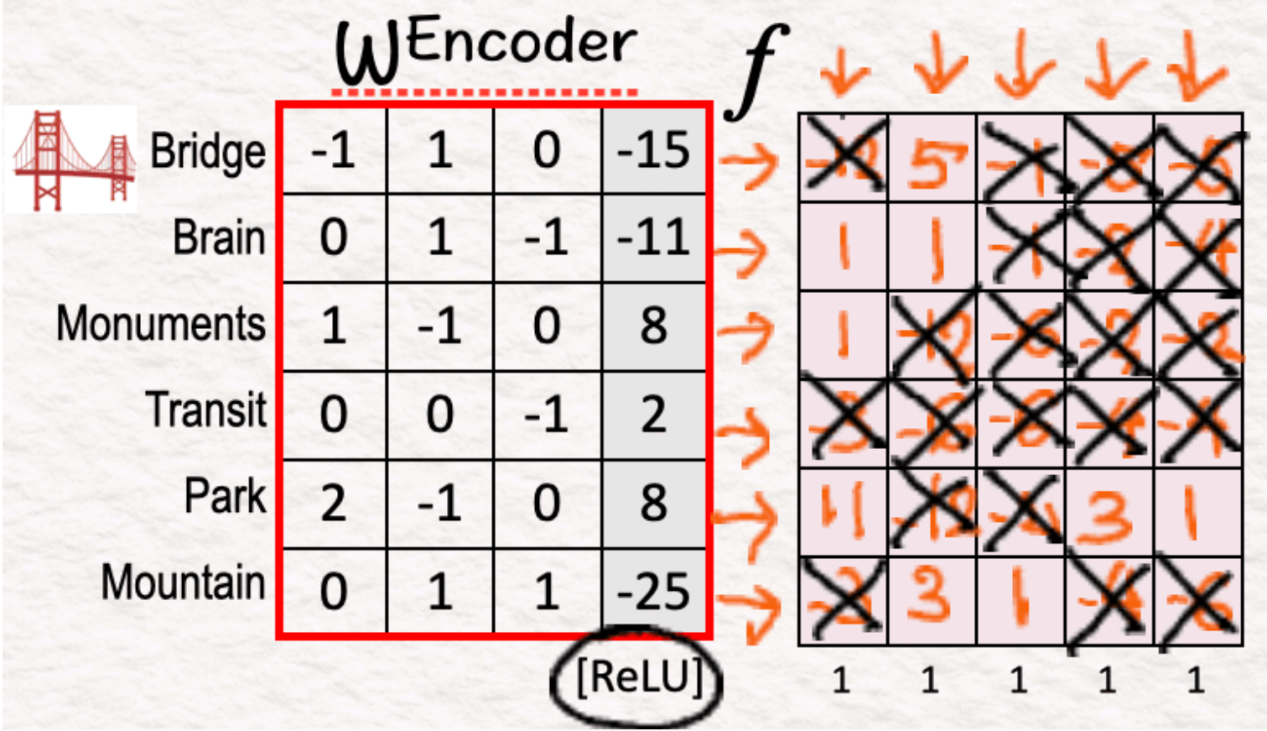

(2)編碼器:ReLU

下一個子步驟是應用ReLU激活函數(shù)來添加非線性并抑制負激活。這種抑制導致許多特征被設置為0,這實現(xiàn)了稀疏性的概念——輸出稀疏和可解釋的特征f。

當我們只有一個或兩個正的特征時,就產(chǎn)生了可解釋性。如果我們檢查f6,我們可以看到X2和X3是正的,可以說兩者都有“峰”的共同點。

(3)解碼器:重建

一旦我們完成了編碼器,接下來就進入解碼器階段。在此,我們將f與解碼器權重相乘,并添加偏差。這輸出了X’,這是根據(jù)可解釋特征對X的重構。

正如在自動編碼器中所做的那樣,我們希望X'盡可能接近X。為了確保這一點,進一步的訓練至關重要。

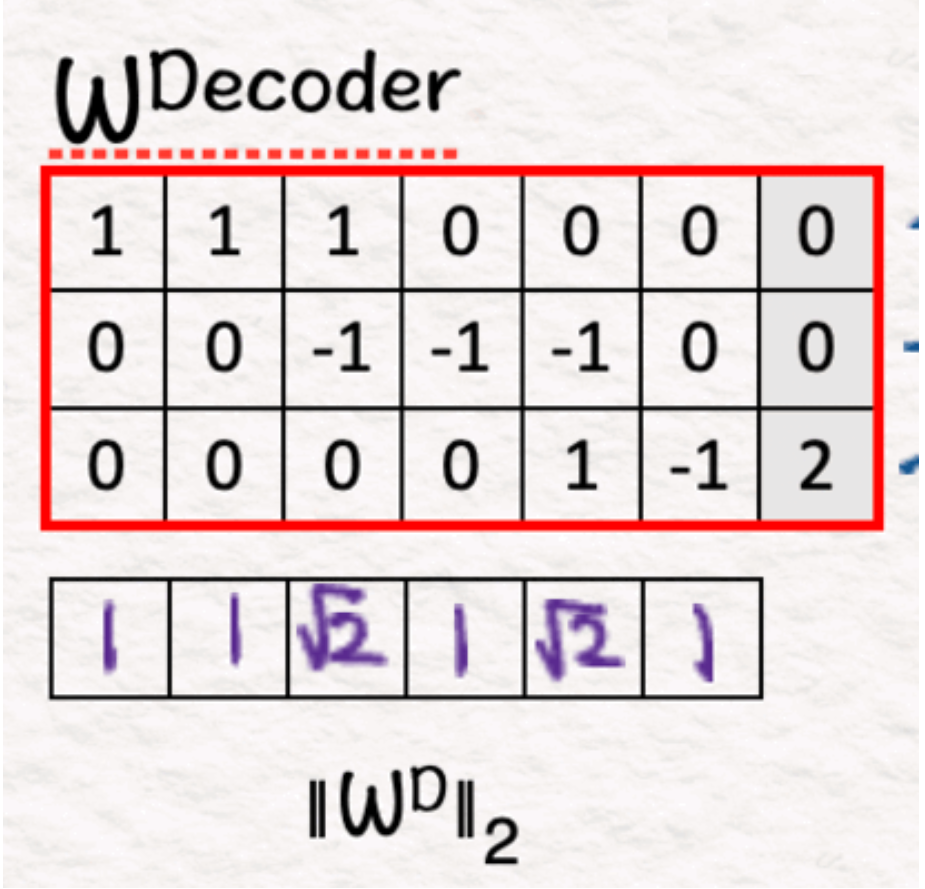

(4)解碼器:權重

作為中間步驟,我們在該步驟中計算每個權重的L2范數(shù)。我們把它們放在一邊待用。

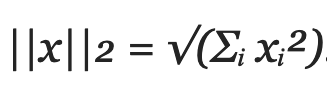

關于L2范數(shù)

L2范數(shù)也被稱為歐幾里得范數(shù),它使用以下公式計算向量的大小:

換句話說,它對每個分量的平方求和,然后取平方根作為結果。這個范數(shù)提供了一種直接的方法來量化歐幾里得空間中向量的長度或距離。

訓練

如前所述,稀疏自動編碼器引入廣泛的訓練,以使重建的X’更接近X。為了說明這一點,我們繼續(xù)進行以下步驟:

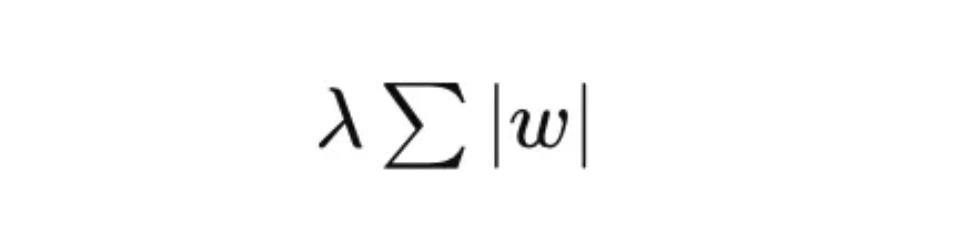

(5)稀疏性:L1損失

這里的目標是獲得盡可能多的接近零/零的值。我們通過調(diào)用L1稀疏性來懲罰權重的絕對值來做到這一點——核心思想是我們希望使總和盡可能小。

關于L1損耗

L1損失計算為權重的絕對值之和:L1=λ∑|w|,其中λ是正則化參數(shù)。

這鼓勵許多權重變?yōu)榱悖喕四P停瑥亩鰪娏丝山忉屝浴?/p>

換言之,L1有助于建立對最相關特征的關注,同時防止過擬合,提高模型泛化能力,并降低計算復雜度。

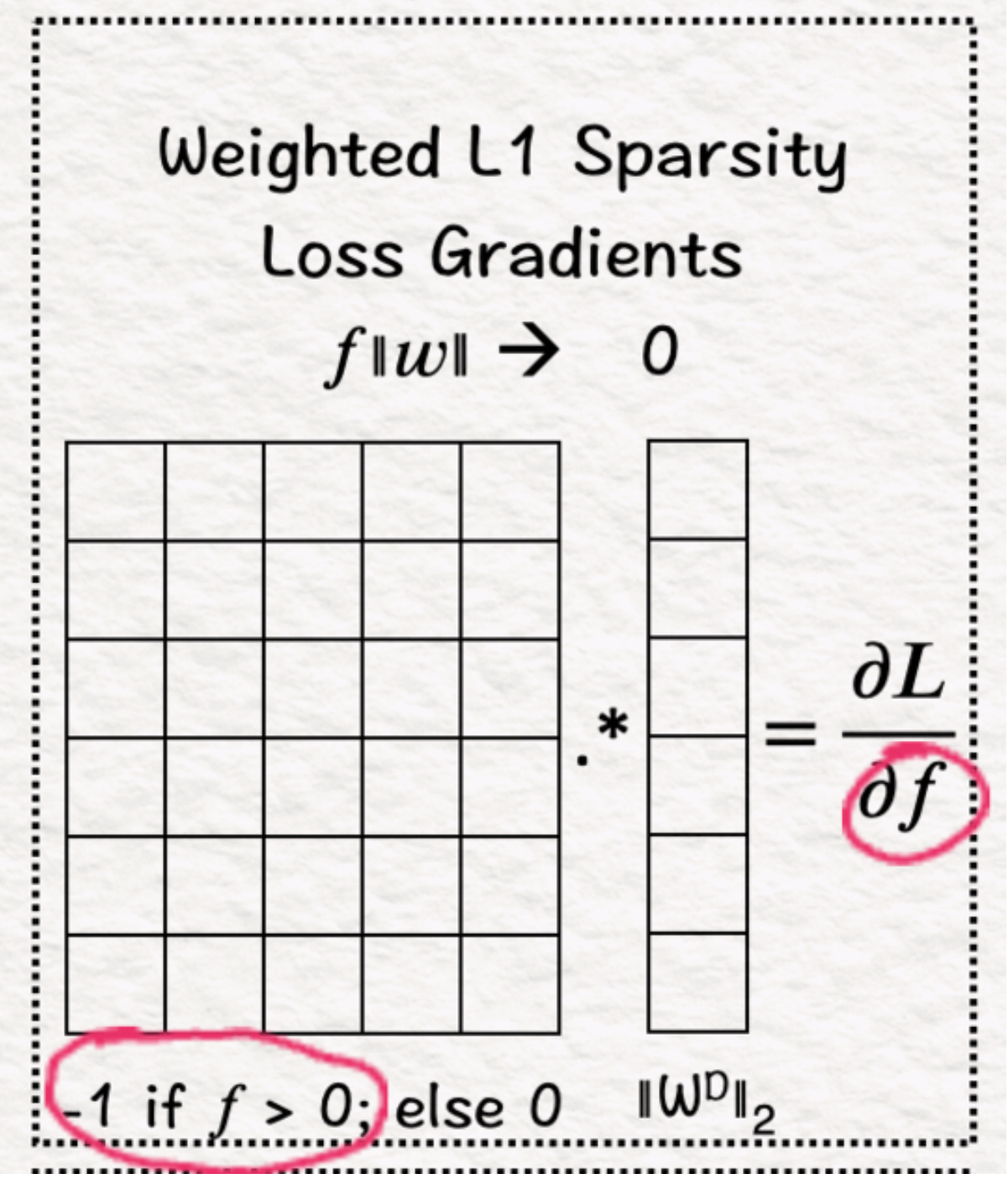

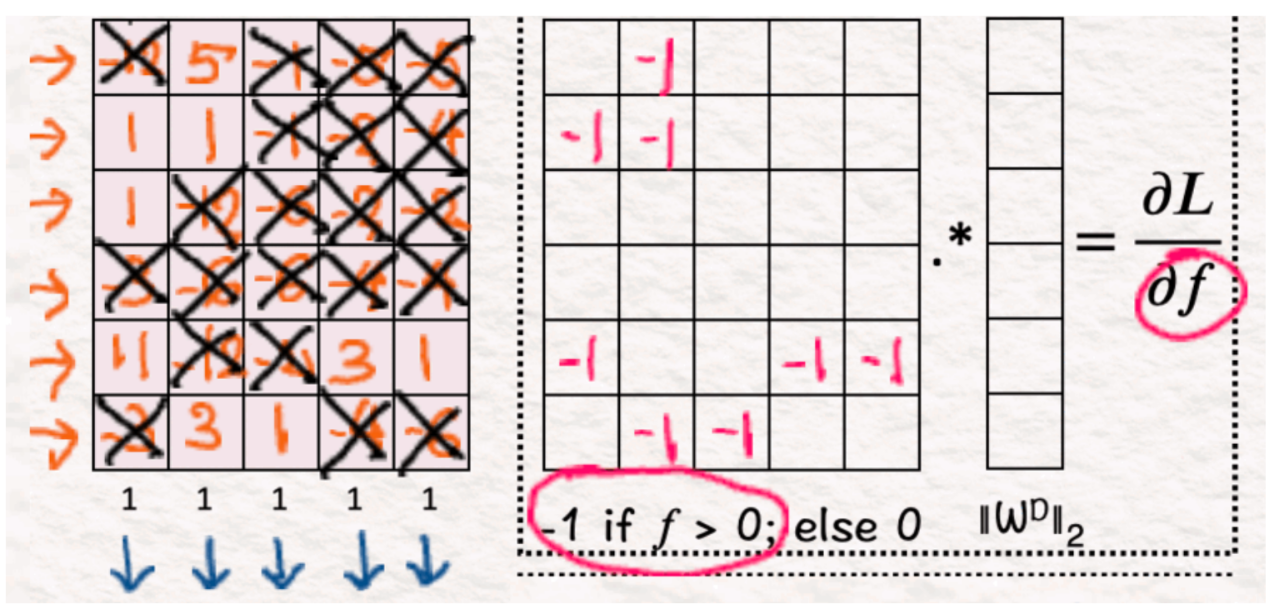

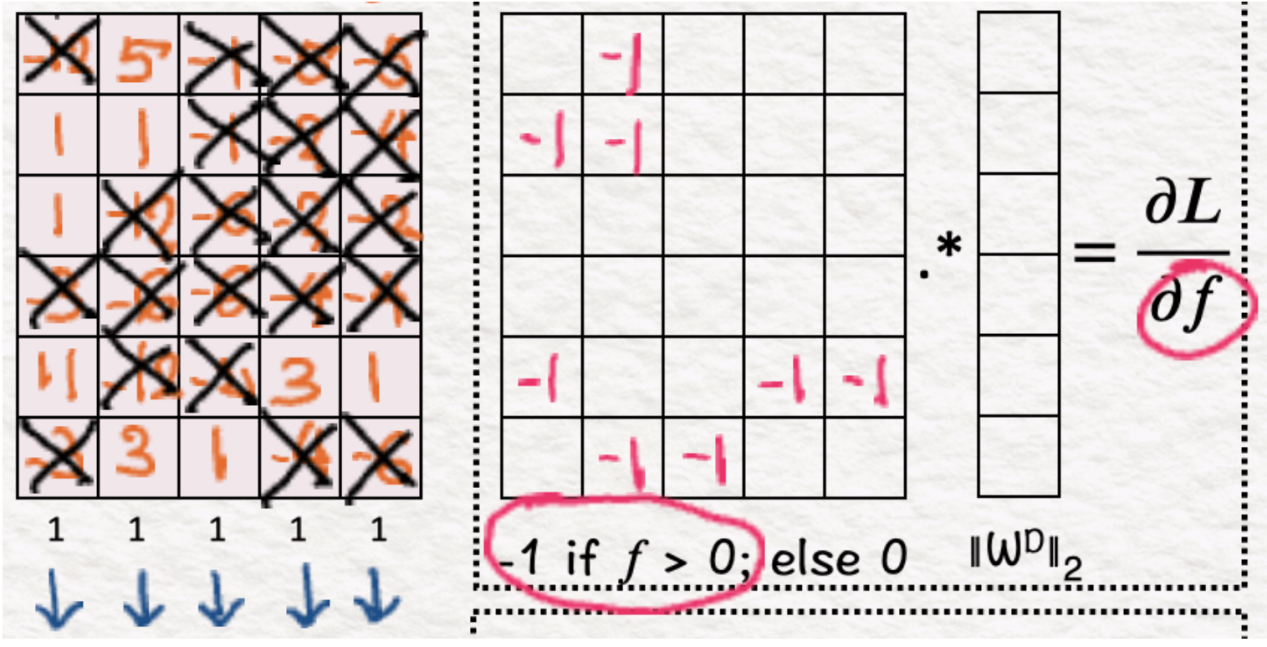

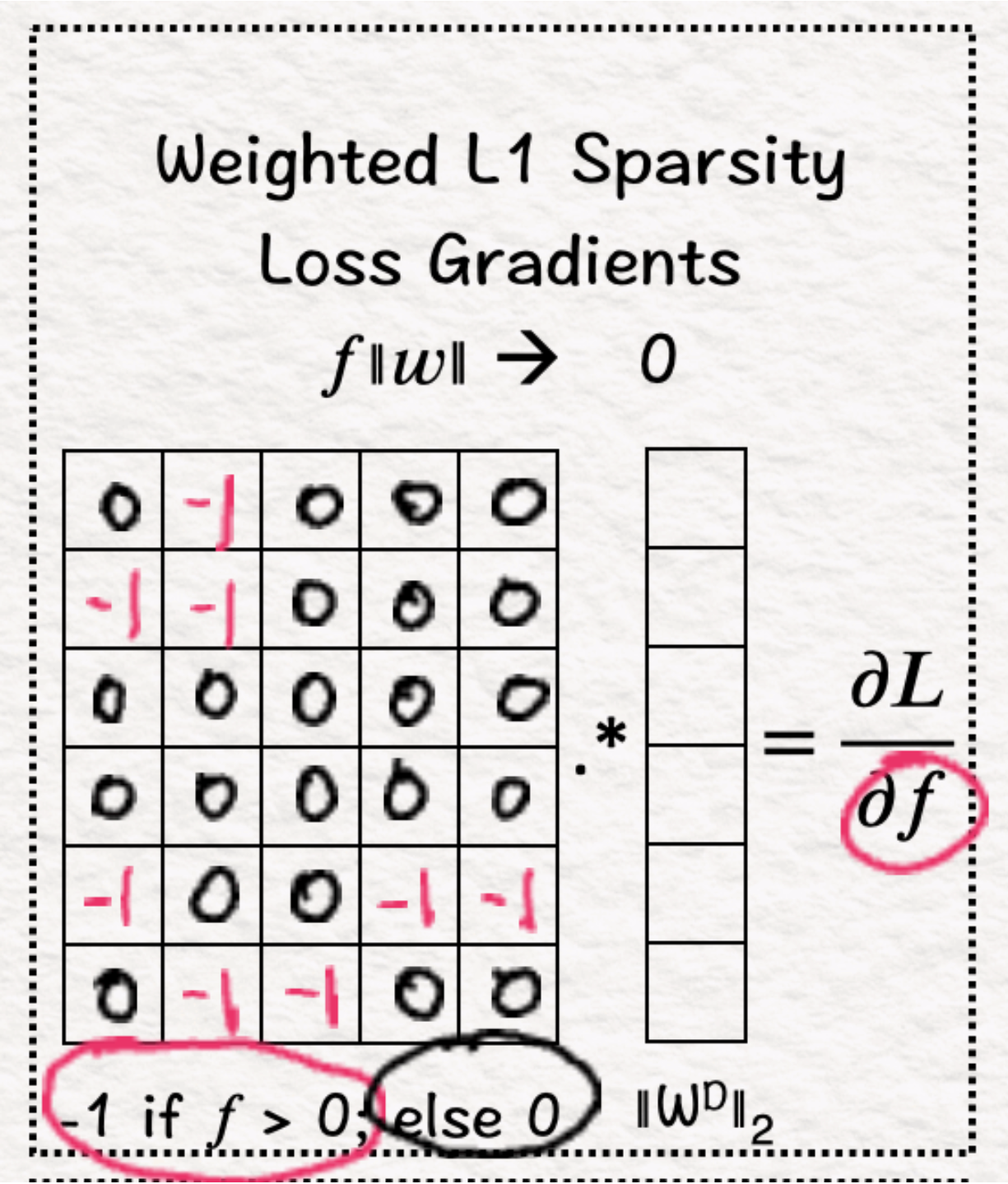

(6)稀疏度:漸變

下一步是計算L1的梯度,對于正值為-1。因此,對于f>0的所有值,結果將設置為-1。

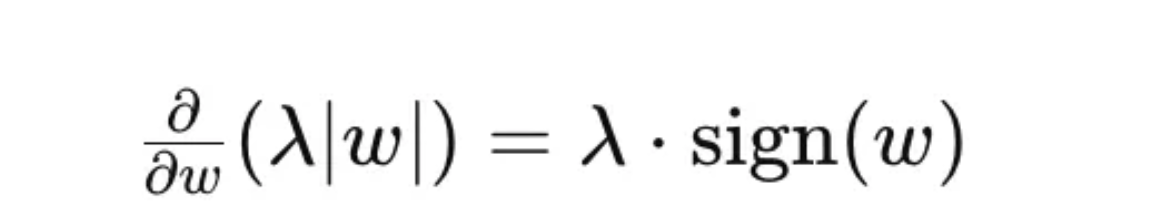

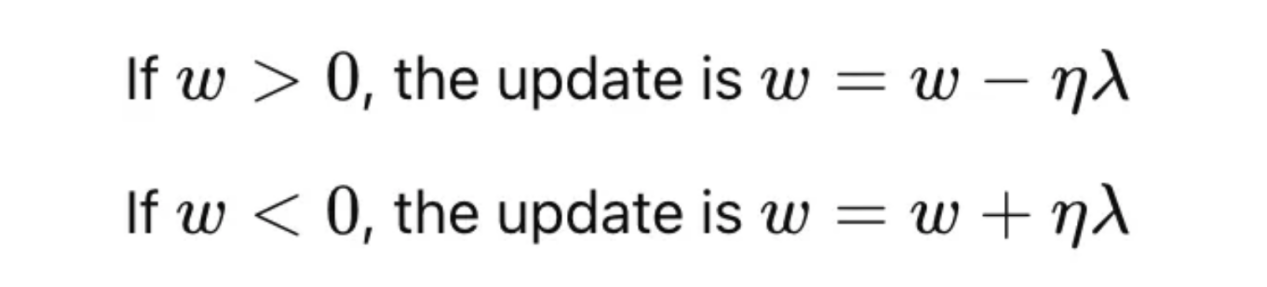

L1懲罰是如何將權重推向零的?

L1懲罰的梯度通過施加恒定力的過程將權重推向零,而與權重的當前值無關。以下是它的工作原理(本小節(jié)中的所有圖片均由作者提供):

L1懲罰表示為:

此懲罰相對于權重w的梯度為:

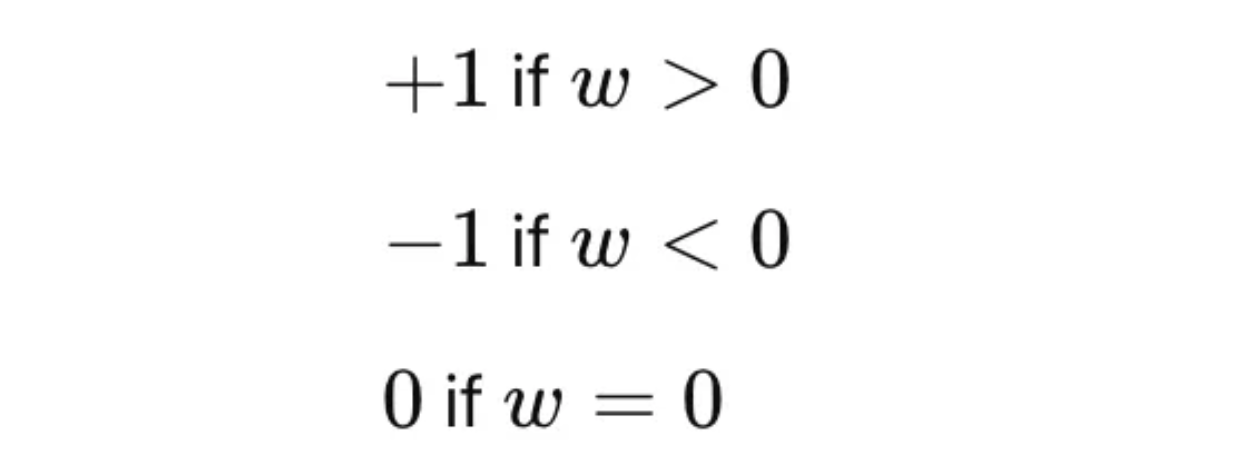

其中符號(w)為:

在梯度下降過程中,權重的更新規(guī)則為:

其中??η代表學習率。

λ與權重值(取決于其符號)的常數(shù)相減(或相加)會降低權重的絕對值。如果重量足夠小,這個過程可以將其精確地驅動到零。

(7)稀疏度:零

對于所有其他已經(jīng)為零的值,我們保持它們不變,因為它們已經(jīng)被清零。

(8)稀疏度:權重

我們將步驟6中獲得的梯度矩陣的每一行乘以步驟4中獲得的相應解碼器權重。這一步驟至關重要,因為它防止了模型學習大的權重,這會在重建結果時添加不正確的信息。

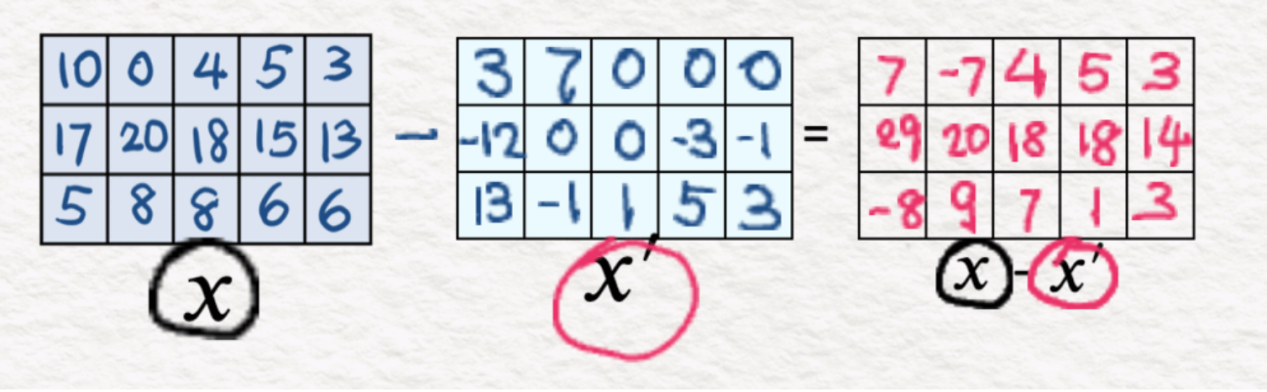

(9)重建:MSE損失

我們使用均方誤差或L2損失函數(shù)來計算X’和X之間的差。如前所述,目標是將誤差最小化到最低值。

(10)重建:漸變

L2損耗的梯度為2*(X'-X)。

因此,正如最初的自動編碼器所看到的那樣,我們運行反向傳播來更新權重和偏差。這里的問題是在稀疏性和重建之間找到一個良好的平衡。

至此,我們就結束了對于稀疏自動編碼器的討論——我們以一種非常聰明和直觀的方式學習了模型是如何理解一個想法以及作出針對性反應的。

小結一下

- 自動編碼器總體上由兩部分組成:編碼器和解碼器。編碼器使用權重和偏差與ReLU激活函數(shù)相結合,將初始輸入特征壓縮到較低的維度,試圖僅捕獲相關部分。另一方面,解碼器獲取編碼器的輸出,并將輸入特征重建回其原始狀態(tài)。由于自動編碼器中的目標本身就是初始特征,因此使用了“自動”一詞。與標準神經(jīng)網(wǎng)絡一樣,其目的是實現(xiàn)目標和輸入特征之間的最低誤差(差),這是通過在網(wǎng)絡中傳播誤差梯度,同時更新權重和偏差來實現(xiàn)的。

- 稀疏自動編碼器由標準自動編碼器的所有組件以及一些附加組件組成。這里的關鍵是訓練步驟中的不同方法。由于這里的目的是檢索可解釋的特征,我們希望將那些意義相對較小的值清零。一旦編碼器使用ReLU激活來抑制負值,我們就更進一步,并對結果使用L1損耗,通過懲罰權重的絕對值來鼓勵稀疏性。這是通過向損失函數(shù)添加懲罰項來實現(xiàn)的,其中的損失函數(shù)是權重的絕對值之和:λ∑|w|。保持非零的權重對模型性能是至關重要的。

利用稀疏度提取可解釋特征

作為人類,我們的大腦對特定刺激的反應只是激活了一小部分神經(jīng)元。同樣,稀疏自動編碼器通過利用L1正則化等稀疏性約束來學習輸入的稀疏表示。通過這樣做,稀疏自動編碼器能夠從復雜數(shù)據(jù)中提取可解釋的特征,從而增強學習特征的簡單性和可解釋性。這種反映生物神經(jīng)過程的選擇性激活有助于關注輸入數(shù)據(jù)的最相關方面,使模型更加穩(wěn)健和高效。

隨著Anthropic公司努力理解人工智能模型的可解釋性,他們的倡議強調(diào)了對透明和可理解的人工智能系統(tǒng)的需求,尤其是當他們越來越融入關鍵決策過程時。通過專注于創(chuàng)建強大且可解釋的模型,Anthropic公司為人工智能的發(fā)展做出了貢獻,人工智能可以在現(xiàn)實世界的應用中得到信任和有效利用。

總之,稀疏自動編碼器對于提取可解釋特征、增強模型魯棒性和確保效率至關重要。正在進行的關于理解這些強大模型及其推理方式的工作強調(diào)了人工智能中可解釋性的日益重要,為更透明的人工智能系統(tǒng)鋪平了道路。這些概念是如何演變的,以及如何推動我們走向一個需要人工智能在我們生活中安全集成的未來,還有待觀察!

附言:如果你想自己完成這個練習,這里有一個空白模板的鏈接供你使用:

徒手練習空白模板:

https://drive.google.com/file/d/1xiAjdlWCAzhj-I-YOb7wSMeroUOQzdlE/view?usp=sharing。

至此,你可以去享受樂趣,幫助Zephyr保護真理圣典的安全了!

再次特別感謝Tom Yeh教授對這項工作的支持!

引用文獻

[1] Towards Monosemanticity: Decomposing Language Models With Dictionary Learning, Bricken et al. Oct 2023 https://transformer-circuits.pub/2023/monosemantic-features/index.html

[2] Scaling Monosemanticity: Extracting Interpretable Features from Claude 3 Sonnet, Templeton et al. May 2024 https://transformer-circuits.pub/2024/scaling-monosemanticity/

譯者介紹

朱先忠,51CTO社區(qū)編輯,51CTO專家博客、講師,濰坊一所高校計算機教師,自由編程界老兵一枚。

原文標題:Explore the concepts behind the interpretability quest for LLMs,作者:Srijanie Dey, PhD

鏈接:

https://towardsdatascience.com/deep-dive-into-anthropics-sparse-autoencoders-by-hand-%EF%B8%8F-eebe0ef59709。